Mise à jour Panda

Découvrez la mise à jour Panda de Google, le changement d’algorithme de 2011 ciblant le contenu de faible qualité. Comprenez son fonctionnement, son impact sur ...

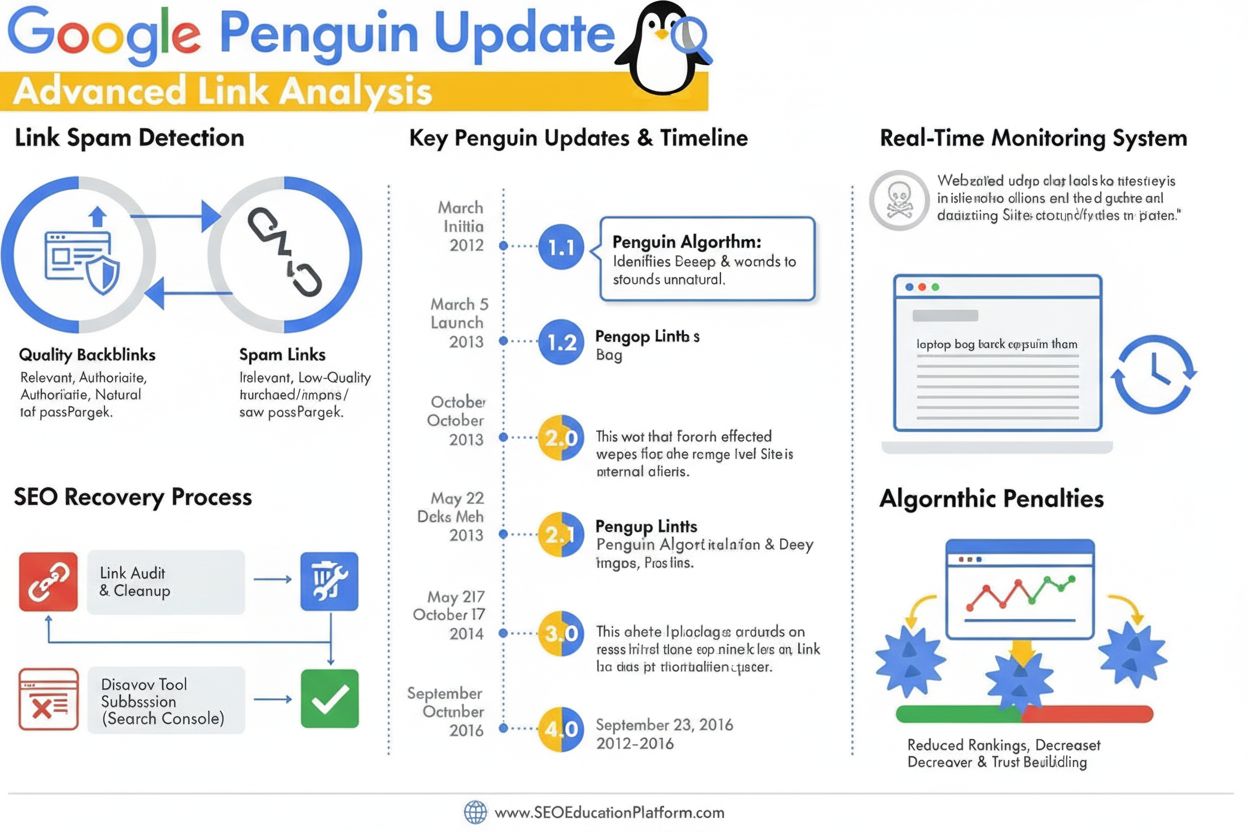

La mise à jour Penguin est un algorithme de Google conçu pour lutter contre le spam de liens et les pratiques de création de liens manipulatrices en identifiant et en dévalorisant les backlinks de mauvaise qualité et non naturels. Lancé pour la première fois en avril 2012, il est devenu en 2016 un composant algorithmique en temps réel qui surveille et ajuste continuellement les classements en fonction de la qualité des backlinks et des schémas de liens.

La mise à jour Penguin est un algorithme de Google conçu pour lutter contre le spam de liens et les pratiques de création de liens manipulatrices en identifiant et en dévalorisant les backlinks de mauvaise qualité et non naturels. Lancé pour la première fois en avril 2012, il est devenu en 2016 un composant algorithmique en temps réel qui surveille et ajuste continuellement les classements en fonction de la qualité des backlinks et des schémas de liens.

La mise à jour Penguin est un algorithme de Google spécialement conçu pour lutter contre le spam de liens et les pratiques de création de liens manipulatrices en identifiant, dévalorisant et pénalisant les sites web présentant des profils de backlinks non naturels ou de mauvaise qualité. Annoncé officiellement pour la première fois par Matt Cutts le 24 avril 2012, l’algorithme Penguin a représenté la réponse agressive de Google à la montée des techniques de SEO black-hat qui gonflaient artificiellement les classements via des liens achetés, des échanges de liens et d’autres pratiques trompeuses. L’objectif principal de l’algorithme est de s’assurer que les liens naturels, faisant autorité et pertinents soient récompensés tandis que les liens manipulés et spammy sont dévalorisés ou totalement ignorés. Contrairement aux mises à jour centrées sur le contenu comme Panda, qui cible le contenu de faible qualité, Penguin évalue spécifiquement la qualité et l’authenticité du profil de liens entrants d’un site web, ce qui en fait un élément clé du système de classement de Google depuis plus d’une décennie.

La mise à jour Penguin est apparue à une période charnière du référencement où le volume de liens jouait un rôle démesuré dans le classement des recherches. Avant le lancement de Penguin, les webmasters pouvaient artificiellement améliorer leur positionnement en acquérant de grandes quantités de liens de faible qualité issus de fermes de liens, de réseaux de blogs privés et d’autres sources de spam. Cette pratique a créé un problème majeur pour les résultats de recherche de Google, car des sites et contenus de faible qualité apparaissaient en bonne place malgré une absence d’autorité ou de pertinence réelles. Matt Cutts, alors responsable de l’équipe webspam de Google, expliquait lors du SMX Advanced 2012 : « Nous considérons cela comme un outil conçu pour lutter contre le contenu de faible qualité. Cela a commencé avec Panda, puis nous avons remarqué qu’il restait encore beaucoup de spam et Penguin a été conçu pour cela. » Le lancement initial de Penguin a affecté plus de 3 % de toutes les requêtes de recherche, en faisant l’une des mises à jour d’algorithme les plus marquantes de l’histoire de Google. Cet impact massif a envoyé un signal fort au secteur du SEO que Google s’engageait fermement contre les pratiques de liens manipulatrices et continuerait à faire évoluer ses algorithmes pour maintenir la qualité des recherches.

L’algorithme Penguin fonctionne grâce à des systèmes sophistiqués d’apprentissage automatique et de reconnaissance de schémas qui analysent les profils de backlinks afin d’identifier les schémas de liens non naturels. L’algorithme examine de nombreux facteurs lors de l’évaluation de la qualité des liens, notamment l’autorité et la pertinence des domaines référents, le texte d’ancrage utilisé, la vélocité d’acquisition des liens et la pertinence contextuelle entre le site référent et le site cible. Penguin cible spécifiquement les schémas de liens, qui englobent un large éventail de pratiques manipulatrices, y compris les liens achetés, les échanges réciproques, les liens issus de réseaux de blogs privés (PBN), les liens provenant d’annuaires de mauvaise qualité et les liens ayant un texte d’ancrage sur-optimisé et rempli de mots-clés. L’algorithme évalue également le ratio de liens de haute qualité versus liens de mauvaise qualité dans le profil de backlinks d’un site, sachant que même les sites légitimes reçoivent parfois des liens de faible qualité. Toutefois, lorsque la proportion de liens spammy devient trop importante, Penguin signale le site pour d’éventuels ajustements de classement. Un aspect clé de la conception de Penguin est qu’il n’évalue que les liens entrants d’un site web ; il n’analyse pas les liens sortants, se concentrant uniquement sur la qualité des backlinks pointant vers un domaine.

La mise à jour Penguin a connu une évolution majeure depuis son lancement initial, à travers plusieurs itérations, avec un changement déterminant en septembre 2016 lors de la sortie de Penguin 4.0. Avant cette étape, Penguin fonctionnait selon un calendrier de mises à jour par lots, Google annonçant des rafraîchissements réguliers pour réévaluer les profils de backlinks et ajuster les classements. Penguin 1.1 (mars 2012) et Penguin 1.2 (octobre 2012) étaient des rafraîchissements de données permettant aux sites pénalisés de se rétablir s’ils avaient nettoyé leur profil de liens. Penguin 2.0 (mai 2013) représentait une version plus avancée, touchant environ 2,3 % des requêtes en anglais et étant la première à examiner en profondeur la structure d’un site et non plus seulement la page d’accueil ou les catégories principales. Penguin 2.1 (octobre 2013) et Penguin 3.0 (octobre 2014) ont poursuivi cette évolution avec des améliorations progressives. Cependant, la sortie de Penguin 4.0 a fondamentalement changé le fonctionnement de l’algorithme en l’intégrant dans le cœur de l’algorithme de Google sous la forme d’un composant en temps réel. Désormais, les sites sont évalués en continu et les ajustements de classement sont immédiats au fur et à mesure de l’évolution des profils de liens, sans attendre une mise à jour programmée. Le passage au temps réel a également modifié le mécanisme de sanction de Penguin, passant de véritables pénalités de classement à de la dévalorisation de liens, où les liens spammy sont simplement ignorés au lieu de déclencher une chute du classement de tout le site.

| Facteur d’évaluation | Liens de haute qualité | Liens de faible qualité/spam | Détection par Penguin |

|---|---|---|---|

| Autorité du domaine référent | Domaines établis et fiables avec une forte autorité | Nouveaux domaines, sites à faible autorité ou réseaux de spam connus | Analyse l’historique du domaine, les signaux de confiance et la pertinence thématique |

| Texte d’ancrage | Expressions naturelles, variées et contextuellement pertinentes | Mots-clés exacts, répétitifs, sur-optimisés | Signale les schémas d’ancre non naturels et le bourrage de mots-clés |

| Vélocité des liens | Acquisition progressive et organique dans le temps | Pics soudains ou schémas non naturels | Surveille la vitesse d’acquisition et la cohérence |

| Pertinence contextuelle | Liens issus de sources thématiques et faisant autorité | Liens provenant de sources non pertinentes ou de mauvaise qualité | Évalue la pertinence sémantique entre le site référent et le site cible |

| Emplacement du lien | Liens éditoriaux intégrés dans le contenu, contexte naturel | Liens en pied de page, barre latérale ou fermes de liens | Évalue l’intégration contextuelle et l’emplacement du lien |

| Qualité du site référent | Contenu de qualité, présence commerciale légitime | Contenu faible, pages auto-générées ou PBN | Examine la qualité globale du site et l’authenticité du contenu |

| Statut nofollow | Attribué correctement lorsque nécessaire | Mal utilisé ou absent sur les liens sponsorisés/promotionnels | Reconnaît la bonne utilisation de nofollow pour les liens non éditoriaux |

La mise à jour Penguin a fondamentalement transformé les pratiques SEO en faisant de la qualité des liens un facteur de classement clé et en décourageant l’usage généralisé des techniques de création de liens black-hat. Avant Penguin, de nombreuses agences SEO et webmasters menaient des campagnes agressives d’achat de liens, d’échanges et de création de PBN sans grande conséquence. Le lancement de l’algorithme a créé une véritable onde de choc, des milliers de sites subissant des baisses de classement et de trafic spectaculaires. Ce changement a forcé l’industrie SEO à adopter des pratiques plus éthiques et white-hat axées sur l’acquisition de liens via la création de contenus de qualité et le développement de relations authentiques. La pénalité Penguin est devenue un cas d’école incitant les entreprises à repenser leur approche, menant à un investissement accru dans le content marketing, les relations publiques et la construction de marque pour obtenir des liens de façon naturelle. Les recherches de l’industrie montrent que comprendre et se conformer aux exigences de Penguin est devenu essentiel pour la réussite SEO à long terme, beaucoup d’organisations mettant en place des audits de backlinks et une surveillance de liens de façon standard. L’algorithme a aussi renforcé l’importance de l’autorité de domaine, de la pertinence thématique et de la vélocité des liens comme mesures clés à surveiller lors de l’évaluation d’opportunités de liens. Plus de 78 % des entreprises utilisent désormais des outils de surveillance de contenu ou d’analyse de liens pilotés par l’IA pour suivre leur profil de backlinks et rester conformes aux consignes de qualité de Google, conséquence directe de l’influence de Penguin sur les standards du secteur.

Se remettre d’une rétrogradation Penguin nécessite une démarche systématique comprenant audits de backlinks, suppression de liens et utilisation stratégique de l’outil de désaveu de Google. La première étape consiste à réaliser un audit complet de tous les liens entrants via la Search Console de Google et des outils tiers comme Ahrefs, SEMrush ou Moz, qui offrent des profils de backlinks détaillés. Les webmasters doivent ensuite évaluer chaque domaine référent pour déterminer si le lien est naturel et de qualité, ou s’il relève d’une pratique manipulatrice. Pour les liens manifestement spammy ou de mauvaise qualité, il est conseillé de contacter le webmaster du site référent et de demander la suppression. Google recommande explicitement de ne pas payer pour la suppression de liens, ce qui perpétue le commerce de liens. Pour les liens impossibles à supprimer, l’outil de désaveu de la Search Console permet de soumettre un fichier demandant à Google d’ignorer certains liens lors de l’évaluation du site. Il est important de noter que désavouer un lien retire aussi toute valeur positive qu’il aurait pu apporter ; l’outil ne doit donc être utilisé que pour les liens réellement nuisibles. Une fois le fichier de désaveu soumis, Google le traite immédiatement, mais l’impact réel sur le classement dépend du moment où Google réexplore ces liens. Comme Penguin 4.0 fonctionne en temps réel, la récupération peut être relativement rapide—parfois en quelques jours ou semaines—une fois les actions correctives suffisantes effectuées. Cependant, il ne faut pas s’attendre à un retour au classement antérieur, certains de ces classements ayant pu être artificiellement gonflés par les liens de mauvaise qualité supprimés.

Alors que les plateformes de recherche IA comme ChatGPT, Perplexity, Google AI Overviews et Claude deviennent cruciales pour la visibilité des marques, comprendre les principes de Penguin dépasse le simple classement dans les résultats de recherche classiques. Ces systèmes IA citent souvent des sources faisant autorité et des sites de qualité lors de la génération de réponses, et les sites disposant de profils de backlinks solides et d’un historique propre sont plus susceptibles d’être reconnus comme fiables dans les données d’entraînement et les systèmes de récupération de l’IA. Un site pénalisé par Penguin pour spam de liens peut non seulement souffrir dans les résultats naturels de Google, mais aussi être dépriorisé par les IA qui évaluent la crédibilité des sources. À l’inverse, les sites maintenant des profils de liens propres et qualitatifs sont plus susceptibles d’être cités comme références dans les réponses générées par l’IA. Ceci constitue une motivation supplémentaire à la conformité Penguin au-delà des métriques SEO traditionnelles. AmICited et des plateformes de surveillance IA similaires aident les organisations à suivre l’apparition de leurs domaines dans les réponses générées par l’IA, offrant une visibilité sur leur reconnaissance comme source d’autorité dans plusieurs systèmes de recherche IA. Le croisement entre conformité Penguin et suivi de citation IA marque une nouvelle frontière en marketing digital, où la qualité des liens impacte à la fois la visibilité dans la recherche classique et celle dans la recherche IA émergente.

La mise à jour Penguin continue d’évoluer à mesure que Google affine sa compréhension de la qualité des liens et des pratiques manipulatrices. Le passage au traitement en temps réel en 2016 a représenté un tournant majeur, mais Google continue d’améliorer ses capacités de détection via l’apprentissage automatique et l’intelligence artificielle. Les développements récents du système SpamBrain de Google, annoncés en 2022, représentent la prochaine étape de la lutte anti-spam, intégrant une IA avancée capable d’identifier à la fois les sites achetant des liens et ceux servant à leur diffusion. On peut donc s’attendre à ce que les prochaines générations de détection du spam de liens soient encore plus sophistiquées, rendant plus difficile l’évasion des pratiques manipulatrices. La tendance du secteur vers le SEO white-hat et les médias acquis continuera probablement de s’accélérer à mesure que les algorithmes de Google distinguent mieux les liens naturels des liens artificiels. De plus, à mesure que les plateformes de recherche IA gagnent en importance, l’enjeu de maintenir des profils de backlinks propres s’étend au-delà de Google pour inclure la reconnaissance comme source d’autorité dans plusieurs systèmes IA. Les organisations qui privilégient la qualité des liens, l’autorité de marque et l’excellence du contenu seront mieux positionnées pour réussir dans la recherche classique comme dans la recherche IA émergente. L’héritage de la mise à jour Penguin n’est pas seulement celui d’un algorithme précis, mais celui d’un tournant fondamental dans la façon dont les moteurs de recherche et les IA évaluent l’autorité d’un site, faisant de la qualité des liens un facteur permanent et de plus en plus déterminant de la visibilité digitale.

Une rétrogradation Penguin est algorithmique et se produit automatiquement lorsque l’algorithme Penguin de Google détecte des schémas de spam de liens, sans intervention manuelle requise. Une pénalité Penguin (ou action manuelle) est infligée par l’équipe webspam de Google après un examen humain et nécessite une demande de réexamen pour être levée. Depuis que Penguin 4.0 est devenu en temps réel en 2016, une rétrogradation algorithmique peut être récupérée presque immédiatement après la mise en œuvre des actions correctives, alors que les pénalités manuelles nécessitent une approbation explicite de Google.

La mise à jour Penguin utilise des algorithmes d’apprentissage automatique pour analyser les profils de backlinks et identifier les schémas de création de liens manipulatrices, notamment les liens achetés, les échanges de liens, les réseaux de blogs privés (PBN) et les schémas d’ancres non naturelles. L’algorithme évalue le ratio de liens naturels de haute qualité par rapport aux liens de mauvaise qualité pointant vers un site web. Il examine également la pertinence et l’autorité des domaines référents pour déterminer si les liens semblent obtenus artificiellement plutôt que de manière éditoriale.

Oui, il est possible de s’en remettre grâce à un processus en plusieurs étapes comprenant des audits de backlinks, la suppression des liens spammy et l’utilisation de l’outil de désaveu de Google pour les liens que vous ne pouvez pas retirer directement. Comme Penguin 4.0 fonctionne en temps réel, la récupération peut être relativement rapide une fois que vous avez nettoyé votre profil de liens et que Google a réexploré ces pages. Cependant, la récupération ne garantit pas un retour aux classements précédents, car certains de ces classements pouvaient être artificiellement gonflés par les liens de mauvaise qualité que vous supprimez.

Penguin pénalise les liens provenant de fermes de liens, de réseaux de liens payants, de réseaux de blogs privés (PBN), d’échanges réciproques de liens et de sites présentant des schémas d’ancres non naturelles. Il cible également les liens provenant d’annuaires de mauvaise qualité, le spam de commentaires, le spam de forums, et les liens obtenus via des pratiques manipulatrices. De plus, Penguin signale les liens provenant de sites à forte autorité qui semblent être vendus ou placés comme des publi-rédactionnels sans la balise nofollow appropriée, car cela enfreint les directives de Google sur les schémas de liens.

Depuis la sortie de Penguin 4.0 en septembre 2016, l’algorithme fonctionne en continu en temps réel dans le cœur de l’algorithme de Google. Cela signifie que Google évalue constamment les profils de backlinks et ajuste les classements en fonction de la qualité des liens, sans attendre les mises à jour programmées. Auparavant, Penguin fonctionnait selon un calendrier de mises à jour par lots avec des rafraîchissements annoncés par Google, mais le traitement en temps réel a éliminé le besoin de ces annonces et permet une récupération plus rapide lorsque les problèmes sont corrigés.

L’outil de désaveu est une fonctionnalité de la Search Console de Google qui permet aux webmasters de demander à Google d’ignorer certains backlinks lors de l’évaluation de leur site. Il s’utilise en dernier recours lorsque vous ne pouvez pas contacter directement les webmasters pour supprimer des liens spammy. En désavouant les liens de mauvaise qualité, vous évitez qu’ils n’affectent négativement vos classements sous l’algorithme Penguin. Cependant, les liens désavoués ne fournissent également plus de valeur positive, il ne faut donc l’utiliser que pour les liens réellement nuisibles.

La mise à jour Penguin originale, lancée en avril 2012, a affecté plus de 3 % de toutes les requêtes de recherche selon les estimations de Google. Les mises à jour ultérieures ont eu des impacts variables : Penguin 2.0 a touché environ 2,3 % des requêtes en anglais, Penguin 2.1 environ 1 %, et Penguin 3.0 moins de 1 % des requêtes de recherche en anglais. Ces pourcentages représentent des millions de sites web à l’échelle mondiale, faisant de Penguin l’une des mises à jour d’algorithme les plus marquantes de l’histoire de la recherche.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez la mise à jour Panda de Google, le changement d’algorithme de 2011 ciblant le contenu de faible qualité. Comprenez son fonctionnement, son impact sur ...

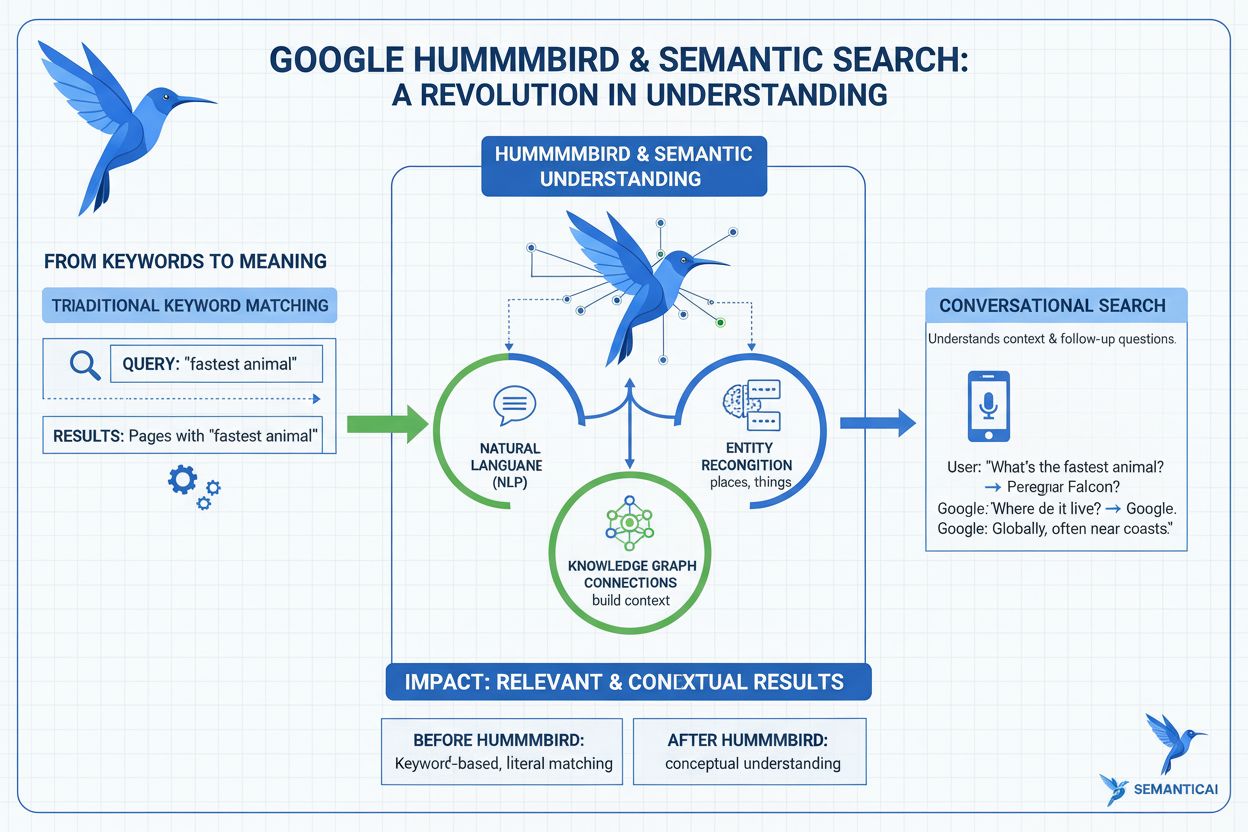

Découvrez ce qu'est la mise à jour Hummingbird, comment elle a révolutionné la recherche sémantique en 2013, et pourquoi elle est essentielle pour le suivi de l...

Découvrez ce que sont les mises à jour de l'algorithme Google, comment elles fonctionnent et leur impact sur le SEO. Comprenez les mises à jour de base, les mis...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.