Limites de jetons et optimisation du contenu : considérations techniques

Découvrez comment les limites de jetons affectent les performances de l’IA et apprenez des stratégies pratiques pour l’optimisation du contenu, y compris RAG, l...

Un jeton est l’unité de base du texte traitée par les modèles de langage, représentant des mots, sous-mots, caractères ou signes de ponctuation convertis en identifiants numériques. Les jetons constituent la base de la compréhension et de la génération de texte par les systèmes d’IA comme ChatGPT, Claude et Perplexity, chaque jeton recevant une valeur entière unique dans le vocabulaire du modèle.

Un jeton est l'unité de base du texte traitée par les modèles de langage, représentant des mots, sous-mots, caractères ou signes de ponctuation convertis en identifiants numériques. Les jetons constituent la base de la compréhension et de la génération de texte par les systèmes d'IA comme ChatGPT, Claude et Perplexity, chaque jeton recevant une valeur entière unique dans le vocabulaire du modèle.

Un jeton est l’unité fondamentale de texte que les modèles de langage traitent et comprennent. Les jetons représentent des mots, des sous-mots, des séquences de caractères ou des signes de ponctuation, chacun se voyant attribuer un identifiant numérique unique dans le vocabulaire du modèle. Plutôt que de traiter le texte brut directement, les systèmes d’IA comme ChatGPT, Claude, Perplexity et Google AI Overviews convertissent tout texte d’entrée en séquences de jetons — traduisant essentiellement le langage humain en un format numérique que les réseaux neuronaux peuvent calculer. Ce processus de tokenisation est l’étape critique qui permet aux modèles de langage d’analyser les relations sémantiques, de générer des réponses cohérentes et de maintenir l’efficacité computationnelle. Comprendre les jetons est essentiel pour toute personne travaillant avec des systèmes d’IA, car le nombre de jetons influence directement les coûts d’API, la qualité des réponses et la capacité du modèle à maintenir le contexte au fil des conversations.

La tokenisation est le processus systématique de découpage du texte brut en jetons discrets qu’un modèle de langage peut traiter. Lorsque vous saisissez un texte dans un système d’IA, le tokenizer analyse d’abord le texte et le divise en unités exploitables. Par exemple, la phrase « J’ai entendu un chien aboyer fort » pourrait être tokenisée en jetons individuels : J', ai, entendu, un, chien, aboyer, fort. Chaque jeton reçoit ensuite un identifiant numérique unique — peut-être que J' devient le jeton 1, ai le 2, entendu le 3, etc. Cette représentation numérique permet au réseau neuronal d’effectuer des opérations mathématiques sur les jetons, calculant les relations et les schémas qui permettent au modèle de comprendre le sens et de générer des réponses appropriées.

La façon dont le texte est tokenisé dépend de l’algorithme de tokenisation utilisé par chaque modèle. Différents modèles de langage utilisent différents tokenizers, ce qui explique pourquoi un même texte peut produire des nombres de jetons différents selon les plateformes. Le vocabulaire du tokenizer — l’ensemble complet des jetons uniques qu’il reconnaît — varie généralement de quelques dizaines à plusieurs centaines de milliers de jetons. Lorsque le tokenizer rencontre un texte ou des mots hors de son vocabulaire, il applique des stratégies spécifiques pour gérer ces cas, soit en les découpant en sous-mots plus petits, soit en les représentant comme des combinaisons de jetons connus. Cette flexibilité est cruciale pour gérer la diversité des langues, le jargon technique, les fautes de frappe et les nouvelles combinaisons de mots qui apparaissent dans les textes du monde réel.

Différentes approches de tokenisation présentent des avantages et des inconvénients distincts. Comprendre ces méthodes est essentiel pour comprendre comment les différentes plateformes d’IA traitent l’information de manière différente :

| Méthode de tokenisation | Fonctionnement | Avantages | Inconvénients | Utilisé par |

|---|---|---|---|---|

| Niveau mot | Découpe le texte en mots complets selon les espaces et la ponctuation | Simple à comprendre ; préserve le sens complet du mot ; séquences de jetons plus courtes | Vocabulaire très vaste ; ne gère pas les mots inconnus ou rares (OOV) ; peu flexible face aux fautes | Systèmes de TAL traditionnels |

| Niveau caractère | Traite chaque caractère individuel comme un jeton, y compris les espaces | Gère tout type de texte ; pas de problème OOV ; contrôle très fin | Séquences de jetons très longues ; plus de calculs nécessaires ; faible densité sémantique par jeton | Certains modèles spécialisés ; modèles pour le chinois |

| Sous-mots (BPE) | Fusionne de façon itérative les paires de caractères/sous-mots fréquentes en jetons plus grands | Équilibre taille du vocabulaire et couverture ; gère efficacement les mots rares ; réduit les erreurs OOV | Implémentation plus complexe ; peut couper des unités de sens ; nécessite entraînement | Modèles GPT, ChatGPT, Claude |

| WordPiece | Commence par les caractères et fusionne progressivement les combinaisons fréquentes | Excellente gestion des mots inconnus ; vocabulaire efficace ; bonne préservation sémantique | Nécessite pré-entraînement ; plus coûteux en calcul | BERT, Modèles Google |

| SentencePiece | Méthode agnostique traitant le texte comme des octets bruts | Idéal pour les modèles multilingues ; gère tout caractère Unicode ; pas de prétraitement nécessaire | Moins intuitif ; nécessite des outils spécialisés | Modèles multilingues, T5 |

Une fois le texte converti en jetons, les modèles de langage traitent ces séquences numériques à travers plusieurs couches de réseaux neuronaux. Chaque jeton est représenté comme un vecteur multidimensionnel appelé embedding, qui capture le sens sémantique et les relations contextuelles. Pendant la phase d’entraînement, le modèle apprend à reconnaître les schémas d’apparition des jetons ensemble, comprenant que certains jetons coapparaissent fréquemment ou apparaissent dans des contextes similaires. Par exemple, les jetons pour « roi » et « reine » développent des embeddings similaires car ils partagent des propriétés sémantiques, tandis que « roi » et « papier » auront des embeddings plus éloignés en raison de leurs sens et usages différents.

Le mécanisme d’attention du modèle est crucial dans ce processus. L’attention permet au modèle de pondérer l’importance des différents jetons les uns par rapport aux autres lors de la génération d’une réponse. Lors du traitement de la phrase « Le directeur de la banque s’est assis au bord de la rivière », le mécanisme d’attention aide le modèle à comprendre que le premier « banque » fait référence à une institution financière tandis que le second « banque » désigne une berge de rivière, en se basant sur des jetons contextuels comme « directeur » et « rivière ». Cette compréhension contextuelle découle des relations apprises entre les embeddings de jetons, permettant une compréhension linguistique sophistiquée bien au-delà de la simple correspondance de mots.

Lors de l’inférence (quand le modèle génère des réponses), il prédit le jeton suivant dans une séquence sur la base de tous les jetons précédents. Le modèle calcule des scores de probabilité pour chaque jeton de son vocabulaire, puis sélectionne le jeton suivant le plus probable. Ce processus se répète de façon itérative : le jeton nouvellement généré est ajouté à la séquence, et le modèle utilise ce contexte élargi pour prédire le jeton suivant. Cette génération jeton par jeton continue jusqu’à ce que le modèle prévoie un jeton spécial « fin de séquence » ou atteigne la limite maximale de jetons. C’est pourquoi il est essentiel de comprendre les limites de jetons : si votre prompt et la réponse souhaitée dépassent ensemble la fenêtre de contexte du modèle, celui-ci ne pourra pas générer une réponse complète.

Chaque modèle de langage possède une fenêtre de contexte — un nombre maximal de jetons qu’il peut traiter simultanément. Cette limite combine à la fois les jetons d’entrée (votre prompt) et les jetons de sortie (la réponse du modèle). Par exemple, GPT-3.5-Turbo a une fenêtre de contexte de 4 096 jetons, tandis que GPT-4 offre des fenêtres allant de 8 000 à 128 000 jetons selon la version. Les modèles Claude 3 permettent des fenêtres de contexte allant jusqu’à 200 000 jetons, permettant l’analyse de livres entiers ou de documents volumineux. Comprendre la fenêtre de contexte de votre modèle est essentiel pour planifier les prompts et gérer efficacement les budgets de jetons.

Les outils de comptage des jetons sont essentiels pour optimiser l’utilisation de l’IA. OpenAI propose la bibliothèque tiktoken, un tokenizer open-source qui permet aux développeurs de compter les jetons avant d’effectuer des appels API. Cela évite des coûts inattendus et permet une optimisation précise des prompts. Par exemple, si vous utilisez GPT-4 avec une fenêtre de 8 000 jetons et que votre prompt utilise 2 000 jetons, il vous reste 6 000 jetons pour la réponse du modèle. Connaître cette contrainte vous aide à rédiger des prompts adaptés à l’espace de jetons disponible tout en demandant des réponses complètes. Différents modèles utilisent différents tokenizers — Claude possède son propre système de tokenisation, Perplexity utilise sa propre approche, et Google AI Overviews encore une autre méthode. Cette variation signifie que le même texte produit des nombres de jetons différents selon les plateformes, rendant indispensable le comptage de jetons spécifique à chaque plateforme pour une estimation précise des coûts et des performances.

Les jetons sont devenus l’unité fondamentale de valeur économique dans l’industrie de l’IA. La plupart des fournisseurs de services d’IA facturent en fonction de la consommation de jetons, avec des tarifs distincts pour les jetons d’entrée et de sortie. La structure tarifaire d’OpenAI en est un exemple : en 2024, GPT-4 facture environ 0,03 $ par 1 000 jetons d’entrée et 0,06 $ par 1 000 jetons de sortie, ce qui signifie que les jetons de sortie coûtent environ deux fois plus cher que les jetons d’entrée. Cette structure tarifaire reflète la réalité computationnelle selon laquelle la génération de nouveaux jetons nécessite plus de puissance de calcul que le traitement des jetons d’entrée existants. Les tarifs de Claude suivent une logique similaire, tandis que Perplexity et d’autres plateformes utilisent leurs propres systèmes de tarification à base de jetons.

Comprendre l’économie du jeton est crucial pour gérer les coûts de l’IA à grande échelle. Un prompt verbeux peut consommer 500 jetons, tandis qu’un prompt concis et bien structuré atteint le même objectif avec seulement 200 jetons. Sur des milliers d’appels API, cette différence d’efficacité se traduit par des économies substantielles. Les études montrent que les entreprises utilisant des outils de surveillance de contenu pilotés par l’IA peuvent réduire leur consommation de jetons de 20 à 40 % grâce à l’optimisation des prompts et à des stratégies de mise en cache intelligentes. De plus, de nombreuses plateformes mettent en place des limites de débit mesurées en jetons par minute (TPM), limitant le nombre de jetons qu’un utilisateur peut traiter dans un laps de temps donné. Ces limites préviennent les abus et garantissent une répartition équitable des ressources. Pour les organisations qui surveillent leur présence de marque dans les réponses d’IA via des plateformes comme AmICited, comprendre les schémas de consommation de jetons révèle non seulement l’impact sur les coûts mais aussi la profondeur et l’étendue de l’engagement de l’IA avec leur contenu.

Pour les plateformes dédiées à la surveillance des apparitions de marques et de domaines dans les réponses de l’IA, les jetons représentent un indicateur clé pour mesurer l’engagement et l’influence. Lorsque AmICited suit l’apparition de votre marque sur ChatGPT, Claude, Perplexity et Google AI Overviews, le nombre de jetons révèle les ressources informatiques que ces systèmes consacrent à votre contenu. Une citation qui consomme 50 jetons indique un engagement plus important qu’une brève mention de seulement 5 jetons. En analysant les schémas de jetons sur différentes plateformes d’IA, les organisations peuvent comprendre quels systèmes d’IA priorisent leur contenu, à quel point les différents modèles traitent leur marque en profondeur, et si leur contenu bénéficie d’une analyse approfondie ou d’un traitement superficiel.

Le suivi des jetons permet également une analyse sophistiquée de la qualité et de la pertinence des réponses de l’IA. Lorsqu’un système d’IA génère une réponse longue et détaillée sur votre marque en utilisant des centaines de jetons, cela indique une forte confiance et une connaissance approfondie. À l’inverse, des réponses brèves utilisant peu de jetons peuvent suggérer une information limitée ou un classement de pertinence moindre. Cette distinction est cruciale pour la gestion de marque à l’ère de l’IA. Les organisations peuvent utiliser le suivi au niveau des jetons pour identifier les aspects de leur marque les plus cités par l’IA, les plateformes qui priorisent leur contenu, et comparer leur visibilité à celle des concurrents. De plus, les schémas de consommation de jetons peuvent révéler des tendances émergentes — si l’utilisation des jetons pour votre marque augmente soudainement sur plusieurs plateformes d’IA, cela peut indiquer une pertinence croissante ou une actualité récente intégrée dans les données d’entraînement de l’IA.

Le paysage de la tokenisation continue d’évoluer à mesure que les modèles de langage deviennent de plus en plus sophistiqués et performants. Les premiers modèles de langage utilisaient une tokenisation assez simple au niveau du mot, mais les systèmes modernes emploient des méthodes avancées de tokenisation par sous-mots qui allient efficacité et préservation sémantique. Le Byte-Pair Encoding (BPE), popularisé par OpenAI et devenu un standard industriel, marque une avancée majeure sur les approches antérieures. Toutefois, des recherches émergentes laissent envisager l’apparition de méthodes de tokenisation encore plus efficaces à mesure que les modèles évoluent vers des contextes plus longs et des types de données plus variés.

Le futur de la tokenisation va au-delà du texte. Les modèles multimodaux comme GPT-4 Vision et Claude 3 tokenisent les images, l’audio et la vidéo en plus du texte, créant des représentations unifiées de jetons à travers différents modes. Cela signifie qu’un même prompt peut contenir des jetons texte, image et audio, tous traités par la même architecture neuronale. À mesure que ces systèmes multimodaux mûrissent, comprendre la consommation de jetons selon les types de données devient de plus en plus crucial. Par ailleurs, l’émergence de modèles de raisonnement générant des « jetons de réflexion » intermédiaires invisibles à l’utilisateur représente une autre évolution. Ces modèles consomment beaucoup plus de jetons lors de l’inférence — parfois 100 fois plus que les modèles traditionnels — pour produire un raisonnement et une résolution de problèmes de meilleure qualité. Ce développement suggère que l’industrie de l’IA pourrait évoluer vers une mesure de la valeur non seulement par les jetons de sortie mais aussi par le total des jetons computationnels consommés, y compris les processus de raisonnement cachés.

La standardisation du comptage des jetons entre plateformes demeure un défi. Bien que la bibliothèque tiktoken d’OpenAI soit largement adoptée, différentes plateformes maintiennent des tokenizers propriétaires qui produisent des résultats variés. Cette fragmentation complique la tâche des organisations qui surveillent leur présence sur plusieurs systèmes d’IA. Les évolutions futures pourraient inclure des standards de jetons à l’échelle de l’industrie, à l’image de la standardisation de l’encodage de caractères (UTF-8) qui a unifié la représentation textuelle entre systèmes. Une telle standardisation simplifierait la prévision des coûts, permettrait une comparaison équitable des services d’IA et faciliterait le suivi de la présence de marque dans l’écosystème de l’IA. Pour des plateformes comme AmICited dédiées au suivi des apparitions de marque dans les réponses d’IA, des métriques de jetons standardisées rendraient la mesure de l’engagement et de l’allocation des ressources computationnelles par différents systèmes d’IA bien plus précise.

En moyenne, un jeton représente environ 4 caractères ou environ les trois quarts d'un mot en anglais. Cependant, cela varie considérablement selon la méthode de tokenisation utilisée. Les mots courts comme « the » ou « a » consomment généralement un jeton, tandis que les mots plus longs ou complexes peuvent nécessiter deux jetons ou plus. Par exemple, le mot « darkness » peut être divisé en « dark » et « ness » comme deux jetons séparés.

Les modèles de langage sont des réseaux neuronaux qui traitent des données numériques, pas du texte. Les jetons convertissent le texte en représentations numériques (embeddings) que les réseaux neuronaux peuvent comprendre et traiter efficacement. Cette étape de tokenisation est essentielle car elle standardise l'entrée, réduit la complexité computationnelle et permet au modèle d'apprendre les relations sémantiques entre différentes parties du texte grâce à des opérations mathématiques sur les vecteurs de jetons.

Les jetons d'entrée sont les jetons de votre prompt ou question envoyés au modèle d'IA, tandis que les jetons de sortie sont ceux que le modèle génère dans sa réponse. La plupart des services d'IA facturent différemment les jetons d'entrée et de sortie, les jetons de sortie coûtant généralement plus cher car la génération de nouveau contenu nécessite plus de ressources informatiques que le traitement du texte existant. Votre consommation totale de jetons correspond à la somme des jetons d'entrée et de sortie.

Le nombre de jetons détermine directement les coûts de l'API pour les modèles de langage. Des services comme OpenAI, Claude et d'autres facturent à l'unité de jeton, avec des tarifs variant selon le modèle et le type de jeton. Un prompt plus long avec plus de jetons coûte plus cher à traiter, et générer des réponses plus longues consomme plus de jetons de sortie. Comprendre l'efficacité des jetons aide à optimiser les coûts : des prompts concis qui transmettent les informations nécessaires minimisent la consommation de jetons tout en maintenant la qualité des réponses.

Une fenêtre de contexte est le nombre maximal de jetons qu'un modèle de langage peut traiter en une seule fois, combinant à la fois les jetons d'entrée et de sortie. Par exemple, GPT-4 a une fenêtre de contexte allant de 8 000 à 128 000 jetons selon la version. Cette limite détermine la quantité de texte que le modèle peut « voir » et mémoriser lors de la génération de réponses. Des fenêtres de contexte plus larges permettent de traiter des documents plus longs, mais nécessitent également plus de ressources informatiques.

Les trois principales méthodes de tokenisation sont : niveau mot (découpage du texte en mots complets), niveau caractère (chaque caractère traité comme un jeton) et tokenisation par sous-mots comme le Byte-Pair Encoding (BPE) utilisé par les modèles GPT. La tokenisation par sous-mots est la plus courante dans les LLM modernes car elle équilibre la taille du vocabulaire, gère efficacement les mots rares et réduit les erreurs hors-vocabulaire (OOV) tout en préservant la signification sémantique.

Pour des plateformes comme AmICited qui surveillent les réponses de l'IA sur ChatGPT, Perplexity, Claude et Google AI Overviews, le suivi des jetons est crucial pour comprendre combien de votre contenu de marque ou d'URL est traité et cité par les systèmes d'IA. Le nombre de jetons révèle la profondeur de l'engagement de l'IA avec votre contenu : une utilisation élevée de jetons indique des citations ou références plus substantielles, ce qui vous aide à mesurer la visibilité et l'influence de votre marque dans les réponses générées par l'IA.

Oui, absolument. Différents modèles de langage utilisent différents tokenizers et vocabulaires, donc le même texte produira des comptes de jetons différents. Par exemple, le mot « antidisestablishmentarianism » produit 5 jetons dans GPT-3 mais 6 dans GPT-4 en raison d'algorithmes de tokenisation différents. C'est pourquoi il est important d'utiliser des compteurs de jetons spécifiques à chaque modèle lors de l'estimation des coûts ou de la planification de prompts pour des systèmes d'IA particuliers.

Commencez à suivre comment les chatbots IA mentionnent votre marque sur ChatGPT, Perplexity et d'autres plateformes. Obtenez des informations exploitables pour améliorer votre présence IA.

Découvrez comment les limites de jetons affectent les performances de l’IA et apprenez des stratégies pratiques pour l’optimisation du contenu, y compris RAG, l...

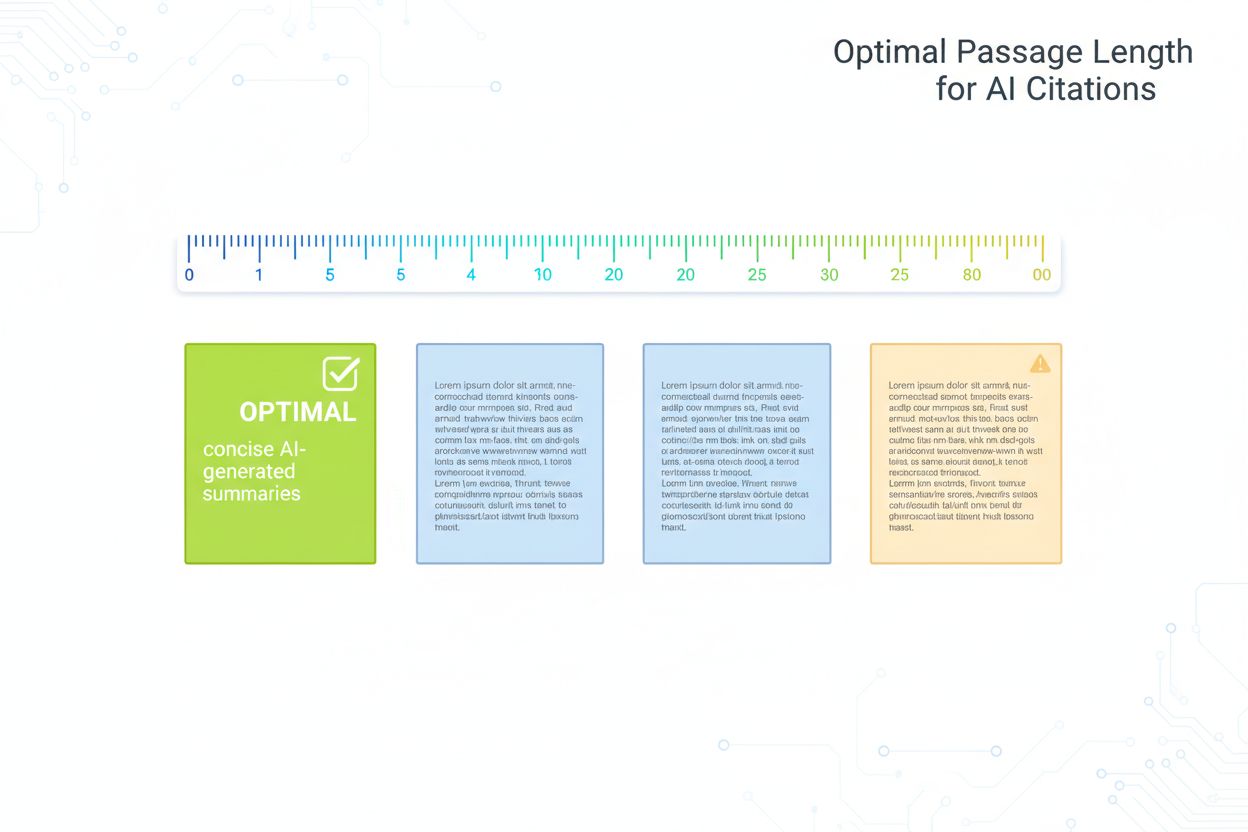

Guide fondé sur la recherche pour déterminer la longueur optimale des passages pour les citations d’IA. Découvrez pourquoi 75-150 mots est idéal, comment les je...

Discussion communautaire expliquant les moteurs génératifs. Explications claires des différences entre ChatGPT, Perplexity et d'autres systèmes d'IA par rapport...

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.