OKR per la Visibilità AI: Definizione degli Obiettivi per GEO

Scopri come impostare OKR efficaci per la visibilità AI e gli obiettivi GEO. Scopri il framework di misurazione a tre livelli, il monitoraggio delle menzioni de...

Scopri come costruire un framework completo di misurazione della visibilità AI per monitorare le menzioni del brand su ChatGPT, Google AI Overviews e Perplexity. Scopri metriche chiave, strumenti e strategie per misurare la visibilità di ricerca AI.

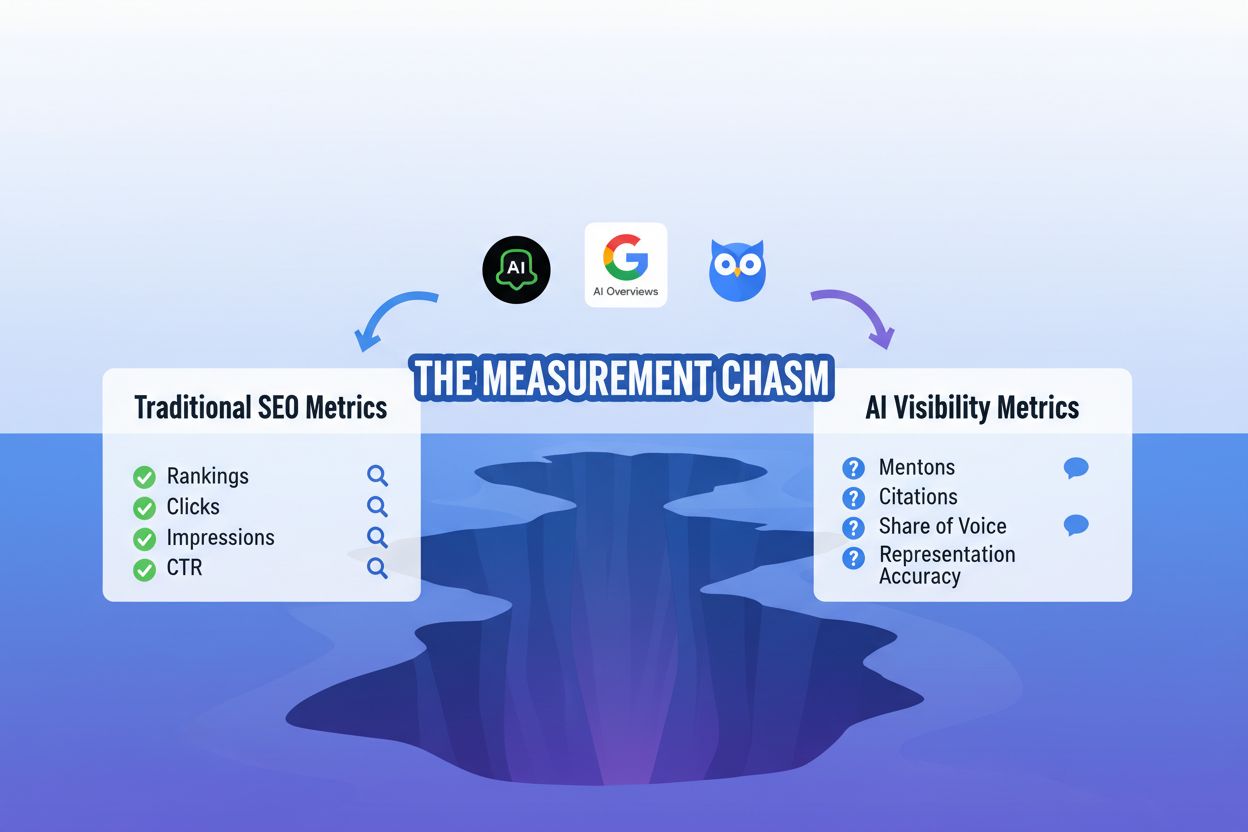

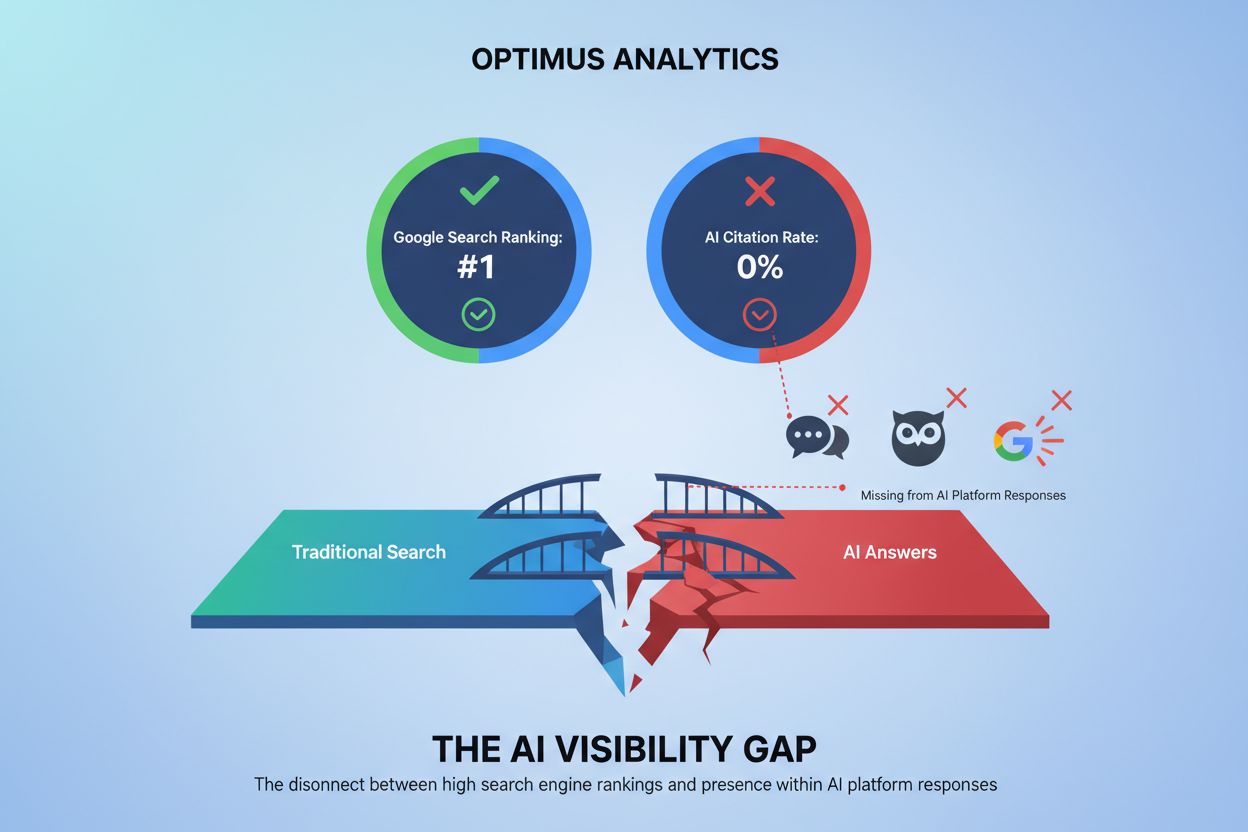

L’ascesa della ricerca generativa AI ha creato quello che gli esperti del settore chiamano il “divario di misurazione”—un gap fondamentale tra le metriche SEO tradizionali e la nuova realtà delle risposte alimentate dall’AI. Per decenni, i marketer si sono affidati al monitoraggio SERP per controllare le posizioni delle keyword, i click-through rate e la visibilità organica. Tuttavia, queste metriche diventano quasi obsolete quando sistemi AI come Google AI Overviews, ChatGPT e Perplexity generano risposte sintetizzate che bypassano completamente i risultati di ricerca tradizionali. La visibilità AI opera in un ecosistema fondamentalmente diverso, in cui i tuoi contenuti possono essere citati, riassunti o parafrasati senza mai apparire come link cliccabile. Gli strumenti di analisi tradizionali non possono tracciare queste interazioni perché avvengono al di fuori dei meccanismi di tracciamento standard del browser. La sfida si intensifica perché i sistemi AI operano con trasparenza limitata, rendendo difficile capire come i tuoi contenuti influenzano le risposte generate dall’AI. Le organizzazioni che continuano a fare affidamento solo sulle metriche SEO rischiano di diventare invisibili nel panorama di ricerca guidato dall’AI, anche quando i loro contenuti vengono effettivamente utilizzati per alimentare le risposte AI.

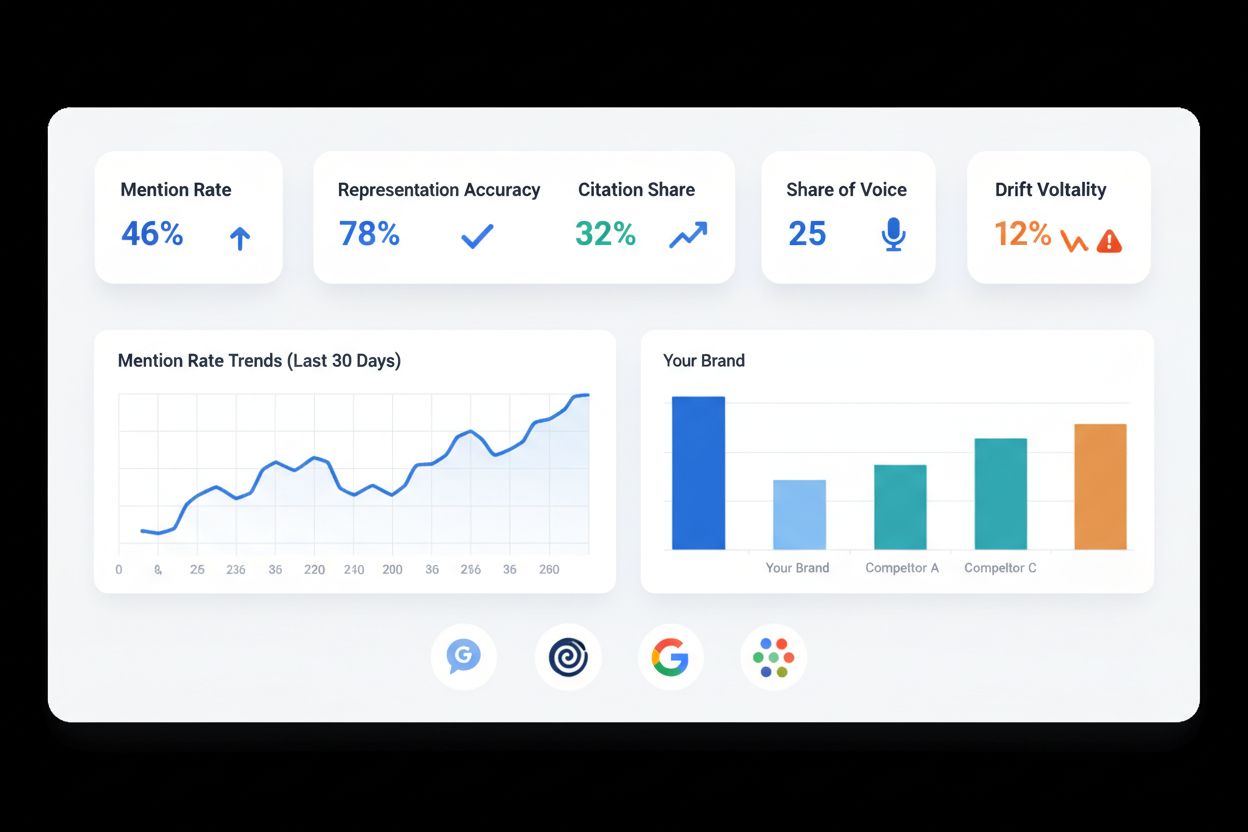

Comprendere la visibilità AI richiede un set completamente nuovo di metriche progettate specificamente per come i sistemi generativi consumano e presentano le informazioni. Piuttosto che monitorare clic e impression, i marketer moderni devono tenere traccia di quante volte i loro contenuti vengono menzionati, citati o rappresentati nelle risposte AI. Il seguente framework delinea le metriche essenziali che dovrebbero costituire la base di qualsiasi strategia completa di misurazione della visibilità AI:

| Metrica | Definizione | Cosa misura | Perché è importante |

|---|---|---|---|

| Tasso di menzione | Percentuale di risposte AI che fanno riferimento al tuo brand, prodotto o contenuto | Visibilità grezza nelle risposte AI | Indica la consapevolezza di base e la rilevanza dei contenuti per i sistemi AI |

| Accuratezza di rappresentazione | Quanto fedelmente i sistemi AI rappresentano i tuoi contenuti, affermazioni e messaggi | Qualità e fedeltà delle citazioni AI | Garantisce che il messaggio del brand non venga distorto o frainteso |

| Quota di citazione | La tua quota di citazioni totali all’interno di uno specifico argomento o categoria di query | Posizionamento competitivo nelle risposte AI | Mostra la quota di mercato nei contenuti generati dall’AI |

| Share of Voice (SOV) | Visibilità del tuo brand rispetto ai competitor nelle risposte AI | Forza competitiva relativa | Confronta le performance rispetto ai concorrenti diretti |

| Drift & Volatilità | Fluttuazioni nei tassi di menzione e rappresentazione attraverso gli aggiornamenti dei modelli AI | Stabilità e coerenza del sistema | Rivela quanto la tua visibilità sia sensibile ai cambiamenti dei modelli AI |

Queste cinque metriche fondamentali lavorano insieme per creare una visione olistica della visibilità AI, andando oltre la semplice presenza per misurare qualità, coerenza e posizionamento competitivo. Ogni metrica ha una funzione distinta: il tasso di menzione stabilisce la visibilità di base, l’accuratezza della rappresentazione protegge l’integrità del brand, la quota di citazione rivela la dinamica competitiva, lo share of voice contestualizza la performance e il monitoraggio del drift assicura stabilità nel tempo. Le organizzazioni che implementano questo framework ottengono la capacità di tracciare non solo se compaiono nelle risposte AI, ma anche come compaiono e se questa presenza genera risultati di business significativi. La combinazione di queste metriche offre la base per decisioni strategiche in un ambiente di ricerca guidato dall’AI.

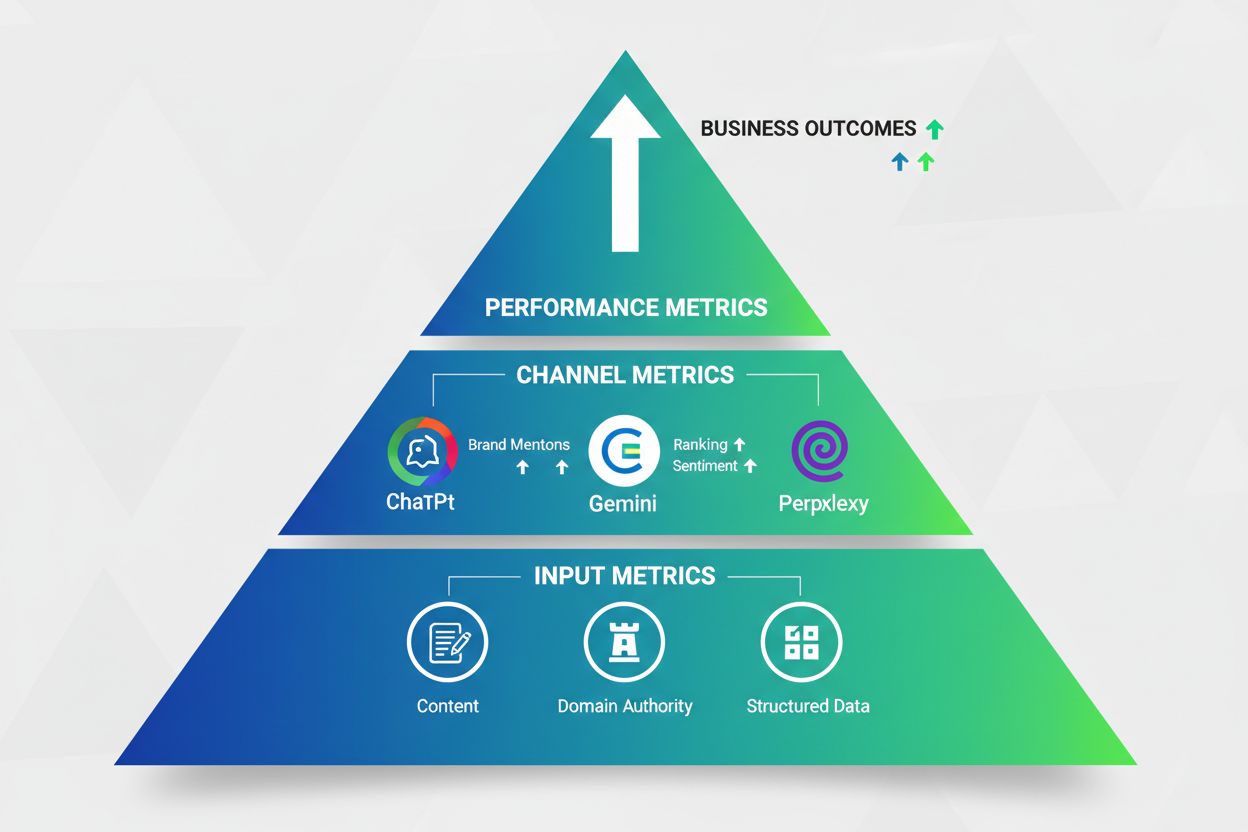

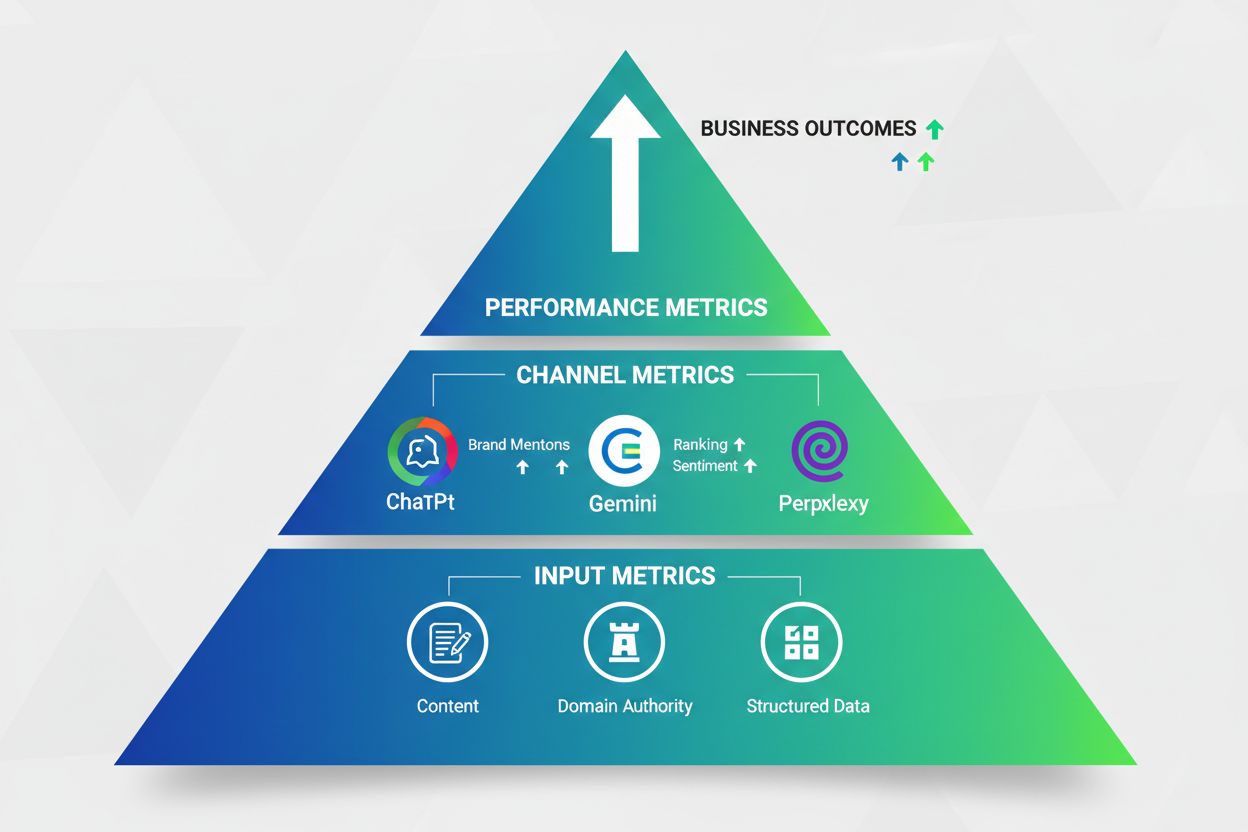

La misurazione efficace della visibilità AI richiede un approccio strutturato e gerarchico che catturi dati su più livelli del percorso cliente. Invece di trattare tutte le metriche allo stesso modo, le organizzazioni di successo implementano uno stack di misurazione a tre livelli che va dagli input, attraverso i canali, fino alle performance aziendali finali:

Metriche di input (Livello 1): Queste metriche fondamentali misurano la materia prima che alimenta i sistemi AI. Esempi: freschezza dei contenuti, ottimizzazione delle keyword, implementazione dei dati strutturati e completezza dei contenuti. Le metriche di input rispondono alla domanda: “Stiamo dando ai sistemi AI le informazioni di cui hanno bisogno per citarci?” Strumenti come Semrush e SE Ranking aiutano a tracciare questi fattori a monte.

Metriche di canale (Livello 2): Questo livello intermedio cattura come i sistemi AI elaborano e presentano effettivamente i tuoi contenuti. Esempi chiave: tasso di menzione, accuratezza di rappresentazione, quota di citazione e share of voice tra diverse piattaforme AI (Google AI Overviews, ChatGPT, Perplexity, Gemini, Bing Copilot). Queste metriche misurano direttamente la visibilità AI e richiedono strumenti di monitoraggio specializzati come AmICited.com o Profound.

Metriche di performance (Livello 3): Il livello superiore collega la visibilità AI ai risultati di business, inclusi traffico, lead, conversioni e ricavi. Questo livello risponde alla domanda critica: “La visibilità AI genera effettivamente risultati di business?” Le metriche di performance possono includere traffico proveniente da AI, costo per acquisizione dai canali AI e attribuzione dei ricavi.

Questo approccio a imbuto garantisce che le organizzazioni comprendano non solo se sono visibili nei sistemi AI, ma perché la visibilità conta e come si collega al successo aziendale. Implementando tutti e tre i livelli, i team possono identificare i colli di bottiglia—magari metriche di input forti ma metriche di canale deboli suggeriscono che i contenuti non vengono correttamente indicizzati dai sistemi AI, mentre metriche di canale forti con metriche di performance deboli indicano che la visibilità non si traduce in valore di business. Lo stack a tre livelli trasforma la visibilità AI da concetto astratto a disciplina aziendale concreta e misurabile.

Stabilire un’infrastruttura robusta di raccolta dati è essenziale per una misurazione affidabile della visibilità AI, richiedendo sia investimenti tecnologici che disciplina operativa. Le organizzazioni devono implementare sistemi di monitoraggio automatico che traccino continuamente menzioni, citazioni e rappresentazioni su più piattaforme AI—un compito che il testing manuale non può sostenere su larga scala. La base tecnica include tipicamente integrazioni API con le piattaforme AI (quando disponibili), strumenti di web scraping per catturare le risposte generate dall’AI e soluzioni di data warehousing per archiviare e analizzare le informazioni raccolte. AmICited.com offre una piattaforma integrata che automatizza gran parte di questa complessità, fornendo connettori preconfigurati ai principali sistemi AI ed eliminando la necessità di sviluppo custom. Oltre all’automazione, le organizzazioni dovrebbero stabilire protocolli di test di base in cui i membri del team interrogano periodicamente i sistemi AI con keyword e argomenti target, documentando le risposte per validare l’accuratezza del monitoraggio automatico. La pipeline dei dati deve includere checkpoint di quality assurance per identificare e correggere errori di tracciamento, poiché anche piccole imprecisioni si sommano nel tempo. Infine, le implementazioni di successo stabiliscono chiare policy di data governance che definiscono chi possiede le varie metriche, con quale frequenza i dati vengono aggiornati e cosa costituisce cambiamento rilevante nei dati.

Una dashboard di visibilità AI efficace deve servire più stakeholder con esigenze informative e responsabilità decisionali differenti, richiedendo un design basato sulle persone che va ben oltre la semplice visualizzazione di metriche generiche. I CMO hanno bisogno di sintesi esecutive che mostrino trend di visibilità AI, posizionamento competitivo e impatto sul business—di solito visualizzati tramite linee di tendenza, benchmark competitivi e attribuzione dei ricavi. Gli SEO Lead necessitano di analisi dettagliate delle metriche, comprensive di tassi di menzione per categoria di query, punteggi di accuratezza di rappresentazione e performance specifiche per piattaforma, spesso visualizzate tramite heatmap e tabelle dettagliate. I Content Leader beneficiano di dashboard a livello di contenuto che mostrano quali pezzi generano citazioni AI, quanto spesso specifiche affermazioni vengono citate correttamente e quali argomenti generano maggiore visibilità AI. I team di Product Marketing hanno bisogno di viste di competitive intelligence che confrontano la share of voice con specifici competitor e tracciano come il posizionamento del prodotto appare nelle risposte AI. Oltre alle viste persona-specifiche, le dashboard moderne dovrebbero includere avvisi in tempo reale che notificano i team quando i tassi di menzione calano drasticamente, emergono problemi di accuratezza di rappresentazione o i competitor guadagnano sostanziale share of voice. L’integrazione con piattaforme di analytics esistenti come Google Analytics e Looker assicura che le metriche di visibilità AI convivano con i dati di performance tradizionali, permettendo ai team di correlare la visibilità AI con le metriche aziendali a valle. Le dashboard più efficaci bilanciano completezza e semplicità, offrendo dettagli per analisi approfondite pur rimanendo accessibili anche ai non tecnici.

L’attuale panorama AI comprende numerose piattaforme concorrenti, ciascuna con architetture, cicli di aggiornamento e pattern di risposta distinti, richiedendo strategie di monitoraggio multi-motore che tengano conto di queste differenze. Google AI Overviews domina il volume di ricerca ma opera nell’ecosistema Google; ChatGPT raggiunge milioni di utenti giornalieri ma opera in modo indipendente; Perplexity è specializzato in query di ricerca; Gemini si integra nell’ecosistema Google; e Bing Copilot serve utenti enterprise. Ogni piattaforma richiede monitoraggio separato poiché cita le fonti in modo diverso, si aggiorna a frequenze diverse e serve intenti utente differenti. Le organizzazioni devono considerare anche variazioni geografiche e di mercato, poiché i sistemi AI spesso producono risposte diverse in base a posizione, lingua e disponibilità di contenuti regionali. Compliance e brand safety diventano considerazioni critiche nel monitoraggio della visibilità AI—le organizzazioni devono monitorare non solo se vengono citate, ma anche il contesto delle citazioni e se i sistemi AI rappresentano correttamente i loro contenuti. La sfida si intensifica perché gli aggiornamenti dei modelli AI possono cambiare drasticamente la visibilità da un giorno all’altro; un aggiornamento può modificare come i sistemi pesano le fonti, citano le informazioni o generano risposte, rendendo necessari sistemi di misurazione flessibili e adattabili. Le implementazioni di successo stabiliscono metriche di base prima dei principali aggiornamenti di piattaforma, quindi monitorano i cambiamenti post-aggiornamento per comprenderne l’impatto. Strumenti come AmICited.com semplificano il monitoraggio multi-motore offrendo monitoraggio unificato tra piattaforme, eliminando la necessità di controllare manualmente ogni sistema.

Misurare la visibilità AI non ha senso senza un processo chiaro che trasformi le metriche in azioni strategiche, richiedendo workflow strutturati di ottimizzazione che colleghino gli insight dei dati alle decisioni di contenuto e prodotto. Quando le metriche di tasso di menzione rivelano che i competitor ricevono più citazioni su argomenti specifici, i team dovrebbero avviare framework di sperimentazione dei contenuti testando approcci diversi—magari coperture più approfondite, formati strutturali differenti o affermazioni più solide supportate da ricerche originali. Metriche di accuratezza di rappresentazione che mostrano frequenti fraintendimenti dei tuoi contenuti devono attivare audit e riscritture focalizzate su chiarezza e precisione. L’analisi dello share of voice che rivela gap competitivi dovrebbe informare aggiustamenti della content strategy, indirizzando risorse verso argomenti ad alto potenziale di visibilità. Oltre all’ottimizzazione dei contenuti, le metriche di visibilità AI abilitano applicazioni di competitive intelligence—tracciare come evolve il posizionamento dei competitor nelle risposte AI, identificare argomenti emergenti in cui stanno guadagnando visibilità e capire quali tipi di contenuto generano più citazioni. Le organizzazioni più avanzate collegano direttamente la visibilità AI ai ricavi monitorando quale traffico proveniente da AI converte meglio, quali argomenti portano clienti di maggior valore e quali miglioramenti di visibilità correlano con la crescita dei ricavi. Questo richiede l’integrazione delle metriche di visibilità AI con CRM e sistemi di revenue, creando cicli di feedback in cui i miglioramenti di visibilità vengono validati rispetto ai risultati di business. Le organizzazioni che padroneggiano questo workflow trasformano la visibilità AI da metrica di vanità a motore centrale del ROI marketing.

Nonostante l’importanza della misurazione della visibilità AI, le organizzazioni incontrano ostacoli significativi che possono compromettere la qualità dei dati e le decisioni strategiche se non vengono affrontati correttamente. La variabilità dei sistemi AI rappresenta forse la sfida maggiore: la stessa query può produrre risposte diverse in momenti diversi, sessioni utente differenti e località geografiche diverse, rendendo difficile stabilire baseline costanti. Le soluzioni includono l’implementazione di metodologie di campionamento statistico che tengano conto della variazione naturale, la definizione di intervalli di confidenza sulle metriche e il monitoraggio delle tendenze anziché dei valori assoluti. La scarsa trasparenza delle piattaforme significa che la maggior parte delle aziende AI non rivela pubblicamente come seleziona le fonti, pesa le citazioni o aggiorna i sistemi, costringendo le organizzazioni a fare reverse engineering tramite test empirici. L’attribuzione delle risposte multi-source complica la misurazione quando i sistemi AI sintetizzano informazioni da più fonti senza indicare chiaramente quale fonte ha contribuito a quale informazione. Le soluzioni avanzate usano NLP e analisi semantica per inferire l’attribuzione anche quando le fonti non sono citate esplicitamente. Vincoli di privacy e termini di servizio limitano quanto aggressivamente le organizzazioni possano monitorare i sistemi AI—alcune piattaforme vietano le query automatizzate, richiedendo l’uso di API ufficiali o l’accettazione di limiti sulla frequenza di raccolta dati. L’imprevedibilità degli aggiornamenti dei modelli significa che la visibilità può cambiare drasticamente senza preavviso, richiedendo sistemi di misurazione flessibili che adattino rapidamente nuove baseline. Le organizzazioni che affrontano queste sfide di solito combinano più metodi di raccolta dati (monitoraggio automatico, test manuali, dati API), implementano processi di quality assurance robusti e mantengono una documentazione dettagliata delle variazioni metodologiche per assicurare coerenza di misurazione nel tempo.

Il panorama AI evolve rapidamente, con nuove piattaforme che emergono, sistemi esistenti che si aggiornano frequentemente e best practice di misurazione ancora in via di definizione, richiedendo che le organizzazioni costruiscano sistemi di misurazione flessibili e adattivi invece di framework rigidi. Le implementazioni di successo danno priorità a un’architettura modulare nell’infrastruttura di misurazione, usando API e integrazioni che permettono di accogliere nuove piattaforme AI senza dover ricostruire l’intero sistema. Invece di ottimizzare esclusivamente per le piattaforme attuali come Google AI Overviews e ChatGPT, le organizzazioni lungimiranti monitorano i sistemi emergenti e preparano approcci di misurazione prima che raggiungano l’adozione mainstream. Metriche e metodologie emergenti continuano ad evolversi con la maturità del settore—concetti come “qualità della risposta” e “engagement degli utenti con contenuti citati da AI” potrebbero diventare importanti quanto tasso di menzione e quota di citazione. Le organizzazioni dovrebbero stabilire cicli di revisione regolari (trimestrali o semestrali) per rivalutare il proprio framework di misurazione, integrando nuove metriche e abbandonando quelle obsolete man mano che il panorama cambia. Considerazioni strategiche di lungo termine includono la costruzione di competenze organizzative interne sulla misurazione della visibilità AI, invece di affidarsi a soluzioni puntuali, lo sviluppo di expertise che sappia adattarsi ai cambiamenti di piattaforma e la definizione di governance della misurazione che assicuri coerenza anche al variare di team e strumenti. Le organizzazioni che prospereranno nell’era della ricerca guidata dall’AI saranno quelle che vedono la misurazione non come una checklist statica ma come un processo di apprendimento continuo, testando regolarmente nuovi approcci, validando le ipotesi con dati reali e rimanendo abbastanza agili da cambiare strategia man mano che il panorama AI si trasforma.

La visibilità SEO tradizionale si concentra su posizionamenti, clic e impression provenienti dalle pagine dei risultati dei motori di ricerca. La visibilità AI misura la frequenza con cui il tuo brand viene menzionato, citato o rappresentato in risposte generate da AI come ChatGPT e Google AI Overviews. Mentre la SEO tradizionale traccia i clic, la visibilità AI spesso riguarda interazioni zero-click, in cui l'utente ottiene la risposta senza visitare il tuo sito, ma i tuoi contenuti influenzano comunque la risposta.

Per argomenti critici e query competitive, il monitoraggio quotidiano è ideale per rilevare cambiamenti improvvisi dovuti ad aggiornamenti dei modelli AI. Per un monitoraggio più ampio, il monitoraggio settimanale offre sufficienti insight sulle tendenze riducendo l’onere operativo. Stabilisci metriche di base prima dei principali aggiornamenti di piattaforma, quindi monitora i cambiamenti dopo l’aggiornamento per comprenderne l’impatto. La maggior parte delle organizzazioni trova che revisioni settimanali combinate con avvisi giornalieri per cambiamenti significativi rappresentino il giusto equilibrio.

Inizia dalle quattro principali piattaforme: Google AI Overviews (maggior copertura), ChatGPT (più utenti giornalieri), Perplexity (orientato alla ricerca) e Gemini (adozione enterprise). Bing Copilot vale la pena di essere monitorato per il pubblico enterprise. La priorità dipende dal tuo target: le aziende B2B dovrebbero puntare su ChatGPT e Perplexity, mentre i marchi consumer dovrebbero dare priorità a Google AI Overviews. Strumenti come AmICited.com semplificano il monitoraggio multi-motore controllando tutte le piattaforme contemporaneamente.

Inizia segmentando le analytics per identificare il traffico proveniente da query generate da AI. Traccia separatamente le conversioni da questi segmenti per comprenderne il valore. Usa modelli di attribuzione per collegare i miglioramenti di visibilità a metriche aziendali a valle come lead e ricavi. Monitora i picchi di ricerche brandizzate dopo un aumento delle citazioni AI, poiché indicano una crescita del brand. L’approccio più avanzato integra le metriche di visibilità AI direttamente con CRM e sistemi di ricavo per creare cicli di feedback completi.

I tassi di menzione variano notevolmente in base all’industria e alla competitività dell’argomento. Un tasso di menzione del 30-50% sul set di query target è generalmente considerato solido, mentre oltre il 50% indica un’eccellente visibilità. Tuttavia, il confronto con i competitor è più utile dei numeri assoluti: se i competitor hanno in media il 60% e tu il 40%, è un’opportunità chiara di ottimizzazione. Usa strumenti come AmICited.com per monitorare i tassi di menzione dei competitor e stabilire benchmark realistici per la tua categoria.

Stabilisci metriche di base prima dei principali aggiornamenti di piattaforma, quindi monitora i cambiamenti dopo l’aggiornamento per quantificare l’impatto. Alcuni cali di visibilità sono temporanei mentre i modelli re-indicizzano i contenuti, altri indicano cambiamenti strutturali su come i sistemi ponderano le fonti. Implementa intervalli di confidenza statistica intorno alle metriche per distinguere i cambiamenti significativi dalla normale variazione. Documenta tutti i principali aggiornamenti di piattaforma e i loro effetti sulla tua visibilità per costruire know-how istituzionale su come questi cambiamenti impattano il tuo brand.

Il test manuale è gratuito: crea un set di 20-50 query target e testale periodicamente su piattaforme AI, registrando i risultati in un foglio di calcolo. Questo fornisce dati di base senza costi. Tuttavia, il test manuale non scala oltre alcune centinaia di query. Per un monitoraggio completo, strumenti a pagamento come AmICited.com, Profound o il toolkit AI Visibility di Semrush offrono automazione e monitoraggio multi-motore. La maggior parte delle organizzazioni ritiene che il risparmio di tempo e il miglioramento della qualità dei dati giustifichino l’investimento.

I primi miglioramenti di visibilità possono apparire in 2-4 settimane mentre i sistemi AI re-indicizzano i contenuti aggiornati. Tuttavia, guadagni significativi di share of voice richiedono in genere 6-12 settimane, mentre costruisci autorità di contenuto e competi per le citazioni. La tempistica dipende dalla competitività dell’argomento: i temi meno competitivi mostrano miglioramenti più rapidi. Stabilisci subito metriche di base, quindi monitora settimanalmente per identificare le tendenze. La maggior parte delle organizzazioni vede miglioramenti misurabili entro 30 giorni e risultati sostanziali entro 90 giorni di ottimizzazione mirata.

AmICited monitora come i sistemi AI fanno riferimento al tuo brand su ChatGPT, Google AI Overviews, Perplexity e altro. Ottieni visibilità in tempo reale della tua presenza AI e ottimizza i tuoi contenuti per la ricerca generativa.

Scopri come impostare OKR efficaci per la visibilità AI e gli obiettivi GEO. Scopri il framework di misurazione a tre livelli, il monitoraggio delle menzioni de...

Scopri le metriche di visibilità AI essenziali e i KPI per monitorare la presenza del tuo brand su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme ...

Scopri cos'è il Divario di Visibilità AI, perché è importante per il tuo brand, come misurarlo e le strategie per colmare il divario tra la visibilità tradizion...