Rendering JavaScript per l'IA

Scopri come il rendering JavaScript influenza la visibilità nell'IA. Comprendi perché i crawler IA non eseguono JavaScript, quali contenuti vengono nascosti e c...

Scopri come il prerendering rende il contenuto JavaScript visibile ai crawler AI come ChatGPT, Claude e Perplexity. Scopri le migliori soluzioni tecniche per l’ottimizzazione della ricerca AI e migliora la tua visibilità nei risultati di ricerca alimentati dall’AI.

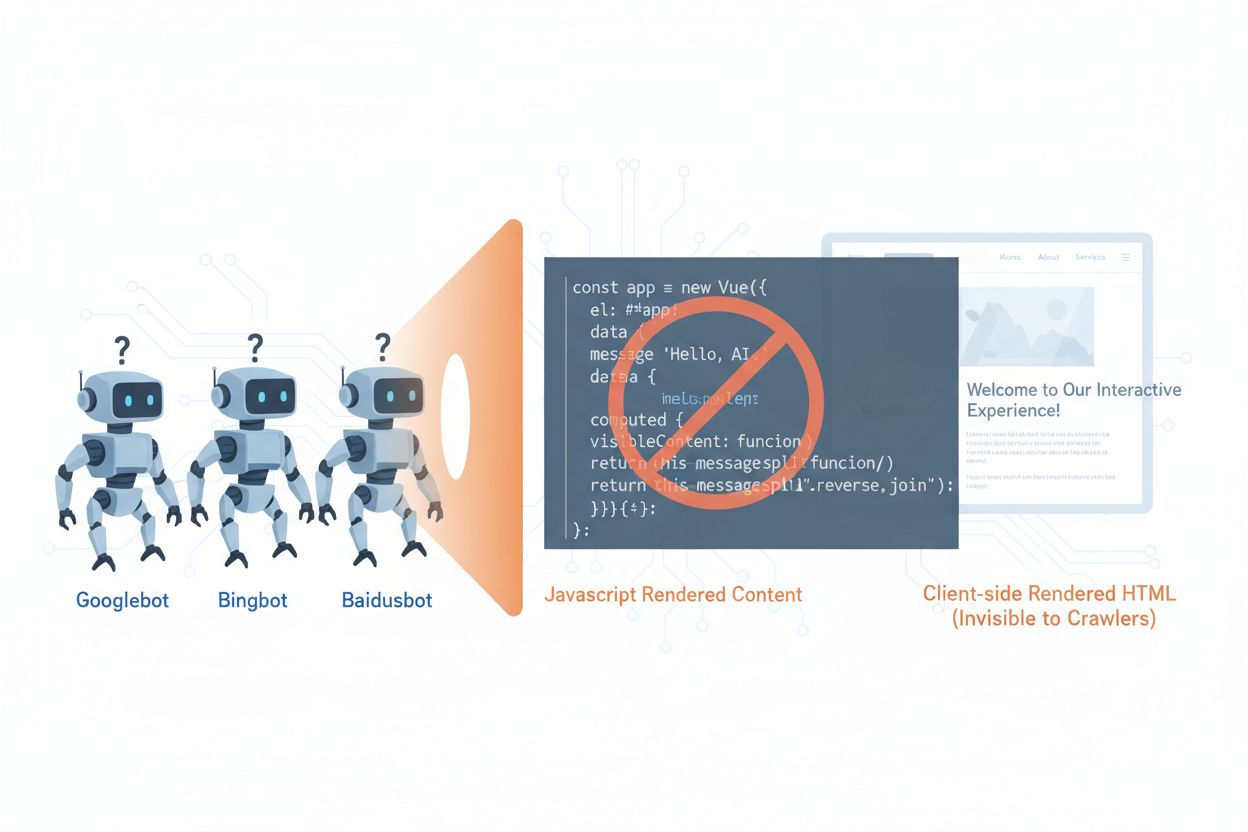

I crawler AI come GPTBot, ClaudeBot e PerplexityBot hanno cambiato radicalmente il modo in cui i contenuti vengono scoperti e indicizzati sul web, ma affrontano un limite fondamentale: non possono eseguire JavaScript. Questo significa che qualsiasi contenuto renderizzato dinamicamente tramite JavaScript—che alimenta le moderne single-page application (SPA), pagine prodotto dinamiche e dashboard interattive—rimane completamente invisibile a questi crawler. Secondo dati recenti, i crawler AI rappresentano ora circa il 28% del traffico di Googlebot, costituendo una parte significativa del crawl budget del tuo sito e un fattore cruciale per l’accessibilità dei contenuti. Quando un crawler AI richiede una pagina, riceve il semplice shell HTML iniziale senza il contenuto renderizzato, vedendo di fatto una versione vuota o incompleta del tuo sito. Questo crea un paradosso: i tuoi contenuti sono perfettamente visibili agli utenti umani con browser abilitati a JavaScript, ma invisibili ai sistemi AI che influenzano sempre più la scoperta, il riassunto e il posizionamento dei contenuti nei motori di ricerca e nelle applicazioni alimentate dall’AI.

Le ragioni tecniche delle limitazioni dei crawler AI con JavaScript derivano da differenze architetturali fondamentali tra il modo in cui i browser e i crawler elaborano i contenuti web. I browser dispongono di un motore JavaScript completo che esegue il codice, manipola il DOM (Document Object Model) e renderizza il risultato visivo finale, mentre i crawler AI tipicamente operano con capacità minime o nulle di esecuzione JavaScript a causa di vincoli di risorse e motivi di sicurezza. Il caricamento asincrono—in cui i contenuti vengono recuperati da API dopo il caricamento iniziale della pagina—costituisce un’altra grande sfida, poiché i crawler ricevono solo l’HTML iniziale prima che arrivino i contenuti. Le single-page application (SPA) aggravano il problema, basandosi completamente sul routing e rendering lato client, lasciando ai crawler solo un bundle JavaScript. Ecco come i diversi metodi di rendering si confrontano in termini di visibilità ai crawler AI:

| Metodo di rendering | Come funziona | Visibilità ai crawler AI | Prestazioni | Costo |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Il browser esegue JavaScript per renderizzare il contenuto | ❌ Scarsa | Veloce per gli utenti | Basso (infrastruttura) |

| SSR (Server-Side Rendering) | Il server renderizza HTML a ogni richiesta | ✅ Eccellente | Caricamento iniziale più lento | Alto (infrastruttura) |

| SSG (Static Site Generation) | Contenuto pre-costruito in fase di build | ✅ Eccellente | Più veloce | Medio (tempo di build) |

| Prerendering | HTML statico in cache su richiesta | ✅ Eccellente | Veloce | Medio (bilanciato) |

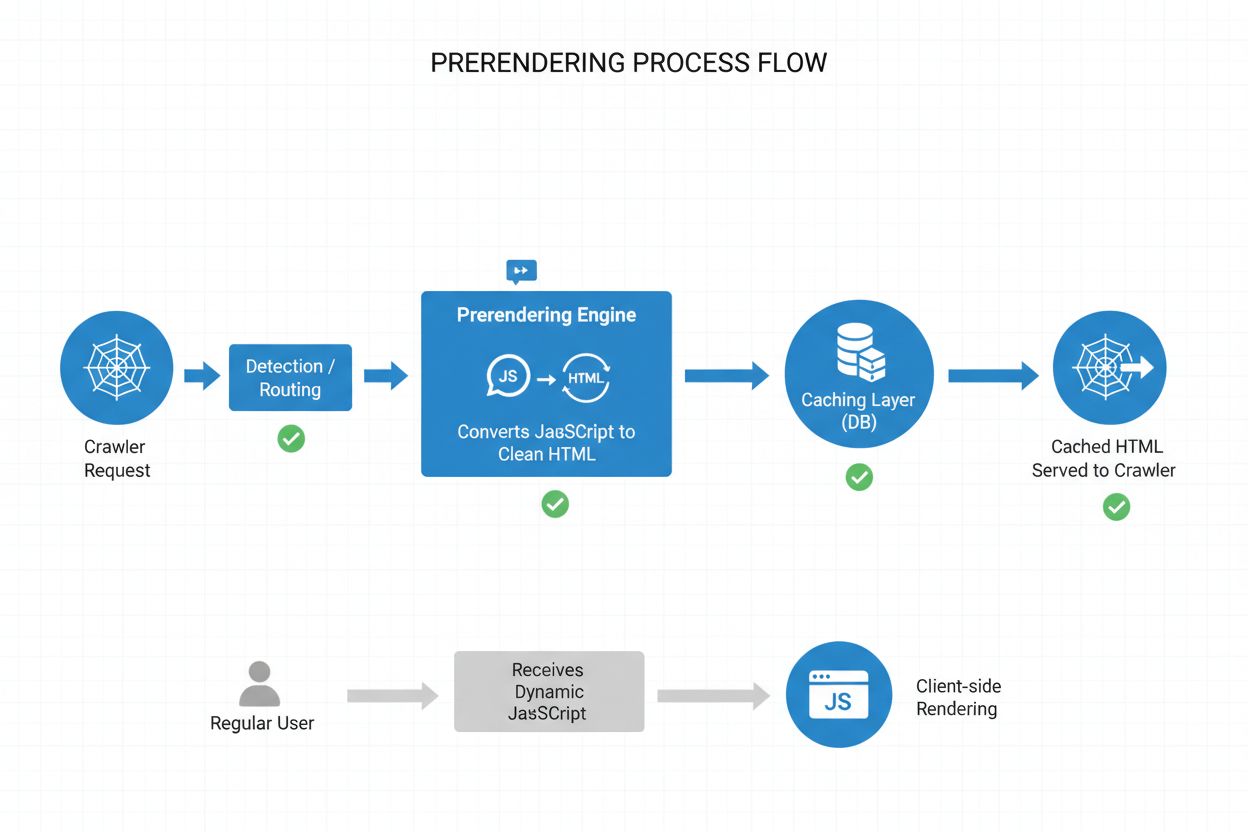

Il prerendering offre un’elegante via di mezzo tra le richieste di risorse del server-side rendering e le limitazioni in fase di build della static site generation. Invece di renderizzare i contenuti a ogni richiesta (SSR) o in fase di build (SSG), il prerendering genera snapshot HTML statici su richiesta quando un crawler o bot richiede una pagina, quindi memorizza quella versione renderizzata in cache per le richieste successive. Questo significa che i crawler AI ricevono HTML statico completamente renderizzato che contiene tutti i contenuti normalmente generati da JavaScript, mentre gli utenti continuano a ricevere la versione dinamica e interattiva del sito senza alcuna modifica nell’esperienza. Il prerendering è particolarmente conveniente perché renderizza solo le pagine effettivamente richieste dai crawler, evitando l’overhead di prerenderizzare l’intero sito o mantenere infrastrutture SSR costose. Il carico di manutenzione è minimo: il codice della tua applicazione rimane invariato e il layer di prerendering opera in modo trasparente in background, rendendolo una soluzione ideale per i team che vogliono accessibilità ai crawler AI senza rivoluzioni architetturali.

Il processo di prerendering opera tramite un workflow sofisticato ma lineare che garantisce ai crawler AI contenuti ottimizzati senza alcuna interruzione per gli utenti. Quando arriva una richiesta al tuo server, il sistema identifica prima l’user agent per capire se si tratta di un crawler AI (GPTBot, ClaudeBot, PerplexityBot) o di un browser comune. Se viene rilevato un crawler AI, la richiesta viene inoltrata al motore di prerendering, che lancia un’istanza di browser headless, esegue tutto il JavaScript, attende il caricamento dei contenuti asincroni e genera uno snapshot HTML statico completo della pagina renderizzata. Questo HTML viene poi memorizzato in cache (tipicamente per 24-48 ore) e servito direttamente al crawler, bypassando completamente la tua applicazione e riducendo il carico sul server. Nel frattempo, le richieste dei browser normali saltano il layer di prerendering e ricevono la tua applicazione dinamica come sempre, garantendo agli utenti l’esperienza interattiva completa con aggiornamenti in tempo reale e funzionalità dinamiche. Tutto avviene in modo trasparente: i crawler vedono contenuti completamente renderizzati, gli utenti vedono la tua applicazione invariata e la tua infrastruttura rimane efficiente perché il prerendering si attiva solo per il traffico dei bot.

Sebbene sia il prerendering che il server-side rendering (SSR) risolvano il problema della visibilità del JavaScript, differiscono notevolmente per implementazione, costi e scalabilità. L’SSR renderizza i contenuti a ogni richiesta, il che significa che il server deve avviare un runtime JavaScript, eseguire tutto il codice della tua applicazione e generare HTML per ogni visitatore—un processo estremamente costoso su larga scala e che può aumentare il Time to First Byte (TTFB) per tutti gli utenti. Il prerendering, invece, mette in cache le pagine renderizzate e le rigenera solo quando i contenuti cambiano o la cache scade, riducendo drasticamente il carico sul server e migliorando i tempi di risposta sia per i crawler che per gli utenti. L’SSR ha senso per contenuti altamente personalizzati o dati che cambiano frequentemente, dove ogni utente necessita di HTML unico, mentre il prerendering eccelle per contenuti relativamente statici o che cambiano raramente—pagine prodotto, articoli di blog, documentazione e contenuti marketing. Molte implementazioni avanzate adottano un approccio ibrido: prerendering per i crawler AI e i contenuti statici, SSR per esperienze utente personalizzate e rendering lato client per funzionalità interattive. Questa strategia a strati offre il meglio di tutti i mondi: eccellente accessibilità ai crawler AI, performance rapide per gli utenti e costi infrastrutturali ragionevoli.

I dati strutturati in formato JSON-LD sono fondamentali per aiutare i crawler AI a comprendere il significato e il contesto dei tuoi contenuti, ma la maggior parte delle implementazioni non tiene conto delle limitazioni dei crawler AI. Quando i dati strutturati vengono inseriti nella pagina tramite JavaScript—pratica comune con Google Tag Manager e sistemi di tag management simili—i crawler AI non li vedono perché non eseguono il JavaScript che crea queste strutture dati. Questo significa che rich snippet, informazioni di prodotto, dettagli sull’organizzazione e altri markup semantici restano invisibili ai sistemi AI, anche se sono perfettamente visibili ai motori di ricerca tradizionali che hanno evoluto la capacità di gestire JavaScript. La soluzione è semplice: assicura che tutti i dati strutturati critici siano presenti nell’HTML renderizzato dal server, non inseriti tramite JavaScript. Questo può significare spostare i blocchi JSON-LD dal tag manager al template lato server della tua applicazione, oppure usare il prerendering per catturare i dati strutturati iniettati da JavaScript e servirli come HTML statico ai crawler. I crawler AI si basano molto sui dati strutturati per estrarre fatti, relazioni e informazioni sulle entità, rendendo l’implementazione server-side dei dati strutturati essenziale per i motori di ricerca AI e l’integrazione nei knowledge graph.

Implementare il prerendering richiede un approccio strategico che bilancia copertura, costi e manutenzione. Segui questi passaggi per iniziare:

Un monitoraggio efficace è essenziale per assicurare che il tuo prerendering funzioni correttamente e che i crawler AI possano accedere ai tuoi contenuti. L’analisi dei log è lo strumento principale: esamina i log del server per identificare le richieste degli user agent dei crawler AI, traccia quali pagine visitano e identifica eventuali pattern di crawling o errori. La maggior parte dei servizi di prerendering come Prerender.io offre dashboard che mostrano tassi di hit della cache, metriche di successo/fallimento del rendering e statistiche sulle prestazioni, dandoti visibilità su quanto efficacemente i tuoi contenuti prerenderizzati vengono serviti. Le metriche chiave da monitorare includono il tasso di hit della cache (percentuale di richieste servite dalla cache), il tasso di successo del rendering (percentuale di pagine renderizzate senza errori), il tempo medio di rendering e il volume di traffico dei crawler. Imposta alert per fallimenti di rendering o pattern di crawling insoliti che possano indicare problemi con il JavaScript o i contenuti dinamici del sito. Correlando le metriche del prerendering con il traffico dei motori di ricerca AI e la visibilità dei tuoi contenuti, puoi quantificare l’impatto della tua implementazione e individuare opportunità di ottimizzazione.

Un prerendering di successo richiede attenzione ai dettagli e manutenzione continua. Evita questi errori comuni:

L’importanza dell’ottimizzazione per i crawler AI crescerà sempre di più man mano che questi sistemi diventeranno centrali per la scoperta e l’estrazione di conoscenza. Sebbene i crawler AI attuali abbiano capacità limitate di esecuzione JavaScript, tecnologie emergenti come Comet e Atlas browsers fanno pensare che in futuro i crawler potranno avere capacità di rendering più avanzate, anche se il prerendering resterà prezioso per motivi di performance e affidabilità. Implementando il prerendering ora, non stai solo risolvendo il problema attuale dei crawler AI—stai rendendo i tuoi contenuti a prova di futuro rispetto all’evoluzione delle capacità dei crawler e assicurando che il tuo sito resti accessibile qualunque sia il modo in cui si evolveranno i sistemi AI. La convergenza tra SEO tradizionale e ottimizzazione per i crawler AI significa che restare competitivi richiede un approccio completo: ottimizza sia per gli utenti che per i sistemi AI, assicurati che i tuoi contenuti siano accessibili in più formati e mantieni la flessibilità per adattarti ai cambiamenti del panorama. Il prerendering rappresenta una soluzione pragmatica e scalabile che colma il divario tra moderne applicazioni pesanti in JavaScript e le esigenze di accessibilità dei sistemi di ricerca e discovery alimentati dall’AI, rendendolo un elemento essenziale di ogni strategia SEO e di contenuti lungimirante.

Il prerendering genera snapshot HTML statici su richiesta e li memorizza in cache, mentre il server-side rendering (SSR) renderizza il contenuto a ogni richiesta. Il prerendering è più conveniente e scalabile per la maggior parte dei casi d'uso, mentre l'SSR è migliore per contenuti altamente personalizzati o che cambiano frequentemente e che richiedono HTML unici per ogni utente.

No, il prerendering influisce solo su come i crawler vedono il tuo contenuto. Gli utenti normali continuano a ricevere la tua applicazione JavaScript dinamica e interattiva esattamente come prima. Il prerendering opera in modo trasparente in background e non ha alcun impatto sulle funzionalità o sulle prestazioni rivolte agli utenti.

I tempi di scadenza della cache dipendono da quanto spesso i tuoi contenuti cambiano. Le pagine ad alto traffico con aggiornamenti frequenti potrebbero richiedere finestre di cache di 12-24 ore, mentre i contenuti statici possono utilizzare durate più lunghe. La maggior parte dei servizi di prerendering consente di configurare i tempi di cache per pagina o template.

Sì, il prerendering funziona bene con contenuti dinamici. Puoi impostare tempi di scadenza della cache più brevi per le pagine che cambiano spesso o implementare strategie di invalidazione della cache che aggiornano le pagine prerenderizzate quando i contenuti vengono modificati. Questo assicura che i crawler vedano sempre contenuti relativamente aggiornati.

I principali crawler AI per cui ottimizzare sono GPTBot (ChatGPT), ClaudeBot (Claude) e PerplexityBot (Perplexity). Dovresti anche continuare a ottimizzare per i crawler tradizionali come Googlebot e Bingbot. La maggior parte dei servizi di prerendering supporta la configurazione per tutti i principali crawler AI e di ricerca.

Se stai già utilizzando l'SSR, hai una buona accessibilità ai crawler AI. Tuttavia, il prerendering può comunque offrire vantaggi riducendo il carico sul server, migliorando le prestazioni e fornendo uno strato di cache che rende la tua infrastruttura più efficiente e scalabile.

Monitora la dashboard del tuo servizio di prerendering per i tassi di hit della cache, le metriche di successo del rendering e le statistiche sulle prestazioni. Controlla i log del server per le richieste dei crawler AI e verifica che ricevano HTML completamente renderizzato. Tieni traccia delle variazioni nella tua visibilità nella ricerca AI e delle citazioni dei tuoi contenuti nel tempo.

I costi del prerendering variano in base al servizio e al volume di utilizzo. La maggior parte dei fornitori offre prezzi a scaglioni in base al numero di pagine renderizzate al mese. I costi sono generalmente molto più bassi rispetto al mantenimento di un'infrastruttura SSR, rendendo il prerendering una soluzione conveniente per la maggior parte dei siti web.

Traccia come le piattaforme AI come ChatGPT, Claude e Perplexity fanno riferimento ai tuoi contenuti con AmICited. Ottieni insight in tempo reale sulla tua visibilità nella ricerca AI e ottimizza la tua strategia di contenuto.

Scopri come il rendering JavaScript influenza la visibilità nell'IA. Comprendi perché i crawler IA non eseguono JavaScript, quali contenuti vengono nascosti e c...

Scopri come le strategie di rendering SSR e CSR influenzano la visibilità ai crawler AI, le citazioni del brand in ChatGPT e Perplexity, e la tua presenza compl...

Scopri come rendere i tuoi contenuti visibili ai crawler AI come ChatGPT, Perplexity e l’AI di Google. Approfondisci i requisiti tecnici, le best practice e le ...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.