Come Garantire che i Crawler AI Vedano Tutti i Tuoi Contenuti

Scopri come rendere i tuoi contenuti visibili ai crawler AI come ChatGPT, Perplexity e l’AI di Google. Approfondisci i requisiti tecnici, le best practice e le ...

Scopri come le strategie di rendering SSR e CSR influenzano la visibilità ai crawler AI, le citazioni del brand in ChatGPT e Perplexity, e la tua presenza complessiva nella ricerca AI.

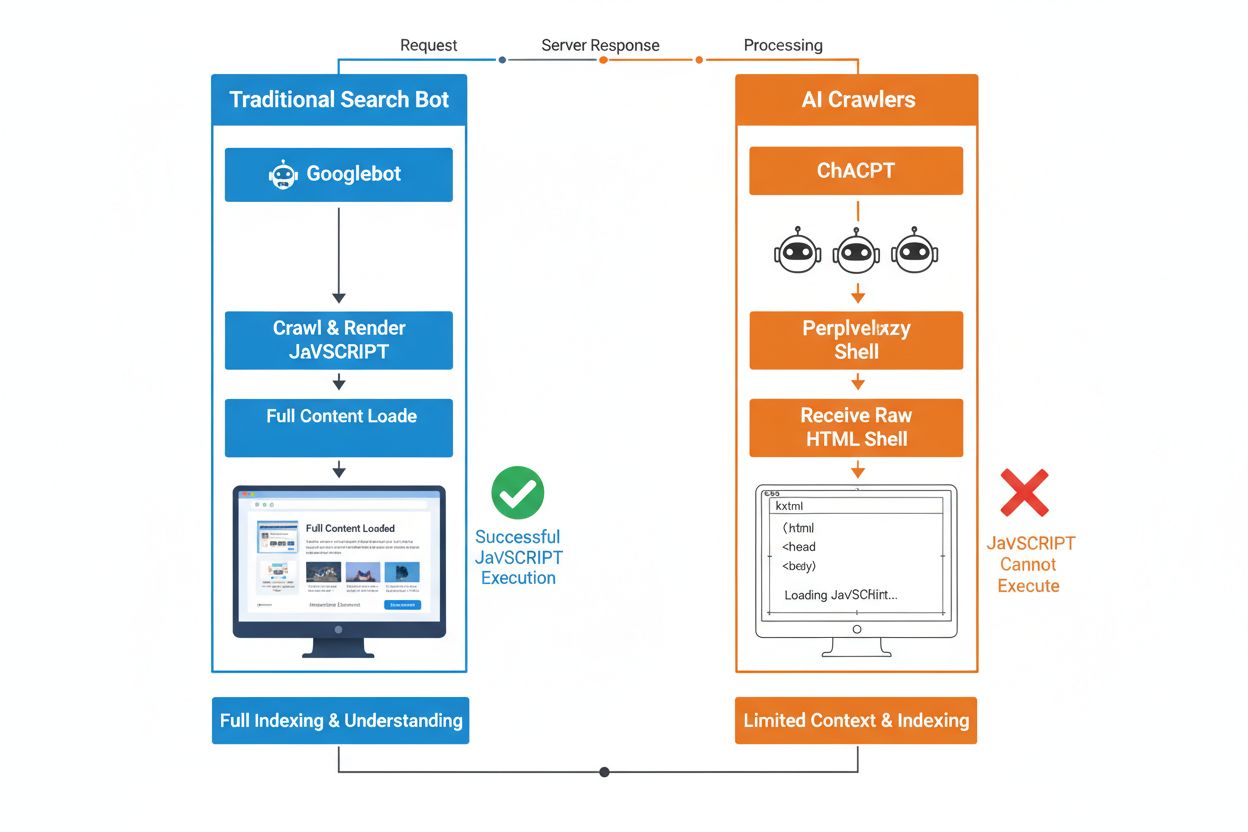

La differenza fondamentale tra i bot di ricerca tradizionali e i crawler AI risiede nel loro approccio all’esecuzione di JavaScript. Mentre Googlebot e altri motori di ricerca tradizionali possono renderizzare JavaScript (seppur con limiti di risorse), i crawler AI come GPTBot, ChatGPT-User e OAI-SearchBot non eseguono affatto JavaScript—vedono solo l’HTML grezzo consegnato al primo caricamento della pagina. Questa distinzione è cruciale: se i contenuti del tuo sito dipendono dal JavaScript lato client per essere visualizzati, i sistemi AI riceveranno una snapshot incompleta o vuota delle tue pagine, senza dettagli prodotto, prezzi, recensioni e altri contenuti dinamici che gli utenti vedono nel browser. Comprendere questo divario è fondamentale, perché i risultati di ricerca alimentati dall’AI stanno rapidamente diventando un canale principale di scoperta per chi cerca informazioni.

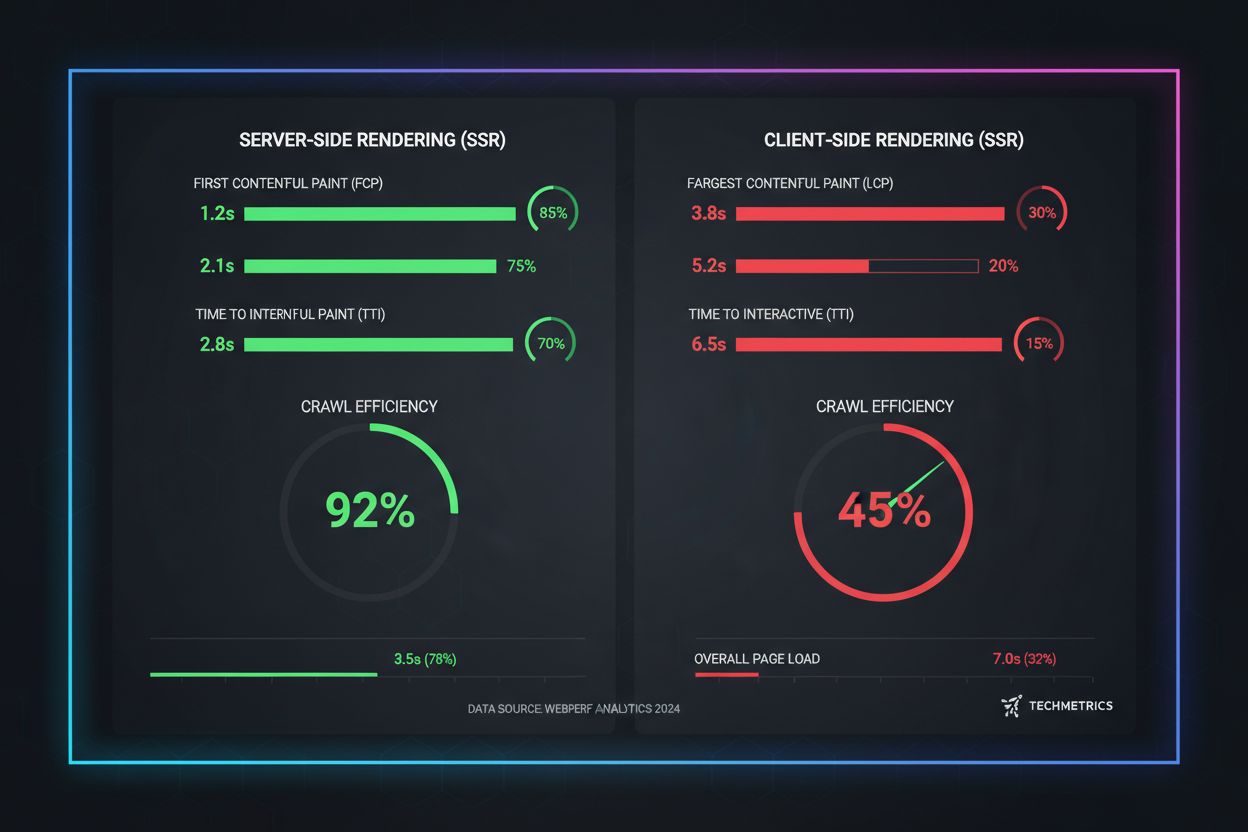

Il Server-Side Rendering (SSR) migliora radicalmente la visibilità AI consegnando HTML completamente renderizzato direttamente dal server alla prima richiesta, eliminando la necessità per i crawler AI di eseguire JavaScript. Con SSR, tutti i contenuti critici—titoli, testo principale, informazioni prodotto, metadati e dati strutturati—sono presenti nell’HTML che ricevono i bot, risultando subito accessibili per l’inserimento nei corpora di training AI e negli indici di ricerca. Questo approccio assicura una consegna coerente dei contenuti a tutti i crawler, velocizza l’indicizzazione e garantisce piena visibilità dei metadati su cui i sistemi AI si basano per comprendere e citare i tuoi contenuti in modo accurato. La tabella seguente mostra come le diverse strategie di rendering impattano la visibilità ai crawler AI:

| Tipo di rendering | Cosa vedono i crawler AI | Velocità di indicizzazione | Completezza dei contenuti | Visibilità dei metadati |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | HTML completamente renderizzato con tutto il contenuto | Veloce (immediata) | Completo | Eccellente |

| Client-Side Rendering (CSR) | Shell HTML minima, contenuti dinamici mancanti | Lento (se renderizzato) | Incompleto | Scarsa |

| Static Site Generation (SSG) | HTML pre-costruito e in cache | Molto veloce | Completo | Eccellente |

| Ibrido/Incrementale | Mix di percorsi statici e dinamici | Moderata o veloce | Buono (se le pagine critiche sono pre-renderizzate) | Buono |

Il Client-Side Rendering (CSR) presenta grosse sfide per la visibilità AI perché costringe i crawler ad attendere l’esecuzione di JavaScript—cosa che i bot AI semplicemente non fanno, a causa delle risorse limitate e dei timeout stretti. Quando un sito CSR viene caricato, la risposta HTML iniziale contiene solo una shell minimale con spinner e segnaposti, mentre i veri contenuti vengono caricati asincronamente tramite JavaScript. I crawler AI impongono timeout stretti di 1-5 secondi e non eseguono script, quindi catturano una snapshot vuota o quasi vuota che non include descrizioni prodotto, prezzi, recensioni e altre informazioni critiche. Questo crea un effetto a catena: snapshot incomplete portano a chunking e embedding di bassa qualità, riducendo le probabilità che le tue pagine vengano incluse tra le risposte AI generate. Per e-commerce, SaaS e applicazioni ricche di contenuti basate su CSR, ciò si traduce direttamente in visibilità persa su AI Overviews, risposte ChatGPT e risposte Perplexity—proprio i canali che oggi guidano la scoperta nell’era AI.

La ragione tecnica per cui i bot AI non possono eseguire JavaScript deriva da vincoli fondamentali di scalabilità e risorse propri della loro architettura. I crawler AI danno priorità a velocità ed efficienza rispetto alla completezza, lavorando con timeout severi perché devono processare miliardi di pagine per addestrare e aggiornare i modelli linguistici. Eseguire JavaScript significa avviare browser headless, allocare memoria e attendere operazioni asincrone—lussi insostenibili alla scala richiesta dal crawling per LLM. I sistemi AI si concentrano invece sull’estrazione di HTML pulito e semanticamente strutturato, subito disponibile, trattando i contenuti statici come versione canonica del tuo sito. Questa scelta progettuale riflette una verità di fondo: i sistemi AI sono ottimizzati per la consegna di HTML statico, non per renderizzare framework JavaScript complessi come React, Vue o Angular.

L’impatto sulle risposte AI generate e sulla visibilità del brand è profondo e si riflette direttamente sui risultati di business. Se i crawler AI non possono accedere ai tuoi contenuti a causa del rendering JavaScript, il tuo brand diventa invisibile nelle AI Overviews, assente dalle citazioni e fuori dai risultati di ricerca LLM—anche se sei ben posizionato nella ricerca Google tradizionale. Per gli e-commerce, ciò significa che dettagli prodotto, prezzi e disponibilità non raggiungono mai i sistemi AI, producendo raccomandazioni incomplete o errate e opportunità di vendita perse. Le aziende SaaS perdono visibilità per confronti funzionalità e pagine prezzo che altrimenti attirerebbero lead qualificati tramite strumenti di ricerca AI. Testate e siti di contenuto vedono i propri articoli esclusi dai riassunti AI, riducendo il traffico referral da ChatGPT e Perplexity. Il divario tra ciò che vedono gli utenti e ciò che vedono i sistemi AI crea un problema di visibilità a due livelli: il tuo sito può sembrare sano nei metriche SEO tradizionali ma essere invisibile al più veloce canale di scoperta in crescita.

Le soluzioni di pre-rendering e ibride offrono modi pratici per combinare i vantaggi di entrambi gli approcci di rendering senza dover stravolgere tutta l’architettura. Invece di scegliere tra l’interattività del CSR e la crawlabilità dell’SSR, i team moderni adottano combinazioni strategiche a seconda dello scopo:

Questi approcci permettono di mantenere esperienze utente ricche e interattive, assicurando che i crawler AI ricevano HTML completo e già renderizzato. Framework come Next.js, Nuxt e SvelteKit rendono il rendering ibrido accessibile senza bisogno di grandi sviluppi custom. La chiave è identificare le pagine che guidano acquisizione, revenue o supporto: queste devono essere sempre pre-renderizzate o server-rendered per garantire la visibilità AI.

La strategia di rendering influisce direttamente su come i sistemi AI citano e fanno riferimento al tuo brand, rendendo fondamentale monitorare la visibilità sulle piattaforme AI. Strumenti come AmICited.com tracciano come i sistemi AI citano il tuo brand su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme LLM, rivelando se i tuoi contenuti raggiungono davvero questi sistemi. Se il tuo sito usa CSR senza pre-rendering, i dati AmICited mostrano spesso un gap netto: puoi essere ben posizionato nella ricerca tradizionale ma ricevere zero citazioni nelle risposte AI generate. Questo monitoraggio mostra il vero costo delle scelte di rendering JavaScript—non solo in efficienza di crawling, ma in visibilità e opportunità di citazione perse. Implementando SSR o pre-rendering e monitorando i risultati tramite AmICited, puoi quantificare l’impatto diretto delle decisioni di rendering sulla visibilità AI, facilitando la giustificazione di investimenti tecnici verso stakeholder orientati a traffico e conversioni.

Analizzare e ottimizzare la tua strategia di rendering per la visibilità AI richiede un approccio sistematico e a step. Inizia identificando le pagine che generano più valore: pagine prodotto, prezzi, documentazione core e blog post ad alto traffico sono la priorità. Utilizza strumenti come Screaming Frog (in modalità “Text Only”) o Chrome DevTools per confrontare ciò che vedono i bot rispetto agli utenti—se contenuti critici non sono presenti nel sorgente, dipendono da JavaScript e sono invisibili ai crawler AI. Quindi, scegli la strategia di rendering in base alle esigenze di freschezza dei contenuti: le pagine statiche possono usare SSG, i contenuti aggiornati spesso beneficiano di SSR o ISR, e le funzionalità interattive possono essere stratificate sopra l’HTML server-rendered. Poi, testa con bot AI reali inviando le tue pagine a ChatGPT, Perplexity e Claude per verificare che accedano ai tuoi contenuti. Infine, monitora i log di crawling per gli user-agent AI (GPTBot, ChatGPT-User, OAI-SearchBot) per confermare che questi bot stiano davvero scansionando le tue pagine pre-renderizzate o server-renderizzate. Questo approccio iterativo trasforma il rendering da dettaglio tecnico a leva di visibilità misurabile.

Le metriche di performance reali evidenziano le differenze tra gli approcci di rendering in termini di crawlabilità AI. SSR e pagine pre-renderizzate raggiungono il First Contentful Paint (FCP) in 0.5-1.5 secondi, mentre i siti CSR spesso impiegano 2-4 secondi o più, dovendo scaricare ed eseguire JavaScript. Per i crawler AI, che lavorano con timeout di 1-5 secondi, questa differenza è tra visibilità totale e completa invisibilità. L’efficienza di crawling migliora drasticamente con SSR: un sito e-commerce pre-renderizzato può essere scansionato e indicizzato completamente in poche ore, mentre l’equivalente in CSR può richiedere settimane, con i crawler bloccati dal rendering JavaScript. Anche la velocità di indicizzazione migliora—i siti SSR vedono i nuovi contenuti indicizzati in 24-48 ore, mentre i siti CSR spesso subiscono ritardi di 7-14 giorni. Per contenuti time-sensitive come news, lanci prodotto o offerte a tempo, questo ritardo si traduce direttamente in visibilità persa proprio nella finestra più critica.

Il futuro della SEO è inseparabile dalla visibilità nella ricerca AI, rendendo la strategia di rendering un investimento fondamentale e non un semplice dettaglio tecnico. La ricerca alimentata da AI sta crescendo esponenzialmente—il 13,14% di tutte le ricerche Google ora attiva AI Overviews, e piattaforme come ChatGPT raccolgono oltre quattro miliardi di visite al mese, con Perplexity e Claude in rapida crescita. Mentre i sistemi AI diventano il canale di scoperta principale per sempre più utenti, le decisioni di rendering che prendi oggi determineranno la tua visibilità domani. Il monitoraggio continuo è essenziale: il comportamento dei crawler AI, i timeout e il supporto JavaScript evolvono col maturare di questi sistemi. I team che vedono il rendering come una migrazione una tantum spesso si ritrovano invisibili dopo pochi mesi, man mano che le piattaforme AI cambiano strategia. Integra invece l’ottimizzazione del rendering nella tua pianificazione trimestrale, includi i check di visibilità AI nei test di regressione e usa strumenti come AmICited per verificare che il brand rimanga visibile con l’evolversi del panorama AI. I brand che vincono nella ricerca AI sono quelli che trattano la strategia di rendering come vantaggio competitivo core, non come debito tecnico da risolvere in futuro.

I crawler AI come GPTBot e ChatGPT-User operano con risorse molto limitate e timeout molto stretti (1-5 secondi) perché devono processare miliardi di pagine per addestrare i modelli linguistici. Eseguire JavaScript richiede l’avvio di browser headless e l’attesa di operazioni asincrone—lussi che non possono essere adottati alla scala necessaria per l’addestramento LLM. Invece, i sistemi AI si concentrano sull’estrazione di HTML statico e pulito, subito disponibile.

Il rendering lato server consegna HTML completamente renderizzato già alla prima richiesta, rendendo subito accessibile tutto il contenuto ai crawler AI senza bisogno di eseguire JavaScript. Questo assicura che dettagli di prodotto, prezzi, recensioni e metadati raggiungano i sistemi AI in modo affidabile, aumentando le probabilità che il tuo brand venga citato nelle risposte AI generate e appaia in AI Overviews.

Il rendering lato server (SSR) genera le pagine su richiesta ogni volta che arriva una richiesta, mentre il pre-rendering genera file HTML statici durante la build. Il pre-rendering è ideale per contenuti che cambiano raramente, mentre l’SSR è preferibile per contenuti dinamici che si aggiornano spesso. Entrambi assicurano che i crawler AI ricevano HTML completo senza esecuzione di JavaScript.

Sì, ma con limitazioni significative. Puoi usare strumenti di pre-rendering per generare snapshot HTML statici delle tue pagine CSR, o implementare rendering ibrido dove le pagine critiche sono server-rendered mentre quelle meno importanti restano client-rendered. Tuttavia, senza queste ottimizzazioni, i siti CSR sono in gran parte invisibili ai crawler AI.

Utilizza strumenti come Screaming Frog (modalità solo testo), Chrome DevTools o Google Search Console per confrontare ciò che vedono i bot rispetto agli utenti. Se contenuti critici mancano nel sorgente pagina, sono dipendenti da JavaScript e invisibili ai crawler AI. Puoi anche testare direttamente con ChatGPT, Perplexity e Claude per verificare che riescano ad accedere ai tuoi contenuti.

SSR e pagine pre-renderizzate raggiungono tipicamente il First Contentful Paint (FCP) in 0.5-1.5 secondi, mentre i siti CSR richiedono spesso 2-4+ secondi. Dato che i crawler AI hanno timeout di 1-5 secondi, un rendering più veloce si traduce direttamente in una migliore crawlabilità AI. Migliorare i Core Web Vitals favorisce anche l’esperienza utente e il posizionamento SEO tradizionale.

AmICited monitora come i sistemi AI citano il tuo brand su ChatGPT, Perplexity e Google AI Overviews. Tracciando la visibilità AI prima e dopo aver implementato SSR o pre-rendering, puoi quantificare l’impatto diretto delle decisioni di rendering sulle citazioni e sulla presenza del brand nella ricerca AI.

Dipende dalle esigenze di aggiornamento dei tuoi contenuti e dalle priorità di business. I contenuti statici beneficiano di SSG, quelli frequentemente aggiornati di SSR, e per funzionalità interattive puoi stratificare JavaScript sopra l’HTML server-rendered. Inizia identificando le pagine di maggior valore (prodotto, prezzi, documentazione) e dai priorità a SSR o pre-rendering su quelle.

Monitora come ChatGPT, Perplexity e Google AI Overviews citano il tuo brand. Comprendi il reale impatto della tua strategia di rendering sulle citazioni AI.

Scopri come rendere i tuoi contenuti visibili ai crawler AI come ChatGPT, Perplexity e l’AI di Google. Approfondisci i requisiti tecnici, le best practice e le ...

Scopri come il rendering JavaScript influenza la visibilità nell'IA. Comprendi perché i crawler IA non eseguono JavaScript, quali contenuti vengono nascosti e c...

Scopri come il prerendering rende il contenuto JavaScript visibile ai crawler AI come ChatGPT, Claude e Perplexity. Scopri le migliori soluzioni tecniche per l'...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.