Come Funziona la Ricerca Live di Perplexity: Integrazione Web in Tempo Reale Spiegata

Comprendi come la tecnologia di ricerca live di Perplexity recupera informazioni in tempo reale dal web e genera risposte citate. Scopri il processo tecnico die...

Ho usato molto Perplexity e sto cercando di fare reverse engineering su come funziona. È chiaramente diverso sia dalla ricerca tradizionale sia da ChatGPT.

Cosa ho osservato:

La mia ipotesi sull’architettura:

Cosa sto cercando di capire:

Cerco qualcuno che abbia studiato in profondità l’architettura di Perplexity.

Daniel, la tua ipotesi sull’architettura è abbastanza vicina. Aggiungo qualche dettaglio:

La pipeline in quattro fasi:

| Fase | Funzione | Tecnologia |

|---|---|---|

| Elaborazione Query | Riconoscimento intenti, estrazione entità | NLP + tokenizzazione |

| Recupero Informazioni | Cerca documenti rilevanti nell’indice web | Ricerca semantica + API |

| Generazione Risposta | Sintesi dai contenuti recuperati | LLM (GPT-4, Claude) |

| Raffinamento | Fact-check, formattazione, suggerimenti | Post-processing |

Fase 1: Elaborazione Query

Non solo estrazione di parole chiave:

Esempio: “Ultimi sviluppi nel computing quantistico” →

Fase 2: Recupero

Usa la ricerca semantica, non solo corrispondenza di parole chiave. Un documento su “reti neurali artificiali” può essere recuperato per una query su “deep learning” perché il significato semantico è simile.

La parte sulla ricerca semantica è interessante. Quindi usa embedding per trovare contenuti concettualmente correlati, non solo corrispondenze di parole chiave?

E per la generazione della risposta - usa più fonti simultaneamente o le elabora in sequenza?

Recupero basato su embedding:

Sì, esattamente. Il processo:

Elaborazione multi-fonte:

Perplexity elabora le fonti in parallelo, non in sequenza:

Documenti recuperati (5-10 fonti)

↓

Estrazione parallela dei passaggi rilevanti

↓

Classifica dei passaggi per rilevanza

↓

Contesto combinato + query → LLM

↓

Risposta sintetizzata con citazioni in linea

Il meccanismo delle citazioni:

Mentre l’LLM genera ogni affermazione, mantiene l’attribuzione della fonte. Ecco perché le citazioni compaiono in linea: il modello tiene traccia di quale fonte supporta ogni affermazione.

Risoluzione dei conflitti:

Quando le fonti non concordano, Perplexity spesso:

Il livello LLM merita più analisi.

Selezione del modello:

Perplexity usa diversi LLM:

Come l’LLM genera risposte citate:

L’LLM non copia semplicemente il testo. Esso:

Esempio di trasformazione:

Fonte 1: “I computer quantistici usano i qubit che possono esistere in sovrapposizione.” Fonte 2: “I principali attori includono IBM, Google e IonQ.” Fonte 3: “Recenti progressi mostrano processori con oltre 1000 qubit.”

Output Perplexity: “I computer quantistici sfruttano qubit che operano in stati di sovrapposizione [1]. Leader di settore IBM, Google e IonQ [2] hanno recentemente raggiunto progressi tra cui processori da oltre 1000 qubit [3].”

La sintesi crea nuovo testo mantenendo un’attribuzione accurata.

Per i creatori di contenuti - ecco cosa conta per essere citati:

Fattori di selezione delle fonti:

| Fattore | Peso | Come ottimizzare |

|---|---|---|

| Rilevanza | Molto Alto | Rispondi direttamente alle domande |

| Credibilità | Alto | Credenziali autore, ente affidabile |

| Attualità | Alto | Date aggiornate, contenuto fresco |

| Chiarezza | Alto | Formato strutturato, facile da estrarre |

| Autorità dominio | Medio | Costruisci la reputazione del sito |

Formato che viene citato:

Perplexity estrae al meglio informazioni da:

Cosa viene saltato:

Ricerca Veloce vs Ricerca Pro - la differenza tecnica:

Ricerca Veloce:

Ricerca Pro:

La decomposizione:

La Ricerca Pro suddivide query complesse in sotto-query:

“Miglior CRM per startup sanitarie con conformità HIPAA” diventa:

Ogni sotto-query recupera fonti diverse, poi i risultati vengono combinati.

Prevenzione delle allucinazioni in Perplexity:

Come riduce le allucinazioni:

Il limite:

Perplexity può comunque allucinare se:

Rispetto a ChatGPT:

| Aspetto | Perplexity | ChatGPT |

|---|---|---|

| Recupero in tempo reale | Sì | Limitato (plugin) |

| Citazione obbligatoria | Sempre | Opzionale |

| Knowledge cutoff | Nessuno (live) | Data di training |

| Rischio allucinazione | Più basso | Più alto |

Il meccanismo della citazione forzata è la principale difesa di Perplexity contro le allucinazioni.

Sistema di memoria contestuale:

All’interno di una sessione:

Perplexity ricorda la cronologia della conversazione:

Esempio: D1: “Quali sono gli ultimi sviluppi nel computing quantistico?” D2: “Come si confronta con il computing classico?”

Per D2, Perplexity capisce che “questo” si riferisce al computing quantistico della D1.

Meccanismo di attenzione:

Utilizza pesi di attenzione per determinare quale contesto precedente è rilevante per la nuova query. Non tutto viene mantenuto - solo le parti contestualmente pertinenti.

Il limite:

La memoria è solo per sessione. Chiudi la conversazione = contesto perso. Nessuna personalizzazione persistente tra sessioni.

Questa è una scelta di privacy, non un limite tecnico.

La Focus Mode è sottovalutata per capire l’architettura di Perplexity:

Focus disponibili:

| Focus | Pool di fonti | Ideale per |

|---|---|---|

| Tutto | Intero web | Query generali |

| Accademico | Articoli scientifici | Domande scientifiche |

| Solo Reddit | Opinioni community | |

| YouTube | Contenuti video | Tutorial, how-to |

| Notizie | Testate giornalistiche | Notizie attuali |

| Scrittura | (nessuna) | Nessun recupero, generazione pura |

Cosa rivela:

La Focus Mode mostra che Perplexity può limitare il recupero a pool di fonti specifici. Ciò significa che hanno:

Per ottimizzare:

Se vuoi citazioni accademiche - assicurati che la tua ricerca sia indicizzata nei database accademici. Se vuoi citazioni generali - concentrati su contenuti facilmente scopribili sul web.

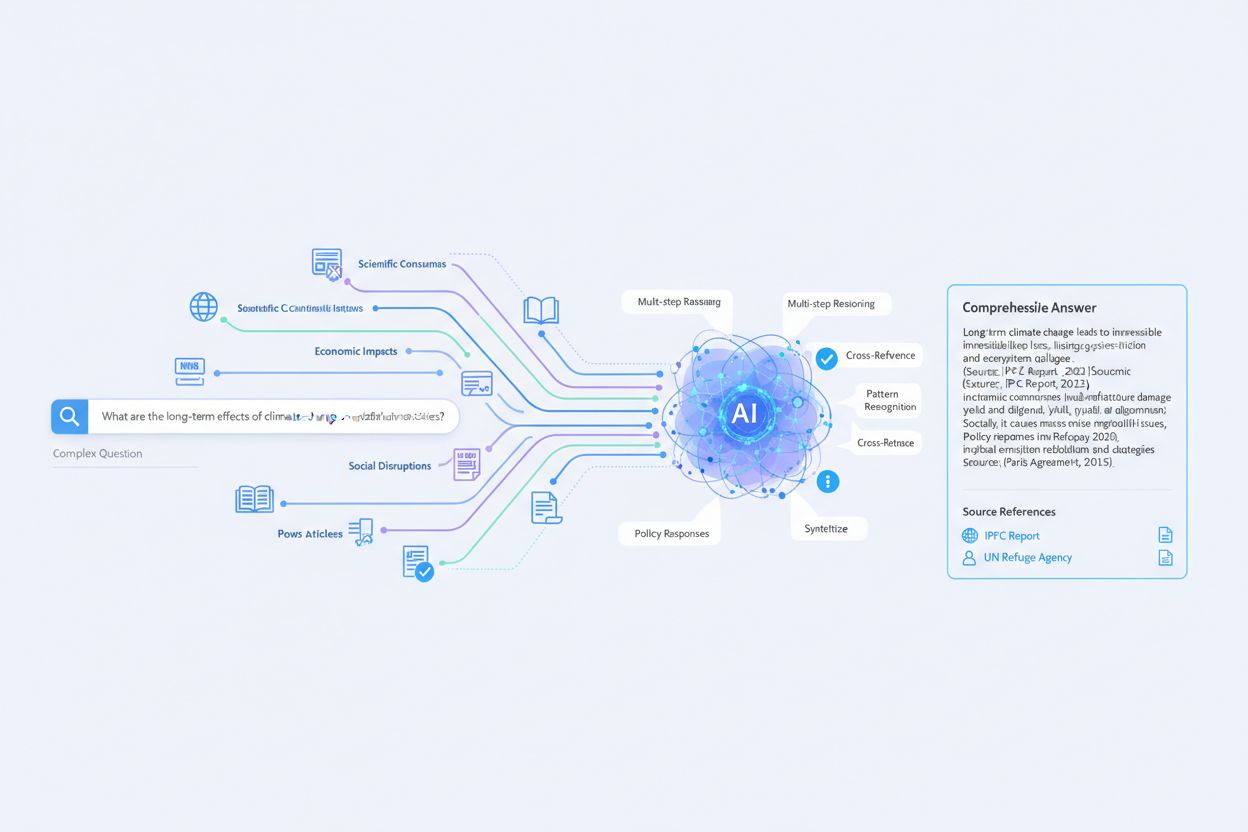

Questo thread ha colmato le lacune nella mia comprensione. Ecco il mio schema aggiornato dell’architettura:

Pipeline della Ricerca Live di Perplexity:

Query Utente

↓

Fase 1: Elaborazione Query

├── Tokenizzazione NLP

├── Classificazione intenti

├── Estrazione entità

├── Riformulazione query (sotto-query multiple)

↓

Fase 2: Recupero Informazioni

├── Ricerca semantica (basata su embedding)

├── Chiamate API all'indice web

├── Filtraggio fonti (Focus Mode)

├── Estrazione passaggi

├── Classifica rilevanza

↓

Fase 3: Generazione Risposta

├── Popolamento finestra di contesto

├── Sintesi LLM (GPT-4/Claude)

├── Tracciamento citazioni in linea

├── Risoluzione conflitti

↓

Fase 4: Raffinamento

├── Fact-check sulle fonti

├── Valutazione coerenza

├── Generazione suggerimenti follow-up

├── Formattazione citazioni

↓

Output finale (Risposta + Citazioni + Suggerimenti)

Principali insight:

Per ottimizzare i contenuti:

Per essere citato in Perplexity:

Grazie a tutti per l’approfondimento tecnico.

Get personalized help from our team. We'll respond within 24 hours.

Monitora quando Perplexity cita il tuo dominio nelle sue risposte di ricerca live. Comprendi come la piattaforma scopre e utilizza i tuoi contenuti.

Comprendi come la tecnologia di ricerca live di Perplexity recupera informazioni in tempo reale dal web e genera risposte citate. Scopri il processo tecnico die...

Scopri Perplexity Pro Search, una modalità di ricerca AI avanzata che utilizza ragionamento multi-step e analizza oltre 20-25 fonti per ricerche approfondite. S...

Scopri come ottimizzare i tuoi contenuti per Perplexity AI e farti citare nei risultati di ricerca in tempo reale. Scopri strategie di contenuti pronti per la c...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.