Quando il posizionamento SEO non equivale alla visibilità AI: il divario

Scopri perché alti posizionamenti su Google non garantiscono visibilità nelle AI. Comprendi il divario tra SEO e citazioni AI, e come ottimizzare per entrambi i...

Il grado in cui le piattaforme di intelligenza artificiale rivelano come selezionano e classificano le fonti durante la generazione delle risposte. La trasparenza del ranking AI si riferisce alla visibilità degli algoritmi e dei criteri che determinano quali fonti compaiono nelle risposte generate dall’AI, distinguendosi dalla tradizionale classificazione dei motori di ricerca. Questa trasparenza è fondamentale per creatori di contenuti, editori e utenti che devono comprendere come vengono selezionate e prioritarizzate le informazioni. Senza trasparenza, gli utenti non possono verificare la credibilità delle fonti né comprendere i potenziali bias nei contenuti generati dall’AI.

Il grado in cui le piattaforme di intelligenza artificiale rivelano come selezionano e classificano le fonti durante la generazione delle risposte. La trasparenza del ranking AI si riferisce alla visibilità degli algoritmi e dei criteri che determinano quali fonti compaiono nelle risposte generate dall’AI, distinguendosi dalla tradizionale classificazione dei motori di ricerca. Questa trasparenza è fondamentale per creatori di contenuti, editori e utenti che devono comprendere come vengono selezionate e prioritarizzate le informazioni. Senza trasparenza, gli utenti non possono verificare la credibilità delle fonti né comprendere i potenziali bias nei contenuti generati dall’AI.

La trasparenza del ranking AI si riferisce alla divulgazione di come i sistemi di intelligenza artificiale selezionano, prioritizzano e presentano le fonti durante la generazione delle risposte alle domande degli utenti. A differenza dei motori di ricerca tradizionali che mostrano elenchi ordinati di link, le moderne piattaforme AI come Perplexity, ChatGPT e le AI Overviews di Google integrano la selezione delle fonti nel processo di generazione delle risposte, rendendo i criteri di ranking in gran parte invisibili all’utente. Questa opacità crea un divario critico tra ciò che l’utente vede (una risposta sintetizzata) e come quella risposta è stata costruita (quali fonti sono state scelte, pesate e citate). Per creatori di contenuti ed editori, questa mancanza di trasparenza significa che la loro visibilità dipende da algoritmi che non possono comprendere né influenzare tramite i metodi di ottimizzazione tradizionali. La differenza rispetto alla trasparenza dei motori di ricerca tradizionali è significativa: mentre Google pubblica fattori di ranking e linee guida generali sulla qualità, le piattaforme AI spesso trattano i propri meccanismi di selezione delle fonti come segreti commerciali proprietari. I principali stakeholder coinvolti includono creatori di contenuti che cercano visibilità, editori preoccupati per l’attribuzione del traffico, brand manager che monitorano la reputazione, ricercatori che verificano le fonti informative e utenti che hanno bisogno di capire la credibilità delle risposte generate dall’AI. Comprendere la trasparenza del ranking AI è diventato essenziale per chiunque produca, distribuisca o si affidi a contenuti digitali in un panorama informativo sempre più mediato dall’intelligenza artificiale.

Le piattaforme AI utilizzano sistemi di Retrieval-Augmented Generation (RAG) che combinano modelli linguistici con il recupero di informazioni in tempo reale per ancorare le risposte a fonti reali invece di affidarsi solo ai dati di addestramento. Il processo RAG si articola in tre fasi principali: retrieval (ricerca di documenti rilevanti), ranking (ordinamento delle fonti per rilevanza) e generation (sintesi delle informazioni mantenendo le citazioni). Diverse piattaforme implementano approcci di ranking distinti—Perplexity dà priorità all’autorità e all’attualità della fonte, le AI Overviews di Google enfatizzano la rilevanza tematica e i segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità), mentre ChatGPT Search bilancia la qualità delle fonti con la completezza della risposta. I fattori che influenzano la selezione delle fonti generalmente includono autorità del dominio (reputazione consolidata e profilo dei backlink), attualità dei contenuti (freschezza delle informazioni), rilevanza tematica (allineamento semantico con la query), segnali di coinvolgimento (metriche di interazione utente) e frequenza di citazione (quanto spesso le fonti sono referenziate da altri siti autorevoli). I sistemi AI ponderano questi segnali in modo diverso a seconda dell’intento della query—le richieste fattuali possono privilegiare autorità e attualità, mentre le richieste opinione possono enfatizzare prospettive diverse e coinvolgimento. Gli algoritmi di ranking rimangono in gran parte non divulgati, anche se la documentazione delle piattaforme offre un’idea limitata dei meccanismi di pesatura.

| Piattaforma | Trasparenza Citazioni | Criteri di Selezione delle Fonti | Divulgazione Algoritmo di Ranking | Controllo Utente |

|---|---|---|---|---|

| Perplexity | Alta - citazioni in linea con link | Autorità, attualità, rilevanza, competenza tematica | Moderata - un po’ di documentazione | Media - opzioni di filtraggio fonti |

| Google AI Overviews | Media - fonti citate elencate | E-E-A-T, rilevanza tematica, freschezza, coinvolgimento | Bassa - minima divulgazione | Bassa - personalizzazione limitata |

| ChatGPT Search | Media - fonti elencate separatamente | Qualità, rilevanza, completezza, autorità | Bassa - algoritmo proprietario | Bassa - nessuna personalizzazione ranking |

| Brave Leo | Media - attribuzione delle fonti | Fonti privacy-respecting, rilevanza, autorità | Bassa - opacità orientata alla privacy | Media - opzioni di selezione fonti |

| Consensus | Molto alta - focus accademico con metriche | Numero citazioni, revisione paritaria, attualità, rilevanza campo | Alta - standard accademici trasparenti | Alta - filtro per tipo e qualità studio |

L’industria AI manca di pratiche standardizzate di divulgazione su come funzionano i sistemi di ranking, creando un panorama frammentato in cui ogni piattaforma stabilisce il proprio livello di trasparenza. ChatGPT Search di OpenAI offre spiegazioni minime sulla selezione delle fonti, i sistemi AI di Meta forniscono documentazione limitata e le AI Overviews di Google divulgano più dei concorrenti ma ancora trattengono dettagli algoritmici fondamentali. Le piattaforme resistono a una piena divulgazione citando vantaggio competitivo, questioni di proprietà intellettuale e la complessità di spiegare sistemi di machine learning a un pubblico generale—ma questa opacità impedisce audit esterni e accountability. Il problema del “source laundering” emerge quando i sistemi AI citano fonti che a loro volta aggregano o riscrivono contenuti originali, oscurando la vera origine delle informazioni e potenzialmente amplificando la disinformazione attraverso molteplici livelli di sintesi. Cresce la pressione normativa: l’EU AI Act richiede ai sistemi AI ad alto rischio di mantenere documentazione sui dati di addestramento e sui processi decisionali, mentre la NTIA AI Accountability Policy chiede alle aziende di divulgare capacità, limiti e casi d’uso appropriati dei sistemi AI. Fallimenti di divulgazione specifici includono le iniziali difficoltà di Perplexity nell’attribuzione corretta (poi migliorate), la spiegazione vaga di Google su come le AI Overviews selezionano le fonti e la trasparenza limitata di ChatGPT su perché alcune fonti appaiono nelle risposte e altre no. L’assenza di metriche standardizzate per misurare la trasparenza rende difficile per utenti e regolatori confrontare oggettivamente le piattaforme.

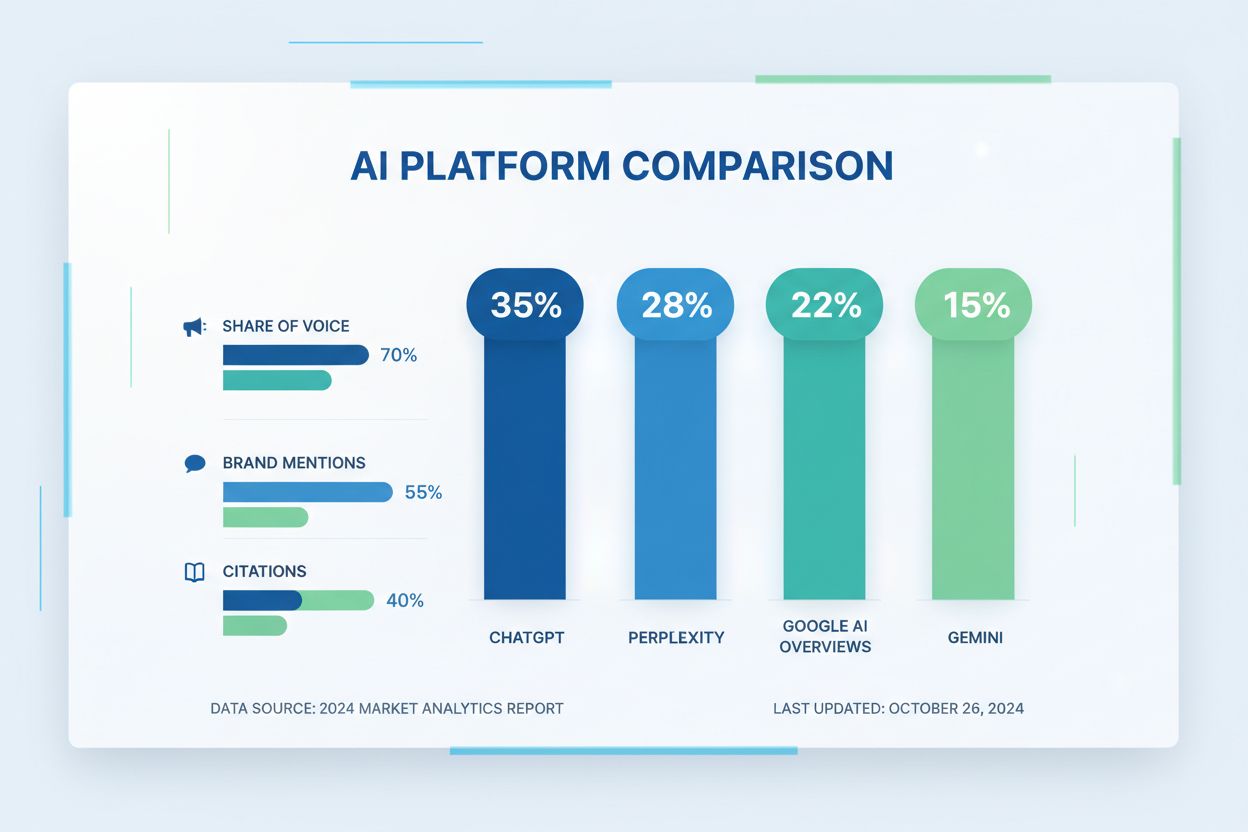

L’opacità dei sistemi di ranking AI crea rilevanti difficoltà di visibilità per i creatori di contenuti, poiché le strategie SEO tradizionali pensate per i motori di ricerca non si traducono direttamente in ottimizzazione per piattaforme AI. Gli editori non possono facilmente capire perché i loro contenuti appaiono in alcune risposte AI ma non in altre, rendendo impossibile sviluppare strategie mirate per migliorare la visibilità nelle risposte generate dall’intelligenza artificiale. Si genera un bias di citazione quando i sistemi AI favoriscono in modo sproporzionato certe fonti—grandi testate, istituzioni accademiche o siti ad alto traffico—a discapito di editori più piccoli, creatori indipendenti ed esperti di nicchia che potrebbero avere informazioni altrettanto valide. Gli editori minori sono particolarmente svantaggiati perché i sistemi di ranking AI spesso pesano fortemente l’autorità del dominio, e siti nuovi o specializzati non hanno i backlink o la notorietà dei grandi brand. Una ricerca di Search Engine Land indica che le AI Overviews hanno ridotto il click-through verso i risultati di ricerca tradizionali dal 18 al 64% a seconda del tipo di query, con il traffico concentrato tra le poche fonti citate nelle risposte AI. La distinzione tra SEO (Search Engine Optimization) e GEO (Generative Engine Optimization) diventa cruciale—mentre la SEO punta al ranking nella ricerca tradizionale, la GEO richiede comprensione e ottimizzazione per i criteri di selezione delle piattaforme AI, che restano per lo più opachi. I creatori di contenuti necessitano di strumenti come AmICited.com per monitorare dove appaiono i loro contenuti nelle risposte AI, tracciare la frequenza di citazione e comprendere la propria visibilità sulle diverse piattaforme AI.

L’industria AI ha sviluppato diversi framework per documentare e divulgare il comportamento dei sistemi, anche se l’adozione resta incoerente tra le piattaforme. Le Model Card forniscono una documentazione standardizzata sulle prestazioni dei modelli di machine learning, casi d’uso previsti, limitazioni e analisi dei bias—simili alle etichette nutrizionali per i sistemi AI. Le Datasheet for Datasets documentano composizione, metodologia di raccolta e potenziali bias dei dati di addestramento, affrontando il principio che i sistemi AI sono efficaci quanto le informazioni su cui vengono addestrati. Le System Card adottano un approccio più ampio, documentando il comportamento del sistema end-to-end inclusa l’interazione tra componenti, possibili modalità di errore e prestazioni nel mondo reale su diversi gruppi di utenti. La NTIA AI Accountability Policy raccomanda che le aziende mantengano dettagliata documentazione sullo sviluppo, il test e il deployment dei sistemi AI, con particolare attenzione alle applicazioni ad alto rischio per il benessere pubblico. L’EU AI Act impone ai sistemi AI ad alto rischio di mantenere documentazione tecnica, registri dei dati di addestramento e log delle prestazioni, con obblighi di report di trasparenza e notifica agli utenti. Le best practice di settore includono sempre più:

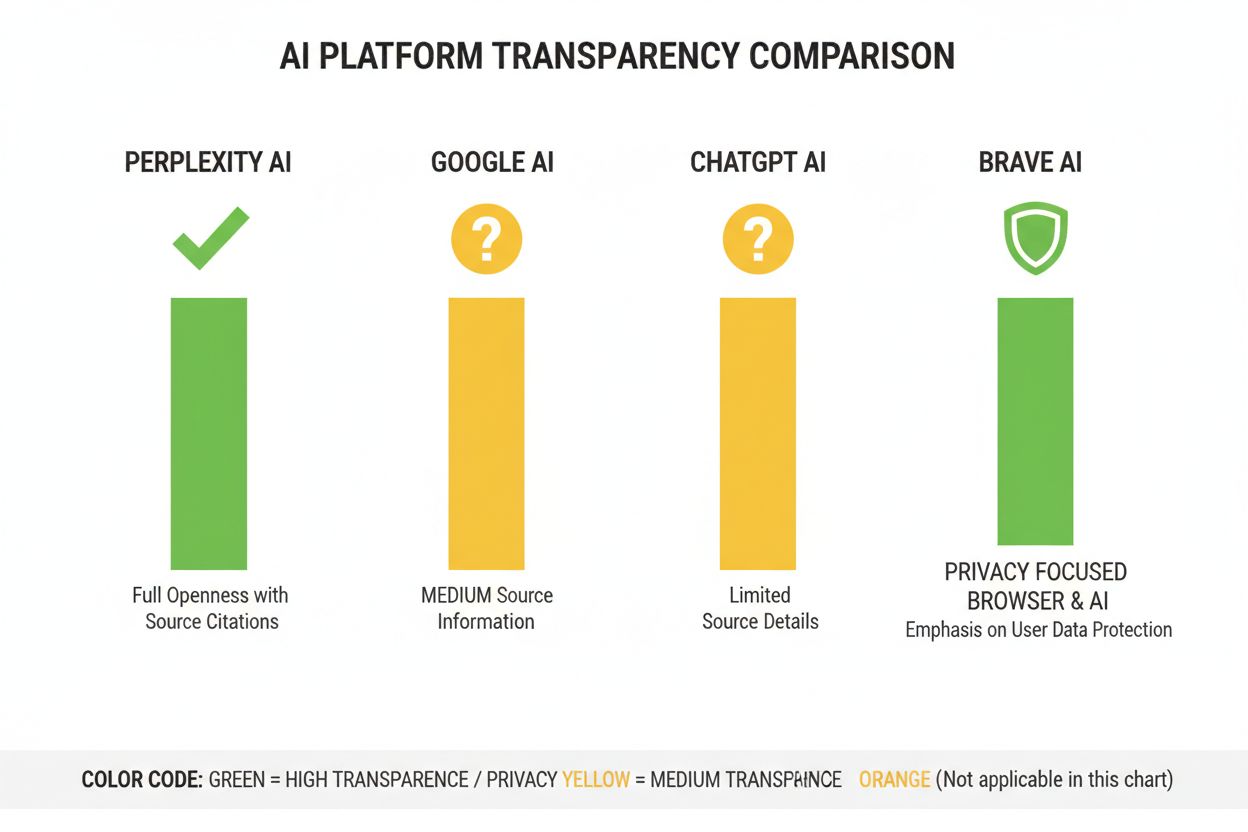

Perplexity si è posizionata come la piattaforma AI più trasparente per quanto riguarda le citazioni, mostrando link alle fonti direttamente nelle risposte e consentendo agli utenti di vedere esattamente quali fonti hanno contribuito a ciascuna affermazione. La piattaforma fornisce una documentazione piuttosto chiara del proprio approccio di ranking, enfatizzando autorità della fonte, competenza tematica e attualità dei contenuti, anche se la pesatura precisa di questi fattori resta proprietaria. Le AI Overviews di Google offrono una trasparenza moderata elencando le fonti citate alla fine delle risposte, ma spiegano poco sul motivo per cui alcune fonti vengono selezionate rispetto ad altre o su come l’algoritmo di ranking pondera i diversi segnali. La documentazione di Google enfatizza i principi E-E-A-T ma non rivela pienamente come questi vengano misurati o pesati nel ranking AI. ChatGPT Search di OpenAI rappresenta una soluzione intermedia, mostrando le fonti separatamente dal testo della risposta e permettendo agli utenti di consultare i contenuti originali, ma offrendo spiegazioni minime sui criteri di selezione o sulla metodologia di ranking. Brave Leo privilegia una trasparenza orientata alla privacy, dichiarando l’uso di fonti che rispettano la privacy e l’assenza di tracciamento delle query degli utenti, anche se ciò comporta spiegazioni meno dettagliate dei meccanismi di ranking. Consensus si distingue per il focus esclusivo sulla ricerca accademica, offrendo trasparenza elevata tramite metriche di citazione, stato di revisione paritaria e indicatori di qualità degli studi—rendendola la piattaforma più trasparente dal punto di vista algoritmico per le query di ricerca. Il controllo utente varia significativamente: Perplexity consente il filtraggio delle fonti, Consensus permette il filtro per tipo e qualità di studio, mentre Google e ChatGPT offrono minima personalizzazione delle preferenze di ranking. La varietà negli approcci riflette modelli di business e pubblici target diversi, con le piattaforme accademiche che privilegiano la divulgazione, mentre quelle consumer bilanciano trasparenza e tutela dei segreti industriali.

Fiducia e credibilità dipendono fondamentalmente dal fatto che gli utenti comprendano come ricevono le informazioni—quando i sistemi AI oscurano le fonti o la logica del ranking, gli utenti non possono verificare autonomamente le affermazioni né valutare l’affidabilità delle fonti. La trasparenza consente verifica e fact-checking, permettendo a ricercatori, giornalisti e utenti informati di risalire alle fonti originali e valutarne accuratezza e contesto. I benefici in termini di prevenzione di disinformazione e bias sono notevoli: quando gli algoritmi di ranking sono visibili, i ricercatori possono individuare bias sistematici (come la preferenza per certe prospettive politiche o interessi commerciali), e le piattaforme possono essere chiamate a rispondere per la diffusione di informazioni false. L’accountability algoritmica rappresenta un diritto fondamentale dell’utente nelle società democratiche—le persone meritano di sapere come funzionano i sistemi che modellano il loro ambiente informativo, soprattutto quando influenzano opinione pubblica, decisioni di acquisto e accesso alla conoscenza. Per la ricerca e il lavoro accademico, la trasparenza è essenziale perché gli studiosi devono comprendere la selezione delle fonti per contestualizzare correttamente i riassunti AI e assicurarsi di non fare affidamento involontariamente su set di fonti parziali o distorte. Le implicazioni di business per i creatori di contenuti sono profonde: senza conoscere i fattori di ranking, gli editori non possono ottimizzare la strategia dei contenuti, i creatori minori non possono competere equamente con le grandi realtà e l’intero ecosistema diventa meno meritocratico. La trasparenza protegge anche gli utenti dalla manipolazione—quando i criteri di ranking sono nascosti, attori malintenzionati possono sfruttare vulnerabilità sconosciute per promuovere contenuti fuorvianti, mentre sistemi trasparenti possono essere auditati e migliorati.

Le tendenze normative stanno portando verso la trasparenza obbligatoria: l’implementazione dell’EU AI Act nel 2025-2026 richiederà documentazione e divulgazione dettagliata per i sistemi AI ad alto rischio, mentre regolamentazioni simili stanno emergendo nel Regno Unito, in California e altrove. L’industria si muove verso la standardizzazione delle pratiche di trasparenza, con organizzazioni come Partnership on AI e istituzioni accademiche che sviluppano framework comuni per la documentazione e la divulgazione del comportamento dei sistemi AI. La domanda degli utenti di trasparenza è in crescita man mano che aumenta la consapevolezza del ruolo dell’AI nella distribuzione delle informazioni—i sondaggi indicano che oltre il 70% degli utenti vuole capire come i sistemi AI selezionano le fonti e classificano le informazioni. Le innovazioni tecniche nell’explainable AI (XAI) rendono sempre più fattibile fornire spiegazioni dettagliate delle decisioni di ranking senza svelare completamente gli algoritmi proprietari, tramite tecniche come LIME (Local Interpretable Model-agnostic Explanations) e SHAP (SHapley Additive exPlanations). Strumenti di monitoraggio come AmICited.com diventeranno sempre più importanti man mano che le piattaforme implementano misure di trasparenza, aiutando creatori di contenuti ed editori a monitorare la propria visibilità su diversi sistemi AI e capire come i cambiamenti nel ranking influenzano la propria portata. La convergenza tra requisiti normativi, aspettative degli utenti e capacità tecniche suggerisce che il biennio 2025-2026 sarà cruciale per la trasparenza del ranking AI, con le piattaforme che probabilmente adotteranno pratiche di divulgazione più standardizzate, implementeranno migliori controlli utente sulla selezione delle fonti e forniranno spiegazioni più chiare della logica di ranking. Il panorama futuro vedrà probabilmente una trasparenza a livelli—le piattaforme accademiche e di ricerca leader con alta divulgazione, le piattaforme consumer con trasparenza moderata e opzioni di personalizzazione utente, e la compliance normativa come aspettativa di base in tutto il settore.

La trasparenza del ranking AI si riferisce a quanto apertamente le piattaforme AI rivelano i loro algoritmi per la selezione e la classificazione delle fonti nelle risposte generate. È importante perché gli utenti devono comprendere la credibilità delle fonti, i creatori di contenuti devono ottimizzare la visibilità nell’AI, e i ricercatori devono verificare le fonti informative. Senza trasparenza, i sistemi AI possono amplificare la disinformazione e creare vantaggi sleali per realtà affermate rispetto a editori più piccoli.

Le piattaforme AI utilizzano sistemi Retrieval-Augmented Generation (RAG) che combinano modelli linguistici con il recupero di informazioni in tempo reale. Classificano le fonti in base a fattori come autorità del dominio, attualità dei contenuti, rilevanza tematica, segnali di coinvolgimento e frequenza di citazione. Tuttavia, il peso esatto di questi fattori rimane in gran parte proprietario e non divulgato dalla maggior parte delle piattaforme.

La SEO tradizionale si concentra sul ranking nelle liste di link dei motori di ricerca, dove Google pubblica fattori di ranking generali. La trasparenza del ranking AI riguarda come le piattaforme AI selezionano le fonti per le risposte sintetizzate, che coinvolgono criteri diversi e sono in gran parte non divulgati. Mentre le strategie SEO sono ben documentate, i fattori di ranking AI restano per lo più opachi.

Puoi cliccare sulle fonti originali per verificare le affermazioni nel loro contesto completo, controllare se le fonti provengono da domini autorevoli, cercare lo stato di revisione paritaria (soprattutto nei contenuti accademici) e confrontare le informazioni tra più fonti. Strumenti come AmICited aiutano a tracciare quali fonti appaiono nelle risposte AI e con quale frequenza i tuoi contenuti vengono citati.

Consensus è leader nella trasparenza, concentrandosi esclusivamente su ricerche accademiche sottoposte a revisione paritaria con metriche di citazione chiare. Perplexity fornisce citazioni fonte in linea e una documentazione moderata dei fattori di ranking. Le AI Overviews di Google offrono una trasparenza media, mentre ChatGPT Search e Brave Leo forniscono una divulgazione limitata dei loro algoritmi di ranking.

Le model card sono documentazioni standardizzate sulle prestazioni dei sistemi AI, casi d’uso previsti, limitazioni e analisi dei bias. Le datasheet documentano composizione dei dati di addestramento, metodi di raccolta e potenziali bias. Le system card descrivono il comportamento del sistema end-to-end. Questi strumenti rendono i sistemi AI più trasparenti e confrontabili, analogamente alle etichette nutrizionali per il cibo.

L’EU AI Act richiede ai sistemi AI ad alto rischio di mantenere una documentazione tecnica dettagliata, registri dei dati di addestramento e log delle prestazioni. Impone rapporti di trasparenza e la notifica agli utenti sull’uso di sistemi AI. Questi requisiti stanno spingendo le piattaforme AI verso una maggiore divulgazione dei meccanismi di ranking e dei criteri di selezione delle fonti.

AmICited.com è una piattaforma di monitoraggio delle citazioni AI che traccia come sistemi AI come Perplexity, Google AI Overviews e ChatGPT citano il tuo brand e i tuoi contenuti. Offre visibilità su quali fonti compaiono nelle risposte AI, con quale frequenza i tuoi contenuti vengono citati e come la tua trasparenza nel ranking si confronta tra diverse piattaforme AI.

Traccia come le piattaforme AI come Perplexity, Google AI Overviews e ChatGPT citano i tuoi contenuti. Comprendi la tua trasparenza nel ranking e ottimizza la tua visibilità nei motori di ricerca AI con AmICited.

Scopri perché alti posizionamenti su Google non garantiscono visibilità nelle AI. Comprendi il divario tra SEO e citazioni AI, e come ottimizzare per entrambi i...

Scopri come analizzare la visibilità AI dei competitor, individuare i gap nella share of voice e ottimizzare la presenza del tuo brand su ChatGPT, Perplexity e ...

Scopri come collegare le metriche di visibilità AI a risultati di business misurabili. Traccia le menzioni del brand in ChatGPT, Perplexity e Google AI Overview...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.