Come funzionano i motori di ricerca AI: Architettura, Recupero e Generazione

Scopri come funzionano i motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Scopri LLM, RAG, ricerca semantica e meccanismi di recupero in tem...

Un motore di ricerca AI è una piattaforma che utilizza l’intelligenza artificiale, l’elaborazione del linguaggio naturale e i grandi modelli linguistici per interpretare le query degli utenti e generare risposte dirette e conversazionali sintetizzate da fonti web, invece di mostrare tradizionali elenchi di link. Queste piattaforme sfruttano la generazione aumentata dal recupero (RAG) per fornire informazioni attuali e citate con accesso web in tempo reale.

Un motore di ricerca AI è una piattaforma che utilizza l'intelligenza artificiale, l'elaborazione del linguaggio naturale e i grandi modelli linguistici per interpretare le query degli utenti e generare risposte dirette e conversazionali sintetizzate da fonti web, invece di mostrare tradizionali elenchi di link. Queste piattaforme sfruttano la generazione aumentata dal recupero (RAG) per fornire informazioni attuali e citate con accesso web in tempo reale.

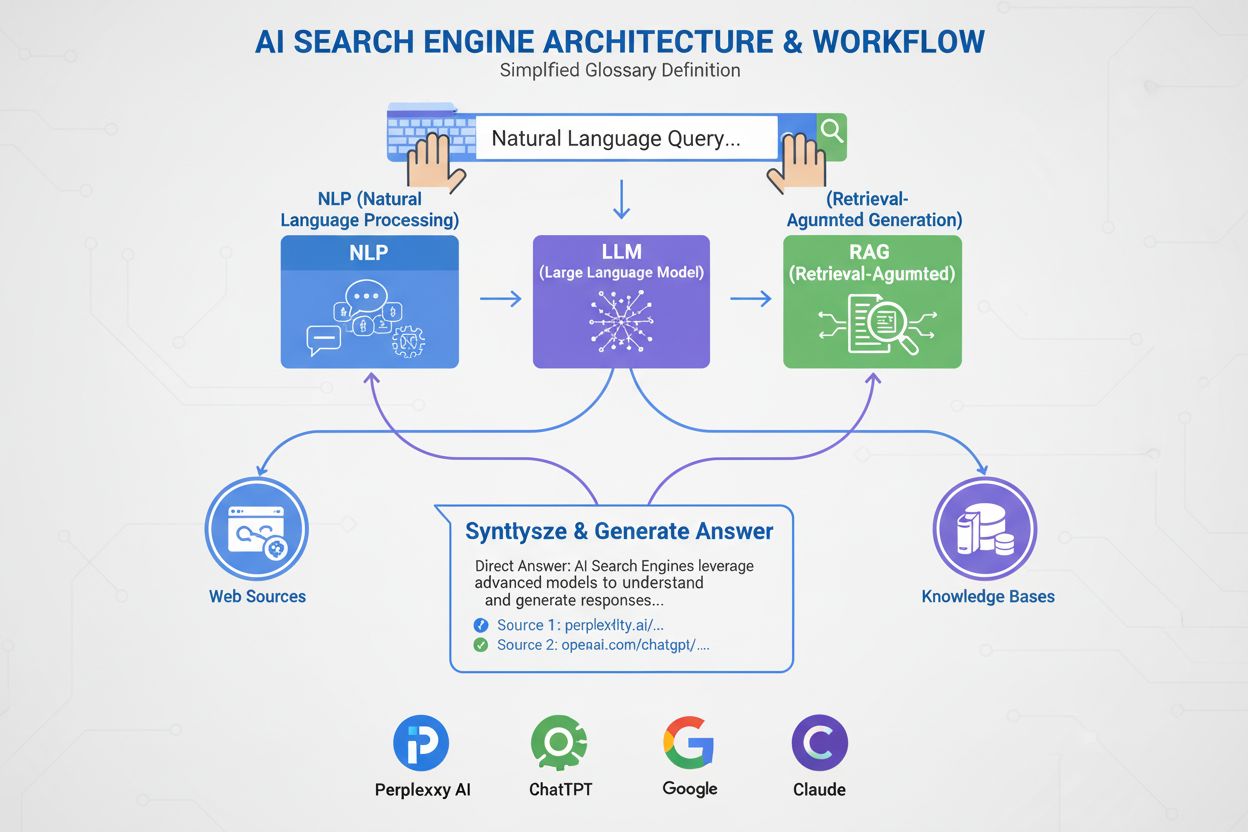

Un motore di ricerca AI è una piattaforma che utilizza intelligenza artificiale, elaborazione del linguaggio naturale (NLP) e grandi modelli linguistici (LLM) per interpretare le query degli utenti e generare risposte dirette e conversazionali sintetizzate da fonti web. Diversamente dai motori di ricerca tradizionali che mostrano elenchi di link, i motori di ricerca AI forniscono riassunti concisi e in linguaggio semplice che rispondono direttamente all’intento dell’utente. Queste piattaforme sfruttano la generazione aumentata dal recupero (RAG) per combinare il recupero web in tempo reale con la sintesi generativa AI, consentendo loro di fornire informazioni attuali e citate. I motori di ricerca AI rappresentano un cambiamento fondamentale nel modo in cui le persone scoprono informazioni online, passando da elenchi di link basati su parole chiave a comprensione semantica e risposte dirette. La tecnologia alla base di questi sistemi integra molteplici discipline AI—including ricerca semantica, riconoscimento di entità e AI conversazionale—per creare un’esperienza di ricerca più intuitiva ed efficiente.

L’emergere dei motori di ricerca AI segna una significativa evoluzione nella tecnologia di recupero delle informazioni. Per decenni, i motori di ricerca hanno operato su un paradigma di corrispondenza di parole chiave, dove la rilevanza era determinata dalla presenza e dalla frequenza dei termini di ricerca nei documenti indicizzati. Tuttavia, l’ascesa dei grandi modelli linguistici e i progressi nella comprensione del linguaggio naturale hanno cambiato radicalmente le possibilità. Il mercato globale dei motori di ricerca AI ha raggiunto 15,23 miliardi di USD nel 2024 e si prevede registrerà un tasso di crescita annuale composto (CAGR) del 16,8% fino al 2032, secondo le ricerche di mercato. Questa crescita esplosiva riflette sia l’adozione aziendale che la domanda dei consumatori per esperienze di ricerca più intelligenti e conversazionali.

L’AI generativa ha trasformato il modo in cui le persone scoprono informazioni online, spingendo la ricerca oltre il familiare elenco di link blu verso risposte più dirette e conversazionali. Leader di settore come Google e Microsoft Bing hanno rapidamente integrato l’AI nelle loro piattaforme per tenere il passo con stelle nascenti come Perplexity e You.com. Secondo una ricerca McKinsey, circa il 50% delle ricerche Google già dispone di riassunti AI, una cifra destinata a salire a oltre il 75% entro il 2028. Questo cambiamento non è solo una questione di interfaccia utente—sta ridefinendo la strategia dei contenuti e l’ottimizzazione per i motori di ricerca in una nuova era chiamata “generative engine optimization” (GEO).

La transizione riflette una più ampia adozione organizzativa delle tecnologie AI. Il 78% delle organizzazioni ha dichiarato di utilizzare l’AI nel 2024, rispetto al 55% dell’anno precedente, secondo il rapporto Stanford’s AI Index. Per i professionisti di ricerca e marketing, ciò significa che la visibilità dipende ora dalla comprensione di come i sistemi AI analizzano, condensano e reiterano i contenuti in riassunti in linguaggio semplice. La sfida è che le risposte generate dall’AI spesso deviano completamente il traffico dai siti web originali, creando sia opportunità che sfide per i creatori di contenuti e i brand in cerca di visibilità in questo nuovo scenario.

I motori di ricerca AI operano tramite una sofisticata pipeline a più stadi che combina recupero, ranking e sintesi. Il processo inizia con la comprensione della query, in cui il sistema analizza l’input dell’utente utilizzando l’elaborazione del linguaggio naturale per estrarre significato, intento e contesto. Anziché trattare la query come una semplice stringa di parole chiave, il sistema crea più rappresentazioni: una forma lessicale per il recupero ad abbinamento esatto, un embedding denso per la ricerca semantica e una forma entità per il matching su knowledge graph.

Una volta compresa la query, la maggior parte dei motori di ricerca AI utilizza la generazione aumentata dal recupero (RAG), un modello architetturale centrale che affronta le debolezze fondamentali dei grandi modelli linguistici. RAG esegue un recupero live, cercando tra indici web o API per prelevare documenti e passaggi rilevanti. Questi candidati vengono poi riordinati da modelli più sofisticati che valutano congiuntamente la query e il candidato per produrre punteggi di rilevanza raffinati. I risultati con il punteggio più alto vengono inseriti in un grande modello linguistico come contesto di ancoraggio, che sintetizza una risposta conversazionale mantenendo fedeltà alle fonti recuperate.

Pipeline di recupero ibride sono standard tra le piattaforme leader. Queste combinano ricerca lessicale (basata su parole chiave, con algoritmi come BM25) e ricerca semantica (basata su embedding, tramite similarità vettoriale). La ricerca lessicale eccelle nella precisione per corrispondenze esatte, termini rari ed entità nominate, mentre la ricerca semantica eccelle nel richiamo per contenuti concettualmente correlati. Unendo entrambi gli approcci e applicando il riordinamento cross-encoder, i motori di ricerca AI raggiungono una precisione superiore rispetto a ciascun metodo singolarmente. La fase finale di sintesi utilizza un grande modello linguistico per comporre una risposta coerente e in stile umano che integra informazioni da più fonti mantenendo accuratezza e fornendo citazioni.

| Aspetto | Motori di Ricerca Tradizionali | Motori di Ricerca AI |

|---|---|---|

| Formato dei Risultati | Elenchi di link con brevi frammenti | Riassunti conversazionali con risposte dirette |

| Elaborazione Query | Abbinamento di parole chiave e ranking | Comprensione semantica e analisi dell’intento |

| Meccanismo di Apprendimento | Riparte da zero a ogni query | Impara continuamente dalle interazioni e dal feedback utente |

| Recupero Informazioni | Abbinamento lessicale/parole chiave | Ibrido (lessicale + semantico + basato su entità) |

| Formati di Input | Solo testo | Testo, immagini, voce e video (multimodale) |

| Aggiornamenti in Tempo Reale | Basato su indice, crawling periodico | Accesso web in tempo reale tramite RAG |

| Comportamento delle Citazioni | Nessuna citazione; l’utente trova le fonti | Citazioni integrate e attribuzione delle fonti |

| Interazione Utente | Query singola, risultati statici | Conversazioni multi-turno con follow-up |

| Gestione Bias | I curatori organizzano le informazioni | La sintesi AI può introdurre bias dello sviluppatore |

| Rischio Allucinazioni | Basso (i link sono fattuali) | Più alto (gli LLM possono generare informazioni false) |

I diversi motori di ricerca AI implementano approcci architetturali distinti, ognuno con implicazioni di ottimizzazione uniche. AI Overviews e Modalità AI di Google impiegano una strategia di distribuzione delle query, dove una singola query dell’utente viene suddivisa in più sottoquery che mirano a diverse dimensioni d’intento. Queste sottoquery vengono eseguite in parallelo contro varie fonti dati—indice web, Knowledge Graph, trascrizioni YouTube, feed Google Shopping e indici specialistici. I risultati vengono aggregati, deduplicati e ordinati prima di essere sintetizzati in una panoramica. Per i professionisti GEO, ciò significa che i contenuti devono affrontare molteplici sfaccettature di una query in modo estraibile per sopravvivere al processo di distribuzione.

Bing Copilot rappresenta un approccio più tradizionale e nativo della ricerca, sfruttando l’infrastruttura di ranking matura di Bing di Microsoft e stratificando sopra la sintesi GPT-class. La piattaforma utilizza il recupero a doppio canale, combinando ricerca lessicale BM25 con ricerca semantica vettoriale densa. I risultati passano attraverso un riordinatore contestuale cross-encoder che si concentra sulla rilevanza a livello di passaggio piuttosto che sull’intera pagina. Questa architettura implica che i segnali SEO classici—crawlabilità, tag canonici, HTML pulito, velocità della pagina—restano molto importanti perché determinano quali candidati raggiungono il set di ancoraggio. Bing Copilot enfatizza anche l’estraibilità: i passaggi con ambito chiaro, elenchi, tabelle e frasi in stile definizione hanno più probabilità di essere citati.

Perplexity AI opera con trasparenza intenzionale, mostrando le fonti in evidenza prima della risposta generata stessa. La piattaforma esegue ricerche in tempo reale, spesso attingendo sia dagli indici Google che Bing, quindi valuta i candidati in base a una combinazione di rilevanza lessicale e semantica, autorità tematica ed estraibilità della risposta. Una ricerca che analizza 59 distinti fattori che influenzano il comportamento di ranking di Perplexity rivela che la piattaforma dà priorità alla formattazione della risposta diretta—le pagine che ripropongono esplicitamente la query in un titolo, seguite subito da una risposta concisa e ad alta densità di informazioni, sono ampiamente rappresentate nei set di citazione. Anche la prominenza e il collegamento delle entità giocano un ruolo importante; Perplexity favorisce passaggi in cui le entità chiave sono chiaramente nominate e collegate contestualmente a concetti correlati.

ChatGPT Search adotta un approccio opportunistico, generando query di ricerca dinamicamente e chiamando l’API Bing per recuperare URL specifici. Diversamente dalle piattaforme con indici persistenti, ChatGPT preleva i contenuti in tempo reale, quindi l’inclusione dipende interamente dalla recuperabilità in tempo reale. Se un sito è bloccato da robots.txt, lento a caricarsi, nascosto dietro rendering lato client o semanticamente opaco, non verrà utilizzato per la sintesi. Questa architettura dà priorità ad accessibilità e chiarezza: le pagine devono essere tecnicamente crawlabili, leggere e semanticamente trasparenti affinché i recuperi al volo restituiscano testo pulito e analizzabile.

L’elaborazione del linguaggio naturale (NLP) è la tecnologia fondamentale che consente ai motori di ricerca AI di andare oltre la corrispondenza di parole chiave. NLP permette ai sistemi di analizzare la struttura, la semantica e l’intento dietro le query di ricerca, comprendendo il contesto e riconoscendo sinonimi e concetti correlati. Quando un utente chiede “migliori posti dove mangiare vicino a me con tavoli all’aperto”, un sistema basato su NLP capisce che la query cerca ristoranti con terrazze, anche senza quelle esatte parole. Questa comprensione semantica consente ai motori di ricerca AI di fornire risultati utili anche quando l’intento è meno ovvio o espresso in modo conversazionale.

I grandi modelli linguistici (LLM) alimentano la fase di sintesi dei motori di ricerca AI. Addestrati su enormi quantità di dati testuali, gli LLM prevedono la parola più logica successiva in base al contesto, permettendo loro di produrre prosa coerente e grammaticalmente corretta che assomiglia molto a quella scritta da un umano. Tuttavia, gli LLM introducono anche rischi. Possono allucinare—presentando falsità come fatti—poiché generano testo dalla conoscenza probabilistica invece che citando fonti reali. Ecco perché la generazione aumentata dal recupero (RAG) è fondamentale: ancorando la sintesi degli LLM a fonti appena recuperate e autorevoli, i motori di ricerca AI riducono il rischio di allucinazione e migliorano la precisione dei fatti. Alcune piattaforme hanno incorporato citazioni articolo per articolo per contrastare ulteriormente le allucinazioni, anche se gli articoli citati a volte non sono accurati o addirittura non esistono.

I motori di ricerca AI si differenziano dai motori di ricerca tradizionali in diversi modi fondamentali. Primo, forniscono riassunti invece di link. I motori di ricerca regolari mostrano i risultati come elenchi di link con brevi frammenti, mentre i motori di ricerca AI generano riassunti concisi che rispondono direttamente alle query, risparmiando agli utenti la necessità di scorrere e cliccare su più siti. Secondo, la ricerca AI impara nel tempo, quella tradizionale riparte da zero a ogni query. I motori di ricerca AI sono progettati per apprendere e adattarsi continuamente alle interazioni degli utenti e ai nuovi dati, migliorando le prestazioni nel tempo. I motori di ricerca tradizionali lavorano da capo a ogni nuova query, senza considerare le precedenti o le interazioni utente.

Terzo, la ricerca AI si concentra sulla semantica, quella tradizionale sulle parole chiave. I motori di ricerca regolari dipendono soprattutto dalla corrispondenza di parole chiave per interpretare le query, mentre i motori di ricerca AI si concentrano sulla semantica—il significato più ampio delle parole nel contesto. Questo permette ai motori di ricerca AI di comprendere meglio l’intento dell’utente e fornire risultati che corrispondono più precisamente a ciò che l’utente cerca. Quarto, la ricerca AI accetta più formati di input, quella tradizionale solo testo. Alcuni motori di ricerca AI hanno capacità multimodali, il che significa che possono elaborare e comprendere informazioni da formati oltre il testo, come immagini, video e audio. Questo offre un’esperienza di ricerca più intuitiva e flessibile rispetto alla digitazione di parole chiave.

L’ascesa dei motori di ricerca AI sta rimodellando il modo in cui i brand affrontano la visibilità e la strategia dei contenuti. Invece di competere solo per il posizionamento delle parole chiave, editori e aziende ora devono considerare come i sistemi AI analizzano, condensano e reiterano i loro contenuti in riassunti in linguaggio semplice. Questo cambiamento ha inaugurato una nuova era di “generative engine optimization” (GEO), dove l’obiettivo non è solo posizionarsi ma essere recuperati, sintetizzati e citati dai sistemi AI.

Le ricerche indicano che anche la performance GEO dei leader di settore può essere inferiore alla SEO dal 20 al 50 percento, secondo l’analisi McKinsey. Questo divario riflette la natura nascente delle strategie GEO e la complessità dell’ottimizzazione simultanea per più piattaforme AI. Per i brand, le implicazioni sono significative: la visibilità nella ricerca AI dipende dal fatto che i contenuti siano recuperabili (compaiano nei risultati di ricerca), estraibili (strutturati in modo che i sistemi AI possano facilmente analizzarli e citarli) e affidabili (dimostrino competenza, autorevolezza e affidabilità). Strumenti di monitoraggio come AmICited ora tracciano le menzioni del brand sulle piattaforme AI—including Perplexity, ChatGPT, Google AI Overviews e Claude—per misurare questa nuova forma di visibilità e identificare opportunità di ottimizzazione.

Il panorama della ricerca AI si sta evolvendo rapidamente, con importanti implicazioni su come le informazioni vengono scoperte, distribuite e monetizzate. Il mercato globale dei motori di ricerca AI è previsto crescere a un CAGR del 16,8% fino al 2032, trainato dall’aumento dell’adozione aziendale e dalla domanda dei consumatori per esperienze di ricerca conversazionali e intelligenti. Man mano che i motori di ricerca AI maturano, possiamo aspettarci che emergano diverse tendenze chiave.

Primo, la consolidazione e la specializzazione probabilmente accelereranno. Mentre le piattaforme generaliste come Google, Bing e Perplexity continueranno a dominare, prolifereranno motori di ricerca AI specializzati in verticali specifici—legale, medico, tecnico, e-commerce. Questi motori offriranno maggiore competenza di dominio e una sintesi più accurata per query di nicchia. Secondo, i meccanismi di citazione e attribuzione diventeranno più sofisticati e standardizzati. Con l’aumento della pressione normativa e la richiesta di maggiore attribuzione da parte degli editori, i motori di ricerca AI probabilmente implementeranno sistemi di citazione più granulari che facilitano la tracciabilità delle affermazioni e la misurazione della visibilità.

Terzo, la definizione e la misurazione della “visibilità” cambierà radicalmente. Nell’era SEO tradizionale, la visibilità significava posizione nel ranking e tasso di clic. Nell’era GEO, la visibilità significa essere recuperati, sintetizzati e citati—metriche che richiedono nuovi strumenti e quadri di misurazione. AmICited e piattaforme simili stanno aprendo la strada in questo spazio, tracciando menzioni di brand su più piattaforme AI e fornendo insight su quanto spesso e in quali contesti i brand appaiono nelle risposte AI generate.

Quarto, la tensione tra ricerca AI e ricerca tradizionale si intensificherà. Man mano che i motori di ricerca AI catturano più attenzione e traffico degli utenti, i motori di ricerca tradizionali dovranno evolversi o rischiare l’obsolescenza. L’integrazione dell’AI nel prodotto di ricerca principale di Google rappresenta una risposta strategica a questa minaccia, ma il vincitore a lungo termine resta incerto. Editori e brand devono ottimizzare sia per la ricerca tradizionale che per quella AI, creando una strategia di contenuti più complessa e costosa.

Infine, fiducia e accuratezza diventeranno essenziali. Man mano che i motori di ricerca AI diventano fonti primarie di informazione, cresce l’importanza della precisione e della mitigazione dei bias. È probabile che emergano quadri normativi su trasparenza e responsabilità dell’AI, richiedendo ai motori di ricerca AI di divulgare dati di training, fattori di ranking e metodologie di citazione. Per brand e editori, questo significa che i segnali E-E-A-T—competenza, esperienza, autorevolezza e affidabilità—diventeranno ancora più critici per la visibilità sia nella ricerca tradizionale che in quella AI.

+++ showCTA = true ctaHeading = “Monitora la Visibilità del Tuo Brand sui Motori di Ricerca AI” ctaDescription = “Comprendere i motori di ricerca AI è solo il primo passo. Traccia dove e come appare il tuo brand su ChatGPT, Perplexity, Google AI Overviews e Claude con la piattaforma di monitoraggio AI search di AmICited. Misura la tua performance GEO, identifica opportunità di citazione e ottimizza i tuoi contenuti per la prossima generazione di ricerca.” ctaPrimaryText = “Contattaci” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Provalo Ora” ctaSecondaryURL = “https://app.amicited.com ” +++

I motori di ricerca tradizionali mostrano i risultati come elenchi di link con frammenti, mentre i motori di ricerca AI generano riassunti conversazionali che rispondono direttamente alle query. I motori di ricerca AI utilizzano l'elaborazione del linguaggio naturale e grandi modelli linguistici per comprendere semanticamente l'intento dell'utente invece di affidarsi esclusivamente alla corrispondenza di parole chiave. Imparano continuamente dalle interazioni degli utenti e possono elaborare diversi formati di input tra cui testo, immagini e voce. Inoltre, i motori di ricerca AI spesso forniscono accesso web in tempo reale tramite la generazione aumentata dal recupero (RAG), consentendo loro di offrire informazioni attuali con citazioni delle fonti.

La generazione aumentata dal recupero (RAG) è una tecnica che permette ai grandi modelli linguistici di recuperare e incorporare informazioni aggiornate da fonti esterne prima di generare le risposte. RAG affronta le limitazioni fondamentali degli LLM—allucinazioni e limiti di conoscenza—ancorando le risposte ai dati recuperati in tempo reale. Nei motori di ricerca AI, RAG funziona eseguendo prima una ricerca o un recupero live, prelevando documenti o frammenti rilevanti, quindi sintetizzando una risposta basata su questi elementi. Questo approccio garantisce che le risposte siano sia attuali che tracciabili a fonti specifiche, rendendo possibili le citazioni e migliorando la precisione dei fatti.

I principali motori di ricerca AI includono Perplexity (noto per le citazioni trasparenti), ChatGPT Search (alimentato da GPT-4o con accesso web in tempo reale), Google Gemini e AI Overviews (integrati con l'infrastruttura di ricerca di Google), Bing Copilot (basato sull'indice di ricerca Microsoft) e Claude (modello di Anthropic con ricerca web selettiva). Perplexity dà priorità al recupero in tempo reale e all'attribuzione visibile delle fonti, mentre ChatGPT genera query di ricerca in modo opportunistico. L'approccio di Google utilizza la distribuzione delle query per coprire molteplici dimensioni d'intento, mentre Bing CoPilot combina segnali SEO tradizionali con sintesi generativa. Ogni piattaforma presenta architetture di recupero, comportamenti di citazione e requisiti di ottimizzazione distinti.

I motori di ricerca AI seguono un processo a più stadi: prima analizzano la query dell'utente tramite l'elaborazione del linguaggio naturale per comprenderne l'intento; poi recuperano documenti o passaggi rilevanti da indici web o API tramite recupero ibrido (combinando ricerca lessicale e semantica); quindi riordinano i candidati in base a rilevanza ed estraibilità; infine sintetizzano una risposta conversazionale tramite un grande modello linguistico, inserendo citazioni ai documenti di origine. Il meccanismo di citazione varia a seconda della piattaforma—alcune mostrano citazioni in linea, altre elenchi di fonti, alcune integrano le citazioni nel testo stesso. La qualità e precisione delle citazioni dipendono da quanto bene i passaggi recuperati corrispondano alle affermazioni sintetizzate.

La generative engine optimization (GEO) è la pratica di ottimizzare i contenuti e la visibilità del brand specificamente per i motori di ricerca AI, a differenza della SEO tradizionale che mira al posizionamento delle parole chiave nei risultati di ricerca basati sui link. GEO si concentra nel rendere i contenuti recuperabili, estraibili e citabili dai sistemi AI. Le strategie GEO chiave includono la strutturazione dei contenuti per chiarezza e risposte dirette, l'uso di linguaggio naturale che corrisponde all'intento dell'utente, l'implementazione di markup di entità e schema, l'assicurare tempi di caricamento rapidi delle pagine e la costruzione di autorità tematica. Come mostra una ricerca McKinsey, circa il 50% delle ricerche Google già dispone di riassunti AI, con una previsione di oltre il 75% entro il 2028, rendendo GEO sempre più essenziale per la visibilità del brand.

I motori di ricerca AI possono sia aumentare che diminuire il traffico dei siti web a seconda di come i contenuti sono ottimizzati. Quando un contenuto viene citato nelle risposte AI, ottiene visibilità e credibilità, ma gli utenti possono ricevere la risposta direttamente senza cliccare sulla fonte. Le ricerche indicano che AI Overviews può deviare traffico dai siti originali, pur offrendo attribuzione e link alle fonti. Per i brand, ciò significa che la visibilità ora dipende dall'essere recuperati, sintetizzati e citati dai sistemi AI—non più solo dal posizionamento nei risultati tradizionali. Strumenti di monitoraggio come AmICited tracciano le menzioni del brand sulle piattaforme AI (Perplexity, ChatGPT, Google AI Overviews, Claude) per misurare questa nuova forma di visibilità e ottimizzare di conseguenza.

L'elaborazione del linguaggio naturale (NLP) è fondamentale per il modo in cui i motori di ricerca AI comprendono ed elaborano le query degli utenti. NLP consente ai sistemi di analizzare la struttura, la semantica e l'intento delle query, non solo di abbinare le parole chiave. Permette ai motori di ricerca AI di comprendere il contesto, disambiguare il significato e riconoscere sinonimi e concetti correlati. NLP alimenta anche la fase di sintesi, in cui i modelli linguistici generano risposte grammaticalmente corrette e coerenti che suonano naturali. Inoltre, NLP aiuta i motori di ricerca AI ad estrarre e strutturare le informazioni dalle pagine web, identificando entità chiave, relazioni e affermazioni che possono essere incorporate nelle risposte generate.

I motori di ricerca AI gestiscono le informazioni in tempo reale tramite la generazione aumentata dal recupero (RAG), che esegue ricerche live o chiamate API per ottenere dati aggiornati al momento della query invece di affidarsi solo ai dati di addestramento. Piattaforme come Perplexity e la Modalità AI di Google interrogano attivamente il web in tempo reale, garantendo risposte aggiornate. ChatGPT utilizza l'API di ricerca Bing per accedere a contenuti web attuali quando la navigazione è abilitata. I segnali di freschezza vengono anche integrati negli algoritmi di ranking—le pagine con date di pubblicazione recenti e contenuti aggiornati hanno un peso maggiore per le query sensibili al tempo. Tuttavia, alcuni motori di ricerca AI si basano ancora parzialmente sui dati di addestramento, che possono essere in ritardo rispetto agli eventi reali, rendendo il recupero in tempo reale un elemento chiave di differenziazione tra le piattaforme.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri come funzionano i motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews. Scopri LLM, RAG, ricerca semantica e meccanismi di recupero in tem...

Scopri come inviare e ottimizzare i tuoi contenuti per i motori di ricerca AI come ChatGPT, Perplexity e Gemini. Approfondisci strategie di indicizzazione, requ...

Scopri come funzionano gli indici di ricerca AI, le differenze tra i metodi di indicizzazione di ChatGPT, Perplexity e SearchGPT, e come ottimizzare i tuoi cont...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.