Finestra di contesto

Finestra di contesto spiegata: i token massimi che un LLM può elaborare in una volta. Scopri come le finestre di contesto influenzano l'accuratezza dell'IA, le ...

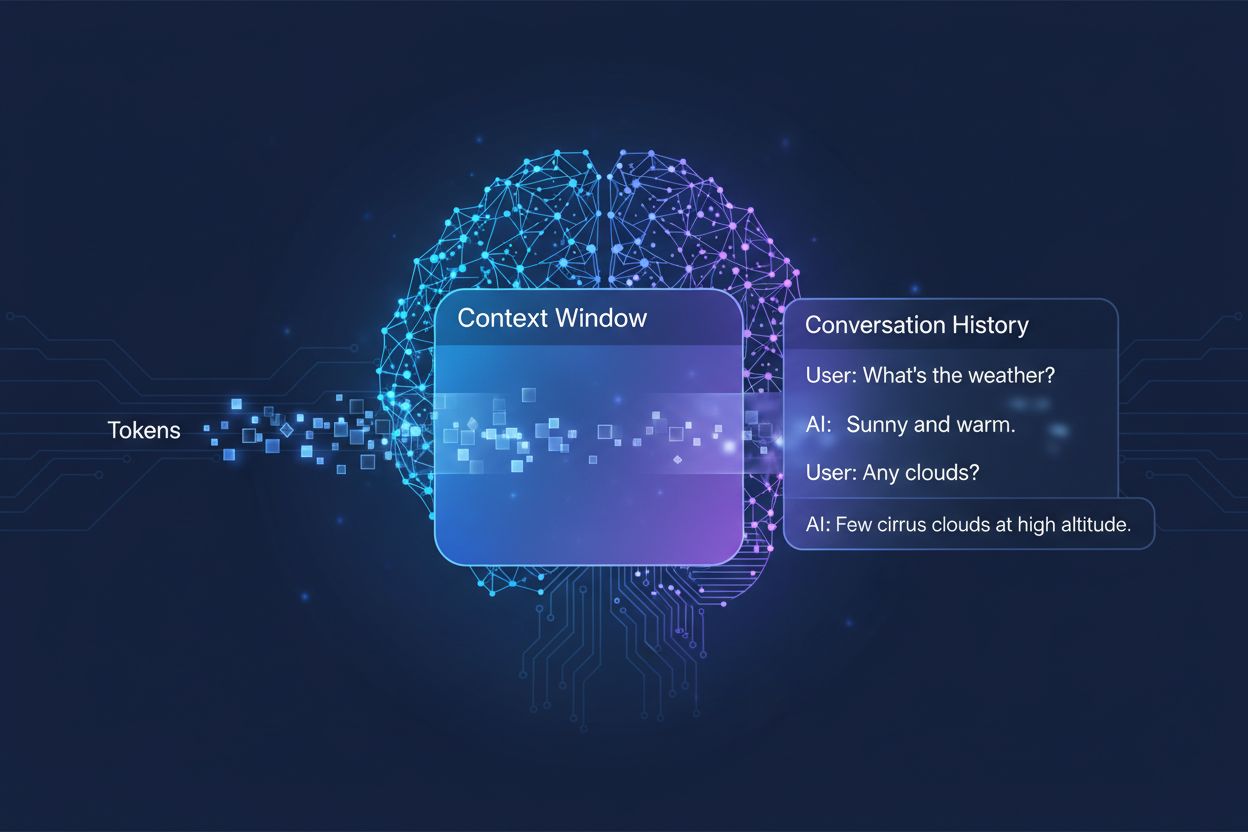

La quantità di conversazione precedente che un sistema di IA prende in considerazione quando genera risposte, misurata in token. Determina quanta parte del testo l’IA può elaborare simultaneamente e incide direttamente sulla qualità e coerenza delle sue risposte nelle conversazioni multi-turno.

La quantità di conversazione precedente che un sistema di IA prende in considerazione quando genera risposte, misurata in token. Determina quanta parte del testo l'IA può elaborare simultaneamente e incide direttamente sulla qualità e coerenza delle sue risposte nelle conversazioni multi-turno.

Una finestra di contesto è la quantità massima di testo che un modello linguistico di IA può elaborare e a cui può fare riferimento in un dato momento durante una conversazione o un compito. Puoi pensarla come la memoria di lavoro del modello: proprio come gli esseri umani possono trattenere solo una quantità limitata di informazioni nella loro consapevolezza immediata, anche i modelli di IA possono “vedere” solo una certa quantità di testo prima e dopo la loro posizione attuale. Questa capacità si misura in token, piccole unità di testo che tipicamente rappresentano parole o frammenti di parole (in media, una parola inglese equivale a circa 1,5 token). Comprendere la finestra di contesto del tuo modello è fondamentale perché determina direttamente quante informazioni l’IA può considerare durante la generazione delle risposte, rappresentando quindi una limitazione fondamentale su quanto efficacemente il modello possa gestire conversazioni complesse, multi-turno o documenti lunghi.

I modelli linguistici moderni, in particolare le architetture transformer, elaborano il testo convertendolo in token e analizzando poi simultaneamente le relazioni tra tutti i token all’interno della finestra di contesto. L’architettura transformer, introdotta nel celebre articolo del 2017 “Attention is All You Need”, utilizza un meccanismo chiamato self-attention per determinare quali parti dell’input sono più rilevanti tra loro. Questo meccanismo di attenzione consente al modello di valutare l’importanza dei diversi token gli uni rispetto agli altri, permettendogli di comprendere contesto e significato su tutta la finestra. Tuttavia, questo processo diventa sempre più oneroso dal punto di vista computazionale man mano che la finestra di contesto cresce, poiché il meccanismo di attenzione deve calcolare le relazioni tra ogni token e ogni altro token: un problema di scalabilità quadratica. La tabella seguente illustra come diversi modelli AI di punta si confrontano rispetto alle capacità della finestra di contesto:

| Modello | Finestra di contesto (token) | Data di rilascio |

|---|---|---|

| GPT-4 | 128.000 | Marzo 2023 |

| Claude 3 Opus | 200.000 | Marzo 2024 |

| Gemini 1.5 Pro | 1.000.000 | Maggio 2024 |

| GPT-4 Turbo | 128.000 | Novembre 2023 |

| Llama 2 | 4.096 | Luglio 2023 |

Queste diverse capacità riflettono scelte progettuali e compromessi computazionali adottati da ciascuna organizzazione: finestre più grandi consentono applicazioni più sofisticate ma richiedono più potenza di calcolo.

Il percorso verso finestre di contesto più ampie rappresenta uno dei progressi più significativi nelle capacità dell’IA dell’ultimo decennio. I primi recurrent neural networks (RNN) e i modelli long short-term memory (LSTM) avevano difficoltà con il contesto, poiché elaboravano il testo in modo sequenziale e faticavano a mantenere informazioni provenienti da parti distanti dell’input. Il salto di qualità è arrivato nel 2017 con l’introduzione dell’architettura Transformer, che ha permesso l’elaborazione parallela di intere sequenze e ha migliorato notevolmente la capacità del modello di mantenere il contesto su testi più lunghi. Questa base ha portato al GPT-2 del 2019, che ha dimostrato capacità di generazione linguistica impressionanti con una finestra di contesto di 1.024 token, seguito dal GPT-3 del 2020 con 2.048 token e infine dal GPT-4 del 2023 con 128.000 token. Ogni progresso è stato fondamentale perché ha esteso ciò che era possibile: finestre più ampie hanno permesso ai modelli di gestire documenti più lunghi, mantenere la coerenza nelle conversazioni multi-turno e comprendere relazioni complesse tra concetti distanti nel testo. La crescita esponenziale delle dimensioni delle finestre di contesto riflette sia innovazioni architetturali sia l’incremento delle risorse computazionali a disposizione dei principali laboratori di IA.

Finestre di contesto più grandi ampliano in modo fondamentale ciò che i modelli di IA possono realizzare, abilitando applicazioni precedentemente impossibili o fortemente limitate. Ecco i benefici principali:

Continuità conversazionale migliorata: i modelli possono mantenere traccia dell’intera storia della conversazione, riducendo la necessità di spiegare nuovamente il contesto e permettendo dialoghi multi-turno più naturali, coerenti e continui.

Elaborazione documentale su larga scala: finestre più ampie consentono all’IA di analizzare interi documenti, articoli scientifici o codebase in un’unica passata, individuando schemi e relazioni su tutto il contenuto senza perdere informazioni delle sezioni iniziali.

Ragionamento e analisi potenziati: con più contesto a disposizione, i modelli possono svolgere compiti di ragionamento più sofisticati che richiedono la comprensione di relazioni tra concetti multipli, risultando più efficaci per ricerca, analisi e risoluzione di problemi complessi.

Riduzione dell’onere di reinserimento del contesto: gli utenti non devono più riassumere o reintrodurre informazioni ripetutamente; il modello può fare riferimento all’intera storia della conversazione, riducendo gli attriti e migliorando l’efficienza nei flussi di lavoro collaborativi.

Gestione migliore di compiti complessi: applicazioni come la revisione di documenti legali, l’analisi di cartelle cliniche e l’audit di codice beneficiano notevolmente della possibilità di considerare il contesto in modo completo, ottenendo risultati più accurati ed esaustivi.

Flussi di lavoro multidocumento senza soluzione di continuità: i professionisti possono lavorare con più documenti correlati contemporaneamente, permettendo al modello di incrociare informazioni e individuare collegamenti che sarebbero impossibili con finestre di contesto più ridotte.

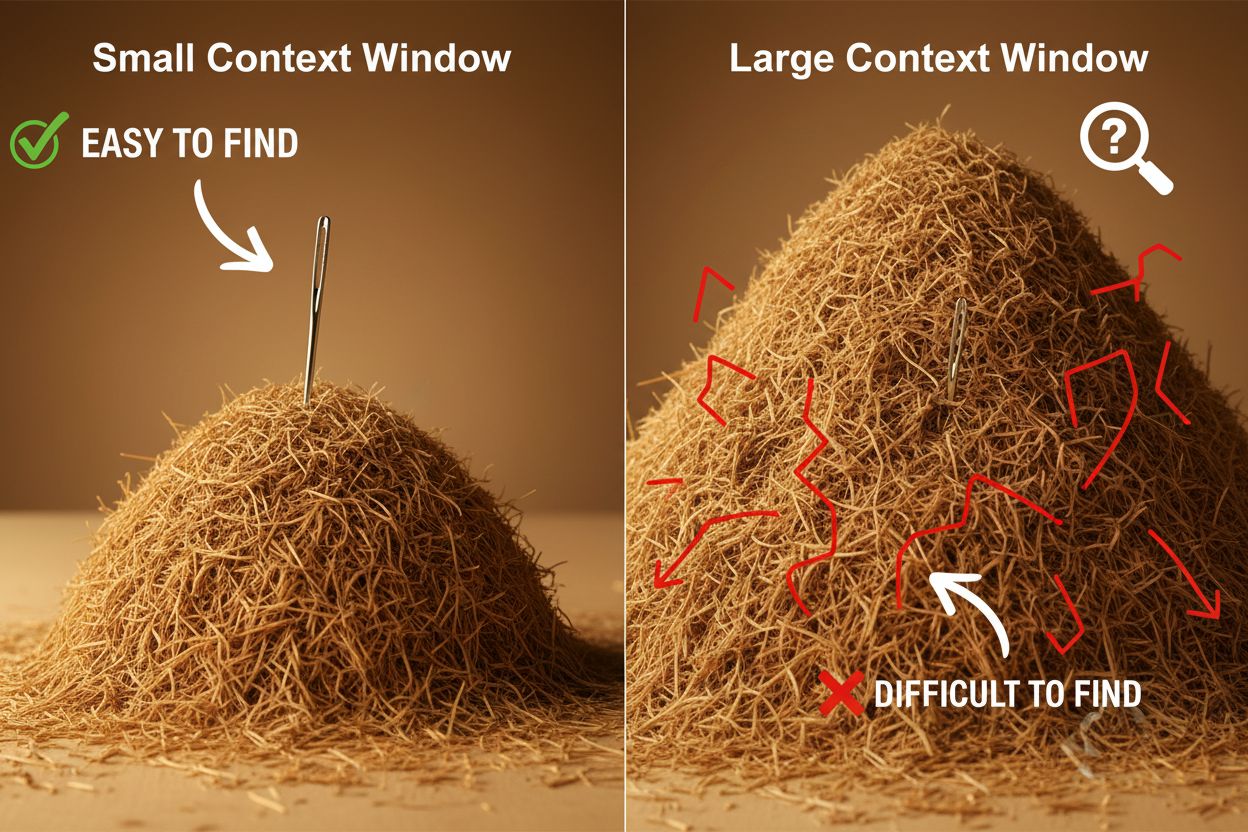

Nonostante i vantaggi, finestre di contesto molto grandi introducono importanti sfide tecniche e pratiche che sviluppatori e utenti devono gestire con attenzione. La sfida più evidente è il costo computazionale: elaborare sequenze più lunghe richiede in modo esponenziale più memoria e potenza di calcolo a causa della scalabilità quadratica del meccanismo di attenzione, rendendo le finestre di contesto più ampie sensibilmente più costose da eseguire. Questa maggiore richiesta di calcolo comporta anche problemi di latenza, poiché finestre di contesto più grandi significano tempi di risposta più lenti: un aspetto critico per applicazioni in tempo reale dove si richiedono risposte rapide. Un altro problema, più sottile ma importante, è il fenomeno “ago nel pagliaio”, dove i modelli faticano a individuare e sfruttare informazioni rilevanti quando sono sepolte in una finestra di contesto molto ampia, talvolta performando peggio che con finestre più piccole. Inoltre, il context rot si verifica quando le informazioni all’inizio di una lunga finestra di contesto diventano meno influenti sull’output del modello, poiché il meccanismo di attenzione può dare priorità ai token più recenti rispetto a quelli più distanti. Queste sfide significano che massimizzare la dimensione della finestra di contesto non è sempre la soluzione ottimale per ogni caso d’uso.

Comprendere il context rot è fondamentale per lavorare efficacemente con finestre di contesto ampie: all’aumentare della lunghezza delle sequenze, i token all’inizio del contesto tendono ad avere un’influenza sempre minore sull’output del modello, il che significa che informazioni critiche possono essere di fatto “dimenticate” anche se tecnicamente sono ancora all’interno della finestra. Questo accade perché il budget di attenzione—la capacità del modello di prestare attenzione in modo significativo a tutti i token—si distribuisce su una porzione più ampia di testo. Fortunatamente, sono emerse diverse tecniche sofisticate per affrontare queste limitazioni. La Retrieval-Augmented Generation (RAG) risolve il problema memorizzando le informazioni in database esterni e recuperando solo i pezzi più rilevanti quando necessario, fornendo di fatto al modello una base di conoscenza più ampia senza richiedere una finestra di contesto enorme. Le tecniche di compattazione del contesto riassumono o comprimono le informazioni meno rilevanti, preservando i dettagli più importanti e riducendo l’uso di token. Approcci di presa di appunti strutturata incoraggiano gli utenti a organizzare le informazioni in modo gerarchico, facilitando al modello la priorità e l’individuazione dei concetti chiave. Queste soluzioni funzionano perché sono strategiche rispetto a quali informazioni entrano nella finestra di contesto e a come sono organizzate, invece di tentare semplicemente di inserire tutto nella memoria contemporaneamente.

Le finestre di contesto ampliate dei moderni modelli di IA hanno sbloccato numerose applicazioni reali che prima erano impraticabili o impossibili. I sistemi di supporto clienti possono ora esaminare l’intera cronologia di un ticket e la documentazione correlata in una singola richiesta, consentendo risposte più accurate e contestualmente appropriate senza che i clienti debbano spiegare nuovamente la loro situazione. L’analisi documentale e la ricerca sono state rivoluzionate da modelli in grado di ingerire interi articoli scientifici, contratti legali o specifiche tecniche, individuando informazioni chiave e rispondendo a domande dettagliate su contenuti che richiederebbero ore a un umano. La revisione del codice e lo sviluppo software beneficiano di finestre di contesto abbastanza ampie da contenere interi file o anche più file correlati, permettendo all’IA di comprendere schemi architetturali e fornire suggerimenti più intelligenti. La creazione di contenuti di lunga durata e i flussi di lavoro di scrittura iterativa diventano più efficienti quando il modello può mantenere la consapevolezza di tono, stile e arco narrativo dell’intero documento durante l’editing. L’analisi delle trascrizioni di riunioni e la sintesi della ricerca sfruttano le finestre di contesto ampie per estrarre insight da ore di conversazione o decine di documenti sorgente, individuando temi e collegamenti difficili da cogliere manualmente. Queste applicazioni dimostrano che la dimensione della finestra di contesto si traduce direttamente in valore pratico per i professionisti di ogni settore.

La traiettoria dello sviluppo delle finestre di contesto suggerisce che ci stiamo avvicinando a espansioni ancora più significative nel prossimo futuro, con Gemini 1.5 Pro che già dimostra una finestra di contesto da 1.000.000 di token e i laboratori di ricerca che esplorano capacità ancora maggiori. Oltre alla dimensione pura, il futuro probabilmente vedrà finestre di contesto dinamiche che si adattano intelligentemente al compito in corso, allocando più capacità quando necessario e riducendola per query più semplici per migliorare efficienza e ridurre i costi. I ricercatori stanno inoltre facendo progressi su meccanismi di attenzione più efficienti, che riducono la penalità computazionale delle finestre più grandi, potenzialmente superando il limite della scalabilità quadratica che attualmente limita la dimensione del contesto. Con la maturazione di queste tecnologie, possiamo aspettarci che la finestra di contesto diventi sempre meno un vincolo e sempre più un problema risolto, permettendo agli sviluppatori di concentrarsi su altri aspetti delle capacità e dell’affidabilità dell’IA. La convergenza tra finestre più grandi, maggiore efficienza e gestione intelligente del contesto definirà probabilmente la prossima generazione di applicazioni IA, abilitando casi d’uso che oggi non possiamo ancora immaginare.

Una finestra di contesto è la quantità totale di testo (misurata in token) che un modello di IA può elaborare contemporaneamente, mentre il limite di token si riferisce al numero massimo di token che il modello può gestire. Questi termini sono spesso usati in modo intercambiabile, ma la finestra di contesto si riferisce specificamente alla memoria di lavoro disponibile durante una singola inferenza, mentre il limite di token può anche riferirsi a vincoli di output o limiti di utilizzo dell'API.

Finestre di contesto più ampie generalmente migliorano la qualità delle risposte perché permettono al modello di considerare più informazioni rilevanti e mantenere meglio la continuità della conversazione. Tuttavia, finestre estremamente grandi possono talvolta peggiorare la qualità a causa del fenomeno chiamato context rot, in cui il modello fatica a dare priorità alle informazioni importanti tra grandi quantità di testo. La dimensione ottimale della finestra di contesto dipende dal compito specifico e da come le informazioni sono organizzate.

Finestre di contesto più grandi richiedono maggiore potenza computazionale a causa della scalabilità quadratica del meccanismo di attenzione nei modelli transformer. Il meccanismo di attenzione deve calcolare le relazioni tra ogni token e tutti gli altri token, quindi raddoppiare la finestra di contesto significa all'incirca quadruplicare le risorse computazionali necessarie. Per questo motivo finestre di contesto più grandi sono più costose da eseguire e producono tempi di risposta più lenti.

Il problema 'ago nel pagliaio' si verifica quando un modello di IA fatica a individuare e utilizzare le informazioni rilevanti (l'ago) quando sono sepolte all'interno di una finestra di contesto molto ampia (il pagliaio). I modelli a volte ottengono risultati peggiori con finestre di contesto estremamente grandi perché il meccanismo di attenzione si disperde su troppe informazioni, rendendo più difficile identificare ciò che è davvero importante.

Per massimizzare l'efficacia della finestra di contesto, organizza le informazioni in modo chiaro e gerarchico, posiziona le informazioni più importanti all'inizio o alla fine del contesto, utilizza formati strutturati come JSON o markdown e prendi in considerazione l'uso della Retrieval-Augmented Generation (RAG) per caricare dinamicamente solo le informazioni più rilevanti. Evita di sovraccaricare il modello con dettagli irrilevanti che consumano token senza aggiungere valore.

La finestra di contesto è la capacità tecnica del modello di elaborare testo in un dato momento, mentre la cronologia della conversazione è il reale registro dei messaggi precedenti in una conversazione. La cronologia deve rientrare nella finestra di contesto, ma la finestra di contesto include anche spazio per prompt di sistema, istruzioni e altri metadati. Una cronologia può essere più lunga della finestra di contesto, richiedendo sintesi o troncamento.

Attualmente nessun modello di IA dispone di finestre di contesto realmente illimitate, poiché tutti i modelli hanno vincoli architetturali e computazionali. Tuttavia, alcuni modelli come Gemini 1.5 Pro offrono finestre estremamente ampie (1.000.000 di token) e tecniche come la Retrieval-Augmented Generation (RAG) possono estendere di fatto la base di conoscenza del modello oltre la sua finestra di contesto recuperando dinamicamente le informazioni necessarie.

La dimensione della finestra di contesto influisce direttamente sui costi delle API perché finestre più grandi richiedono maggiori risorse computazionali per l'elaborazione. La maggior parte dei fornitori di API IA addebita in base all'utilizzo dei token, quindi utilizzare una finestra di contesto più ampia significa più token elaborati e costi più elevati. Alcuni fornitori applicano anche tariffe premium per modelli con finestre di contesto più grandi, quindi è importante scegliere la dimensione giusta per le proprie esigenze.

AmICited traccia come i sistemi di IA come ChatGPT, Perplexity e Google AI Overviews citano e fanno riferimento ai tuoi contenuti. Comprendi la tua visibilità nell'IA e monitora le menzioni del tuo brand attraverso le piattaforme di IA.

Finestra di contesto spiegata: i token massimi che un LLM può elaborare in una volta. Scopri come le finestre di contesto influenzano l'accuratezza dell'IA, le ...

Scopri cosa sono le finestre di contesto nei modelli linguistici di intelligenza artificiale, come funzionano, il loro impatto sulle prestazioni del modello e p...

Discussione della community sulle finestre di contesto AI e le loro implicazioni per il content marketing. Comprendere come i limiti di contesto influenzano l'e...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.