Soluzioni di Visibilità AI per le Imprese: Scegliere la Piattaforma Giusta

Guida completa alle soluzioni di visibilità AI per le imprese. Confronta le principali piattaforme come Conductor, Profound e Athena. Scopri i criteri di valuta...

La Strategia di Visibilità AI Enterprise si riferisce all’approccio completo che le organizzazioni implementano per monitorare, tracciare e comprendere tutti i sistemi, i modelli e le applicazioni di intelligenza artificiale che operano all’interno della loro infrastruttura. Questa strategia comprende la capacità di vedere quali sistemi AI vengono utilizzati, come si comportano, chi li utilizza e quali rischi presentano in tutta l’organizzazione. Per le grandi imprese che gestiscono centinaia o migliaia di implementazioni AI, la visibilità diventa di importanza critica perché l’AI ombra—strumenti AI non autorizzati o non documentati—può proliferare rapidamente senza una supervisione adeguata. Senza una visibilità completa, le organizzazioni non possono garantire la conformità, gestire i rischi, ottimizzare le prestazioni o ricavare il massimo valore dai propri investimenti in AI.

La Strategia di Visibilità AI Enterprise si riferisce all'approccio completo che le organizzazioni implementano per monitorare, tracciare e comprendere tutti i sistemi, i modelli e le applicazioni di intelligenza artificiale che operano all'interno della loro infrastruttura. Questa strategia comprende la capacità di vedere quali sistemi AI vengono utilizzati, come si comportano, chi li utilizza e quali rischi presentano in tutta l'organizzazione. Per le grandi imprese che gestiscono centinaia o migliaia di implementazioni AI, la visibilità diventa di importanza critica perché l'AI ombra—strumenti AI non autorizzati o non documentati—può proliferare rapidamente senza una supervisione adeguata. Senza una visibilità completa, le organizzazioni non possono garantire la conformità, gestire i rischi, ottimizzare le prestazioni o ricavare il massimo valore dai propri investimenti in AI.

La Strategia di Visibilità AI Enterprise si riferisce all’approccio completo che le organizzazioni implementano per monitorare, tracciare e comprendere tutti i sistemi, i modelli e le applicazioni di intelligenza artificiale che operano all’interno della loro infrastruttura. Questa strategia comprende la capacità di vedere quali sistemi AI vengono utilizzati, come si comportano, chi li utilizza e quali rischi presentano in tutta l’organizzazione. Per le grandi imprese che gestiscono centinaia o migliaia di implementazioni AI, la visibilità diventa di importanza critica perché l’AI ombra—strumenti AI non autorizzati o non documentati—può proliferare rapidamente senza una supervisione adeguata. La sfida si intensifica su larga scala, dove l'85% delle imprese ora utilizza l’AI in qualche misura, ma solo l'11% riporta un chiaro valore di business, indicando un notevole divario tra implementazione e gestione efficace. Senza una visibilità completa, le organizzazioni non possono garantire la conformità, gestire i rischi, ottimizzare le prestazioni o ricavare il massimo valore dai propri investimenti in AI.

La visibilità AI a livello enterprise opera su tre dimensioni interconnesse che insieme forniscono una consapevolezza organizzativa completa dei sistemi AI e del loro impatto. La prima dimensione, monitoraggio dell’uso, traccia quali sistemi AI sono implementati, chi vi accede, con quale frequenza vengono utilizzati e per quali scopi aziendali. La seconda dimensione, monitoraggio della qualità, assicura che i modelli AI funzionino come previsto, mantengano standard di accuratezza e non si degradino nel tempo a causa di drift di dati o decadimento dei modelli. La terza dimensione, monitoraggio della sicurezza, protegge da accessi non autorizzati, violazioni dei dati, attacchi di prompt injection e garantisce la conformità ai requisiti normativi. Queste tre dimensioni devono lavorare in sinergia, supportate da log centralizzati, dashboard in tempo reale e sistemi di allerta automatizzati. Le organizzazioni che implementano una visibilità completa su tutte e tre le dimensioni riportano risultati di governance significativamente migliori e tempi di risposta agli incidenti più rapidi.

| Dimensione | Scopo | Metriche Chiave |

|---|---|---|

| Monitoraggio Uso | Tracciare l’implementazione e l’utilizzo dei sistemi AI | Utenti attivi, chiamate API, versioni modelli, adozione per unità aziendale |

| Monitoraggio Qualità | Garantire prestazioni e affidabilità dei modelli | Accuratezza, precisione, recall, drift predittivo, latenza |

| Monitoraggio Sicurezza | Proteggere da minacce e garantire la conformità | Log accessi, anomalie rilevate, violazioni policy, audit trail |

Le organizzazioni affrontano ostacoli sostanziali quando tentano di implementare una visibilità AI completa in ambienti grandi e complessi. L’AI ombra rappresenta forse la sfida più significativa—dipendenti e dipartimenti implementano strumenti AI senza che l’IT ne sia a conoscenza o li abbia approvati, creando punti ciechi che impediscono il monitoraggio e la governance centralizzati. I silos di dati frammentano le informazioni tra i dipartimenti, rendendo impossibile correlare i pattern di utilizzo dell’AI o identificare sforzi duplicati e risorse sprecate. La complessità di integrazione emerge quando le organizzazioni devono collegare gli strumenti di visibilità con sistemi legacy, piattaforme cloud e framework AI diversi che non sono stati progettati tenendo conto del monitoraggio. La frammentazione normativa richiede standard di visibilità differenti per diverse giurisdizioni, creando complessità di conformità che richiede un’infrastruttura di monitoraggio flessibile e adattabile. Inoltre, l'84% dei responsabili IT segnala l’assenza di un processo di governance formale e il 72% delle organizzazioni segnala problemi di qualità dei dati che compromettono l’affidabilità delle metriche di visibilità stesse.

Le principali sfide della visibilità includono:

Una visibilità AI enterprise efficace richiede l’allineamento a framework e standard di governance consolidati che conferiscano struttura e credibilità agli sforzi di monitoraggio. Il NIST AI Risk Management Framework (RMF) offre un approccio completo per identificare, misurare e gestire i rischi AI, fornendo una base per i requisiti di visibilità in tutte le funzioni organizzative. ISO/IEC 42001 stabilisce standard internazionali per i sistemi di gestione AI, inclusi i requisiti di monitoraggio, documentazione e miglioramento continuo in linea con gli obiettivi di visibilità. L’EU AI Act impone severi requisiti di trasparenza e documentazione per i sistemi AI ad alto rischio, obbligando a registrare in dettaglio il comportamento dei sistemi AI e i processi decisionali. Framework specifici di settore aggiungono ulteriori requisiti—le organizzazioni finanziarie devono rispettare le aspettative dei regolatori bancari sulla governance AI, le organizzazioni sanitarie devono conformarsi alle richieste della FDA sui sistemi AI clinici e le agenzie governative devono seguire le direttive federali sulla governance AI. Le organizzazioni dovrebbero selezionare i framework appropriati in base a settore, geografia e profilo di rischio, quindi costruire infrastrutture di visibilità che dimostrino la conformità agli standard scelti.

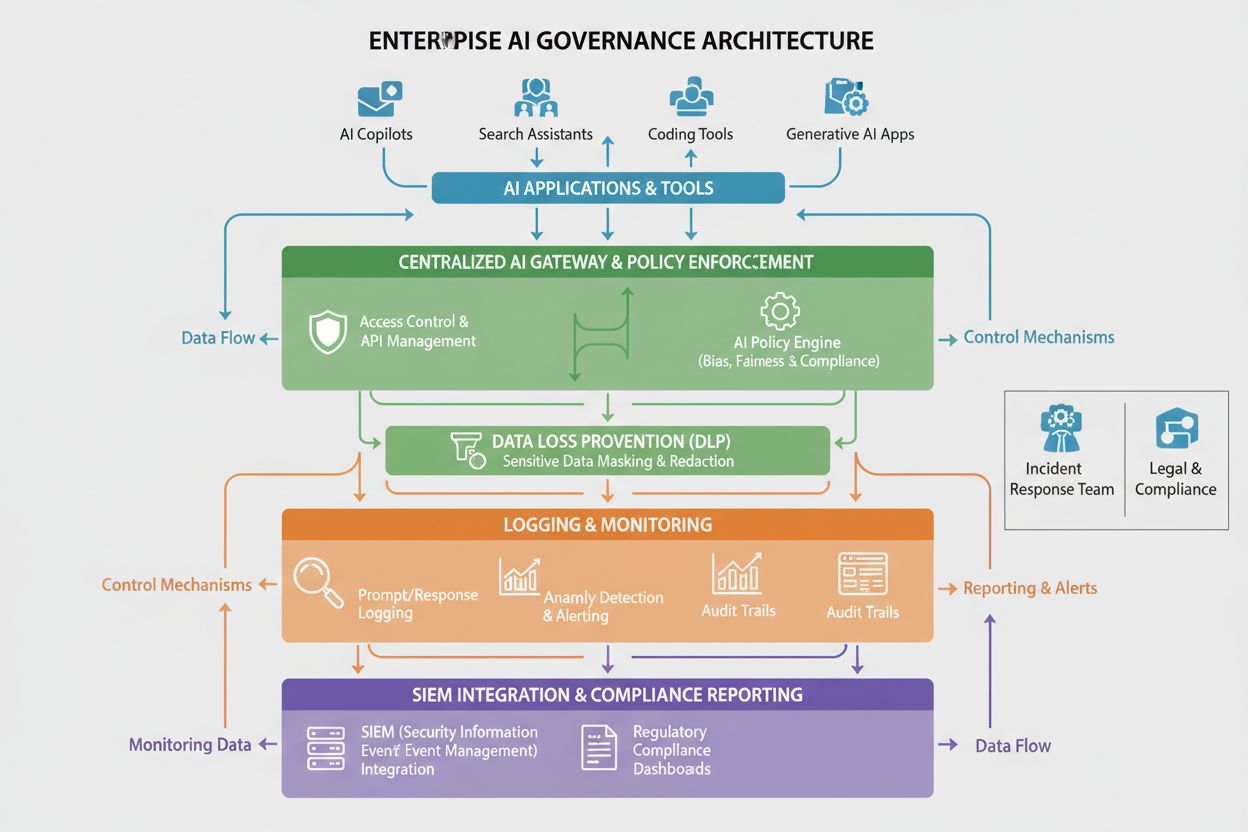

Implementare la visibilità AI enterprise richiede una solida base tecnica che raccolga, elabori e presenti dati sul comportamento e le prestazioni dei sistemi AI. Piattaforme AI centralizzate fungono da backbone dell’infrastruttura di visibilità, offrendo una vista unica da cui monitorare tutti i sistemi AI a prescindere da dove siano implementati. Gateway AI agiscono da intermediari tra applicazioni e servizi AI, raccogliendo metadati su ogni richiesta e risposta, consentendo un tracciamento dettagliato dell’uso e il monitoraggio della sicurezza. Sistemi di logging completi registrano tutte le attività dei sistemi AI, predizioni dei modelli, interazioni degli utenti e metriche di performance in repository centralizzati che supportano audit trail e analisi forense. Gli strumenti di Data Loss Prevention (DLP) monitorano i sistemi AI per tentativi di esfiltrazione di dati sensibili, impedendo che i modelli vengano addestrati su informazioni confidenziali o restituiscano dati protetti nelle risposte. L’integrazione SIEM collega i dati di visibilità AI ai sistemi più ampi di gestione delle informazioni e degli eventi di sicurezza, permettendo la correlazione degli eventi di sicurezza AI con altre minacce organizzative. Le organizzazioni che implementano questi componenti tecnici riportano una riduzione del 30% nei tempi di risposta agli incidenti in caso di problemi di sicurezza legati all’AI. Piattaforme come Liminal, Ardoq e Knostic offrono soluzioni di visibilità orientate alla governance, mentre AmICited.com è specializzata nel monitoraggio della qualità delle risposte AI su GPT, Perplexity e Google AI Overviews.

Una visibilità AI enterprise di successo richiede strutture organizzative chiare e ruoli definiti che distribuiscano la responsabilità del monitoraggio e della governance in tutta l’organizzazione. Un Comitato di Governance AI funge tipicamente da organo esecutivo che supervisiona la strategia di visibilità AI, definisce le politiche e assicura l’allineamento con obiettivi di business e requisiti normativi. Gli Owner dei Modelli sono responsabili di specifici sistemi AI, assicurando che siano correttamente documentati, monitorati e mantenuti secondo gli standard organizzativi. Gli AI Champion inseriti nelle unità di business fungono da collegamento tra i team di governance IT e gli utenti finali, promuovendo pratiche di visibilità e identificando l’AI ombra prima che diventi ingestibile. Gli steward dei dati gestiscono la qualità e l’accessibilità dei dati usati per addestrare e monitorare i sistemi AI, garantendo che le metriche di visibilità siano affidabili e attendibili. I team di sicurezza e conformità stabiliscono i requisiti di monitoraggio, conducono audit e assicurano che l’infrastruttura di visibilità rispetti gli obblighi normativi. Strutture di responsabilità chiare assicurano che la visibilità non sia vista come una responsabilità esclusiva dell’IT ma piuttosto come un impegno organizzativo condiviso che richiede la partecipazione di funzioni business, tecniche e di governance.

Le organizzazioni devono stabilire indicatori chiave di performance (KPI) e framework di misurazione chiari per valutare se la propria strategia di visibilità AI sta portando valore e supportando gli obiettivi aziendali. La copertura della visibilità misura la percentuale di sistemi AI che sono documentati e monitorati, con le organizzazioni mature che puntano a una copertura del 95%+ di tutte le implementazioni AI. La maturità della governance traccia i progressi attraverso fasi definite—dal monitoraggio ad hoc a processi standardizzati fino a una governance ottimizzata e automatizzata—utilizzando framework come il modello CMMI adattato alla governance AI. Le metriche di rilevamento e risposta agli incidenti misurano la rapidità con cui le organizzazioni individuano e rispondono a problematiche legate all’AI, con miglioramenti nella velocità di rilevamento e nei tempi di risposta che indicano una visibilità più efficace. L’aderenza alla conformità monitora la percentuale di sistemi AI che rispettano i requisiti normativi e gli standard interni, con i risultati degli audit e i tempi di remediation come metriche chiave. La realizzazione del valore di business misura se gli investimenti in visibilità si traducono in benefici tangibili come la riduzione del rischio, il miglioramento delle prestazioni dei modelli, tempi più rapidi di go-to-market delle iniziative AI o una migliore allocazione delle risorse. Le organizzazioni dovrebbero implementare dashboard in tempo reale che mostrino queste metriche agli stakeholder, consentendo un monitoraggio continuo e correzioni rapide quando emergono lacune di visibilità.

Settori diversi affrontano requisiti di visibilità AI unici, determinati da ambienti regolatori, profili di rischio e modelli di business che richiedono approcci di monitoraggio personalizzati. Le organizzazioni dei servizi finanziari devono rispettare le aspettative dei regolatori bancari per la governance AI, incluso il monitoraggio dettagliato dei sistemi AI utilizzati per decisioni di credito, rilevamento frodi e algoritmi di trading, con particolare attenzione al rilevamento dei bias e alle metriche di equità. Le organizzazioni sanitarie devono rispettare le richieste della FDA per i sistemi AI clinici, tra cui la validazione delle prestazioni dei modelli, il monitoraggio di problematiche di sicurezza e la documentazione di come i sistemi AI influenzano le decisioni cliniche. Le organizzazioni legali che usano l’AI per analisi contrattuale, ricerca giuridica e due diligence devono garantire visibilità sui dati di addestramento dei modelli per prevenire violazioni di riservatezza e mantenere il privilegio avvocato-cliente. Le agenzie governative devono rispettare direttive federali sulla governance AI, tra cui requisiti di trasparenza, audit dei bias e documentazione dei processi decisionali AI per la responsabilità pubblica. Le organizzazioni retail ed e-commerce devono monitorare i sistemi AI utilizzati in motori di raccomandazione e personalizzazione per la conformità a regolamenti di tutela dei consumatori e leggi sulla concorrenza leale. Le organizzazioni manifatturiere devono tracciare i sistemi AI utilizzati per il controllo qualità e la manutenzione predittiva per garantire sicurezza e affidabilità. I requisiti di visibilità specifici per settore dovrebbero essere incorporati nei framework di governance invece di essere trattati come esercizi di compliance separati.

Le organizzazioni che implementano la visibilità AI enterprise dovrebbero adottare un approccio graduale che offra risultati rapidi mentre si costruiscono capacità di governance complete e mature. Iniziare con inventario e documentazione—effettuare un audit per identificare tutti i sistemi AI attualmente in uso, inclusa l’AI ombra, e creare un registro centralizzato che documenti lo scopo di ciascun sistema, il proprietario, le fonti dati e la criticità per il business. Individuare risultati rapidi concentrando gli sforzi di monitoraggio iniziali su sistemi ad alto rischio come AI a contatto con i clienti, sistemi che processano dati sensibili o modelli che prendono decisioni rilevanti sulle persone. Implementare logging centralizzato come capacità fondamentale che raccoglie metadati su tutte le attività dei sistemi AI, abilitando sia il monitoraggio in tempo reale che le analisi storiche. Stabilire politiche di governance che definiscano standard per la documentazione, il monitoraggio e la conformità dei sistemi AI, comunicando poi chiaramente queste policy a tutti gli stakeholder. Costruire team cross-funzionali che includano IT, sicurezza, business e compliance, assicurando che le iniziative di visibilità affrontino le preoccupazioni da tutte le prospettive organizzative. Misurare e comunicare i progressi monitorando le metriche di visibilità e condividendo i risultati con la leadership, dimostrando il valore degli investimenti in governance e costruendo supporto organizzativo per il continuo investimento nell’infrastruttura di visibilità AI.

La visibilità AI è la capacità di vedere e monitorare cosa stanno facendo i sistemi AI, mentre la governance AI è il quadro più ampio di politiche, processi e controlli che gestiscono come vengono sviluppati, implementati e utilizzati i sistemi AI. La visibilità è una componente fondamentale della governance—non puoi governare ciò che non puoi vedere. Una governance AI efficace richiede una visibilità completa su tutte e tre le dimensioni: monitoraggio dell'uso, della qualità e della sicurezza.

Le grandi organizzazioni affrontano sfide uniche nel gestire centinaia o migliaia di implementazioni AI attraverso più dipartimenti, provider cloud e unità aziendali. Senza una visibilità completa, l'AI ombra si diffonde, aumentano i rischi di non conformità e le organizzazioni non possono ottimizzare gli investimenti AI né garantire un uso responsabile dell'AI. La visibilità consente alle organizzazioni di identificare i rischi, far rispettare le politiche e ricavare il massimo valore dalle iniziative AI.

Una scarsa visibilità AI crea molteplici rischi: i sistemi AI ombra operano senza supervisione, dati sensibili possono essere esposti tramite sistemi AI non monitorati, le violazioni di conformità non vengono rilevate, il degrado delle prestazioni dei modelli non viene identificato, le minacce alla sicurezza non vengono individuate e le organizzazioni non possono dimostrare la governance ai regolatori. Questi rischi possono portare a violazioni dei dati, multe regolatorie, danni reputazionali e perdita di fiducia dei clienti.

L'AI ombra—strumenti AI non autorizzati implementati senza la conoscenza dell'IT—crea punti ciechi che impediscono il monitoraggio e la governance centralizzati. I dipendenti possono utilizzare servizi AI pubblici come ChatGPT senza supervisione organizzativa, esponendo potenzialmente dati sensibili o violando i requisiti di conformità. L'AI ombra porta anche a sforzi duplicati, risorse sprecate e incapacità di far rispettare le politiche e gli standard AI dell'organizzazione.

Piattaforme di governance AI dedicate come Liminal, Ardoq e Knostic offrono monitoraggio centralizzato, applicazione delle politiche e report di conformità. Queste piattaforme si integrano con i servizi AI, raccolgono log dettagliati, rilevano anomalie e forniscono dashboard per i team di governance. Inoltre, AmICited è specializzata nel monitorare come i sistemi AI fanno riferimento al tuo brand su GPT, Perplexity e Google AI Overviews, offrendo visibilità sulla qualità delle risposte AI.

Quadri normativi come l'EU AI Act, GDPR, CCPA e regolamenti specifici di settore (OCC per il settore bancario, FDA per la sanità) impongono requisiti specifici di visibilità e documentazione. Le organizzazioni devono implementare un monitoraggio che dimostri la conformità a tali regolamenti, inclusi audit trail, test di bias, monitoraggio delle prestazioni e documentazione dei processi decisionali dei sistemi AI. L'infrastruttura di visibilità deve essere progettata per soddisfare questi obblighi normativi.

Le metriche chiave includono: copertura della visibilità (percentuale di sistemi AI documentati e monitorati), maturità della governance (progresso attraverso fasi di governance definite), tempi di rilevamento e risposta agli incidenti, aderenza alla conformità (percentuale di sistemi che soddisfano i requisiti normativi) e realizzazione del valore aziendale (benefici tangibili dagli investimenti nella visibilità). Le organizzazioni dovrebbero anche monitorare metriche d'uso (utenti attivi, chiamate API), metriche di qualità (accuratezza, drift), e metriche di sicurezza (anomalie rilevate, violazioni di policy).

I tempi di implementazione variano in base a dimensioni e complessità organizzativa. L'infrastruttura di visibilità iniziale (inventario, log di base, dashboard) può essere stabilita in 3-6 mesi. Raggiungere una visibilità completa su tutti i sistemi AI richiede tipicamente 6-12 mesi. Ottenere capacità di governance mature e ottimizzate richiede solitamente 12-24 mesi. Le organizzazioni dovrebbero adottare un approccio graduale, iniziando dai sistemi ad alto rischio e dai risultati rapidi, per poi espandersi verso una copertura completa.

AmICited traccia come i sistemi AI come GPT, Perplexity e Google AI Overviews fanno riferimento al tuo brand e ai tuoi contenuti. Ottieni visibilità sulla qualità delle risposte AI e sulle menzioni del brand su tutte le principali piattaforme AI.

Guida completa alle soluzioni di visibilità AI per le imprese. Confronta le principali piattaforme come Conductor, Profound e Athena. Scopri i criteri di valuta...

Scopri il Modello di Maturità della Visibilità dell'IA, un framework per valutare la prontezza organizzativa nel monitoraggio e nella governance dell'IA. Scopri...

Scopri come iniziare con la visibilità AI in soli 30 giorni. Una guida pratica per principianti che copre scoperta, ottimizzazione, strategia dei contenuti e mo...