Cloaking

Il cloaking è una tecnica SEO black-hat che mostra contenuti diversi ai motori di ricerca rispetto agli utenti. Scopri come funziona, i rischi, i metodi di rile...

Il testo nascosto si riferisce a testo o link su una pagina web che sono invisibili agli utenti ma leggibili dai crawler dei motori di ricerca e dai sistemi di intelligenza artificiale. Questa tecnica viene tipicamente utilizzata per manipolare il posizionamento nei motori di ricerca ed è considerata una pratica SEO black-hat che viola le linee guida dei motori di ricerca.

Il testo nascosto si riferisce a testo o link su una pagina web che sono invisibili agli utenti ma leggibili dai crawler dei motori di ricerca e dai sistemi di intelligenza artificiale. Questa tecnica viene tipicamente utilizzata per manipolare il posizionamento nei motori di ricerca ed è considerata una pratica SEO black-hat che viola le linee guida dei motori di ricerca.

Il testo nascosto è un contenuto inserito in una pagina web che risulta invisibile o inaccessibile agli utenti umani ma rimane leggibile dai crawler dei motori di ricerca e dai sistemi di intelligenza artificiale. Questa tecnica prevede l’uso di diversi metodi HTML e CSS per nascondere il testo dalla visualizzazione della pagina, mantenendolo comunque presente nel codice sorgente. Google definisce il testo nascosto come “testo o link nei tuoi contenuti utilizzati per manipolare il posizionamento di Google che possono essere segnalati come ingannevoli.” La principale distinzione tra contenuto nascosto legittimo e spam risiede nell’intento: il testo nascosto utilizzato per manipolare il ranking viola le linee guida dei motori di ricerca, mentre il contenuto nascosto progettato per migliorare l’esperienza utente o l’accessibilità è accettabile. Il testo nascosto rappresenta una sfida persistente nella SEO sin dai primi anni 2000, quando gli algoritmi di ricerca erano meno sofisticati e i webmaster potevano ingannare più facilmente i sistemi di ranking. Oggi, con tecnologie avanzate di crawling e sistemi di rilevamento alimentati dall’AI, il testo nascosto è una delle pratiche black-hat SEO più facilmente individuabili e severamente penalizzate.

La pratica di nascondere testo è emersa nei primi tempi dell’ottimizzazione per i motori di ricerca, quando gli algoritmi di ranking di Google si basavano fortemente sulla densità di parole chiave e sull’analisi del testo on-page. I webmaster scoprirono che potevano gonfiare artificialmente la rilevanza delle keyword inserendo testo nascosto che i motori di ricerca avrebbero scansionato e indicizzato ma che gli utenti non avrebbero mai visto. Le implementazioni comuni includevano testo bianco su sfondo bianco, testo posizionato fuori dallo schermo tramite valori CSS negativi e testo con dimensione font zero. Questa tecnica era particolarmente diffusa tra il 2000 e il 2005, prima che Google introducesse sistemi sofisticati di rilevamento dello spam. La pratica divenne così diffusa che stime del settore suggeriscono che circa il 15-20% dei siti web abbia utilizzato qualche forma di manipolazione del testo nascosto a metà degli anni 2000, anche se questa percentuale è diminuita notevolmente con l’aumento delle penalizzazioni e il miglioramento dei sistemi di rilevamento.

La risposta di Google all’abuso del testo nascosto fu rapida e completa. Il motore di ricerca iniziò a emettere azioni manuali contro i siti che utilizzavano testo nascosto e, già nel 2008, i sistemi automatici di rilevamento erano in grado di individuare la maggior parte delle tecniche comuni. L’introduzione dell’indicizzazione mobile-first nel 2018 ha cambiato effettivamente la conversazione sul contenuto nascosto, poiché Google ha riconosciuto che parte del contenuto nascosto—come menu a scomparsa e sezioni espandibili—migliora davvero l’esperienza utente su mobile. Questa distinzione tra testo nascosto ingannevole e contenuto nascosto legittimo è stata formalizzata nelle linee guida di Google, creando un quadro più chiaro per i webmaster su ciò che è accettabile o meno.

Il testo bianco su sfondo bianco rimane la tecnica di testo nascosto più famosa, anche se ora è estremamente facile da individuare per i motori di ricerca. Questo metodo prevede l’impostazione del colore del testo su bianco (#FFFFFF) su uno sfondo bianco, rendendolo invisibile agli utenti ma presente nell’HTML. Le tecniche di posizionamento CSS utilizzano valori negativi per proprietà come text-indent: -9999px per spostare il testo fuori dall’area visibile della pagina, mantenendolo nel DOM ma nascosto alla vista. La manipolazione delle dimensioni del font imposta il testo su font-size: 0 o valori estremamente piccoli come font-size: 1px, rendendo il testo illeggibile pur essendo tecnicamente presente sulla pagina.

Proprietà di opacità zero e visibilità utilizzano regole CSS come opacity: 0 o visibility: hidden per rendere il testo invisibile mantenendolo nel flusso del documento. Il testo nascosto dietro immagini consiste nel posizionare il testo sotto elementi immagine tramite layering z-index, rendendolo invisibile agli utenti ma accessibile ai crawler. L’abuso del tag NoScript sfrutta il tag <noscript>, destinato a mostrare contenuti quando JavaScript è disabilitato, riempiendolo di testo ricco di keyword che i motori di ricerca potrebbero scansionare. Lo stuffing di keyword all’interno di elementi nascosti combina tecniche di testo nascosto con ripetizione eccessiva di parole chiave, creando pagine che appaiono normali agli utenti ma contengono concentrazioni innaturali di keyword in sezioni nascoste.

Le implementazioni moderne sono diventate più sofisticate, utilizzando JavaScript per nascondere e mostrare dinamicamente contenuti in base al rilevamento dell’user agent, servendo contenuti diversi ai motori di ricerca rispetto agli utenti. Alcuni siti usano div nascosti attivati da specifiche interazioni utente, cercando di nascondere il contenuto al caricamento iniziale della pagina pur mantenendolo accessibile ai crawler. Queste tecniche avanzate sono ora esplicitamente vietate dalle policy di cloaking di Google e vengono rilevate tramite rendering in browser headless che simulano il comportamento utente.

| Aspetto | Testo Nascosto Black-Hat (Spam) | Contenuto Nascosto White-Hat (Legittimo) | Prospettiva Crawler AI |

|---|---|---|---|

| Intento | Manipolare i ranking tramite inganno | Migliorare esperienza e accessibilità utente | Rilevabile tramite analisi dell’intento |

| Beneficio per l’utente | Nessuno; il contenuto non serve all’utente | Migliora navigazione, riduce disordine, favorisce accessibilità | I crawler valutano il reale valore per l’utente |

| Esempi Comuni | Testo bianco su bianco, keyword stuffing, testo fuori schermo | Accordion, schede, menu a discesa, testo per screen reader | Entrambi sono scansionabili ma valutati diversamente |

| Trattamento da parte dei motori di ricerca | Penalità manuali, calo ranking, possibile deindicizzazione | Indicizzato normalmente, può avere peso minore | I sistemi AI indicizzano entrambi ma privilegiano il contenuto visibile |

| Metodo di rilevamento | Analisi colori, ispezione proprietà CSS, confronto rendering | Analisi interazione utente, verifica markup accessibilità | Rendering in browser headless e analisi DOM |

| Tempo di recupero | Da settimane a mesi dopo richiesta riconsiderazione | Nessun recupero necessario; nessuna violazione | Ricrawling immediato dopo le correzioni |

| Impatto Mobile-First | Penalizzato in tutti i metodi di indicizzazione | Spesso premiato per miglioramento UX mobile | Il rendering mobile è il metodo di valutazione principale |

| Conformità Accessibilità | Viola le linee guida WCAG | Conforme agli standard di accessibilità | Compatibilità con screen reader verificata |

I crawler dei motori di ricerca operano in modalità di rendering multiple per rilevare il testo nascosto. La prima modalità è l’analisi dell’HTML grezzo, in cui i crawler esaminano direttamente il codice sorgente, identificando il testo presente nel DOM indipendentemente dallo stile CSS. La seconda modalità è l’analisi della pagina renderizzata, in cui i crawler utilizzano browser headless come Chromium per rendere le pagine esattamente come le vedono gli utenti, confrontando poi l’output renderizzato con l’HTML grezzo. Qualsiasi discrepanza significativa tra queste due versioni attiva gli algoritmi di rilevamento del testo nascosto.

Il sistema di rilevamento di Google analizza molteplici segnali per identificare il testo nascosto: rapporti di contrasto tra testo e sfondo, proprietà CSS che nascondono elementi, valori di font inferiori alle soglie di leggibilità e valori di posizionamento che spostano il contenuto fuori schermo. Il sistema valuta anche densità di keyword e rilevanza semantica, segnalando pagine in cui il testo nascosto contiene keyword non correlate ai contenuti visibili o dove la densità di keyword nelle sezioni nascoste supera di gran lunga quella visibile. Modelli di machine learning addestrati su milioni di pagine ora riescono a individuare tecniche di testo nascosto sottili che i semplici sistemi a regole non rileverebbero.

I crawler AI come GPTBot, ClaudeBot e PerplexityBot utilizzano meccanismi di rilevamento simili, rendendo le pagine in browser headless e analizzando la relazione tra contenuto visibile e nascosto. Questi sistemi sono particolarmente sofisticati perché devono comprendere l’intento e il significato semantico del contenuto, non solo l’implementazione tecnica. Una pagina con contenuto nascosto legittimo (come una fisarmonica) mostrerà coerenza semantica tra le parti visibili e nascoste, mentre una pagina con testo nascosto spammostrerà cambiamenti drastici di argomento o focus keyword tra aree visibili e nascoste.

Google assegna azioni manuali specificatamente per violazioni di testo nascosto, che compaiono nel report Azioni Manuali all’interno di Search Console. I siti che ricevono questa penalità sperimentano tipicamente calo di ranking del 50-90% per le pagine coinvolte, con alcuni siti che perdono completamente la visibilità nei risultati di ricerca. La penalità può essere a livello di sito o di pagina a seconda dell’estensione e della diffusione del testo nascosto nel dominio. Il recupero richiede la rimozione completa di tutto il testo nascosto, la verifica dell’assenza di violazioni e l’invio di una richiesta di riconsiderazione tramite Search Console.

Il processo di riconsiderazione richiede in genere 2-4 settimane per la prima revisione, anche se i casi complessi possono richiedere più tempo. Il team di revisione di Google esamina manualmente il sito per confermare la rimozione del testo nascosto e la conformità alle linee guida. Circa il 60-70% delle richieste di riconsiderazione viene inizialmente respinto, costringendo i webmaster a ulteriori correzioni e a un nuovo invio. Anche dopo una riconsiderazione accettata, i siti possono subire una “penalità di fiducia” con recupero lento del ranking per diversi mesi, mentre gli algoritmi di Google ricostruiscono la fiducia nella conformità del sito.

Anche altri motori di ricerca e sistemi AI applicano penalità simili. Bing ha i propri sistemi di rilevamento dello spam che individuano testo nascosto, e i motori di ricerca AI come Perplexity e Claude possono declassare o escludere contenuti da siti noti per l’uso di tecniche di testo nascosto. L’effetto cumulativo di queste penalità può devastare il traffico organico di un sito, rendendo il testo nascosto uno degli errori SEO più costosi per un webmaster.

Le interfacce a fisarmonica e a schede sono ora pattern standard di web design che migliorano l’esperienza utente organizzando informazioni complesse in sezioni a scomparsa. Questi elementi nascondono contenuti di default ma li rivelano all’interazione, riducendo il carico cognitivo e il disordine nella pagina. Google supporta esplicitamente questi pattern quando sono implementati con HTML semantico e attributi di accessibilità corretti. La distinzione chiave è che il contenuto nascosto è semanticamente correlato al contenuto visibile e serve uno scopo organizzativo reale.

I menu di navigazione a discesa nascondono opzioni di navigazione secondaria finché l’utente non passa il mouse o clicca sulle voci principali. Questo pattern è praticamente universale nel web design moderno ed è pienamente supportato dai motori di ricerca. Il design responsive mobile-first spesso si basa sul contenuto nascosto, nascondendo la navigazione desktop su mobile e sostituendola con hamburger menu o altri pattern ottimizzati per dispositivi mobili. L’indicizzazione mobile-first di Google premia i siti che implementano efficacemente questi pattern, perché dimostrano attenzione all’esperienza utente su mobile.

Il testo per screen reader e le funzionalità di accessibilità nascondono intenzionalmente contenuti agli utenti vedenti rendendoli disponibili a persone con disabilità visive. Questo include link “salta la navigazione”, testo descrittivo per immagini e label di form estesi che forniscono contesto per le tecnologie assistive. Queste implementazioni non solo sono accettabili ma necessarie per la conformità alle linee guida WCAG. I motori di ricerca riconoscono e supportano questi pattern perché servono uno scopo reale di accessibilità.

Le sezioni di contenuto espandibili come pulsanti “Leggi di più”, troncamento di recensioni prodotto e fisarmoniche FAQ sono usi legittimi di contenuto nascosto. Questi pattern migliorano le prestazioni della pagina riducendo la dimensione di caricamento iniziale pur mantenendo accessibile tutto il contenuto. I motori di ricerca indicizzano tutto il contenuto anche se nascosto dietro un’interazione, garantendo che tutte le informazioni siano disponibili ai fini del ranking.

L’emergere di motori di ricerca alimentati da AI come ChatGPT, Perplexity, Google AI Overviews e Claude ha creato nuove sfide e opportunità legate al testo nascosto. Questi sistemi scansionano e indicizzano i siti per addestrare i loro modelli e generare risposte, e si confrontano con gli stessi problemi di testo nascosto dei motori di ricerca tradizionali. I crawler AI sono particolarmente sofisticati nel rilevare il testo nascosto perché rendono le pagine in più modi e analizzano la semantica del contenuto per comprenderne l’intento.

Per piattaforme di monitoraggio brand come AmICited, il testo nascosto rappresenta una sfida unica. Quando i siti utilizzano testo nascosto con riferimenti al brand, queste menzioni possono essere indicizzate dai crawler AI ma non essere visibili agli utenti umani. Questo crea discrepanze tra ciò che appare nelle risposte AI e ciò che vedono gli utenti sul sito sorgente. I sistemi di monitoraggio di AmICited devono considerare sia il contenuto visibile che quello nascosto per fornire metriche accurate sulle apparizioni del brand nei motori di ricerca AI. La piattaforma traccia non solo se un brand viene menzionato, ma anche il contesto e la visibilità di tali menzioni, aiutando i clienti a comprendere la loro impronta digitale completa nelle risposte generative AI.

Il testo nascosto può gonfiare artificialmente le menzioni di brand nei risultati di ricerca AI se i siti utilizzano testo nascosto con keyword di brand. Questo crea una falsa impressione di visibilità e può distorcere l’analisi di mercato. Al contrario, contenuti nascosti legittimi come le fisarmoniche FAQ che includono informazioni sul brand dovrebbero essere correttamente indicizzati e valorizzati nelle risposte AI, poiché offrono valore reale agli utenti. Comprendere la distinzione tra questi scenari è fondamentale per un monitoraggio accurato dei brand e l’analisi della concorrenza.

La sofisticazione del rilevamento del testo nascosto continua a crescere poiché motori di ricerca e sistemi AI investono in tecnologie di rendering e analisi sempre più potenti. I modelli di machine learning diventano sempre più capaci di comprendere l’intento del contenuto, rendendo quasi impossibile nascondere testo manipolativo ai sistemi di rilevamento. I futuri sistemi di rilevamento probabilmente incorporeranno analisi comportamentali, esaminando i pattern di interazione utente per individuare pagine in cui il contenuto nascosto non riceve engagement legittimo.

Le tecnologie blockchain e di trasparenza potrebbero in futuro giocare un ruolo nella verifica dei contenuti, consentendo a utenti e motori di ricerca di garantire che il contenuto del sito non sia stato manipolato o nascosto. Quadri normativi su AI e ricerca potrebbero un giorno richiedere la divulgazione esplicita dei contenuti nascosti, analogamente a quanto avviene con la pubblicità. L’ascesa dei dati zero-party e dei meccanismi di consenso esplicito potrebbero cambiare la percezione del contenuto nascosto, con gli utenti che scelgono attivamente di mostrare o nascondere contenuti invece di averli nascosti di default.

I motori di ricerca AI saranno probabilmente ancora più aggressivi nel penalizzare il testo nascosto, poiché competono per offrire risultati affidabili e trasparenti. L’integrazione di meccanismi di feedback utente nei sistemi di ricerca AI potrebbe permettere agli utenti di segnalare testo nascosto e contenuti manipolativi, creando un livello di rilevamento crowdsourced oltre a quello automatico. Il futuro della SEO si allontanerà probabilmente dalla manipolazione tecnica verso la qualità reale del contenuto, l’ottimizzazione dell’esperienza utente e la comunicazione trasparente tra siti web e sistemi di ricerca.

Per piattaforme di monitoraggio come AmICited, l’evoluzione del rilevamento del testo nascosto significa un tracking sempre più accurato delle menzioni di brand nei sistemi AI. Con crawler AI sempre più sofisticati, la distinzione tra contenuto nascosto legittimo e manipolativo sarà più chiara, consentendo un monitoraggio del brand e un’analisi competitiva più precisi. Le organizzazioni che puntano su strategie di contenuto trasparenti e user-first beneficeranno di una maggiore visibilità sia nella ricerca tradizionale sia nei risultati alimentati dall’intelligenza artificiale.

Le tecniche di testo nascosto più diffuse includono testo bianco su sfondo bianco, posizionamento CSS per spostare il testo fuori dallo schermo usando valori negativi di text-indent, impostazione della dimensione del font a zero, nascondere il testo dietro immagini e utilizzare opacità zero. Questi metodi erano particolarmente comuni nei primi anni 2000, quando gli algoritmi di ricerca erano meno sofisticati. I motori di ricerca moderni come Google, Perplexity e Claude ora sono in grado di rilevare queste tecniche tramite capacità avanzate di crawling e rendering, rendendole inefficaci e rischiose per la SEO.

I motori di ricerca rilevano il testo nascosto analizzando l'HTML e il CSS delle pagine web per identificare discrepanze tra ciò che vedono gli utenti e ciò a cui hanno accesso i crawler. Esaminano i valori dei colori, proprietà CSS come display:none e visibility:hidden, dimensioni dei font e attributi di posizionamento. I crawler AI come GPTBot e ClaudeBot utilizzano metodi di rilevamento simili, rendendo le pagine come le vedrebbero gli utenti e confrontando il risultato renderizzato con l'HTML sottostante. Lo Strumento di Ispezione URL di Google in Search Console aiuta anche i webmaster a individuare violazioni di testo nascosto sui propri siti.

I siti web sorpresi a utilizzare testo nascosto per manipolare il posizionamento affrontano gravi penalità, tra cui azioni manuali da Google, forti cali di ranking, rimozione completa dai risultati di ricerca ed esclusione da funzionalità speciali come Google News o Discover. Queste penalità possono interessare l'intero sito o pagine specifiche a seconda dell'entità della violazione. Il ripristino richiede l'invio di una richiesta di riconsiderazione dopo aver rimosso tutto il testo nascosto e aver dimostrato la conformità alle linee guida dei motori di ricerca. Il processo può richiedere settimane o mesi, durante i quali traffico e visibilità sono gravemente compromessi.

No, non tutto il contenuto nascosto viola le linee guida dei motori di ricerca. Il contenuto nascosto white-hat include menu a fisarmonica, interfacce a schede, menu a discesa e contenuti rivelati tramite interazioni utente che migliorano l'esperienza. Anche il testo per screen reader a fini di accessibilità è accettabile. La distinzione chiave è l'intento: se il contenuto nascosto è progettato per manipolare il ranking invece che per migliorare l'esperienza o l'accessibilità, viola le policy. L'indicizzazione mobile-first di Google supporta il contenuto nascosto quando migliora l'usabilità e la navigazione mobile.

Il testo nascosto rappresenta una sfida per le piattaforme di monitoraggio AI che tracciano le menzioni di brand su sistemi AI come ChatGPT, Perplexity e Claude. Se i siti web utilizzano testo nascosto contenente riferimenti al brand, queste menzioni possono essere indicizzate dai crawler AI ma non visibili agli utenti umani, creando discrepanze nei dati di monitoraggio. I sistemi di tracking di AmICited devono tenere conto sia dei contenuti visibili che di quelli nascosti per fornire metriche accurate sulle apparizioni del brand nei motori di ricerca AI, assicurando che i clienti comprendano la loro impronta digitale completa nelle risposte generative AI.

Gli utilizzi legittimi dei contenuti nascosti includono il miglioramento dell'esperienza utente mobile tramite menu a scomparsa e fisarmoniche, la fornitura di informazioni supplementari tramite sezioni espandibili, l'implementazione di funzionalità di accessibilità per screen reader e l'organizzazione di informazioni complesse sui prodotti tramite schede. I siti e-commerce spesso nascondono specifiche dettagliate e recensioni dietro sezioni espandibili per ridurre l'affollamento della pagina. I siti di notizie usano contenuti nascosti per anteprime di articoli troncate con funzionalità 'leggi di più'. Queste implementazioni non violano le linee guida perché servono uno scopo reale per l'utente e non mirano a manipolare il ranking.

Il rilevamento del testo nascosto si è evoluto notevolmente dal semplice pattern matching a sofisticati modelli di machine learning che comprendono il rendering della pagina, i pattern di interazione utente e l'intento del contenuto. I sistemi moderni rendono le pagine in browser headless per vedere esattamente ciò che vedono gli utenti, quindi confrontano questo risultato con l'HTML e il CSS sottostanti. I sistemi AI ora possono identificare sottili variazioni in colore del testo, opacità e posizionamento che gli algoritmi più vecchi non rilevavano. Inoltre, l'elaborazione del linguaggio naturale aiuta a rilevare keyword stuffing e pattern testuali innaturali che indicano manipolazione, rendendo sempre più difficile nascondere contenuti ai sistemi di rilevamento.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Il cloaking è una tecnica SEO black-hat che mostra contenuti diversi ai motori di ricerca rispetto agli utenti. Scopri come funziona, i rischi, i metodi di rile...

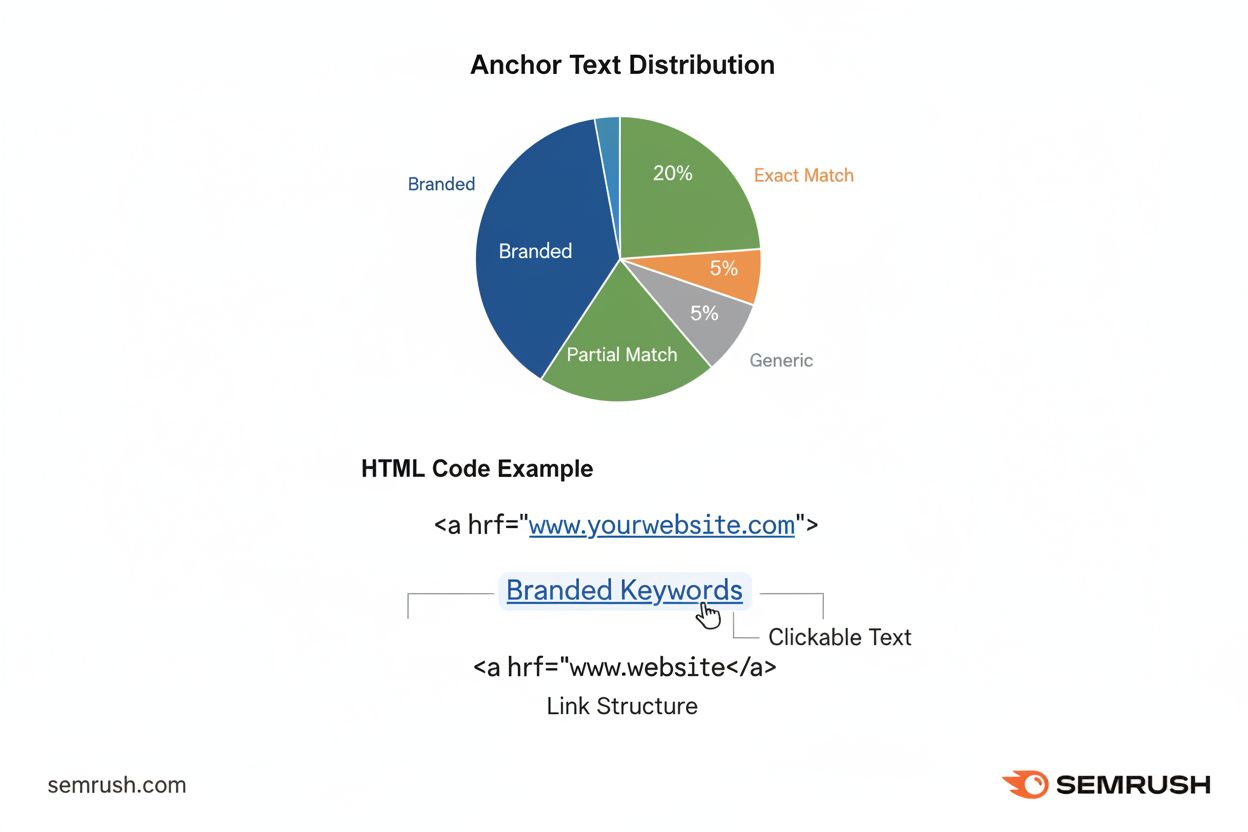

Il testo di ancoraggio è il testo cliccabile nei collegamenti ipertestuali che aiuta i motori di ricerca a capire la pertinenza della pagina e migliora la navig...

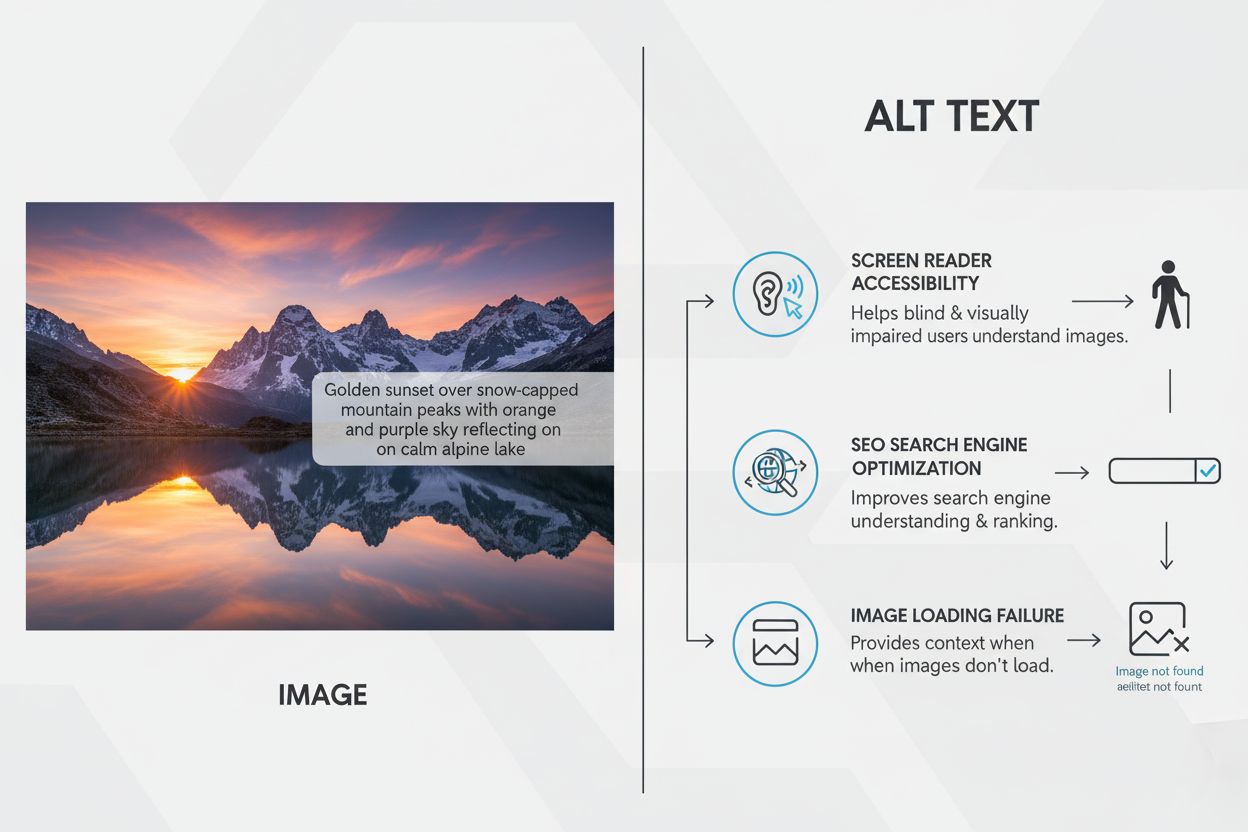

Il testo alternativo è un testo descrittivo per le immagini che migliora l’accessibilità per gli utenti di lettori di schermo e potenzia la SEO. Scopri best pra...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.