Copertura dell'indice

La copertura dell'indice misura quali pagine di un sito web sono indicizzate dai motori di ricerca. Scopri cosa significa, perché è importante per la SEO e come...

L’indicizzabilità si riferisce alla possibilità che una pagina web venga correttamente scansionata, analizzata e archiviata nell’indice di un motore di ricerca per una potenziale inclusione nei risultati di ricerca. Dipende da fattori tecnici come le direttive robots.txt, i tag noindex, le URL canoniche e i segnali di qualità dei contenuti che determinano se una pagina è idonea all’indicizzazione.

L’indicizzabilità si riferisce alla possibilità che una pagina web venga correttamente scansionata, analizzata e archiviata nell’indice di un motore di ricerca per una potenziale inclusione nei risultati di ricerca. Dipende da fattori tecnici come le direttive robots.txt, i tag noindex, le URL canoniche e i segnali di qualità dei contenuti che determinano se una pagina è idonea all’indicizzazione.

Indicizzabilità è la capacità di una pagina web di essere correttamente scansionata, analizzata e archiviata nell’indice di un motore di ricerca per una potenziale inclusione nei risultati di ricerca. A differenza della crawlabilità—che si concentra sulla possibilità che i motori di ricerca possano accedere a una pagina—l’indicizzabilità determina se quella pagina, una volta raggiunta, viene considerata degna di essere inserita nel database del motore di ricerca. Una pagina può essere perfettamente scansionabile ma comunque non indicizzabile se contiene una direttiva noindex, non supera le valutazioni di qualità o viola altre regole di indicizzazione. L’indicizzabilità è il ponte critico tra accessibilità tecnica e reale visibilità nei risultati di ricerca, rendendola uno dei concetti più importanti nell’ottimizzazione per i motori di ricerca e nella generative engine optimization (GEO). Senza un’adeguata indicizzabilità, anche i contenuti di più alta qualità rimangono invisibili sia ai motori di ricerca tradizionali che alle piattaforme di scoperta guidate dall’AI.

Sebbene spesso confuse, crawlabilità e indicizzabilità servono a scopi diversi nella pipeline dei motori di ricerca. La crawlabilità si riferisce alla possibilità che Googlebot e altri crawler dei motori di ricerca possano scoprire e accedere a una pagina web tramite link, sitemap o riferimenti esterni. Risponde alla domanda: “Il bot del motore di ricerca può raggiungere questa pagina?” L’indicizzabilità, invece, risponde: “Questa pagina dovrebbe essere archiviata nell’indice del motore di ricerca?” Una pagina può essere altamente scansionabile—facilmente accessibile dai bot—ma comunque non essere indicizzata se contiene un meta tag noindex, presenta problemi di contenuti duplicati o manca di sufficienti segnali di qualità. Secondo una ricerca di Botify, uno studio di 30 giorni su 413 milioni di pagine web uniche ha rilevato che, mentre il 51% delle pagine non veniva scansionato, il 37% delle pagine scansionate non era indicizzabile a causa di problemi di qualità o tecnici. Questa distinzione è cruciale perché risolvere solo i problemi di crawlabilità non garantisce l’indicizzazione; devono allinearsi sia i fattori tecnici che la qualità dei contenuti per un’indicizzazione efficace.

Diversi meccanismi tecnici controllano direttamente se una pagina può essere indicizzata. Il meta tag noindex è il controllo più esplicito, implementato come <meta name="robots" content="noindex"> nella sezione head dell’HTML di una pagina o come intestazione HTTP X-Robots-Tag: noindex. Quando i motori di ricerca incontrano questa direttiva, non indicizzeranno la pagina, indipendentemente dalla sua qualità o dai link esterni che puntano a essa. Il file robots.txt controlla l’accesso alla scansione ma non impedisce direttamente l’indicizzazione; se una pagina è bloccata da robots.txt, i crawler non possono vedere il tag noindex, il che può permettere che la pagina rimanga indicizzata se scoperta tramite link esterni. I tag canonici specificano quale versione di una pagina dovrebbe essere indicizzata quando esistono contenuti duplicati o simili su più URL. Un’implementazione errata dei canonici—come il puntamento all’URL sbagliato o la creazione di riferimenti circolari—può impedire l’indicizzazione della pagina desiderata. Anche i codici di stato HTTP influenzano l’indicizzabilità: le pagine che restituiscono 200 OK sono indicizzabili, mentre i redirect 301 indicano spostamenti permanenti, i 302 cambiamenti temporanei e i 404 segnalano pagine mancanti che non possono essere indicizzate. Comprendere e implementare correttamente questi fattori tecnici è essenziale per mantenere una forte indicizzabilità sul proprio sito web.

| Concetto | Definizione | Focus principale | Impatto sulla visibilità | Metodo di controllo |

|---|---|---|---|---|

| Indicizzabilità | Se una pagina scansionata può essere archiviata nell’indice di ricerca | Inclusione nel database di ricerca | Diretto—le pagine indicizzate sono idonee al ranking | tag noindex, segnali di qualità, canonici |

| Crawlabilità | Se i bot possono accedere e leggere una pagina | Accesso e scoperta da parte dei bot | Prerequisito per l’indicizzabilità | robots.txt, link interni, sitemap |

| Renderizzabilità | Se i motori possono elaborare JavaScript e contenuti dinamici | Visibilità dei contenuti per i crawler | Influenza cosa viene indicizzato | Rendering server-side, strumenti di pre-rendering |

| Rankabilità | Se una pagina indicizzata può posizionarsi per specifiche keyword | Posizione nei risultati di ricerca | Determina la visibilità per le query | Qualità dei contenuti, autorevolezza, segnali di rilevanza |

| Trovabilità | Se gli utenti possono trovare una pagina tramite ricerca o link | Accesso degli utenti ai contenuti | Dipende da indicizzazione e ranking | Ottimizzazione SEO, link building, promozione |

La decisione di indicizzabilità coinvolge diverse fasi di valutazione che avvengono dopo la scansione di una pagina. Innanzitutto, i motori di ricerca effettuano il rendering, eseguendo JavaScript e processando contenuti dinamici per comprendere la struttura e il contenuto completi della pagina. In questa fase, Google valuta se elementi critici come heading, meta tag e dati strutturati sono implementati correttamente. In secondo luogo, i motori analizzano la qualità dei contenuti, verificando se la pagina offre informazioni originali, utili e pertinenti. Le pagine con contenuti scarni—testo minimo, poche parole o informazioni generiche—spesso non superano questa soglia qualitativa. In terza battuta, i motori verificano problemi di contenuto duplicato; se più URL contengono contenuti identici o molto simili, il motore seleziona una versione canonica da indicizzare, escludendo potenzialmente le altre. In quarta posizione, viene valutata la rilevanza semantica tramite elaborazione del linguaggio naturale, per determinare se il contenuto risponde realmente all’intento dell’utente e alle query di ricerca. Infine, vengono esaminati i segnali di fiducia e autorevolezza, tra cui struttura della pagina, pattern di link interni, citazioni esterne e autorevolezza generale del dominio. Secondo i dati del Web Almanac 2024 di HTTP Archive, il 53,4% delle pagine desktop e il 53,9% di quelle mobile include direttive di indicizzazione nei meta tag robots, segno di una diffusa consapevolezza dei controlli sull’indicizzabilità. Tuttavia, molti siti continuano ad avere problemi a causa di un’implementazione scorretta di questi fattori tecnici.

La qualità dei contenuti è diventata sempre più importante nelle decisioni di indicizzabilità, soprattutto dopo la centralità data da Google ai segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità). I motori di ricerca valutano se i contenuti dimostrano reale competenza, forniscono spunti originali e hanno uno scopo chiaro per l’utente. Le pagine che sembrano generate automaticamente, copiate da altre fonti o create principalmente per manipolare i motori di ricerca vengono spesso non indicizzate, anche se tecnicamente corrette. Una buona indicizzabilità richiede contenuti ben strutturati, con heading chiari, flusso logico e copertura completa dell’argomento. Le pagine dovrebbero includere prove a supporto come statistiche, case study, citazioni di esperti o ricerche originali. L’uso di schema markup e dati strutturati aiuta i motori di ricerca a comprendere il contesto dei contenuti e aumenta la probabilità di indicizzazione. Inoltre, la freschezza dei contenuti è importante: le pagine aggiornate regolarmente segnalano ai motori di ricerca che le informazioni sono attuali e rilevanti. Le pagine che non vengono aggiornate da anni possono essere declassate per l’indicizzazione, soprattutto in settori dinamici. Il rapporto tra qualità dei contenuti e indicizzabilità implica che i professionisti SEO debbano concentrarsi non solo sull’implementazione tecnica, ma anche sulla creazione di contenuti realmente utili all’utente.

L’ascesa di AI Overviews, ChatGPT, Perplexity e altri large language models (LLM) ha ampliato l’importanza dell’indicizzabilità oltre i risultati della ricerca tradizionale. Questi sistemi AI si basano su contenuti indicizzati dai motori di ricerca come dati di addestramento e materiale di riferimento per generare risposte. Quando una pagina è indicizzata da Google, diventa idonea a essere scoperta da crawler AI come OAI-SearchBot (il crawler di ChatGPT) e da altre piattaforme AI. Tuttavia, l’indicizzabilità per la ricerca AI comporta considerazioni aggiuntive rispetto alla SEO tradizionale. I sistemi AI valutano i contenuti per chiarezza semantica, accuratezza fattuale e idoneità alla citazione. Le pagine indicizzate ma prive di struttura chiara, citazioni corrette o segnali di autorevolezza potrebbero non essere selezionate per le risposte AI. Secondo una ricerca di Prerender.io, un cliente ha registrato un aumento dell’800% del traffico referral da ChatGPT dopo aver ottimizzato l’indicizzabilità del sito e garantito un rendering corretto per i crawler AI. Questo dimostra che pratiche solide di indicizzabilità hanno un impatto diretto sulla visibilità su più superfici di scoperta. Le organizzazioni devono ora considerare l’indicizzabilità non solo per Google Search, ma per l’intero ecosistema di piattaforme di ricerca e scoperta AI che si basano su contenuti indicizzati.

Diversi problemi comuni impediscono l’indicizzazione delle pagine nonostante siano scansionabili. I tag noindex involontari sono una causa frequente, spesso ereditati dai template dei CMS o applicati accidentalmente durante i redesign del sito. Controlla il sito tramite Google Search Console per individuare le pagine marcate come noindex e verifica se la scelta è intenzionale. Anche contenuti scarni o duplicati sono un importante ostacolo: pagine con poche informazioni originali o molto simili ad altre del sito possono non essere indicizzate. Consolida le pagine duplicate tramite redirect 301 o utilizza i tag canonici per specificare la versione preferita. Link interni rotti e pagine orfane—cioè prive di link interni che vi puntano—rendono difficile ai crawler la scoperta e la priorità per l’indicizzazione. Rafforza la struttura dei link interni assicurando che le pagine chiave siano raggiungibili dal menu di navigazione e dalle pagine più autorevoli. Catene di redirect e loop di redirect sprecano il crawl budget e confondono i motori su quale pagina indicizzare. Controlla i redirect e assicurati che puntino direttamente alla destinazione finale. Problemi di rendering JavaScript impediscono ai motori di vedere contenuti critici se caricati solo lato client. Usa il server-side rendering (SSR) o strumenti di pre-rendering come Prerender.io per garantire che tutti i contenuti siano visibili già nell’HTML iniziale. Tempi di caricamento lenti ed errori del server (codici 5xx) possono impedire l’indicizzazione; monitora le prestazioni del sito e risolvi tempestivamente i problemi tecnici.

Una gestione efficace dell’indicizzabilità richiede monitoraggio e misurazione continui. Google Search Console è lo strumento principale per tracciare l’indicizzabilità, con il rapporto “Indicizzazione delle pagine” (ex “Copertura dell’indice”) che mostra quante pagine sono indicizzate, escluse e i motivi. Questo report classifica le pagine come “Indicizzate”, “Scansionate – attualmente non indicizzate”, “Scoperte – attualmente non indicizzate” o “Escluse dal tag noindex”. Monitorare questi parametri nel tempo rivela tendenze e aiuta a individuare problemi sistemici. Il Rapporto di Efficienza dell’Indice (IER) è una metrica utile, calcolata come pagine indicizzate diviso pagine destinate all’indicizzazione. Se hai 10.000 pagine che dovrebbero essere indicizzabili ma solo 6.000 sono indicizzate, il tuo IER è 0,6, segnalando che il 40% dei contenuti desiderati non è visibile. Monitorare l’IER nel tempo aiuta a misurare l’impatto degli interventi sull’indicizzabilità. L’analisi dei log del server offre un’altra prospettiva chiave, mostrando quali pagine vengono effettivamente richieste da Googlebot e con quale frequenza. Strumenti come Log File Analyzer di Semrush rivelano se le pagine più importanti vengono scansionate regolarmente o se il crawl budget viene sprecato su contenuti a bassa priorità. Crawler di siti come Screaming Frog e Sitebulb aiutano a individuare problemi tecnici di indicizzabilità come link rotti, catene di redirect e tag canonici errati. Audit regolari—mensili per siti piccoli, trimestrali per quelli grandi—permettono di intercettare tempestivamente i problemi di indicizzabilità prima che impattino sulla visibilità nei risultati di ricerca.

Per ottenere una forte indicizzabilità è necessario un approccio sistematico che unisca implementazione tecnica e strategia dei contenuti. Primo, dai priorità alle pagine importanti: concentra gli sforzi su quelle che generano valore di business, come pagine prodotto, servizi e contenuti pilastro. Non tutte le pagine devono essere indicizzate; l’esclusione strategica di pagine a basso valore tramite noindex migliora l’efficienza della scansione. Secondo, garantisci una corretta canonicalizzazione: usa tag canonici autoreferenziali sulla maggior parte delle pagine e canonici cross-domain solo per consolidare contenuti in modo intenzionale. Terzo, implementa correttamente robots.txt: utilizzalo per bloccare cartelle tecniche e risorse secondarie, ma mai pagine che vuoi indicizzare. Quarto, crea contenuti originali e di qualità: punta su profondità, chiarezza e utilità invece che sulla densità di keyword. Quinto, ottimizza la struttura del sito: mantieni una gerarchia logica con le pagine chiave raggiungibili entro tre click dalla home e usa link interni chiari per guidare utenti e crawler. Sesto, aggiungi dati strutturati: implementa schema markup per articoli, FAQ, prodotti e organizzazioni per aiutare i motori a comprendere i contenuti. Settimo, assicura solidità tecnica: correggi link rotti, elimina catene di redirect, ottimizza la velocità di caricamento e monitora gli errori server. Infine, mantieni i contenuti aggiornati: aggiorna regolarmente le pagine importanti per segnalare che le informazioni sono attuali e rilevanti. Queste pratiche creano un ambiente in cui i motori di ricerca possono indicizzare con sicurezza i tuoi contenuti più preziosi.

L’indicizzabilità si evolve insieme alle tecnologie di ricerca. L’avvento del mobile-first indexing implica che Google scansiona e indicizza prioritariamente la versione mobile delle pagine, rendendo l’ottimizzazione mobile essenziale per l’indicizzabilità. La crescente importanza dei Core Web Vitals e dei segnali di esperienza utente suggerisce che le performance tecniche avranno un ruolo sempre maggiore nelle decisioni di indicizzazione. Con la diffusione della ricerca AI, i requisiti di indicizzabilità potrebbero spostarsi verso una maggiore chiarezza semantica, accuratezza fattuale e qualità delle citazioni rispetto ai tradizionali fattori di ranking. L’emergere di zero-click search e featured snippet significa che anche le pagine indicizzate devono essere ottimizzate per l’estrazione e la sintesi da parte dei motori di ricerca e dei sistemi AI. Le organizzazioni dovrebbero aspettarsi standard di indicizzabilità sempre più selettivi, con i motori che indicizzeranno meno pagine ma di qualità superiore. Questa tendenza rende sempre più importante puntare sulla creazione di contenuti realmente preziosi e su una corretta implementazione tecnica, invece di tentare di indicizzare ogni possibile variante di pagina. Il futuro dell’indicizzabilità è nella qualità, non nella quantità: motori e AI saranno sempre più abili nel individuare e prioritizzare i contenuti che rispondono realmente ai bisogni degli utenti.

Per le organizzazioni che usano piattaforme di monitoraggio AI come AmICited, comprendere l’indicizzabilità è fondamentale per tracciare la visibilità del brand su più superfici di scoperta. Quando le tue pagine sono correttamente indicizzate da Google, diventano idonee a essere citate nelle risposte AI su piattaforme come ChatGPT, Perplexity, Google AI Overviews e Claude. Tuttavia, la sola indicizzabilità non garantisce la visibilità AI; i tuoi contenuti devono essere anche semanticamente rilevanti, autorevoli e ben strutturati affinché i sistemi AI li selezionino come fonte. AmICited aiuta le organizzazioni a monitorare se i contenuti indicizzati vengono effettivamente citati e referenziati nelle risposte AI, offrendo insight su come l’indicizzabilità si traduca in reale visibilità nell’ecosistema della ricerca AI. Unendo il monitoraggio tradizionale dell’indicizzabilità al tracking delle citazioni AI, le organizzazioni possono avere una visione completa della propria visibilità nella ricerca e prendere decisioni data-driven sull’ottimizzazione dei contenuti e i miglioramenti SEO tecnici.

La crawlabilità si riferisce alla possibilità che i bot dei motori di ricerca possano accedere e leggere una pagina web, mentre l’indicizzabilità determina se quella pagina scansionata può essere archiviata nell’indice del motore di ricerca. Una pagina può essere scansionabile ma non indicizzabile se contiene un tag noindex o non supera le valutazioni di qualità. Entrambe sono essenziali per la visibilità nei motori di ricerca, ma la crawlabilità è il prerequisito per l’indicizzabilità.

Il tag meta noindex o l’intestazione HTTP comunicano esplicitamente ai motori di ricerca di non includere una pagina nel loro indice, anche se la pagina è scansionabile. Quando Googlebot incontra una direttiva noindex, la pagina viene rimossa completamente dai risultati di ricerca. Questo è utile per pagine come quelle di ringraziamento o contenuti duplicati che hanno una funzione, ma non dovrebbero apparire nei risultati di ricerca.

Il file robots.txt controlla quali pagine i motori di ricerca possono scansionare, ma non impedisce direttamente l’indicizzazione. Se una pagina è bloccata da robots.txt, i crawler non possono vedere il tag noindex, quindi la pagina potrebbe comunque apparire nei risultati se altri siti la linkano. Per un controllo efficace dell’indicizzabilità, utilizza i tag noindex invece del blocco tramite robots.txt per le pagine che vuoi escludere dai risultati di ricerca.

I motori di ricerca valutano la qualità dei contenuti come parte della decisione di indicizzabilità. Le pagine con contenuti scarni, informazioni duplicate o di basso valore possono essere scansionate ma non indicizzate. Gli algoritmi di indicizzazione di Google valutano se i contenuti sono originali, utili e pertinenti all’intento dell’utente. Contenuti di alta qualità, unici, con struttura chiara e formattazione corretta hanno maggiori probabilità di essere indicizzati.

Il rapporto di efficienza dell’indice (IER) si calcola come pagine indicizzate diviso pagine destinate all’indicizzazione. Ad esempio, se 10.000 pagine dovrebbero essere indicizzabili ma solo 6.000 sono indicizzate, il tuo IER è 0,6. Questa metrica aiuta a misurare quanto efficacemente i contenuti del tuo sito vengono inclusi negli indici di ricerca e identifica le lacune tra la visibilità potenziale e quella reale.

I tag canonici comunicano ai motori di ricerca quale versione di una pagina considerare come fonte autorevole quando esistono contenuti duplicati o simili. Un’implementazione errata dei canonici può impedire l’indicizzazione della pagina corretta o portare Google a indicizzare una versione indesiderata. I canonici autoreferenziali (in cui il canonical corrisponde all’URL della pagina stessa) sono la best practice per la maggior parte delle pagine.

Sì, una pagina può essere indicizzata senza posizionarsi per alcuna parola chiave. L’indicizzazione significa che la pagina è archiviata nel database del motore di ricerca ed è idonea ad apparire nei risultati. Il posizionamento è un processo separato in cui i motori di ricerca determinano quali pagine indicizzate mostrare per query specifiche. Molte pagine indicizzate non si posizionano mai perché non corrispondono all’intento di ricerca dell’utente o mancano di sufficienti segnali di autorevolezza.

I motori di ricerca AI come ChatGPT, Perplexity e Claude utilizzano contenuti indicizzati dai motori di ricerca tradizionali come dati di addestramento e materiale di riferimento. Se le tue pagine non sono indicizzate da Google, è meno probabile che vengano scoperte e citate dai sistemi AI. Garantire una forte indicizzabilità nei motori di ricerca tradizionali è fondamentale per la visibilità anche sulle piattaforme di ricerca alimentate dall’AI.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

La copertura dell'indice misura quali pagine di un sito web sono indicizzate dai motori di ricerca. Scopri cosa significa, perché è importante per la SEO e come...

La crawlability è la capacità dei motori di ricerca di accedere e navigare le pagine di un sito web. Scopri come funzionano i crawler, cosa li blocca e come ott...

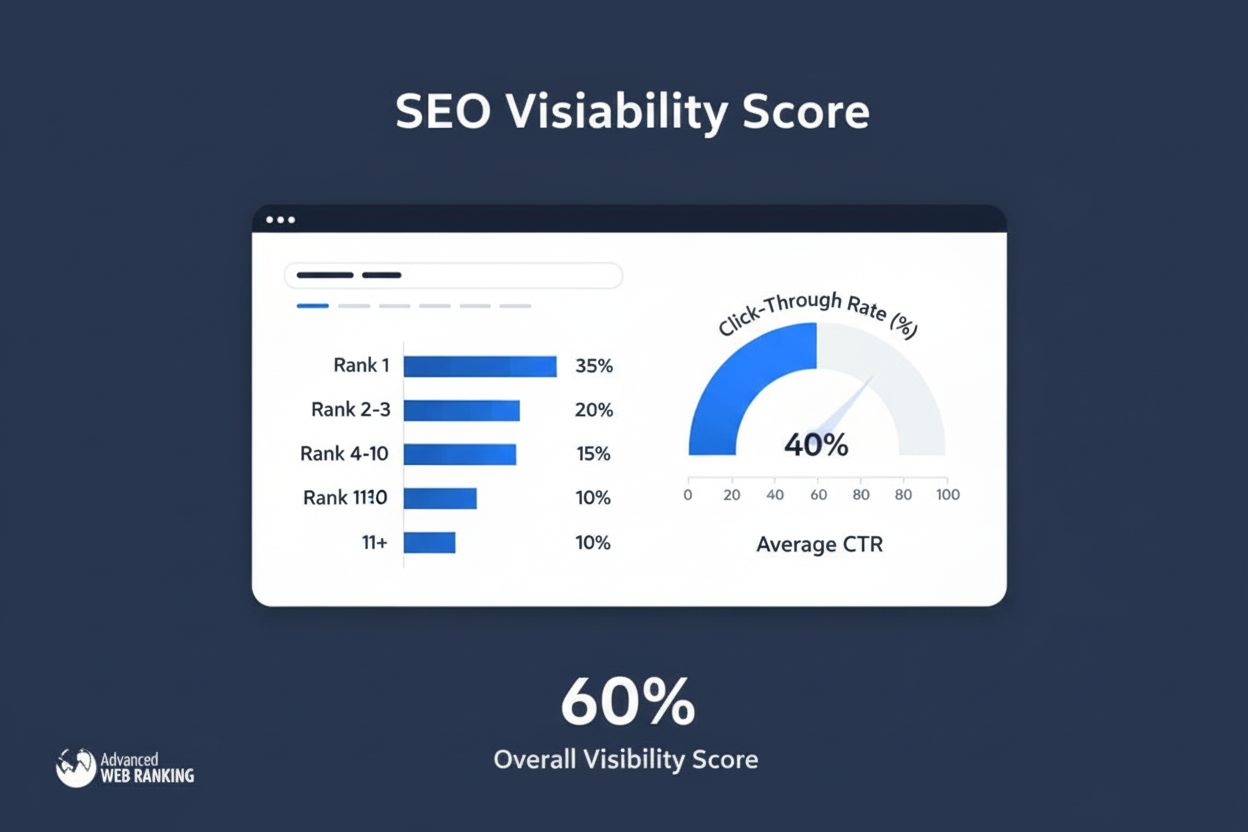

Il punteggio di visibilità misura la presenza nella ricerca calcolando i clic stimati dai posizionamenti organici. Scopri come funziona questa metrica, i metodi...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.