Creare Meta Risposte LLM: Approfondimenti Autonomi che l’AI Può Citare

Scopri come creare meta risposte LLM che i sistemi AI citano. Scopri tecniche strutturali, strategie di densità delle risposte e formati di contenuto pronti per...

Contenuti che affrontano direttamente il modo in cui i modelli linguistici possono interpretare e rispondere a query correlate, progettati per migliorare la visibilità nelle risposte generate dall’IA su piattaforme come ChatGPT, Google AI Overviews e Perplexity. Le Risposte Meta LLM rappresentano risposte sintetizzate che combinano informazioni provenienti da più fonti in risposte coese e conversazionali che soddisfano l’intento dell’utente.

Contenuti che affrontano direttamente il modo in cui i modelli linguistici possono interpretare e rispondere a query correlate, progettati per migliorare la visibilità nelle risposte generate dall’IA su piattaforme come ChatGPT, Google AI Overviews e Perplexity. Le Risposte Meta LLM rappresentano risposte sintetizzate che combinano informazioni provenienti da più fonti in risposte coese e conversazionali che soddisfano l’intento dell’utente.

Le Risposte Meta LLM rappresentano le risposte sintetizzate e generate dall’IA che i grandi modelli linguistici producono quando gli utenti fanno domande tramite piattaforme come ChatGPT, Claude o Google AI Overviews. Queste risposte sono fondamentalmente diverse dai risultati di ricerca tradizionali perché combinano informazioni da più fonti in una risposta coesa e conversazionale che affronta direttamente l’intento dell’utente. Anziché presentare un elenco di link, gli LLM analizzano i contenuti recuperati e generano testo originale che incorpora fatti, prospettive e intuizioni dai loro dati di addestramento e dai sistemi di generazione aumentata da recupero (RAG). Comprendere come gli LLM costruiscono queste meta risposte è essenziale per i creatori di contenuti che desiderano che il loro lavoro venga citato e referenziato nelle risposte generate dall’IA. La visibilità dei tuoi contenuti in queste risposte IA è diventata importante quanto il posizionamento nei risultati di ricerca tradizionali, rendendo l’ottimizzazione LLM (LLMO) una componente fondamentale della strategia di contenuto moderna.

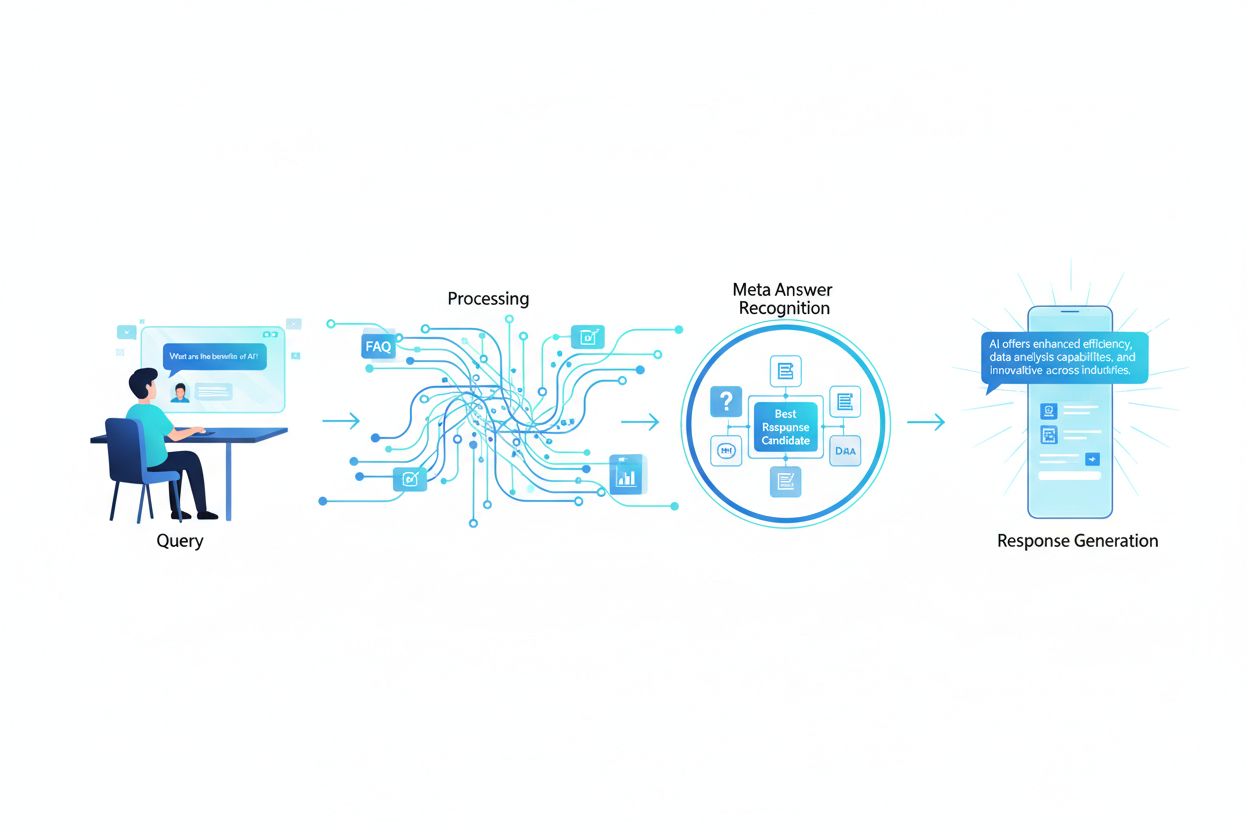

Quando un utente invia una query a un LLM, il sistema non si limita a corrispondere le keyword come fanno i motori di ricerca tradizionali. Gli LLM eseguono invece un’analisi semantica per comprendere l’intento sottostante, il contesto e la sfumatura della domanda. Il modello scompone la query in componenti concettuali, identifica argomenti e entità correlate e determina quale tipo di risposta sarebbe più utile—che si tratti di una definizione, un confronto, una guida passo-passo o una prospettiva analitica. Gli LLM recuperano quindi contenuti rilevanti dalla loro base di conoscenza utilizzando sistemi RAG che danno priorità alle fonti in base a pertinenza, autorevolezza e completezza. Il processo di recupero considera non solo corrispondenze esatte di keyword ma anche la similarità semantica, le relazioni tematiche e quanto bene i contenuti affrontano gli aspetti specifici della query. Ciò significa che i tuoi contenuti devono essere rintracciabili non solo per le keyword esatte, ma per i concetti semantici e gli argomenti correlati che gli utenti realmente cercano.

| Fattore di Interpretazione Query | Ricerca Tradizionale | Risposte Meta LLM |

|---|---|---|

| Metodo di Corrispondenza | Corrispondenza keyword | Comprensione semantica |

| Formato Risultato | Elenco di link | Narrazione sintetizzata |

| Selezione Fonte | Ranking di pertinenza | Pertinenza + completezza + autorevolezza |

| Considerazione del Contesto | Limitata | Ampio contesto semantico |

| Sintesi della Risposta | L’utente deve leggere più fonti | L’IA combina più fonti |

| Necessità di Citazione | Facoltativa | Spesso inclusa |

Perché i tuoi contenuti vengano selezionati e citati nelle risposte meta LLM, devono possedere alcune caratteristiche fondamentali che si allineano con il modo in cui questi sistemi valutano e sintetizzano le informazioni. Innanzitutto, i tuoi contenuti devono dimostrare chiara esperienza e autorevolezza sull’argomento, con forti segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità) che aiutano gli LLM a identificare fonti affidabili. In secondo luogo, il contenuto dovrebbe offrire un reale valore informativo—intuiti uniche, dati o prospettive che aggiungono valore rispetto a ciò che è comunemente disponibile. Terzo, i tuoi contenuti devono essere strutturati in modo che gli LLM possano facilmente analizzarli ed estrarre informazioni rilevanti, usando gerarchie chiare e un’organizzazione logica. Quarto, la ricchezza semantica è essenziale; i tuoi contenuti dovrebbero esplorare a fondo i concetti correlati, usare una terminologia varia e costruire un’autorevolezza tematica completa invece di concentrarsi solo su una singola keyword. Quinto, la freschezza è molto importante per argomenti attuali, poiché gli LLM privilegiano informazioni recenti e aggiornate nella sintesi delle risposte. Infine, i tuoi contenuti dovrebbero includere prove a supporto tramite citazioni, dati e riferimenti esterni che costruiscono fiducia nei sistemi LLM.

Caratteristiche chiave che migliorano la citazione dagli LLM:

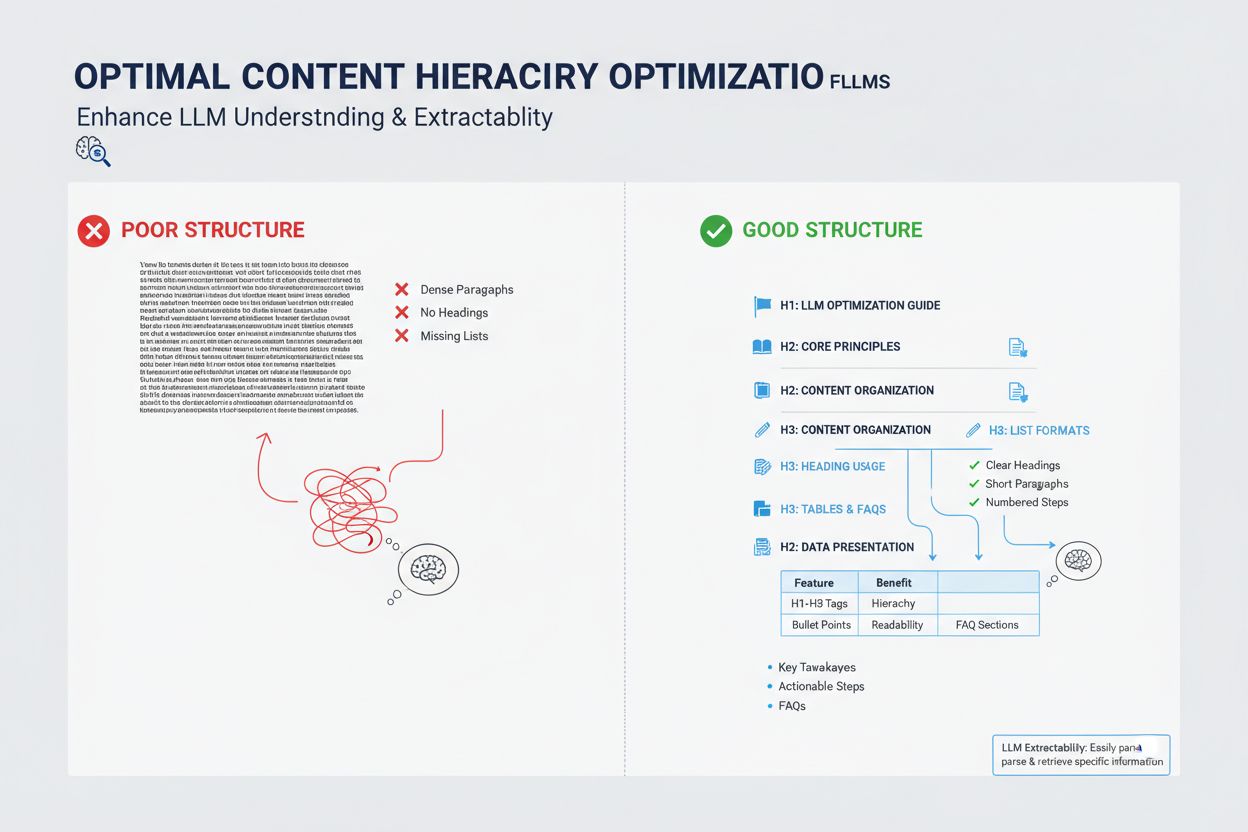

Il modo in cui strutturi i tuoi contenuti ha un impatto profondo sulla probabilità che gli LLM li selezionino per le meta risposte, poiché questi sistemi sono ottimizzati per estrarre e sintetizzare informazioni ben organizzate. Gli LLM preferiscono fortemente i contenuti con gerarchie di titoli chiare (H1, H2, H3) che creano un’architettura logica dell’informazione, consentendo al modello di comprendere la relazione tra i concetti ed estrarre sezioni rilevanti in modo efficiente. I punti elenco e le liste numerate sono particolarmente preziosi perché presentano informazioni in unità scansionabili e discrete che gli LLM possono facilmente incorporare nelle risposte sintetizzate. Le tabelle sono particolarmente potenti per la visibilità LLM perché presentano dati strutturati in un formato che i sistemi IA possono facilmente analizzare e referenziare. Paragrafi brevi (3-5 frasi) funzionano meglio di blocchi di testo densi, poiché consentono agli LLM di identificare ed estrarre informazioni specifiche senza dover vagliare contenuti irrilevanti. Inoltre, l’uso di markup schema (FAQ, Articolo, HowTo) fornisce segnali espliciti agli LLM sulla struttura e lo scopo dei tuoi contenuti, migliorando significativamente la probabilità di citazione.

Sebbene le risposte meta LLM e i featured snippet possano sembrare simili in superficie, rappresentano meccanismi fondamentalmente diversi per la visibilità dei contenuti e richiedono strategie di ottimizzazione distinte. I featured snippet sono selezionati dagli algoritmi di ricerca tradizionali da contenuti web esistenti e visualizzati in una posizione specifica nella pagina dei risultati di ricerca, mostrando tipicamente 40-60 parole di testo estratto. Le risposte meta LLM, invece, sono risposte generate dall’IA che sintetizzano informazioni da più fonti in una nuova narrazione originale che può essere più lunga e completa di qualsiasi singola fonte. I featured snippet premiano i contenuti che rispondono direttamente e in modo conciso a una domanda specifica, mentre le risposte meta LLM premiano contenuti autorevoli e completi che offrono una copertura tematica profonda. I meccanismi di citazione differiscono significativamente: i featured snippet mostrano un link alla fonte ma il contenuto è estratto testualmente, mentre le meta risposte LLM possono parafrasare o sintetizzare i tuoi contenuti e di solito includono l’attribuzione. Inoltre, i featured snippet sono ottimizzati principalmente per la ricerca tradizionale, mentre le risposte meta LLM sono ottimizzate per le piattaforme IA e potrebbero non apparire affatto nei risultati di ricerca.

| Aspetto | Featured Snippets | Risposte Meta LLM |

|---|---|---|

| Metodo di Generazione | Algoritmo estrae testo esistente | IA sintetizza da più fonti |

| Formato di Visualizzazione | Posizione pagina risultati ricerca | Risposta piattaforma IA |

| Lunghezza Contenuto | Tipicamente 40-60 parole | 200-500+ parole |

| Stile Citazione | Link fonte con testo estratto | Attribuzione con contenuto parafrasato |

| Focus Ottimizzazione | Risposte dirette concise | Autorevolezza completa |

| Piattaforma | Google Search | ChatGPT, Claude, Google AI Overviews |

| Metrica Visibilità | Impression ricerca | Citazioni nelle risposte IA |

La ricchezza semantica—la profondità e l’ampiezza della copertura concettuale nei tuoi contenuti—è uno dei fattori più importanti ma spesso trascurati nell’ottimizzazione LLM. Gli LLM non cercano solo la keyword target; analizzano le relazioni semantiche tra i concetti, le informazioni contestuali che circondano il tema principale e quanto a fondo esplori idee correlate. I contenuti con alta ricchezza semantica utilizzano terminologia varia, esplorano più angolazioni di un argomento e costruiscono connessioni tra concetti correlati, aiutando gli LLM a comprendere che i tuoi contenuti sono veramente autorevoli e non superficialmente ottimizzati per le keyword. Quando scrivi su un tema, includi termini correlati, sinonimi e idee concettualmente vicine che aiutano gli LLM a collocare i tuoi contenuti in un knowledge graph più ampio. Ad esempio, un articolo sul “content marketing” dovrebbe includere naturalmente discussioni su segmentazione del pubblico, buyer personas, distribuzione dei contenuti, analytics e ROI—non per accumulare keyword, ma perché questi concetti sono semanticamente collegati ed essenziali per una comprensione completa. Questa profondità semantica segnala agli LLM che possiedi autentica esperienza e puoi offrire le risposte sfaccettate e approfondite che gli utenti cercano.

Gli LLM valutano l’autorevolezza in modo diverso rispetto ai motori di ricerca tradizionali, dando maggiore importanza ai segnali che indicano competenza reale e affidabilità piuttosto che alla sola popolarità dei link. Le credenziali dell’autore e l’esperienza dimostrata sono particolarmente importanti; gli LLM favoriscono contenuti di esperti riconosciuti, professionisti o organizzazioni con autorevolezza consolidata nel settore. Le citazioni esterne e i riferimenti ad altre fonti autorevoli rafforzano la credibilità agli occhi degli LLM, in quanto dimostrano che i tuoi contenuti sono radicati in una conoscenza più ampia e confermati da altri esperti. La coerenza tra più contenuti pubblicati su un argomento aiuta a costruire autorevolezza tematica; gli LLM riconoscono quando un autore o un’organizzazione ha pubblicato più articoli completi su temi correlati. La validazione da parte di terzi attraverso menzioni, citazioni o riferimenti da altre fonti autorevoli incrementa notevolmente la visibilità nelle risposte meta LLM. Ricerca originale, dati proprietari o metodologie uniche forniscono forti segnali di autorevolezza perché rappresentano informazioni non reperibili altrove. Inoltre, mantenere una cronologia di pubblicazione aggiornata e rinfrescare regolarmente i contenuti segnala che sei attivamente impegnato sull’argomento e aggiornato sugli sviluppi.

Segnali di autorevolezza che influenzano la selezione da parte degli LLM:

La freschezza dei contenuti è diventata sempre più cruciale per la visibilità LLM, soprattutto per argomenti in cui le informazioni cambiano frequentemente o dove sviluppi recenti hanno un impatto significativo sulla risposta. Gli LLM sono addestrati su dati con date di cutoff, ma fanno sempre più affidamento su sistemi RAG che recuperano informazioni attuali dal web, il che significa che la data di pubblicazione e la frequenza di aggiornamento dei tuoi contenuti influenzano direttamente la probabilità di essere selezionati per le meta risposte. Per gli argomenti evergreen, aggiornamenti regolari—anche minimi che rinfreschino la data di pubblicazione—segnalano agli LLM che i tuoi contenuti sono mantenuti attivamente e affidabili. Per temi sensibili al tempo come trend di settore, aggiornamenti tecnologici o eventi attuali, i contenuti obsoleti sono attivamente declassati dagli LLM a favore di fonti più recenti. La migliore pratica è stabilire un calendario di manutenzione dei contenuti in cui rivedi e aggiorni i pezzi chiave ogni trimestre o semestre, aggiornando statistiche, aggiungendo nuovi esempi e includendo sviluppi recenti. Questa manutenzione continua non solo migliora la visibilità LLM, ma dimostra sia ai sistemi IA che ai lettori umani che sei una fonte attuale e affidabile.

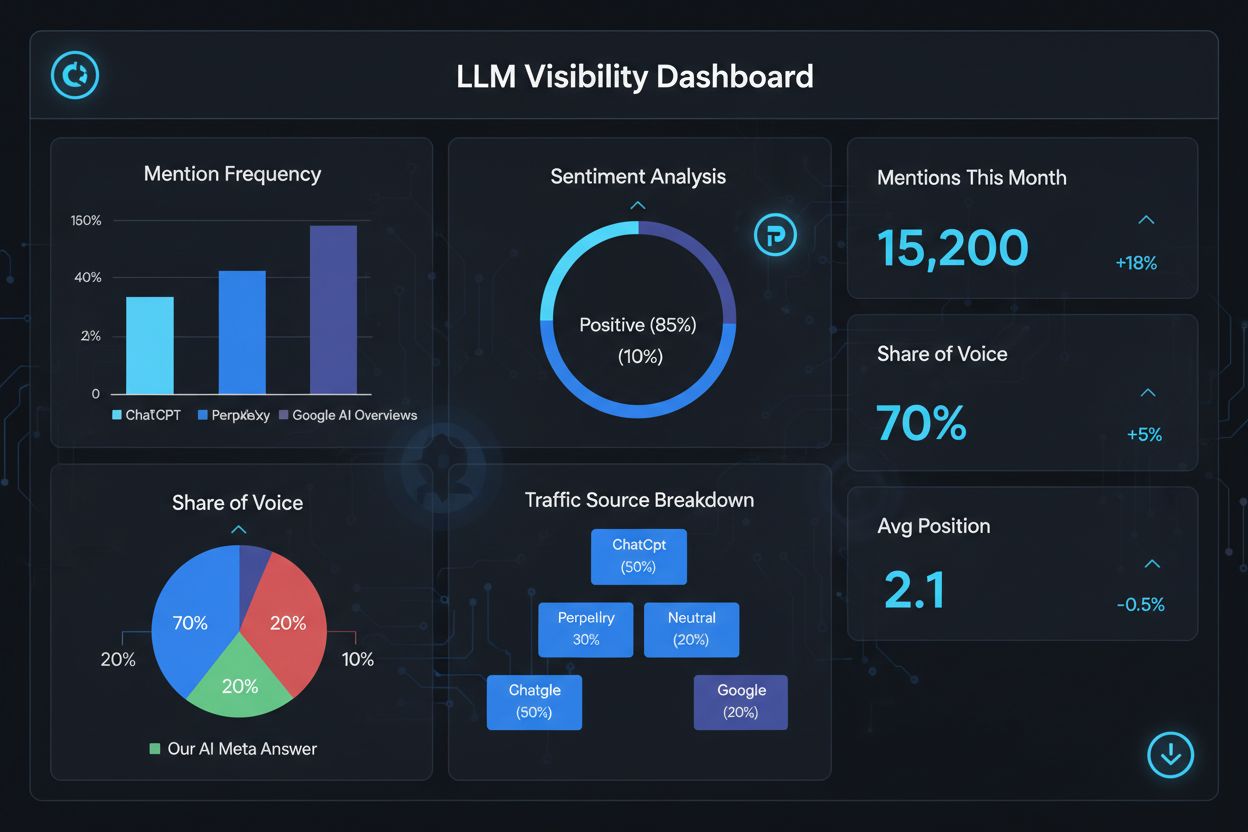

Misurare il successo nelle risposte meta LLM richiede metriche e strumenti diversi rispetto alla SEO tradizionale, poiché queste risposte esistono al di fuori dell’ecosistema classico dei risultati di ricerca. Strumenti come AmICited.com offrono monitoraggio specializzato che traccia quando e dove i tuoi contenuti appaiono nelle risposte generate dall’IA, dandoti visibilità su quali pezzi vengono citati e con quale frequenza. Dovresti monitorare diverse metriche chiave: frequenza di citazione (quanto spesso i tuoi contenuti appaiono nelle risposte LLM), contesto della citazione (quali argomenti fanno scattare l’inclusione dei tuoi contenuti), diversità delle fonti (se vieni citato su diverse piattaforme LLM) e posizione della risposta (se i tuoi contenuti sono messi in evidenza nella risposta sintetizzata). Tieni traccia di quali pagine o sezioni dei tuoi contenuti vengono citate più spesso: questo rivela quali informazioni gli LLM trovano più preziose e affidabili. Monitora i cambiamenti nei pattern di citazione nel tempo per identificare quali strategie di ottimizzazione stanno funzionando e quali argomenti necessitano di ulteriore sviluppo. Inoltre, analizza le query che attivano le tue citazioni per comprendere come gli LLM interpretano l’intento utente e quali variazioni semantiche sono più efficaci.

Metriche chiave per le performance delle risposte meta LLM:

Ottimizzare per le risposte meta LLM richiede un approccio strategico che combini implementazione tecnica, qualità dei contenuti e misurazione continua. Inizia conducendo una ricerca tematica completa per identificare i gap dove la tua esperienza può offrire valore unico che gli LLM priorizzeranno rispetto alle fonti generiche. Struttura i tuoi contenuti con gerarchie chiare, utilizzando titoli H2 e H3 per creare un’architettura logica dell’informazione che gli LLM possano facilmente analizzare ed estrarre. Implementa markup schema (FAQ, Articolo, HowTo) per segnalare esplicitamente la struttura e lo scopo dei tuoi contenuti ai sistemi LLM, migliorando notevolmente la scoperta. Sviluppa contenuti autorevoli e completi che esplorino il tuo argomento da più angolazioni, includendo concetti correlati e costruendo ricchezza semantica che dimostri esperienza reale. Includi ricerca originale, dati o intuizioni che forniscano valore informativo e differenzino i tuoi contenuti dai concorrenti. Mantieni un programma di aggiornamento regolare dei contenuti, rinfrescando i pezzi chiave ogni trimestre per garantire freschezza e segnalare autorevolezza continua. Costruisci autorevolezza tematica creando più pezzi correlati che collettivamente stabiliscano la tua esperienza su una materia. Usa un linguaggio chiaro e diretto che risponda alle domande specifiche degli utenti, facilitando l’estrazione e la sintesi da parte degli LLM. Infine, monitora la performance delle tue citazioni LLM con strumenti specializzati per identificare ciò che funziona e perfezionare continuamente la tua strategia sulla base di dati concreti.

Le Risposte Meta LLM si concentrano su come i modelli linguistici interpretano e citano i contenuti, mentre la SEO tradizionale si focalizza sul posizionamento nei risultati di ricerca. Gli LLM privilegiano la pertinenza e la chiarezza rispetto all’autorità del dominio, rendendo i contenuti ben strutturati e orientati alla risposta più importanti dei backlink. I tuoi contenuti possono essere citati nelle risposte LLM anche se non sono tra i primi risultati di Google.

Struttura i contenuti con titoli chiari, fornisci risposte dirette subito, utilizza markup schema (FAQ, Articolo), includi citazioni e statistiche, mantieni l’autorità tematica e assicurati che il sito sia accessibile ai bot IA. Concentrati su ricchezza semantica, valore informativo e copertura completa dell’argomento anziché su keyword troppo specifiche.

Gli LLM estraggono più facilmente snippet da contenuti ben organizzati. Titoli chiari, elenchi, tabelle e paragrafi brevi aiutano i modelli a identificare e citare le informazioni rilevanti. Studi dimostrano che le pagine citate dagli LLM hanno molti più elementi strutturati rispetto alle pagine web medie, rendendo la struttura un fattore di ranking fondamentale.

Sì. A differenza della SEO tradizionale, gli LLM privilegiano la pertinenza della query e la qualità dei contenuti rispetto all’autorità del dominio. Una pagina di nicchia ben strutturata e molto pertinente può essere citata dagli LLM anche se non compare tra i primi risultati di Google, rendendo l’esperienza e la chiarezza più importanti dell’autorità del sito.

Aggiorna regolarmente i contenuti, soprattutto per argomenti sensibili al tempo. Aggiungi date che mostrino l’ultimo aggiornamento. Per argomenti evergreen, sono consigliate revisioni trimestrali. I contenuti freschi segnalano accuratezza agli LLM, migliorando la probabilità di citazione e dimostrando autorità continua.

AmICited.com è specializzato nel monitoraggio delle menzioni IA su ChatGPT, Perplexity e Google AI Overviews. Altri strumenti includono Semrush AI SEO Toolkit, Ahrefs Brand Radar e Peec AI. Questi strumenti monitorano la frequenza di menzione, la quota di voce, il sentiment e ti aiutano a misurare il successo dell’ottimizzazione.

Il markup schema (FAQ, Articolo, HowTo) fornisce una struttura leggibile dalle macchine che aiuta gli LLM a comprendere ed estrarre i contenuti con maggiore accuratezza. Segnala il tipo e l’intento del contenuto, rendendo la tua pagina più probabile da selezionare per query rilevanti e migliorando la scoperta complessiva.

Le menzioni esterne su siti autorevoli (news, Wikipedia, pubblicazioni di settore) costruiscono credibilità e aumentano le probabilità che gli LLM citino i tuoi contenuti. Più fonti indipendenti menzionano il tuo brand o dati, più si crea un pattern di autorevolezza che gli LLM riconoscono e premiano con una maggiore frequenza di citazione.

Tieni traccia di come il tuo brand appare nelle risposte generate dall’IA su ChatGPT, Perplexity e Google AI Overviews con la piattaforma di monitoraggio specializzata di AmICited.

Scopri come creare meta risposte LLM che i sistemi AI citano. Scopri tecniche strutturali, strategie di densità delle risposte e formati di contenuto pronti per...

Scopri come gli LLM generano risposte tramite tokenizzazione, architettura transformer, meccanismi di attenzione e predizione probabilistica. Approfondisci il p...

Scopri come individuare e mirare i siti fonte LLM per backlink strategici. Scopri quali piattaforme AI citano più spesso le fonti e ottimizza la tua strategia d...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.