Ricerca AI Multimodale: Ottimizzazione per Query Immagine e Voce

Diventa esperto nell'ottimizzazione della ricerca AI multimodale. Scopri come ottimizzare immagini e query vocali per risultati di ricerca potenziati dall'AI, c...

Sistemi di intelligenza artificiale che elaborano e rispondono a query che coinvolgono testo, immagini, audio e video simultaneamente, consentendo una comprensione più completa e risposte consapevoli del contesto attraverso molteplici tipi di dati.

Sistemi di intelligenza artificiale che elaborano e rispondono a query che coinvolgono testo, immagini, audio e video simultaneamente, consentendo una comprensione più completa e risposte consapevoli del contesto attraverso molteplici tipi di dati.

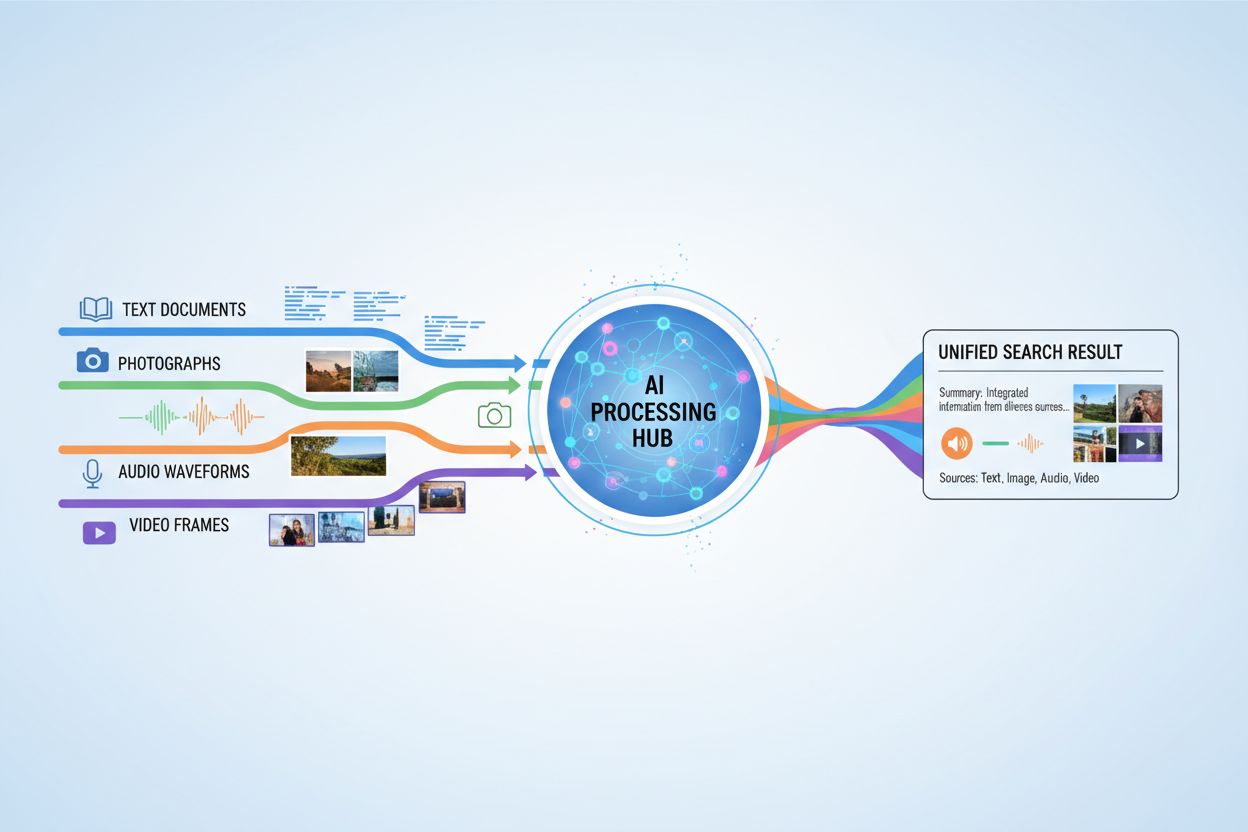

La ricerca AI multimodale si riferisce a sistemi di intelligenza artificiale che elaborano e integrano informazioni da molteplici tipi di dati o modalità—come testo, immagini, audio e video—simultaneamente per fornire risultati più completi e contestualmente rilevanti. A differenza dell’AI unimodale, che si basa su un unico tipo di input (ad esempio, motori di ricerca solo-testuali), i sistemi multimodali sfruttano i punti di forza complementari dei diversi formati di dati per ottenere una comprensione più approfondita e risultati più precisi. Questo approccio rispecchia la cognizione umana, in cui naturalmente combiniamo informazioni visive, uditive e testuali per comprendere l’ambiente che ci circonda. Elaborando insieme diversi tipi di input, i sistemi di ricerca AI multimodale possono cogliere sfumature e relazioni che sarebbero invisibili agli approcci a singola modalità.

La ricerca AI multimodale opera attraverso sofisticate tecniche di fusione che combinano informazioni da diverse modalità in vari stadi di elaborazione. Il sistema prima estrae le caratteristiche da ciascuna modalità in modo indipendente, quindi fonde strategicamente queste rappresentazioni per creare una comprensione unificata. Il momento e il metodo della fusione incidono significativamente sulle prestazioni, come illustrato nel seguente confronto:

| Tipo di Fusione | Quando Applicata | Vantaggi | Svantaggi |

|---|---|---|---|

| Fusione Precoce | Fase di input | Cattura correlazioni a basso livello | Meno robusta con dati disallineati |

| Fusione Intermedia | Stadi di pre-elaborazione | Approccio bilanciato | Più complessa |

| Fusione Tardiva | Livello di output | Design modulare | Coesione contestuale ridotta |

La fusione precoce combina i dati grezzi immediatamente, catturando interazioni dettagliate ma avendo difficoltà con input disallineati. La fusione intermedia si applica durante le fasi di elaborazione intermedie, offrendo un compromesso bilanciato tra complessità e prestazioni. La fusione tardiva opera a livello di output, consentendo l’elaborazione indipendente delle modalità ma potenzialmente perdendo importante contesto cross-modale. La scelta della strategia di fusione dipende dai requisiti applicativi specifici e dalla natura dei dati elaborati.

Diverse tecnologie chiave alimentano i moderni sistemi di ricerca AI multimodale, consentendo loro di elaborare e integrare efficacemente diversi tipi di dati:

Queste tecnologie lavorano in sinergia per creare sistemi in grado di comprendere relazioni complesse tra diversi tipi di informazioni.

La ricerca AI multimodale ha applicazioni trasformative in numerosi settori e domini. Nel settore sanitario, i sistemi analizzano immagini mediche insieme alle cartelle cliniche e alle note dei pazienti per migliorare l’accuratezza diagnostica e le raccomandazioni terapeutiche. Le piattaforme di e-commerce utilizzano la ricerca multimodale per consentire ai clienti di trovare prodotti combinando descrizioni testuali con riferimenti visivi o persino schizzi. I veicoli autonomi si affidano alla fusione multimodale di flussi di telecamere, dati radar e input dei sensori per navigare in sicurezza e prendere decisioni in tempo reale. I sistemi di moderazione dei contenuti combinano riconoscimento delle immagini, analisi del testo ed elaborazione audio per identificare contenuti dannosi in modo più efficace rispetto agli approcci a singola modalità. Inoltre, la ricerca multimodale migliora l’accessibilità permettendo agli utenti di cercare usando il metodo di input preferito—voce, immagine o testo—mentre il sistema comprende l’intento su tutti i formati.

La ricerca AI multimodale offre benefici sostanziali che giustificano la maggiore complessità e i requisiti computazionali. Maggiore accuratezza grazie allo sfruttamento di fonti di informazione complementari, riducendo gli errori che potrebbero verificarsi in sistemi a singola modalità. Migliore comprensione contestuale quando informazioni visive, testuali e uditive si combinano per fornire un significato semantico più ricco. Esperienza utente superiore grazie a interfacce di ricerca più intuitive che accettano diversi tipi di input e restituiscono risultati più rilevanti. Apprendimento cross-domain reso possibile dal trasferimento di conoscenza da una modalità all’altra, consentendo il transfer learning tra diversi tipi di dati. Maggiore robustezza significa che il sistema mantiene le prestazioni anche quando una modalità è degradata o non disponibile, poiché le altre possono compensare l’informazione mancante.

Nonostante i vantaggi, la ricerca AI multimodale affronta sfide tecniche e pratiche significative. Allineamento e sincronizzazione dei dati restano difficili, poiché le diverse modalità spesso presentano caratteristiche temporali e livelli di qualità differenti che devono essere gestiti attentamente. La complessità computazionale aumenta notevolmente quando si elaborano più flussi di dati simultaneamente, richiedendo risorse e hardware specializzati. Bias ed equità diventano problematici quando i dati di addestramento sono sbilanciati tra le modalità o quando determinati gruppi sono sottorappresentati in specifici tipi di dati. Privacy e sicurezza si complicano con flussi di dati multipli, aumentando la superficie di esposizione a potenziali violazioni e richiedendo una gestione accurata delle informazioni sensibili. I requisiti di dati massicci fanno sì che addestrare sistemi multimodali efficaci richieda dataset molto più ampi e diversificati rispetto alle alternative unimodali, il che può essere costoso e richiedere molto tempo per essere acquisito e annotato.

La ricerca AI multimodale si intreccia in modo importante con il monitoraggio AI e il tracciamento delle citazioni, specialmente man mano che i sistemi AI generano sempre più risposte che fanno riferimento o sintetizzano informazioni da più fonti. Piattaforme come AmICited.com si concentrano sul monitorare come i sistemi AI citano e attribuiscono le informazioni alle fonti originali, garantendo trasparenza e responsabilità nelle risposte generate dall’AI. Allo stesso modo, FlowHunt.io traccia la generazione di contenuti AI e aiuta le organizzazioni a comprendere come i loro contenuti di brand vengono elaborati e referenziati dai sistemi AI multimodali. Con la crescente prevalenza della ricerca AI multimodale, monitorare come questi sistemi citano marchi, prodotti e fonti originali diventa cruciale per le aziende che vogliono comprendere la propria visibilità nei risultati AI. Questa capacità di monitoraggio aiuta le organizzazioni a verificare che i propri contenuti siano rappresentati accuratamente e correttamente attribuiti quando i sistemi AI multimodali sintetizzano informazioni tra testo, immagini e altre modalità.

Il futuro della ricerca AI multimodale punta verso una integrazione sempre più unificata e senza soluzione di continuità dei diversi tipi di dati, andando oltre gli attuali approcci di fusione verso modelli più olistici che elaborano tutte le modalità come intrinsecamente interconnesse. Le capacità di elaborazione in tempo reale si espanderanno, permettendo alla ricerca multimodale di operare su flussi video live, audio continuo e testo dinamico simultaneamente senza vincoli di latenza. Tecniche avanzate di data augmentation affronteranno le attuali sfide di scarsità di dati generando sinteticamente esempi di training multimodali che mantengano coerenza semantica tra le modalità. Gli sviluppi emergenti includono modelli fondativi addestrati su vasti dataset multimodali che possono essere adattati efficientemente a compiti specifici, approcci di calcolo neuromorfico che imitano più da vicino l’elaborazione biologica multimodale e apprendimento multimodale federato che consente l’addestramento su fonti di dati distribuite preservando la privacy. Questi progressi renderanno la ricerca AI multimodale più accessibile, efficiente e in grado di gestire scenari reali sempre più complessi.

I sistemi AI unimodali elaborano solo un tipo di input dati, come i motori di ricerca solo-testuali. I sistemi AI multimodali, invece, elaborano e integrano più tipi di dati—testo, immagini, audio e video—simultaneamente, consentendo una comprensione più profonda e risultati più accurati sfruttando i punti di forza complementari dei diversi formati di dati.

La ricerca AI multimodale migliora la precisione combinando fonti di informazione complementari che catturano sfumature e relazioni invisibili agli approcci a singola modalità. Quando informazioni visive, testuali e uditive si combinano, il sistema raggiunge una comprensione semantica più ricca e può prendere decisioni più informate basandosi su molteplici prospettive della stessa informazione.

Le sfide chiave includono l'allineamento e la sincronizzazione dei dati tra diverse modalità, una notevole complessità computazionale, preoccupazioni di bias ed equità quando i dati di addestramento sono sbilanciati, problemi di privacy e sicurezza con flussi di dati multipli e enormi requisiti di dati per un addestramento efficace. Ogni modalità ha caratteristiche temporali e livelli di qualità diversi che devono essere gestiti con attenzione.

La sanità beneficia dall'analisi delle immagini mediche insieme alle cartelle e note cliniche dei pazienti. L'e-commerce utilizza la ricerca multimodale per la scoperta visiva dei prodotti. I veicoli autonomi si affidano alla fusione multimodale di telecamere, radar e sensori. La moderazione dei contenuti combina analisi di immagini, testo e audio. I sistemi di assistenza clienti sfruttano molteplici tipi di input per un supporto migliore e le applicazioni di accessibilità consentono agli utenti di cercare utilizzando il metodo di input preferito.

I modelli di embedding convertono le diverse modalità in rappresentazioni numeriche che catturano il significato semantico. I database vettoriali memorizzano questi embedding in uno spazio matematico condiviso dove le relazioni tra diversi tipi di dati possono essere misurate e confrontate. Questo permette al sistema di trovare connessioni tra testo, immagini, audio e video confrontando le loro posizioni in questo spazio semantico comune.

I sistemi AI multimodali gestiscono molteplici tipi di dati sensibili—conversazioni registrate, dati di riconoscimento facciale, comunicazioni scritte e immagini mediche—che aumentano i rischi per la privacy. La combinazione di diverse modalità crea più opportunità per violazioni dei dati e richiede stretta conformità a regolamenti come GDPR e CCPA. Le organizzazioni devono implementare misure di sicurezza robuste per proteggere l'identità degli utenti e le informazioni sensibili su tutte le modalità.

Piattaforme come AmICited.com monitorano come i sistemi AI citano e attribuiscono le informazioni alle fonti originali, garantendo trasparenza nelle risposte generate dall'AI. Le organizzazioni possono tracciare la loro visibilità nei risultati di ricerca AI multimodale, verificare che i loro contenuti siano rappresentati accuratamente e confermare la corretta attribuzione quando i sistemi AI sintetizzano informazioni tra testo, immagini e altre modalità.

Il futuro include modelli unificati che elaborano tutte le modalità come intrinsecamente interconnesse, elaborazione in tempo reale di flussi video e audio live, tecniche avanzate di data augmentation per affrontare la scarsità di dati, modelli fondativi addestrati su vasti dataset multimodali, approcci di calcolo neuromorfico che imitano l'elaborazione biologica e apprendimento federato che preserva la privacy durante l'addestramento su fonti distribuite.

Traccia come i motori di ricerca AI multimodale citano e attribuiscono i tuoi contenuti attraverso testo, immagini e altre modalità con la piattaforma di monitoraggio completa di AmICited.

Diventa esperto nell'ottimizzazione della ricerca AI multimodale. Scopri come ottimizzare immagini e query vocali per risultati di ricerca potenziati dall'AI, c...

Scopri come ottimizzare testo, immagini e video per i sistemi di IA multimodale. Scopri strategie per migliorare citazioni e visibilità AI su ChatGPT, Gemini e ...

Scopri cos'è il contenuto multimodale per l'IA, come funziona e perché è importante. Esplora esempi di sistemi di IA multimodale e le loro applicazioni nei vari...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.