Aggiornamento Panda

Scopri l'Aggiornamento Panda di Google, la modifica dell'algoritmo del 2011 che prende di mira i contenuti di bassa qualità. Comprendi come funziona, il suo imp...

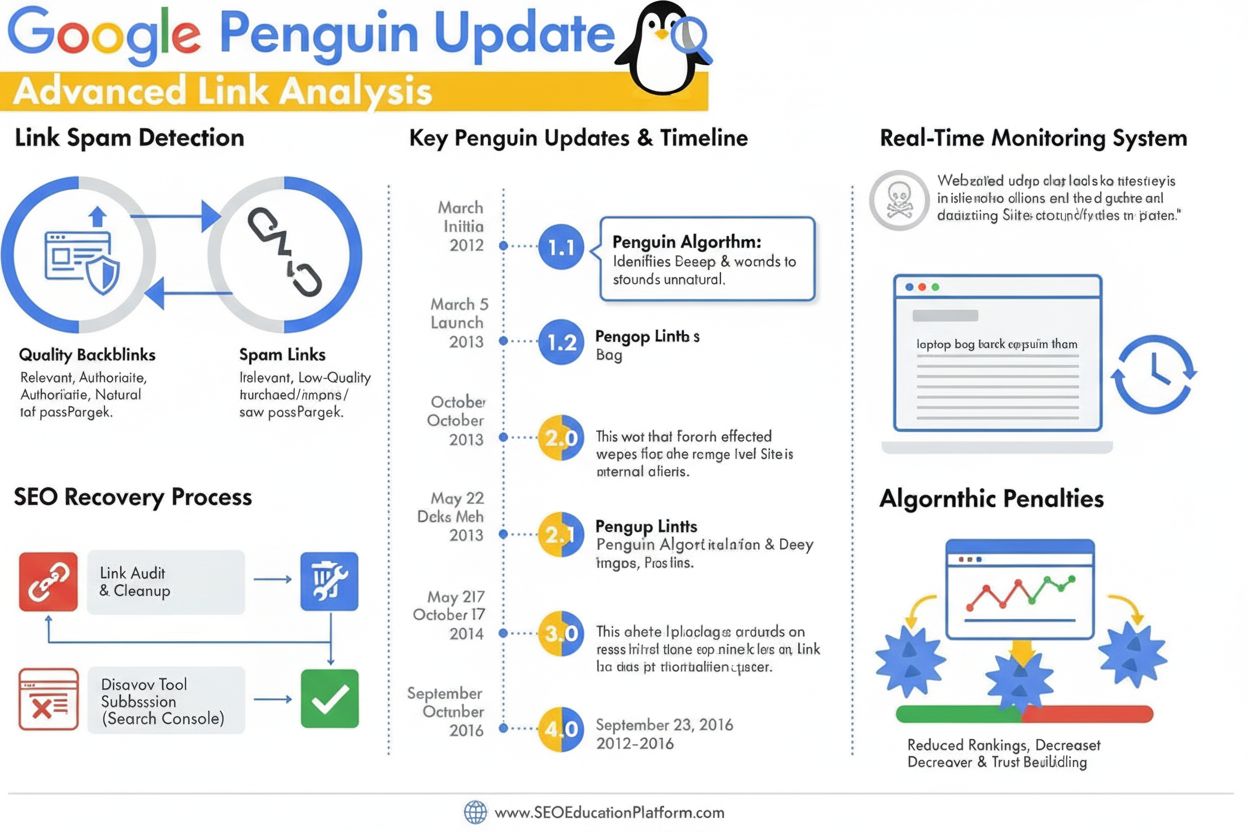

L’Aggiornamento Penguin è un algoritmo di Google progettato per combattere lo spam dei link e le pratiche manipolative di link-building, identificando e svalutando backlink di bassa qualità e innaturali. Lanciato per la prima volta nell’aprile 2012, si è evoluto in un componente in tempo reale dell’algoritmo nel 2016 che monitora e regola continuamente il posizionamento in base alla qualità dei backlink e ai pattern degli schemi di link.

L'Aggiornamento Penguin è un algoritmo di Google progettato per combattere lo spam dei link e le pratiche manipolative di link-building, identificando e svalutando backlink di bassa qualità e innaturali. Lanciato per la prima volta nell'aprile 2012, si è evoluto in un componente in tempo reale dell'algoritmo nel 2016 che monitora e regola continuamente il posizionamento in base alla qualità dei backlink e ai pattern degli schemi di link.

L’Aggiornamento Penguin è un algoritmo di Google specificamente progettato per combattere lo spam di link e le pratiche manipolative di link-building individuando, svalutando e penalizzando i siti web con profili di backlink innaturali o di bassa qualità. Annunciato ufficialmente per la prima volta da Matt Cutts il 24 aprile 2012, l’algoritmo Penguin ha rappresentato la risposta aggressiva di Google all’aumento delle tecniche SEO black-hat che gonfiavano artificialmente i ranking tramite acquisto di link, scambi di link e altre pratiche ingannevoli. L’obiettivo principale dell’algoritmo è assicurare che i link naturali, autorevoli e rilevanti vengano premiati, mentre i link manipolativi e spam vengano declassati o completamente ignorati. A differenza di aggiornamenti focalizzati sui contenuti come Panda, che prende di mira i contenuti di bassa qualità, Penguin valuta specificamente la qualità e l’autenticità del profilo di link in ingresso di un sito, rendendolo un componente fondamentale del sistema di ranking di Google da oltre un decennio.

L’Aggiornamento Penguin è emerso in un periodo cruciale per la SEO, in cui il volume di link giocava un ruolo sproporzionato nel determinare il posizionamento nei risultati di ricerca. Prima del lancio di Penguin, i webmaster potevano gonfiare artificialmente i ranking acquisendo grandi quantitativi di link di bassa qualità da link farm, private blog network e altre fonti di spam. Questa pratica creava un grave problema nei risultati di Google, facendo apparire in posizioni di rilievo siti web e contenuti di bassa qualità, privi di reale autorevolezza o pertinenza. Matt Cutts, allora responsabile del team antispam di Google, spiegò alla conferenza SMX Advanced 2012 che “Lo consideriamo qualcosa progettato per affrontare i contenuti di bassa qualità. È iniziato con Panda, poi abbiamo notato che c’era ancora molto spam e Penguin è stato creato per affrontare quello.” Il lancio iniziale di Penguin ha colpito più del 3% di tutte le query di ricerca, rendendolo uno degli aggiornamenti algoritmici più impattanti nella storia di Google. Questo impatto massiccio ha segnalato all’industria SEO che Google avrebbe adottato una posizione decisa contro le pratiche manipolative di link e che avrebbe continuato a evolvere i suoi algoritmi per mantenere la qualità della ricerca.

L’algoritmo Penguin opera attraverso sofisticati sistemi di machine learning e riconoscimento di pattern che analizzano i profili di backlink per individuare schemi di link innaturali. L’algoritmo esamina diversi fattori nella valutazione della qualità dei link, tra cui autorità e pertinenza dei domini linkanti, anchor text utilizzato nei link, velocità di acquisizione dei link e rilevanza contestuale tra il sito linkante e il sito target. Penguin prende di mira specificamente gli schemi di link, che includono una vasta gamma di pratiche manipolative come link acquistati, scambi di link reciproci, link da private blog network (PBN), link da directory di bassa qualità e link con anchor text eccessivamente ottimizzato per le keyword. L’algoritmo valuta anche il rapporto tra link di alta qualità e link di bassa qualità nel profilo backlink di un sito, riconoscendo che anche siti legittimi ricevono occasionalmente alcuni link di bassa qualità. Tuttavia, quando la proporzione di link spam diventa eccessivamente alta, Penguin segnala il sito per potenziali aggiustamenti di ranking. Un aspetto fondamentale del design di Penguin è che valuta solo i link in ingresso verso un sito; non analizza i link in uscita da quel sito, concentrandosi esclusivamente sulla qualità dei backlink che puntano a un dominio.

L’Aggiornamento Penguin ha subito un’importante evoluzione dal suo lancio iniziale attraverso molteplici iterazioni, con il cambiamento più significativo avvenuto a settembre 2016 con il rilascio di Penguin 4.0. Prima di questa pietra miliare, Penguin operava secondo una programmazione a lotti, con Google che annunciava periodicamente dei refresh per rivalutare i profili di backlink dei siti e adeguare i ranking di conseguenza. Penguin 1.1 (marzo 2012) e Penguin 1.2 (ottobre 2012) sono stati dei refresh di dati che consentivano ai siti precedentemente penalizzati di recuperare, una volta ripuliti i profili di link. Penguin 2.0 (maggio 2013) rappresentava una versione tecnicamente più avanzata che ha colpito circa il 2,3% delle query inglesi ed è stata la prima iterazione ad analizzare non solo homepage e pagine di categoria, ma anche la struttura più profonda dei siti alla ricerca di evidenze di spam nei link. Penguin 2.1 (ottobre 2013) e Penguin 3.0 (ottobre 2014) hanno continuato questa evoluzione con miglioramenti incrementali nelle capacità di rilevamento. Il rilascio di Penguin 4.0 ha però cambiato radicalmente l’operatività dell’algoritmo, integrandolo nell’algoritmo core di Google come componente in tempo reale. Questo significa che i siti vengono ora valutati in modo continuo e gli aggiustamenti di ranking avvengono immediatamente al variare dei profili di link, senza attendere aggiornamenti programmati. Il passaggio all’elaborazione in tempo reale ha inoltre modificato il meccanismo della penalizzazione Penguin: dai precedenti declassamenti diretti si è passati alla svalutazione dei link, in cui i link spam vengono semplicemente ignorati invece che causare un crollo generale del ranking del sito.

| Fattore di Valutazione | Link di Alta Qualità | Link di Bassa Qualità/Spam | Rilevamento Penguin |

|---|---|---|---|

| Autorità della Fonte del Link | Domini consolidati, affidabili e con forte autorità | Domini nuovi, siti con DA basso o noti network di spam | Analizza la storia del dominio, segnali di fiducia e pertinenza tematica |

| Anchor Text | Frasi naturali, varie e contestualmente rilevanti | Keyword esatte ripetitive, eccessiva ottimizzazione | Segnala pattern innaturali di anchor text e keyword stuffing |

| Velocità di Acquisizione Link | Acquisizione graduale e organica nel tempo | Picchi improvvisi o pattern innaturali | Monitora la velocità e la coerenza di acquisizione |

| Rilevanza Contestuale | Link da fonti autorevoli e tematicamente correlate | Link da fonti non correlate o di bassa qualità | Valuta la rilevanza semantica tra sito linkante e target |

| Posizionamento del Link | Link editoriali all’interno dei contenuti, in contesto naturale | Link in footer, sidebar o in link farm | Valuta il posizionamento e l’integrazione contestuale del link |

| Qualità del Sito Linkante | Contenuti di alta qualità, presenza aziendale legittima | Contenuti sottili, pagine auto-generate o PBN | Esamina la qualità complessiva del sito e l’autenticità dei contenuti |

| Stato Nofollow | Attribuito correttamente quando opportuno | Usato in modo scorretto o assente su link pagati/promozionali | Riconosce l’uso corretto del nofollow per i link non editoriali |

L’Aggiornamento Penguin ha trasformato radicalmente le pratiche SEO, stabilendo la qualità dei link come fattore di ranking critico e scoraggiando l’uso diffuso delle tecniche black-hat di link-building. Prima di Penguin, molte agenzie SEO e webmaster praticavano campagne aggressive di acquisto link, scambi e creazione di PBN senza particolari conseguenze. Il lancio dell’algoritmo ha causato una immediata disruption nel mercato, con migliaia di siti che hanno subito crolli di ranking e perdita di traffico. Questo ha forzato l’industria SEO ad adottare pratiche più etiche, white-hat, focalizzate sulla conquista di link tramite creazione di contenuti di alta qualità e reali relazioni. La penalizzazione Penguin è diventata un monito che ha influenzato il modo in cui le aziende approcciano il link building, portando a maggiori investimenti in content marketing, pubbliche relazioni e brand building come strategie primarie di acquisizione link. Le ricerche di settore dimostrano che comprendere e rispettare i requisiti di Penguin è diventato essenziale per il successo SEO a lungo termine, con molte organizzazioni che hanno introdotto audit dei backlink e monitoraggio dei link come pratiche standard. L’algoritmo ha inoltre elevato l’importanza di domain authority, rilevanza tematica e velocità di acquisizione come metriche chiave da monitorare nella valutazione delle opportunità di link. Oltre il 78% delle aziende ora utilizza strumenti di monitoraggio dei contenuti guidati dall’IA o di analisi dei link per tracciare i propri profili di backlink e garantire la conformità alle linee guida di qualità di Google—diretta conseguenza dell’influenza di Penguin sugli standard di settore.

Recuperare da un declassamento Penguin richiede un approccio sistematico che include audit dei backlink, rimozione dei link e l’uso strategico dello strumento di disconoscimento di Google. Il primo passo è condurre un audit completo di tutti i link in ingresso tramite la Google Search Console e strumenti di terze parti come Ahrefs, SEMrush o Moz, che forniscono profili dettagliati e valutazioni di qualità dei backlink. I webmaster devono valutare ogni dominio linkante singolarmente per stabilire se il link è di alta qualità e naturale o rappresenta una pratica manipolativa. Per i link chiaramente spam o di bassa qualità, l’approccio raccomandato è contattare il webmaster del sito linkante e chiederne la rimozione. Google raccomanda esplicitamente di non pagare per la rimozione dei link, poiché ciò perpetua il commercio dei link. Per i link che non possono essere rimossi tramite outreach, lo strumento di disconoscimento nella Google Search Console consente di inviare un file che indica a Google di ignorare specifici link nella valutazione del sito. È importante notare che disconoscere un link comporta anche la perdita di qualsiasi valore positivo che avrebbe potuto fornire, quindi lo strumento va usato solo per link realmente dannosi. Una volta inviato il file di disconoscimento, Google lo processa immediatamente, ma l’effetto sui ranking dipende da quando Google ricrawla i link disconosciuti. Dato che Penguin 4.0 gira in tempo reale, il recupero può avvenire abbastanza rapidamente—talvolta in pochi giorni o settimane—una volta intraprese sufficienti azioni correttive. Tuttavia, i webmaster non devono aspettarsi un ritorno ai livelli precedenti alla penalizzazione, poiché alcuni ranking potrebbero essere stati gonfiati artificialmente dai link di bassa qualità rimossi.

Poiché le piattaforme di ricerca AI come ChatGPT, Perplexity, Google AI Overviews e Claude diventano sempre più importanti per la visibilità del brand, comprendere i principi di Penguin è rilevante anche al di là del ranking tradizionale. Questi sistemi AI spesso citano fonti autorevoli e siti di alta qualità nelle loro risposte, e i siti con profili di backlink forti e storici puliti sono più propensi ad essere riconosciuti come autorevoli dai dati di addestramento e dai sistemi di retrieval AI. Un sito penalizzato da Penguin per spam di link può subire danni non solo nei risultati organici di Google, ma anche essere de-prioritizzato dai sistemi AI che valutano la credibilità delle fonti. Al contrario, i siti che mantengono profili di backlink puliti e di alta qualità hanno maggiori probabilità di essere citati come fonti autorevoli nelle risposte AI. Questo crea un ulteriore incentivo a mantenere la conformità Penguin, oltre alle metriche SEO tradizionali. AmICited e piattaforme simili di monitoraggio AI aiutano le organizzazioni a tracciare come i propri domini appaiono nelle risposte generate dalle AI, fornendo visibilità sul riconoscimento dell’autorità su più sistemi di ricerca AI. L’intersezione tra conformità Penguin e monitoraggio delle citazioni AI rappresenta una nuova frontiera nel digital marketing, dove la qualità dei link incide direttamente sia sulla visibilità nella ricerca tradizionale che su quella emergente nella ricerca AI.

L’Aggiornamento Penguin continua a evolversi mentre Google affina la comprensione della qualità dei link e delle pratiche manipolative. Il passaggio all’elaborazione in tempo reale nel 2016 ha rappresentato un cambiamento fondamentale nel funzionamento dell’algoritmo, ma Google continua a rafforzare le capacità di rilevamento tramite machine learning e intelligenza artificiale. Gli sviluppi recenti nel sistema SpamBrain di Google, annunciato nel 2022, rappresentano la prossima evoluzione nel rilevamento dello spam, integrando AI avanzata per individuare sia i siti che acquistano link sia quelli utilizzati per la distribuzione dei link. Questo suggerisce che le future iterazioni del rilevamento dello spam dei link saranno ancora più sofisticate, rendendo potenzialmente più difficile eludere i controlli con pratiche manipolative. Il trend di settore verso la SEO white-hat e i media guadagnati continuerà probabilmente a rafforzarsi, man mano che gli algoritmi di Google diventano più efficaci nel distinguere i link naturali da quelli artificiali. Inoltre, con la crescita delle piattaforme di ricerca AI, l’importanza di mantenere profili di backlink puliti va oltre l’algoritmo di Google, interessando anche il riconoscimento come fonte autorevole su molteplici sistemi AI. Le organizzazioni che danno priorità a qualità dei link, autorità del brand ed eccellenza dei contenuti saranno meglio posizionate per avere successo sia nella ricerca tradizionale che in quella emergente basata sull’AI. L’eredità dell’Aggiornamento Penguin non è solo quella di uno specifico algoritmo, ma di un cambiamento fondamentale nel modo in cui motori di ricerca e sistemi AI valutano l’autorevolezza di un sito, rendendo la qualità dei link un fattore permanente e sempre più rilevante per la visibilità digitale.

Un declassamento Penguin è algoritmico e avviene automaticamente quando l'algoritmo Penguin di Google rileva pattern di spam nei link, senza bisogno di intervento manuale. Una penalizzazione Penguin (o azione manuale) viene emessa dal team antispam di Google dopo una revisione umana e richiede una richiesta di riconsiderazione per essere revocata. Da quando Penguin 4.0 è diventato in tempo reale nel 2016, dai declassamenti algoritmici si può recuperare quasi immediatamente una volta intraprese le azioni correttive, mentre le penalizzazioni manuali richiedono un'approvazione esplicita da parte di Google.

L'Aggiornamento Penguin utilizza algoritmi di apprendimento automatico per analizzare i profili di backlink e identificare pattern di link-building manipolativo, inclusi link acquistati, scambi di link, private blog network (PBN) e pattern innaturali di anchor text. L'algoritmo valuta il rapporto tra link naturali di alta qualità e link spam di bassa qualità che puntano a un sito web. Esamina anche la pertinenza e l'autorità dei domini che generano link per determinare se i link sembrano ottenuti artificialmente piuttosto che guadagnati editorialmente.

Sì, il recupero è possibile attraverso un processo a più fasi che include audit dei backlink, rimozione dei link spam e l'uso dello strumento di disconoscimento di Google per i link che non puoi rimuovere direttamente. Dato che Penguin 4.0 funziona in tempo reale, il recupero può avvenire relativamente in fretta una volta che hai ripulito il tuo profilo di link e Google ha ricrawlato quelle pagine. Tuttavia, il recupero non garantisce un ritorno alle posizioni precedenti, poiché alcune di esse potrebbero essere state gonfiate artificialmente dai link di bassa qualità che stai rimuovendo.

Penguin penalizza i link provenienti da link farm, reti di link a pagamento, private blog network (PBN), scambi di link reciproci e siti con pattern innaturali di anchor text. Prende di mira anche i link da directory di bassa qualità, commenti spam, spam nei forum e link ottenuti tramite pratiche manipolative. Inoltre, Penguin segnala link provenienti da siti ad alta autorità che sembrano essere venduti o posizionati come advertorial senza i corretti tag nofollow, poiché ciò viola le linee guida di Google sugli schemi di link.

Da quando Penguin 4.0 è stato rilasciato a settembre 2016, l'algoritmo gira continuamente in tempo reale come parte dell'algoritmo core di Google. Questo significa che Google valuta costantemente i profili di backlink e regola il posizionamento in base alla qualità dei link senza attendere aggiornamenti programmati. In precedenza, Penguin operava secondo una pianificazione a lotti con refresh annunciati da Google, ma l'elaborazione in tempo reale ha eliminato la necessità di questi annunci e consente un recupero più rapido una volta risolti i problemi.

Lo strumento di disconoscimento è una funzione della Google Search Console che consente ai webmaster di comunicare a Google di ignorare determinati backlink nella valutazione del proprio sito. Si usa come ultima risorsa quando non puoi contattare direttamente i webmaster per rimuovere i link spam. Disconoscendo i link di bassa qualità, eviti che influiscano negativamente sul ranking ai sensi dell'algoritmo Penguin. Tuttavia, anche i link disconosciuti smettono di fornire valore positivo, quindi dovrebbe essere usato solo per link realmente dannosi.

L'Aggiornamento Penguin originale, lanciato nell'aprile 2012, ha colpito oltre il 3% di tutte le query di ricerca secondo le stime di Google. Gli aggiornamenti successivi hanno avuto impatti variabili: Penguin 2.0 ha colpito circa il 2,3% delle query inglesi, Penguin 2.1 circa l'1% delle query e Penguin 3.0 meno dell'1% delle query di ricerca in inglese. Queste percentuali rappresentano milioni di siti web a livello globale, rendendo Penguin uno degli aggiornamenti algoritmici più significativi della storia della ricerca.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri l'Aggiornamento Panda di Google, la modifica dell'algoritmo del 2011 che prende di mira i contenuti di bassa qualità. Comprendi come funziona, il suo imp...

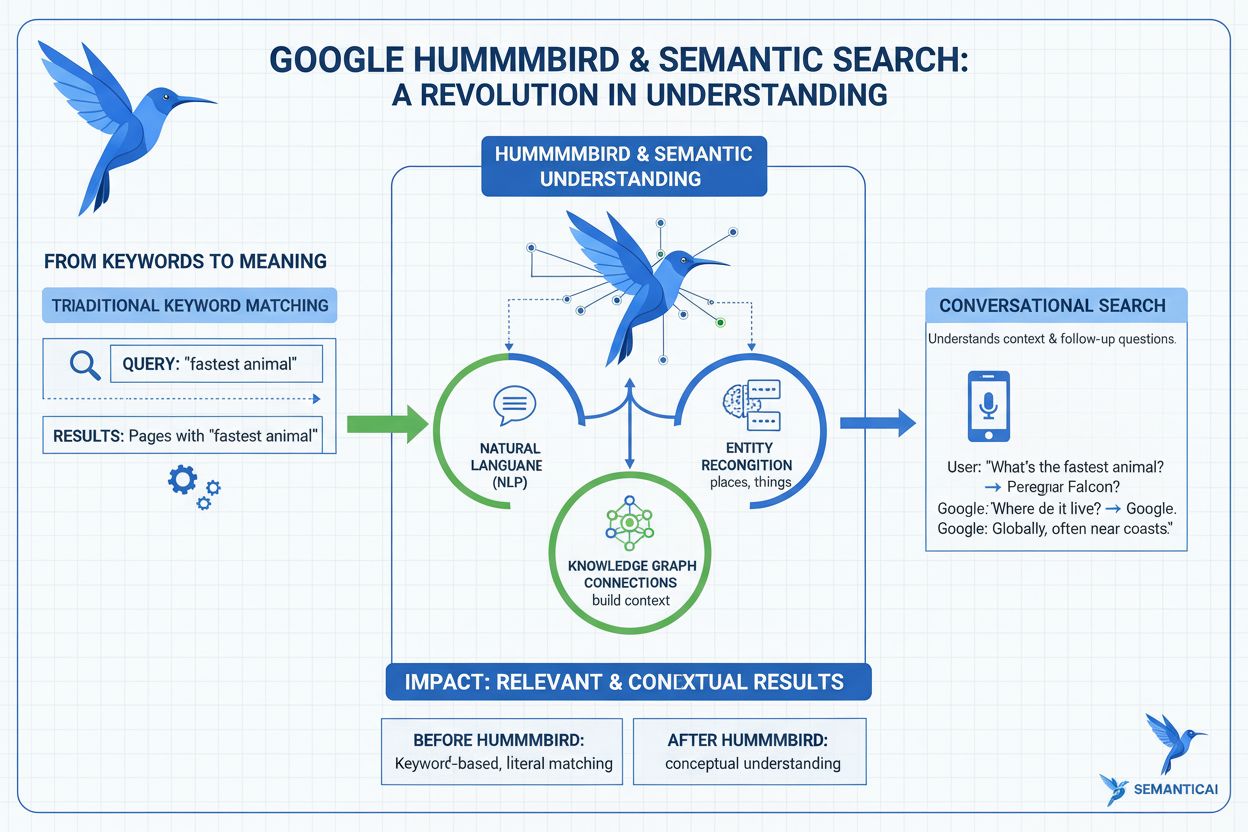

Scopri cos'è l'Aggiornamento Hummingbird, come ha rivoluzionato la ricerca semantica nel 2013 e perché è importante per il monitoraggio dell'IA e la visibilità ...

Scopri cosa sono gli aggiornamenti dell'algoritmo di Google, come funzionano e il loro impatto sulla SEO. Comprendi gli aggiornamenti principali, quelli sullo s...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.