Cos'è la Prompt Engineering per la Ricerca AI - Guida Completa

Scopri cos’è la prompt engineering, come funziona con i motori di ricerca AI come ChatGPT e Perplexity, e scopri le tecniche fondamentali per ottimizzare i tuoi...

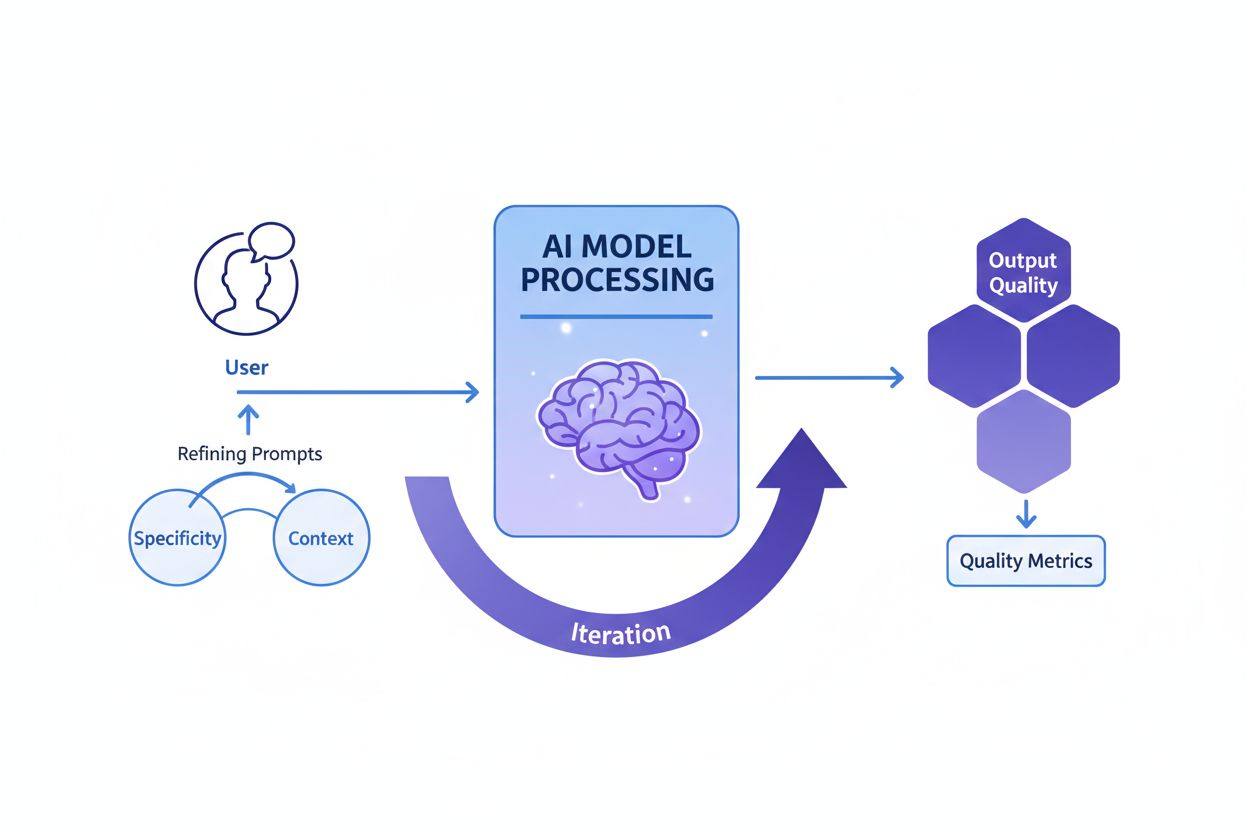

Il prompt engineering è il processo di ideazione, perfezionamento e ottimizzazione di istruzioni in linguaggio naturale per guidare i modelli di intelligenza artificiale generativa verso la produzione di output desiderati, accurati e pertinenti. Comprende la sperimentazione iterativa su formulazione, contesto e struttura per massimizzare le prestazioni dell’IA senza modificare il modello sottostante.

Il prompt engineering è il processo di ideazione, perfezionamento e ottimizzazione di istruzioni in linguaggio naturale per guidare i modelli di intelligenza artificiale generativa verso la produzione di output desiderati, accurati e pertinenti. Comprende la sperimentazione iterativa su formulazione, contesto e struttura per massimizzare le prestazioni dell’IA senza modificare il modello sottostante.

Prompt engineering è il processo sistematico di progettazione, perfezionamento e ottimizzazione di istruzioni in linguaggio naturale—chiamate prompt—per guidare i modelli di intelligenza artificiale generativa verso la produzione di output desiderati, accurati e contestualmente pertinenti. Invece di modificare il modello di IA sottostante, i prompt engineer lavorano sulle capacità esistenti del modello strutturando attentamente il proprio input per influenzare il modo in cui il modello elabora le informazioni e genera risposte. Questa disciplina è emersa come competenza fondamentale durante il boom dell’IA generativa 2023-2025, quando le organizzazioni hanno compreso che accedere a potenti strumenti come ChatGPT, Claude, Perplexity e Google AI non era sufficiente senza capacità di comunicare efficacemente con questi sistemi. Il prompt engineering colma il divario tra intento umano e capacità dell’IA, trasformando obiettivi aziendali vaghi in output di alta qualità e azionabili. La pratica è intrinsecamente iterativa, richiedendo sperimentazione, test e perfezionamento continui per ottenere risultati ottimali per casi d’uso specifici.

Il concetto di prompt engineering è nato organicamente dopo il rilascio pubblico di ChatGPT nel novembre 2022, quando milioni di utenti hanno iniziato a sperimentare come ottenere risultati migliori dai large language model. I primi utilizzatori hanno scoperto che la qualità degli output AI variava notevolmente in base a come venivano formulate le domande, quale contesto veniva fornito e quanto fossero specifiche le istruzioni. Questa osservazione ha portato alla formalizzazione del prompt engineering come disciplina distinta. Nel 2023, grandi aziende tecnologiche come OpenAI, Google, Microsoft e Anthropic hanno iniziato ad assumere prompt engineer dedicati, con alcune posizioni che offrivano stipendi superiori ai 300.000 dollari. Il mercato globale del prompt engineering è stato valutato circa 222,1 milioni di dollari nel 2023 e si prevede raggiungerà i 2,06 miliardi entro il 2030, rappresentando un tasso di crescita annuo composto (CAGR) di notevole espansione. Questa rapida crescita riflette la crescente consapevolezza che il prompt engineering non è una moda passeggera ma una competenza fondamentale per le organizzazioni che sfruttano l’IA su larga scala. La disciplina si è evoluta da una semplice sperimentazione a tentativi verso una pratica sofisticata che incorpora tecniche consolidate, framework di valutazione e best practice documentate da istituzioni di ricerca AI e professionisti del settore.

Un prompt engineering efficace si basa su diversi principi fondamentali che distinguono prompt di alta qualità da quelli inefficaci. La specificità è essenziale: più un prompt è dettagliato e descrittivo, meglio il modello di IA potrà comprendere i requisiti esatti e generare output allineati. Invece di chiedere all’IA di “scrivere sui cani”, un prompt specifico potrebbe essere “crea una guida veterinaria di 300 parole sui problemi di salute del golden retriever, scritta per proprietari di animali con livello di lettura di terza media, focalizzata sulla prevenzione”. La fornitura di contesto è altrettanto cruciale; fornire informazioni di background, esempi o vincoli aiuta il modello a restringere il focus e produrre risposte più pertinenti. La chiarezza garantisce che le istruzioni siano inequivocabili e comunichino direttamente il compito richiesto senza richiedere al modello di interpretare formulazioni vaghe. Il perfezionamento iterativo riconosce che il primo prompt raramente produce risultati ottimali; i prompt engineer di successo testano continuamente varianti, analizzano gli output e adattano l’approccio in base ai risultati. L’allineamento di tono e stile implica specificare la voce desiderata, il livello di formalità e il formato di presentazione per assicurare che gli output rispecchino le aspettative organizzative o dell’utente. Questi principi si applicano a tutte le piattaforme AI, sia che si creino prompt per ChatGPT, Perplexity, Claude o Google AI Overviews, rendendoli universalmente preziosi per chiunque desideri ottimizzare le interazioni AI.

Il campo del prompt engineering ha sviluppato numerose tecniche sofisticate per affrontare diversi tipi di compiti e livelli di complessità. Lo zero-shot prompting è l’approccio più diretto, fornendo all’IA un’istruzione chiara o una domanda senza ulteriori esempi o contesto. Questo metodo funziona bene per compiti semplici ma può avere difficoltà con ragionamenti complessi. Il few-shot prompting migliora le prestazioni fornendo al modello uno o più esempi che mostrano il formato o il ragionamento desiderato, insegnando di fatto al modello tramite dimostrazione. Il chain-of-thought (CoT) prompting suddivide problemi complessi in passaggi intermedi di ragionamento, incoraggiando il modello a mostrare il proprio processo e migliorando l’accuratezza su problemi a più step. Il prompt chaining divide un compito complesso in sottocompiti sequenziali, utilizzando l’output di un prompt come input per il successivo, aumentando affidabilità e coerenza nei flussi di lavoro articolati. Il tree-of-thought prompting generalizza il chain-of-thought esplorando contemporaneamente più percorsi di ragionamento, consentendo al modello di valutare approcci diversi prima di selezionare il più promettente. Il maieutic prompting consiste nel chiedere al modello di spiegare il proprio ragionamento, poi porre domande di approfondimento su parti specifiche della spiegazione, aiutando a identificare e correggere incoerenze. Il generated knowledge prompting istruisce il modello a generare prima fatti o informazioni di background rilevanti prima di affrontare il compito principale, condizionando il modello con contesto utile. Il self-refine prompting prevede che il modello risolva un problema, critichi la propria soluzione e poi la riveda in base alle critiche, ripetendo fino al raggiungimento di risultati soddisfacenti. Ogni tecnica serve scopi specifici e il prompt engineering più efficace spesso combina più tecniche adattate strategicamente al compito.

| Tecnica | Ideale per | Complessità | Caso d’uso tipico | Efficacia |

|---|---|---|---|---|

| Zero-shot Prompting | Task semplici e diretti | Bassa | Domande base, istruzioni semplici | Buono per compiti semplici, limitato per ragionamenti complessi |

| Few-shot Prompting | Compiti che richiedono coerenza di formato | Media | Generazione di contenuti, classificazioni | Ottimo per mostrare pattern di output desiderati |

| Chain-of-Thought | Problemi di ragionamento multi-step | Medio-Alta | Problemi di matematica, deduzioni logiche | Migliora notevolmente l’accuratezza su task complessi |

| Prompt Chaining | Workflow complessi con dipendenze | Alta | Creazione di contenuti multi-fase | Eccellente per scomporre problemi complessi |

| Tree-of-Thought | Problemi con più soluzioni possibili | Alta | Pianificazione strategica, problem solving creativo | Superiore per esplorare approcci alternativi |

| Generated Knowledge | Task che richiedono contesto di background | Media | Domande di dominio, spiegazioni tecniche | Migliora pertinenza e accuratezza tramite il contesto |

| Self-Refine | Applicazioni dove la qualità è critica | Alta | Scrittura professionale, documentazione tecnica | Produce output di massima qualità tramite iterazione |

Comprendere come i prompt influenzano il comportamento dei modelli AI richiede una conoscenza di base del funzionamento dei large language model (LLM). Questi modelli processano il testo suddividendolo in token (piccole unità di testo), quindi prevedono il token successivo più probabile sulla base dei pattern appresi in fase di training. Il prompt funge da contesto iniziale che influenza tutte le previsioni successive. Quando un prompt include istruzioni specifiche, esempi o vincoli, restringe di fatto la distribuzione di probabilità degli output possibili, guidando il modello verso risposte allineate all’intento del prompt. I parametri di temperature e top-p sampling influenzano ulteriormente la variabilità dell’output: temperature basse producono risposte più determinate e focalizzate, temperature alte aumentano creatività e diversità. La finestra di contesto (la quantità di testo che il modello può considerare) limita quante informazioni possono essere incluse in un prompt; prompt più lunghi consumano più spazio, riducendo eventualmente quello disponibile per il compito stesso. I prompt engineer efficaci conoscono questi vincoli tecnici e progettano prompt che vi si adattino. Per le organizzazioni che monitorano la visibilità del brand sulle piattaforme AI tramite strumenti come AmICited, la comprensione di questi meccanismi è cruciale, perché i prompt inseriti dagli utenti determinano quali informazioni le IA recuperano e citano. Un prompt ben progettato che chiede a un’IA “elenca le tre migliori aziende di cloud computing” produrrà risultati diversi da “elenca aziende innovative di cloud computing fondate dopo il 2015”, influenzando quali brand ricevono visibilità nelle risposte generate dall’IA.

Implementare un prompt engineering efficace in azienda richiede l’adozione di best practice emerse sia dalla ricerca accademica che dall’esperienza industriale. Iniziare semplice e iterare è il principio fondamentale: partire da un prompt di base e aggiungere complessità gradualmente, testando a ogni passaggio per capire quali cambiamenti migliorano i risultati. Essere espliciti nei requisiti dichiarando chiaramente formato, lunghezza, tono e vincoli dell’output desiderato; prompt vaghi producono risultati vaghi. Fornire contesto rilevante senza sovraccaricare il modello; inserire informazioni di background utili ma evitare dettagli superflui che consumano la finestra di contesto. Usare separatori chiari come “###” o “—” per distinguere le sezioni del prompt (istruzioni, contesto, esempi), facilitando l’analisi strutturale da parte del modello. Evitare negazioni dichiarando ciò che si vuole anziché ciò che non si vuole; invece di “non essere troppo formale”, specificare “usa un tono conversazionale”. Testare più varianti in modo sistematico, cambiando un elemento alla volta per capire cosa migliora i risultati. Documentare i prompt di successo in un repository centralizzato, creando una libreria di template testati che i team possono riutilizzare e adattare. Monitorare le metriche di performance come accuratezza, pertinenza, coerenza e soddisfazione dell’utente per valutare oggettivamente se i prompt raggiungono gli obiettivi prefissati. Incorporare cicli di feedback in cui il feedback degli utenti alimenta direttamente il perfezionamento dei prompt, creando un ciclo di miglioramento continuo. Le organizzazioni che adottano queste pratiche segnalano miglioramenti significativi nella qualità e coerenza degli output AI, riducendo il tempo speso in correzioni manuali e revisioni.

La relazione tra prompt engineering e monitoraggio della visibilità AI è sempre più rilevante per le organizzazioni che vogliono capire come i propri brand, prodotti e contenuti appaiono nelle risposte generate dall’IA. Piattaforme come AmICited tracciano le citazioni dei brand su ChatGPT, Perplexity, Google AI Overviews e Claude, ma sono i prompt inseriti dagli utenti in questi sistemi a determinare quali informazioni l’IA recupera e cita. Le organizzazioni che comprendono il prompt engineering possono creare query strategiche per scoprire come viene rappresentato il proprio brand, quali competitor vengono menzionati insieme e se i propri contenuti sono citati correttamente. Ad esempio, un’azienda può progettare prompt come “Quali sono le migliori soluzioni per la gestione dati aziendale?” per vedere come i sistemi AI posizionano la propria offerta rispetto ai competitor. Analizzando i prompt che generano citazioni favorevoli o sfavorevoli, le organizzazioni possono sviluppare strategie di contenuto che migliorano la visibilità nelle risposte AI. Questo rappresenta una nuova frontiera della search engine optimization (SEO) e della gestione del brand, dove saper dialogare con i sistemi AI diventa importante quanto l’ottimizzazione delle keyword tradizionali. Le aziende che investono nelle competenze di prompt engineering ottengono vantaggi strategici nell’ecosistema informativo guidato dall’IA, assicurando visibilità e rappresentazione accurate dei brand.

Valutare se un prompt è realmente efficace richiede criteri chiari e oggettivi allineati agli obiettivi aziendali. L’accuratezza misura la correttezza fattuale degli output, fondamentale in settori come sanità, finanza e legale dove gli errori sono critici. La pertinenza valuta quanto l’output sia vicino all’intento originale dell’utente, spesso con metriche di similarità semantica o valutazione manuale. La coerenza verifica che prompt identici producano risposte simili su più esecuzioni, cruciale per applicazioni che richiedono affidabilità. La completezza determina se le risposte coprono tutti gli elementi richiesti, misurata come rapporto tra componenti coperte e richieste totali. La specificità valuta il livello di dettaglio nelle risposte, importante per documentazione tecnica e settori specializzati. Leggibilità e coerenza misurano chiarezza e flusso logico, valutate con formule di leggibilità o giudizio umano. La soddisfazione dell’utente riflette quanto gli utenti finali siano soddisfatti degli output, raccolta tramite survey o sistemi di feedback integrati. Le organizzazioni che implementano framework di valutazione completi riportano che l’efficacia dei prompt migliora del 40-60% grazie a misurazione e perfezionamento sistematici. Strumenti come Portkey, DSPy e la Evaluate Library di Hugging Face forniscono metriche automatizzate per valutare queste dimensioni, mentre le piattaforme di A/B testing consentono il confronto diretto tra versioni di prompt. Le organizzazioni più avanzate combinano diversi metodi di valutazione, pesando le metriche in base alle priorità per ottenere uno score complessivo di qualità del prompt.

Il mercato del lavoro per il prompt engineering ha vissuto una crescita esplosiva, riflettendo l’importanza critica di questa skill nell’era AI. Nel 2025, Glassdoor riporta uno stipendio base medio di circa 123.274 dollari annui per i prompt engineer, con posizioni che vanno da 90.000 al 25° percentile a oltre 335.000 dollari per ruoli specializzati presso aziende AI leader come Anthropic. Indeed elenca oltre 110.000 posizioni per prompt engineer attualmente aperte, segnalando una domanda sostenuta in tutti i settori. Big Tech come Google, Microsoft, Amazon e Meta reclutano attivamente prompt engineer con range da 110.000 a 250.000 dollari. Aziende focalizzate sull’AI come OpenAI, Anthropic, Cohere e Midjourney offrono sfide all’avanguardia, culture remote-first e significativi pacchetti azionari. Le grandi imprese in finanza, sanità, assicurazioni e altri settori regolamentati assumono prompt engineer per l’integrazione AI, spesso con titoli come “AI Solutions Architect”. Le consulenze tra cui le Big Four e società specializzate come Booz Allen Hamilton propongono ruoli fino a 212.000 dollari per progetti enterprise e governativi. Le opportunità freelance su piattaforme come Upwork e Toptal raggiungono 100-300 dollari l’ora per professionisti esperti. Il percorso di carriera tipico richiede una laurea in informatica o affini, anche se professionisti da ambiti come scrittura, giornalismo e creatività sono entrati con successo nel prompt engineering. Fondamentale è la dimostrabilità delle competenze con strumenti AI, un portfolio di prompt engineering e apprendimento continuo.

Il prompt engineering è destinato a una notevole evoluzione con l’avanzare della tecnologia AI e la maturazione delle pratiche organizzative. Il prompting multimodale combinerà sempre più testo, codice, immagini e altri dati in uno stesso prompt, richiedendo ai prompt engineer di capire come interagiscono le diverse modalità nei sistemi AI. I prompt adattivi che si regolano automaticamente in base al contesto, al comportamento dell’utente e ai feedback in tempo reale diventeranno più sofisticati, andando oltre i template statici verso sistemi dinamici e responsivi. Il context engineering emerge come evoluzione del prompt engineering, ponendo l’accento sul contesto in cui operano i prompt oltre che sul testo stesso. Il prompting etico e orientato all’equità acquisirà centralità man mano che le aziende daranno priorità a un’IA responsabile, con prompt progettati esplicitamente per mitigare bias, garantire trasparenza e allinearsi ai requisiti normativi. L’integrazione con AI agent renderà sfumati i confini tra prompt engineering e orchestrazione AI più ampia, con prompt come componenti di sistemi autonomi complessi. Il ruolo di “prompt engineer” potrà evolvere o fondersi con figure adiacenti come “AI strategist”, “context engineer” o “AI product manager”, a testimonianza della maturità del settore. Le organizzazioni che investono oggi nelle competenze di prompt engineering saranno ben posizionate per guidare l’economia guidata dall’IA, poiché la capacità di comunicare ed indirizzare efficacemente i sistemi AI diventerà sempre più centrale per il vantaggio competitivo. Per le aziende che usano AmICited per monitorare la visibilità dei brand nelle risposte AI, la conoscenza del prompt engineering sarà cruciale per ottimizzare la propria presenza nel panorama di ricerca AI e garantirsi una rappresentazione accurata su piattaforme come ChatGPT, Perplexity, Google AI e Claude.

Il prompt engineering differisce fondamentalmente dalla programmazione tradizionale: invece di scrivere codice esplicito che controlla direttamente il comportamento, i prompt engineer guidano i modelli di IA attraverso istruzioni in linguaggio naturale. La programmazione tradizionale richiede sintassi e logica precise, mentre il prompt engineering si basa su raffinamenti iterativi, fornitura di contesto e formulazioni strategiche per indirizzare l’output dell’IA verso i risultati desiderati. Entrambi richiedono capacità di problem solving, ma il prompt engineering enfatizza la comunicazione e la sperimentazione rispetto alla rigida sintassi del codice.

Il prompt engineering influisce direttamente su come i brand appaiono nelle risposte generate dall’IA su piattaforme come ChatGPT, Perplexity, Google AI Overviews e Claude. Prompt ben progettati possono influenzare se e come i sistemi di IA citano, menzionano o raccomandano i brand. Per le organizzazioni che utilizzano strumenti come AmICited per monitorare la visibilità nell’IA, comprendere il prompt engineering aiuta a prevedere e ottimizzare come il proprio brand appare nelle risposte dell’IA, garantendo una rappresentazione accurata e un posizionamento competitivo nel panorama della ricerca AI.

Le tecniche chiave includono chain-of-thought prompting (suddividere problemi complessi in passaggi), few-shot prompting (fornire esempi), zero-shot prompting (istruzioni dirette), prompt chaining (suddividere compiti in sottocompiti), e tree-of-thought prompting (esplorazione di percorsi di ragionamento multipli). L’efficacia di ciascuna tecnica dipende dalla complessità del compito, dalle capacità del modello e dal tipo di output desiderato. Le implementazioni di maggior successo combinano più tecniche adattate ai casi d’uso specifici.

L’efficacia di un prompt si misura attraverso metriche come accuratezza (correttezza fattuale), pertinenza (allineamento con l’intento), coerenza (riproducibilità), completezza (copertura degli elementi richiesti) e soddisfazione dell’utente. I metodi di valutazione includono revisione manuale, valutazione automatizzata con strumenti come BLEU e ROUGE, A/B test su diverse versioni di prompt e raccolta di feedback diretto dagli utenti. Le organizzazioni spesso combinano più metriche in un punteggio ponderato che riflette le proprie priorità.

I prompt engineer devono possedere solide competenze di comunicazione e scrittura, comprensione di come funzionano i large language model, familiarità con concetti AI come tokenizzazione e finestre di contesto, e capacità di problem solving creativo. Competenze tecniche in Python, SQL o JavaScript sono spesso preferite ma non sempre necessarie. L’expertise settoriale in ambiti specifici (sanità, finanza, legale) è molto richiesta. Fondamentale è la capacità di apprendimento continuo e sperimentazione.

Il prompt engineering è cruciale per il monitoraggio AI perché i prompt inseriti dagli utenti nei sistemi di IA determinano quali informazioni questi sistemi recuperano e citano. Comprendendo il prompt engineering, le organizzazioni possono creare query che le aiutano a scoprire come il proprio brand, contenuto o settore appare nelle risposte AI. AmICited traccia queste apparizioni su più piattaforme AI, rendendo essenziale la conoscenza del prompt engineering per ottimizzare la visibilità del brand nei contenuti generati dall’IA.

Il mercato del lavoro per i prompt engineer rimane solido con stipendi medi attorno a 123.274 dollari annui secondo Glassdoor, con posizioni che vanno da 90.000 a oltre 335.000 dollari in base all’esperienza e all’azienda. Oltre 110.000 posizioni per prompt engineer sono attualmente aperte sulle job board. Il settore si sta evolvendo da un ruolo specializzato a responsabilità di integrazione AI più ampie, con opportunità in aziende tech, imprese, consulenze e piattaforme freelance. Il lavoro da remoto è diffuso, rendendo meno restrittiva la posizione geografica.

Si prevede che il prompt engineering si evolva verso il prompting multimodale (combinando testo, codice e immagini), prompt adattivi che si regolano in base al contesto e maggiore attenzione all’etica e all’equità dell’IA. Con l’aumentare delle capacità dei modelli AI, il prompt engineering potrebbe fondersi con ruoli più ampi di strategia AI e context engineering. Il settore si focalizzerà probabilmente su pratiche AI responsabili, mitigazione dei bias e trasparenza negli output AI su piattaforme come quelle monitorate da AmICited.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Scopri cos’è la prompt engineering, come funziona con i motori di ricerca AI come ChatGPT e Perplexity, e scopri le tecniche fondamentali per ottimizzare i tuoi...

Scopri come il prompt engineering migliora la strategia GEO per far citare il tuo brand dai motori di ricerca AI come ChatGPT, Perplexity e Google AI Overviews.

Discussione della community sul fatto che i marketer debbano o meno possedere competenze di prompt engineering per ottimizzare la ricerca su IA. Comprendere com...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.