Che cos'è la ricerca in tempo reale nell'IA?

Scopri come funziona la ricerca in tempo reale nell'IA, i suoi vantaggi per utenti e aziende e in che modo si differenzia dai motori di ricerca tradizionali e d...

API che forniscono ai sistemi di intelligenza artificiale aggiornamenti di contenuto attuali per informazioni sensibili al tempo, consentendo l’accesso immediato a dati freschi tramite connessioni di streaming persistenti. Queste API consegnano informazioni in millisecondi invece di richiedere polling periodici, garantendo che i modelli AI abbiano sempre il contesto più recente disponibile per decisioni accurate e generazione di risposte.

API che forniscono ai sistemi di intelligenza artificiale aggiornamenti di contenuto attuali per informazioni sensibili al tempo, consentendo l’accesso immediato a dati freschi tramite connessioni di streaming persistenti. Queste API consegnano informazioni in millisecondi invece di richiedere polling periodici, garantendo che i modelli AI abbiano sempre il contesto più recente disponibile per decisioni accurate e generazione di risposte.

Una API di Contenuti in Tempo Reale è un’interfaccia di programmazione applicativa che fornisce ai sistemi AI aggiornamenti di contenuto attuali e informazioni man mano che diventano disponibili, consentendo l’accesso immediato a dati sensibili al tempo senza ritardi. A differenza delle tradizionali API request-response che richiedono ai client di interrogare per aggiornamenti a intervalli, le API di contenuto in tempo reale stabiliscono connessioni persistenti che inviano nuove informazioni ai sistemi AI non appena vengono generate o aggiornate. Queste API sono fondamentali per le moderne applicazioni AI che richiedono contesto aggiornato, come i large language model (LLM), agenti AI e sistemi di generazione aumentata dal recupero (RAG). Fornendo contenuti freschi e rilevanti in millisecondi, le API di contenuto in tempo reale assicurano che i sistemi AI possano prendere decisioni informate basandosi sulle informazioni più recenti disponibili invece che su dati obsoleti.

Le API di contenuto in tempo reale operano su principi fondamentalmente diversi rispetto alle tradizionali REST API, privilegiando la consegna continua dei dati rispetto ai cicli discreti richiesta-risposta. L’architettura di base si basa su connessioni persistenti che rimangono aperte tra il client (sistema AI) e il server, consentendo il flusso di dati bidirezionale o unidirezionale a seconda del protocollo. Queste API impiegano un’architettura event-driven, dove gli aggiornamenti sono innescati immediatamente quando nuovi contenuti diventano disponibili, anziché attendere processi batch programmati. L’implementazione tecnica enfatizza la consegna a bassa latenza, tipicamente misurata in millisecondi, assicurando che i sistemi AI ricevano informazioni con un ritardo minimo. La scalabilità è integrata nel design tramite piattaforme di streaming distribuite in grado di gestire milioni di connessioni concorrenti e processare enormi volumi di dati simultaneamente.

| Caratteristica | API di Contenuti in Tempo Reale | REST API Tradizionale | Batch Processing |

|---|---|---|---|

| Tipo di Connessione | Persistente/Streaming | Richiesta-Risposta | Job Programmati |

| Consegna Dati | Push (Iniziata dal Server) | Pull (Iniziata dal Client) | Batch Periodici |

| Latenza | Millisecondi | Secondi-Minuti | Ore-Giorni |

| Freschezza Dati | Sempre Attuale | Dipende dal Polling | Notevolmente Ritardata |

| Scalabilità | Alta Concorrenza | Connessioni Limitate | Dipendente dal Batch |

| Caso d’Uso | AI in tempo reale, Aggiornamenti Live | Servizi Web Standard | Analisi, Reporting |

| Modello di Costo | Basato su Connessioni | Basato su Richieste | Basato su Calcolo |

Il flusso operativo di una API di contenuti in tempo reale inizia con l’ingestione dei dati, dove contenuti da varie fonti—database, code di messaggi, API esterne o eventi generati dagli utenti—vengono acquisiti e normalizzati in un formato standardizzato. Una volta acquisiti, i dati entrano in una pipeline di elaborazione dove possono essere arricchiti, filtrati o trasformati per aggiungere contesto e rilevanza per i sistemi AI. I contenuti elaborati sono quindi resi disponibili tramite endpoint di streaming che mantengono connessioni aperte con i client AI sottoscritti. Quando arrivano contenuti nuovi o aggiornati, l’API li trasmette immediatamente tramite queste connessioni persistenti a tutti i consumatori interessati. Questa architettura elimina la necessità per i sistemi AI di interrogare ripetutamente per aggiornamenti, riducendo l’overhead di rete e assicurando che informazioni critiche raggiungano i modelli AI entro millisecondi dalla loro disponibilità. L’intero processo è progettato per la tolleranza ai guasti, con meccanismi per gestire errori di connessione, garantire la consegna dei messaggi e mantenere la coerenza dei dati tra sistemi distribuiti.

L’importanza della freschezza dei dati nei sistemi AI non può essere sopravvalutata, poiché l’accuratezza e la rilevanza delle uscite AI dipendono direttamente dall’attualità delle informazioni disponibili al modello. Quando sistemi AI come LLM o agenti AI operano con dati obsoleti, rischiano di fornire raccomandazioni inaccurate, perdere contesto critico o prendere decisioni basate su fatti superati. Le API di contenuto in tempo reale risolvono questo problema assicurando che i sistemi AI abbiano sempre accesso alle informazioni più aggiornate disponibili, consentendo loro di fornire risposte più accurate e decisioni meglio informate. Per applicazioni come trading finanziario, rilevamento frodi o raccomandazioni personalizzate, anche un ritardo di pochi secondi può comportare errori significativi o opportunità perse. Mantenendo un accesso continuo a dati freschi, le API di contenuto in tempo reale permettono ai sistemi AI di comprendere lo stato attuale del mondo, adattarsi alle condizioni in cambiamento e fornire risposte che riflettono gli ultimi sviluppi. Questa freschezza è particolarmente critica per i sistemi di generazione aumentata dal recupero (RAG), dove la qualità del contesto recuperato influisce direttamente sulla qualità delle risposte generate.

Le API di contenuto in tempo reale sfruttano diversi protocolli di streaming chiave e tecnologie, ognuno ottimizzato per diversi casi d’uso ed esigenze:

WebSockets: Fornisce comunicazione full-duplex su una singola connessione TCP, abilitando lo scambio dati in tempo reale bidirezionale. Ideale per applicazioni interattive che richiedono bassa latenza e comunicazione a due vie tra client e server.

Server-Sent Events (SSE): Permette ai server di inviare dati ai client su connessioni HTTP in modo unidirezionale. Più semplice da implementare rispetto a WebSocket e adatto a scenari dove sono necessari solo aggiornamenti server-to-client.

gRPC: Framework RPC ad alte prestazioni che utilizza Protocol Buffers per una serializzazione efficiente. Supporta diversi modelli di streaming ed è particolarmente efficace per la comunicazione tra microservizi e la servitizzazione di modelli AI.

Apache Kafka: Piattaforma di streaming distribuita che funge da message broker, abilitando lo streaming di eventi affidabile e scalabile. Comunemente usato come backbone per pipeline di dati in tempo reale che alimentano sistemi AI.

MQTT: Protocollo publish-subscribe leggero progettato per applicazioni IoT e mobile. Offre utilizzo efficiente della banda ed è ideale per scenari con risorse di rete limitate.

AMQP: Advanced Message Queuing Protocol che offre consegna affidabile dei messaggi con supporto per pattern di routing complessi. Adatto ad applicazioni enterprise che richiedono garanzia di consegna e supporto alle transazioni.

Le API di contenuto in tempo reale abilitano una vasta gamma di applicazioni AI che dipendono da informazioni attuali. I sistemi di Generazione Aumentata dal Recupero (RAG) usano le API di contenuto in tempo reale per recuperare i documenti, articoli o voci di knowledge base più recenti, assicurando che le risposte generate incorporino le informazioni più aggiornate disponibili. Gli agenti AI sfruttano le API in tempo reale per accedere a dati di mercato correnti, livelli di inventario, informazioni sui clienti e metriche operative, consentendo loro di prendere decisioni tempestive e intraprendere azioni adeguate. I motori di personalizzazione usano le API di contenuto in tempo reale per tracciare comportamento, preferenze e contesto degli utenti, permettendo ai sistemi AI di offrire esperienze personalizzate che si adattano alle esigenze in continua evoluzione. I sistemi di rilevamento frodi fanno affidamento sulle API di contenuto in tempo reale per accedere a dati di transazione, profili utente e pattern storici, abilitando l’identificazione immediata di attività sospette. I sistemi di raccomandazione utilizzano API in tempo reale per incorporare contenuti di tendenza, interazioni utente e informazioni contestuali, garantendo che le raccomandazioni siano sempre pertinenti e aggiornate. Chatbot e AI conversazionali beneficiano dell’accesso in tempo reale a knowledge base, FAQ e informazioni di prodotto, consentendo loro di fornire risposte accurate e aggiornate alle richieste degli utenti.

Le API di contenuto in tempo reale svolgono un ruolo cruciale nell’abilitare visibilità e monitoraggio AI, consentendo alle organizzazioni di tracciare come i sistemi AI accedono, processano e utilizzano i contenuti. Strumentando le API di contenuto in tempo reale con capacità di monitoraggio, le organizzazioni possono osservare quali contenuti i sistemi AI stanno recuperando, con quale frequenza accedono a informazioni specifiche e come questi contenuti influenzano le uscite AI. Questa visibilità è essenziale per comprendere il comportamento dell’AI, garantire la conformità alle politiche di governance dei dati e rilevare quando i sistemi AI fanno affidamento su informazioni obsolete o errate. Il tracciamento dell’attribuzione dei contenuti tramite API in tempo reale permette alle organizzazioni di capire quali fonti i sistemi AI usano per generare risposte, supportando trasparenza e responsabilità. Il monitoraggio in tempo reale dei pattern di utilizzo delle API aiuta a identificare colli di bottiglia prestazionali, ottimizzare la consegna dei dati e garantire che i sistemi AI abbiano accesso alle informazioni di cui hanno bisogno. Per le organizzazioni che utilizzano piattaforme come AmICited.com, le API di contenuto in tempo reale forniscono la base per monitorare come sistemi AI come ChatGPT, Perplexity e Google AI Overviews fanno riferimento e citano i contenuti di un brand, abilitando la visibilità in tempo reale su menzioni e citazioni AI generate.

La distinzione tra API di contenuto in tempo reale e batch processing rappresenta una differenza fondamentale su come i dati vengono consegnati ai sistemi AI. Il batch processing raccoglie dati in un certo periodo di tempo e li elabora a intervalli programmati, tipicamente ore o giorni dopo, rendendolo adatto all’analisi storica e al reporting ma inadatto alle applicazioni AI sensibili al tempo. Le API di contenuto in tempo reale, invece, consegnano i dati immediatamente non appena sono disponibili, consentendo ai sistemi AI di rispondere alle condizioni attuali e prendere decisioni basate sulle informazioni più recenti. Per le applicazioni AI che richiedono risposte immediate—come rilevamento frodi, sistemi di trading o chatbot per il servizio clienti—la latenza del batch processing è proibitiva. Le API in tempo reale abilitano anche apprendimento e adattamento continui, dove i sistemi AI possono modificare il loro comportamento in base al feedback immediato e alle condizioni variabili. Mentre il batch processing eccelle nell’elaborare grandi volumi di dati storici in modo economico, le API di contenuto in tempo reale sono essenziali per applicazioni dove tempestività e accuratezza sono fondamentali. Molte architetture AI moderne adottano un approccio ibrido, utilizzando API in tempo reale per decisioni immediate mentre il batch processing gestisce analisi approfondite e l’addestramento dei modelli su dati storici.

Implementare API di contenuto in tempo reale per i sistemi AI introduce diverse sfide tecniche e operative. La scalabilità rimane una preoccupazione primaria, poiché mantenere milioni di connessioni concorrenti garantendo prestazioni costanti richiede infrastrutture sofisticate e una gestione attenta delle risorse. La consistenza dei dati tra sistemi distribuiti diventa più complessa in ambienti real-time, dove assicurarsi che tutti i sistemi AI ricevano aggiornamenti nell’ordine corretto e senza duplicazioni richiede un coordinamento accurato. Gestione degli errori e resilienza sono critici, poiché guasti di rete, interruzioni di servizio o corruzione dei dati possono influenzare le prestazioni dei sistemi AI; sono essenziali meccanismi robusti per il recupero delle connessioni, il replay dei messaggi e la sincronizzazione dello stato. Le implicazioni sui costi possono essere significative, poiché le infrastrutture di streaming in tempo reale richiedono spesso più risorse rispetto al batch processing, anche se il valore fornito in termini di maggiore accuratezza e reattività AI spesso giustifica l’investimento. Sicurezza e controllo degli accessi devono essere implementati con attenzione per assicurare che i sistemi AI accedano solo ai contenuti autorizzati e che le informazioni sensibili siano protette durante la trasmissione. Monitoraggio e osservabilità diventano sempre più importanti nei sistemi real-time, dove flussi di dati rapidi e interazioni complesse rendono essenziale avere una visibilità completa sul comportamento e sulle prestazioni del sistema.

Diversi strumenti e piattaforme mature consentono alle organizzazioni di costruire e distribuire API di contenuto in tempo reale per sistemi AI. Confluent offre una piattaforma completa di data streaming basata su Apache Kafka, con servizi gestiti per l’ingestione, l’elaborazione e la distribuzione di dati in tempo reale alle applicazioni AI tramite il suo Real-Time Context Engine e le funzionalità Confluent Intelligence. Tinybird è specializzata nell’elaborazione dati in tempo reale e nella generazione di API, permettendo alle organizzazioni di ingerire dati in streaming ed esporli istantaneamente tramite API a bassa latenza adatte alle applicazioni AI. Realtime API di OpenAI consente la comunicazione diretta in tempo reale con i modelli AI, supportando interazioni speech-to-speech e input multimodali con latenza minima. Apache Kafka resta lo standard industriale per l’event streaming distribuito, fornendo la base per innumerevoli pipeline di dati real-time. AmICited.com si distingue come piattaforma leader per il monitoraggio e la visibilità AI, usando API di contenuto in tempo reale per tracciare come i sistemi AI fanno riferimento e citano i contenuti di un brand su ChatGPT, Perplexity, Google AI Overviews e altre piattaforme AI. Queste piattaforme consentono collettivamente alle organizzazioni di costruire sistemi AI sofisticati che sfruttano contenuti in tempo reale per una maggiore accuratezza, reattività e qualità delle decisioni.

Le API di Contenuti in Tempo Reale stabiliscono connessioni persistenti che inviano dati ai client appena sono disponibili, mentre le tradizionali REST API richiedono che i client inviino richieste e attendano le risposte. Le API di Contenuti in Tempo Reale consegnano informazioni in millisecondi con aggiornamenti continui, mentre le REST API hanno una latenza maggiore e richiedono polling per i nuovi dati. Questo rende le API in tempo reale ideali per i sistemi AI che necessitano di informazioni attuali, mentre le REST API sono più adatte ai servizi web standard.

I sistemi AI come LLM e agenti AI prendono decisioni basandosi sulle informazioni disponibili. Dati obsoleti o non aggiornati possono portare a risposte inaccurate, opportunità perse e decisioni sbagliate. Le API di contenuto in tempo reale garantiscono che i sistemi AI abbiano sempre accesso alle informazioni più attuali, consentendo loro di fornire risposte accurate, comprendere le condizioni attuali e adattarsi a circostanze mutevoli. Questo è particolarmente critico per applicazioni come rilevamento frodi, trading e raccomandazioni personalizzate, dove i ritardi possono causare errori significativi.

I protocolli comuni includono WebSockets per la comunicazione bidirezionale, Server-Sent Events (SSE) per aggiornamenti unidirezionali server-to-client, gRPC per comunicazione ad alte prestazioni tra microservizi, Apache Kafka per streaming di eventi distribuiti, MQTT per applicazioni IoT e AMQP per messaggistica aziendale. Ogni protocollo ha punti di forza diversi ed è ottimizzato per casi d’uso specifici, dalle applicazioni interattive alle pipeline di dati su larga scala.

Le API di contenuto in tempo reale migliorano l’accuratezza garantendo ai modelli AI l’accesso alle informazioni più attuali e rilevanti nella generazione delle risposte. Questo è particolarmente importante per i sistemi di generazione aumentata dal recupero (RAG), dove la qualità del contesto recuperato influisce direttamente sulla qualità delle risposte. Con dati freschi, i sistemi AI possono fornire raccomandazioni più accurate, rilevare frodi in modo più efficace e prendere decisioni meglio informate basate sulle condizioni attuali invece che su informazioni obsolete.

Le sfide chiave includono la gestione della scalabilità per milioni di connessioni concorrenti, la garanzia della coerenza dei dati tra sistemi distribuiti, l’implementazione di meccanismi robusti di gestione errori e recupero, il controllo dei costi dell’infrastruttura in tempo reale, la sicurezza dei dati sensibili durante la trasmissione e il mantenimento di un monitoraggio e osservabilità completi. Queste sfide richiedono infrastrutture sofisticate, un’attenta progettazione architetturale e una gestione operativa continua.

Le API di contenuto in tempo reale permettono alle organizzazioni di tracciare quali contenuti i sistemi AI stanno accedendo, con quale frequenza recuperano informazioni specifiche e come questi contenuti influenzano le uscite AI. Strumentando le API con capacità di monitoraggio, le organizzazioni possono osservare il comportamento dell’AI, garantire la conformità alle politiche di governance dei dati, tracciare l’attribuzione dei contenuti e comprendere su quali fonti fanno affidamento i sistemi AI. Questa visibilità è essenziale per trasparenza, responsabilità e comprensione delle prestazioni dei sistemi AI.

Le API di contenuto in tempo reale richiedono tipicamente più risorse infrastrutturali rispetto al batch processing, poiché devono mantenere connessioni persistenti e consegnare dati con latenza minima. Tuttavia, il valore aggiunto in termini di maggiore accuratezza AI, decisioni più rapide e migliore esperienza utente spesso giustifica il costo superiore. Molte organizzazioni adottano un approccio ibrido, utilizzando le API in tempo reale per decisioni immediate mentre il batch processing gestisce analisi approfondite e l’addestramento dei modelli su dati storici.

AmICited.com sfrutta le API di contenuto in tempo reale per monitorare come sistemi AI come ChatGPT, Perplexity e Google AI Overviews fanno riferimento e citano i contenuti di un brand. La piattaforma offre visibilità in tempo reale sulle menzioni AI generate, citazioni e attribuzione dei contenuti, consentendo alle organizzazioni di tracciare l’utilizzo dei propri contenuti da parte dei sistemi AI. Questo monitoraggio in tempo reale aiuta i brand a comprendere la loro presenza nelle uscite AI e garantire una rappresentazione accurata attraverso le piattaforme AI.

Traccia e monitora come sistemi AI come ChatGPT, Perplexity e Google AI Overviews citano e fanno riferimento al tuo brand con la piattaforma di monitoraggio dei contenuti in tempo reale di AmICited.com.

Scopri come funziona la ricerca in tempo reale nell'IA, i suoi vantaggi per utenti e aziende e in che modo si differenzia dai motori di ricerca tradizionali e d...

Scopri l'adattamento AI in tempo reale: la tecnologia che consente ai sistemi AI di apprendere continuamente dagli eventi e dai dati attuali. Esplora come funzi...

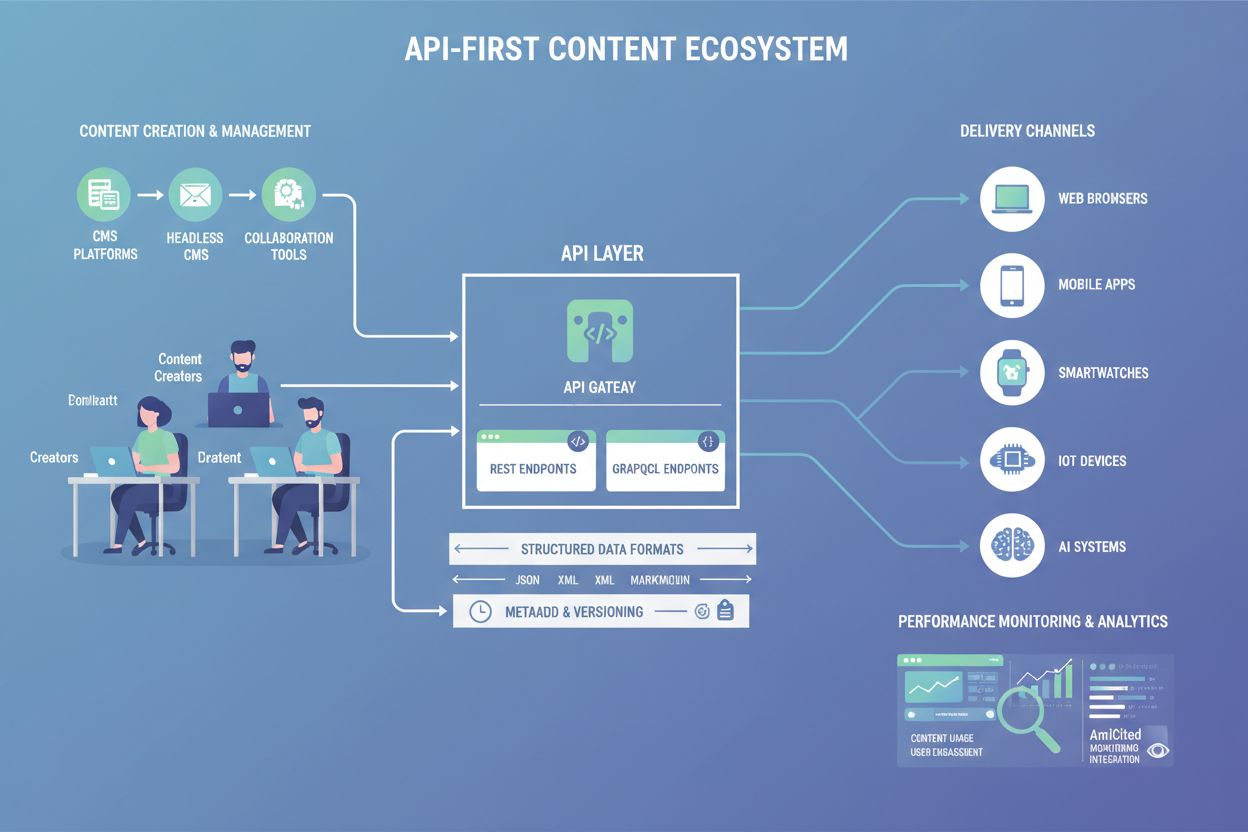

Scopri cos’è il Contenuto API-First, come facilita la visibilità per l’IA e perché è importante per l’architettura dei contenuti. Scopri come le API strutturate...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.