Content SEO

Il Content SEO è la creazione e ottimizzazione strategica di contenuti di alta qualità per migliorare il posizionamento nei motori di ricerca e la visibilità or...

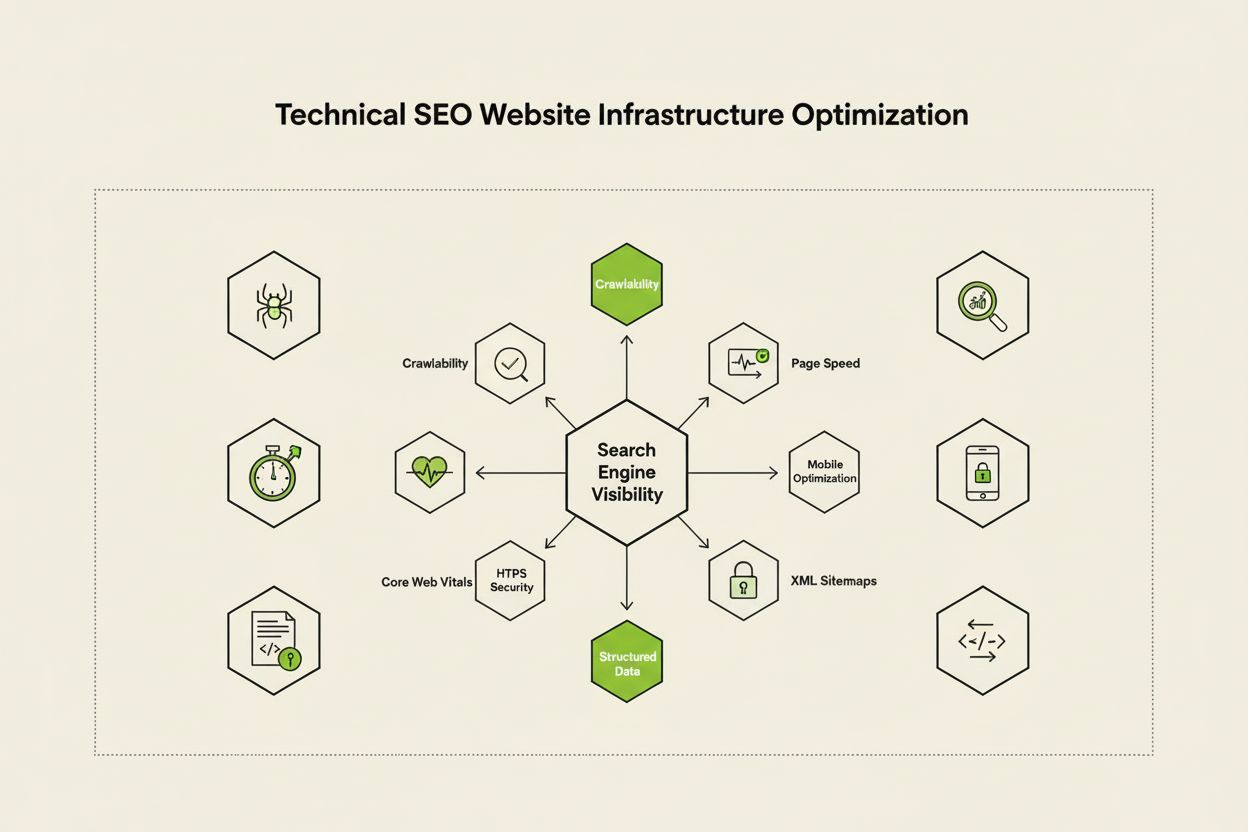

La SEO tecnica è il processo di ottimizzazione dell’infrastruttura di un sito web affinché i motori di ricerca possano eseguire la scansione, il rendering, l’indicizzazione e la distribuzione dei contenuti in modo corretto ed efficiente. Comprende la velocità del sito, la compatibilità mobile, l’architettura del sito, la sicurezza e l’implementazione dei dati strutturati per garantire che i motori di ricerca possano scoprire e posizionare le tue pagine.

La SEO tecnica è il processo di ottimizzazione dell'infrastruttura di un sito web affinché i motori di ricerca possano eseguire la scansione, il rendering, l'indicizzazione e la distribuzione dei contenuti in modo corretto ed efficiente. Comprende la velocità del sito, la compatibilità mobile, l'architettura del sito, la sicurezza e l'implementazione dei dati strutturati per garantire che i motori di ricerca possano scoprire e posizionare le tue pagine.

La SEO tecnica è il processo di ottimizzazione dell’infrastruttura backend di un sito web per garantire che i motori di ricerca possano eseguire in modo efficiente la scansione, il rendering, l’indicizzazione e la distribuzione dei contenuti in modo corretto. Diversamente dalla SEO on-page, che si concentra sulla qualità dei contenuti e sull’ottimizzazione delle parole chiave, la SEO tecnica si occupa degli elementi fondamentali che determinano se i motori di ricerca possano effettivamente accedere e comprendere il tuo sito web. Questo include la velocità del sito, la reattività mobile, l’architettura del sito, i protocolli di sicurezza, l’implementazione dei dati strutturati e i fattori di crawlabilità. La SEO tecnica funge da fondamento invisibile su cui si basano tutte le altre attività SEO: senza di essa, anche i contenuti di più alta qualità rimangono invisibili ai motori di ricerca e agli utenti. Secondo le ricerche di settore, il 91% dei marketer ha dichiarato che la SEO ha migliorato le performance dei siti web nel 2024, con l’ottimizzazione tecnica che gioca un ruolo fondamentale nel raggiungere risultati misurabili. L’importanza della SEO tecnica è aumentata con la crescente sofisticazione dei motori di ricerca e l’emergere di piattaforme di ricerca AI, che richiedono siti web conformi a standard tecnici sempre più rigorosi per ottenere visibilità.

La SEO tecnica si basa su quattro pilastri interconnessi che lavorano insieme per massimizzare la visibilità sui motori di ricerca. La crawlabilità determina se Googlebot e altri crawler dei motori di ricerca possono accedere alle pagine del tuo sito tramite link, sitemap e strutture di navigazione interna. L’indicizzabilità garantisce che le pagine scansionate vengano effettivamente archiviate nell’indice di Google e possano comparire nei risultati di ricerca. Performance e Core Web Vitals misurano la velocità di caricamento delle pagine e la loro reattività all’interazione degli utenti: fattori che influenzano direttamente ranking ed esperienza utente. L’ottimizzazione mobile assicura che il tuo sito funzioni perfettamente su smartphone e tablet, che oggi rappresentano oltre il 60% di tutto il traffico di ricerca secondo le ricerche Sistrix. Questi quattro pilastri sono interdipendenti: una debolezza in uno solo può compromettere l’efficacia degli altri. Ad esempio, un sito desktop veloce che però offre una scarsa esperienza mobile farà fatica a posizionarsi nell’indice mobile-first di Google, indipendentemente da quanto sia ottimizzata la sua crawlabilità. Comprendere come questi pilastri interagiscono è fondamentale per sviluppare una strategia di SEO tecnica completa che affronti ogni aspetto della visibilità sui motori di ricerca.

Sebbene spesso confuse, crawlabilità e indicizzabilità rappresentano due fasi distinte nel processo dei motori di ricerca. Crawlabilità si riferisce alla capacità di un motore di ricerca di scoprire e accedere alle pagine del tuo sito seguendo link interni, backlink esterni e sitemap XML. Risponde alla domanda: “Googlebot può raggiungere questa pagina?” Se una pagina non è scansionabile—magari perché bloccata da robots.txt, nascosta dietro JavaScript o orfana senza link interni—non può passare alla fase di indicizzazione. Indicizzabilità, invece, determina se una pagina scansionata viene effettivamente archiviata nell’indice di Google ed è idonea a comparire nei risultati di ricerca. Una pagina può essere perfettamente scansionabile ma non indicizzata se contiene il meta tag noindex, ha contenuti duplicati o non soddisfa gli standard di qualità di Google. Secondo la guida tecnica di Search Engine Land, comprendere questa distinzione è fondamentale perché risolvere i problemi di crawlabilità richiede soluzioni diverse rispetto a quelli di indicizzabilità. I problemi di crawlabilità riguardano tipicamente la struttura del sito, la configurazione del robots.txt e i link interni, mentre quelli di indicizzabilità spesso dipendono da meta tag, tag canonici, qualità dei contenuti e problemi di rendering. Entrambi devono essere affrontati per raggiungere la massima visibilità sui motori di ricerca.

I Core Web Vitals sono tre metriche specifiche che Google utilizza per misurare l’esperienza utente reale e che influenzano direttamente il ranking. Largest Contentful Paint (LCP) misura quanto velocemente si carica l’elemento visibile più grande di una pagina: Google raccomanda un LCP di 2,5 secondi o meno. Interaction to Next Paint (INP), che ha sostituito First Input Delay nel 2024, misura la reattività di una pagina alle interazioni degli utenti come click e tap: l’obiettivo è restare sotto i 200 millisecondi. Cumulative Layout Shift (CLS) valuta la stabilità visiva monitorando cambiamenti di layout inattesi durante il caricamento: un punteggio inferiore a 0,1 è considerato buono. Secondo DebugBear, i siti web devono offrire a almeno il 75% degli utenti prestazioni “Buone” su tutte e tre le metriche per ottenere il massimo beneficio in termini di ranking. Il passaggio a INP come fattore di ranking riflette l’impegno di Google nel valutare la reattività complessiva durante tutta l’interazione dell’utente e non solo al caricamento iniziale. Ottimizzare i Core Web Vitals richiede un approccio multifattoriale: migliorare l’LCP significa ottimizzare le immagini, usare CDN e posticipare JavaScript non essenziale; migliorare l’INP richiede la suddivisione di compiti JavaScript lunghi e l’ottimizzazione dei gestori di eventi; ridurre il CLS implica riservare spazio per contenuti dinamici ed evitare pubblicità che spostano il layout. Queste metriche sono ormai imprescindibili per una SEO competitiva, poiché le pagine con Core Web Vitals scadenti subiscono penalizzazioni nel ranking e tassi di rimbalzo più elevati.

L’architettura del sito riguarda il modo in cui le pagine del tuo sito sono organizzate, strutturate e collegate tramite link interni. Un’architettura ben progettata svolge funzioni critiche: aiuta i motori di ricerca a comprendere la gerarchia dei contenuti, distribuisce l’equità dei link (ranking power) in tutto il sito, garantisce che le pagine importanti siano facilmente individuabili e migliora la navigazione per l’utente. L’architettura ideale segue una gerarchia chiara con la homepage in cima, le pagine di categoria al secondo livello e i contenuti specifici ai livelli inferiori. La best practice prevede che tutte le pagine importanti siano accessibili entro tre clic dalla homepage, così che Googlebot non sprechi crawl budget su pagine profonde e isolate. Il linking interno funge da tessuto connettivo dell’architettura, guidando utenti e motori di ricerca tra i contenuti. Un linking interno strategico consolida i segnali di ranking sulle pagine prioritarie, crea relazioni tematiche tra contenuti correlati e aiuta i motori di ricerca a capire quali pagine sono più importanti. Ad esempio, un modello “hub and spoke”—dove una pagina pilastro collega a diverse sottopagine tematiche, che a loro volta rimandano alla pagina pilastro—genera una struttura efficace che segnala autorità tematica ai motori di ricerca. Un’architettura scadente, con pagine orfane, navigazione incoerente e troppi livelli di profondità, costringe i motori di ricerca a sprecare crawl budget su contenuti poco rilevanti e rende difficile stabilire autorità tematica. Le aziende che ristrutturano l’architettura del sito registrano spesso miglioramenti drastici nella velocità di indicizzazione e nelle performance di ranking.

Il mobile-first indexing significa che Google utilizza principalmente la versione mobile del tuo sito per la scansione, l’indicizzazione e il posizionamento—non quella desktop. Questo cambiamento riflette il fatto che oltre il 60% delle ricerche oggi parte da dispositivi mobili. Dal punto di vista tecnico, ciò implica che l’esperienza mobile deve essere impeccabile: design responsivo che si adatta a tutte le dimensioni di schermo, navigazione touch-friendly con spaziatura adeguata tra gli elementi cliccabili, dimensioni dei caratteri leggibili senza bisogno di zoom e tempi di caricamento rapidi ottimizzati per le reti mobili. Il design responsivo utilizza layout fluidi e immagini flessibili per adattarsi automaticamente a qualsiasi schermo, garantendo funzionalità coerente su tutti i dispositivi. Errori comuni di ottimizzazione mobile includono interstitial invasivi (pop-up) che bloccano i contenuti principali, testo troppo piccolo per essere letto senza zoom, pulsanti troppo ravvicinati per tap precisi e pagine che si caricano lentamente su reti mobili. Il Mobile-Friendly Test di Google e gli audit Lighthouse aiutano a identificare questi problemi, ma sono fondamentali anche test reali su dispositivi mobili. Il rapporto tra ottimizzazione mobile e ranking è diretto: pagine con scarsa esperienza mobile subiscono penalità, mentre quelle ottimizzate guadagnano visibilità. Per e-commerce, SaaS e publisher, l’ottimizzazione mobile non è opzionale—è fondamentale per la visibilità competitiva.

Le sitemap XML fungono da mappa per i motori di ricerca, elencando tutti gli URL che desideri indicizzare insieme a metadati come la data di ultima modifica e la priorità. Una sitemap ben gestita deve includere solo URL canonici e indicizzabili, escludendo redirect, pagine 404 e contenuti duplicati. Il robots.txt è un file di testo che si trova nella root del sito e fornisce istruzioni di scansione ai bot, specificando quali directory e file possono o non possono essere esaminati. Il robots.txt può bloccare la scansione, ma non impedisce l’indicizzazione se la pagina viene scoperta in altri modi: per escluderla davvero serve il meta tag noindex. Il crawl budget è il numero di pagine che Googlebot scansiona sul tuo sito in un dato periodo: una risorsa limitata da gestire strategicamente. I siti di grandi dimensioni, con milioni di pagine, devono ottimizzare il crawl budget per fare in modo che Googlebot si concentri sui contenuti di maggior valore e non sprechi risorse su pagine poco importanti, duplicate o varianti di navigazione facettata. Lo spreco di crawl budget avviene spesso quando i parametri di ricerca generano infinite varianti di URL, quando ambienti di staging o sviluppo sono accessibili ai crawler o quando pagine di scarsa qualità ricevono troppi link interni. Secondo le linee guida ufficiali di Google, la gestione del crawl budget è particolarmente rilevante per i siti molto grandi, perché una scansione inefficace può ritardare la scoperta e l’indicizzazione dei nuovi contenuti. Strumenti come il report Crawl Stats di Google Search Console e l’analisi dei log server aiutano a capire quali pagine Googlebot visita e con quale frequenza, consentendo un’ottimizzazione mirata del crawl budget.

I dati strutturati, implementati tramite schema markup, aiutano i motori di ricerca a comprendere il significato e il contesto dei tuoi contenuti oltre la semplice analisi testuale. Lo schema markup utilizza un vocabolario standardizzato (schema.org) per etichettare diversi tipi di contenuti—prodotti, articoli, ricette, eventi, attività locali e altro. Se implementato correttamente, lo schema markup consente rich result nelle ricerche, in cui Google mostra informazioni avanzate come valutazioni, prezzi, tempi di cottura o date di eventi direttamente nei risultati. Questa visibilità aumentata può migliorare notevolmente i tassi di clic e il coinvolgimento. Ogni tipo di contenuto richiede uno schema specifico: Article schema per blog e news, Product schema per e-commerce, FAQ schema per domande frequenti, Local Business schema per attività locali, Event schema per eventi futuri. L’implementazione avviene di solito in formato JSON-LD, metodo preferito da Google. Tuttavia, lo schema deve riflettere fedelmente il contenuto reale della pagina: schema fuorviante o inventato può comportare penalità manuali. Secondo Search Engine Land, solo le pagine con schema valido e pertinente ottengono rich result, quindi la precisione è cruciale. Le organizzazioni che implementano dati strutturati su tutte le pagine chiave vedono spesso una maggiore visibilità sia nei risultati tradizionali sia sulle piattaforme di ricerca AI, poiché questi sistemi si affidano ai dati strutturati per comprendere e citare accuratamente i contenuti.

HTTPS (Hypertext Transfer Protocol Secure) cripta i dati trasmessi tra il browser degli utenti e il tuo server, proteggendo le informazioni sensibili e segnalando affidabilità sia agli utenti sia ai motori di ricerca. Google ha confermato che HTTPS è un fattore di ranking e i siti senza HTTPS subiscono sia penalità dirette sia conseguenze indirette come avvisi del browser che scoraggiano l’interazione. L’implementazione di HTTPS richiede un certificato SSL/TLS rilasciato da un’autorità di certificazione affidabile e la configurazione del server affinché tutte le pagine utilizzino HTTPS. Oltre al semplice HTTPS, gli header di sicurezza come Content-Security-Policy, Strict-Transport-Security e X-Content-Type-Options offrono ulteriore protezione contro le vulnerabilità web più comuni. Errori di mixed content—dove pagine HTTPS caricano risorse HTTP—compromettono la sicurezza e possono far scattare avvisi del browser. Il rapporto tra sicurezza e SEO va oltre il ranking: i siti sicuri ispirano fiducia, riducono il bounce rate e migliorano le conversioni. Per e-commerce, SaaS e tutti i siti che raccolgono dati personali, la sicurezza è imprescindibile. Audit regolari tramite Google Search Console Security Issues e scanner di vulnerabilità di terze parti aiutano a individuare e risolvere i problemi prima che impattino ranking o fiducia degli utenti.

| Aspetto | SEO tecnico | SEO On-Page | SEO Off-Page |

|---|---|---|---|

| Focus principale | Infrastruttura del sito, velocità, crawlabilità, indicizzabilità | Qualità dei contenuti, parole chiave, meta tag, intestazioni | Backlink, menzioni del brand, segnali social |

| Accesso dei Motori di Ricerca | Garantisce che i motori di ricerca possano scansionare e indicizzare le pagine | Aiuta i motori di ricerca a comprendere la rilevanza della pagina | Costruisce autorità e segnali di fiducia |

| Elementi chiave | Velocità sito, ottimizzazione mobile, Core Web Vitals, architettura, HTTPS, dati strutturati | Posizionamento parole chiave, profondità contenuto, linking interno, meta description | Profilo backlink, autorità dominio, menzioni brand |

| Strumenti utilizzati | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Impatto sul ranking | Fondamentale—senza di essa le pagine non possono posizionarsi | Diretto—migliora la rilevanza per le keyword target | Significativo—costruisce autorità e fiducia |

| Impatto sull’esperienza utente | Alto—influenza velocità, usabilità mobile, accessibilità | Medio—influenza leggibilità e coinvolgimento | Basso—indiretto tramite percezione del brand |

| Tempistiche di implementazione | Continuativa—richiede monitoraggio e ottimizzazione costanti | Continuativa—richiede aggiornamenti e ottimizzazione contenuti | Lungo termine—richiede attività sostenute di link building |

| Misurazione ROI | Efficienza scansione, tasso indicizzazione, punteggi Core Web Vitals, ranking | Posizionamento keyword, traffico organico, click-through rate | Crescita backlink, autorità dominio, traffico referral |

La SEO JavaScript affronta le sfide specifiche dei siti web pesanti in JavaScript, single-page application (SPA) e contenuti dinamici. In passato, Googlebot aveva difficoltà con JavaScript perché richiedeva il rendering—cioè l’esecuzione del codice JavaScript per costruire la pagina finale—aggiungendo complessità e ritardi nella scansione. Oggi Googlebot rende la maggior parte delle pagine prima di indicizzarle, ma questo introduce nuove considerazioni tecniche. Il server-side rendering (SSR) genera HTML completo sul server prima di inviarlo al browser, assicurando che i motori di ricerca vedano subito tutti i contenuti senza attendere l’esecuzione di JavaScript. La static site generation (SSG) pre-renderizza le pagine in fase di build, creando file HTML statici che si caricano istantaneamente. Il dynamic rendering serve HTML pre-renderizzato ai motori di ricerca e JavaScript agli utenti, ma Google considera questa soluzione temporanea. Il principio chiave: tutti i contenuti essenziali, meta tag e dati strutturati devono essere visibili nell’HTML iniziale, e non caricati solo dopo l’esecuzione di JavaScript. Le pagine che nascondono contenuti critici dietro JavaScript rischiano indicizzazione incompleta o ritardata. Framework come React, Vue e Angular richiedono attenzioni specifiche—molte aziende che li utilizzano implementano Next.js o Nuxt.js proprio per gestire il rendering server-side e migliorare la SEO. Testare come Googlebot vede le tue pagine tramite lo strumento di ispezione URL di Google Search Console e la funzione snapshot renderizzato rivela se i contenuti dipendenti da JavaScript vengono effettivamente indicizzati.

Una SEO tecnica efficace richiede un approccio sistematico che dia priorità alle ottimizzazioni ad alto impatto. Parti dagli elementi fondamentali: assicurati che il sito sia scansionabile controllando robots.txt e linking interno, verifica che le pagine importanti siano indicizzabili controllando tag noindex e problemi di canonicalizzazione, e stabilisci una baseline per i Core Web Vitals. Poi passa all’ottimizzazione delle performance: comprimi e ottimizza le immagini, implementa il lazy loading per i contenuti sotto la piega, posticipa JavaScript non essenziale e sfrutta le Content Delivery Network (CDN) per una distribuzione più rapida. Successivamente, ottimizza la struttura del sito: assicurati che le pagine importanti siano raggiungibili entro tre clic dalla homepage, implementa la navigazione breadcrumb con schema markup e crea pattern di linking interno chiari che guidino utenti e motori di ricerca. Implementa i dati strutturati per le tipologie di contenuto principali—prodotti, articoli, attività locali o eventi—utilizzando formato JSON-LD e validando con Rich Results Test di Google. Monitora costantemente tramite Google Search Console per problemi di indicizzazione, PageSpeed Insights per i Core Web Vitals e i log server per le scansioni dei crawler. Assumi responsabilità tracciando metriche chiave come numero di pagine indicizzate, punteggi Core Web Vitals ed efficienza di scansione nel tempo. Le organizzazioni che trattano la SEO tecnica come processo continuo, e non come audit una tantum, superano costantemente i concorrenti in visibilità e metriche di esperienza utente.

Con la crescita di piattaforme di ricerca AI come Google AI Overviews, Perplexity, ChatGPT e Claude, l’importanza della SEO tecnica si estende oltre la ricerca tradizionale di Google. Questi sistemi AI si basano su contenuti correttamente indicizzati e ben strutturati dagli indici dei motori di ricerca per generare risposte e citazioni. La SEO tecnica garantisce che i tuoi contenuti siano individuabili e correttamente interpretati dai sistemi AI attraverso diversi meccanismi: l’indicizzazione rende i contenuti disponibili per l’addestramento e la consultazione delle AI, i dati strutturati aiutano a comprendere il contesto e il significato, la ricchezza semantica permette all’AI di riconoscere i contenuti come autorevoli e pertinenti. Secondo ricerche di Conductor e Botify, le pagine che compaiono negli AI Overviews provengono tipicamente da siti ben indicizzati, tecnicamente solidi e con forti segnali semantici. Il rapporto è bidirezionale: mentre la SEO tradizionale punta al ranking per parole chiave specifiche, la ricerca AI punta a fornire risposte complete che possono citare più fonti. Questo cambiamento implica che la SEO tecnica debba supportare entrambe le modalità—garantendo l’indicizzazione per la ricerca tradizionale e la ricchezza semantica per essere riconosciuti e citati dalle AI. Le organizzazioni che monitorano la visibilità su più piattaforme AI tramite strumenti come AmICited possono identificare quali ottimizzazioni tecniche migliorano maggiormente la citazione e la visibilità nei risultati generativi.

Una SEO tecnica efficace richiede il monitoraggio di metriche specifiche che indichino la salute del sito e l’accessibilità ai motori di ricerca. Numero di pagine indicizzate: mostra quante delle pagine che desideri sono effettivamente presenti nell’indice di Google—il confronto con il totale delle pagine indicizzabili rivela l’efficienza di indicizzazione. Efficienza di scansione: misura quanto efficacemente Googlebot usa il crawl budget, calcolata dividendo le pagine scansionate per il totale delle pagine del sito. Punteggi Core Web Vitals: indicano la qualità dell’esperienza utente su velocità (LCP), interattività (INP) e stabilità visiva (CLS). Problemi di usabilità mobile tracciati in Google Search Console segnalano errori come tap target troppo piccoli, errori di configurazione viewport o interstitial invasivi. Lunghezza delle catene di redirect: va minimizzata per non disperdere l’equità dei link e ridurre i ritardi di scansione. Copertura dei dati strutturati: indica la percentuale di pagine che implementano schema markup valido. Metriche di velocità pagina: includono First Contentful Paint (FCP), Time to Interactive (TTI) e Total Blocking Time (TBT) per insight dettagliati sulle performance. Le organizzazioni dovrebbero stabilire metriche di base, fissare obiettivi di miglioramento e monitorare i progressi mensilmente o trimestralmente. Variazioni improvvise spesso segnalano problemi tecnici da risolvere prima che impattino il ranking. Strumenti come Google Search Console, PageSpeed Insights, Lighthouse e piattaforme enterprise come Semrush offrono dashboard complete per monitorare queste metriche su tutto il sito.

Il panorama della SEO tecnica continua ad evolversi in risposta ai cambiamenti degli algoritmi, alle nuove tecnologie e ai comportamenti degli utenti. Indicizzazione e ranking guidati dall’AI influenzeranno sempre più quali pagine verranno indicizzate e come saranno posizionate, richiedendo alla SEO tecnica di supportare la comprensione semantica e il riconoscimento delle entità. Edge computing e architetture serverless permetteranno una distribuzione dei contenuti più rapida e ottimizzazione real-time al bordo della rete, riducendo la latenza e migliorando i Core Web Vitals. Focus crescente sui segnali E-E-A-T (Esperienza, Competenza, Autorevolezza, Affidabilità) implica che la SEO tecnica debba supportare la credibilità dei contenuti tramite markup dell’autore, date di pubblicazione e segnali di fiducia. L’ottimizzazione multi-superficie diventerà la norma con la proliferazione delle piattaforme di ricerca AI, richiedendo ai siti di massimizzare la visibilità su Google, Perplexity, ChatGPT, Claude e altre piattaforme emergenti. Analytics privacy-first e raccolta dati di prima parte rivoluzioneranno il modo in cui si misura l’impatto della SEO tecnica, spostandosi dai cookie di terze parti verso il tracking server-side e misurazioni basate sul consenso. La maturazione dei framework JavaScript continuerà a migliorare le capacità SEO, con Next.js, Nuxt.js e Remix che diventeranno standard per applicazioni SEO-friendly. SEO tecnica automatizzata guidata dall’AI consentirà rilevamento e risoluzione più rapidi dei problemi, con piattaforme che suggeriranno automaticamente correzioni per crawlabilità, indicizzabilità e performance. Le organizzazioni che rimarranno aggiornate su queste tendenze, aggiornando costantemente l’infrastruttura tecnica e seguendo le best practice emergenti, manterranno un vantaggio competitivo nella visibilità organica.

La SEO tecnica si concentra sull'ottimizzazione dell'infrastruttura di backend di un sito web—come la velocità del sito, la crawlabilità, l'indicizzabilità e la configurazione del server—per aiutare i motori di ricerca a scoprire e processare i contenuti. La SEO on-page, invece, si concentra sull'ottimizzazione degli elementi delle singole pagine come la collocazione delle parole chiave, i meta tag, le intestazioni e la qualità dei contenuti per migliorarne la rilevanza rispetto alle query di ricerca specifiche. Mentre la SEO tecnica garantisce che i motori di ricerca possano accedere al tuo sito, la SEO on-page assicura che comprendano di cosa tratta il tuo contenuto e perché è rilevante per gli utenti.

I Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) e Cumulative Layout Shift (CLS)—sono fattori di ranking confermati che misurano l'esperienza utente reale. Secondo la ricerca di DebugBear, i siti web devono offrire a almeno il 75% degli utenti una esperienza 'Buona' su tutte e tre le metriche per ottenere il massimo beneficio in termini di ranking. Core Web Vitals scadenti possono comportare penalizzazioni nel ranking, tassi di clic ridotti e tassi di rimbalzo più elevati, influenzando direttamente la visibilità organica e il coinvolgimento degli utenti.

La crawlabilità determina se i bot dei motori di ricerca possono accedere e seguire i link all'interno del tuo sito web. Se Googlebot non può scansionare le tue pagine a causa di risorse bloccate, struttura del sito inadeguata o restrizioni robots.txt, quelle pagine non possono essere indicizzate o posizionate. Senza una corretta crawlabilità, anche i contenuti di alta qualità rimangono invisibili ai motori di ricerca, rendendo impossibile ottenere visibilità organica a prescindere dalla qualità dei contenuti o dal profilo di backlink.

Man mano che le piattaforme di ricerca guidate dall'AI come Google AI Overviews e Perplexity diventano più importanti, la SEO tecnica rimane fondamentale. Questi sistemi di intelligenza artificiale si basano su contenuti correttamente indicizzati e ben strutturati provenienti dall'indice di Google per generare risposte. La SEO tecnica garantisce che i tuoi contenuti siano individuabili, correttamente renderizzati e semanticamente ricchi per essere citati e referenziati dai sistemi AI. Senza solide basi tecniche, i tuoi contenuti non appariranno negli AI Overviews o in altri risultati di ricerca generativa.

Per la maggior parte dei siti web, si consiglia di eseguire un audit tecnico SEO completo ogni trimestre, con monitoraggio mensile per problemi critici. I siti enterprise più grandi con aggiornamenti frequenti dovrebbero eseguire audit mensili oppure implementare sistemi di monitoraggio continuo. Dopo modifiche importanti al sito, migrazioni o redesign, sono essenziali audit immediati. Audit regolari aiutano a individuare tempestivamente i problemi prima che influenzino il ranking, assicurando che il sito mantenga crawlabilità, indicizzabilità e prestazioni ottimali.

L'architettura del sito determina come i motori di ricerca navigano e comprendono la gerarchia dei contenuti del tuo sito web. Un'architettura ben ottimizzata assicura che le pagine importanti siano raggiungibili entro tre clic dalla homepage, distribuisce efficacemente l'equità dei link e aiuta i motori di ricerca a privilegiare la scansione dei contenuti di maggior valore. Un'architettura del sito scadente può portare a pagine orfane, spreco del crawl budget e difficoltà nello stabilire l'autorità tematica, influenzando negativamente ranking e visibilità.

La velocità della pagina influisce direttamente sia sul posizionamento nei motori di ricerca che sul comportamento degli utenti. Google ha confermato che i Core Web Vitals—che misurano la velocità di caricamento, l’interattività e la stabilità visiva—sono fattori di ranking. Le pagine lente registrano tassi di rimbalzo più alti, minore coinvolgimento e conversioni ridotte. Studi dimostrano che le pagine che si caricano in meno di 2,5 secondi hanno una retention degli utenti e performance di ranking significativamente migliori rispetto a quelle più lente, rendendo l’ottimizzazione della velocità fondamentale per il successo SEO.

Inizia a tracciare come i chatbot AI menzionano il tuo brand su ChatGPT, Perplexity e altre piattaforme. Ottieni informazioni utili per migliorare la tua presenza AI.

Il Content SEO è la creazione e ottimizzazione strategica di contenuti di alta qualità per migliorare il posizionamento nei motori di ricerca e la visibilità or...

La JavaScript SEO ottimizza i siti resi tramite JavaScript per la scansione e l'indicizzazione da parte dei motori di ricerca. Scopri best practice, metodi di r...

La SEO aziendale è la pratica di ottimizzare siti web grandi e complessi con migliaia di pagine per i motori di ricerca. Scopri strategie, sfide e best practice...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.