AI可視性の長期的ビジョン:私たちが目指す未来

AI可視性モニタリングの未来を、透明性基準から規制遵守まで探ります。ブランドがAI主導の情報環境に備え、AI可視性戦略を早期に導入することで競争優位を獲得する方法を学びましょう。...

AIランキングの透明性とは、AIプラットフォームが回答を生成する際に、どのように情報源を選択・ランク付けしているかを開示する度合いを指します。これは、AIが生成した回答にどのソースが登場するかを決定するアルゴリズムや基準の可視性を意味し、従来の検索エンジンのランキングとは異なります。この透明性は、情報の選択や優先順位付けの仕組みを理解する必要があるコンテンツ制作者、出版社、ユーザーにとって極めて重要です。透明性がなければ、ユーザーは情報源の信頼性を検証したり、AI生成コンテンツに潜む偏りを理解したりすることができません。

AIランキングの透明性とは、AIプラットフォームが回答を生成する際に、どのように情報源を選択・ランク付けしているかを開示する度合いを指します。これは、AIが生成した回答にどのソースが登場するかを決定するアルゴリズムや基準の可視性を意味し、従来の検索エンジンのランキングとは異なります。この透明性は、情報の選択や優先順位付けの仕組みを理解する必要があるコンテンツ制作者、出版社、ユーザーにとって極めて重要です。透明性がなければ、ユーザーは情報源の信頼性を検証したり、AI生成コンテンツに潜む偏りを理解したりすることができません。

AIランキングの透明性とは、人工知能システムがユーザーの質問に回答を生成する際、どのように情報源を選択・優先・提示するかを開示することを指します。従来の検索エンジンが順位付きリンクリストを表示するのとは異なり、Perplexity、ChatGPT、GoogleのAI Overviewsなどの現代的なAIプラットフォームでは、情報源の選択が回答生成プロセスに統合されており、ランキング基準がユーザーからはほぼ見えません。この不透明さは、ユーザーが目にする「合成回答」と、その回答がどのように構築されたか(どの情報源が選ばれ、どのように重み付け・引用されたか)との間に大きなギャップを生みます。コンテンツ制作者や出版社にとって、この透明性の欠如は、自身の可視性が従来の最適化手法では理解・影響できないアルゴリズムに依存することを意味します。従来の検索エンジンの透明性との違いは大きく、Googleは一般的なランキング要素や品質ガイドラインを公開していますが、AIプラットフォームは情報源選択メカニズムを企業秘密として扱うことが多いです。影響を受ける主要な関係者には、可視性を求めるコンテンツ制作者、トラフィックの帰属を懸念する出版社、評判を監視するブランド担当者、情報源を検証する研究者、AI生成の回答の信頼性を理解する必要があるユーザーなどが挙げられます。AIランキングの透明性を理解することは、デジタルコンテンツを生産・流通・利用するすべての人にとって、AIがますます情報流通を仲介する現代において不可欠となっています。

AIプラットフォームは**RAG(Retrieval-Augmented Generation)**システムを採用し、言語モデルとリアルタイムの情報検索を組み合わせて、トレーニングデータだけでなく実際の情報源に基づいた回答を生成します。RAGのプロセスは主に3つの段階からなり、リトリーバル(関連文書の取得)、ランキング(情報源の関連度による順位付け)、生成(引用を維持しながら情報を統合)です。プラットフォームごとにランキング手法は異なり、Perplexityは情報源の権威性と新しさを重視し、GoogleのAI Overviewsはトピックの関連性やE-E-A-T(経験・専門性・権威性・信頼性)指標を重視、ChatGPT Searchは情報源の質と回答の包括性のバランスを取ります。情報源選択に影響する主な要素には、ドメインオーソリティ(評価・被リンク数)、コンテンツの新しさ、トピックの関連性(クエリとの意味的整合性)、エンゲージメント指標(ユーザーの関与度)、引用頻度(他の権威サイトでの参照回数)などがあります。AIシステムは、クエリの意図によってこれらのシグナルの重み付けを変え、事実系の質問では権威性や新しさ、意見系の質問では多様な視点やエンゲージメントを重視する場合があります。ランキングアルゴリズムの詳細はほとんど非公開ですが、各プラットフォームのドキュメントでその一端が明かされています。

| プラットフォーム | 引用の透明性 | 情報源選択基準 | ランキングアルゴリズムの開示 | ユーザー操作性 |

|---|---|---|---|---|

| Perplexity | 高:インライン引用付きリンク | 権威性、新鮮さ、関連性、専門性 | 中程度:一部ドキュメントあり | 中:情報源フィルタ可 |

| Google AI Overviews | 中:引用元を一覧表示 | E-E-A-T、関連性、新鮮さ、エンゲージメント | 低:ほぼ非開示 | 低:カスタマイズ性限定 |

| ChatGPT Search | 中:情報源を別表示 | 質、関連性、包括性、権威性 | 低:独自アルゴリズム | 低:カスタマイズ不可 |

| Brave Leo | 中:情報源明示 | プライバシー尊重、関連性、権威性 | 低:プライバシー重視で不透明 | 中:情報源選択可 |

| Consensus | 非常に高:学術特化・指標明示 | 引用数、査読、最新性、分野の関連性 | 高:学術基準を公開 | 高:研究種別や質でフィルタ可 |

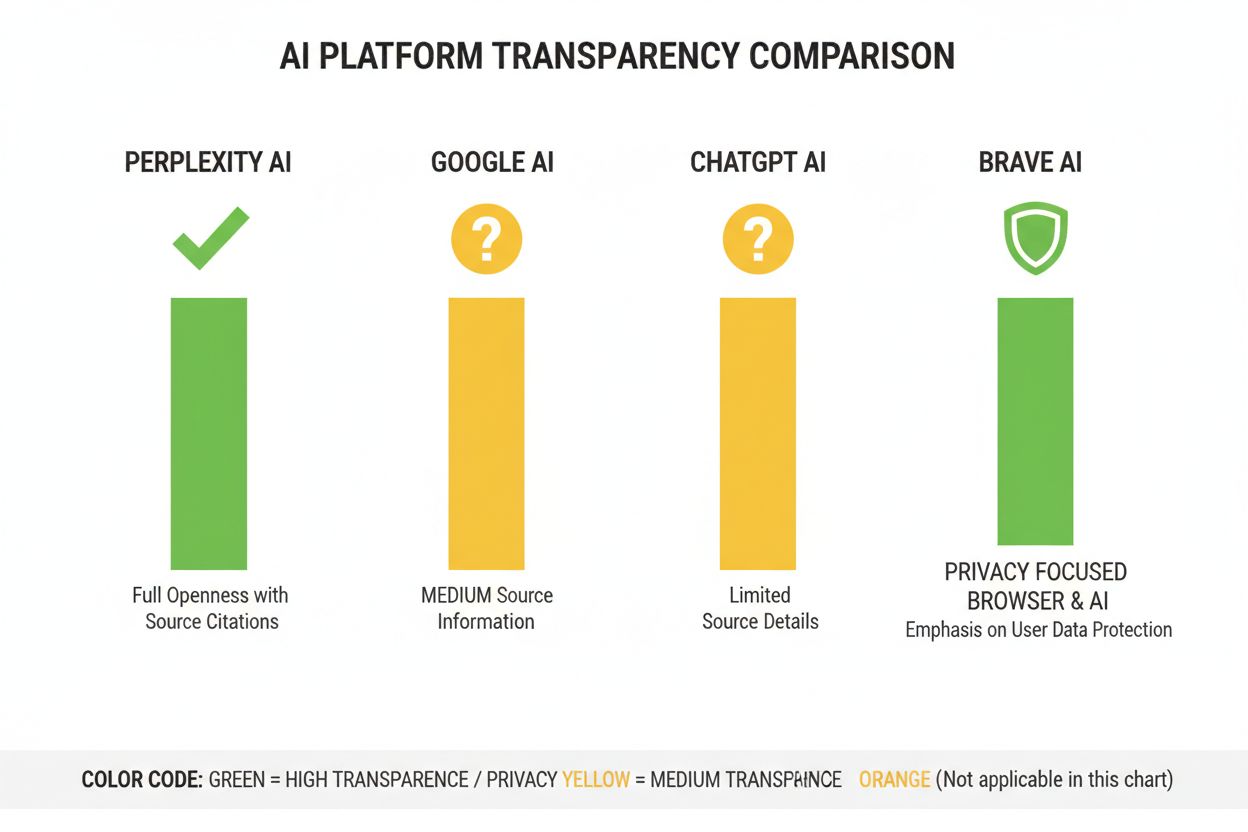

AI業界では、ランキングシステムの運用に関する標準的な開示慣行が確立されておらず、各プラットフォームが透明性のレベルを独自に決定しているのが現状です。OpenAIのChatGPT Searchは情報源選択の説明がほとんどなく、MetaのAIシステムのドキュメントも限定的です。GoogleのAI Overviewsは競合他社より開示が多いものの、重要なアルゴリズムの詳細は非公開です。プラットフォーム側は、競争優位性や企業秘密、機械学習システムの複雑さ等を理由に全面的な開示を避けていますが、この不透明さが外部からの監査や説明責任を妨げています。さらに、AIがコンテンツの「出自」を曖昧にする**「ソースロンダリング」問題**もあり、AIがまとめサイトや書き換え元を引用することで、本来の情報源が見えにくくなり、誤情報が重層的に拡散するリスクもあります。規制の圧力も高まっており、EU AI法は高リスクAIシステムにトレーニングデータや意思決定プロセスの記録を求め、NTIA AI説明責任政策もAIシステムの能力・限界・適切な用途の開示を求めています。具体的な開示の失敗例としては、Perplexityが当初は情報源の帰属が不十分だった点(その後改善)、GoogleのAI Overviewsが情報源選択の説明が曖昧な点、ChatGPTがなぜ特定の情報源が回答に現れるかをほとんど説明しない点などが挙げられます。透明性を測定する標準指標の不在は、ユーザーや規制当局が客観的にプラットフォームを比較することを困難にしています。

AIランキングの不透明さは、コンテンツ制作者の可視性に大きな課題をもたらします。従来の検索エンジン向けSEO戦略はAI最適化には直結せず、なぜ自社コンテンツがAI回答に採用されたりされなかったりするのかを把握できず、AI回答での可視性向上のための戦略を立てることが非常に困難です。AIシステムが主要メディアや学術機関、大規模サイトなど特定の情報源を**偏って引用する「引用バイアス」**が生まれ、小規模出版社や独立系クリエイター、ニッチな専門家の情報が埋もれがちです。特に小規模出版社は、AIランキングがドメインオーソリティを重視する傾向が強いため、被リンクや認知度の少ない新興サイトほど不利になります。Search Engine Landの調査では、AI Overviews導入で従来の検索結果へのクリック率がクエリ種類によって18~64%減少し、AI回答で引用されたごく一部の情報源にトラフィックが集中したと報告されています。**SEO(検索エンジン最適化)とGEO(生成エンジン最適化)**の違いが重要となりつつあり、SEOは従来の検索順位向上を指しますが、GEOはAIプラットフォームの情報源選択基準を理解・最適化する必要があり、その基準は依然として不透明です。コンテンツ制作者は、AmICited.comのようなツールでAI回答に自社コンテンツがどこで登場しているか、引用頻度、各AIプラットフォームでの可視性などをモニタリングする必要性が高まっています。

AI業界では、システムの挙動を文書化・開示するための複数のフレームワークが開発されていますが、各プラットフォームでの採用状況はまだ一貫していません。モデルカードは機械学習モデルの性能、利用用途、制限、バイアス分析などを標準化して記載し、AIシステムの「成分表示ラベル」のような役割を果たします。Datasheets for Datasetsは、トレーニングデータの構成や収集方法、潜在的なバイアスを記録し、「AIはその訓練データの質次第」という原則に対応します。システムカードはさらに広範な観点から、各コンポーネントの相互作用、失敗モード、ユーザーグループごとの実運用時の挙動などシステム全体を文書化します。NTIA AI説明責任政策は、特に公共福祉に影響を与える高リスク用途において、AIシステムの開発・テスト・運用の詳細な文書化を推奨しています。EU AI法も高リスクAIシステムに技術文書・トレーニングデータ記録・性能ログの維持、透明性レポートやユーザー通知の義務付けを行っています。業界のベストプラクティスには以下が含まれます:

Perplexityは、インラインで情報源リンクを表示し、各主張がどの情報源に基づくのかを明示することで、最も引用に透明性のあるAIプラットフォームとして位置づけられています。情報源の権威性・専門性・新しさを重視したランキング手法も比較的明確にドキュメント化されていますが、要素の正確な重み付けは企業秘密です。GoogleのAI Overviewsは、回答末尾に引用元をリストアップする中程度の透明性を提供していますが、なぜ特定の情報源が選ばれたかやランキングアルゴリズムの重み付けの説明は限定的です。GoogleのドキュメントはE-E-A-T原則を強調していますが、それがAIランキングでどのように測定・重視されているかは完全には公開していません。OpenAIのChatGPT Searchは、回答テキストと分離して情報源を表示し、元情報源へのリンクを提供する中間的なアプローチですが、情報源選択やランキング手法の説明はほとんどありません。Brave Leoはプライバシー重視型の透明性を採用し、プライバシーを尊重した情報源を使いユーザーのクエリ追跡をしない点を開示していますが、ランキングメカニズムの詳細な説明は控えめです。Consensusは学術研究に特化し、引用数や査読状況、研究の質指標を明示することで、アルゴリズム的にも最も透明性が高い研究用途向けプラットフォームとなっています。ユーザーの操作性も大きく異なり、Perplexityは情報源フィルタが可能、Consensusは研究種別や質でのフィルタリングができる一方、GoogleやChatGPTはランキング設定のカスタマイズ性がほぼありません。透明性アプローチの違いはビジネスモデルやターゲット層の違いを反映しており、学術系は開示重視、一般消費者向けは企業秘密と透明性のバランスを図っています。

信頼と信用は、ユーザーがどのように情報にアクセスしているかを理解できることに根本的に依存しています。AIシステムが情報源やランキングロジックを隠蔽すると、ユーザーは主張を独自に検証したり、情報源の信頼性を評価したりできません。透明性は検証・ファクトチェックを可能にし、研究者やジャーナリスト、リテラシーの高いユーザーが主張を元情報源まで遡って正確性や文脈を評価できるようにします。誤情報やバイアス防止の観点でも、ランキングアルゴリズムが可視化されていれば、特定の政治的観点や商業的利害を優遇するようなシステム的バイアスを特定でき、プラットフォーム側の説明責任も明確になります。アルゴリズム責任は民主主義社会における基本的権利であり、情報環境を形作るシステムがどのように意思決定しているか、特にそのシステムが世論や購買、知識のアクセスに影響する場合に知る権利があります。研究・学術面でも、AI生成サマリーの情報源選択を把握しないと、偏った・不完全な情報源セットに無自覚に依存するリスクが生じます。ビジネス上も、ランキング要素を理解できなければコンテンツ戦略を最適化できず、小規模クリエイターは大手媒体と公平に競争できず、エコシステム全体の実力主義性が損なわれます。また、透明性がなければ悪意ある第三者が不明な脆弱性を突いて誤情報を拡散できる一方、透明なシステムは監査と改善が可能です。

規制動向としては、EU AI法が2025~2026年に施行されることにより、高リスクAIシステムに対して詳細な文書化・開示が義務付けられ、イギリスやカリフォルニアなどでも同様の規制が進みつつあります。業界としても、透明性慣行の標準化が進展しており、Partnership on AIや学術機関がAIシステム行動の文書化・開示フレームワークを開発中です。ユーザーの透明性要求も高まっており、AIが情報流通に果たす役割への関心の高まりとともに、70%以上のユーザーがAIがどのように情報源を選び情報をランク付けしているか知りたいと考えています。説明可能AI(XAI)の技術革新により、LIMEやSHAPなどの手法を使って、企業秘密を完全に開示せずともランキング判断の詳細な説明を提供することが可能になりつつあります。AmICited.comのようなモニタリングツールも、各AIプラットフォームが透明性措置を導入する中で、コンテンツ制作者や出版社が自社の可視性やランキング変動の影響を追跡するためにますます重要になります。規制要件、ユーザー期待、技術的可能性が収束することから、2025~2026年はAIランキングの透明性にとって転換期となり、プラットフォームはより標準化された開示慣行や情報源選択のユーザー操作性、ランキングロジックの明確な説明を採用していくと見込まれます。今後は、学術・研究向けプラットフォームが高い開示水準をリードし、消費者向けプラットフォームは中程度の透明性とユーザーカスタマイズ性を提供、業界全体で規制対応がベースラインとなる「階層型透明性」の時代になると予想されます。

AIランキングの透明性とは、AIプラットフォームが回答生成時に情報源を選択・ランク付けするアルゴリズムをどれだけ公開しているかを指します。ユーザーが情報源の信頼性を理解し、コンテンツ制作者がAIでの可視性を最適化し、研究者が情報源を検証するために重要です。透明性がなければ、AIシステムは誤情報を拡散し、大手媒体が小規模出版社よりも不当に有利になる可能性があります。

AIプラットフォームは、言語モデルとリアルタイム情報検索を組み合わせたRAG(Retrieval-Augmented Generation)システムを使用します。情報源はドメインオーソリティ、コンテンツの新しさ、トピックの関連性、エンゲージメント指標、引用頻度などの要素でランク付けされます。ただし、これら要素の具体的な重み付けは多くのプラットフォームで非公開です。

従来のSEOはGoogleなどの検索エンジンでのリンクリストの順位付けに焦点を当て、Googleは一般的なランキング要素を公開しています。AIランキングの透明性は、AIプラットフォームが合成回答のためにどの情報源を選ぶかに関するもので、基準が異なり多くが非公開です。SEO戦略は明確に文書化されていますが、AIランキング要素はほとんど不透明です。

元の情報源にアクセスして主張の文脈を確認し、オーソリティのあるドメインかどうかを見極め、(特に学術系で)査読の有無を確認し、複数の情報源でクロスチェックしましょう。AmICitedのようなツールを使えば、AI回答にどの情報源がどれくらい頻繁に登場するか追跡できます。

Consensusは査読付き学術研究に限定して明確な引用指標を重視することで透明性をリードしています。Perplexityはインラインで情報源を明示し、ランキング要素の説明も一定程度あります。Google AI Overviewsは中程度の透明性、ChatGPT SearchやBrave Leoはランキングアルゴリズムの説明が限定的です。

モデルカードはAIシステムの性能、利用目的、制限、バイアス分析を標準化して文書化したものです。データシートはトレーニングデータの構成や収集方法、潜在的なバイアスを記録します。システムカードはシステム全体の挙動を記述します。これらは食品の成分表示のようにAIシステムの透明性と比較性を高めます。

EU AI法は高リスクAIシステムに対して、技術文書やトレーニングデータの記録、性能ログの維持を求めています。透明性レポートやユーザーへのAI利用通知も義務付けており、AIプラットフォームがランキングの仕組みや情報源選択基準をより開示する方向に進んでいます。

AmICited.comは、Perplexity、Google AI Overviews、ChatGPTなどのAIシステムがブランドやコンテンツをどのように引用しているかを追跡するAI引用モニタリングプラットフォームです。AI回答に登場する情報源や引用頻度、各AIプラットフォームでのランキング透明性の比較などを可視化します。

Perplexity、Google AI Overviews、ChatGPTなどのAIプラットフォームがあなたのコンテンツをどのように引用しているかを追跡できます。AIランキングの透明性を理解し、AmICitedでAI検索エンジン全体の可視性を最適化しましょう。

AI可視性モニタリングの未来を、透明性基準から規制遵守まで探ります。ブランドがAI主導の情報環境に備え、AI可視性戦略を早期に導入することで競争優位を獲得する方法を学びましょう。...

ChatGPT、Perplexity、Google AI Overviews などのAI生成回答で、コンテンツの可視性を維持・向上させるための実践的な戦略をご紹介。AIによる引用・発見性の最適化方法を学びましょう。...

プロアクティブな監視、早期警告システム、戦略的な対応プロトコルでAI可視性危機を防ぐ方法をご紹介。AI時代のブランドを守りましょう。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.