AIエンジンが情報源の信頼性を評価する際の要素とは

ChatGPT、Perplexity、Google AIなどのAIエンジンが、どのように情報源の信頼性を評価しているかを解説します。E-E-A-T、ドメインオーソリティ、引用頻度、その他AIが生成する回答で引用される情報源を決定する重要な信頼性シグナルについて学びましょう。...

著者の資格、引用、検証に基づくコンテンツの信頼性をAIが評価します。情報源の信頼性評価は、著者の専門性、出版社の評判、引用パターン、ファクトチェックの結果など複数の側面を体系的に分析し、情報源が研究、ナレッジベース、AI生成要約に含める価値があるかどうかを判断します。この自動化プロセスにより、プラットフォームは何百万もの情報源の信頼性評価を一貫して拡大でき、人間のレビュアーだけでは到達できない一貫性を保てます。

著者の資格、引用、検証に基づくコンテンツの信頼性をAIが評価します。情報源の信頼性評価は、著者の専門性、出版社の評判、引用パターン、ファクトチェックの結果など複数の側面を体系的に分析し、情報源が研究、ナレッジベース、AI生成要約に含める価値があるかどうかを判断します。この自動化プロセスにより、プラットフォームは何百万もの情報源の信頼性評価を一貫して拡大でき、人間のレビュアーだけでは到達できない一貫性を保てます。

情報源の信頼性評価とは、情報源が信頼できるか、正確であるか、権威があるかを体系的に評価することです。AI活用システムの文脈では、信頼性評価は情報源の複数の側面を分析し、その内容が研究や引用、ナレッジベースに含める価値があるか判断します。AIによる信頼性評価は、著者の資格(学歴、職歴、専門性)や引用パターン(他の権威ある情報源からどれだけ頻繁かつ好意的に引用されているか)を調べることから始まります。プロセスでは、査読状況や所属機関、出版媒体の評判などの検証メカニズムも評価し、基本的な信頼性を確立します。信頼性シグナルは、著者の資格のような明示的な指標からテキスト分析やメタデータパターンに基づく暗黙的なシグナルまで、AIが検出・評価する測定可能な指標です。現代のAIは、信頼性が多次元的であることを認識しており、ある分野では高い信頼性を持つ情報源でも、別分野では権威がない場合があるため、文脈認識型の評価が必要です。情報量の爆発や偽情報の急速な拡散が進む中、この評価プロセスの重要性が増しています。自動化された信頼性評価は、何百万人もの情報源を一貫して評価でき、人間だけでは実現できない規模と一貫性をもたらします。こうした仕組みを理解することで、コンテンツ制作者や研究者、出版社は自らの情報源が信頼性として認識されやすく最適化でき、消費者は情報の信頼性を判断しやすくなります。

AIシステムは、高度なマルチシグナル分析(自然言語処理、機械学習モデル、構造化データ評価の組み合わせ)により情報源の信頼性を評価します。信頼性シグナル検出では、テキスト、メタデータ、ネットワークパターンに現れる信頼性と相関する指標を特定し、正確性の予測力に基づいて重み付けします。NLP分析は、言語パターンや引用密度、主張の具体性、言語的確信度を精査し、内容が厳密な研究か、信頼性の低い特徴を持つかを判定します。機械学習モデルは、信頼できる/できない情報源の大規模データセットで学習し、人間では見逃しがちな複雑なパターンを認識し、大規模かつリアルタイム評価を可能にします。ファクトチェック統合は、主張を信頼できるデータベースや事実と照合し、矛盾や裏付けのない主張があれば信頼性スコアを下げます。これらはアンサンブル手法(複数の評価アプローチの統合)を活用し、単一のシグナルに依存しない多面的な評価を実現します。下表は、AIが分析する主なシグナルカテゴリです:

| シグナル種類 | 測定内容 | 例 |

|---|---|---|

| 学術的シグナル | 査読状況、出版媒体、所属機関 | ジャーナルインパクトファクター、学会ランキング、大学の評判 |

| テキスト的シグナル | 文章の質、引用密度、主張の具体性、言語パターン | 適切な引用、専門用語、根拠に基づく主張 |

| メタデータシグナル | 著者の資格、公開日、更新頻度、情報源履歴 | 学位、公開タイムライン、改訂履歴 |

| 社会的シグナル | 引用数、拡散パターン、専門家の推薦、コミュニティでの議論 | Google Scholar引用、学術ネットワークでの言及、ピアの推薦 |

| 検証シグナル | ファクトチェック結果、主張の裏付け、情報源の透明性 | Snopes検証、複数の独立した裏付け、手法の開示 |

| 構造的シグナル | コンテンツ構成、手法の明確さ、利益相反の開示 | 明確なセクション、透明な方法論、資金源の透明性 |

AIが評価する最も影響力のある信頼性要因は、情報源の信頼性を総合的に構築する多様な次元で構成されます。著者の評判は基礎的な信頼性指標であり、分野の実績ある専門家は無名の寄稿者より大きな重みを持ちます。出版社の評判は、査読付きジャーナルや確立された学術出版社であるかなど、組織的な信頼性も加味します。引用パターンは、広い学術コミュニティがどれだけその情報源を評価しているかを示し、著名な場で高頻度に引用されていれば研究の質の裏付けとなります。新しさは文脈によって重要であり、最新の知識は新しい出版物に、基礎的知識は過去の影響力のある論文に見られます。バイアス検出アルゴリズムは、利益相反や資金源、思想的立場の開示があるかを見ます。エンゲージメントシグナル(学術・専門コミュニティからの引用や議論)は、外部からの信頼性裏付けとなります。AIが重視する主要要因は以下の通りです:

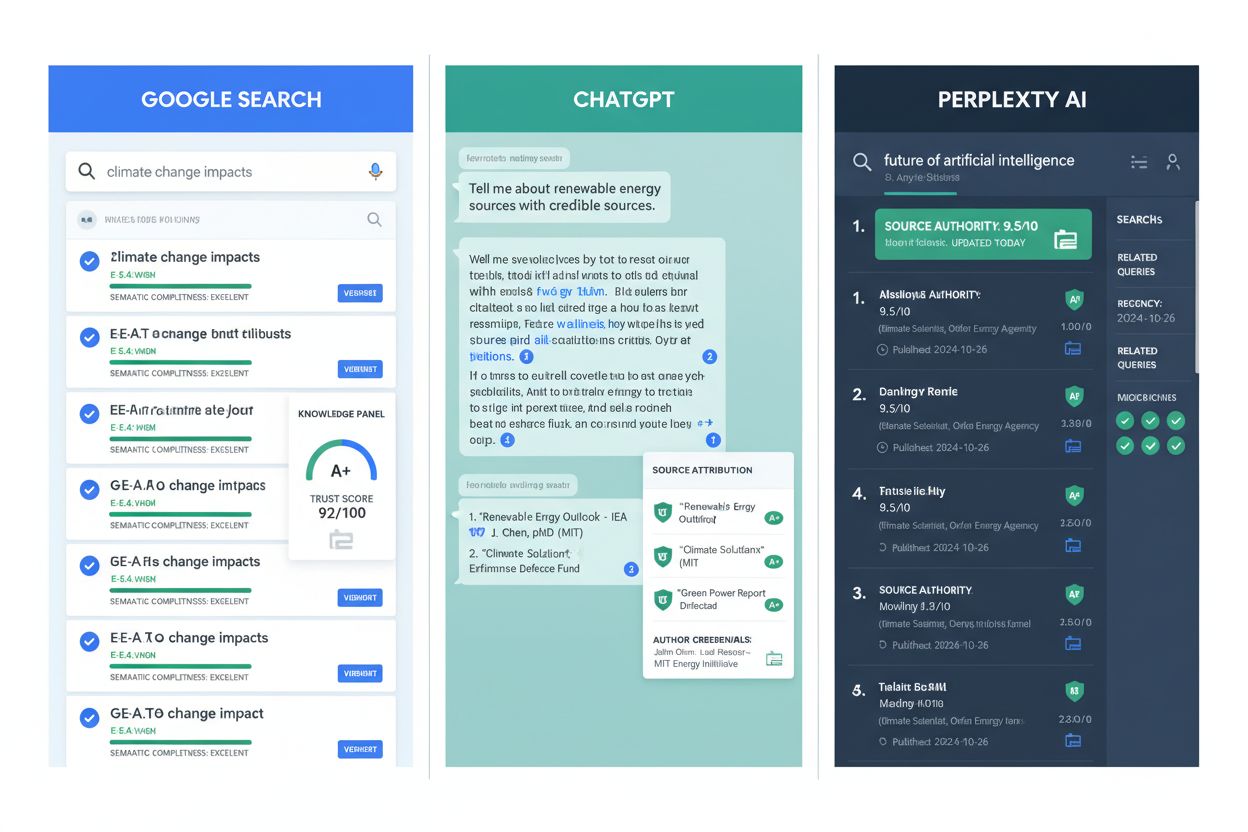

AIによる信頼性評価は、主要な情報プラットフォームや研究インフラに不可欠となっています。Google AI Overviewsは、確立された出版社や認定専門家の情報源をAI生成要約に優先採用するため、信頼性シグナルを活用しています。ChatGPTや類似言語モデルは、トレーニング時に信頼性評価を行い、適切に情報源を重み付けしますが、未知の主張のリアルタイム評価には課題があります。Perplexity AIは、情報源の信頼性を引用方式に明示的に組み込み、検索結果とともに情報源の評判を表示し、ユーザーが情報の質を判断しやすくしています。学術研究の現場では、信頼性評価ツールによって高品質な情報源の特定が効率化され、文献調査の時間短縮と研究基盤の質向上に寄与しています。コンテンツ保存事業では、権威ある情報源のアーカイブを優先し、将来的な研究者が信頼できる歴史情報にアクセスできるようにしています。AmICited.comは、情報源が各プラットフォームでどのように引用・評価されているかを追跡し、出版社が自らの信頼性や改善点を把握できるよう支援します。ファクトチェック組織は、自動信頼性評価を活用して人手による検証対象を優先順位付けし、重要な偽情報への対応効率を高めています。教育機関でも、信頼性評価ツールを使い、情報源評価の隠れた基準を明示化・計測可能にして学生指導に役立てています。これらの応用例は、信頼性評価が理論的枠組みからデジタル情報品質を支える実用インフラへと進化したことを示しています。

大きな進歩がある一方で、自動化された信頼性評価には人間による監督や文脈的判断が不可欠な限界もあります。エンゲージメントシグナルのバイアスは根本的な課題であり、人気がある情報源が不正確でも社会的シグナルで高評価となる場合があります。誤検出や見逃しも起こり、特に新興分野の専門家は引用履歴が少なく、逆に偽情報の発信者が巧妙な信頼性シグナルを作り出すケースもあります。進化する偽情報戦術は、正当な情報源を装うために偽の著者資格や引用を作り出し、自動評価を欺きます。分野ごとの信頼性差もあり、ある分野で信頼される情報源が他分野では権威を持たない場合もありますが、システムは一律のスコアを適用しがちです。時間的ダイナミクスも複雑で、発表当初は信頼された情報源でも新証拠の登場で陳腐化・否定されることがあり、継続的な再評価が必要です。文化的・言語的バイアスも問題で、英語圏以外やマイノリティコミュニティの情報源は過小評価されがちです。透明性の課題もあり、多くの信頼性評価アルゴリズムがブラックボックス的に動作するため、情報源が改善方法を理解できず、ユーザーも評価理由を把握しにくい状況があります。これらの限界から、自動評価は人間の批判的評価を補完する存在であるべきであることがわかります。

コンテンツ制作者や出版社は、AIによる信頼性評価の仕組みに沿った実証的な手法を実践することで、信頼性シグナルを大きく向上できます。E-E-A-T原則の実装(経験・専門性・権威性・信頼性の明示)は、著者の資格や所属、関連する実績を明確に表示することで実現します。適切な引用方法は、高品質な情報源へのリンク、一貫した書誌情報形式、すべての主張に検証可能な根拠を添えることで信頼性を高めます。方法論の透明性も重要で、データソースや研究方法、制約、利益相反について明確に説明すれば、AIは厳密な研究姿勢を認識できます。著者プロフィールを詳細な経歴や出版履歴、資格などとともに維持することで、AIが検証・評価しやすくなります。定期的なコンテンツ更新は、正確性への継続的な取り組みを示し、古い情報はスコアを下げますが、更新・修正があれば最新性をアピールできます。資金源や所属の開示はバイアスの透明化となり、隠された利益相反よりも開示されたものの方が問題視されにくいとAIは認識します。引用権威の構築は、権威ある媒体での出版や査読、他の信頼性ある情報源からの引用獲得によって、信頼性の好循環を生み出します。専門コミュニティとの交流(学会、共同研究、ピアとの議論)は、専門性の裏付けやAIによる可視性向上に役立ちます。構造化データマークアップ(schema.org等)は、AIが著者情報や公開日、その他の信頼性シグナルを自動抽出・検証できるようにするため効果的です。

情報源の信頼性評価は今後、マルチモーダル評価(テキスト・画像・動画・音声の総合分析)を取り入れ、単一メディア分析では見抜けない巧妙な偽情報も検出できるよう進化します。リアルタイム検証システムは、コンテンツ作成時に即座に信頼性フィードバックを提供し、発信前に軌道修正できるようになります。ブロックチェーンによる信頼性追跡は、情報源の履歴や引用・修正の記録を不変化し、AIが高い透明性で評価できる仕組みを提供します。パーソナライズド信頼性評価は、一律の評価から脱却し、ユーザーの専門性や目的に合わせた文脈評価へと進化します。ナレッジグラフとの統合により、AIは情報源を孤立的にではなく、関連情報のネットワーク内で評価し、既存知識と矛盾するものや重要なギャップを埋めるものを特定できます。説明可能なAI信頼性システムが標準となり、なぜそのスコアとなったのかを透明に説明し、制作者の改善やユーザーの納得感を高めます。継続学習システムは、新たな偽情報戦術の出現にリアルタイムで適応し、固定データに頼らない柔軟な評価を実現します。クロスプラットフォーム信頼性追跡により、情報源の統一された信頼性プロフィールがウェブ全体で維持され、悪質な発信者がプラットフォームごとに別人格を装うことが困難になります。こうした発展により、信頼性評価はさらに高度化し、透明性と統合性を備えた情報インフラの中核となっていきます。

情報源の信頼性評価とは、情報源がどれだけ信頼できるか、正確であるかを体系的に評価することです。AIシステムは著者の資格、出版社の評判、引用パターン、ファクトチェックの結果など複数の視点から分析し、情報源が研究、ナレッジベース、AI生成の要約に含める価値があるかどうか判断します。この自動化プロセスにより、プラットフォームは何百万もの情報源を一貫して評価できます。

AIシステムは自然言語処理、機械学習モデル、構造化データの分析を通じて信頼性シグナルを検出します。学術的シグナル(査読状況、所属機関)、テキスト的シグナル(引用密度、主張の具体性)、メタデータシグナル(著者の資格、公開日)、社会的シグナル(引用数、専門家の推薦)、検証シグナル(ファクトチェック結果、主張の裏付け)などを調べます。これらのシグナルは正確性の予測価値に応じて重み付けされます。

最も重要な信頼性要因には、著者の評判と専門性、出版社の評判、引用数とその質、新しさやタイムリーさ、バイアスや利益相反の開示、専門コミュニティからのエンゲージメントシグナル、ファクトチェックによる情報源の検証、既存知識との統合、著者が権威ある機関に所属していること、更新頻度などがあります。これらの要素が総合的に情報源の信頼性・信用性を築きます。

出版社はE-E-A-T原則(経験、専門性、権威性、信頼性)を実践し、適切な引用方法の利用、透明な方法論の公開、詳細な著者プロフィールと資格の表示、定期的なコンテンツ更新、資金源や所属の開示、査読による引用権威の構築、専門コミュニティとの交流、AIシステムが信頼性情報を抽出しやすい構造化データマークアップの実装などで信頼性を高められます。

自動化された信頼性評価には、エンゲージメントシグナルのバイアス(人気情報源が不正確でも高スコアになる)、誤検出や見逃し、正当な情報源を装う進化する偽情報戦術、分野ごとの信頼性の違い、情報源の陳腐化など時間的要因、トレーニングデータにおける文化的・言語的バイアス、ブラックボックス的なアルゴリズムによる透明性の課題などがあります。こうした限界から、自動評価は人間による批判的評価を補完する役割であるべきです。

Google AI Overviewsは、確立された出版社や認定専門家の情報源をAI要約に優先しています。ChatGPTはトレーニング時に信頼性シグナルに基づき情報源を重み付けします。Perplexityは検索結果横に情報源の評判を明示表示します。AmICited.comはすべての主要AIプラットフォームでの引用状況をモニタリングし、出版社が自らの信頼性や改善点を把握できるよう支援します。

今後は、テキスト・画像・動画・音声を総合的に評価するマルチモーダル評価、即時の信頼性フィードバックを行うリアルタイム検証システム、ブロックチェーンによる信頼性追跡、ユーザーの専門性に合わせたパーソナライズ評価、ナレッジグラフとの統合、根拠を説明するAI、進化する偽情報戦術に適応する継続学習、クロスプラットフォームでの信頼性追跡による統一プロフィールの実現などが進むでしょう。

情報源の信頼性評価は、AI要約やAIのトレーニングデータ、何十億人もの目に触れる情報の質を決定するため不可欠です。正確な信頼性評価は、偽情報の拡散を防ぎ、AIが信頼できる情報を提供し、学術研究の質を支え、AI搭載情報システムへの信頼を維持します。AIが情報発見でますます影響力を持つ中、信頼性評価の重要性も増しています。

Google AI Overviews、ChatGPT、Perplexity、Geminiであなたの情報源がどのように引用・評価されているかを追跡します。AmICited.comは、あなたの信頼性の現状を理解し、改善の機会を見つけるのに役立ちます。

ChatGPT、Perplexity、Google AIなどのAIエンジンが、どのように情報源の信頼性を評価しているかを解説します。E-E-A-T、ドメインオーソリティ、引用頻度、その他AIが生成する回答で引用される情報源を決定する重要な信頼性シグナルについて学びましょう。...

AIエンジンが最も頻繁に引用する情報源を解説。ChatGPT、Google AI Overviews、Perplexityが情報源の信頼性をどう評価し、各業界での引用パターンがAIでの可視性最適化にどう役立つかを学びましょう。...

AI検索での可視性における信頼性アピールについてのコミュニティディスカッション。AIシステムが認識・評価する信頼シグナルについて、コンテンツチームの実体験を紹介。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.