Hoe onjuiste informatie in AI-antwoorden betwisten en corrigeren

Leer hoe u onjuiste AI-informatie betwist, fouten rapporteert aan ChatGPT en Perplexity en strategieën implementeert om te zorgen dat uw merk accuraat wordt wee...

AI-misinformatiecorrectie verwijst naar strategieën en tools voor het identificeren en aanpakken van onjuiste merkinformatie die verschijnt in AI-gegenereerde antwoorden van systemen zoals ChatGPT, Gemini en Perplexity. Het omvat het monitoren van hoe AI-systemen merken weergeven en het doorvoeren van bronaanpassingen om te zorgen dat juiste informatie wordt verspreid over betrouwbare platforms. In tegenstelling tot traditionele factchecking richt het zich op het corrigeren van de bronnen die AI-systemen vertrouwen, in plaats van de AI-uitvoer zelf. Dit is essentieel voor het behouden van merkreputatie en nauwkeurigheid in een door AI gedreven zoekomgeving.

AI-misinformatiecorrectie verwijst naar strategieën en tools voor het identificeren en aanpakken van onjuiste merkinformatie die verschijnt in AI-gegenereerde antwoorden van systemen zoals ChatGPT, Gemini en Perplexity. Het omvat het monitoren van hoe AI-systemen merken weergeven en het doorvoeren van bronaanpassingen om te zorgen dat juiste informatie wordt verspreid over betrouwbare platforms. In tegenstelling tot traditionele factchecking richt het zich op het corrigeren van de bronnen die AI-systemen vertrouwen, in plaats van de AI-uitvoer zelf. Dit is essentieel voor het behouden van merkreputatie en nauwkeurigheid in een door AI gedreven zoekomgeving.

AI-misinformatiecorrectie verwijst naar de strategieën, processen en tools die worden gebruikt om onjuiste, verouderde of misleidende informatie over merken te identificeren en aan te pakken die verschijnt in AI-gegenereerde antwoorden van systemen zoals ChatGPT, Gemini en Perplexity. Recent onderzoek toont aan dat ongeveer 45% van de AI-vragen foutieve antwoorden oplevert, waardoor merkaccuratesse in AI-systemen een cruciaal aandachtspunt is voor bedrijven. In tegenstelling tot traditionele zoekresultaten waar merken hun eigen vermeldingen kunnen beheren, synthetiseren AI-systemen informatie uit meerdere bronnen op het web, waardoor er een complex landschap ontstaat waarin misinformatie stilletjes kan blijven bestaan. De uitdaging is niet alleen het corrigeren van individuele AI-antwoorden—het gaat erom te begrijpen waarom AI-systemen merkinformatie verkeerd hebben en systematische correcties te implementeren op bron-niveau.

AI-systemen verzinnen merkinformatie niet uit het niets; ze stellen deze samen uit wat er al op internet bestaat. Dit proces creëert echter verschillende voorspelbare fouten waardoor merken verkeerd worden weergegeven:

| Oorzaak | Hoe gebeurt het | Zakelijk effect |

|---|---|---|

| Bron-inconsistentie | Merk wordt verschillend beschreven op websites, gidsen en artikelen | AI leidt verkeerde consensus af uit tegenstrijdige informatie |

| Verouderde autoritatieve bronnen | Oude Wikipedia-pagina’s, gidsvermeldingen of vergelijkingspagina’s bevatten foutieve data | Nieuwere correcties worden genegeerd omdat oudere bronnen sterkere autoriteitssignalen hebben |

| Entiteitsverwarring | Soortgelijke merknamen of overlappende categorieën verwarren AI-systemen | Concurrenten krijgen erkenning voor uw capaciteiten of merk wordt geheel weggelaten |

| Ontbrekende primaire signalen | Gebrek aan gestructureerde data, duidelijke Over-ons-pagina’s of consistente terminologie | AI moet informatie afleiden, wat leidt tot vage of onjuiste omschrijvingen |

Wanneer een merk verschillend wordt beschreven over platforms heen, hebben AI-systemen moeite te bepalen welke versie gezaghebbend is. In plaats van om opheldering te vragen, leiden ze consensus af op basis van frequentie en waargenomen autoriteit—zelfs als die consensus fout is. Kleine verschillen in merknamen, omschrijvingen of positionering worden vaak gedupliceerd over platforms heen, en na herhaling worden deze fragmenten signalen die AI-modellen als betrouwbaar behandelen. Het probleem wordt erger wanneer verouderde maar gezaghebbende pagina’s foutieve informatie bevatten; AI-systemen geven vaak de voorkeur aan deze oudere bronnen boven nieuwere correcties, vooral als die correcties zich nog niet breed hebben verspreid over betrouwbare platforms.

Foutieve merkinformatie corrigeren in AI-systemen vereist een fundamenteel andere aanpak dan traditionele SEO-opruiming. Bij traditionele SEO werken merken hun eigen vermeldingen bij, corrigeren ze NAP-gegevens (Naam, Adres, Telefoon) en optimaliseren ze on-page content. AI-merkcorrectie richt zich op het veranderen van wat betrouwbare bronnen over uw merk zeggen, niet op het controleren van uw eigen zichtbaarheid. U corrigeert AI niet direct—u corrigeert wat AI vertrouwt. Proberen AI-antwoorden te “corrigeren” door foutieve beweringen te blijven herhalen (zelfs om ze te ontkennen) kan een averechts effect hebben door juist de associatie te versterken die u wilt verwijderen. AI-systemen herkennen patronen, geen intentie. Dit betekent dat elke correctie op bron-niveau moet beginnen, terugwerkend vanaf waar AI-systemen daadwerkelijk informatie leren.

Voordat u foutieve merkinformatie kunt corrigeren, heeft u inzicht nodig in hoe AI-systemen uw merk momenteel beschrijven. Effectieve monitoring richt zich op:

Handmatige controles zijn onbetrouwbaar omdat AI-antwoorden variëren per prompt, context en updatecyclus. Gestructureerde monitoringtools bieden het inzicht dat nodig is om fouten vroegtijdig op te sporen, voordat ze zich vastzetten in AI-systemen. Veel merken beseffen pas dat ze verkeerd worden weergegeven in AI als een klant het meldt of er een crisis ontstaat. Proactieve monitoring voorkomt dit door inconsistenties te onderscheppen voordat ze zich verspreiden.

Zodra u foutieve merkinformatie heeft geïdentificeerd, moet de correctie plaatsvinden waar AI-systemen daadwerkelijk van leren—niet waar de fout alleen zichtbaar is. Effectieve bron-niveau correcties zijn onder meer:

Het belangrijkste principe is: correcties werken alleen als ze op bron-niveau worden toegepast. Veranderen wat er in AI-uitvoer verschijnt zonder de onderliggende bronnen te herstellen is hooguit tijdelijk. AI-systemen her-evalueren continu signalen naarmate nieuwe content verschijnt en oudere pagina’s opnieuw opduiken. Een correctie die de oorspronkelijke bron niet aanpakt, zal uiteindelijk worden overschreven door de originele misinformatie.

Bij het corrigeren van foutieve merkinformatie over gidsen, marktplaatsen of AI-gevoede platforms vereisen de meeste systemen verificatie die het merk koppelt aan legitiem eigendom en gebruik. Veelgevraagde documentatie omvat:

Het doel is geen hoeveelheid—maar consistentie. Platforms beoordelen of documentatie, vermeldingen en publiekelijk zichtbare merkdata overeenkomen. Deze materialen vooraf organiseren verkort afkeurcycli en versnelt goedkeuring bij grootschalige correcties. Consistentie over bronnen heen signaleert aan AI-systemen dat uw merkinformatie betrouwbaar en gezaghebbend is.

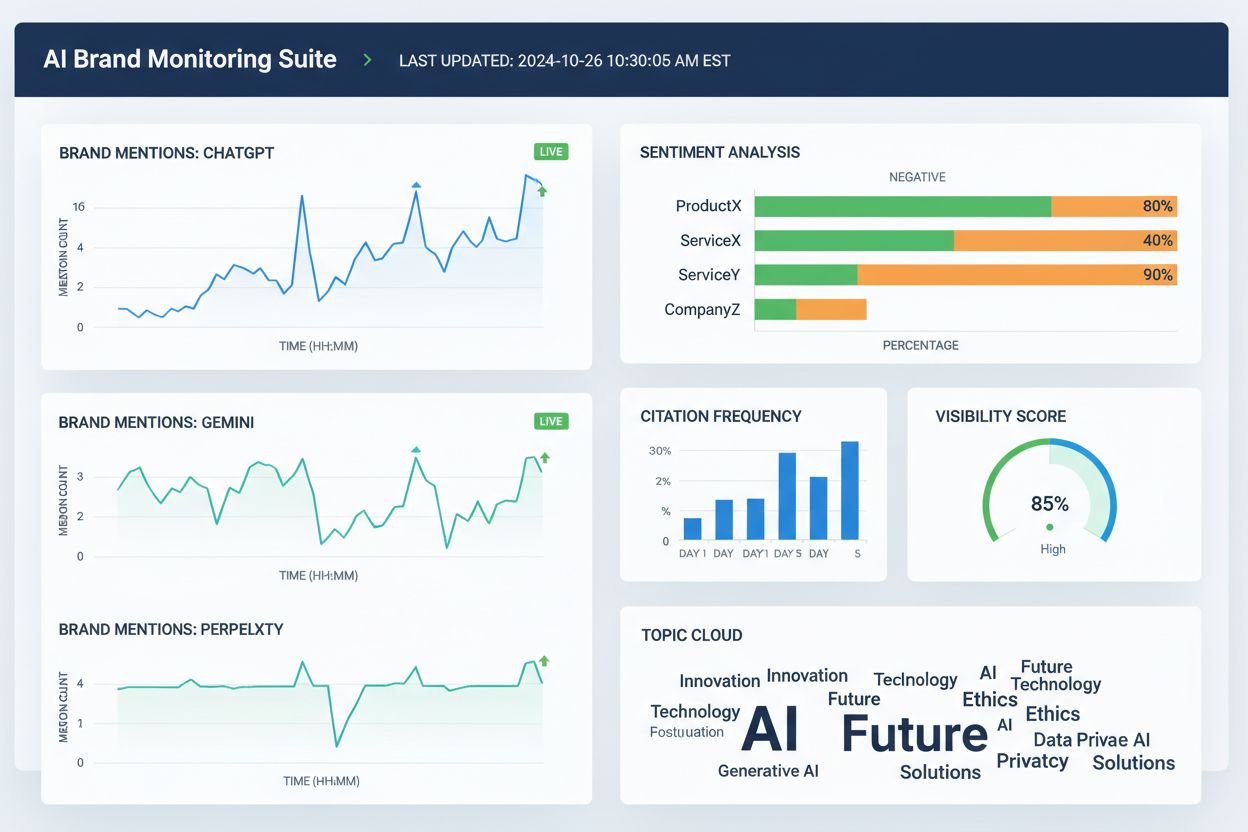

Er zijn diverse tools die teams helpen merkweergave over AI-zoekplatforms en het bredere web te volgen. Hoewel de mogelijkheden overlappen, richten ze zich doorgaans op zichtbaarheid, toeschrijving en consistentie:

Deze tools corrigeren foutieve merkinformatie niet direct. Ze helpen teams juist fouten vroeg te detecteren, merkdatadiscrepanties te signaleren voordat ze zich verspreiden, te valideren of broncorrecties de AI-nauwkeurigheid verbeteren, en langetermijntrends in AI-toeschrijving en zichtbaarheid te monitoren. In combinatie met broncorrecties en documentatie bieden monitoringtools de feedbackloop die nodig is om onjuiste merkinformatie duurzaam te herstellen.

AI-zoeknauwkeurigheid verbetert wanneer merken duidelijk gedefinieerde entiteiten zijn, niet vage spelers binnen een categorie. Om merkvervorming in AI-systemen te verminderen, richt u zich op:

Het doel is niet om meer te zeggen—maar om overal hetzelfde te zeggen. Wanneer AI-systemen consistente merkdefinities tegenkomen over gezaghebbende bronnen heen, stoppen ze met raden en beginnen ze de juiste informatie te herhalen. Deze stap is vooral belangrijk voor merken die worden geconfronteerd met foutieve vermeldingen, toeschrijving aan concurrenten, of weglating uit relevante AI-antwoorden. Zelfs na het herstellen van foutieve merkinformatie is nauwkeurigheid niet blijvend. AI-systemen evalueren signalen voortdurend opnieuw, wat continue helderheid essentieel maakt.

Er is geen vaste tijdlijn voor het corrigeren van merkvervorming in AI-systemen. AI-modellen updaten op basis van signaalsterkte en consensus, niet op indieningsdata. Typische patronen zijn:

Vroege vooruitgang is zelden zichtbaar als een plotseling “gerepareerd” antwoord. Let in plaats daarvan op indirecte signalen: minder variatie in AI-antwoorden, minder tegenstrijdige omschrijvingen, consistentere citaties over bronnen heen, en geleidelijke opname van uw merk waar het eerst ontbrak. Stilstand ziet er anders uit—als dezelfde foutieve formulering blijft terugkomen ondanks meerdere correcties, betekent dit meestal dat de oorspronkelijke bron niet is hersteld of dat elders sterkere versterking nodig is.

De meest betrouwbare manier om foutieve merkinformatie te herstellen is het verminderen van de omstandigheden waarin deze kan ontstaan. Effectieve preventie omvat:

Merken die AI-zichtbaarheid behandelen als een levend systeem—en niet als een eenmalig opschoningsproject—herstellen sneller van fouten en ervaren minder herhaalde merkvervorming. Preventie draait niet om het controleren van AI-uitvoer. Het draait om het aanhouden van schone, consistente input die AI-systemen met vertrouwen kunnen herhalen. Naarmate AI-zoekopdrachten zich blijven ontwikkelen, zijn de merken die slagen degenen die misinformatiecorrectie zien als een continu proces dat voortdurende monitoring, bronbeheer en strategische versterking van juiste informatie over betrouwbare platforms vereist.

AI-misinformatiecorrectie is het proces van het identificeren en herstellen van onjuiste, verouderde of misleidende informatie over merken die verschijnt in AI-gegenereerde antwoorden. In tegenstelling tot traditionele factchecking richt het zich op het corrigeren van de bronnen die AI-systemen vertrouwen (gidsen, artikelen, vermeldingen) in plaats van direct de AI-uitvoer te bewerken. Het doel is ervoor te zorgen dat gebruikers die AI-systemen naar uw merk vragen, juiste informatie ontvangen.

AI-systemen zoals ChatGPT, Gemini en Perplexity beïnvloeden nu hoe miljoenen mensen kennis maken met merken. Onderzoek toont aan dat 45% van de AI-vragen fouten oplevert, en onjuiste merkinformatie kan reputatieschade veroorzaken, klanten verwarren en tot verlies van omzet leiden. In tegenstelling tot traditionele zoekresultaten waar merken hun eigen vermeldingen beheren, synthetiseren AI-systemen informatie uit meerdere bronnen, waardoor merkaccuratesse moeilijker te beheersen maar des te belangrijker is.

Nee, directe correctie werkt niet effectief. AI-systemen slaan merkinformatie niet op in bewerkbare locaties—ze maken antwoorden op basis van externe bronnen. AI herhaaldelijk vragen om informatie te 'corrigeren' kan zelfs hallucinaties versterken door juist de associatie te versterken die u wilt verwijderen. Correcties moeten daarom plaatsvinden op bron-niveau: door gidsen te updaten, verouderde vermeldingen te corrigeren en juiste informatie te publiceren op vertrouwde platforms.

Er is geen vaste tijdlijn omdat AI-systemen updaten op basis van signaalsterkte en consensus, niet op indieningsdata. Kleine feitelijke correcties verschijnen meestal binnen 2-4 weken, entiteit-niveau verduidelijkingen duren 1-3 maanden, en concurrentieverdringing kan 3-6 maanden of langer duren. Vooruitgang toont zich zelden als een plotseling 'gerepareerd' antwoord—let op minder variatie in antwoorden en consistentere citaties over bronnen heen.

Er zijn diverse tools die merkweergave over AI-platforms monitoren: Wellows volgt vermeldingen en sentiment over ChatGPT, Gemini en Perplexity; Profound vergelijkt zichtbaarheid over LLM's; Otterly.ai analyseert merksentiment in AI-antwoorden; BrandBeacon biedt positioneringsanalyses; Ahrefs Brand Radar volgt webvermeldingen; en AmICited.com is gespecialiseerd in het monitoren van hoe merken geciteerd en weergegeven worden over AI-systemen. Deze tools helpen fouten vroegtijdig te detecteren en te valideren of correcties werken.

AI-hallucinaties ontstaan wanneer AI-systemen informatie genereren die niet gebaseerd is op trainingsdata of verkeerd wordt gedecodeerd. AI-misinformatie is valse of misleidende informatie die verschijnt in AI-uitvoer, wat kan voortkomen uit hallucinaties, maar ook uit verouderde bronnen, entiteitsverwarring of inconsistente data over platforms heen. Misinformatiecorrectie pakt zowel hallucinaties als bron-niveau onnauwkeurigheden aan die leiden tot onjuiste merkweergave.

Monitor hoe AI-systemen uw merk beschrijven door ze vragen te stellen over uw bedrijf, producten en positionering. Let op verouderde informatie, onjuiste omschrijvingen, ontbrekende details of toeschrijving aan concurrenten. Gebruik monitoringtools om vermeldingen over ChatGPT, Gemini en Perplexity te volgen. Controleer of uw merk ontbreekt in relevante AI-antwoorden. Vergelijk AI-beschrijvingen met uw officiële merkinfo om afwijkingen te signaleren.

Het is een doorlopend proces. AI-systemen her-evalueren continu signalen naarmate nieuwe content verschijnt en oudere pagina's opnieuw opduiken. Een eenmalige correctie zonder voortdurende monitoring wordt uiteindelijk overschreven door de originele misinformatie. Merken die succesvol zijn, behandelen AI-zichtbaarheid als een levend systeem: consistente merkdefinities aanhouden over bronnen, gidsen regelmatig controleren en AI-vermeldingen continu monitoren om nieuwe fouten te onderscheppen voordat ze zich verspreiden.

Volg hoe AI-systemen zoals ChatGPT, Gemini en Perplexity uw merk weergeven. Krijg realtime inzicht in merkvermeldingen, citaties en zichtbaarheid over AI-platforms met AmICited.com.

Leer hoe u onjuiste AI-informatie betwist, fouten rapporteert aan ChatGPT en Perplexity en strategieën implementeert om te zorgen dat uw merk accuraat wordt wee...

Leer hoe je AI-desinformatie over jouw merk herkent, voorkomt en corrigeert. Ontdek 7 bewezen strategieën en tools om je reputatie te beschermen in AI-zoekresul...

Leer effectieve strategieën om onjuiste informatie over jouw merk te identificeren, monitoren en corrigeren in AI-gegenereerde antwoorden van ChatGPT, Perplexit...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.