Fine-Tuning

Fine-tuning definitie: het aanpassen van vooraf getrainde AI-modellen voor specifieke taken via domeinspecifieke training. Ontdek hoe fine-tuning modelprestatie...

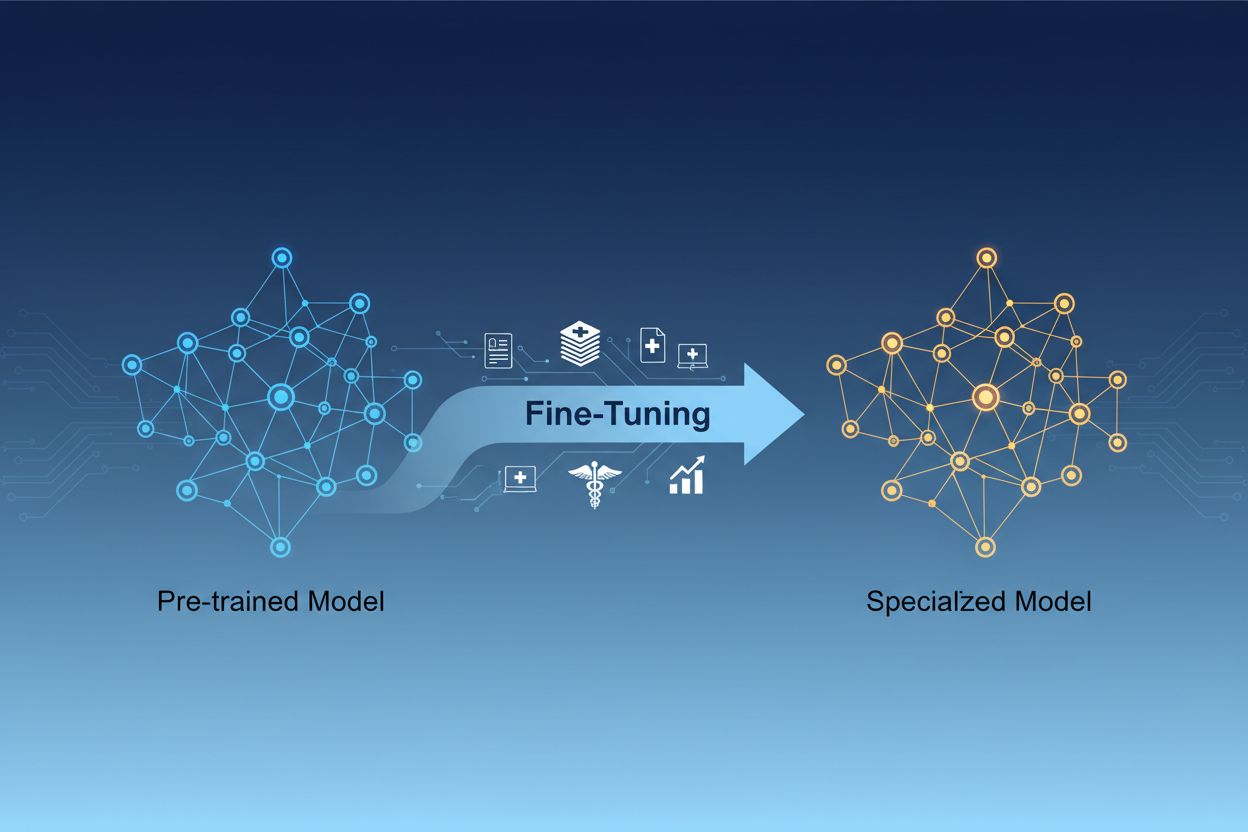

AI-model-finetuning is het proces waarbij vooraf getrainde modellen voor kunstmatige intelligentie worden aangepast om specifieke taken uit te voeren of te werken met gespecialiseerde data, door hun parameters bij te stellen via extra training op domeinspecifieke datasets. Deze aanpak benut bestaande fundamentele kennis en maakt het mogelijk modellen te personaliseren voor specifieke zakelijke toepassingen, waardoor organisaties zeer gespecialiseerde AI-systemen kunnen creëren zonder de hoge rekenkosten van volledige training vanaf nul.

AI-model-finetuning is het proces waarbij vooraf getrainde modellen voor kunstmatige intelligentie worden aangepast om specifieke taken uit te voeren of te werken met gespecialiseerde data, door hun parameters bij te stellen via extra training op domeinspecifieke datasets. Deze aanpak benut bestaande fundamentele kennis en maakt het mogelijk modellen te personaliseren voor specifieke zakelijke toepassingen, waardoor organisaties zeer gespecialiseerde AI-systemen kunnen creëren zonder de hoge rekenkosten van volledige training vanaf nul.

AI-model-finetuning is het proces waarbij een vooraf getraind model voor kunstmatige intelligentie wordt aangepast om specifieke taken uit te voeren of te werken met gespecialiseerde data. In plaats van een model helemaal vanaf nul te trainen, benut finetuning de basiskennis die al in een vooraf getraind model zit en worden de parameters bijgesteld via extra training op domeinspecifieke of taakgerichte datasets. Deze aanpak combineert de efficiëntie van transfer learning met de maatwerkbenadering die nodig is voor specifieke zakelijke toepassingen. Met finetuning kunnen organisaties zeer gespecialiseerde AI-modellen creëren zonder de hoge rekenkosten en tijdsinvestering die training vanaf nul met zich meebrengt, waardoor het een essentiële techniek is in moderne machine learning-ontwikkeling.

Het onderscheid tussen finetuning en training vanaf nul behoort tot de belangrijkste beslissingen bij machine learning-ontwikkeling. Wanneer je een model vanaf nul traint, begin je met willekeurig geïnitialiseerde gewichten en moet je het model alles leren over taalpatronen, visuele kenmerken of domeinspecifieke kennis aan de hand van enorme datasets en veel rekenkracht. Deze aanpak kan weken tot maanden trainingstijd vergen en vereist vaak speciale hardware zoals GPU’s of TPU’s. Finetuning daarentegen begint met een model dat al fundamentele patronen en concepten begrijpt, en heeft slechts een fractie van de data en rekenkracht nodig om het aan te passen aan jouw specifieke behoeften. Het vooraf getrainde model heeft tijdens de initiële trainingsfase al algemene kenmerken geleerd, dus finetuning richt zich op het bijstellen van deze kenmerken voor jouw specifieke toepassing. Deze efficiëntiewinst maakt finetuning de voorkeursaanpak voor de meeste organisaties, omdat het zowel de time-to-market als de infrastructuurkosten verlaagt en vaak betere prestaties biedt dan kleinere modellen die vanaf nul zijn getraind.

| Aspect | Finetuning | Training vanaf nul |

|---|---|---|

| Trainingstijd | Dagen tot weken | Weken tot maanden |

| Data-eisen | Duizenden tot miljoenen voorbeelden | Miljoenen tot miljarden voorbeelden |

| Rekenkosten | Gemiddeld (vaak voldoende aan één GPU) | Zeer hoog (meerdere GPU’s/TPU’s vereist) |

| Initiële kennis | Benut vooraf getrainde gewichten | Start met willekeurige initiatie |

| Prestaties | Vaak superieur met beperkte data | Beter met enorme datasets |

| Vereiste expertise | Gemiddeld | Geavanceerd |

| Maatwerk | Hoog voor specifieke taken | Maximale flexibiliteit |

| Infrastructuur | Standaard cloud resources | Gespecialiseerde hardwareclusters |

Finetuning is een essentiële vaardigheid geworden voor organisaties die AI-oplossingen willen inzetten die concurrentievoordeel opleveren. Door vooraf getrainde modellen aan te passen aan jouw specifieke bedrijfscontext kun je AI-systemen creëren die jouw brancheterminologie, klantvoorkeuren en operationele eisen met grote nauwkeurigheid begrijpen. Dit maatwerk zorgt ervoor dat bedrijven prestaties kunnen behalen die generieke, kant-en-klare modellen simpelweg niet halen, vooral bij gespecialiseerde domeinen zoals gezondheidszorg, juridische diensten of technische support. Door de kostenefficiëntie van finetuning kunnen zelfs kleinere organisaties nu over AI-capaciteiten op ondernemingsniveau beschikken zonder enorme infrastructuurinvesteringen. Bovendien zijn gefinetunede modellen sneller inzetbaar, waardoor bedrijven snel kunnen inspelen op marktkansen en concurrentiedruk. De mogelijkheid om modellen voortdurend te verbeteren door ze te finetunen op nieuwe data zorgt ervoor dat je AI-systemen relevant en effectief blijven naarmate de bedrijfsomstandigheden veranderen.

Belangrijkste zakelijke voordelen van finetuning:

Er zijn verschillende beproefde technieken ontstaan als best practice op het gebied van finetuning, elk met unieke voordelen afhankelijk van je specifieke vereisten. Volledige finetuning betekent dat je alle parameters van het vooraf getrainde model bijwerkt, wat maximale flexibiliteit en vaak de beste prestaties biedt, maar veel rekenkracht en grotere datasets vereist om overfitting te voorkomen. Parameter-efficiënte finetuning-methoden zoals LoRA (Low-Rank Adaptation) en QLoRA hebben het veld veranderd door effectieve modelaanpassing mogelijk te maken terwijl slechts een klein deel van de parameters wordt bijgewerkt, waardoor het geheugenverbruik en de trainingstijd drastisch dalen. Deze technieken voegen trainbare low-rank-matrices toe aan de gewichtsmatrices van het model en vangen taakgerichte aanpassingen op zonder de originele gewichten te wijzigen. Adaptermodules zijn een andere aanpak, waarbij kleine trainbare netwerken worden toegevoegd tussen de lagen van het bevroren vooraf getrainde model, waardoor efficiënte finetuning mogelijk is met minimale extra parameters. Prompt-based finetuning richt zich op het optimaliseren van inputprompts in plaats van modelgewichten, wat nuttig is bij modellen waar parametertoegang beperkt is. Instruction finetuning traint modellen om specifieke instructies en commando’s op te volgen, vooral belangrijk voor grote taalmodellen die adequaat moeten reageren op uiteenlopende gebruikersvragen. De keuze tussen deze technieken hangt af van je rekenbeperkingen, datasetgrootte, prestatie-eisen en het specifieke modelarchitectuur waarmee je werkt.

Het finetunen van grote taalmodellen (LLM’s) biedt unieke kansen en uitdagingen vergeleken met kleinere modellen of andere neurale netwerken. Moderne LLM’s zoals GPT-achtige modellen bevatten miljarden parameters, waardoor volledige finetuning voor de meeste organisaties onhaalbaar is qua rekenkracht. Dit heeft geleid tot de brede inzet van parameter-efficiënte technieken, zodat LLM’s effectief aangepast kunnen worden zonder dat daar een infrastructuur op ondernemingsniveau voor nodig is. Instruction finetuning is bijzonder belangrijk voor LLM’s, waarbij modellen worden getraind op voorbeelden van instructies met hoogwaardige antwoorden, zodat ze gebruikersopdrachten beter opvolgen. Reinforcement Learning from Human Feedback (RLHF) is een geavanceerde finetuningaanpak waarbij modellen verder worden verbeterd op basis van menselijke voorkeuren en beoordelingen, zodat ze beter aansluiten bij menselijke waarden en verwachtingen. De relatief kleine hoeveelheid taakgerichte data die nodig is om LLM’s te finetunen—vaak slechts honderden of duizenden voorbeelden—maakt deze aanpak toegankelijk voor organisaties zonder enorme gelabelde datasets. Wel vereist het finetunen van LLM’s zorgvuldige aandacht voor hyperparameterselectie, leerrate-schema’s en het voorkomen van catastrofale vergeten, waarbij het model eerder geleerde vaardigheden kwijtraakt bij het aanpassen aan nieuwe taken.

Organisaties in allerlei sectoren ontdekken krachtige toepassingen van gefinetunede AI-modellen die meetbare zakelijke waarde opleveren. Klantenservice-automatisering is een van de meest voorkomende use cases, waarbij modellen worden gefinetuned op bedrijfsspecifieke supporttickets, productinformatie en communicatiestijlen om chatbots te creëren die klantvragen afhandelen met domeinkennis en merkconsistentie. Analyse van medische en juridische documenten maakt gebruik van finetuning om algemene taalmodellen aan te passen voor het begrijpen van gespecialiseerde terminologie, regelgeving en branchegerichte formats, waardoor accurate informatie-extractie en classificatie mogelijk wordt. Sentimentanalyse en moderatie van inhoud kunnen sterk worden verbeterd door modellen te finetunen op voorbeelden uit jouw specifieke sector of community, zodat ze genuanceerde taalpatronen en context oppikken die generieke modellen missen. Codegeneratie en software-ondersteuning profiteren van finetuning op de eigen codebase van je organisatie, programmeerconventies en architectuurpatronen, zodat AI-tools code genereren die aansluit bij jouw standaarden. Aanbevelingssystemen worden vaak gefinetuned op gebruikersgedrag en productcatalogi, zodat ze gepersonaliseerde suggesties bieden die zorgen voor meer engagement en omzet. Named entity recognition en informatie-extractie uit domeinspecifieke documenten—zoals financiële rapporten, wetenschappelijke publicaties of technische specificaties—kunnen aanzienlijk worden verbeterd door finetuning op relevante voorbeelden. Deze uiteenlopende toepassingen tonen aan dat finetuning niet is beperkt tot één sector of use case, maar een fundamentele vaardigheid is voor AI-systemen die concurrentievoordeel bieden in vrijwel elk zakelijk domein.

Het finetuning-proces volgt een gestructureerde workflow die begint met zorgvuldige voorbereiding en doorloopt tot aan implementatie en monitoring. Datavoorbereiding is de eerste cruciale stap, waarbij je jouw domeinspecifieke dataset verzamelt, opschoont en formatteert zodat deze aansluit bij de input-outputstructuur van het vooraf getrainde model. Deze dataset moet representatief zijn voor de taken die jouw gefinetunede model in productie zal uitvoeren, en kwaliteit is belangrijker dan kwantiteit—een kleinere dataset met hoogwaardige voorbeelden presteert doorgaans beter dan een grotere set met inconsistente of ruisgevoelige labels. Train-validatie-test-splitsing zorgt ervoor dat je de modelprestaties goed kunt evalueren, met doorgaans 70-80% voor training, 10-15% voor validatie en 10-15% voor testen. Hyperparameterselectie omvat het kiezen van leerrates, batchgroottes, aantal trainingsrondes en andere parameters die het finetuning-proces sturen; deze keuzes beïnvloeden zowel de prestaties als de trainingsefficiëntie aanzienlijk. Modelinitialisatie gebruikt de vooraf getrainde gewichten als uitgangspunt, zodat de fundamentele kennis behouden blijft terwijl de parameters zich aanpassen aan jouw specifieke taak. Trainingsexecutie betekent het iteratief bijwerken van modelparameters op je trainingsdata, terwijl je de validatieprestaties monitort om overfitting te detecteren. Evaluatie en iteratie gebruikt je testset om de uiteindelijke prestaties te beoordelen en te bepalen of extra finetuning, andere hyperparameters of meer trainingsdata het resultaat verbeteren. Implementatievoorbereiding omvat het optimaliseren van het model voor inferentiesnelheid en efficiënt gebruik van resources, eventueel via quantization of distillatie. Tot slot zorgt monitoring en onderhoud in productie ervoor dat het model goed blijft presteren als datastromen in de tijd veranderen, door periodiek opnieuw te trainen op nieuwe data om de nauwkeurigheid te behouden.

Finetuning is weliswaar efficiënter dan training vanaf nul, maar kent zijn eigen uitdagingen die zorgvuldig moeten worden gemanaged. Overfitting treedt op wanneer modellen trainingsdata uit het hoofd leren in plaats van generaliseerbare patronen te vinden, een verhoogd risico bij kleine datasets; dit kun je beperken met technieken als early stopping, regularisatie en data-augmentatie. Catastrofaal vergeten ontstaat wanneer finetuning ertoe leidt dat modellen eerder verworven vaardigheden verliezen, vooral lastig bij het aanpassen van algemene modellen aan gespecialiseerde taken; een zorgvuldige keuze van leerrate en technieken als knowledge distillation helpen om basiskennis te behouden. Datakwaliteit en labeling vormen belangrijke praktische uitdagingen, omdat finetuning hoogwaardige gelabelde voorbeelden vraagt die jouw doeldomein en use cases goed vertegenwoordigen. Beheer van rekenmiddelen vereist een balans tussen prestatieverbeteringen en trainingstijd en infrastructuurkosten, vooral van belang bij grote modellen. Hyperparametergevoeligheid betekent dat de prestaties van finetuning sterk kunnen variëren afhankelijk van leerrate, batchgrootte en andere instellingen, wat systematisch experimenteren en valideren noodzakelijk maakt.

Best practices voor succesvolle finetuning:

Organisaties staan vaak voor de keuze uit drie complementaire strategieën om AI-modellen aan te passen aan specifieke taken: finetuning, Retrieval-Augmented Generation (RAG) en prompt engineering. Prompt engineering betekent het zorgvuldig formuleren van instructies en voorbeelden om modelgedrag te sturen zonder het model zelf te wijzigen; deze aanpak is snel en vereist geen training, maar is beperkt effectief voor complexe taken en kan modellen geen echt nieuwe kennis bijbrengen. RAG breidt modelantwoorden uit door relevante documenten of data uit externe bronnen op te halen vóór het genereren van antwoorden, waardoor modellen toegang hebben tot actuele informatie en domeinkennis zonder parameterupdates; deze aanpak werkt goed bij kennisintensieve taken, maar voegt vertraging en complexiteit toe aan het gebruik. Finetuning past modelparameters aan om taakgerichte kennis en patronen diep te integreren, wat de beste prestaties oplevert voor goed gedefinieerde taken met voldoende trainingsdata, maar meer tijd en rekenkracht vraagt dan de andere methoden. De optimale oplossing combineert vaak deze technieken: prompt engineering voor snelle prototypes, RAG voor kennisintensieve toepassingen en finetuning voor prestatiekritische systemen waar de investering in training gerechtvaardigd is. Finetuning blinkt uit wanneer je consistente topprestaties op specifieke taken wilt, voldoende trainingsdata hebt en de prestatieverbetering de ontwikkelinspanning waard is. RAG werkt het beste voor toepassingen waarbij toegang tot actuele of bedrijfseigen informatie vereist is die vaak verandert. Prompt engineering is een uitstekend startpunt voor verkenning en prototyping voordat je investeert in meer resource-intensieve methoden. Door de sterke en zwakke punten van elke aanpak te begrijpen, kunnen organisaties weloverwogen beslissingen nemen over welke technieken het beste aansluiten bij verschillende onderdelen van hun AI-systemen.

Transfer learning is het bredere concept waarbij kennis van de ene taak wordt gebruikt om de prestaties op een andere taak te verbeteren, terwijl finetuning een specifieke implementatie van transfer learning is. Bij finetuning neem je een vooraf getraind model en pas je de parameters aan op nieuwe data, terwijl transfer learning ook feature extractie kan omvatten waarbij je de vooraf getrainde gewichten bevriest en alleen nieuwe lagen traint. Alle finetuning omvat transfer learning, maar niet alle transfer learning vereist finetuning.

De duur van finetuning varieert sterk afhankelijk van de grootte van het model, de dataset en de beschikbare hardware. Met parameter-efficiënte technieken zoals LoRA kan een model van 13 miljard parameters in ongeveer 5 uur worden gefinetuned op een enkele A100 GPU. Kleinere modellen of parameter-efficiënte methoden kunnen slechts enkele uren duren, terwijl volledige finetuning van grotere modellen dagen of weken kan kosten. Het belangrijkste voordeel is dat finetuning veel sneller is dan training vanaf nul, wat maanden kan duren.

Ja, finetuning is juist ontworpen om effectief te werken met beperkte data. Vooraf getrainde modellen hebben al algemene patronen geleerd, dus je hebt meestal slechts honderden tot duizenden voorbeelden nodig voor effectieve finetuning, vergeleken met miljoenen die nodig zijn bij training vanaf nul. De kwaliteit van de data is echter belangrijker dan de kwantiteit—een kleinere dataset met hoogwaardige, representatieve voorbeelden presteert beter dan een grotere dataset met inconsistente of ruisgevoelige labels.

LoRA (Low-Rank Adaptation) is een parameter-efficiënte finetuningtechniek waarbij trainbare low-rank-matrices worden toegevoegd aan de gewichtsmatrices van een model, in plaats van alle parameters bij te werken. Deze aanpak vermindert het aantal trainbare parameters met duizenden keren, terwijl de prestaties vergelijkbaar blijven met volledige finetuning. LoRA is belangrijk omdat het finetuning toegankelijk maakt op standaard hardware, het geheugenverbruik drastisch verlaagt en organisaties in staat stelt grote modellen te finetunen zonder dure infrastructuur.

Overfitting treedt op wanneer het trainingverlies daalt maar het validatieverlies stijgt, wat aangeeft dat het model trainingsdata uit het hoofd leert in plaats van generaliseerbare patronen. Monitor beide metingen tijdens de training—als de validatieprestaties stagneren of verslechteren terwijl de trainingsprestaties blijven verbeteren, is je model waarschijnlijk overfitted. Voer early stopping in om de training te stoppen wanneer de validatieprestaties niet meer verbeteren, en gebruik technieken zoals regularisatie en data-augmentatie om overfitting te voorkomen.

Kosten voor finetuning omvatten rekenmiddelen (GPU/TPU-tijd), datavoorbereiding en labeling, opslag van modellen en implementatie-infrastructuur, en voortdurende monitoring en onderhoud. Deze kosten zijn echter meestal 10-100 keer lager dan volledige training vanaf nul. Parameter-efficiënte technieken zoals LoRA kunnen de rekenkosten met 80-90% verminderen ten opzichte van volledige finetuning, waardoor finetuning een voordelige aanpak is voor de meeste organisaties.

Ja, finetuning verbetert doorgaans de nauwkeurigheid van modellen aanzienlijk voor specifieke taken. Door training op domeinspecifieke data leren modellen taakrelevante patronen en terminologie die generieke modellen missen. Uit studies blijkt dat finetuning de nauwkeurigheid met 10-30% of meer kan verbeteren, afhankelijk van de taak en de datakwaliteit. De verbetering is het grootst wanneer de finetuning-taak verschilt van de pre-trainingtaak, omdat het model zijn geleerde features aanpast aan jouw specifieke eisen.

Finetuning stelt organisaties in staat gevoelige data op hun eigen infrastructuur te houden in plaats van deze naar externe API's te sturen. Je kunt modellen lokaal finetunen op vertrouwelijke of gereguleerde data zonder deze bloot te stellen aan externe diensten, waardoor je voldoet aan regelgeving zoals GDPR, HIPAA of branchespecifieke eisen. Deze aanpak biedt zowel veiligheids- als compliancevoordelen, terwijl je profiteert van de prestaties van vooraf getrainde modellen.

Volg hoe AI-systemen zoals GPT's, Perplexity en Google AI Overviews jouw merk noemen en citeren met het AI-monitoringplatform van AmICited.

Fine-tuning definitie: het aanpassen van vooraf getrainde AI-modellen voor specifieke taken via domeinspecifieke training. Ontdek hoe fine-tuning modelprestatie...

Modelparameters zijn leerbare variabelen in AI-modellen die het gedrag bepalen. Begrijp gewichten, biases en hoe parameters invloed hebben op AI-modelprestaties...

Ontdek alles over training met synthetische data voor AI-modellen, hoe het werkt, voordelen voor machine learning, uitdagingen zoals modelcollaps en de gevolgen...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.