AI Visibility Index

Ontdek wat een AI Visibility Index is, hoe het citatiefrequentie, positie, sentiment en bereik combineert, en waarom het belangrijk is voor merkzichtbaarheid in...

Een organisatorische eenheid die zich richt op het monitoren, volgen en waarborgen van transparantie van AI-systemen binnen een organisatie. Het biedt realtime inzicht in de prestaties van AI-systemen, de nalevingsstatus en het risicoprofiel, en fungeert als centrale autoriteit voor AI-governance en toezicht.

Een organisatorische eenheid die zich richt op het monitoren, volgen en waarborgen van transparantie van AI-systemen binnen een organisatie. Het biedt realtime inzicht in de prestaties van AI-systemen, de nalevingsstatus en het risicoprofiel, en fungeert als centrale autoriteit voor AI-governance en toezicht.

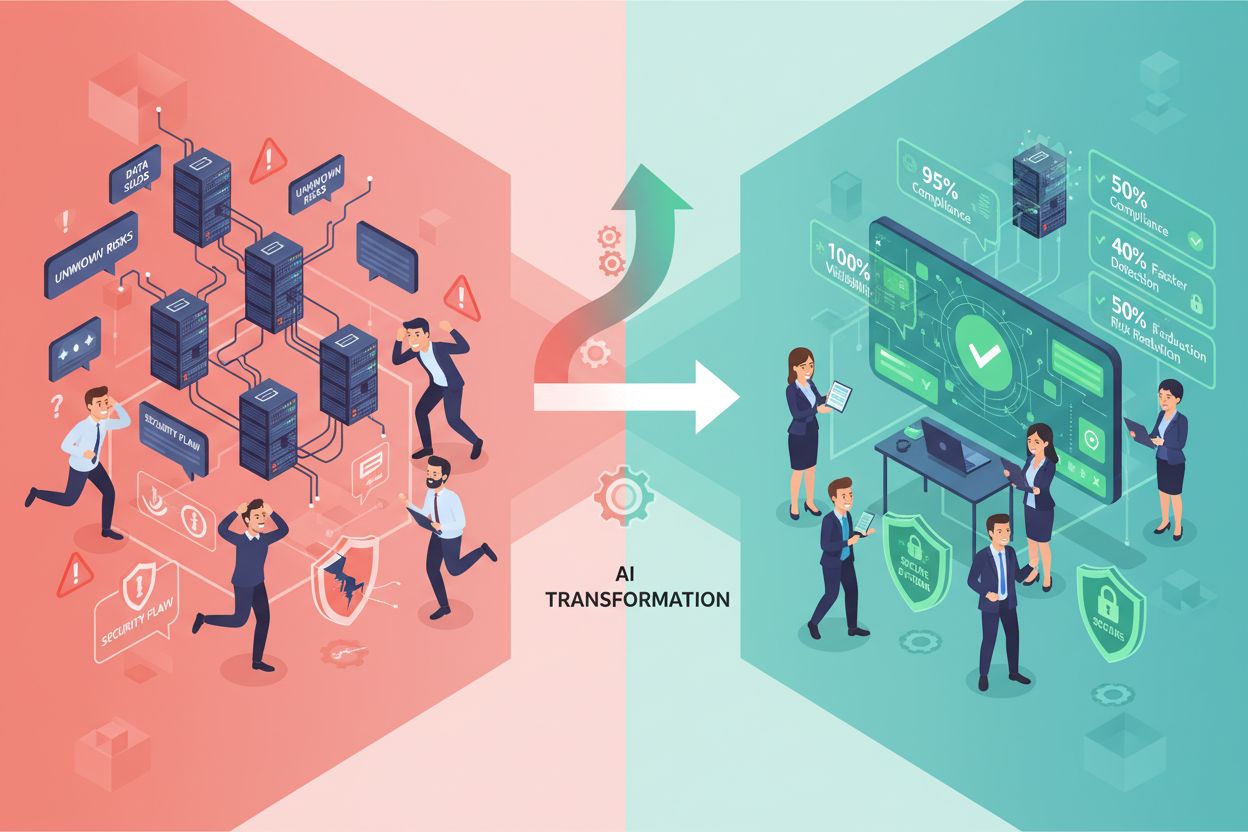

Een AI Visibility Center of Excellence (CoE) is een gespecialiseerde organisatorische eenheid die is opgericht om uitgebreide monitoring, tracking en transparantie te bieden van kunstmatige intelligentiesystemen die binnen een organisatie worden ingezet. Dit centrum fungeert als centrale autoriteit voor realtime inzicht in hoe AI-systemen werken, welke data ze verwerken en hoe ze bedrijfsresultaten en belangen van stakeholders beïnvloeden. Het primaire doel is het creëren van een enkele bron van waarheid voor de status van AI-systemen, prestatie-indicatoren en nalevingspositie binnen de hele organisatie. Door AI-zichtbaarheidsfuncties te consolideren stelt het centrum het leiderschap in staat het volledige bereik van AI-implementaties en de bijbehorende risico’s te begrijpen. Het AI Visibility CoE fungeert als een cruciale brug tussen technische AI-operaties en het bestuurlijk toezicht, zodat besluitvormers beschikken over accurate en tijdige informatie over het gedrag en de prestaties van AI-systemen.

Het AI Visibility Center of Excellence onderhoudt verschillende kernverantwoordelijkheden die essentieel zijn voor AI-governance op ondernemingsniveau. Hiertoe behoort het ontwikkelen en onderhouden van een uitgebreide AI-systeeminventaris waarin alle AI-toepassingen, modellen en systemen binnen de organisatie worden gecatalogiseerd. Het centrum is verantwoordelijk voor continue monitoring van AI-systeemprestaties, waaronder nauwkeurigheidsstatistieken, latentie, hulpbronnengebruik en outputkwaliteit. Nalevingstracking is een andere cruciale functie, die waarborgt dat AI-systemen voldoen aan wettelijke vereisten, interne beleidsregels en industriestandaarden. Het centrum voert doorlopende risicobeoordeling en -beheer uit, waarbij potentiële problemen zoals modeldrift, verslechtering van datakwaliteit, opkomst van bias en beveiligingskwetsbaarheden worden geïdentificeerd. Daarnaast produceert het AI Visibility CoE regelmatige rapportages en dashboards die de status van AI-systemen communiceren naar stakeholders op verschillende organisatieniveaus. Ook beheert het centrum de incidentrespons bij AI-gerelateerde problemen en houdt het documentatie bij van alle wijzigingen en updates aan AI-systemen.

| Functie | Traditioneel AI CoE | AI Visibility CoE |

|---|---|---|

| Focus | Modelontwikkeling en uitrol | Realtime monitoring en transparantie |

| Primaire Activiteit | Bouwen en trainen van AI-systemen | Volgen en observeren van AI-systeengedrag |

| Belangrijkste Maatstaf | Modelnauwkeurigheid en prestaties | Systeemzichtbaarheid, naleving en risico |

| Stakeholder Focus | Datascientists en engineers | Directie en compliance teams |

| Rapportagefrequentie | Projectmatig | Continu en realtime |

| Risicomanagement | Risicobeheersing in ontwikkelfase | Operationele en doorlopende risicomonitoring |

Het AI Visibility Center of Excellence biedt uitgebreide monitoring over meerdere dimensies van AI-systeemoperatie en -impact. Het centrum volgt belangrijke monitoringcategorieën, waaronder:

Deze monitoringmogelijkheden stellen de organisatie in staat om continu inzicht te houden in de gezondheid en het gedrag van AI-systemen binnen het volledige AI-portfolio.

Het AI Visibility Center of Excellence fungeert als een cruciaal onderdeel binnen het bredere AI-governance framework, als de operationele ogen en oren van de AI-strategie van de organisatie. Het centrum ondersteunt direct de functie AI Risicomanagement door realtime gegevens te leveren over potentiële risico’s, waardoor sneller opkomende problemen kunnen worden geïdentificeerd en aangepakt. Het integreert met compliance- en regelgevingsbeheer door ervoor te zorgen dat alle AI-systemen voldoen aan toepasselijke wetten, regelgeving en industriestandaarden, en door audittrails en documentatie te leveren die vereist zijn voor regelgevende controles. Het AI Visibility CoE ondersteunt ethische AI-initiatieven door te monitoren op bias, eerlijkheidskwesties en onbedoelde consequenties van AI-beslissingen. Het centrum werkt samen met de functie AI-strategie en planning om inzichten te bieden die beslissingen over AI-investeringen, systeemafbouw en portfoliobeheer ondersteunen. Door transparantie en zichtbaarheid te behouden stelt het AI Visibility CoE de organisatie in staat om verantwoord AI-beleid te implementeren en rekenschap af te leggen aan stakeholders, toezichthouders en het publiek.

Het AI Visibility Center of Excellence maakt gebruik van gespecialiseerde technologische platforms en tools om uitgebreide monitoring en transparantie te realiseren. AI-monitoringsplatformen zoals Datadog, New Relic en gespecialiseerde AI-observeeroplossingen bieden realtime dashboards en waarschuwingsmogelijkheden voor AI-systeemprestaties. Audit logging en data lineage tools volgen datastromen, modelinvoer en -uitvoer, en toegangsprofielen om nalevingsdocumentatie bij te houden en forensische analyse mogelijk te maken. Analytics- en business intelligence-platformen bundelen monitoringdata en vertalen deze naar bruikbare inzichten voor verschillende doelgroepen. Modelmonitoringsoplossingen die specifiek zijn ontworpen voor machine learning-systemen detecteren prestatievermindering, datadrift en problemen met voorspeldingskwaliteit. Beveiligings- en toegangscontrolesystemen beheren wie toegang heeft tot AI-systemen en hun uitkomsten, met gedetailleerde logging van alle interacties. Governance- en risicomanagementplatformen bieden centrale opslag voor AI-systeemdocumentatie, risicoanalyses en nalevingsbewijzen. De technologiestack moet naadloos integreren met bestaande bedrijfsvoering, terwijl het de gespecialiseerde mogelijkheden biedt die nodig zijn voor AI-specifieke monitoring en zichtbaarheid.

Het AI Visibility Center of Excellence bestaat meestal uit een multidisciplinair team met gespecialiseerde rollen en verantwoordelijkheden. De AI Visibility Lead of Center Director biedt strategisch toezicht, beheert stakeholdersrelaties en zorgt voor afstemming met governance-doelstellingen van de organisatie. AI Monitoring Specialisten ontwerpen en implementeren monitoringssystemen, configureren dashboards en onderhouden de technische infrastructuur voor AI-zichtbaarheid. Compliance Analisten zien toe op naleving van regelgeving, houden auditdocumentatie bij en coördineren met compliance- en juridische teams. Security Analisten richten zich op het detecteren en reageren op beveiligingsdreigingen, onbevoegde toegang en mogelijke datalekken met betrekking tot AI-systemen. Data Engineers beheren datapijplijnen, waarborgen datakwaliteit voor monitoringssystemen en onderhouden de technische infrastructuur voor dataverzameling en analyse. Business Analisten vertalen technische monitoringdata naar bedrijfskritische inzichten en rapportages voor het management. De teamgrootte en rolverdeling zijn afhankelijk van het AI-volwassenheidsniveau van de organisatie, het aantal AI-systemen en de complexiteit van de regelgevende omgeving.

Het opzetten van een AI Visibility Center of Excellence levert aanzienlijke tastbare en strategische voordelen op voor de organisatie. Het centrum biedt meetbare waarde door:

Deze voordelen zorgen samen voor een significante return on investment en strategische waarde voor de organisatie.

Het opzetten van een AI Visibility Center of Excellence vereist zorgvuldige planning en gefaseerde implementatie. Organisaties beginnen met een verkenningsfase om bestaande AI-systemen te inventariseren, huidige monitoringmogelijkheden te beoordelen en tekortkomingen in zichtbaarheid en governance te identificeren. De planningsfase omvat het definiëren van de opdracht van het centrum, het identificeren van benodigde rollen en vaardigheden, het selecteren van technologische platforms en het vaststellen van succesindicatoren. Resourcebehoeften bestaan doorgaans uit toegewijde medewerkers (5-15 personen afhankelijk van de organisatiegrootte), investeringen in monitoringplatformen en -tools, en voortdurende training en ontwikkeling. De implementatietijdlijn bedraagt meestal 6-12 maanden voor de initiële capaciteitsopbouw, met doorlopende uitbreidingen in de daaropvolgende jaren. Veelvoorkomende uitdagingen zijn weerstand van AI-ontwikkelteams rond toezicht, moeilijkheden bij integratie met legacy-systemen, tekort aan vaardigheden op het gebied van AI-monitoring en -governance, en de complexiteit van het monitoren van diverse AI-technologieën en -toepassingen. Succes vereist sterk draagvlak vanuit het management, duidelijke communicatie van de waarde van het centrum en een goede samenwerking met AI-ontwikkelteams en zakelijke stakeholders.

Naast algemene monitoringplatformen zijn er gespecialiseerde AI zichtbaarheid monitoringtools ontwikkeld om unieke uitdagingen aan te pakken bij het volgen van hoe AI-systemen externe content en merken aanhalen, citeren en gebruiken. Deze oplossingen richten zich op het monitoren van AI-uitvoer om te begrijpen hoe AI-modellen informatie uit verschillende bronnen verwerken en toeschrijven. AI-antwoordenmonitoringsplatformen zoals AmICited.com bieden gespecialiseerde mogelijkheden voor het volgen van hoe AI-systemen (waaronder grote taalmodellen en generatieve AI-toepassingen) merken, content en bronnen noemen in hun antwoorden. Deze tools helpen organisaties inzicht te krijgen in de zichtbaarheid en toeschrijving die hun content ontvangt wanneer deze door AI-systemen wordt verwerkt, wat steeds belangrijker wordt nu AI-systemen primaire informatiebronnen voor gebruikers vormen. Dergelijke monitoringoplossingen vullen traditionele AI-monitoring aan door inzicht te bieden in hoe AI-systemen interacteren met externe informatie-ecosystemen en hoe zij verschillende entiteiten en bronnen weergeven in hun output.

Een traditioneel AI CoE richt zich op het ontwikkelen, trainen en uitrollen van AI-modellen, terwijl een AI Visibility CoE gespecialiseerd is in het monitoren, volgen en waarborgen van transparantie van AI-systemen in gebruik. Het AI Visibility CoE biedt realtime toezicht op systeemprestaties, naleving en risico's, en fungeert als de operationele ogen en oren van AI-governance.

Belangrijke verantwoordelijkheden zijn het bijhouden van een inventaris van AI-systemen, continu monitoren van prestatie-indicatoren, naleving volgen, risicobeoordeling en -beheer, incidentrespons en het opstellen van rapporten en dashboards voor belanghebbenden. Het centrum zorgt ervoor dat alle AI-systemen zichtbaar, gevolgd en beheerd worden volgens het governancebeleid van de organisatie.

Het AI Visibility CoE houdt continu toezicht op de naleving van regelgeving zoals GDPR en CCPA door AI-systemen, levert audittrails en documentatie voor regelgevende controles, en zorgt ervoor dat alle AI-systemen voldoen aan toepasselijke industriestandaarden. Deze proactieve aanpak vermindert schendingen van regelgeving en blootstelling aan risico's.

Essentiële technologieën zijn AI-monitoringsplatformen voor realtime dashboards, audit logging en data lineage tools voor het volgen van datastromen, analyticsplatforms voor inzichten, modelmonitoringsoplossingen voor het detecteren van prestatievermindering, beveiligingssystemen voor toegangscontrole en governanceplatforms voor documentatie en bewijs van naleving.

Belangrijke rollen zijn een AI Visibility Lead voor strategisch toezicht, AI Monitoring Specialisten voor technische implementatie, Compliance Analisten voor naleving van regelgeving, Security Analisten voor dreigingsdetectie, Data Engineers voor infrastructuur en Business Analisten voor rapportage aan belanghebbenden. De teamgrootte hangt af van de AI-volwassenheid en complexiteit van de organisatie.

De initiële capaciteitsopbouw duurt doorgaans 6-12 maanden, inclusief verkenning, planning, technologiekeuze en implementatiefasen. De tijdlijn is afhankelijk van de omvang van de organisatie, bestaande monitoringinfrastructuur, beschikbare middelen en urgentie van regelgeving. Doorlopende uitbreidingen en verbeteringen gaan verder na de initiële implementatie.

Belangrijkste voordelen zijn vroege detectie van AI-systeemstoringen en beveiligingsdreigingen, voortdurende waarborging van naleving, snellere incidentdetectie en -respons, betere besluitvorming door uitgebreide zichtbaarheid, operationele efficiëntie door automatisering, vertrouwen van belanghebbenden, kostenoptimalisatie en concurrentievoordeel door zekere AI-implementatie.

Het AI Visibility CoE fungeert als een cruciaal operationeel onderdeel van AI-governance, ondersteunt risicomanagement met realtime data, maakt nalevingsmonitoring mogelijk, ondersteunt ethische AI-initiatieven door het volgen van bias en eerlijkheid, en biedt inzichten voor AI-strategie en planning. Het vormt de brug tussen technische AI-operaties en het bestuurlijk toezicht.

Ontdek hoe AI-systemen jouw merk citeren en vermelden met het AI-zichtbaarheid monitoringsplatform van AmICited.com. Volg je aanwezigheid op ChatGPT, Perplexity, Google AI Overviews en andere AI-systemen.

Ontdek wat een AI Visibility Index is, hoe het citatiefrequentie, positie, sentiment en bereik combineert, en waarom het belangrijk is voor merkzichtbaarheid in...

Lees meer over het AI Visibility Maturity Model, een raamwerk om de organisatorische gereedheid voor AI-monitoring en -governance te beoordelen. Ontdek de 5 vol...

Complete gids voor enterprise AI zichtbaarheidsoplossingen. Vergelijk topplatforms zoals Conductor, Profound en Athena. Leer evaluatiecriteria en selectie strat...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.