Contextvenster

Contextvenster uitgelegd: het maximale aantal tokens dat een LLM tegelijk kan verwerken. Leer hoe contextvensters AI-nauwkeurigheid, hallucinaties en merkmonito...

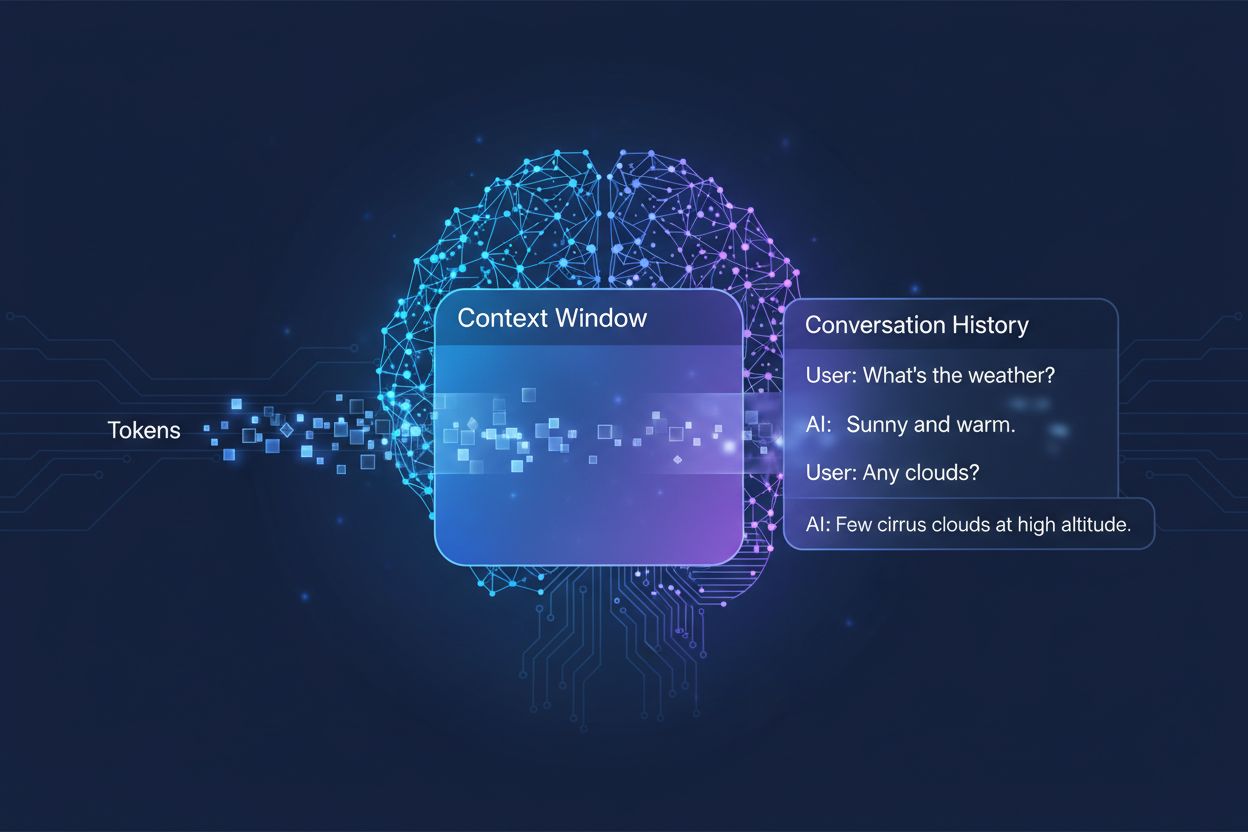

De hoeveelheid eerdere conversatie die een AI-systeem meeneemt bij het genereren van antwoorden, gemeten in tokens. Het bepaalt hoeveel tekst een AI tegelijkertijd kan verwerken en heeft direct invloed op de kwaliteit en samenhang van de uitkomsten in gesprekken met meerdere beurten.

De hoeveelheid eerdere conversatie die een AI-systeem meeneemt bij het genereren van antwoorden, gemeten in tokens. Het bepaalt hoeveel tekst een AI tegelijkertijd kan verwerken en heeft direct invloed op de kwaliteit en samenhang van de uitkomsten in gesprekken met meerdere beurten.

Een contextvenster is de maximale hoeveelheid tekst die een AI-taalmodel in één keer kan verwerken en raadplegen tijdens een gesprek of taak. Zie het als het werkgeheugen van het model — net zoals mensen slechts een beperkte hoeveelheid informatie direct kunnen onthouden, kan een AI-model slechts een bepaalde hoeveelheid tekst “zien” voor en na zijn huidige positie. Deze capaciteit wordt gemeten in tokens, kleine eenheden tekst die meestal woorden of woordfragmenten voorstellen (gemiddeld komt één Engels woord overeen met ongeveer 1,5 tokens). Inzicht in het contextvenster van je model is cruciaal, omdat het direct bepaalt hoeveel informatie de AI kan meenemen bij het genereren van antwoorden, waardoor het een fundamentele beperking vormt in hoe effectief het model complexe, meerstapsgesprekken of lange documenten kan verwerken.

Moderne taalmodellen, met name transformergebaseerde architecturen, verwerken tekst door deze om te zetten in tokens en vervolgens de relaties tussen alle tokens binnen het contextvenster gelijktijdig te analyseren. De transformer-architectuur, geïntroduceerd in het invloedrijke artikel “Attention is All You Need” uit 2017, maakt gebruik van een mechanisme genaamd zelf-attentie om te bepalen welke delen van de input het meest relevant zijn voor elkaar. Dit attention-mechanisme stelt het model in staat om het belang van verschillende tokens ten opzichte van elkaar te wegen, waardoor het context en betekenis over het hele venster kan begrijpen. Dit proces wordt echter steeds duurder qua rekenkracht naarmate het contextvenster groeit, omdat het attention-mechanisme relaties moet berekenen tussen elke token en alle andere tokens — een kwadratisch schaalprobleem. De onderstaande tabel laat zien hoe verschillende toonaangevende AI-modellen zich verhouden qua contextvenstermogelijkheden:

| Model | Contextvenster (tokens) | Release |

|---|---|---|

| GPT-4 | 128.000 | maart 2023 |

| Claude 3 Opus | 200.000 | maart 2024 |

| Gemini 1.5 Pro | 1.000.000 | mei 2024 |

| GPT-4 Turbo | 128.000 | november 2023 |

| Llama 2 | 4.096 | juli 2023 |

Deze verschillende capaciteiten weerspiegelen uiteenlopende ontwerpkeuzes en computationele afwegingen per organisatie, waarbij grotere vensters meer geavanceerde toepassingen mogelijk maken, maar ook meer rekenkracht vereisen.

De opmars naar grotere contextvensters is een van de belangrijkste sprongen in AI-capaciteit van het afgelopen decennium. Vroege recurrente neurale netwerken (RNN’s) en long short-term memory (LSTM)-modellen hadden moeite met context: zij verwerkten tekst sequentieel en konden informatie uit verre delen van de input slecht vasthouden. De doorbraak kwam in 2017 met de introductie van de Transformer-architectuur, waarmee hele sequenties parallel verwerkt konden worden en de context over langere teksten veel beter behouden bleef. Dit vormde de basis voor GPT-2 uit 2019 (met een contextvenster van 1.024 tokens), vervolgens GPT-3 uit 2020 (2.048 tokens) en uiteindelijk GPT-4 uit 2023 (128.000 tokens). Elke vooruitgang was van belang, omdat grotere vensters modellen in staat stelden om langere documenten te verwerken, samenhang te behouden in meerstapsgesprekken en subtiele verbanden te begrijpen tussen verre concepten in tekst. De exponentiële groei van contextvenstergrootte weerspiegelt zowel architecturale innovaties als toegenomen rekenkracht bij toonaangevende AI-labs.

Grotere contextvensters vergroten fundamenteel de mogelijkheden van AI-modellen en maken toepassingen mogelijk die voorheen onmogelijk of ernstig beperkt waren. Belangrijkste voordelen:

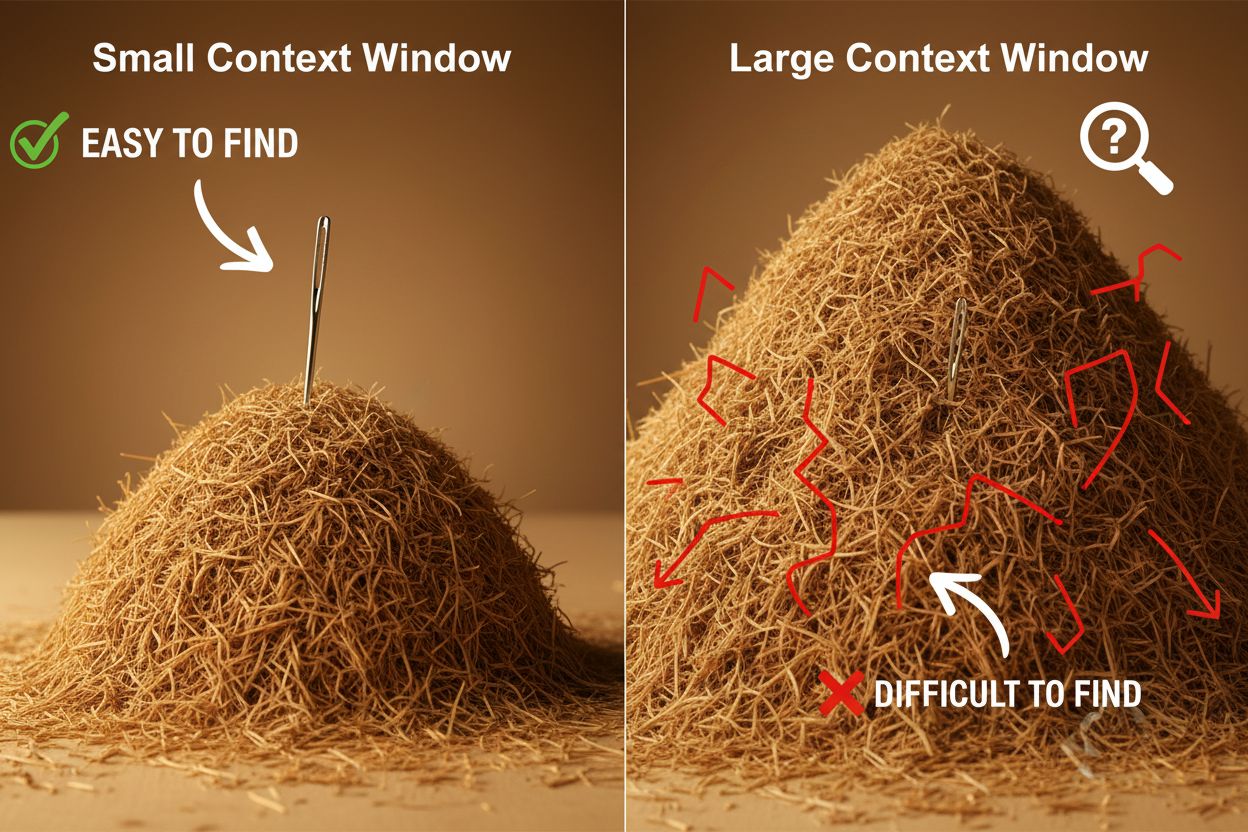

Ondanks de voordelen brengen grote contextvensters aanzienlijke technische en praktische uitdagingen met zich mee. De meest voor de hand liggende uitdaging is de computationele kostprijs: langere sequenties vereisen exponentieel meer geheugen en rekenkracht door de kwadratische schaal van het attention-mechanisme, waardoor grote contextvensters veel duurder worden om te draaien. Deze verhoogde rekeneis veroorzaakt ook latentieproblemen: grotere contextvensters leiden tot tragere reacties, wat problematisch is voor realtime toepassingen waar snelheid belangrijk is. Een minder direct zichtbaar, maar belangrijk probleem is het “naald in hooiberg”-fenomeen, waarbij modellen moeite hebben relevante informatie te vinden als die begraven ligt in een zeer groot contextvenster, en soms slechter presteren dan bij kleinere vensters. Daarnaast treedt contextrot op: informatie aan het begin van een lang contextvenster verliest invloed op de output, doordat het attention-mechanisme verre tokens minder gewicht geeft dan recente. Deze uitdagingen maken dat simpelweg het contextvenster maximaliseren niet altijd de beste oplossing is.

Inzicht in contextrot is essentieel bij het werken met grote contextvensters: naarmate sequenties langer worden, krijgen tokens aan het begin steeds minder invloed op de output van het model, waardoor belangrijke informatie feitelijk “vergeten” kan worden, ook al zit het technisch gezien nog binnen het venster. Dit gebeurt omdat het attention-budget — de capaciteit van het model om betekenisvol aandacht te geven aan alle tokens — over een grotere tekst wordt uitgesmeerd. Gelukkig zijn er geavanceerde technieken ontwikkeld om deze beperkingen aan te pakken. Retrieval-Augmented Generation (RAG) lost dit op door informatie in externe databases op te slaan en alleen de meest relevante stukken op te halen wanneer nodig. Zo krijgt het model een grotere effectieve kennisbasis zonder een enorm contextvenster te vereisen. Contextcompactie-technieken vatten minder relevante informatie samen of comprimeren deze, zodat de belangrijkste details behouden blijven met minder tokens. Gestructureerde notitiemethoden moedigen gebruikers aan informatie hiërarchisch te organiseren, waardoor het model sleutelconcepten makkelijker kan prioriteren en vinden. Deze oplossingen werken door strategisch te bepalen welke informatie het contextvenster ingaat en hoe deze wordt georganiseerd, in plaats van alles in het geheugen te willen proppen.

De grotere contextvensters van moderne AI-modellen hebben talloze toepassingen mogelijk gemaakt die voorheen onpraktisch of onmogelijk waren. Klantenservicesystemen kunnen nu een volledig ticketverloop en relevante documentatie in één keer beoordelen, wat resulteert in meer accurate en contextueel juiste antwoorden zonder dat klanten hun situatie steeds opnieuw hoeven uit te leggen. Documentanalyse en onderzoek zijn getransformeerd door modellen die hele onderzoeksartikelen, contracten of technische specificaties kunnen verwerken, en zo snel belangrijke informatie kunnen vinden en beantwoorden waar mensen uren over zouden doen. Codereview en softwareontwikkeling profiteren van contextvensters die groot genoeg zijn voor complete bestanden of zelfs meerdere samenhangende bestanden, zodat AI architectuurpatronen begrijpt en slimmere suggesties kan doen. Langvormige contentcreatie en iteratieve schrijfprocessen verlopen efficiënter als het model doorlopend zicht houdt op toon, stijl en verhaallijn. Transcriptie van vergaderingen en onderzoekssynthese benutten grote contextvensters om inzichten te halen uit uren aan gesprekken of tientallen bronnen, waarbij thema’s en verbanden worden gevonden die handmatig lastig te ontdekken zijn. Deze toepassingen tonen aan dat de grootte van het contextvenster direct vertaalt naar praktische waarde voor professionals in alle sectoren.

De ontwikkeling van contextvensters wijst op een verdere spectaculaire groei in de nabije toekomst, met Gemini 1.5 Pro die al een contextvenster van 1.000.000 tokens biedt en onderzoeksinstituten die nog grotere capaciteiten onderzoeken. Behalve pure omvang, zal de toekomst waarschijnlijk bestaan uit dynamische contextvensters die hun grootte intelligent aanpassen aan de taak, meer capaciteit toekennen waar nodig en verkleinen bij eenvoudige vragen voor meer efficiëntie en lagere kosten. Onderzoekers boeken ook vooruitgang met efficiëntere attention-mechanismen, die de computationele nadelen van grotere vensters verminderen en mogelijk de kwadratische schaal doorbreken die contextvenstergrootte nu beperkt. Naarmate deze technologieën volwassen worden, kunnen contextvensters minder een beperkende factor worden en meer een opgelost probleem, zodat ontwikkelaars zich kunnen richten op andere aspecten van AI-capaciteit en betrouwbaarheid. De combinatie van grotere vensters, betere efficiëntie en slimmere contextbeheer zal waarschijnlijk de volgende generatie AI-toepassingen definiëren, met mogelijkheden die we nu nog niet kunnen voorzien.

Een contextvenster is de totale hoeveelheid tekst (gemeten in tokens) die een AI-model in één keer kan verwerken, terwijl een tokenlimiet verwijst naar het maximum aantal tokens dat het model aankan. Deze termen worden vaak door elkaar gebruikt, maar contextvenster verwijst specifiek naar het werkgeheugen tijdens één inferentie, terwijl tokenlimiet ook kan verwijzen naar outputbeperkingen of API-gebruikslimieten.

Grotere contextvensters verbeteren over het algemeen de antwoordkwaliteit doordat het model meer relevante informatie kan meenemen en een betere continuïteit in gesprekken kan behouden. Echter, extreem grote vensters kunnen soms de kwaliteit verminderen door contextrot, waarbij het model moeite heeft om belangrijke informatie te prioriteren tussen grote hoeveelheden tekst. De optimale grootte van het contextvenster hangt af van de specifieke taak en hoe de informatie is georganiseerd.

Grotere contextvensters vereisen meer rekenkracht door de kwadratische schaal van het attention-mechanisme in transformermodellen. Het attention-mechanisme moet relaties berekenen tussen elke token en elke andere token, dus het verdubbelen van het contextvenster verviervoudigt ongeveer de berekeningseisen. Daarom zijn grotere contextvensters duurder om te draaien en zorgen ze voor tragere reactietijden.

Het 'naald in hooiberg'-probleem ontstaat wanneer een AI-model moeite heeft om relevante informatie (de 'naald') te lokaliseren en te gebruiken wanneer deze begraven ligt in een zeer groot contextvenster (de 'hooiberg'). Modellen presteren soms slechter met extreem grote contextvensters omdat het attention-mechanisme over zoveel informatie wordt verspreid, waardoor het moeilijker wordt om te bepalen wat echt belangrijk is.

Om de effectiviteit van het contextvenster te maximaliseren, organiseer je informatie duidelijk en hiërarchisch, plaats je de belangrijkste informatie aan het begin of eind van de context, gebruik je gestructureerde formaten zoals JSON of markdown en overweeg je Retrieval-Augmented Generation (RAG) om alleen de meest relevante informatie dynamisch te laden. Vermijd het overladen van het model met irrelevante details die tokens verbruiken zonder waarde toe te voegen.

Contextvenster is de technische capaciteit van het model om tekst in één keer te verwerken, terwijl gespreksgeschiedenis het daadwerkelijke overzicht is van eerdere berichten in een gesprek. De gespreksgeschiedenis moet binnen het contextvenster passen, maar het contextvenster bevat ook ruimte voor systeemopdrachten, instructies en andere metadata. Een gespreksgeschiedenis kan langer zijn dan het contextvenster, waardoor samenvatting of inkorting nodig is.

Er zijn momenteel geen AI-modellen met echt onbeperkte contextvensters, omdat alle modellen architecturale en computationele beperkingen hebben. Sommige modellen, zoals Gemini 1.5 Pro, bieden echter extreem grote vensters (1.000.000 tokens) en technieken zoals Retrieval-Augmented Generation (RAG) kunnen de kennisbasis van het model effectief uitbreiden buiten het contextvenster door informatie dynamisch op te halen.

De grootte van het contextvenster heeft direct invloed op de API-kosten, omdat grotere vensters meer rekenkracht vereisen om te verwerken. De meeste AI-API-aanbieders rekenen op basis van tokengebruik, dus een groter contextvenster betekent meer verwerkte tokens en hogere kosten. Sommige aanbieders rekenen ook premiumtarieven voor modellen met grotere contextvensters, waardoor het belangrijk is om het juiste model te kiezen voor jouw specifieke behoeften.

AmICited volgt hoe AI-systemen zoals ChatGPT, Perplexity en Google AI Overviews jouw content citeren en vermelden. Begrijp je AI-zichtbaarheid en volg je merkvermeldingen op AI-platforms.

Contextvenster uitgelegd: het maximale aantal tokens dat een LLM tegelijk kan verwerken. Leer hoe contextvensters AI-nauwkeurigheid, hallucinaties en merkmonito...

Ontdek wat contextvensters zijn in AI-taalmodellen, hoe ze werken, hun impact op de prestaties van modellen en waarom ze belangrijk zijn voor AI-toepassingen en...

Discussie in de community over AI context windows en hun implicaties voor contentmarketing. Begrijpen hoe contextlimieten de AI-verwerking van je content beïnvl...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.