Edge SEO

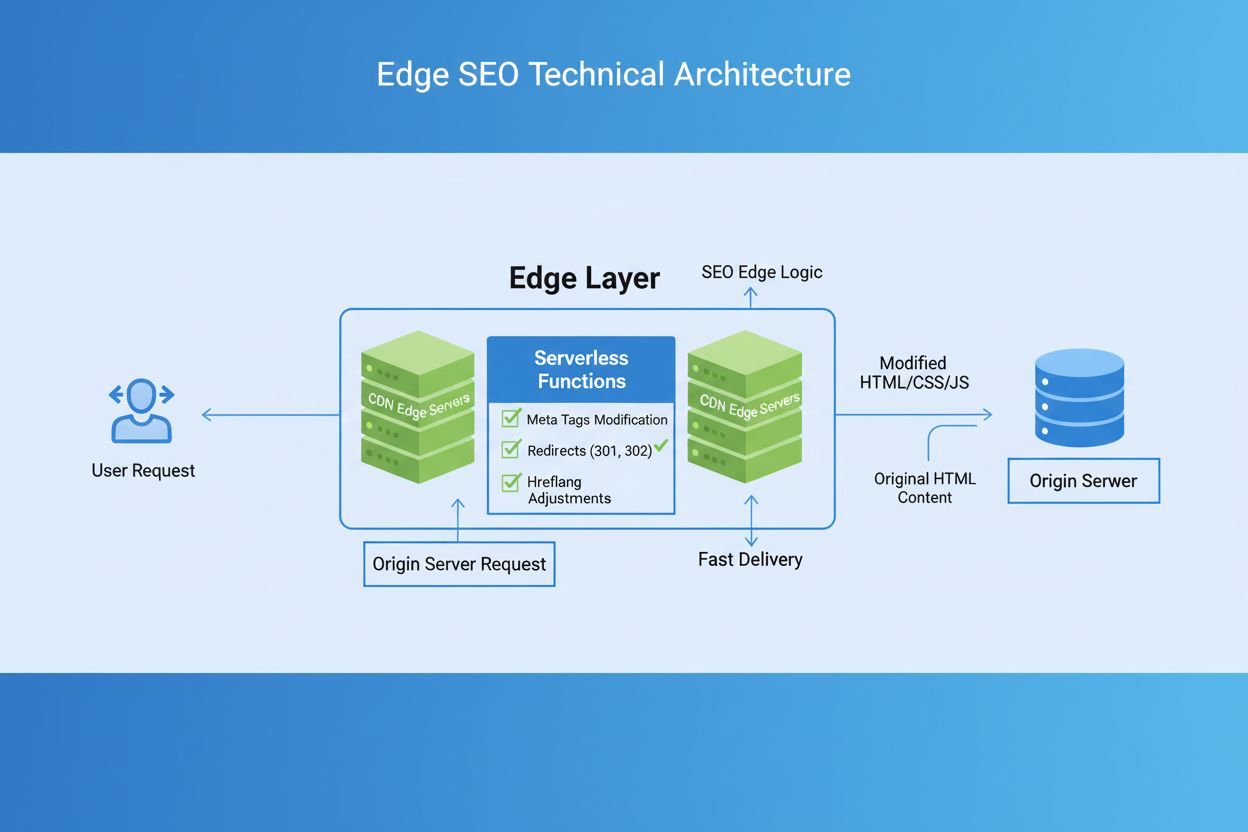

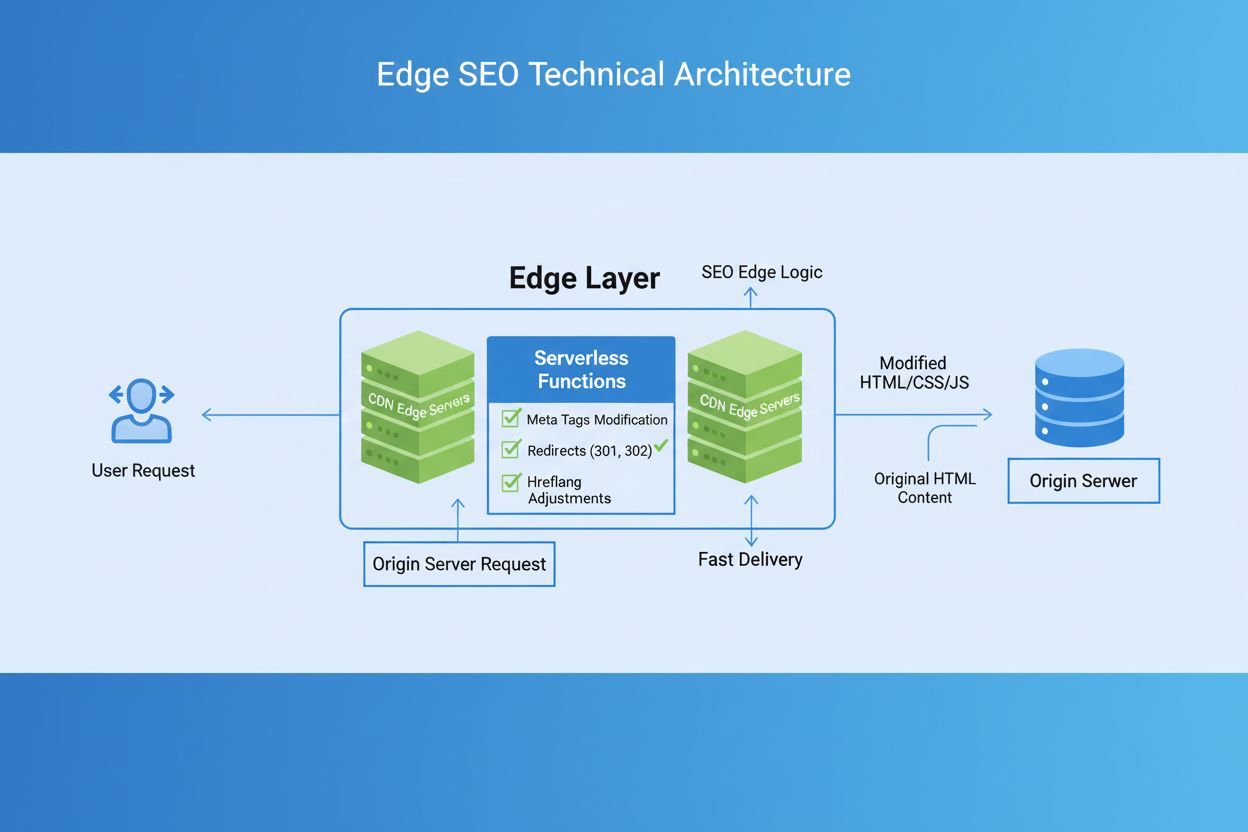

Edge SEO is het toepassen van technische SEO-wijzigingen aan de rand van het netwerk met serverloze functies op CDNs. Leer hoe dit de prestaties verbetert, snel...

Edge AI-verwerking verwijst naar het inzetten van kunstmatige intelligentie-algoritmen direct op lokale apparaten of edge-servers, waardoor realtime gegevensverwerking en -analyse mogelijk is zonder voortdurend afhankelijk te zijn van cloudinfrastructuur. Deze benadering vermindert latentie, verbetert de gegevensprivacy en maakt onmiddellijke besluitvorming mogelijk voor toepassingen zoals merkmonitoring, IoT-apparaten en autonome systemen.

Edge AI-verwerking verwijst naar het inzetten van kunstmatige intelligentie-algoritmen direct op lokale apparaten of edge-servers, waardoor realtime gegevensverwerking en -analyse mogelijk is zonder voortdurend afhankelijk te zijn van cloudinfrastructuur. Deze benadering vermindert latentie, verbetert de gegevensprivacy en maakt onmiddellijke besluitvorming mogelijk voor toepassingen zoals merkmonitoring, IoT-apparaten en autonome systemen.

Edge AI-verwerking vertegenwoordigt een paradigmaverschuiving in de inzet van kunstmatige intelligentie, waarbij rekentaken rechtstreeks worden uitgevoerd op edge-apparaten—zoals smartphones, IoT-sensoren, camera’s en embedded systemen—in plaats van uitsluitend te vertrouwen op gecentraliseerde cloudservers. Deze aanpak verwerkt gegevens aan de bron, waardoor onmiddellijke analyse en besluitvorming mogelijk zijn zonder ruwe informatie naar verre datacenters te verzenden. In tegenstelling tot traditionele cloud AI, die gegevens naar externe servers stuurt voor verwerking en resultaten na netwerkvertraging terugstuurt, brengt edge AI intelligentie naar de rand van netwerken waar data ontstaat. De verwerking gebeurt op lokale hardware met ingebedde machine learning-modellen, waardoor apparaten autonoom kunnen opereren en realtime beslissingen kunnen nemen. Edge AI combineert lichte neurale netwerken, geoptimaliseerde algoritmen en gespecialiseerde hardwareversnellers om AI-mogelijkheden te leveren binnen strikte resourcebeperkingen. Dit gedistribueerde intelligentiemodel verandert fundamenteel hoe organisaties omgaan met gegevensprivacy, systeemresponsiviteit en infrastructuurkosten. Door gevoelige informatie lokaal te verwerken, elimineert edge AI de noodzaak om mogelijk vertrouwelijke data via netwerken te verzenden, waarmee wordt ingespeeld op groeiende privacyzorgen in gereguleerde sectoren.

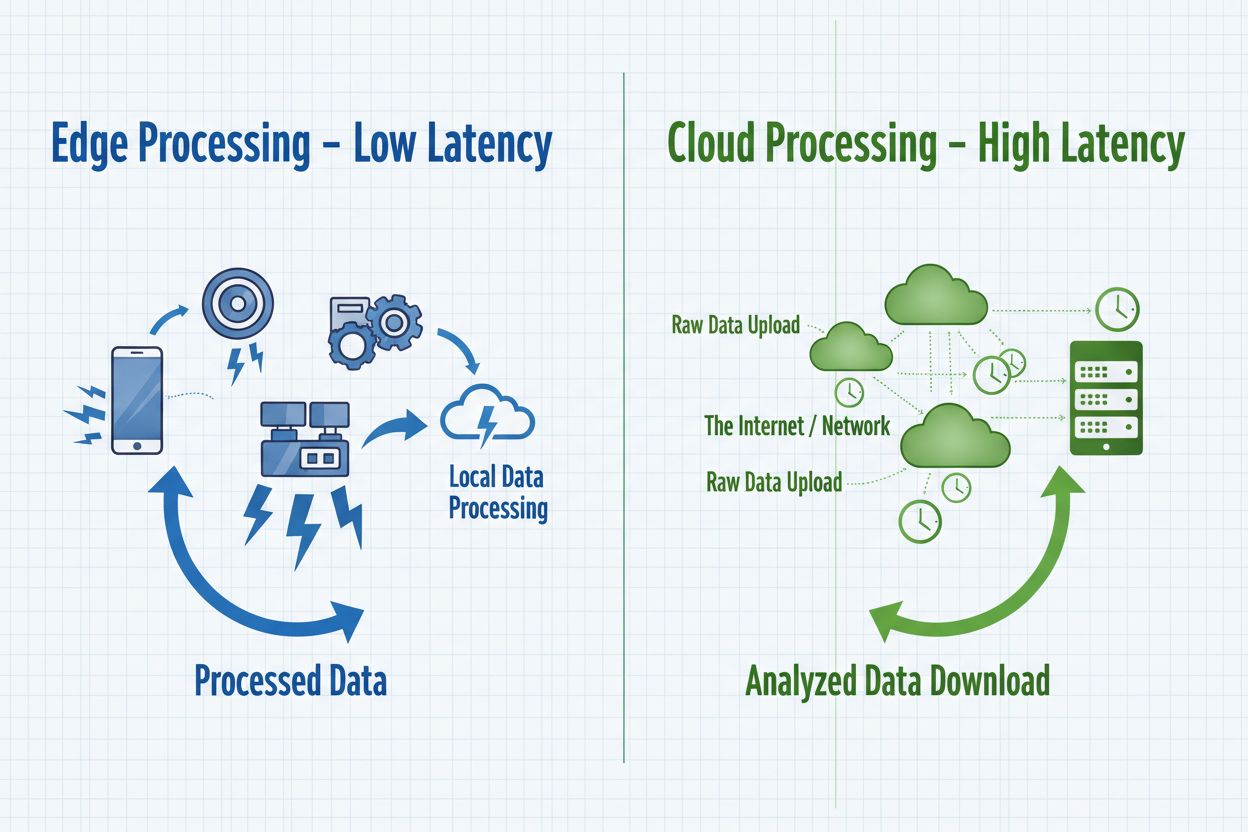

Edge AI en cloud AI vormen complementaire benaderingen voor de inzet van kunstmatige intelligentie, elk met hun eigen voordelen die geschikt zijn voor verschillende use cases en organisatiewensen. Cloud AI blinkt uit in het verwerken van enorme datasets, het trainen van complexe modellen en het uitvoeren van rekentechnisch intensieve taken die profiteren van gecentraliseerde verwerkingskracht en onbeperkte schaalbaarheid. Cloudoplossingen brengen echter inherente latentie met zich mee omdat gegevens over netwerken reizen, waardoor ze ongeschikt zijn voor toepassingen die directe reacties vereisen. Edge AI geeft prioriteit aan snelheid en responsiviteit door informatie lokaal te verwerken, waardoor besluitvorming onder de milliseconde mogelijk is, cruciaal voor autonome systemen en realtime monitoringtoepassingen. De keuze tussen deze benaderingen hangt af van specifieke eisen: cloud AI is geschikt voor batchverwerking, modeltraining en toepassingen waar kleine vertragingen acceptabel zijn, terwijl edge AI wordt ingezet voor realtime toepassingen, privacygevoelige operaties en scenario’s met onbetrouwbare netwerkverbindingen. Organisaties implementeren steeds vaker hybride architecturen die beide paradigma’s benutten—edge-apparaten voor directe verwerking en cloudinfrastructuur voor modeltraining, analyses en langdurige opslag. Inzicht in deze fundamentele verschillen helpt organisaties oplossingen te ontwerpen die prestaties, veiligheid en operationele efficiëntie in balans brengen.

| Aspect | Edge AI | Cloud AI |

|---|---|---|

| Latentie | Responstijden onder de milliseconde; directe lokale verwerking | 50-500ms+ door netwerkoverdracht en serververwerking |

| Bandbreedte | Minimale gegevensoverdracht; verwerkt lokaal | Hoge bandbreedtevereisten; verzendt continu ruwe data |

| Veiligheid & Privacy | Data blijft lokaal; minder kans op datalekken | Data reist over netwerken; gecentraliseerde opslag vormt single point of failure |

| Rekenkracht | Beperkt door apparaat-hardware; geoptimaliseerde lichte modellen | Onbeperkte schaalbaarheid; complexe modellen en enorme datasets |

| Schaalbaarheid | Horizontaal over gedistribueerde apparaten | Verticaal met serverinfrastructuur; gecentraliseerd beheer |

Edge AI-systemen bestaan uit vier essentiële technische componenten die samenwerken om intelligente verwerking aan de netwerkedge te leveren. De inference engine voert voorgetrainde machine learning-modellen uit op edge-apparaten en maakt voorspellingen en classificaties zonder cloudverbinding. Deze engines gebruiken geoptimaliseerde frameworks zoals TensorFlow Lite, ONNX Runtime en PyTorch Mobile, die modellen comprimeren zodat ze in het geheugen van het apparaat passen, terwijl de nauwkeurigheid behouden blijft. De hardwareversnellers—waaronder GPU’s, TPU’s en gespecialiseerde AI-chips—bieden de rekenkracht die nodig is om neurale netwerken efficiënt te laten draaien op apparaten met beperkte middelen. Edge-apparaten passen modeloptimalisatietechnieken toe zoals kwantisatie, pruning en knowledge distillation om het model kleiner en lichter te maken zonder veel prestatieverlies. De databeheerlaag zorgt voor lokale gegevensverzameling, voorbewerking en selectieve overdracht van relevante inzichten naar cloudsystemen voor aggregatie en langdurige analyse. Tot slot beheert de connectiviteitsmodule intermitterende netwerkverbindingen, zodat apparaten offline kunnen blijven werken en gegevens synchroniseren zodra verbinding weer mogelijk is.

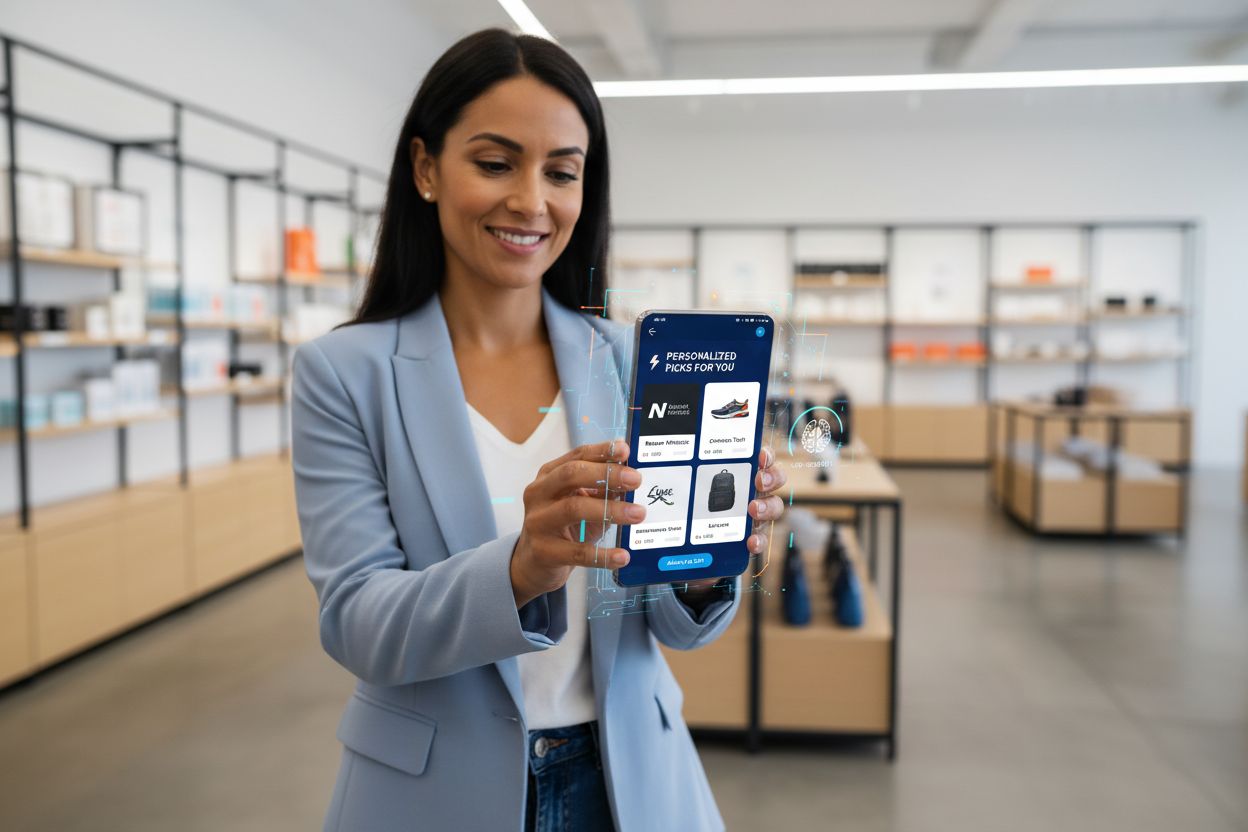

Edge AI-verwerking maakt ongekende mogelijkheden mogelijk voor realtime merkaanbevelingen en monitoring van AI-uitvoer, waarmee organisaties AI-besluitvorming direct op het uitvoeringspunt kunnen volgen en verifiëren. Retailtoepassingen gebruiken edge AI om gepersonaliseerde productaanbevelingen direct te leveren terwijl klanten browsen, waarbij gedragsgegevens lokaal worden geanalyseerd zonder gevoelige winkeldata naar externe servers te sturen. Realtime monitoring van AI-uitvoer wordt mogelijk doordat inferentie plaatsvindt op edge-apparaten, zodat organisaties onmiddellijk afwijkingen, bevooroordeelde voorspellingen of modeldrift kunnen detecteren voordat aanbevelingen bij de klant terechtkomen. Deze lokale verwerking creëert audittrails en beslissingslogs die compliance ondersteunen en merken inzicht geven in waarom bepaalde aanbevelingen werden gegenereerd. Edge AI-monitoringsystemen kunnen verdachte patronen signaleren—zoals aanbevelingen die bepaalde producten of demografische groepen buitensporig bevoordelen—en snelle interventie en modelaanpassing mogelijk maken. Voor merkveiligheid en reputatiebeheer zorgt edge-gebaseerde AI-monitoring ervoor dat geautomatiseerde systemen binnen vastgestelde kaders werken en aansluiten bij de merkwaarden voordat ze klantgericht worden ingezet. De mogelijkheid om AI-uitvoer in realtime aan de edge te monitoren, transformeert hoe organisaties kwaliteitscontrole houden over algoritmische besluitvorming, ondersteunt transparantie-initiatieven en bouwt klantvertrouwen op via verifieerbaar AI-beheer.

Edge AI-verwerking biedt aanzienlijke voordelen op meerdere terreinen die inspelen op kritische uitdagingen voor organisaties in moderne digitale omgevingen. Verminderde latentie is het grootste voordeel, waardoor toepassingen die directe respons vereisen mogelijk worden—autonome voertuigen die in een fractie van een seconde navigatiebeslissingen nemen, industriële robots die reageren op gevaren of medische apparaten die kritieke patiëntcondities detecteren. Verbeterde privacy is een tweede voordeel, omdat gevoelige gegevens op lokale apparaten blijven in plaats van door netwerken te reizen of in gecentraliseerde cloudopslag te staan, waarmee wordt voldaan aan GDPR-, HIPAA- en andere regelgevingseisen. Bandbreedteoptimalisatie vermindert netwerkcongestie en bijbehorende kosten door gegevens lokaal te verwerken en alleen relevante inzichten te verzenden in plaats van ruwe informatiestromen. Offline functionaliteit maakt het mogelijk dat edge-apparaten blijven werken en intelligente beslissingen nemen, zelfs als netwerkverbinding ontbreekt—cruciaal voor afgelegen locaties en missiekritische toepassingen. Verbeterde betrouwbaarheid is te danken aan gedistribueerde verwerking—storingen op individuele edge-apparaten hebben geen impact op de gehele infrastructuur, en lokale verwerking gaat door, ongeacht de beschikbaarheid van cloudservices. Kostenefficiëntie ontstaat door lagere cloudkosten, omdat organisaties gegevens lokaal verwerken in plaats van te betalen voor continue cloudinfrastructuur en datatransmissie. Schaalbaarheidsvoordelen manifesteren zich anders dan bij cloudsystemen; edge AI schaalt horizontaal over verspreide apparaten zonder uitbreiding van gecentraliseerde infrastructuur, ideaal voor IoT-implementaties met duizenden apparaten.

Edge AI-verwerking transformeert operaties in uiteenlopende sectoren door intelligente besluitvorming mogelijk te maken op het punt van datageneratie. Fabrieken zetten edge AI in voor voorspellend onderhoud, waarbij trillingen en temperatuurpatronen lokaal worden geanalyseerd om storingen te voorspellen voordat ze optreden, wat uitvaltijd en onderhoudskosten verlaagt. Zorgverleners gebruiken edge AI in medische beeldvormingsapparatuur die lokaal een eerste analyse uitvoert, waardoor snellere diagnoses mogelijk zijn en de privacy van patiëntgegevens wordt beschermd doordat gevoelige medische informatie lokaal blijft. Winkelomgevingen implementeren edge AI voor voorraadbeheer, klantgedraganalyse en directe persoonlijke aanbevelingen zonder cloudlatentie. Autonome voertuigen zijn volledig afhankelijk van edge AI, die sensorgegevens van camera’s, lidar en radar lokaal verwerkt om binnen milliseconden navigatie- en veiligheidsbeslissingen te nemen. Slimme huissystemen gebruiken edge AI om spraakopdrachten te herkennen, beveiligingsdreigingen te detecteren en routines te automatiseren zonder audio of video naar cloudservers te verzenden. Beveiligings- en surveillancetoepassingen gebruiken edge AI om afwijkingen te detecteren, bedreigingen te identificeren en lokaal alarmen te activeren, waardoor valse meldingen worden verminderd voordat ze naar meldkamers worden gestuurd. Landbouwbedrijven zetten edge AI in op IoT-sensoren om bodemgesteldheid, weerspatronen en gewasgezondheid te monitoren, zodat irrigatie- en bemestingsbeslissingen lokaal kunnen worden genomen en datatransmissiekosten in landelijke gebieden met beperkte connectiviteit worden geminimaliseerd.

Ondanks aanzienlijke voordelen kent Edge AI-verwerking belangrijke technische en operationele uitdagingen die organisaties bij implementatie moeten aanpakken. Energieverbruik blijft een kritieke beperking, omdat het draaien van neurale netwerken op batterijgevoede apparaten veel stroom vergt, wat de inzetduur beperkt en zorgvuldige modeloptimalisatie vereist om nauwkeurigheid en efficiëntie te balanceren. Rekenbeperkingen beperken de complexiteit van modellen die op edge-apparaten kunnen draaien—organisaties moeten kiezen tussen vereenvoudigde modellen met lagere nauwkeurigheid of langere inferentietijden op beperkte hardware. Complexiteit van modelbeheer neemt toe in gedistribueerde omgevingen, omdat het updaten van modellen op duizenden edge-apparaten robuuste versiebeheer-, rollback- en consistentiemechanismen vereist. Dataheterogeniteit is een uitdaging als edge-apparaten werken met uiteenlopende gegevenskenmerken, waardoor centraal getrainde modellen lokaal mogelijk minder presteren. Moeilijkheden bij debugging en monitoring ontstaan door de gedistribueerde aard, waardoor het lastig is om storingen te diagnosticeren, modelgedrag te begrijpen en prestatiestatistieken te verzamelen over geografisch verspreide apparaten. Beveiligingsrisico’s op edge-apparaten vergroten het aanvalsoppervlak, aangezien gecompromitteerde apparaten kwaadaardige code kunnen uitvoeren of lokale modellen manipuleren; dit vereist robuuste beveiliging en regelmatige updates. Integratiecomplexiteit met bestaande cloudinfrastructuur vraagt om zorgvuldige architectuurplanning, zodat edge-systemen effectief communiceren met gecentraliseerde analyses en modeltrainingspijplijnen.

De kruising van Edge AI-verwerking en AI-monitoring creëert krachtige mogelijkheden voor organisaties die toezicht willen houden op algoritmische besluitvorming op schaal. Traditionele AI-monitoring worstelt met cloudgebaseerde systemen waar latentie en datatransmissiekosten realtime inzicht in modeluitvoer beperken; edge AI-monitoring lost dit op door lokale analyse van voorspellingen mogelijk te maken voordat deze klanten beïnvloeden. Uitvoer-verificatiesystemen op edge-apparaten kunnen voorspellingen direct toetsen aan bedrijfsregels, afwijkingen detecteren en beslissingen markeren die menselijke beoordeling vereisen voordat ze worden uitgevoerd. Deze lokale monitoring ondersteunt merkveiligheidsinitiatieven door te waarborgen dat AI-aanbevelingen, contentbeslissingen en klantinteracties in lijn zijn met organisatiewaarden en compliance-eisen. Edge-gebaseerde monitoringsystemen genereren gedetailleerde audittrails waarin wordt vastgelegd waarom bepaalde beslissingen zijn genomen, wat transparantie ondersteunt en post-hoc analyse van algoritmegedrag mogelijk maakt. Bias-detectiemechanismen die aan de edge werken kunnen herkennen wanneer modellen onevenredige uitkomsten opleveren voor bepaalde groepen, waardoor snelle interventie mogelijk is voordat bevooroordeelde aanbevelingen klanten bereiken. De combinatie van edge AI en monitoring creëert een feedbackloop waarbij lokale beslissingslogs modelretraining aansturen, zodat systemen continu verbeteren met behoud van toezicht op hun gedrag. Organisaties die edge AI-monitoring implementeren krijgen ongekende inzichten in algoritmische besluitvorming, waardoor AI verandert van een black box in een transparant, controleerbaar systeem dat zowel prestatieoptimalisatie als verantwoord AI-beheer ondersteunt.

Edge AI-verwerking staat aan de voorhoede van technologische evolutie, met opkomende trends die de manier waarop organisaties gedistribueerde intelligentie inzetten en beheren transformeren. Federated learning is een baanbrekende benadering waarbij edge-apparaten gezamenlijk modellen trainen zonder ruwe data naar centrale servers te sturen, waardoor privacyvriendelijke machine learning op schaal mogelijk wordt. Uitbreiding van 5G-netwerken zal edge AI-adoptie aanzienlijk versnellen door betrouwbare, latentiearme connectiviteit te bieden waarmee edge-apparaten en cloudinfrastructuur naadloos kunnen synchroniseren en toch de voordelen van lokale verwerking behouden. Ontwikkeling van gespecialiseerde hardware blijft doorgaan, met fabrikanten die steeds efficiëntere AI-chips maken, geoptimaliseerd voor specifieke edge-toepassingen en betere prestaties per watt leveren, cruciaal voor batterijgevoede apparaten. Marktprognoses voorspellen explosieve groei, waarbij de wereldwijde edge AI-markt naar verwachting $15,7 miljard bereikt in 2030, met een samengesteld jaarlijks groeipercentage van 38,3% van 2023 tot 2030. TinyML (machine learning op microcontrollers) is een belangrijke trend, die AI-mogelijkheden mogelijk maakt op apparaten met minimale geheugen- en rekenkracht, zodat edge AI kan worden toegepast op voorheen onmogelijke use cases. Containerisatie- en orkestratietechnologieën zoals Kubernetes worden aangepast voor edge-omgevingen, waardoor organisaties verspreide edge-implementaties met dezelfde tools en processen kunnen beheren als hun cloudinfrastructuur. De convergentie van deze trends suggereert een toekomst waarin intelligente verwerking naadloos plaatsvindt over verspreide netwerken, waarbij edge-apparaten realtime beslissingen nemen terwijl clouds systemen bieden voor training, aggregatie en langdurige analyse.

Het succesvol inzetten van Edge AI-verwerking vereist zorgvuldige planning op meerdere vlakken om te garanderen dat systemen de gewenste prestaties en bedrijfswaarde leveren. Modelselectie is de eerste cruciale beslissing, waarbij organisaties beschikbare voorgetrainde modellen moeten beoordelen, hun nauwkeurigheid op de beoogde use cases moeten evalueren en bepalen of maatwerk nodig is. Optimalisatiestrategieën moeten modelnauwkeurigheid afwegen tegen apparaatbeperkingen, waarbij kwantisatie, pruning en architectuurzoektechnieken worden toegepast om modellen te creëren die binnen de hardwarelimieten passen en toch voldoende presteren. Hardwarekeuze hangt af van de specifieke applicatie, rekeneisen en energiebeperkingen; organisaties moeten opties beoordelen variërend van algemene processoren tot gespecialiseerde AI-versnellers. Uitrolmechanismen vereisen robuuste processen voor het verspreiden van modellen over edge-apparaten, versiebeheer en terugdraaien bij problemen. Monitoring en observability-systemen moeten modelprestaties volgen, datadrift detecteren, afwijkingen identificeren en waarschuwingen genereren bij afwijkend gedrag. Beveiligingsversteviging beschermt edge-apparaten tegen ongeautoriseerde toegang, modeldiefstal en kwaadaardige manipulatie door encryptie, authenticatie en regelmatige updates. Integratieplanning zorgt ervoor dat edge-systemen effectief communiceren met cloudinfrastructuur voor modelupdates, analyses en langdurige gegevensopslag, waarmee coherente hybride architecturen ontstaan die de voordelen van beide paradigma’s benutten. Organisaties die edge AI implementeren, moeten duidelijke succescriteria vaststellen, pilotprojecten op beperkte schaal uitvoeren voor volledige uitrol en flexibel blijven om strategieën aan te passen op basis van prestaties in de praktijk.

Edge AI verwerkt gegevens lokaal op apparaten met directe responstijden (sub-millisecond latentie), terwijl Cloud AI gegevens naar externe servers stuurt voor verwerking, wat netwerkvertragingen veroorzaakt. Edge AI geeft prioriteit aan snelheid en privacy, terwijl Cloud AI onbeperkte rekenkracht biedt voor complexe taken.

Edge AI houdt gevoelige gegevens op lokale apparaten in plaats van deze over netwerken te verzenden of op te slaan in gecentraliseerde cloudservers. Deze aanpak verkleint het risico op datalekken, ondersteunt naleving van GDPR en HIPAA en zorgt ervoor dat persoonlijke informatie onder controle van de organisatie blijft.

Edge AI bereikt responstijden onder de milliseconde door gegevens lokaal te verwerken, vergeleken met 50-500 ms of meer voor cloudgebaseerde systemen. Deze drastische vermindering van latentie maakt realtime toepassingen mogelijk, zoals autonome voertuigen, industriële robots en medische apparaten die onmiddellijke besluitvorming vereisen.

Ja, Edge AI-systemen kunnen volledig offline werken omdat de verwerking lokaal op apparaten plaatsvindt. Deze offline functionaliteit is cruciaal voor afgelegen locaties met onbetrouwbare connectiviteit en missiekritische toepassingen waarbij netwerkstoringen de werking niet mogen onderbreken.

Edge AI draait op diverse apparaten, waaronder smartphones, IoT-sensoren, industriële apparatuur, beveiligingscamera's, smartwatches, autonome voertuigen en embedded systemen. Moderne edge-apparaten variëren van microcontrollers met minimale middelen tot krachtige single-board computers met gespecialiseerde AI-versnellers.

Edge AI verwerkt gegevens lokaal en verzendt alleen relevante inzichten in plaats van ruwe informatiestromen. Deze selectieve overdracht vermindert het bandbreedteverbruik drastisch, verlaagt de netwerkosten en verbetert de systeemprestaties door minimale gegevensoverdracht via netwerken.

Edge AI maakt realtime monitoring van AI-gegenereerde aanbevelingen en beslissingen mogelijk op het uitvoeringspunt, waardoor organisaties onmiddellijk afwijkingen kunnen detecteren, merkveiligheid kunnen verifiëren en kunnen garanderen dat algoritmische uitkomsten overeenkomen met de organisatiewaarden voordat ze klanten bereiken.

Belangrijke uitdagingen zijn onder meer het energieverbruik op batterijgevoede apparaten, computationele beperkingen die modeloptimalisatie vereisen, de complexiteit van het beheren van gedistribueerde systemen, beveiligingsrisico's op edge-apparaten en integratie-uitdagingen met bestaande cloudinfrastructuur.

Edge AI-verwerking maakt directe analyse van AI-uitvoer en merkvermeldingen mogelijk. AmICited volgt hoe uw merk verschijnt in AI-gegenereerde content over GPTs, Perplexity en Google AI Overviews met realtime precisie.

Edge SEO is het toepassen van technische SEO-wijzigingen aan de rand van het netwerk met serverloze functies op CDNs. Leer hoe dit de prestaties verbetert, snel...

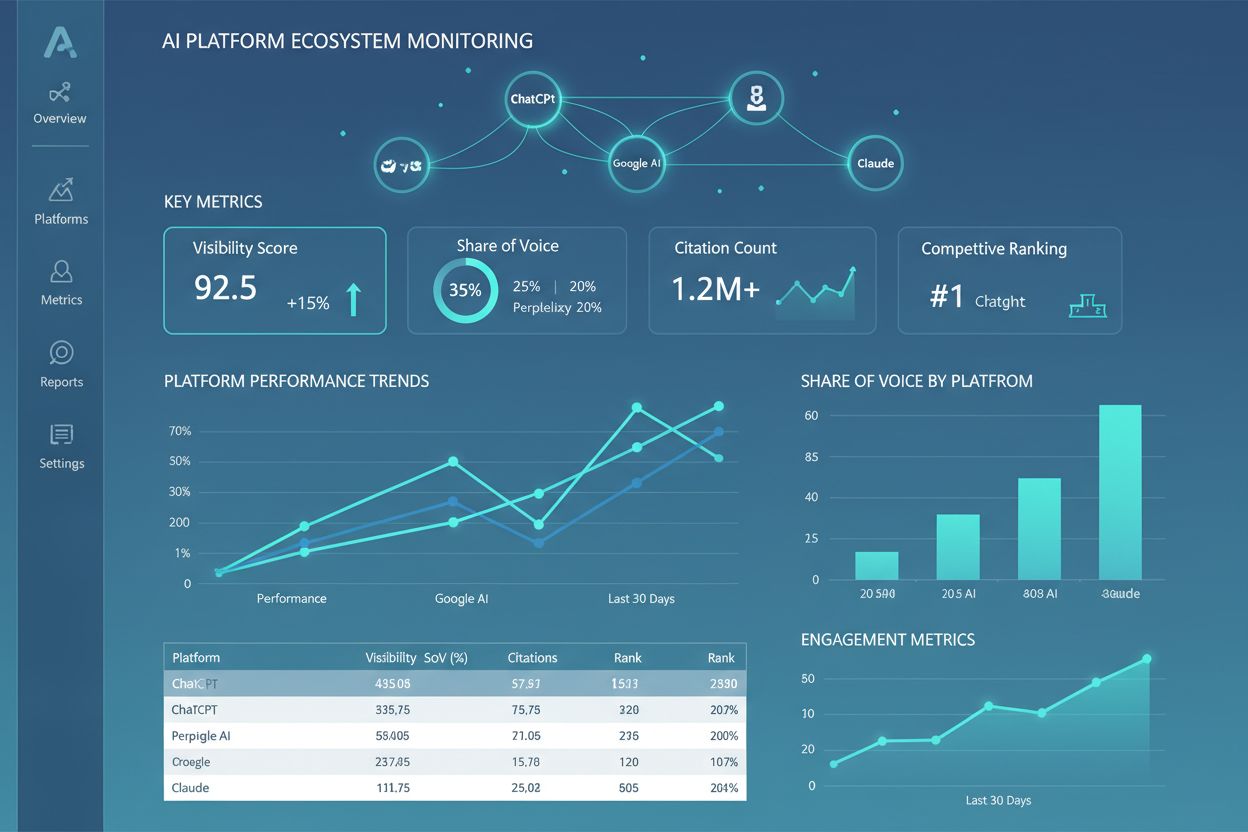

Ontdek wat een AI-platformecosysteem is, hoe onderling verbonden AI-systemen samenwerken en waarom het beheren van je merkoveral op meerdere AI-platforms belang...

Ontdek wat RAG-pijplijnen zijn, hoe ze werken en waarom ze cruciaal zijn voor nauwkeurige AI-antwoorden. Begrijp ophaalmechanismen, vectordatabases en hoe AI-sy...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.