AI-zichtbaarheidsroutekaart Sjabloon: Kwartaaldoelen en Mijlpalen

Leer hoe je een AI-zichtbaarheidsroutekaart opstelt met kwartaaldoelen en GEO-mijlpalen. Ontvang een sjabloon, best practices en tools voor het monitoren van je...

De strategie voor zichtbaarheid van AI in ondernemingen verwijst naar de allesomvattende aanpak die organisaties hanteren om alle kunstmatige intelligentiesystemen, modellen en toepassingen binnen hun infrastructuur te monitoren, volgen en begrijpen. Deze strategie omvat het vermogen om te zien welke AI-systemen worden gebruikt, hoe ze presteren, wie ze gebruikt, en welke risico’s ze met zich meebrengen voor de gehele organisatie. Voor grote ondernemingen die honderden of duizenden AI-implementaties beheren, wordt zichtbaarheid van cruciaal belang omdat shadow AI—ongeautoriseerde of niet-gedocumenteerde AI-tools—zonder adequaat toezicht snel kunnen toenemen. Zonder volledige zichtbaarheid kunnen organisaties niet voldoen aan regelgeving, risico’s beheersen, prestaties optimaliseren of maximale waarde halen uit hun AI-investeringen.

De strategie voor zichtbaarheid van AI in ondernemingen verwijst naar de allesomvattende aanpak die organisaties hanteren om alle kunstmatige intelligentiesystemen, modellen en toepassingen binnen hun infrastructuur te monitoren, volgen en begrijpen. Deze strategie omvat het vermogen om te zien welke AI-systemen worden gebruikt, hoe ze presteren, wie ze gebruikt, en welke risico’s ze met zich meebrengen voor de gehele organisatie. Voor grote ondernemingen die honderden of duizenden AI-implementaties beheren, wordt zichtbaarheid van cruciaal belang omdat shadow AI—ongeautoriseerde of niet-gedocumenteerde AI-tools—zonder adequaat toezicht snel kunnen toenemen. Zonder volledige zichtbaarheid kunnen organisaties niet voldoen aan regelgeving, risico’s beheersen, prestaties optimaliseren of maximale waarde halen uit hun AI-investeringen.

De strategie voor zichtbaarheid van AI in ondernemingen verwijst naar de allesomvattende aanpak die organisaties hanteren om alle kunstmatige intelligentiesystemen, modellen en toepassingen binnen hun infrastructuur te monitoren, volgen en begrijpen. Deze strategie omvat het vermogen om te zien welke AI-systemen worden gebruikt, hoe ze presteren, wie ze gebruikt, en welke risico’s ze met zich meebrengen voor de gehele organisatie. Voor grote ondernemingen die honderden of duizenden AI-implementaties beheren, wordt zichtbaarheid van cruciaal belang omdat shadow AI—ongeautoriseerde of niet-gedocumenteerde AI-tools—zonder adequaat toezicht snel kunnen toenemen. De uitdaging neemt toe op schaal, waar 85% van de ondernemingen nu AI gebruikt in een bepaalde vorm, maar slechts 11% duidelijke bedrijfswaarde rapporteert, wat wijst op een aanzienlijke kloof tussen implementatie en effectief beheer. Zonder volledige zichtbaarheid kunnen organisaties niet voldoen aan regelgeving, risico’s beheersen, prestaties optimaliseren of maximale waarde halen uit hun AI-investeringen.

AI-zichtbaarheid in ondernemingen werkt over drie onderling verbonden dimensies die samen volledige organisatorische bewustwording geven van AI-systemen en hun impact. De eerste dimensie, gebruikmonitoring, volgt welke AI-systemen zijn ingezet, wie er toegang toe heeft, hoe vaak ze worden gebruikt en voor welke bedrijfsdoeleinden. De tweede dimensie, kwaliteitsmonitoring, zorgt ervoor dat AI-modellen presteren zoals bedoeld, voldoen aan nauwkeurigheidsnormen en niet achteruitgaan door datadrift of modelveroudering. De derde dimensie, beveiligingsmonitoring, beschermt tegen ongeautoriseerde toegang, datalekken, prompt-injectie-aanvallen en zorgt voor naleving van regelgevingseisen. Deze drie dimensies moeten samenwerken, ondersteund door centrale logging, realtime dashboards en geautomatiseerde waarschuwingssystemen. Organisaties die volledige zichtbaarheid over alle drie de dimensies implementeren, rapporteren aanzienlijk betere governance-resultaten en snellere reacties op incidenten.

| Dimensie | Doel | Belangrijkste metrics |

|---|---|---|

| Gebruikmonitoring | Volgen van AI-implementatie en gebruikspatronen | Actieve gebruikers, API-calls, modelversies, adoptie per businessunit |

| Kwaliteitsmonitoring | Zorgen voor modelprestaties en betrouwbaarheid | Nauwkeurigheid, precisie, recall, predictiedrift, latency |

| Beveiligingsmonitoring | Beschermen tegen dreigingen en compliance waarborgen | Toegangslogs, gedetecteerde afwijkingen, beleidschendingen, audit trails |

Organisaties stuiten op aanzienlijke obstakels bij het implementeren van volledige AI-zichtbaarheid in grote, complexe omgevingen. Shadow AI is wellicht de belangrijkste uitdaging—medewerkers en afdelingen zetten AI-tools in zonder medeweten of goedkeuring van IT, wat blinde vlekken creëert die centrale monitoring en governance onmogelijk maken. Datasilo’s versnipperen informatie over afdelingen, waardoor het onmogelijk wordt AI-gebruikspatronen te correleren of dubbel werk en verspilde middelen te identificeren. Integratiecomplexiteit ontstaat wanneer organisaties zichtbaarheidstools moeten koppelen aan legacy-systemen, cloudplatforms en uiteenlopende AI-raamwerken die niet zijn ontworpen met monitoring in gedachten. Regelgevingsfragmentatie vereist verschillende zichtbaarheidsstandaarden per jurisdictie, wat compliance ingewikkeld maakt en een flexibele, aanpasbare monitoringinfrastructuur vereist. Daarnaast geeft 84% van de IT-leiders aan geen formeel governanceproces te hebben, en 72% van de organisaties meldt datakwaliteitsproblemen die de betrouwbaarheid van zichtbaarheidmetrics zelf ondermijnen.

Belangrijkste uitdagingen op het gebied van zichtbaarheid zijn onder andere:

Effectieve AI-zichtbaarheid in ondernemingen vereist afstemming op gevestigde governance-raamwerken en standaarden die structuur en geloofwaardigheid geven aan monitoringinspanningen. Het NIST AI Risk Management Framework (RMF) biedt een allesomvattende aanpak voor het identificeren, meten en beheren van AI-risico’s en vormt de basis voor zichtbaarheidseisen over alle organisatorische functies. ISO/IEC 42001 stelt internationale standaarden vast voor AI-managementsystemen, inclusief eisen voor monitoring, documentatie en continue verbetering die aansluiten bij zichtbaarheidsdoelen. De EU AI Act legt strikte transparantie- en documentatie-eisen op voor high-risk AI-systemen en vereist gedetailleerde vastlegging van gedrag en besluitvorming van AI-systemen. Sectorspecifieke raamwerken voegen aanvullende eisen toe—financiële dienstverleners moeten voldoen aan de verwachtingen van toezichthouders op AI-governance, zorginstellingen moeten voldoen aan FDA-eisen voor klinische AI-systemen en overheidsinstanties aan federale richtlijnen voor AI-governance. Organisaties moeten raamwerken kiezen die passen bij hun sector, regio en risicoprofiel, en vervolgens hun zichtbaarheid infrastructuur daarop afstemmen om compliance met de gekozen standaarden aan te tonen.

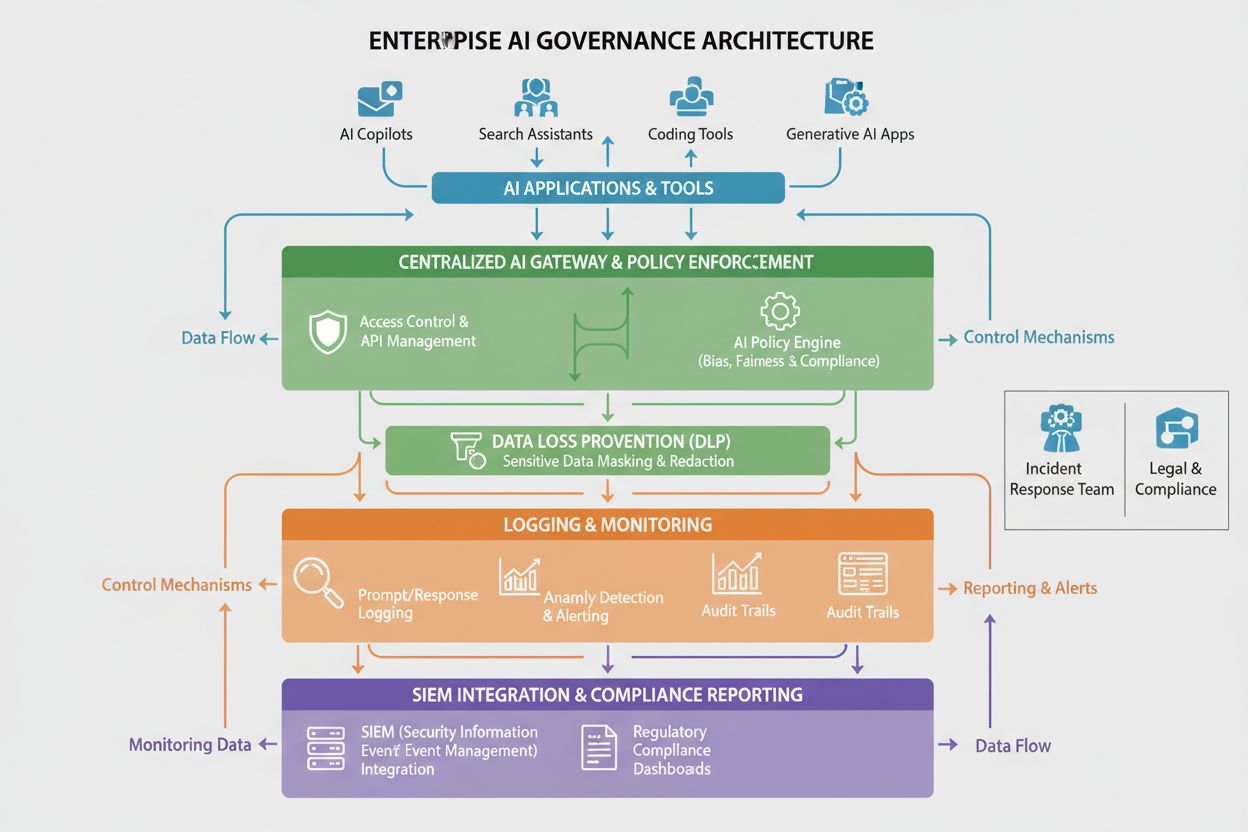

Het implementeren van AI-zichtbaarheid in ondernemingen vereist een solide technische basis die data over het gedrag en de prestaties van AI-systemen vastlegt, verwerkt en presenteert. Centrale AI-platforms vormen de ruggengraat van zichtbaarheid infrastructuur en bieden een centraal overzicht waarop organisaties alle AI-systemen kunnen monitoren, ongeacht waar deze draaien. AI-gateways fungeren als tussenlaag tussen applicaties en AI-diensten en leggen metadata vast van elke aanvraag en respons, waarmee gedetailleerde gebruiksregistratie en beveiligingsmonitoring mogelijk worden. Uitgebreide loggingsystemen registreren alle AI-activiteiten, modelvoorspellingen, gebruikersinteracties en systeemperformance in centrale repositories die audit trails en forensische analyse ondersteunen. DLP-tools (Data Loss Prevention) monitoren AI-systemen op pogingen tot het exfiltreren van gevoelige data, voorkomen dat modellen worden getraind op vertrouwelijke informatie of beschermde data teruggeven in antwoorden. SIEM-integratie verbindt AI-zichtbaarheidsdata met bredere security-informatie- en eventmanagementsystemen en maakt correlatie van AI-gerelateerde beveiligingsincidenten met andere dreigingen mogelijk. Organisaties die deze technische componenten implementeren, rapporteren 30% snellere incidentrespons bij AI-gerelateerde beveiligingsproblemen. Platforms zoals Liminal, Ardoq en Knostic bieden governance-gedreven zichtbaarheidoplossingen, terwijl AmICited.com gespecialiseerd is in het monitoren van AI-antwoordkwaliteit op GPT’s, Perplexity en Google AI Overviews.

Succesvolle AI-zichtbaarheid in ondernemingen vereist duidelijke organisatiestructuren en vastgelegde rollen die verantwoordelijkheid voor monitoring en governance over de organisatie verdelen. Een AI Governance Committee fungeert meestal als het uitvoerende orgaan dat toezicht houdt op de AI-zichtbaarheidsstrategie, beleid vaststelt en zorgt voor afstemming met bedrijfsdoelstellingen en regelgevingseisen. Model Owners zijn verantwoordelijk voor specifieke AI-systemen en zorgen dat deze correct zijn gedocumenteerd, gemonitord en onderhouden volgens de organisatiestandaarden. AI Champions binnen business units fungeren als schakel tussen IT-governanceteams en eindgebruikers, promoten zichtbaarheidpraktijken en signaleren shadow AI voordat deze onbeheersbaar wordt. Datastewards bewaken de kwaliteit en toegankelijkheid van data die wordt gebruikt voor training en monitoring van AI-systemen en zorgen dat zichtbaarheidmetrics zelf betrouwbaar en geloofwaardig zijn. Beveiligings- en compliance-teams stellen monitoringvereisten op, voeren audits uit en zorgen dat de zichtbaarheid infrastructuur aan wet- en regelgeving voldoet. Heldere verantwoordingsstructuren zorgen ervoor dat zichtbaarheid niet als een exclusieve IT-verantwoordelijkheid wordt gezien, maar als een gedeelde organisatieverplichting die vraagt om participatie van business, techniek en governancefuncties.

Organisaties moeten duidelijke key performance indicators (KPI’s) en meetraamwerken opstellen om te beoordelen of hun AI-zichtbaarheidsstrategie waarde levert en de organisatie ondersteunt. Zichtbaarheidsdekking meet het percentage AI-systemen dat is gedocumenteerd en gemonitord, waarbij volwassen organisaties streven naar meer dan 95% dekking van alle AI-implementaties. Governancevolwassenheid volgt de voortgang door gedefinieerde stadia—van ad-hoc monitoring naar gestandaardiseerde processen tot geoptimaliseerde, geautomatiseerde governance—op basis van modellen als het CMMI, aangepast voor AI-governance. Incidentdetectie en -respons meten hoe snel organisaties AI-gerelateerde problemen identificeren en oplossen; verbeteringen in detectie- en reactietijd duiden op effectievere zichtbaarheid. Compliance-naleving volgt het percentage AI-systemen dat voldoet aan regelgeving en interne standaarden, waarbij auditbevindingen en hersteltermijnen als kernmetrics dienen. Gerealiseerde bedrijfswaarde meet of investeringen in zichtbaarheid leiden tot tastbare voordelen zoals lager risico, betere modelprestaties, snellere time-to-market voor AI-initiatieven of betere middelenallocatie. Organisaties moeten realtime dashboards implementeren die deze metrics tonen aan stakeholders om continu te kunnen monitoren en snel bij te sturen als zichtbaarheidsgaten ontstaan.

Verschillende sectoren hebben unieke AI-zichtbaarheidseisen, ingegeven door regelgeving, risicoprofielen en bedrijfsmodellen, die vragen om een op maat gemaakte monitoringaanpak. Financiële dienstverleners moeten voldoen aan verwachtingen van toezichthouders op AI-governance, met gedetailleerde monitoring van AI-systemen voor kredietverlening, fraudedetectie en handelsalgoritmen, met bijzondere aandacht voor bias-detectie en eerlijkheidsmetrics. Zorginstellingen moeten voldoen aan FDA-eisen voor klinische AI-systemen, waaronder validatie van modelprestaties, monitoring van veiligheidsissues en documentatie van de invloed van AI op klinische beslissingen. Juridische organisaties die AI inzetten voor contractanalyse, juridisch onderzoek en due diligence moeten inzicht hebben in modeltrainingsdata om vertrouwelijkheid te waarborgen en het beroepsgeheim te behouden. Overheidsinstanties moeten voldoen aan federale AI-governancedirectieven, waaronder transparantie-eisen, bias-audits en documentatie van AI-besluitvorming voor publieke verantwoording. Retail en e-commerce organisaties moeten AI-systemen monitoren die worden gebruikt in aanbevelingssystemen en personalisatie, voor compliance met consumentenbescherming en eerlijke concurrentiewetgeving. Productiebedrijven moeten AI-systemen voor kwaliteitscontrole en voorspellend onderhoud monitoren om veiligheid en betrouwbaarheid te waarborgen. Sectorspecifieke zichtbaarheidseisen moeten worden opgenomen in governance-raamwerken en niet als aparte compliance-oefeningen worden behandeld.

Organisaties die AI-zichtbaarheid in ondernemingen implementeren, moeten een gefaseerde aanpak hanteren die snelle successen oplevert en toewerkt naar volledige, volwassen governance-capaciteiten. Begin met inventarisatie en documentatie—voert een audit uit om alle AI-systemen in kaart te brengen, inclusief shadow AI, en maak een centraal register met per systeem het doel, de eigenaar, databronnen en bedrijfsbelang. Identificeer quick wins door in eerste instantie te focussen op systemen met het hoogste risico, zoals klantgerichte AI, systemen die gevoelige data verwerken of modellen die belangrijke beslissingen nemen over individuen. Implementeer centrale logging als basisfunctionaliteit die metadata vastlegt over alle AI-activiteiten, voor zowel realtime monitoring als historische analyse. Stel governancebeleid op dat standaarden definieert voor documentatie, monitoring en compliance van AI-systemen en communiceer dit helder naar alle stakeholders. Bouw crossfunctionele teams met IT, security, business en compliance, zodat zichtbaarheidinitiatieven zorgen adresseren vanuit alle organisatiedisciplines. Meet en communiceer voortgang door zichtbaarheidmetrics bij te houden en te delen met het management, om de waarde van governance-investeringen aan te tonen en draagvlak te creëren voor verdere investeringen in AI-zichtbaarheid infrastructuur.

AI-zichtbaarheid is het vermogen om te zien en te monitoren wat AI-systemen doen, terwijl AI-governance het bredere raamwerk is van beleid, processen en controles die bepalen hoe AI-systemen worden ontwikkeld, ingezet en gebruikt. Zichtbaarheid is een fundamenteel onderdeel van governance—je kunt niet besturen wat je niet kunt zien. Effectieve AI-governance vereist volledige zichtbaarheid over drie dimensies: gebruik, kwaliteit en beveiligingsmonitoring.

Grote organisaties staan voor unieke uitdagingen bij het beheren van honderden of duizenden AI-implementaties over meerdere afdelingen, cloudproviders en business units. Zonder volledige zichtbaarheid neemt shadow AI toe, stijgen compliance-risico’s en kunnen organisaties hun AI-investeringen niet optimaliseren of verantwoordelijk AI-gebruik garanderen. Zichtbaarheid stelt organisaties in staat om risico’s te identificeren, beleid af te dwingen en maximale waarde uit AI-initiatieven te halen.

Gebrekkige AI-zichtbaarheid creëert meerdere risico’s: shadow AI-systemen opereren zonder toezicht, gevoelige data kunnen worden blootgesteld via niet-gemonitorde AI-systemen, overtredingen van regelgeving blijven onopgemerkt, prestatievermindering van modellen wordt niet geïdentificeerd, beveiligingsbedreigingen worden niet opgemerkt en organisaties kunnen geen governance aantonen aan toezichthouders. Deze risico’s kunnen leiden tot datalekken, boetes, reputatieschade en verlies van klantvertrouwen.

Shadow AI—ongeautoriseerde AI-tools die zonder medeweten van IT worden ingezet—creëert blinde vlekken die centrale monitoring en governance verhinderen. Werknemers kunnen publieke AI-diensten zoals ChatGPT gebruiken zonder toezicht van de organisatie, waardoor mogelijk gevoelige data worden blootgesteld of regelgeving wordt overtreden. Shadow AI leidt ook tot dubbel werk, verspilde middelen en het onvermogen om AI-beleid en -standaarden af te dwingen.

Speciaal ontwikkelde AI-governanceplatforms zoals Liminal, Ardoq en Knostic bieden centrale monitoring, handhaving van beleid en compliance-rapportages. Deze platforms integreren met AI-diensten, leggen gedetailleerde logboeken vast, detecteren afwijkingen en bieden dashboards voor governance-teams. Daarnaast specialiseert AmICited zich in het monitoren van hoe AI-systemen uw merk vermelden op GPT’s, Perplexity en Google AI Overviews, en geeft inzicht in de kwaliteit van AI-antwoorden.

Regelgevende raamwerken zoals de EU AI Act, AVG, CCPA en sectorspecifieke regelgeving (OCC voor banken, FDA voor gezondheidszorg) stellen specifieke eisen aan zichtbaarheid en documentatie. Organisaties moeten monitoring implementeren die compliance met deze regels aantoont, waaronder audit trails, bias-tests, prestatiemonitoring en documentatie van besluitvorming door AI-systemen. De zichtbaarheid infrastructuur moet zijn ontworpen om aan deze regelgevende verplichtingen te voldoen.

Belangrijke metrics zijn: zichtbaarheidsdekking (percentage AI-systemen vastgelegd en gemonitord), governancevolwassenheid (voortgang door gedefinieerde governance stadia), incidentdetectie en reactietijd, compliance-naleving (percentage systemen dat voldoet aan regelgeving), en gerealiseerde bedrijfswaarde (tastbare voordelen van zichtbaarheidsinvesteringen). Organisaties moeten ook gebruiksmetrics (actieve gebruikers, API-calls), kwaliteitsmetrics (nauwkeurigheid, drift) en beveiligingsmetrics (gedetecteerde afwijkingen, beleidschendingen) volgen.

Implementatietijden variëren afhankelijk van de omvang en complexiteit van de organisatie. De initiële zichtbaarheid infrastructuur (inventarisatie, basislogging, dashboards) kan in 3-6 maanden worden opgezet. Het realiseren van volledige zichtbaarheid over alle AI-systemen duurt doorgaans 6-12 maanden. Het bereiken van volwassen, geoptimaliseerde governance-capaciteiten duurt meestal 12-24 maanden. Organisaties kunnen het beste gefaseerd te werk gaan, te beginnen met systemen met het hoogste risico en snelle successen, en daarna uitbouwen naar volledige dekking.

AmICited volgt hoe AI-systemen zoals GPT’s, Perplexity en Google AI Overviews uw merk en content vermelden. Krijg inzicht in de kwaliteit van AI-antwoorden en merknamen op alle grote AI-platforms.

Leer hoe je een AI-zichtbaarheidsroutekaart opstelt met kwartaaldoelen en GEO-mijlpalen. Ontvang een sjabloon, best practices en tools voor het monitoren van je...

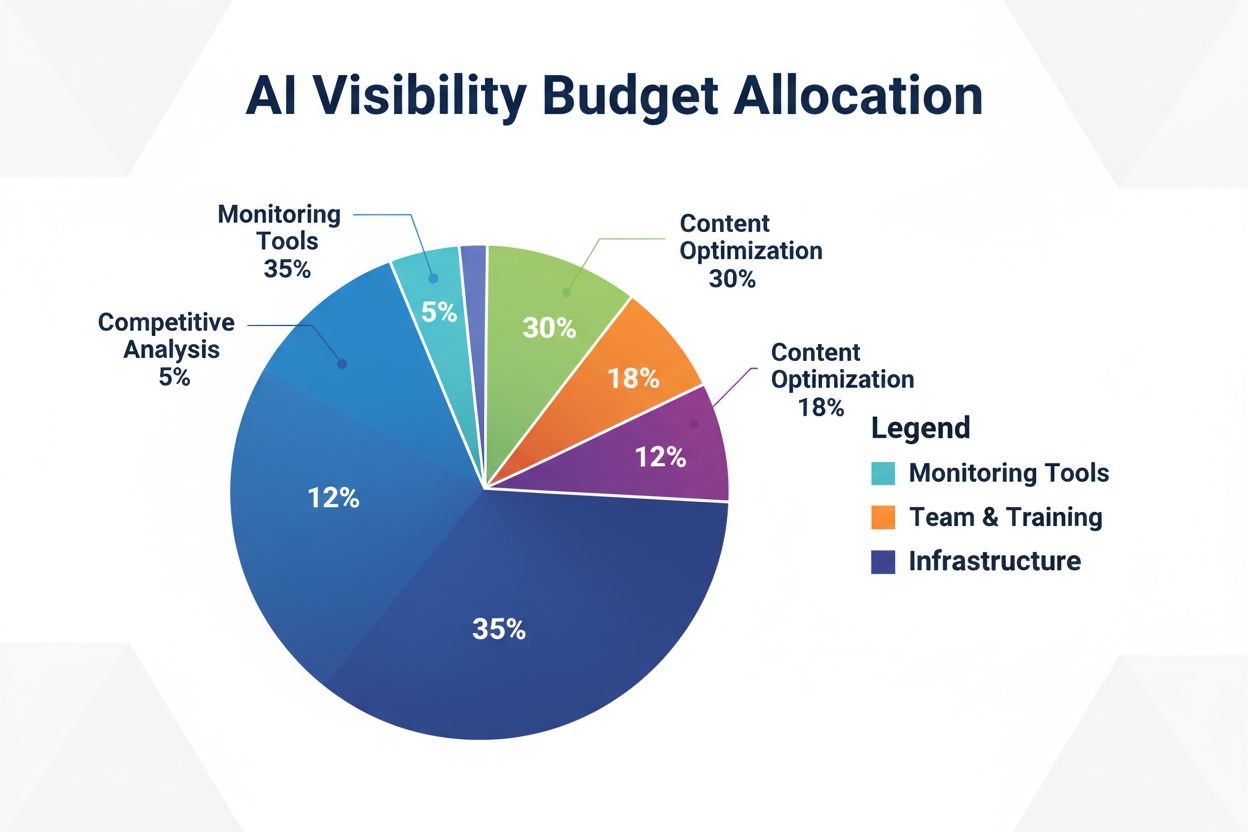

Leer hoe je je AI-zichtbaarheidsbudget strategisch toewijst over monitoringtools, contentoptimalisatie, teammiddelen en concurrentieanalyse om de ROI en merkbek...

Complete gids voor enterprise AI zichtbaarheidsoplossingen. Vergelijk topplatforms zoals Conductor, Profound en Athena. Leer evaluatiecriteria en selectie strat...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.