AI-zichtbaarheid voor financiële dienstverlening: Compliance en optimalisatie

Monitor hoe uw financiële merk verschijnt in AI-gegenereerde antwoorden. Leer compliance-eisen, zichtbaarheidsstrategieën en optimalisatietechnieken voor geregu...

Regelgevende vereisten voor financiële instellingen om transparant hun gebruik van kunstmatige intelligentie te openbaren in besluitvorming, risicobeheer en klantgerichte toepassingen. Omvat SEC-, CFPB-, FINRA- en andere toezichthoudende verwachtingen voor het documenteren van AI-governance, modelprestaties en effecten op consumenten en markten.

Regelgevende vereisten voor financiële instellingen om transparant hun gebruik van kunstmatige intelligentie te openbaren in besluitvorming, risicobeheer en klantgerichte toepassingen. Omvat SEC-, CFPB-, FINRA- en andere toezichthoudende verwachtingen voor het documenteren van AI-governance, modelprestaties en effecten op consumenten en markten.

Financiële AI-openbaarmaking verwijst naar de regelgevende vereisten en best practices voor financiële instellingen om transparant hun gebruik van kunstmatige intelligentie in besluitvormingsprocessen, risicobeheer en klantgerichte toepassingen openbaar te maken. Het omvat SEC-, CFPB-, FINRA- en andere toezichthoudende verwachtingen voor het documenteren van AI-governance, modelprestaties en potentiële effecten op consumenten en markten. In december 2024 heeft het Investor Advisory Committee (IAC) van de SEC een formele aanbeveling gedaan dat het agentschap richtlijnen moet uitvaardigen waarin uitgevers worden verplicht informatie te verstrekken over de impact van kunstmatige intelligentie op hun bedrijven. Het IAC wees op een “gebrek aan consistentie” in hedendaagse AI-openbaarmakingen, wat “problematisch kan zijn voor investeerders die op zoek zijn naar duidelijke en vergelijkbare informatie.” Slechts 40% van de S&P 500-bedrijven doet AI-gerelateerde openbaarmakingen en slechts 15% maakt informatie openbaar over toezicht van de raad van bestuur op AI, ondanks het feit dat 60% van de S&P 500-bedrijven AI als een materieel risico beschouwt.

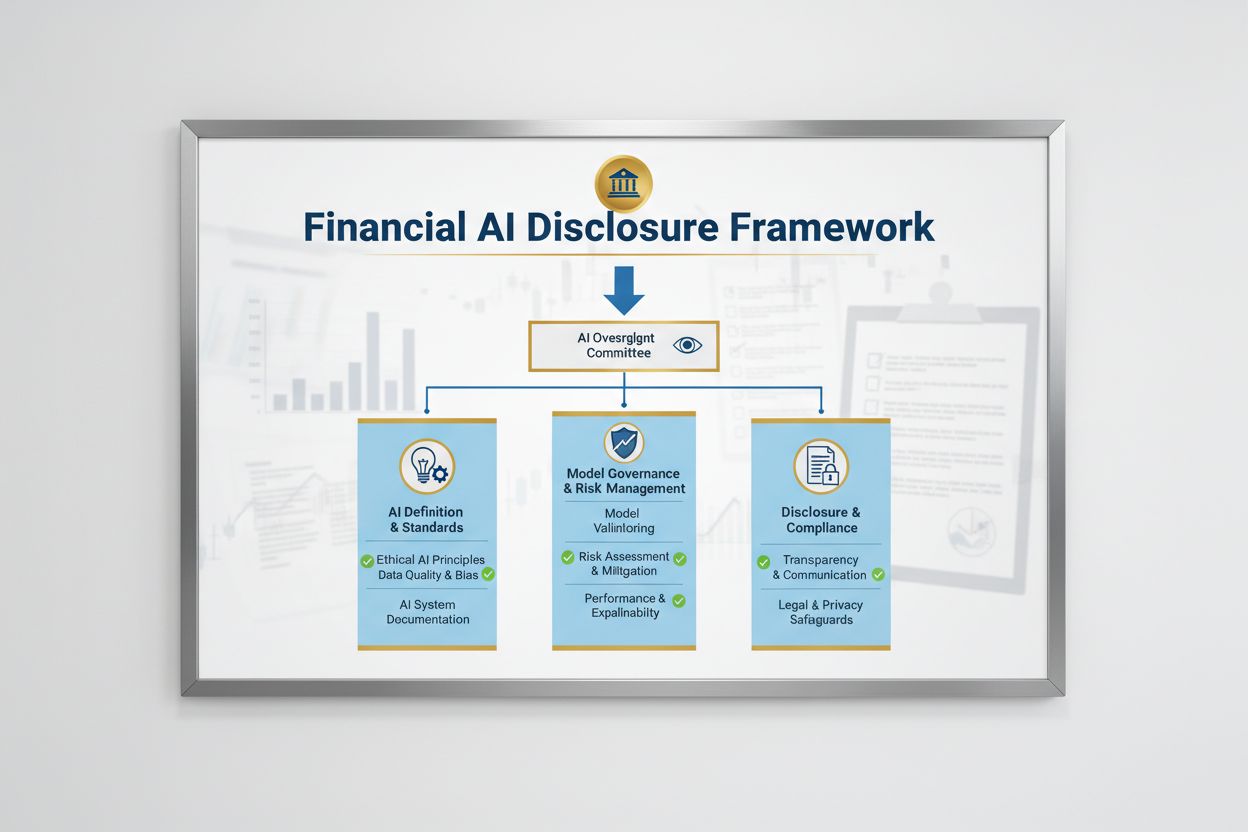

Het regelgevende landschap voor Financiële AI-openbaarmaking wordt bepaald door meerdere federale agentschappen die bestaande technologie-neutrale wetten toepassen op AI-systemen. Het Investor Advisory Committee van de SEC stelde een initiële raamwerk voor met drie belangrijke pijlers: (1) uitgevers verplichten te definiëren wat zij bedoelen met “Kunstmatige Intelligentie”, (2) openbaar maken van toezicht door de raad van bestuur op AI-implementatie, en (3) rapporteren over materiële AI-implementaties en de effecten daarvan op interne operaties en klantgerichte producten. Naast de SEC hebben de CFPB, FINRA, OCC en Federal Reserve allemaal richtlijnen uitgegeven waarin wordt benadrukt dat bestaande consumentenbeschermingswetten—waaronder eerlijke kredietverlening, gegevensprivacy en anti-fraude wetten—van toepassing zijn op AI-systemen, ongeacht de gebruikte technologie. Deze instanties hanteren een technologie-neutrale benadering, wat betekent dat nalevingsverplichtingen onder de Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) en Unfair or Deceptive Acts or Practices (UDAAP) ongewijzigd blijven wanneer AI wordt ingezet.

| Toezichthouder | Focusgebied | Belangrijkste vereiste |

|---|---|---|

| SEC | Investeerdersopenbaarmaking, belangenconflicten | Definieer AI, maak toezicht door de raad openbaar, rapporteer materiële implementaties |

| CFPB | Eerlijke kredietverlening, consumentenbescherming | Zorg dat AI-modellen voldoen aan ECOA, verstrek negatieve beslissingsbrieven |

| FINRA | Broker-dealer activiteiten, klantcommunicatie | Stel AI-governancebeleid op, houd toezicht op AI-gebruik in alle functies |

| OCC/Federal Reserve/FDIC | Bankmodelgovernance, operationeel risico | Valideer AI-modellen, documenteer controles, beoordeel betrouwbaarheid |

| FTC | Misleidende praktijken, gegevensbeheer | Monitor AI-gerelateerde claims, voorkom oneerlijk datagebruik |

Effectieve Financiële AI-openbaarmaking vereist duidelijk toezicht door de raad van bestuur op de inzet van kunstmatige intelligentie en risicobeheer. De IAC-aanbeveling van de SEC benadrukt dat investeerders er belang bij hebben te weten of er duidelijke lijnen van verantwoordelijkheid zijn omtrent de inzet van AI-technologie bij interne bedrijfsvoering en productlijnen. Financiële instellingen moeten governance-structuren opzetten waarin verantwoordelijkheid voor AI-toezicht bij de raad van bestuur of een aangewezen commissies ligt, zodat AI-gerelateerde risico’s op het hoogste niveau van de organisatie worden beheerd. Dit governancekader moet gedocumenteerd beleid en procedures bevatten voor AI-ontwikkeling, -testen, -validatie en -implementatie, met regelmatige rapportages aan de raad over modelprestaties, geconstateerde risico’s en herstelmaatregelen. Zonder duidelijke verantwoording op bestuursniveau lopen financiële instellingen het risico op toezicht door toezichthouders en mogelijke handhavingsmaatregelen wegens onvoldoende toezicht op materiële AI-systemen.

Financiële instellingen moeten de materiële effecten van AI-implementatie op interne bedrijfsvoering en klantgerichte producten afzonderlijk openbaar maken. Voor interne operaties moeten openbaarmakingen de impact van AI op menselijk kapitaal (zoals personeelsreductie of omscholing), nauwkeurigheid van financiële verslaglegging, governanceprocessen en cyberbeveiligingsrisico’s behandelen. Voor klantgerichte aspecten moeten instellingen investeringen in AI-gedreven platforms, integratie van AI in producten en diensten, regelgevende gevolgen van AI-gebruik en de invloed van AI op prijsstrategieën of zakelijke benchmarks openbaar maken. De SEC adviseert om deze openbaarmakingen te integreren in bestaande Regulation S-K openbaarmakingsonderdelen (zoals Items 101, 103, 106 en 303) op basis van materialiteit, in plaats van volledig nieuwe openbaarmakingscategorieën te creëren. Deze benadering stelt financiële instellingen in staat gebruik te maken van bestaande openbaarmakingskaders, terwijl investeerders duidelijke, vergelijkbare informatie krijgen over de rol van AI in de bedrijfsvoering en strategische richting van de organisatie.

Hoogwaardige data vormt de basis voor verantwoord AI-gebruik in financiële dienstverlening, maar veel instellingen worstelen met datagovernance-kaders die voldoen aan de verwachtingen van toezichthouders. Financiële instellingen moeten ervoor zorgen dat data die wordt gebruikt om AI-modellen te trainen, testen en valideren, schoon, compleet, gestandaardiseerd en volledig is, met duidelijke documentatie van gegevensbronnen, herkomst en eventuele bekende beperkingen. Databeveiliging moet “datavergiftiging”—het manipuleren van trainingsdata om de integriteit van het model te ondermijnen—voorkomen en bescherming bieden tegen ongeautoriseerde toegang tot of openbaarmaking van gevoelige informatie. De Gramm-Leach-Bliley Act (GLBA) biedt basisbescherming voor financiële consumentendata, maar veel toezichthouders en consumentenorganisaties vinden deze bescherming onvoldoende in de context van AI, vooral gezien de uitbreiding van dataverzameling en -gebruik voor modeltraining. Financiële instellingen moeten ook intellectuele eigendomsrechten respecteren, zorgen dat zij toestemming hebben om data te gebruiken voor AI-ontwikkeling en de rechten van derden respecteren. Het implementeren van robuuste datagovernance, waaronder dataminimalisatie, toegangscontroles en regelmatige audits, is essentieel om te voldoen aan de verwachtingen van toezichthouders.

Toezichthoudende instanties hebben duidelijk gemaakt dat AI-modellen die worden gebruikt bij financiële besluitvorming getest moeten worden op bias en mogelijk discriminerende uitkomsten, ongeacht de algehele nauwkeurigheid of prestaties van het model. Het “black box”-probleem—waarbij complexe AI-systemen outputs genereren die moeilijk of niet uit te leggen zijn—vormt een groot compliance risico, vooral bij klantgerichte toepassingen zoals kredietbeoordeling, prijsstelling en fraudedetectie. Financiële instellingen moeten processen implementeren om bias te detecteren en te mitigeren gedurende de hele levenscyclus van het model, inclusief bias-testing tijdens ontwikkeling, validatie en voortdurende monitoring. Naleving van eerlijke kredietverlening vereist dat instellingen de specifieke redenen voor negatieve beslissingen (zoals kredietweigeringen) kunnen uitleggen en aantonen dat hun AI-modellen geen ongerechtvaardigd nadelig effect hebben op beschermde groepen. Toezichthouders verwachten steeds vaker dat er wordt getest op “minder discriminerende alternatieven”—methoden die dezelfde zakelijke doelen bereiken met minder bias. Veel instellingen adopteren uitlegbare AI (xAI)-technieken, zoals feature importance analyse en beslisbomen, om transparantie en verantwoording in AI-gedreven beslissingen te verbeteren.

Financiële instellingen die AI gebruiken in klantgerichte toepassingen moeten voldoen aan bestaande consumentenbeschermingswetten, waaronder eisen voor negatieve beslissingsbrieven, privacyverklaringen en eerlijke behandeling. Wanneer een AI-systeem wordt gebruikt om beslissingen over krediet, verzekeringen of andere financiële producten te nemen of sterk te beïnvloeden, hebben consumenten recht op uitleg over waarom zij zijn afgewezen of minder gunstige voorwaarden hebben gekregen. De CFPB benadrukt dat kredietverstrekkers die onder de Equal Credit Opportunity Act (ECOA) vallen geen “black box”-modellen mogen gebruiken als zij geen specifieke en juiste redenen voor negatieve beslissingen kunnen geven. Daarnaast is de Unfair or Deceptive Acts or Practices (UDAAP)-standaard van toepassing op AI-gedreven systemen die consumenten kunnen schaden door ondoorzichtige dataverzameling, privacyovertredingen of het sturen naar ongeschikte producten. Financiële instellingen moeten ervoor zorgen dat AI-systemen die worden gebruikt voor klantenservice, productaanbevelingen en accountbeheer transparant zijn over het gebruik van AI en duidelijke informatie geven over hoe consumentendata wordt verzameld, gebruikt en beschermd.

De meeste financiële instellingen vertrouwen op externe leveranciers voor de ontwikkeling, implementatie of het onderhoud van AI-systemen, wat aanzienlijke verplichtingen met zich meebrengt voor third-party risk management (TPRM). De Interagency Guidance on Third-Party Relationships van de federale banktoezichthouders benadrukt dat financiële instellingen verantwoordelijk blijven voor de prestaties en naleving van externe AI-systemen, zelfs als zij het model niet zelf hebben ontwikkeld. Effectief TPRM voor AI vereist grondige due diligence voorafgaand aan samenwerking met een leverancier, inclusief beoordeling van datagovernance, modelvalidatieprocessen en de mogelijkheid om transparantie in de modelwerking te bieden. Financiële instellingen moeten ook letten op concentratierisico—de potentiële systemische impact als een klein aantal AI-leveranciers storingen of uitval ervaart. Supply chain-risico’s, zoals de betrouwbaarheid van gegevensbronnen en de stabiliteit van de infrastructuur van derden, moeten worden geëvalueerd en gedocumenteerd. Contracten met AI-leveranciers moeten duidelijke eisen bevatten voor databeveiliging, monitoring van modelprestaties, incidentrapportage en de mogelijkheid om het AI-systeem te auditen of te testen. Vooral kleinere financiële instellingen kunnen moeite hebben met de technische expertise die nodig is om complexe AI-systemen te beoordelen, wat een behoefte creëert aan industriestandaarden of certificeringsprogramma’s ter ondersteuning van leveranciersbeoordeling.

Financiële instellingen die grensoverschrijdend actief zijn, worden geconfronteerd met een steeds complexer lappendeken van AI-regelgeving, waarbij de AI Act van de Europese Unie het meest uitgebreide regelgevingskader tot nu toe vormt. De EU AI Act classificeert AI-systemen die worden gebruikt voor kredietbeoordeling, fraudepreventie en anti-witwaspraktijken als “hoog risico”, met uitgebreide vereisten voor documentatie, bias-testing, menselijk toezicht en conformiteitsbeoordelingen. De OESO en G7 hebben eveneens principes en aanbevelingen gepubliceerd voor verantwoord AI-beheer in de financiële sector, met nadruk op transparantie, eerlijkheid, verantwoording en menselijk toezicht. Veel van deze internationale standaarden hebben extraterritoriale werking, wat betekent dat financiële instellingen die klanten bedienen in de EU, het VK of andere gereguleerde rechtsgebieden aan deze standaarden moeten voldoen, zelfs als zij elders zijn gevestigd. Pogingen tot regelgevende harmonisatie zijn gaande, maar er blijven aanzienlijke verschillen tussen jurisdicties bestaan, wat compliance-uitdagingen oplevert voor wereldwijde financiële instellingen. Proactieve afstemming op de hoogste internationale standaarden—zoals de EU AI Act en OESO-principes—helpt instellingen zich voor te bereiden op toekomstige regelgeving en het risico op handhavingsmaatregelen in meerdere rechtsgebieden te verminderen.

Financiële instellingen dienen uitgebreide documentatie en governancepraktijken te implementeren om te voldoen aan de verwachtingen voor Financiële AI-openbaarmaking. Belangrijke best practices zijn onder meer:

Door deze praktijken te volgen, kunnen financiële instellingen het regelgevingsrisico verlagen, vertrouwen van belanghebbenden opbouwen en zich profileren als leiders in verantwoord AI-gebruik binnen de financiële dienstverlening.

Financiële AI-openbaarmaking verwijst naar de regelgevende vereisten voor financiële instellingen om transparant hun gebruik van kunstmatige intelligentie in besluitvorming, risicobeheer en klantgerichte toepassingen te openbaren. Het omvat SEC-, CFPB-, FINRA- en andere toezichthoudende verwachtingen voor het documenteren van AI-governance, modelprestaties en effecten op consumenten en markten. Het Investor Advisory Committee van de SEC adviseerde in december 2024 dat financiële instellingen hun gebruik van AI moeten definiëren, toezicht door de raad van bestuur moeten openbaren en rapporteren over materiële AI-implementaties.

Financiële instellingen moeten het gebruik van AI openbaar maken om investeerders, consumenten en de integriteit van de markt te beschermen. Toezichthouders hebben vastgesteld dat slechts 40% van de S&P 500-bedrijven AI-gerelateerde openbaarmakingen doet, wat zorgt voor inconsistentie en informatiekloven voor investeerders. Openbaarmakingsvereisten zorgen ervoor dat belanghebbenden begrijpen hoe AI financiële beslissingen, risicobeheer en consumentenresultaten beïnvloedt. Daarnaast zijn bestaande consumentenbeschermingswetten—waaronder regels voor eerlijke kredietverlening en gegevensprivacy—van toepassing op AI-systemen, waardoor openbaarmaking essentieel is voor naleving van wet- en regelgeving.

Het Investor Advisory Committee van de SEC adviseerde drie belangrijke pijlers voor AI-openbaarmaking: (1) van uitgevers eisen dat zij definiëren wat zij bedoelen met 'Kunstmatige Intelligentie', (2) openbaar maken van toezicht door de raad van bestuur op AI-implementatie, en (3) rapporteren over materiële AI-implementaties en de effecten daarvan op interne operaties en klantgerichte producten. Deze aanbevelingen zijn bedoeld om investeerders duidelijke, vergelijkbare informatie te geven over hoe AI de bedrijfsvoering en strategische richting van financiële instellingen beïnvloedt.

Financiële AI-openbaarmaking richt zich specifiek op regelgevende vereisten voor transparante communicatie over AI-gebruik naar externe belanghebbenden (investeerders, toezichthouders, consumenten), terwijl algemene AI-governance verwijst naar interne processen en controles voor het beheren van AI-systemen. Openbaarmaking is het externe onderdeel van AI-governance, dat ervoor zorgt dat belanghebbenden toegang hebben tot relevante informatie over AI-implementatie, risico's en effecten. Beide zijn essentieel voor verantwoord AI-gebruik in financiële dienstverlening.

AI-implementatie openbaarmakingen moeten zowel interne operaties als klantgerichte effecten behandelen. Voor interne operaties moeten instellingen de invloed op menselijk kapitaal, financiële verslaglegging, governance en cyberbeveiligingsrisico's openbaar maken. Voor klantgerichte producten moeten openbaarmakingen investeringen in AI-gedreven platforms, integratie van AI in producten, regelgevende impact en hoe AI prijsstelling of bedrijfsstrategieën beïnvloedt omvatten. Openbaarmakingen moeten worden geïntegreerd in bestaande regelgevende openbaarmakingsonderdelen (zoals SEC Regulation S-K) op basis van materialiteit.

Wetten voor eerlijke kredietverlening, waaronder de Equal Credit Opportunity Act (ECOA) en Fair Credit Reporting Act (FCRA), zijn van toepassing op AI-systemen die worden gebruikt bij kredietbeslissingen, ongeacht de gebruikte technologie. Financiële instellingen moeten de specifieke redenen voor negatieve beslissingen (zoals kredietweigeringen) kunnen uitleggen en aantonen dat hun AI-modellen geen ongerechtvaardigd nadelig effect hebben op beschermde groepen. Toezichthouders verwachten dat instellingen AI-modellen testen op vooringenomenheid, 'minder discriminerende alternatieven' toepassen waar mogelijk en documentatie bijhouden van eerlijkheidstesten en validatie.

De meeste financiële instellingen vertrouwen voor AI-systemen op externe leveranciers, wat aanzienlijke verplichtingen met zich meebrengt voor third-party risk management (TPRM). Financiële instellingen blijven verantwoordelijk voor de prestaties en naleving van externe AI-systemen, zelfs als zij het model niet zelf hebben ontwikkeld. Effectief TPRM voor AI vereist grondige due diligence, voortdurende monitoring, beoordeling van gegevensbeheerpraktijken van de leverancier en documentatie van modelprestaties. Instellingen moeten ook letten op concentratierisico—de mogelijke systemische impact als een klein aantal AI-leveranciers problemen ondervindt.

De AI Act van de Europese Unie is het meest uitgebreide regelgevingskader voor AI en classificeert financiële AI-systemen als 'hoog risico', met uitgebreide documentatie-, bias-test- en menselijk toezichtseisen. De OESO en G7 hebben ook principes voor verantwoord AI-beheer gepubliceerd. Veel van deze internationale standaarden zijn extraterritoriaal van toepassing, wat betekent dat financiële instellingen die klanten in gereguleerde rechtsgebieden bedienen aan deze standaarden moeten voldoen. Proactieve afstemming op internationale standaarden kan instellingen helpen zich voor te bereiden op toekomstige regelgeving en handhavingsrisico's te verkleinen.

Volg hoe uw financiële instelling wordt genoemd in AI-antwoorden van GPT's, Perplexity en Google AI Overviews. Zorg dat uw merk zichtbaar en accuraat blijft in door AI gegenereerde financiële content.

Monitor hoe uw financiële merk verschijnt in AI-gegenereerde antwoorden. Leer compliance-eisen, zichtbaarheidsstrategieën en optimalisatietechnieken voor geregu...

Ontdek hoe financiële instellingen kunnen optimaliseren voor AI-zoekmachines en zichtbaarheid in AI-gegenereerde antwoorden kunnen waarborgen. Ontdek strategieë...

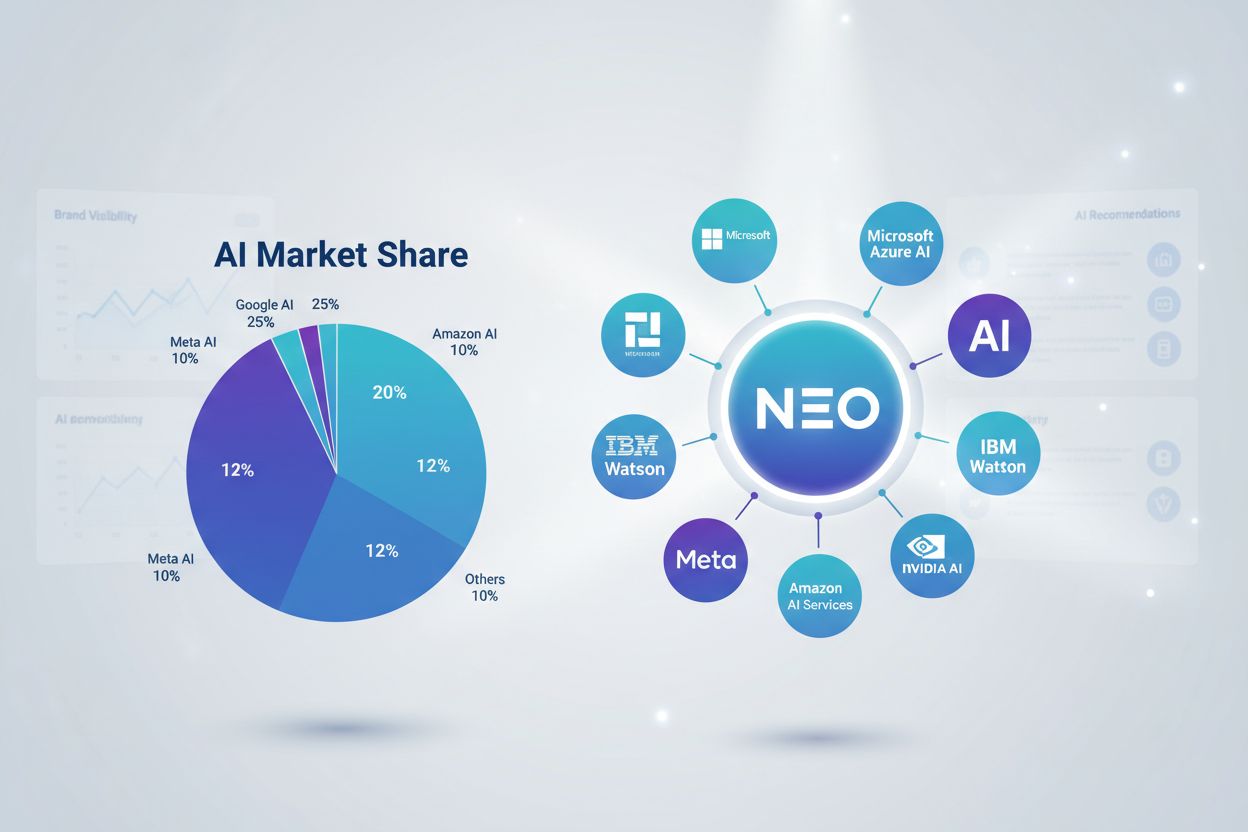

Ontdek wat AI-marktaandeel is, hoe je het meet op ChatGPT, Perplexity, Google AI Overviews en andere platforms, en waarom het belangrijk is voor de concurrentie...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.