Wat is GPTBot en Moet Je Het Toestaan? Complete Gids voor Website-eigenaren

Ontdek wat GPTBot is, hoe het werkt en of je OpenAI's webcrawler moet toestaan of blokkeren. Begrijp de impact op je merkzichtbaarheid in AI-zoekmachines en Cha...

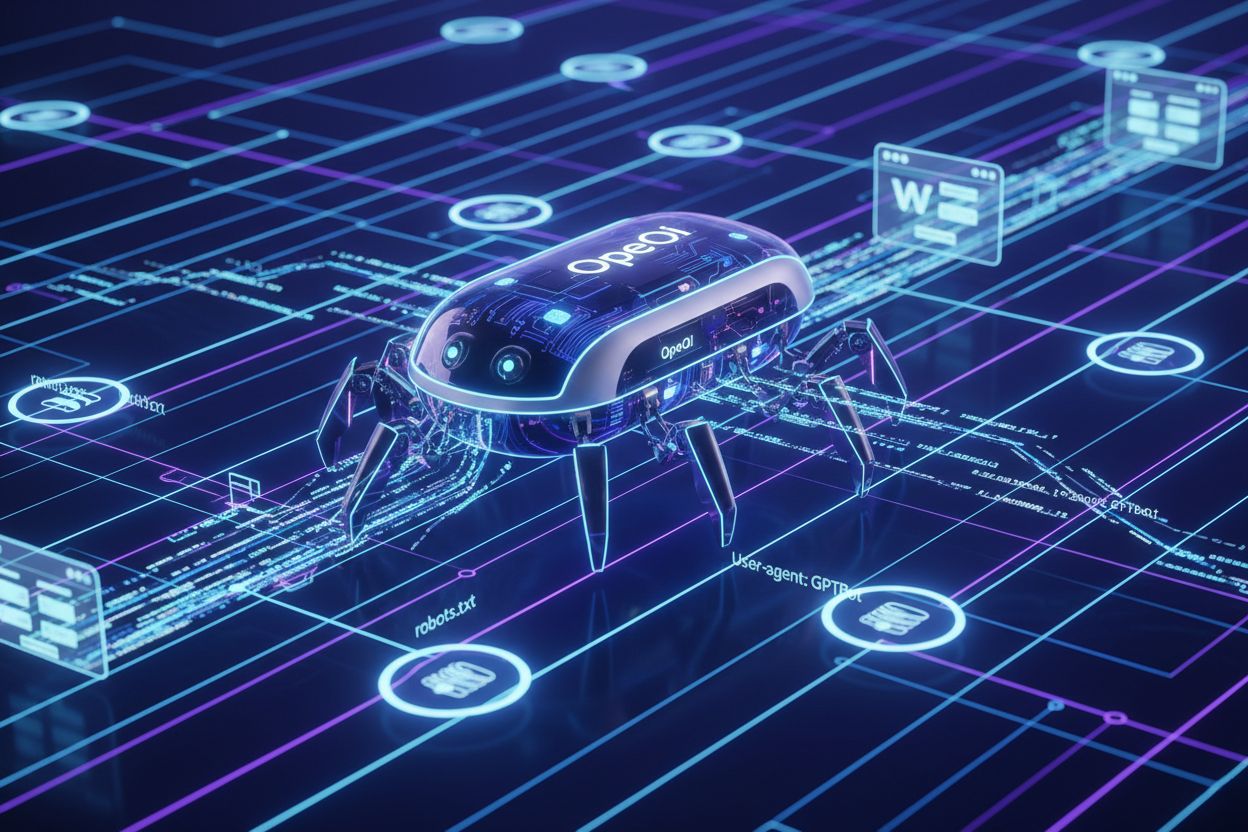

De officiële webcrawler van OpenAI die trainingsdata verzamelt voor AI-modellen zoals ChatGPT en GPT-4. Website-eigenaren kunnen toegang beheren via robots.txt met ‘User-agent: GPTBot’-richtlijnen. De crawler respecteert standaard webprotocollen en indexeert alleen publiek toegankelijke content.

De officiële webcrawler van OpenAI die trainingsdata verzamelt voor AI-modellen zoals ChatGPT en GPT-4. Website-eigenaren kunnen toegang beheren via robots.txt met 'User-agent: GPTBot'-richtlijnen. De crawler respecteert standaard webprotocollen en indexeert alleen publiek toegankelijke content.

GPTBot is de officiële webcrawler van OpenAI, ontwikkeld om publiek toegankelijke content van het internet te indexeren voor het trainen en verbeteren van AI-modellen zoals ChatGPT en GPT-4. In tegenstelling tot algemene zoekmachine-crawlers zoals Googlebot, heeft GPTBot een specifieke missie: data verzamelen waarmee OpenAI zijn taalmodellen kan verbeteren en gebruikers betere AI-gestuurde antwoorden kan bieden. Website-eigenaren kunnen GPTBot herkennen aan de kenmerkende user agent string (“GPTBot/1.0”), die verschijnt in serverlogs en analysetools zodra de crawler hun pagina’s bezoekt. GPTBot respecteert het robots.txt-bestand, wat betekent dat website-eigenaren kunnen bepalen of de crawler toegang krijgt tot hun content door bepaalde richtlijnen aan dit bestand toe te voegen. De crawler indexeert alleen publiek toegankelijke content en probeert geen authenticatie te omzeilen of toegang te krijgen tot afgeschermde delen van websites. Het begrijpen van het doel en gedrag van GPTBot is essentieel voor website-eigenaren die weloverwogen beslissingen willen nemen over het al dan niet toestaan of blokkeren van deze crawler op hun digitale eigendommen.

GPTBot werkt door systematisch webpagina’s te crawlen, de inhoud te analyseren en data terug te sturen naar de servers van OpenAI voor verwerking en modeltraining. De crawler controleert eerst het robots.txt-bestand van een website om te bepalen welke pagina’s toegankelijk zijn, waarbij de richtlijnen van de website-eigenaar worden gerespecteerd voordat er wordt geïndexeerd. Zodra GPTBot zichzelf kenbaar maakt via de user agent string, downloadt en verwerkt het de paginacontent, waarbij tekst, metadata en structurele informatie wordt geëxtraheerd voor trainingsdatasets. De crawler kan aanzienlijke bandbreedte verbruiken, waarbij sommige websites meer dan 30TB aan maandelijkse crawlertraffic melden voor alle bots samen, hoewel de individuele impact van GPTBot varieert afhankelijk van de grootte en relevantie van de site.

| Crawlernaam | Doel | Respecteert robots.txt | Impact op SEO | Datagebruik |

|---|---|---|---|---|

| GPTBot | AI-modeltraining | Ja | Indirect (AI-zichtbaarheid) | Trainingsdatasets |

| Googlebot | Zoekindexatie | Ja | Direct (rankings) | Zoekresultaten |

| Bingbot | Zoekindexatie | Ja | Direct (rankings) | Zoekresultaten |

| ClaudeBot | AI-modeltraining | Ja | Indirect (AI-zichtbaarheid) | Trainingsdatasets |

Website-eigenaren kunnen GPTBot-activiteit monitoren via serverlogs door te zoeken naar de specifieke user agent string, zodat zij de crawlfrequentie kunnen volgen en eventuele prestatie-impact kunnen identificeren. Het gedrag van de crawler is ontworpen om serverbronnen te respecteren, maar op drukbezochte websites kan het bandbreedtegebruik toenemen wanneer meerdere AI-crawlers gelijktijdig actief zijn.

Veel website-eigenaren kiezen ervoor GPTBot te blokkeren vanwege zorgen over contentgebruik zonder compensatie, aangezien OpenAI gecrawlde content gebruikt voor het trainen van commerciële AI-modellen zonder directe voordelen of betaling aan contentmakers te bieden. Serverbelasting vormt een andere belangrijke zorg, vooral voor kleinere websites of sites met beperkte bandbreedte, omdat AI-crawlers aanzienlijke resources kunnen verbruiken—sommige sites melden meer dan 30TB aan maandelijkse crawlertraffic voor alle bots, waarbij GPTBot daar een aanzienlijk aandeel in heeft. Data-exposure en beveiligingsrisico’s zijn zorgpunten voor makers die vrezen dat hun vertrouwelijke informatie, handelsgeheimen of gevoelige gegevens onbedoeld worden geïndexeerd en gebruikt voor AI-training, wat concurrentievoordelen of vertrouwelijkheid kan ondermijnen. Het juridische landschap rondom AI-trainingsdata is onzeker, met onopgeloste vragen over AVG-compliance, CCPA-verplichtingen en auteursrechtenschending, wat voor beide partijen aansprakelijkheidsrisico’s kan opleveren. Statistieken tonen aan dat ongeveer 3,5% van de websites GPTBot actief blokkeert, terwijl meer dan 30 grote publicaties binnen de top 100 websites de crawler blokkeren, waaronder The New York Times, CNN, Associated Press en Reuters—wat erop wijst dat invloedrijke contentmakers aanzienlijke risico’s zien. De combinatie van deze factoren maakt het blokkeren van GPTBot steeds gebruikelijker bij uitgevers, mediabedrijven en contentrijke websites die hun intellectueel eigendom willen beschermen en controle willen houden over het gebruik van hun content.

Website-eigenaren die GPTBot toestaan, erkennen de strategische waarde van zichtbaarheid in ChatGPT, aangezien het platform ongeveer 800 miljoen wekelijkse gebruikers bedient die regelmatig AI-gegenereerde antwoorden zien waarin gecrawlde content wordt genoemd of samengevat. Wanneer GPTBot een website crawlt, vergroot dit de kans dat de content van de site wordt aangehaald, samengevat of genoemd in ChatGPT-antwoorden, wat zorgt voor merkaanwezigheid binnen AI-interfaces en het bereiken van gebruikers die steeds vaker AI-tools gebruiken in plaats van traditionele zoekmachines. Onderzoek toont aan dat AI-zoekverkeer 23x beter converteert dan traditioneel organisch zoekverkeer, waardoor gebruikers die via AI-samenvattingen en -aanbevelingen content vinden, veel meer betrokken en geneigd zijn tot conversie dan gewone zoekmachinebezoekers. GPTBot toestaan is een vorm van toekomstbestendig maken, nu AI-gestuurde zoek- en contentontdekking steeds dominanter worden in de manier waarop mensen online informatie zoeken, waardoor vroege zichtbaarheid in AI-systemen een concurrentievoordeel biedt. Website-eigenaren die GPTBot omarmen, profiteren ook van Generative Engine Optimization (GEO), een opkomende discipline gericht op het optimaliseren van content voor AI-systemen in plaats van traditionele zoekalgoritmes, wat op de lange termijn aanzienlijk meer verkeer kan opleveren. Door GPTBot toe te laten, positioneren vooruitstrevende uitgevers en bedrijven zich om verkeer te trekken uit het snel groeiende segment van gebruikers die AI-tools inzetten voor informatie en beslissingen.

Het blokkeren van GPTBot is eenvoudig en vereist slechts aanpassingen aan het robots.txt-bestand van je website, dat zich in de rootdirectory bevindt en crawlertoegang regelt voor je hele domein. De simpelste methode is een volledige blokkade voor alle OpenAI-crawlers:

User-agent: GPTBot

Disallow: /

Wil je GPTBot blokkeren voor specifieke mappen en toegang tot de rest toestaan? Gebruik dan gerichte richtlijnen:

User-agent: GPTBot

Disallow: /private/

Disallow: /admin/

Disallow: /api/

Om alle OpenAI-gerelateerde crawlers te blokkeren, waaronder GPTBot, ChatGPT-User en ChatGPT-Plugins:

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ChatGPT-Plugins

Disallow: /

Naast aanpassingen in robots.txt kunnen website-eigenaren alternatieve blokkeermethoden implementeren, zoals IP-blokkering via firewalls, Web Application Firewalls (WAF) die verzoeken filteren op user agent, en rate limiting om het bandbreedteverbruik van crawlers te beperken. Voor maximale controle combineren sommige sites meerdere benaderingen—robots.txt als primaire methode in combinatie met IP-blokkering als extra bescherming tegen crawlers die robots.txt negeren. Controleer na het implementeren van een blokkeermethode altijd je serverlogs op GPTBot-user agent strings om zeker te zijn dat de crawler geen toegang meer heeft tot je content.

Bepaalde sectoren lopen extra risico bij onbeperkte toegang door AI-crawlers en moeten zorgvuldig afwegen of het blokkeren van GPTBot past bij hun bedrijfsbelangen en contentbeschermingsstrategie:

Deze sectoren moeten blokkeerstrategieën implementeren om concurrentievoordeel, vertrouwelijkheid en compliance met gegevensbescherming te waarborgen.

Website-eigenaren moeten hun serverlogs regelmatig monitoren om GPTBot-activiteit te identificeren en crawlpaden te volgen, wat inzicht geeft in hoe AI-systemen hun content benaderen en mogelijk gebruiken. GPTBot identificeren is eenvoudig—de crawler meldt zich via de user agent string “GPTBot/1.0” in HTTP-verzoekheaders, waardoor hij gemakkelijk te onderscheiden is van andere crawlers in serverlogs en analysetools. De meeste moderne analysetools en SEO-monitoringsoftware (zoals Google Analytics, Semrush, Ahrefs en gespecialiseerde botmonitoring-platforms) categoriseren en rapporteren GPTBot-activiteit automatisch, zodat website-eigenaren crawlfrequentie, bandbreedteverbruik en bezochte pagina’s kunnen volgen zonder handmatige loganalyse. Directe bestudering van serverlogs laat gedetailleerde informatie zien over GPTBot-verzoeken, inclusief tijdstempels, bezochte URL’s, response-codes en bandbreedteverbruik, wat diepgaand inzicht geeft in het crawlergedrag. Regelmatige monitoring is essentieel, omdat crawlergedrag in de tijd kan veranderen, er nieuwe AI-crawlers kunnen opduiken, en het nodig is om de effectiviteit van blokkades periodiek te controleren. Website-eigenaren doen er goed aan basiswaarden voor normaal crawlerverkeer vast te stellen en afwijkingen te onderzoeken die kunnen wijzen op toegenomen AI-crawleractiviteit of beveiligingsproblemen die aandacht vragen.

OpenAI heeft openbare toezeggingen gedaan aan verantwoordelijke AI-ontwikkeling en dataverwerking, waaronder expliciete verklaringen dat GPTBot voorkeuren van website-eigenaren respecteert zoals vastgelegd in robots.txt-bestanden en andere technische richtlijnen. Het bedrijf benadrukt dataprivacy en verantwoord AI-gebruik, en erkent dat contentmakers legitieme belangen hebben bij controle over het gebruik en de vergoeding van hun werk, hoewel OpenAI op dit moment geen directe vergoeding biedt aan gecrawlde contentmakers. Het gedocumenteerde beleid van OpenAI bevestigt dat GPTBot robots.txt-richtlijnen respecteert, wat betekent dat het bedrijf nalevingsmechanismen in zijn crawlerinfrastructuur heeft ingebouwd en verwacht dat website-eigenaren standaard technische tools inzetten voor toegangsbeheer. Het bedrijf geeft ook aan bereid te zijn in gesprek te gaan met uitgevers en contentmakers over zorgen rondom datagebruik, hoewel formele licentieovereenkomsten en vergoedingsregelingen beperkt blijven. Het beleid van OpenAI ontwikkelt zich verder onder invloed van juridische uitdagingen, regelgeving en feedback uit de sector, wat suggereert dat toekomstige versies van GPTBot mogelijk extra waarborgen, transparantiemaatregelen of vergoedingsmechanismen zullen bevatten. Website-eigenaren doen er goed aan officiële communicatie en beleidsupdates van OpenAI te volgen om te begrijpen hoe het beleid rondom contentcrawling en datagebruik in de loop der tijd verandert.

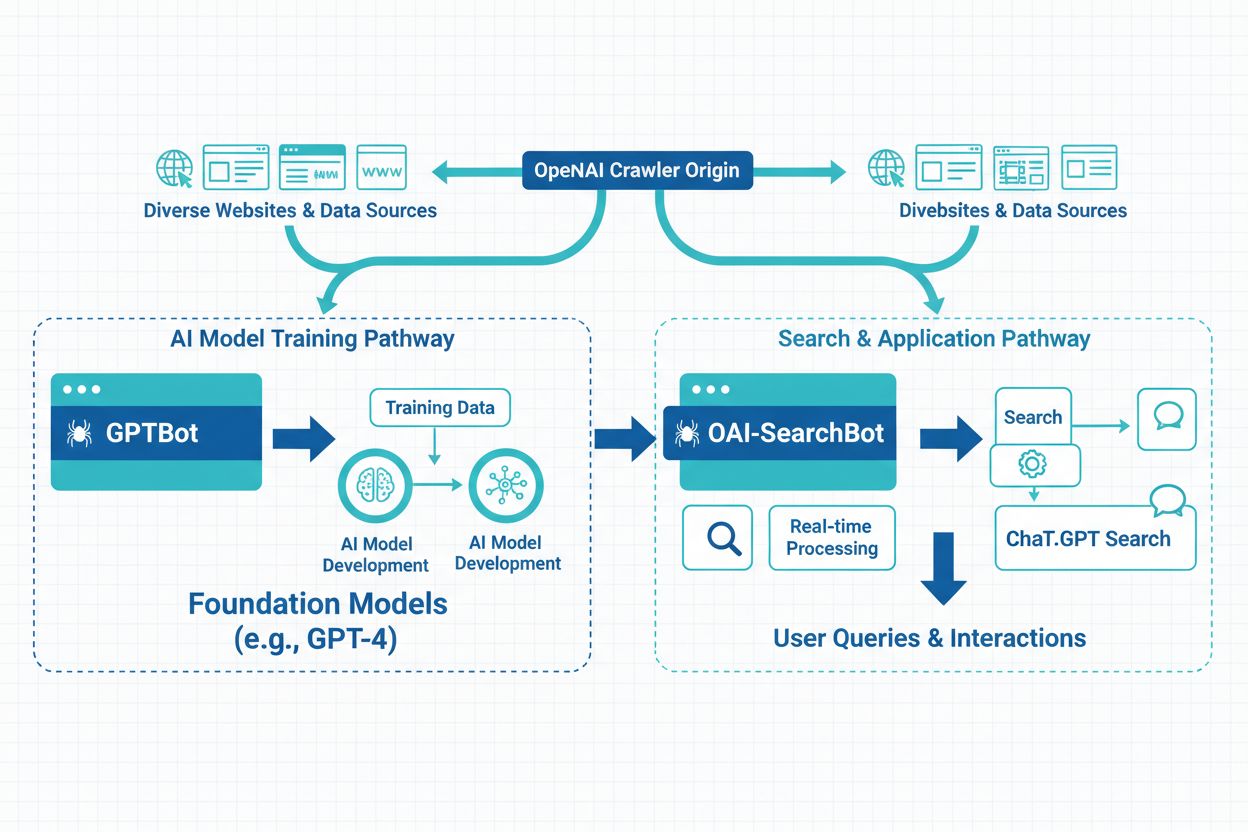

OpenAI heeft drie verschillende typen crawlers voor uiteenlopende doeleinden: GPTBot (algemene webcrawling voor modeltraining), ChatGPT-User (crawling van links gedeeld door ChatGPT-gebruikers) en ChatGPT-Plugins (toegang via plugin-integraties)—elk met eigen user agent strings en toegangspatronen. Buiten de crawlers van OpenAI kent het AI-landschap tal van andere crawlers van concurrenten: Google-Extended (Google’s AI-trainingscrawler), CCBot (Commoncrawl), Perplexity (AI-zoekmachine), Claude (Anthropic’s AI-model), en opkomende crawlers van andere AI-bedrijven, die elk verschillende doelen en datagebruikspatronen kennen. Website-eigenaren staan voor de strategische keuze tussen selectief blokkeren (specifieke crawlers als GPTBot weigeren en andere toelaten) en volledig blokkeren (alle AI-crawlers weigeren voor maximale controle over contentgebruik). Door de groei van AI-crawlers is alleen GPTBot blokkeren vaak onvoldoende om content volledig tegen AI-training te beschermen, omdat andere crawlers mogelijk alsnog toegang krijgen via alternatieve routes. Sommige website-eigenaren hanteren een gelaagde aanpak, waarbij de meest agressieve of commercieel belangrijke crawlers worden geblokkeerd en kleinere of onderzoeksgerichte crawlers worden toegestaan. Inzicht in de verschillen tussen deze crawlers helpt website-eigenaren om weloverwogen keuzes te maken over welke crawlers zij willen blokkeren, afhankelijk van hun specifieke zorgen over datagebruik, concurrentie en bedrijfsdoelen.

De invloed van ChatGPT op zoekgedrag verandert de manier waarop gebruikers informatie ontdekken ingrijpend, met 800 miljoen wekelijkse gebruikers die steeds vaker AI-tools gebruiken in plaats van traditionele zoekmachines, wat het concurrentielandschap voor zichtbaarheid drastisch verandert. AI-gegenereerde samenvattingen en featured snippets in ChatGPT-antwoorden fungeren nu als alternatieve ontdekkingsmechanismen, waardoor content die goed scoort in traditionele zoekresultaten mogelijk wordt gemist als deze niet wordt geselecteerd voor AI-antwoorden. Generative Engine Optimization (GEO) is uitgegroeid tot een cruciale discipline voor vooruitstrevende contentmakers, gericht op het optimaliseren van structuur, duidelijkheid en autoriteit van content om de kans op opname in AI-antwoorden en samenvattingen te vergroten. De langetermijnimplicaties voor zichtbaarheid zijn groot: websites die GPTBot blokkeren, missen mogelijk kansen om in ChatGPT-antwoorden te verschijnen, wat verkeer uit het snelgroeiende AI-zoeksegment kan beperken, terwijl toegestane toegang juist leidt tot AI-gestuurde vindbaarheid. Onderzoek wijst uit dat 86,5% van de content in Google’s top 20 zoekresultaten gedeeltelijk door AI wordt gegenereerd, wat laat zien dat AI-integratie standaard wordt in het zoeklandschap. Concurrentiepositie hangt in toenemende mate af van zichtbaarheid in zowel traditionele zoekmachines als AI-systemen, waardoor strategische keuzes rondom GPTBot-toegang essentieel zijn voor blijvend SEO-succes en organische groei. Website-eigenaren moeten contentbescherming zorgvuldig afwegen tegen het risico op verlies van zichtbaarheid in AI-systemen die voor miljoenen gebruikers wereldwijd de primaire vindmiddelen worden.

GPTBot is de officiële webcrawler van OpenAI, ontworpen om trainingsdata te verzamelen voor AI-modellen zoals ChatGPT en GPT-4. In tegenstelling tot Googlebot, die content indexeert voor zoekmachineresultaten, verzamelt GPTBot data specifiek om taalmodellen te verbeteren. Beide crawlers respecteren robots.txt-richtlijnen en benaderen alleen publiek beschikbare content, maar ze dienen fundamenteel verschillende doelen in het digitale ecosysteem.

De keuze hangt af van je bedrijfsdoelen en contentstrategie. Blokkeer GPTBot als je over eigendomscontent beschikt, actief bent in gereguleerde sectoren of zorgen hebt over intellectueel eigendom. Sta GPTBot toe als je zichtbaar wilt zijn in ChatGPT (800 miljoen wekelijkse gebruikers), wilt profiteren van AI-zoekverkeer (dat 23x beter converteert dan organisch) of je digitale aanwezigheid wilt voorbereiden op AI-gedreven zoeken.

Voeg deze regels toe aan je robots.txt-bestand om GPTBot te blokkeren van je hele site: User-agent: GPTBot / Disallow: /. Om specifieke mappen te blokkeren, vervang je de schuine streep door het pad van de map. Om alle OpenAI-crawlers te blokkeren, voeg je aparte User-agent-regels toe voor GPTBot, ChatGPT-User en ChatGPT-Plugins. Wijzigingen zijn direct van kracht en eenvoudig om te keren.

De impact van GPTBot varieert afhankelijk van de grootte van je site en de relevantie van de content. Hoewel de impact van een enkele crawler meestal beheersbaar is, kunnen meerdere AI-crawlers tegelijk aanzienlijke bandbreedte verbruiken—sommige sites melden meer dan 30TB aan maandelijkse crawlertraffic voor alle bots samen. Controleer je serverlogs om GPTBot-activiteit te volgen en implementeer rate limiting of IP-blokkering als het bandbreedteverbruik problematisch wordt.

Ja, je kunt gerichte robots.txt-richtlijnen gebruiken om GPTBot te blokkeren voor specifieke mappen of pagina's terwijl je toegang tot andere delen toestaat. Zo kun je bijvoorbeeld de mappen /private/ en /admin/ blokkeren en de rest van je site openlaten. Deze selectieve benadering stelt je in staat gevoelige content te beschermen en toch zichtbaar te blijven in AI-systemen voor publieke pagina's.

Controleer je serverlogs op de user agent string 'GPTBot/1.0' in HTTP-verzoekheaders. De meeste analysetools (Google Analytics, Semrush, Ahrefs) categoriseren en rapporteren GPTBot-activiteit automatisch. Je kunt ook SEO-monitoringtools gebruiken die specifiek AI-crawleractiviteit volgen. Regelmatige monitoring helpt je om de crawlfrequentie te begrijpen en eventuele prestatie-impact te identificeren.

Het juridische landschap is nog in ontwikkeling. Het toelaten van GPTBot roept vragen op over AVG-compliance, CCPA-verplichtingen en auteursrechtenschending, hoewel OpenAI beweert robots.txt-richtlijnen te respecteren. GPTBot blokkeren is juridisch eenvoudig, maar kan je zichtbaarheid in AI-systemen beperken. Raadpleeg juridisch advies als je actief bent in gereguleerde sectoren of gevoelige data verwerkt om de beste aanpak voor jouw situatie te bepalen.

GPTBot toestaan heeft geen direct effect op traditionele Google-rankings, maar verhoogt je zichtbaarheid in ChatGPT-antwoorden en andere AI-zoekresultaten. Met 800 miljoen ChatGPT-gebruikers en AI-zoekverkeer dat 23x beter converteert dan organisch, positioneer je jezelf voor langdurige zichtbaarheid in AI-systemen door GPTBot toe te laten. Het blokkeren van GPTBot kan kansen op opname in AI-gegenereerde antwoorden verminderen en daarmee verkeer uit het snelst groeiende zoeksegment beperken.

Volg hoe je merk verschijnt in ChatGPT, Perplexity, Google AI en andere AI-platforms. Krijg realtime inzichten in AI-vermeldingen en zichtbaarheid met AmICited.

Ontdek wat GPTBot is, hoe het werkt en of je OpenAI's webcrawler moet toestaan of blokkeren. Begrijp de impact op je merkzichtbaarheid in AI-zoekmachines en Cha...

Ontdek de belangrijkste verschillen tussen de GPTBot- en OAI-SearchBot-crawlers. Begrijp hun doelen, crawlgedrag en hoe je ze beheert voor optimale contentzicht...

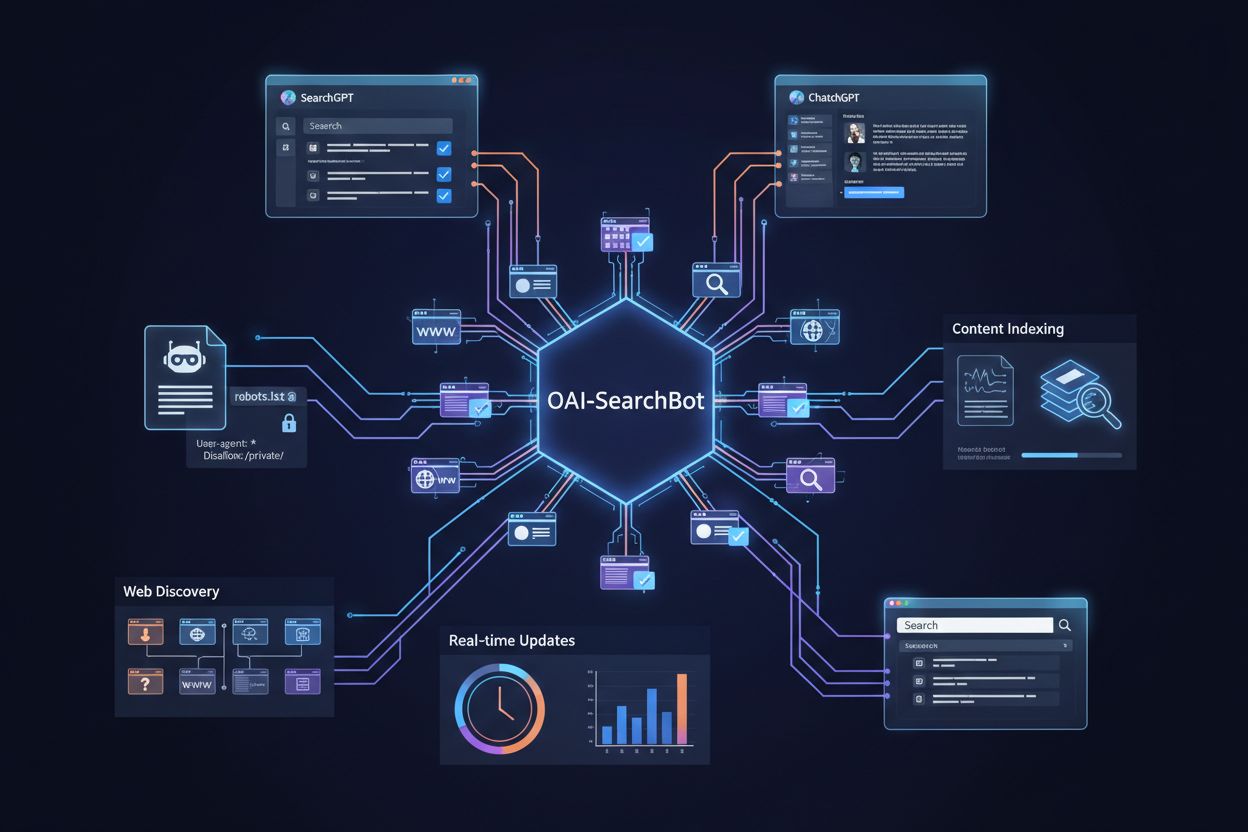

Leer wat OAI-SearchBot is, hoe het werkt en hoe je je website optimaliseert voor OpenAI's toegewijde zoekcrawler die wordt gebruikt door SearchGPT en ChatGPT.

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.