Detectie van AI-inhoud

Ontdek wat detectie van AI-inhoud is, hoe detectietools werken met behulp van machine learning en NLP, en waarom ze belangrijk zijn voor merkmonitoring, onderwi...

Inferentie is het proces waarbij een getraind AI-model uit nieuwe invoergegevens uitkomsten, voorspellingen of conclusies genereert door patronen en kennis toe te passen die tijdens de training zijn geleerd. Het vertegenwoordigt de operationele fase waarin AI-systemen hun geleerde intelligentie toepassen op echte problemen in productieomgevingen.

Inferentie is het proces waarbij een getraind AI-model uit nieuwe invoergegevens uitkomsten, voorspellingen of conclusies genereert door patronen en kennis toe te passen die tijdens de training zijn geleerd. Het vertegenwoordigt de operationele fase waarin AI-systemen hun geleerde intelligentie toepassen op echte problemen in productieomgevingen.

Inferentie is het proces waarbij een getraind kunstmatig intelligentiemodel uit nieuwe invoergegevens uitkomsten, voorspellingen of conclusies genereert door patronen en kennis toe te passen die tijdens de trainingsfase zijn geleerd. In de context van AI-systemen vertegenwoordigt inferentie de operationele fase waarin machine learning-modellen uit het laboratorium naar productieomgevingen gaan om echte problemen op te lossen. Wanneer je interacteert met ChatGPT, Perplexity, Google AI Overviews of Claude, ervaar je AI-inferentie in actie—het model neemt jouw input en genereert intelligente antwoorden op basis van patronen die het heeft geleerd uit enorme trainingsdatasets. Inferentie verschilt fundamenteel van training; waar training het model leert wat het moet doen, is inferentie het moment waarop het model dat daadwerkelijk toepast op data die het nooit eerder heeft gezien.

Het onderscheid tussen AI-training en AI-inferentie is cruciaal om te begrijpen hoe moderne kunstmatige intelligentiesystemen werken. Tijdens de trainingsfase voeren data scientists enorme, samengestelde datasets in neurale netwerken, zodat het model patronen, relaties en beslissingsregels leert door iteratieve optimalisatie. Dit proces is rekenintensief en duurt vaak weken of maanden op gespecialiseerde hardware zoals GPU’s en TPU’s. Zodra de training is voltooid en het model optimale gewichten en parameters heeft bereikt, begint de inferentiefase. Op dat moment is het model bevroren—het leert niet meer van nieuwe data—en past het zijn geleerde patronen toe om voorspellingen of uitkomsten te genereren op niet eerder geziene input. Volgens onderzoek van IBM en Oracle wordt de echte zakelijke waarde van AI gerealiseerd tijdens de inferentie, omdat organisaties AI-capaciteiten op schaal kunnen inzetten in productiesystemen. De AI-inferentiemarkt werd gewaardeerd op USD 106,15 miljard in 2025 en zal naar verwachting groeien tot USD 254,98 miljard in 2030, wat de explosieve vraag naar inferentiemogelijkheden in diverse sectoren weerspiegelt.

AI-inferentie werkt via een meerstapsproces dat ruwe inputgegevens omzet in intelligente uitkomsten. Wanneer een gebruiker een vraag indient bij een groot taalmodel zoals ChatGPT, start de inferentie-pijplijn met inputcodering, waarbij tekst wordt omgezet in numerieke tokens die het neuraal netwerk kan verwerken. Vervolgens doorloopt het model de prefill-fase, waarin alle input-tokens tegelijk worden verwerkt door elke laag van het neuraal netwerk, zodat het model de context en relaties binnen de vraag begrijpt. Deze fase is rekenintensief maar essentieel voor begrip. Na de prefill-fase volgt de decode-fase, waarbij het model sequentieel output-tokens genereert, één voor één, waarbij elke nieuwe token afhankelijk is van alle voorgaande tokens in de reeks. Deze sequentiële generatie veroorzaakt het kenmerkende streamingeffect dat gebruikers zien bij AI-chatbots. Tot slot zet de outputconversiefase de voorspelde tokens om in voor mensen leesbare tekst, afbeeldingen of andere formaten die gebruikers kunnen begrijpen en gebruiken. Dit gehele proces moet binnen milliseconden plaatsvinden voor realtime toepassingen, waardoor optimalisatie van inferentie-latentie een cruciale zorg is voor AI-dienstverleners.

Organisaties die AI-systemen inzetten, moeten kiezen uit drie primaire inferentie-architecturen, elk geoptimaliseerd voor verschillende use-cases en prestatie-eisen. Batch-inferentie verwerkt grote hoeveelheden data offline op geplande momenten en is ideaal voor scenario’s waar realtime reacties niet nodig zijn, zoals het genereren van dagelijkse analysetools, wekelijkse risicobeoordelingen of nachtelijke aanbevelingsupdates. Deze aanpak is efficiënt en kosteneffectief omdat duizenden voorspellingen tegelijk kunnen worden verwerkt, waardoor rekenkosten over velen worden verspreid. Online-inferentie, ook wel dynamische inferentie, genereert voorspellingen direct op aanvraag met minimale latentie en is essentieel voor interactieve applicaties zoals chatbots, zoekmachines en realtime fraudedetectie. Online-inferentie vereist geavanceerde infrastructuur om lage latentie en hoge beschikbaarheid te garanderen, vaak met cachingstrategieën en modeloptimalisatietechnieken om reacties binnen milliseconden te leveren. Streaming-inferentie verwerkt continu gegevens van sensoren, IoT-apparaten of realtime datastromen en genereert voorspellingen voor elk binnenkomend datapunt. Dit type ondersteunt toepassingen als voorspellend onderhoud bij industriële apparatuur, autonome voertuigen die sensordata in realtime verwerken, en slimme stadssystemen die continu verkeerspatronen analyseren. Elk inferentietype vraagt om andere architecturale keuzes, hardwarevereisten en optimalisatiestrategieën.

| Aspect | Batch-inferentie | Online-inferentie | Streaming-inferentie |

|---|---|---|---|

| Latentie-eis | Seconden tot minuten | Milliseconden | Realtime (sub-seconde) |

| Gegevensverwerking | Grote datasets offline | Enkele aanvragen op afroep | Continue datastroom |

| Toepassingen | Analytics, rapportages, aanbevelingen | Chatbots, zoeken, fraudedetectie | IoT-monitoring, autonome systemen |

| Kostenefficiëntie | Hoog (kosten gespreid over veel voorspellingen) | Gemiddeld (altijd-aan infrastructuur vereist) | Gemiddeld tot hoog (afhankelijk van datavolume) |

| Schaalbaarheid | Uitstekend (bulkverwerking) | Goed (load balancing vereist) | Uitstekend (gedistribueerde verwerking) |

| Modeloptimalisatie-prioriteit | Doorvoer | Balans tussen latentie en doorvoer | Balans tussen latentie en nauwkeurigheid |

| Hardwarevereisten | Standaard GPU’s/CPU’s | Hoogwaardige GPU’s/TPU’s | Gespecialiseerde edge-hardware of gedistribueerde systemen |

Inferentie-optimalisatie is een belangrijk vakgebied geworden nu organisaties AI-modellen efficiënter en kosteneffectiever willen inzetten. Kwantisatie is een van de meest impactvolle technieken, waarbij de numerieke precisie van modelgewichten wordt verlaagd van standaard 32-bits floating-point naar 8-bits of zelfs 4-bits gehele getallen. Deze reductie kan het model tot 75-90% verkleinen met behoud van 95-99% van de oorspronkelijke nauwkeurigheid, wat leidt tot snellere inferentie en minder geheugengebruik. Modelpruning verwijdert niet-kritische neuronen, verbindingen of zelfs hele lagen uit het neuraal netwerk, waardoor overbodige parameters verdwijnen die weinig bijdragen aan de voorspellingen. Onderzoek toont aan dat pruning de modelcomplexiteit met 50-80% kan verminderen zonder noemenswaardig verlies van nauwkeurigheid. Knowledge distillation traint een kleiner, sneller ‘student’-model om het gedrag van een groter, nauwkeuriger ’teacher’-model na te bootsen, zodat inzet op apparaten met beperkte middelen mogelijk wordt met behoud van voldoende prestaties. Batchverwerking-optimalisatie groepeert meerdere inferentie-aanvragen om de GPU-bezetting en doorvoer te maximaliseren. Key-value caching slaat tussentijdse berekeningen op om herhaalde berekeningen tijdens de decode-fase van taalmodel-inferentie te voorkomen. Volgens NVIDIA-onderzoek kan het combineren van meerdere optimalisatietechnieken zorgen voor 10x prestatieverbetering en 60-70% lagere infrastructuurkosten. Deze optimalisaties zijn essentieel voor grootschalige inferentie, vooral voor organisaties die duizenden gelijktijdige inferentie-aanvragen verwerken.

Hardwareversnelling is essentieel om aan de latentie- en doorvoereisen van moderne AI-inferentie te voldoen. Graphics Processing Units (GPU’s) zijn de meest gebruikte inferentieversnellers dankzij hun parallelle architectuur, die perfect past bij de matrixbewerkingen van neurale netwerken. NVIDIA GPU’s drijven het merendeel van de grote taalmodel-inferenties wereldwijd aan, waarbij gespecialiseerde CUDA-cores voor enorme parallelliteit zorgen. Tensor Processing Units (TPU’s), ontwikkeld door Google, zijn op maat gemaakte ASIC’s die specifiek zijn geoptimaliseerd voor neurale netwerkbewerkingen en bieden superieure prestaties per watt ten opzichte van algemene GPU’s voor bepaalde taken. Field-Programmable Gate Arrays (FPGA’s) bieden aanpasbare hardware die kan worden geherprogrammeerd voor specifieke inferentiewerklasten en zijn ideaal voor gespecialiseerde toepassingen. Application-Specific Integrated Circuits (ASIC’s) zoals Google’s TPU of Cerebras’ WSE-3 zijn ontworpen voor specifieke inferentietaken en leveren uitzonderlijke prestaties met beperkte flexibiliteit. De hardwarekeuze hangt af van factoren als modelarchitectuur, gewenste latentie, doorvoer, stroomverbruik en totale eigendomskosten. Voor edge-inferentie op mobiele apparaten of IoT-sensoren maken gespecialiseerde edge-versnellers en neurale verwerkingseenheden (NPU’s) efficiënte inferentie mogelijk met minimaal stroomverbruik. De wereldwijde verschuiving naar AI-fabrieken—zeer geoptimaliseerde infrastructuren voor grootschalige intelligentieproductie—heeft geleid tot enorme investeringen in inferentiehardware, waarbij bedrijven duizenden GPU’s en TPU’s inzetten in datacenters om te voldoen aan de groeiende vraag naar AI-diensten.

Generatieve AI-systemen zoals ChatGPT, Claude en Perplexity zijn volledig afhankelijk van inferentie om mensachtige tekst, code, afbeeldingen en andere inhoud te genereren. Wanneer je een prompt aan deze systemen geeft, start het inferentieproces met het omzetten van je input naar numerieke representaties die het neuraal netwerk kan verwerken. Vervolgens voert het model de prefill-fase uit, waarbij alle input-tokens tegelijk worden verwerkt om een volledig begrip op te bouwen van je verzoek, inclusief context, intentie en nuance. Daarna volgt de decode-fase, waarin output-tokens sequentieel worden gegenereerd, telkens de meest waarschijnlijke volgende token voorspellend op basis van alle voorgaande tokens en de geleerde patronen uit de trainingsdata. Deze token-voor-token generatie zorgt ervoor dat je streaming tekst in realtime ziet verschijnen bij het gebruik van deze diensten. Het inferentieproces moet verschillende, vaak conflicterende doelen balanceren: het genereren van nauwkeurige, samenhangende en contextueel passende antwoorden met lage latentie om gebruikers betrokken te houden. Speculatieve decodering, een geavanceerde inferentie-optimalisatietechniek, laat een kleiner model meerdere toekomstige tokens voorspellen terwijl het grotere model deze voorspellingen valideert, wat de latentie aanzienlijk verlaagt. De schaal van inferentie voor grote taalmodellen is enorm—OpenAI’s ChatGPT verwerkt dagelijks miljoenen inferentie-aanvragen, elk met honderden tot duizenden tokens, wat een immense infrastructuur en geavanceerde optimalisaties vereist om economisch haalbaar te blijven.

Voor organisaties die hun merk en contentvermelding in AI-gegenereerde antwoorden willen volgen, is inferentie-monitoring steeds belangrijker geworden. Wanneer AI-systemen als Perplexity, Google AI Overviews of Claude antwoorden genereren, voeren zij inferentie uit op hun getrainde modellen om uitkomsten te produceren waarin jouw domein, merk of content kan worden genoemd of geciteerd. Inzicht in hoe inferentiesystemen werken, helpt organisaties hun contentstrategie te optimaliseren voor een juiste weergave in AI-antwoorden. AmICited specialiseert zich in het monitoren van waar merken en domeinen verschijnen in AI-inferentie-uitkomsten op verschillende platformen en biedt inzicht in hoe AI-systemen jouw content citeren en benoemen. Deze monitoring is cruciaal omdat inferentiesystemen antwoorden kunnen genereren die je merk wel of niet noemen op basis van de kwaliteit van trainingsdata, relevantiesignalen en modeloptimalisatie. Organisaties kunnen met inferentie-monitoringdata zien welke content wordt geciteerd, hoe vaak hun merk in AI-antwoorden verschijnt en of hun domein correct wordt toegeschreven. Deze inzichten maken datagedreven beslissingen mogelijk over contentoptimalisatie, SEO-strategie en merkpositionering in het opkomende AI-gedreven zoeklandschap. Nu inferentie het belangrijkste kanaal wordt voor informatieontdekking, is het volgen van je aanwezigheid in AI-uitkomsten net zo belangrijk als traditionele zoekmachine-optimalisatie.

Het grootschalig uitrollen van inferentiesystemen brengt tal van technische, operationele en strategische uitdagingen met zich mee. Latentiebeheer blijft een voortdurende uitdaging, omdat gebruikers sub-seconde antwoorden verwachten van interactieve AI-toepassingen, terwijl complexe modellen met miljarden parameters veel rekentijd vragen. Doorvoeroptimalisatie is even belangrijk—organisaties moeten duizenden of miljoenen gelijktijdige inferentie-aanvragen kunnen verwerken met behoud van acceptabele latentie en nauwkeurigheid. Modeldrift doet zich voor wanneer de inferentieprestaties na verloop van tijd achteruitgaan doordat de echte dataverdeling afwijkt van de trainingsdata, wat continue monitoring en periodieke modelhertraining vereist. Interpreterbaarheid en uitlegbaarheid worden steeds belangrijker nu AI-inferentiesystemen beslissingen nemen die gebruikers raken; dit vraagt om inzicht in en uitleg van hoe modellen tot specifieke voorspellingen komen. Naleving van regelgeving wordt een grotere uitdaging, met regels als de EU AI Act die transparantie, biasdetectie en menselijke controle vereisen in AI-inferentiesystemen. Datakwaliteit blijft fundamenteel—inferentiesystemen zijn slechts zo goed als de data waarop ze zijn getraind, en slechte trainingsdata leiden tot bevooroordeelde, onnauwkeurige of schadelijke inferentie-uitkomsten. Infrastructuurkosten kunnen aanzienlijk zijn, omdat grootschalige inferentie veel investeringen vraagt in GPU’s, TPU’s, netwerken en koelsystemen. Schaarste aan talent betekent dat organisaties moeite hebben om ingenieurs en data scientists met expertise in inferentie-optimalisatie, modeluitrol en MLOps te vinden, wat de kosten opdrijft en implementaties vertraagt.

De toekomst van AI-inferentie ontwikkelt zich razendsnel in verschillende transformerende richtingen die de inzet en het gebruik van AI-systemen ingrijpend zullen veranderen. Edge-inferentie—het uitvoeren van inferentie op lokale apparaten in plaats van in de cloud—neemt snel toe dankzij vooruitgang in modelcompressie, gespecialiseerde edge-hardware en privacy-overwegingen. Deze verschuiving maakt realtime AI-functionaliteit op smartphones, IoT-apparaten en autonome systemen mogelijk zonder afhankelijk te zijn van cloudverbindingen. Multimodale inferentie, waarbij modellen tekst, beeld, audio en video gelijktijdig verwerken en genereren, wordt steeds gebruikelijker en vereist nieuwe optimalisaties en hardwarekeuzes. Reasoning-modellen die meerstapsinferentie uitvoeren om complexe problemen op te lossen, komen op, met systemen als OpenAI’s o1 die laten zien dat inferentie kan schalen met meer rekentijd en tokens, niet alleen met modelgrootte. Disaggregated serving-architecturen winnen terrein, waarbij aparte hardwareclusters de prefill- en decode-fases van inferentie verwerken en zo middelen optimaliseren voor verschillende rekentaken. Speculatieve decodering en andere geavanceerde inferentietechnieken worden standaard, waardoor de latentie 2-3x lager kan zijn. Inferentie aan de edge gecombineerd met federated learning stelt organisaties in staat AI lokaal in te zetten met behoud van privacy en minder bandbreedteverbruik. De AI-inferentiemarkt zal naar verwachting groeien met een CAGR van 19,2% tot 2030, gedreven door toenemende zakelijke adoptie, nieuwe use-cases en de economische noodzaak om inferentiekosten te optimaliseren. Nu inferentie de dominante workload in AI-infrastructuur wordt, zullen optimalisatietechnieken, gespecialiseerde hardware en inferentie-specifieke software steeds geavanceerder en essentieel worden voor concurrentievoordeel.

AI-training is het proces waarbij een model patronen leert herkennen met behulp van grote datasets, terwijl AI-inferentie het moment is waarop dat getrainde model toepast wat het geleerd heeft om voorspellingen of uitkomsten te genereren op nieuwe gegevens. Training is rekenintensief en gebeurt éénmalig, terwijl inferentie meestal sneller en minder veeleisend is en continu plaatsvindt in productieomgevingen. Zie training als studeren voor een examen en inferentie als het daadwerkelijk maken van het examen.

Inferentie-latentie—de tijd die een model nodig heeft om een uitkomst te genereren—is cruciaal voor de gebruikerservaring en real-time toepassingen. Lage latentie maakt directe reacties mogelijk in chatbots, realtime vertaling, autonome voertuigen en fraudedetectiesystemen. Hoge latentie kan applicaties onbruikbaar maken voor tijdgevoelige taken. Bedrijven optimaliseren latentie met technieken zoals kwantisatie, modelpruning en gespecialiseerde hardware zoals GPU's en TPU's om te voldoen aan service level agreements.

De drie belangrijkste typen zijn batch-inferentie (grote datasets offline verwerken), online-inferentie (onmiddellijk voorspellingen genereren op aanvraag) en streaming-inferentie (voortdurend gegevens verwerken van sensoren of IoT-apparaten). Batch-inferentie is geschikt voor scenario's zoals dagelijkse analysetools, online-inferentie drijft chatbots en zoekmachines aan, en streaming-inferentie maakt real-time monitoringsystemen mogelijk. Elk type heeft verschillende latentie-eisen en toepassingsgebieden.

Kwantisatie verlaagt de numerieke precisie van modelgewichten van 32-bits naar 8-bits of lager, waardoor het model aanzienlijk kleiner wordt en minder rekenkracht vereist zonder noemenswaardig verlies van nauwkeurigheid. Pruning verwijdert niet-kritische neuronen of verbindingen uit het neuraal netwerk, wat de complexiteit vermindert. Beide technieken kunnen de inferentie-latentie met 50-80% verlagen en hardwarekosten reduceren. Deze optimalisaties zijn essentieel voor het inzetten van modellen op edge-apparaten en mobiele platformen.

Inferentie is het kernmechanisme waarmee generatieve AI-systemen tekst, afbeeldingen en code produceren. Wanneer je ChatGPT een prompt geeft, tokenizeert het inferentieproces jouw input, verwerkt deze door de getrainde lagen van het neuraal netwerk en genereert één voor één uitgaande tokens. De prefill-fase verwerkt alle input-tokens tegelijk, terwijl de decode-fase de output sequentieel genereert. Dankzij deze inferentie kunnen grote taalmodellen responsief en praktisch ingezet worden voor echte toepassingen.

Inferentie-monitoring volgt hoe AI-modellen presteren in productie, inclusief nauwkeurigheid, latentie en outputkwaliteit. Platformen zoals AmICited monitoren waar merken en domeinen verschijnen in AI-gegenereerde antwoorden in systemen als ChatGPT, Perplexity en Google AI Overviews. Inzicht in inferentiegedrag helpt organisaties om te waarborgen dat hun content correct wordt geciteerd en weergegeven wanneer AI-systemen uitkomsten genereren die hun domein of merk vermelden.

Gangbare inferentieversnellers zijn GPU's (Graphics Processing Units) voor parallelle verwerking, TPU's (Tensor Processing Units) geoptimaliseerd voor neurale netwerken, FPGA's (Field-Programmable Gate Arrays) voor aanpasbare werklasten, en ASIC's (Application-Specific Integrated Circuits) ontworpen voor specifieke taken. GPU's worden het meest gebruikt vanwege hun balans tussen prestaties en kosten, terwijl TPU's uitblinken in grootschalige inferentie. De keuze hangt af van de gewenste verwerkingssnelheid, latentie-eisen en het budget.

De wereldwijde AI-inferentiemarkt werd in 2025 gewaardeerd op USD 106,15 miljard en zal naar verwachting groeien tot USD 254,98 miljard in 2030, een samengesteld jaarlijks groeipercentage (CAGR) van 19,2%. Deze snelle groei weerspiegelt de toenemende adoptie van AI-toepassingen door bedrijven, met 78% van de organisaties die AI gebruikt in 2024, tegenover 55% in 2023. De uitbreiding wordt gedreven door de vraag naar realtime AI-toepassingen in sectoren als gezondheidszorg, financiën, retail en autonome systemen.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek wat detectie van AI-inhoud is, hoe detectietools werken met behulp van machine learning en NLP, en waarom ze belangrijk zijn voor merkmonitoring, onderwi...

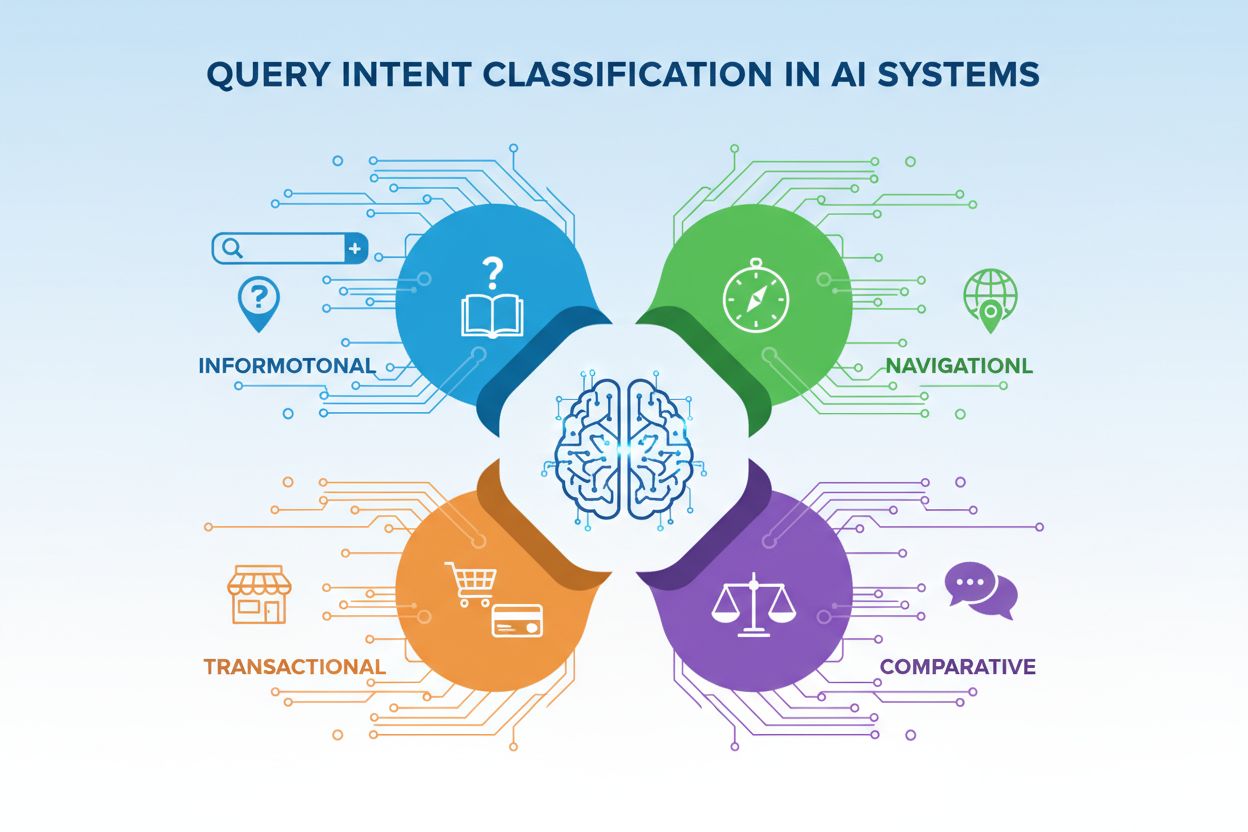

Leer over Query Intent Classificatie - hoe AI-systemen gebruikerszoekopdrachten categoriseren op basis van intentie (informatief, navigatief, transactioneel, ve...

Ontdek hoe AI-model-finetuning vooraf getrainde modellen aanpast voor specifieke industrie- en merktaken, de nauwkeurigheid verbetert en de kosten en rekenverei...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.