LLM Meta-antwoorden maken: op zichzelf staande inzichten die AI kan citeren

Leer hoe je LLM meta-antwoorden maakt die door AI-systemen worden geciteerd. Ontdek structuurtechnieken, strategieën voor antwoorddichtheid en citaatklare conte...

Inhoud die direct ingaat op hoe taalmodellen gerelateerde vragen interpreteren en beantwoorden, ontworpen om de zichtbaarheid in AI-gegenereerde antwoorden op platforms zoals ChatGPT, Google AI Overviews en Perplexity te vergroten. LLM Meta-antwoorden zijn gesynthetiseerde reacties die informatie uit meerdere bronnen combineren tot samenhangende, conversatiële antwoorden die inspelen op de intentie van de gebruiker.

Inhoud die direct ingaat op hoe taalmodellen gerelateerde vragen interpreteren en beantwoorden, ontworpen om de zichtbaarheid in AI-gegenereerde antwoorden op platforms zoals ChatGPT, Google AI Overviews en Perplexity te vergroten. LLM Meta-antwoorden zijn gesynthetiseerde reacties die informatie uit meerdere bronnen combineren tot samenhangende, conversatiële antwoorden die inspelen op de intentie van de gebruiker.

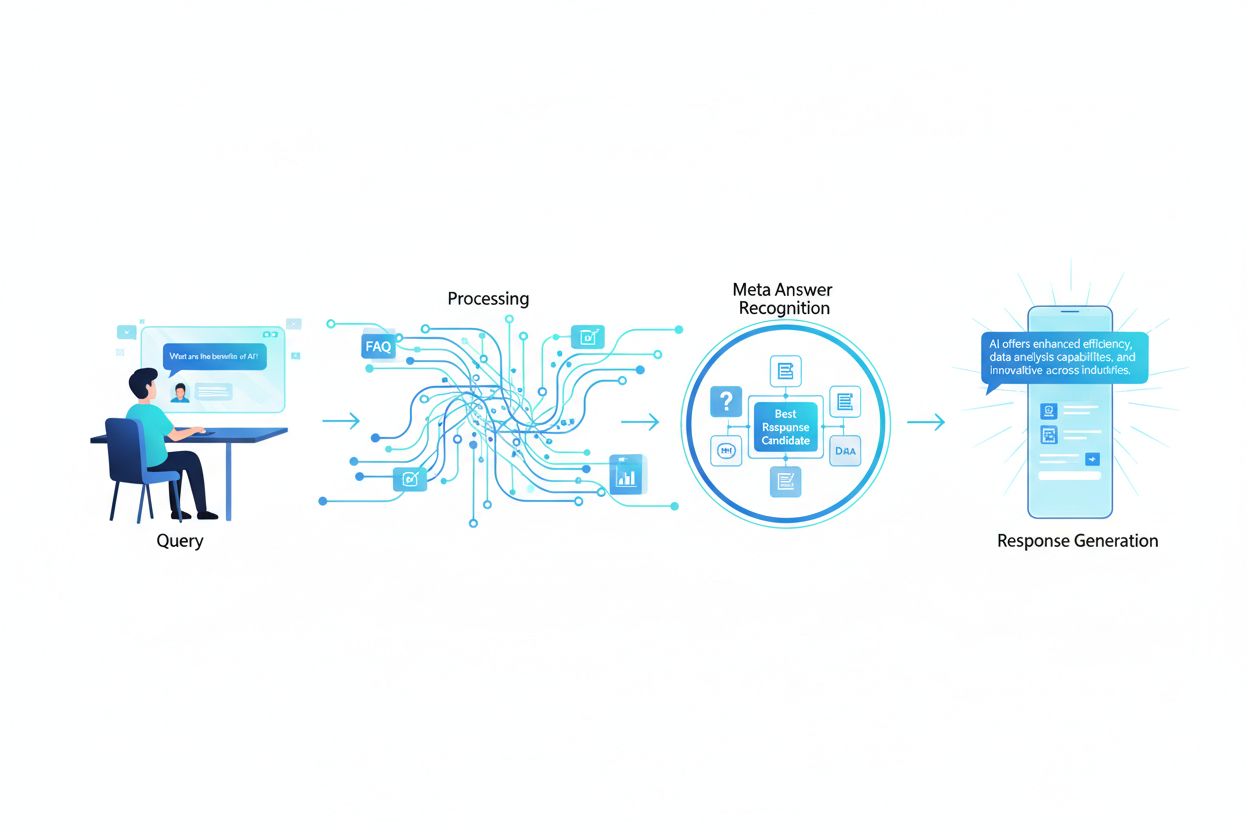

LLM Meta-antwoorden zijn de gesynthetiseerde, AI-gegenereerde reacties die grote taalmodellen produceren wanneer gebruikers hen benaderen via platforms zoals ChatGPT, Claude of Google’s AI Overviews. Deze antwoorden verschillen fundamenteel van traditionele zoekresultaten omdat ze informatie uit meerdere bronnen combineren tot een samenhangende, conversatiële reactie die direct inspeelt op de intentie van de gebruiker. In plaats van een lijst met links te presenteren, analyseren LLM’s opgehaalde content en genereren originele tekst die feiten, perspectieven en inzichten uit hun trainingsdata en retrieval-augmented generation (RAG)-systemen verwerkt. Begrijpen hoe LLM’s deze meta-antwoorden samenstellen is essentieel voor contentmakers die willen dat hun werk wordt geciteerd en verwezen in AI-gegenereerde reacties. De zichtbaarheid van je content in deze AI-reacties is even belangrijk geworden als ranking in traditionele zoekresultaten, waardoor LLM-optimalisatie (LLMO) een cruciaal onderdeel is van moderne contentstrategie.

Wanneer een gebruiker een zoekopdracht indient bij een LLM, matcht het systeem niet simpelweg zoekwoorden zoals traditionele zoekmachines. In plaats daarvan voeren LLM’s semantische analyse uit om de onderliggende intentie, context en nuance van de vraag te begrijpen. Het model breekt de zoekopdracht op in conceptuele componenten, identificeert gerelateerde onderwerpen en entiteiten, en bepaalt welk type antwoord het meest behulpzaam is—of dat nu een definitie, vergelijking, stapsgewijze uitleg of analytisch perspectief is. LLM’s halen vervolgens relevante content op uit hun kennisbank via RAG-systemen die bronnen prioriteren op basis van relevantie, autoriteit en volledigheid. Het retrieval-proces kijkt niet alleen naar exacte zoekwoordovereenkomsten, maar ook naar semantische overeenkomsten, thematische relaties en hoe goed content inspeelt op specifieke aspecten van de vraag. Dit betekent dat je content vindbaar moet zijn, niet alleen op exacte zoekwoorden, maar ook op de semantische concepten en gerelateerde onderwerpen waar gebruikers daadwerkelijk naar vragen.

| Interpretatiefactor zoekopdracht | Traditionele zoekopdracht | LLM Meta-antwoorden |

|---|---|---|

| Matchmethode | Zoekwoordmatching | Semantisch begrip |

| Resultaatformaat | Lijst met links | Gesynthetiseerd verhaal |

| Bronselectie | Relevantie-ranking | Relevantie + volledigheid + autoriteit |

| Contextoverweging | Beperkt | Uitgebreide semantische context |

| Antwoord-synthese | Gebruiker moet meerdere bronnen lezen | AI combineert meerdere bronnen |

| Citatienoodzaak | Optioneel | Vaak inbegrepen |

Wil je dat je content wordt geselecteerd en geciteerd in LLM-meta-antwoorden, dan moet deze een aantal cruciale kenmerken bevatten die aansluiten op hoe deze systemen informatie beoordelen en synthetiseren. Ten eerste moet je content duidelijke expertise en autoriteit over het onderwerp tonen, met sterke E-E-A-T-signalen (Ervaring, Expertise, Autoriteit, Betrouwbaarheid) waarmee LLM’s betrouwbare bronnen identificeren. Ten tweede moet de content echt informatievoordeel bieden—unieke inzichten, data of perspectieven die waarde toevoegen boven het gangbare aanbod. Ten derde moet je content zo gestructureerd zijn dat LLM’s eenvoudig relevante informatie kunnen uitlezen, door heldere hiërarchieën en logische opbouw te gebruiken. Vierde, semantische rijkdom is essentieel; je content moet gerelateerde concepten diepgaand verkennen, diverse terminologie hanteren en brede thematische autoriteit opbouwen, in plaats van zich te richten op enkelvoudige zoekwoorden. Vijfde, actualiteit is van groot belang bij actuele onderwerpen, aangezien LLM’s recente, actuele informatie prioriteren bij het samenstellen van antwoorden. Tot slot moet je content ondersteunend bewijs bevatten via citaties, data en externe bronnen die vertrouwen opbouwen bij LLM-systemen.

Belangrijke kenmerken die LLM-citatie verbeteren:

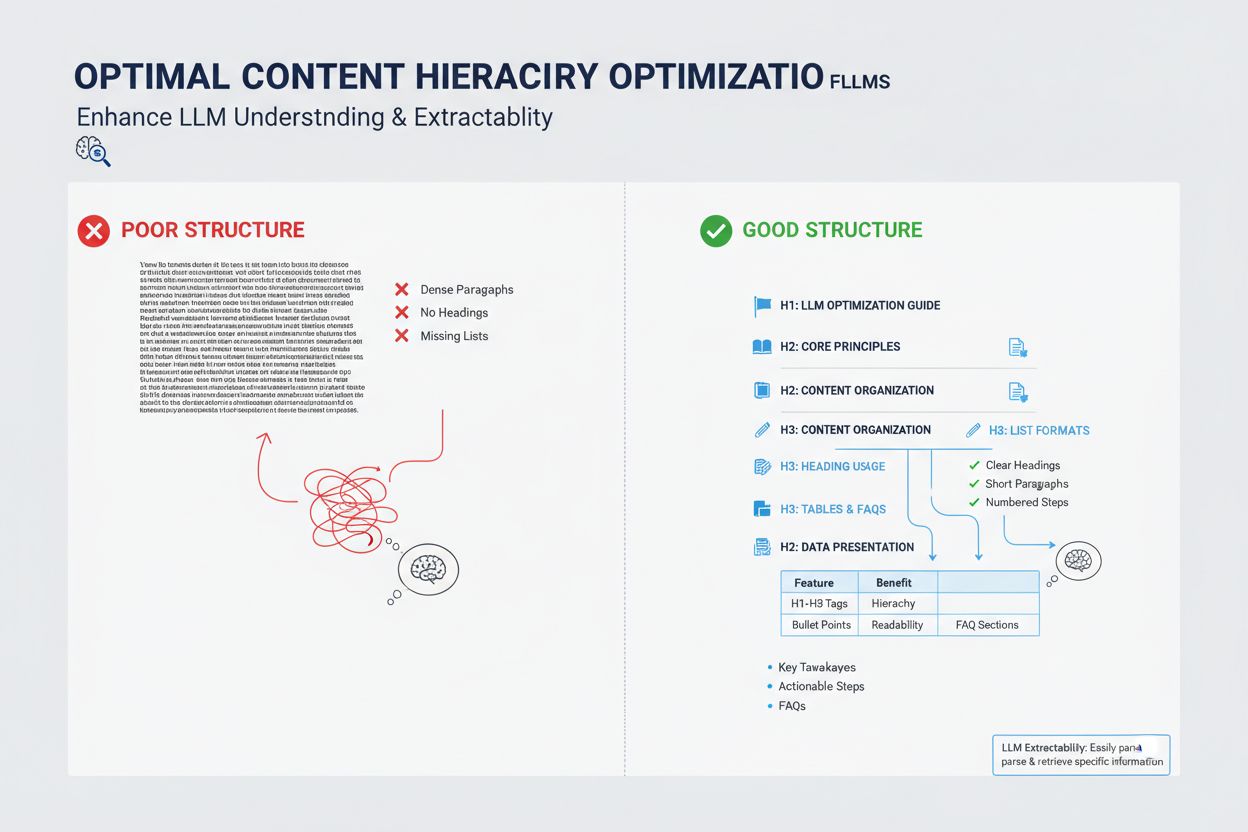

De manier waarop je content gestructureerd is, heeft grote invloed op de kans dat LLM’s deze selecteren voor meta-antwoorden, omdat deze systemen zijn geoptimaliseerd om goed georganiseerde informatie te extraheren en te synthetiseren. LLM’s geven de voorkeur aan content met duidelijke koppenhiërarchieën (H1, H2, H3) die een logische informatiearchitectuur creëren, waardoor het model relaties tussen concepten begrijpt en relevante secties efficiënt kan uitlezen. Opsommingen en genummerde lijsten zijn bijzonder waardevol omdat ze informatie presenteren in scanbare, discrete eenheden die LLM’s eenvoudig kunnen verwerken in hun gesynthetiseerde reacties. Tabellen zijn bijzonder krachtig voor LLM-zichtbaarheid omdat ze gestructureerde data bieden in een formaat dat AI-systemen gemakkelijk kunnen uitlezen en citeren. Korte alinea’s (3-5 zinnen) presteren beter dan lange tekstblokken, omdat LLM’s zo gemakkelijker specifieke informatie kunnen vinden zonder door irrelevante content te hoeven zoeken. Daarnaast geeft het gebruik van schema markup (FAQ, Artikel, HowTo) expliciete signalen aan LLM’s over de structuur en het doel van je content, wat de kans op citatie aanzienlijk vergroot.

Hoewel LLM-meta-antwoorden en featured snippets oppervlakkig gezien op elkaar lijken, vertegenwoordigen ze fundamenteel verschillende mechanismen voor contentzichtbaarheid en vereisen ze verschillende optimalisatiestrategieën. Featured snippets worden geselecteerd door traditionele zoekalgoritmen uit bestaande webcontent en weergegeven op een specifieke positie op de zoekresultatenpagina, meestal met 40-60 woorden uitgelichte tekst. LLM-meta-antwoorden daarentegen zijn AI-gegenereerde reacties die informatie uit meerdere bronnen synthetiseren tot een nieuw, origineel verhaal dat langer en vollediger kan zijn dan elke afzonderlijke bron. Featured snippets belonen content die een specifieke vraag direct en beknopt beantwoordt, terwijl LLM-meta-antwoorden uitgebreide, gezaghebbende content belonen die diepe thematische dekking biedt. De citatiemechanismen verschillen aanzienlijk: featured snippets tonen een bronvermelding maar de content zelf wordt letterlijk overgenomen, terwijl LLM-meta-antwoorden je content kunnen parafraseren of synthetiseren en doorgaans attributie opnemen. Daarnaast zijn featured snippets primair geoptimaliseerd voor traditionele zoekopdrachten, terwijl LLM-meta-antwoorden geoptimaliseerd zijn voor AI-platforms en mogelijk helemaal niet in zoekresultaten verschijnen.

| Aspect | Featured Snippets | LLM Meta-antwoorden |

|---|---|---|

| Genereermethode | Algoritme extraheert bestaande tekst | AI synthetiseert uit meerdere bronnen |

| Weergaveformaat | Zoekresultatenpagina-positie | AI-platformreactie |

| Contentlengte | Meestal 40-60 woorden | 200-500+ woorden |

| Citatiewijze | Bronvermelding met geëxtraheerde tekst | Attributie met geparafraseerde content |

| Optimalisatiefocus | Beknopte directe antwoorden | Uitgebreide autoriteit |

| Platform | Google Search | ChatGPT, Claude, Google AI Overviews |

| Zichtbaarheidsmetric | Zoekimpressies | AI-responscitaten |

Semantische rijkdom—de diepte en breedte van conceptuele dekking in je content—is een van de belangrijkste maar vaak over het hoofd geziene factoren bij LLM-optimalisatie. LLM’s kijken niet alleen naar je doelzoekwoord; ze analyseren de semantische relaties tussen concepten, de contextuele informatie rond je hoofdonderwerp en hoe grondig je gerelateerde ideeën verkent. Content met hoge semantische rijkdom gebruikt diverse terminologie, benadert een onderwerp vanuit meerdere invalshoeken en legt verbanden tussen gerelateerde concepten, waardoor LLM’s begrijpen dat je content echt gezaghebbend is en niet oppervlakkig geoptimaliseerd op zoekwoorden. Schrijf je over een onderwerp, neem dan gerelateerde termen, synoniemen en conceptueel verwante ideeën op die LLM’s helpen je content in een breder kenniskader te plaatsen. Een artikel over “contentmarketing” moet bijvoorbeeld vanzelfsprekend ingaan op doelgroeptargeting, buyer persona’s, contentdistributie, analytics en ROI—niet omdat je zoekwoorden aan het proppen bent, maar omdat die concepten semantisch gerelateerd zijn en essentieel voor een volledig begrip. Deze semantische diepgang signaleert aan LLM’s dat je over echte expertise beschikt en het soort genuanceerde, veelzijdige antwoorden kunt geven waar gebruikers naar op zoek zijn.

LLM’s beoordelen autoriteit anders dan traditionele zoekmachines en leggen meer nadruk op signalen die echte expertise en betrouwbaarheid aantonen dan alleen linkpopulariteit. Auteurstitels en aangetoonde ervaring zijn bijzonder belangrijk; LLM’s geven de voorkeur aan content van erkende experts, praktijkmensen of organisaties met gevestigde autoriteit in hun vakgebied. Externe citaties en verwijzingen naar andere gezaghebbende bronnen vergroten de geloofwaardigheid bij LLM-systemen, omdat ze aantonen dat je content is ingebed in bredere kennis en ondersteund wordt door andere experts. Consistentie in meerdere stukken content over een onderwerp helpt om thematische autoriteit op te bouwen; LLM’s herkennen wanneer een auteur of organisatie meerdere diepgaande stukken over verwante onderwerpen heeft gepubliceerd. Validatie door derden via vermeldingen, citaten of verwijzingen door andere autoriteiten verhoogt je zichtbaarheid in LLM-meta-antwoorden aanzienlijk. Origineel onderzoek, eigen data of unieke methodologieën zijn krachtige autoriteitssignalen omdat ze informatie vertegenwoordigen die nergens anders te vinden is. Ook het regelmatig bijwerken van publicaties en het up-to-date houden van content signaleert dat je actief bent in je vakgebied en op de hoogte blijft van de laatste ontwikkelingen.

Autoriteitssignalen die LLM-selectie beïnvloeden:

Contentactualiteit is steeds belangrijker geworden voor LLM-zichtbaarheid, vooral voor onderwerpen waarbij informatie snel verandert of recente ontwikkelingen het antwoord sterk beïnvloeden. LLM’s zijn getraind op data met kennis-cutoffs, maar vertrouwen steeds vaker op RAG-systemen die actuele informatie van het web ophalen. Dit betekent dat de publicatiedatum en updatefrequentie van je content direct bepalen of deze wordt geselecteerd voor meta-antwoorden. Voor evergreen onderwerpen signaleren regelmatige updates—zelfs kleine die de publicatiedatum verversen—dat je content actief wordt onderhouden en betrouwbaar is. Voor tijdgevoelige onderwerpen zoals trends, technologische updates of actualiteiten wordt verouderde content door LLM-systemen actief lager gewaardeerd ten gunste van recentere bronnen. De beste praktijk is een onderhoudsschema waarbij je belangrijke content elk kwartaal of halfjaar bekijkt en bijwerkt, statistieken ververst, nieuwe voorbeelden toevoegt en recente ontwikkelingen verwerkt. Dit voortdurende onderhoud vergroot niet alleen je LLM-zichtbaarheid, maar toont ook aan AI-systemen en menselijke lezers dat je een actuele, betrouwbare bron bent.

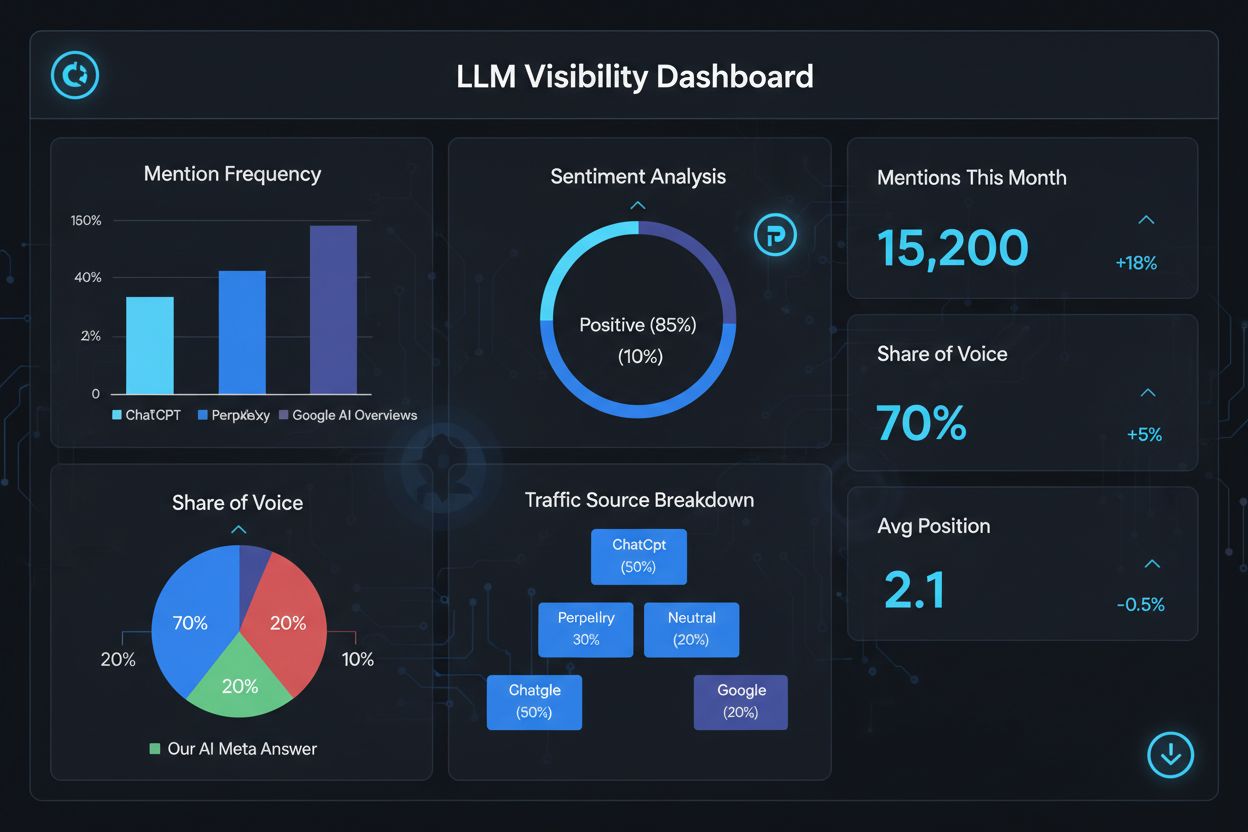

Het meten van succes in LLM-meta-antwoorden vereist andere metrics en tools dan traditionele SEO, omdat deze reacties buiten het traditionele zoekresultateneiland bestaan. Tools zoals AmICited.com bieden gespecialiseerde monitoring die bijhoudt wanneer en waar je content verschijnt in AI-gegenereerde antwoorden, zodat je zicht hebt op welke stukken worden geciteerd en hoe vaak. Je zou verschillende belangrijke metrics moeten monitoren: citatiefrequentie (hoe vaak je content verschijnt in LLM-reacties), citaatcontext (welke onderwerpen je content triggeren), brondiversiteit (of je op verschillende LLM-platforms wordt geciteerd) en antwoordpositie (of je content prominent wordt weergegeven in de gesynthetiseerde reactie). Volg welke specifieke pagina’s of secties van je content het vaakst worden geciteerd, omdat dit aangeeft welk type informatie LLM’s het meest waardevol en betrouwbaar vinden. Houd veranderingen in je citatiepatronen bij om te zien welke optimalisaties werken en welke onderwerpen verdere ontwikkeling behoeven. Analyseer bovendien de vragen die je citaties activeren om te begrijpen hoe LLM’s gebruikersintentie interpreteren en welke semantische variaties het meest effectief zijn.

Belangrijke metrics voor LLM-meta-antwoord-prestaties:

Optimaliseren voor LLM-meta-antwoorden vereist een strategische aanpak die technische implementatie, contentkwaliteit en voortdurende meting combineert. Begin met uitgebreid thematisch onderzoek om gaten te identificeren waar jouw expertise unieke waarde kan bieden die LLM’s laat prevaleren boven generieke bronnen. Structureer je content met duidelijke hiërarchieën via H2- en H3-koppen om een logisch informatie-architectuur te creëren die LLM’s eenvoudig kunnen uitlezen en extraheren. Implementeer schema markup (FAQ, Artikel, HowTo) om de structuur en het doel van je content expliciet te signaleren aan LLM-systemen en de vindbaarheid sterk te verbeteren. Ontwikkel diepgaande, gezaghebbende content die je onderwerp vanuit meerdere invalshoeken verkent, gerelateerde concepten integreert en semantische rijkdom opbouwt die echte expertise laat zien. Voeg origineel onderzoek, data of inzichten toe die informatievoordeel bieden en je onderscheiden van concurrenten. Onderhoud een regelmatig updateschema, waarbij je belangrijke stukken elk kwartaal ververst om actualiteit te waarborgen en voortdurende autoriteit te signaleren. Bouw thematische autoriteit op door meerdere verwante stukken te creëren die collectief je expertise over een onderwerp aantonen. Gebruik duidelijke, directe taal die specifieke vragen van gebruikers beantwoordt, zodat LLM’s je content gemakkelijk kunnen uitlezen en synthetiseren. Monitor tenslotte je LLM-citatieprestaties met gespecialiseerde tools om te ontdekken wat werkt en verfijn je strategie continu op basis van datagedreven inzichten.

LLM Meta-antwoorden richten zich op hoe taalmodellen content interpreteren en citeren, terwijl traditionele SEO zich focust op ranking in zoekresultaten. LLM's geven prioriteit aan relevantie en duidelijkheid boven domeinautoriteit, waardoor goed gestructureerde, antwoordgerichte content belangrijker is dan backlinks. Je content kan geciteerd worden in LLM-antwoorden, zelfs als deze niet in de topposities van Google staat.

Structuur je content met duidelijke koppen, geef directe antwoorden vooraan, gebruik schema markup (FAQ, Artikel), voeg citaties en statistieken toe, behoud thematische autoriteit en zorg dat je site door AI-bots gecrawld kan worden. Focus op semantische rijkdom, informatievoordeel en volledige thematische dekking in plaats van op smalle zoekwoorden.

LLM's halen eenvoudiger fragmenten uit goed georganiseerde content. Duidelijke koppen, lijsten, tabellen en korte alinea's helpen modellen relevante informatie te identificeren en te citeren. Onderzoek toont aan dat door LLM geciteerde pagina's aanzienlijk meer gestructureerde elementen bevatten dan gemiddelde webpagina's, waardoor structuur een kritische rankingfactor is.

Ja. In tegenstelling tot traditionele SEO geven LLM's prioriteit aan relevantie van de vraag en contentkwaliteit boven domeinautoriteit. Een goed gestructureerde, zeer relevante nichepagina kan door LLM's geciteerd worden, zelfs als deze niet in de topposities van Google staat. Expertise en duidelijkheid zijn belangrijker dan siteautoriteit.

Werk content regelmatig bij, vooral voor tijdgevoelige onderwerpen. Voeg tijdstempels toe waarop de content voor het laatst is bijgewerkt. Voor evergreen onderwerpen worden kwartaalreviews aanbevolen. Verse content signaleert nauwkeurigheid aan LLM's, vergroot de kans op citatie en toont voortdurende autoriteit.

AmICited.com is gespecialiseerd in het monitoren van AI-vermeldingen op ChatGPT, Perplexity en Google AI Overviews. Andere tools zijn onder meer Semrush's AI SEO Toolkit, Ahrefs Brand Radar en Peec AI. Deze tools volgen vermeldingsfrequentie, aandeel van stem, sentiment en helpen je het optimalisatiesucces te meten.

Schema markup (FAQ, Artikel, HowTo) biedt machine-leesbare structuur die LLM's helpt content nauwkeuriger te begrijpen en te extraheren. Het signaleert het type en de intentie van content, waardoor je pagina eerder wordt geselecteerd voor relevante vragen en de vindbaarheid toeneemt.

Externe vermeldingen op gezaghebbende sites (nieuws, Wikipedia, vakpublicaties) bouwen geloofwaardigheid op en vergroten de kans dat LLM's je content citeren. Meerdere onafhankelijke bronnen die je merk of data noemen, creëren een gezagsstructuur die LLM's herkennen en belonen met een hogere citatiefrequentie.

Volg hoe je merk verschijnt in AI-gegenereerde antwoorden op ChatGPT, Perplexity en Google AI Overviews met het gespecialiseerde monitoringplatform van AmICited.

Leer hoe je LLM meta-antwoorden maakt die door AI-systemen worden geciteerd. Ontdek structuurtechnieken, strategieën voor antwoorddichtheid en citaatklare conte...

Ontdek hoe LLM's antwoorden genereren via tokenisatie, transformerarchitectuur, attention-mechanismen en probabilistische voorspellingen. Leer het technische pr...

Ontdek hoe Retrieval-Augmented Generation AI-verwijzingen transformeert, waardoor nauwkeurige bronvermelding en onderbouwde antwoorden mogelijk zijn in ChatGPT,...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.