AI Crawl Analytics

Ontdek wat AI-crawlanalyse is en hoe serverloganalyse het gedrag van AI-crawlers, patronen van contenttoegang en zichtbaarheid in AI-gestuurde zoekplatforms als...

Logbestand analyse is het proces van het onderzoeken van servertoegangslogboeken om te begrijpen hoe zoekmachinecrawlers en AI-bots met een website omgaan. Het onthult crawlpatronen, technische problemen en optimalisatiemogelijkheden voor SEO-prestaties.

Logbestand analyse is het proces van het onderzoeken van servertoegangslogboeken om te begrijpen hoe zoekmachinecrawlers en AI-bots met een website omgaan. Het onthult crawlpatronen, technische problemen en optimalisatiemogelijkheden voor SEO-prestaties.

Logbestand analyse is het systematisch onderzoeken van servertoegangslogboeken om te begrijpen hoe zoekmachinecrawlers, AI-bots en gebruikers met een website interageren. Deze logboeken worden automatisch gegenereerd door webservers en bevatten gedetailleerde registraties van elk HTTP-verzoek aan je site, inclusief het IP-adres van de aanvrager, tijdstip, opgevraagde URL, HTTP-statuscode en user-agent string. Voor SEO-professionals dient logbestand analyse als de definitieve bron van waarheid over crawlergedrag en onthult patronen die oppervlakkige tools zoals Google Search Console of traditionele crawlers niet kunnen vastleggen. In tegenstelling tot gesimuleerde crawls of geaggregeerde analysedata bieden serverlogs ongefilterd, direct bewijs van wat zoekmachines en AI-systemen daadwerkelijk op je website doen in real time.

Het belang van logbestand analyse is exponentieel toegenomen naarmate het digitale landschap is geëvolueerd. Met meer dan 51% van het wereldwijde internetverkeer dat nu door bots wordt gegenereerd (ACS, 2025), en AI-crawlers als GPTBot, ClaudeBot en PerplexityBot die regelmatig websites bezoeken, is begrip van crawlergedrag niet langer optioneel—het is essentieel om zichtbaar te blijven in zowel traditionele zoekresultaten als opkomende AI-zoekplatformen. Logbestand analyse overbrugt de kloof tussen wat je denkt dat er op je site gebeurt en wat er daadwerkelijk gebeurt, en stelt je in staat datagedreven beslissingen te nemen die direct invloed hebben op zoekrangschikkingen, indexatiesnelheid en de algehele organische prestaties.

Logbestand analyse is al decennia een hoeksteen van technische SEO, maar de relevantie is de afgelopen jaren drastisch toegenomen. Historisch vertrouwden SEO-professionals vooral op Google Search Console en crawlers van derden om zoekmachinegedrag te begrijpen. Deze tools hebben echter aanzienlijke beperkingen: Google Search Console levert alleen geaggregeerde, bemonsterde data van Google’s crawlers; crawlers van derden simuleren crawlergedrag in plaats van echte interacties vast te leggen; en geen van beide tools volgt niet-Google zoekmachines of AI-bots effectief.

De opkomst van AI-gestuurde zoekplatformen heeft het speelveld fundamenteel veranderd. Volgens onderzoek van Cloudflare uit 2024 is Googlebot goed voor 39% van al het AI- en zoekcrawlerverkeer, terwijl AI-specifieke crawlers nu het snelst groeiende segment zijn. De AI-bots van Meta genereren alleen al 52% van het AI-crawlerverkeer, meer dan het dubbele van Google (23%) of OpenAI (20%). Deze verschuiving betekent dat websites nu bezoek krijgen van tientallen verschillende soorten bots, waarvan velen zich niet aan traditionele SEO-protocollen of robots.txt-regels houden. Logbestand analyse is de enige methode die dit volledige beeld vastlegt en onmisbaar maakt voor moderne SEO-strategieën.

De wereldwijde log management markt zal naar verwachting groeien van $3.228,5 miljoen in 2025 naar aanzienlijk hogere waarderingen in 2029, met een samengesteld jaarlijks groeipercentage (CAGR) van 14,6%. Deze groei weerspiegelt het groeiende besef binnen bedrijven dat loganalyse cruciaal is voor beveiliging, prestatiemonitoring en SEO-optimalisatie. Organisaties investeren fors in geautomatiseerde loganalyse tools en AI-gestuurde platformen die miljoenen logregels in real time kunnen verwerken en ruwe data omzetten in bruikbare inzichten die bedrijfsresultaten sturen.

Wanneer een gebruiker of bot een pagina op je website opvraagt, verwerkt de webserver dat verzoek en registreert gedetailleerde informatie over de interactie. Dit proces gebeurt automatisch en continu, waardoor een uitgebreid controleregister van alle serveractiviteiten ontstaat. Begrijpen hoe dit werkt is essentieel om logbestand data correct te interpreteren.

De typische flow begint wanneer een crawler (zoals Googlebot, een AI-bot of de browser van een gebruiker) een HTTP GET-verzoek naar je server stuurt, met een user-agent string die de aanvrager identificeert. Je server ontvangt het verzoek, verwerkt het en retourneert een HTTP-statuscode (200 voor succes, 404 voor niet gevonden, 301 voor permanente redirect, enz.) samen met de opgevraagde content. Elk van deze interacties wordt vastgelegd in het toegangslogbestand van je server, met een tijdstempel die het IP-adres, de opgevraagde URL, HTTP-methode, statuscode, responsgrootte, referrer en user-agent string bevat.

HTTP-statuscodes zijn bijzonder belangrijk voor SEO-analyse. Een 200-statuscode betekent een succesvolle levering van de pagina; 3xx-codes geven redirects aan; 4xx-codes duiden op clientfouten (zoals 404 Niet Gevonden); en 5xx-codes op serverfouten. Door de verdeling van deze statuscodes in je logs te analyseren kun je technische problemen identificeren die crawlers verhinderen je content te bereiken. Als een crawler bijvoorbeeld meerdere 404-antwoorden ontvangt bij het proberen van belangrijke pagina’s, wijst dit op een gebroken link of ontbrekend contentprobleem dat direct aandacht vereist.

User-agent strings zijn net zo belangrijk om te achterhalen welke bots je site bezoeken. Elke crawler heeft een unieke user-agent string. Googlebot’s user-agent bevat bijvoorbeeld “Googlebot/2.1”, GPTBot bevat “GPTBot/1.0” en ClaudeBot bevat “ClaudeBot”. Door deze strings te parseren kun je je logdata segmenteren en gedrag per specifieke crawler analyseren, met inzicht in welke bots welke content prioriteren en hoe hun crawlpatronen verschillen. Deze gedetailleerde analyse maakt gerichte optimalisatie mogelijk voor verschillende zoekplatformen en AI-systemen.

| Aspect | Logbestand Analyse | Google Search Console | Crawlers van derden | Analyticstools |

|---|---|---|---|---|

| Databron | Serverlogs (eigen data) | Google’s crawlgegevens | Gesimuleerde crawls | Gebruikersgedrag tracking |

| Volledigheid | 100% van alle verzoeken | Bemonsterde, geaggregeerde data | Alleen simulatie | Alleen menselijk verkeer |

| Botdekking | Alle crawlers (Google, Bing, AI-bots) | Alleen Google | Gesimuleerde crawlers | Geen botdata |

| Historische data | Volledige geschiedenis (retentie varieert) | Beperkte tijdsspanne | Eén crawlsnapshot | Historisch beschikbaar |

| Real-time inzichten | Ja (met automatisering) | Vertraagde rapportage | Nee | Vertraagde rapportage |

| Crawlbudget inzicht | Exacte crawls | Globale samenvatting | Geschat | Niet van toepassing |

| Technische issues | Gedetailleerd (statuscodes, reactietijden) | Beperkt inzicht | Gesimuleerde issues | Niet van toepassing |

| AI-bot tracking | Ja (GPTBot, ClaudeBot, enz.) | Nee | Nee | Nee |

| Kosten | Gratis (serverlogs) | Gratis | Betaalde tools | Gratis/Betaald |

| Installatiecomplexiteit | Matig tot hoog | Eenvoudig | Eenvoudig | Eenvoudig |

Logbestand analyse is onmisbaar geworden om te begrijpen hoe zoekmachines en AI-systemen met je website omgaan. In tegenstelling tot Google Search Console, die alleen Google’s perspectief en geaggregeerde data biedt, leggen logbestanden het complete plaatje vast van alle crawleractiviteit. Dit is essentieel om verspilling van crawlbudget op te sporen, waarbij zoekmachines tijd besteden aan het crawlen van lage-waarde pagina’s in plaats van belangrijke content. Onderzoek toont aan dat grote websites vaak 30-50% van hun crawlbudget verspillen aan niet-essentiële URL’s zoals pagineringen, gefacetteerde navigatie of verouderde content.

De opkomst van AI-gestuurde zoekfuncties maakt logbestand analyse nog belangrijker. Nu AI-bots zoals GPTBot, ClaudeBot en PerplexityBot regelmatig websites bezoeken, is begrip van hun gedrag essentieel voor zichtbaarheid in AI-gegenereerde antwoorden. Deze bots gedragen zich vaak anders dan traditionele crawlers—ze negeren soms robots.txt-regels, crawlen agressiever of focussen op specifieke contenttypes. Logbestand analyse is de enige methode die deze patronen onthult, waardoor je je site kunt optimaliseren voor AI-ontdekking en tegelijkertijd bottoegang kunt beheren met gerichte regels.

Technische SEO-problemen die anders onopgemerkt zouden blijven, kunnen worden geïdentificeerd via loganalyse. Redirectketens, 5xx-serverfouten, trage laadtijden en JavaScript-renderingsproblemen laten allemaal sporen achter in serverlogs. Door deze patronen te analyseren kun je prioriteit geven aan fixes die directe invloed hebben op de toegankelijkheid en indexatiesnelheid van zoekmachines. Bijvoorbeeld: als logs aantonen dat Googlebot consequent 503 Service Unavailable-fouten ontvangt bij het crawlen van een bepaald gedeelte van je site, weet je precies waar je technische inspanningen nodig zijn.

Het verkrijgen van je serverlogs is de eerste stap in logbestand analyse, maar het proces verschilt per hostingomgeving. Voor zelfgehoste servers met Apache of NGINX worden logs doorgaans opgeslagen in /var/log/apache2/access.log of /var/log/nginx/access.log. Je kunt deze bestanden direct benaderen via SSH of via het bestandsbeheer van je server. Voor managed WordPress hosts zoals WP Engine of Kinsta zijn logs mogelijk beschikbaar via het hostingdashboard of SFTP, hoewel sommige providers de toegang beperken om serverprestaties te beschermen.

Content Delivery Networks (CDN’s) zoals Cloudflare, AWS CloudFront en Akamai vereisen speciale configuratie om logs te verkrijgen. Cloudflare biedt Logpush, waarmee HTTP-verzoeken naar aangewezen opslaglocaties (AWS S3, Google Cloud Storage, Azure Blob Storage) worden gestuurd voor analyse. AWS CloudFront biedt standaard logging die kan worden opgeslagen in S3-buckets. Deze CDN-logs zijn essentieel om te begrijpen hoe bots met je site omgaan wanneer content via een CDN wordt geleverd, omdat ze verzoeken aan de edge in plaats van aan je origin server vastleggen.

Shared hostingomgevingen hebben vaak beperkte logtoegang. Providers als Bluehost en GoDaddy bieden soms gedeeltelijke logs via cPanel, maar deze logs worden vaak snel overschreven en missen mogelijk belangrijke velden. Als je op shared hosting zit en uitgebreide loganalyse nodig hebt, overweeg dan een upgrade naar VPS of managed hosting met volledige logtoegang.

Na het verkrijgen van je logs is datavoorbereiding essentieel. Ruwe logbestanden bevatten verzoeken van alle bronnen—gebruikers, bots, scrapers en kwaadwillenden. Voor SEO-analyse wil je niet-relevante traffic filteren en focussen op zoekmachine- en AI-botactiviteit. Dit omvat doorgaans:

Logbestand analyse onthult inzichten die voor andere SEO-tools onzichtbaar zijn en vormt de basis voor strategische optimalisatie. Eén van de waardevolste inzichten is crawlpatroon analyse, waarmee je ziet welke pagina’s zoekmachines bezoeken en hoe vaak. Door crawl frequentie over tijd te volgen, kun je zien of Google meer of minder aandacht besteedt aan specifieke secties van je site. Plotselinge dalingen in crawl frequentie kunnen wijzen op technische problemen of veranderingen in de waargenomen belangrijkheid van pagina’s, terwijl stijgingen suggereren dat Google positief reageert op je optimalisaties.

Crawlbudget efficiëntie is een ander belangrijk inzicht. Door de verhouding van succesvolle (2xx) naar foutieve (4xx, 5xx) antwoorden te analyseren, kun je delen van je site identificeren waar crawlers problemen ondervinden. Als een bepaalde directory consequent 404-fouten retourneert, wordt crawlbudget verspild aan gebroken links. Evenzo, als crawlers onevenredig veel tijd besteden aan gepagineerde URL’s of gefacetteerde navigatie, verspil je budget aan lage-waarde content. Loganalyse kwantificeert deze verspilling, zodat je het potentiële effect van optimalisaties kunt berekenen.

Verweesde pagina’s opsporen is een uniek voordeel van logbestand analyse. Verweesde pagina’s zijn URL’s zonder interne links die buiten je sitestructuur bestaan. Traditionele crawlers missen deze pagina’s vaak omdat ze ze niet via interne links kunnen vinden. Logbestanden tonen echter dat zoekmachines ze nog steeds crawlen—vaak omdat ze extern zijn gelinkt of in oude sitemaps staan. Door deze verweesde pagina’s te identificeren kun je bepalen of je ze opnieuw in de sitestructuur wilt opnemen, wil laten redirecten of volledig wilt verwijderen.

AI-bot gedrag analyseren wordt steeds belangrijker. Door logdata te segmenteren op AI-bot user-agents zie je welke content deze bots prioriteren, hoe vaak ze langskomen en of ze technische barrières tegenkomen. Bijvoorbeeld: als GPTBot consequent je FAQ-pagina’s crawlt, maar zelden je blog bezoekt, suggereert dit dat AI-systemen FAQ-content waardevoller vinden als trainingsdata. Dit inzicht kan je contentstrategie informeren en helpen optimaliseren voor AI-zichtbaarheid.

Succesvolle logbestand analyse vereist zowel de juiste tools als een strategische aanpak. Screaming Frog’s Log File Analyzer is één van de populairste tools, met gebruiksvriendelijke interfaces voor het verwerken van grote logbestanden, het herkennen van botpatronen en het visualiseren van crawldata. Botify biedt loganalyse op ondernemingsniveau geïntegreerd met SEO-metrics, zodat je botactiviteit kunt koppelen aan rankings en verkeer. seoClarity’s Bot Clarity integreert loganalyse direct in het SEO-platform, wat het eenvoudig maakt om crawldata te koppelen aan andere SEO-metrics.

Voor organisaties met veel verkeer of complexe infrastructuur bieden AI-gestuurde loganalyse platformen zoals Splunk, Sumo Logic en Elastic Stack geavanceerde mogelijkheden zoals geautomatiseerde patroonherkenning, anomaliedetectie en voorspellende analyses. Deze platformen kunnen miljoenen logregels in real time verwerken, nieuwe bottype automatisch opsporen en ongebruikelijke activiteit signaleren die op securitydreigingen of technische problemen kan wijzen.

Best practices voor logbestand analyse zijn onder andere:

Nu AI-gestuurde zoekoplossingen steeds belangrijker worden, is AI-bot monitoring via logbestand analyse een essentiële SEO-functie. Door te volgen welke AI-bots je site bezoeken, welke content ze openen en hoe vaak, begrijp je hoe je content wordt gebruikt in AI-gestuurde zoektools en generatieve AI-modellen. Deze data stelt je in staat om weloverwogen te beslissen of je specifieke AI-bots wilt toestaan, blokkeren of vertragen via robots.txt-regels of HTTP-headers.

Crawlbudget optimalisatie is wellicht de meest impactvolle toepassing van logbestand analyse. Voor grote websites met duizenden of miljoenen pagina’s is crawlbudget een eindige bron. Door logbestanden te analyseren kun je pagina’s identificeren die te vaak worden gecrawld in verhouding tot hun belang, en pagina’s die vaker gecrawld zouden moeten worden maar dat niet worden. Veelvoorkomende scenario’s van crawlbudget verspilling zijn onder andere:

Door deze issues aan te pakken—met robots.txt-regels, canonicals, noindex-tags of technische oplossingen—kun je crawlbudget richten op waardevolle content en de indexatiesnelheid en zichtbaarheid in zoekmachines van je belangrijkste pagina’s verbeteren.

De toekomst van logbestand analyse wordt gevormd door de snelle ontwikkeling van AI-gestuurde zoekoplossingen. Nu meer AI-bots het ecosysteem betreden en hun gedrag verfijnder wordt, zal logbestand analyse nog belangrijker zijn om te begrijpen hoe je content wordt ontdekt, benaderd en gebruikt door AI-systemen. Opkomende trends zijn onder andere:

Real-time loganalyse aangedreven door machine learning stelt SEO-specialisten in staat om crawlproblemen binnen minuten in plaats van dagen te detecteren en op te lossen. Geautomatiseerde systemen identificeren nieuwe bottype, signaleren ongebruikelijke patronen en doen optimalisatievoorstellen zonder handmatige tussenkomst. Deze verschuiving van reactieve naar proactieve analyse stelt SEO’s in staat om continue optimale crawlbaarheid en indexatie te behouden.

Integratie met AI-zichtbaarheid tracking koppelt logbestand data aan prestaties in AI-zoekresultaten. In plaats van logs geïsoleerd te analyseren, correleren SEO’s crawlergedrag met daadwerkelijke zichtbaarheid in AI-gegenereerde antwoorden, zodat ze precies begrijpen hoe crawlpatronen AI-rankings beïnvloeden. Deze integratie biedt ongekende inzichten in hoe content van crawl naar AI-trainingdata naar AI-antwoorden voor gebruikers stroomt.

Ethisch botbeheer wordt steeds belangrijker nu organisaties zich afvragen welke AI-bots toegang tot hun content moeten krijgen. Logbestand analyse maakt gedetailleerde controle over bottoegang mogelijk, zodat uitgevers nuttige AI-crawlers kunnen toestaan en anderen die geen waarde of attributie bieden kunnen blokkeren. Standaarden zoals het opkomende LLMs.txt-protocol bieden gestructureerde manieren om bottoegangsbeleid te communiceren, en loganalyse verifieert de naleving.

Privacybeschermende analyse ontwikkelt zich om de behoefte aan gedetailleerd crawl inzicht in balans te brengen met privacywetgeving zoals de AVG. Geavanceerde anonimiseringstechnieken en privacygerichte analysetools stellen organisaties in staat waardevolle inzichten uit logs te halen zonder persoonlijk identificeerbare informatie op te slaan of te tonen. Dit wordt vooral belangrijk naarmate loganalyse breder wordt toegepast en regelgeving rond gegevensbescherming strenger wordt.

De convergentie van traditionele SEO en AI-zoekoptimalisatie betekent dat logbestand analyse nog jarenlang een hoeksteen van technische SEO-strategie zal blijven. Organisaties die vandaag uitblinken in logbestand analyse, zullen het best gepositioneerd zijn om hun zichtbaarheid en prestaties te behouden naarmate zoekoplossingen verder evolueren.

Logbestand analyse biedt volledige, ongefilterde gegevens van je server die elk verzoek van alle crawlers vastleggen, terwijl Google Search Console's crawlstatistieken alleen geaggregeerde, bemonsterde gegevens van Google's crawlers tonen. Logbestanden bieden gedetailleerde historische data en inzicht in gedrag van niet-Google bots, waaronder AI-crawlers zoals GPTBot en ClaudeBot, waardoor ze een completer beeld geven van echt crawlergedrag en technische problemen kunnen blootleggen die GSC mogelijk mist.

Voor drukbezochte websites wordt wekelijkse logbestand analyse aanbevolen om problemen vroegtijdig op te sporen en veranderingen in crawlpatronen te monitoren. Kleinere websites profiteren van maandelijkse controles om trends vast te stellen en nieuwe botactiviteit te identificeren. Ongeacht de grootte van je site helpt continue monitoring via geautomatiseerde tools om afwijkingen in real-time te detecteren, zodat je snel kunt reageren op verspilling van crawlbudget of technische problemen die de zichtbaarheid in zoekmachines beïnvloeden.

Ja, logbestand analyse is een van de meest effectieve manieren om AI-botverkeer te volgen. Door user-agent strings en IP-adressen in je serverlogboeken te onderzoeken, kun je identificeren welke AI-bots je site bezoeken, welke content ze openen en hoe vaak ze crawlen. Deze data is cruciaal om te begrijpen hoe je content wordt gebruikt in AI-gestuurde zoektools en generatieve AI-modellen, zodat je kunt optimaliseren voor AI-zichtbaarheid en bottoegang kunt beheren via robots.txt-regels.

Logbestand analyse onthult tal van technische SEO-problemen zoals crawl fouten (4xx- en 5xx-statuscodes), redirectketens, trage laadtijden van pagina's, verweesde pagina's zonder interne links, verspilling van crawlbudget op lage-waarde URL's, JavaScript-renderingsproblemen en problemen met dubbele content. Het identificeert ook gespoofte botactiviteit en helpt te detecteren wanneer legitieme crawlers toegankelijkheidsproblemen ondervinden, zodat je kunt prioriteren welke issues directe impact hebben op zoekmachinezichtbaarheid en indexatie.

Logbestand analyse toont precies welke pagina's door zoekmachines worden gecrawld en hoe vaak, waardoor duidelijk wordt waar crawlbudget wordt verspild aan lage-waarde content zoals gepagineerde archieven, gefacetteerde navigatie of verouderde URL's. Door deze inefficiënties te identificeren kun je je robots.txt-bestand aanpassen, interne links naar prioriteitspagina's verbeteren en canonicals implementeren om crawl aandacht te richten op waardevolle content. Zo zorg je ervoor dat zoekmachines zich focussen op de pagina's die het belangrijkst zijn voor je bedrijf.

Serverlogbestanden leggen doorgaans IP-adressen vast (bron van het verzoek), tijdstempels (wanneer verzoeken plaatsvonden), HTTP-methoden (meestal GET of POST), opgevraagde URLs (exacte pagina's), HTTP-statuscodes (200, 404, 301, etc.), responsgroottes in bytes, referrer-informatie en user-agent strings (identificatie van de crawler of browser). Deze uitgebreide gegevens stellen SEO-specialisten in staat om precies te reconstrueren wat er tijdens elke serverinteractie is gebeurd en patronen te identificeren die invloed hebben op crawlbaarheid en indexatie.

Gespoofte bots doen zich voor als legitieme zoekmachinecrawlers maar hebben IP-adressen die niet overeenkomen met de officiële IP-ranges van de zoekmachines. Om ze te identificeren kun je user-agent strings (zoals 'Googlebot') vergelijken met de officiële IP-ranges die door Google, Bing en andere zoekmachines worden gepubliceerd. Tools zoals Screaming Frog's Log File Analyzer valideren automatisch de echtheid van bots. Gespoofte bots verspillen crawlbudget en kunnen je server belasten, dus het is aan te raden ze te blokkeren via robots.txt of firewallregels.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek wat AI-crawlanalyse is en hoe serverloganalyse het gedrag van AI-crawlers, patronen van contenttoegang en zichtbaarheid in AI-gestuurde zoekplatforms als...

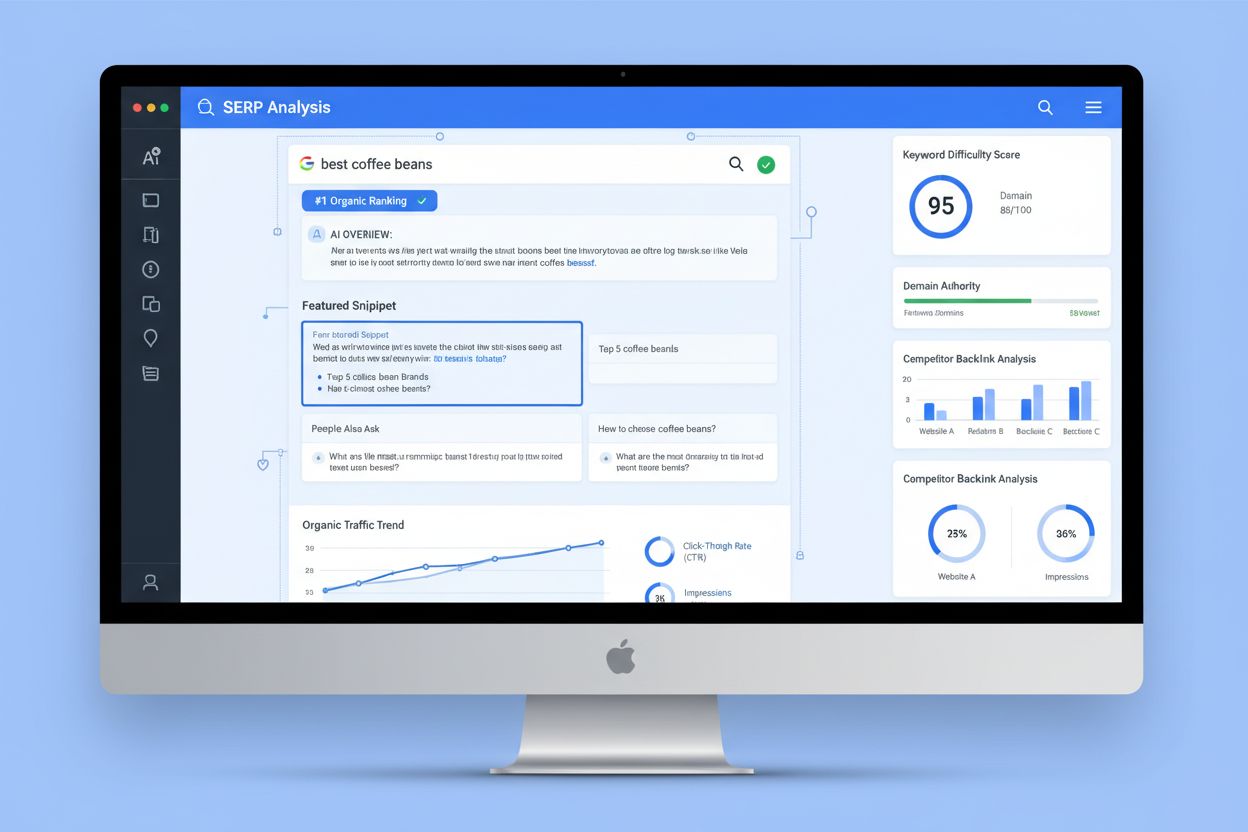

SERP-analyse is het proces van het onderzoeken van zoekresultatenpagina's van zoekmachines om de moeilijkheidsgraad van ranking, zoekintentie en concurrentiestr...

Discussie in de community over patronen in AI-crawlerfrequentie. Echte data over hoe vaak GPTBot, PerplexityBot en ClaudeBot websites bezoeken.

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.