AI-trainingscrawlers versus zoekcrawlers: het verschil uitgelegd

Ontdek de cruciale verschillen tussen AI-trainingscrawlers en zoekcrawlers. Leer hoe ze de zichtbaarheid van je content, optimalisatiestrategieën en AI-vermeldi...

Een scraper site is een website die automatisch content van andere bronnen kopieert zonder toestemming en deze opnieuw publiceert, vaak met minimale aanpassingen. Deze sites gebruiken geautomatiseerde bots om data, tekst, afbeeldingen en andere content van legitieme websites te verzamelen om hun eigen pagina’s te vullen, doorgaans voor frauduleuze doeleinden, plagiaat of om advertentie-inkomsten te genereren.

Een scraper site is een website die automatisch content van andere bronnen kopieert zonder toestemming en deze opnieuw publiceert, vaak met minimale aanpassingen. Deze sites gebruiken geautomatiseerde bots om data, tekst, afbeeldingen en andere content van legitieme websites te verzamelen om hun eigen pagina's te vullen, doorgaans voor frauduleuze doeleinden, plagiaat of om advertentie-inkomsten te genereren.

Een scraper site is een website die automatisch content van andere bronnen kopieert zonder toestemming en deze opnieuw publiceert, vaak met minimale aanpassingen of parafraseringen. Deze sites gebruiken geautomatiseerde bots om data, tekst, afbeeldingen, productbeschrijvingen en andere content van legitieme websites te verzamelen om hun eigen pagina’s te vullen. De praktijk is technisch gezien illegaal volgens het auteursrecht en schendt de gebruiksvoorwaarden van de meeste websites. Content scraping is fundamenteel verschillend van legitieme web scraping, omdat het gaat om ongeautoriseerd kopiëren van gepubliceerde content voor kwaadaardige doeleinden, waaronder fraude, plagiaat, het genereren van advertentie-inkomsten en diefstal van intellectueel eigendom. De geautomatiseerde aard van scraping stelt kwaadwillenden in staat om duizenden pagina’s in enkele minuten te kopiëren, wat een groot duplicaatcontentprobleem op het internet creëert.

Content scraping bestaat al sinds de begindagen van het internet, maar het probleem is enorm toegenomen door de vooruitgang in automatiseringstechnologie en kunstmatige intelligentie. In de vroege jaren 2000 waren scrapers relatief simpel en eenvoudig te detecteren. Moderne scraper bots zijn echter steeds geavanceerder geworden en gebruiken technieken als parafraseer-algoritmen, roterende IP-adressen en browserautomatisering om detectie te ontwijken. De opkomst van AI-gedreven contentgeneratie heeft het probleem verergerd, omdat scrapers nu machine learning inzetten om gestolen content te herschrijven op manieren die moeilijker als duplicaat te herkennen zijn. Volgens brancherapporten zijn scraper sites verantwoordelijk voor een aanzienlijk deel van het kwaadaardige botverkeer, waarbij sommige schattingen aangeven dat geautomatiseerde bots meer dan 40% van al het internetverkeer vertegenwoordigen. De opkomst van AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews heeft nieuwe uitdagingen gecreëerd, omdat deze systemen onbedoeld scraper sites kunnen citeren in plaats van oorspronkelijke contentmakers, waardoor het probleem wordt versterkt.

Scraper bots werken via een geautomatiseerd proces in meerdere stappen dat minimale menselijke tussenkomst vereist. Eerst crawlt de bot doelwebsites door links te volgen en pagina’s te bezoeken, waarbij de HTML-code en alle bijbehorende content wordt gedownload. Vervolgens parseert de bot de HTML om relevante data te extraheren, zoals artikeltekst, afbeeldingen, metadata en productinformatie. Deze geëxtraheerde content wordt opgeslagen in een database, waar deze mogelijk verder wordt verwerkt met parafraseertools of AI-gedreven herschrijfsoftware om variaties te maken die anders lijken dan het origineel. Tot slot wordt de gescrapete content opnieuw gepubliceerd op de scraper site, vaak met minimale naamsvermelding of onder valse auteursclaims. Sommige geavanceerde scrapers gebruiken roterende proxies en user-agent spoofing om hun verzoeken als legitiem menselijk verkeer te vermommen, waardoor ze moeilijker te detecteren en blokkeren zijn. Het hele proces kan volledig geautomatiseerd verlopen, waardoor één scraper-operatie dagelijks duizenden pagina’s kan kopiëren van meerdere websites tegelijk.

| Aspect | Scraper Site | Originele Content Site | Legitieme Data-aggregator |

|---|---|---|---|

| Contentoorsprong | Gekopieerd zonder toestemming | Origineel gecreëerd | Geselecteerd met bronvermelding en links |

| Juridische status | Illegaal (auteursrechtschending) | Beschermd door auteursrecht | Legaal (met juiste licentie) |

| Bronvermelding | Minimaal of onjuist | Originele auteur vermeld | Bronnen geciteerd en gelinkt |

| Doel | Fraude, plagiaat, advertentie-inkomsten | Waarde bieden aan publiek | Informatie verzamelen en organiseren |

| SEO-impact | Negatief (dubbele content) | Positief (originele content) | Neutraal tot positief (met juiste canonicalisatie) |

| Gebruikerservaring | Slecht (lage kwaliteit content) | Hoog (unieke, waardevolle content) | Goed (georganiseerde, geverifieerde content) |

| Gebruiksvoorwaarden | Schendt ToS | Voldoet aan eigen ToS | Respecteert website-ToS en robots.txt |

| Detectiemethoden | IP-tracking, botsignaturen | N.v.t. | Transparante crawlpatronen |

Scraper sites werken volgens verschillende verdienmodellen, allemaal gericht op het genereren van inkomsten uit gestolen content. Het meest voorkomende model is advertentie-gebaseerde monetisatie, waarbij scrapers hun pagina’s vullen met advertenties van netwerken zoals Google AdSense of andere advertentieplatforms. Door populaire content opnieuw te publiceren, trekken scrapers organisch zoekverkeer aan en genereren ze advertentie-impressies en klikken zonder enige originele waarde te creëren. Een ander veelvoorkomend model is e-commercefraude, waarbij scrapers nepwebwinkels creëren die legitieme retailers nabootsen, inclusief gekopieerde productbeschrijvingen, afbeeldingen en prijsinformatie. Onwetende klanten kopen op deze frauduleuze sites, ontvangen vervolgens nepproducten of krijgen hun betalingsinformatie gestolen. E-mail harvesting is een ander belangrijk verdienmodel, waarbij contactinformatie van websites wordt verzameld en verkocht aan spammers of gebruikt voor gerichte phishingcampagnes. Sommige scrapers houden zich ook bezig met affiliate marketingfraude, waarbij productreviews en content worden gekopieerd en eigen affiliatelinks worden ingevoegd om commissies te verdienen. De lage operationele kosten van scraping—waarbij alleen serverruimte en geautomatiseerde software nodig zijn—maken deze verdienmodellen zeer winstgevend ondanks hun illegale karakter.

De gevolgen van content scraping voor originele makers zijn ernstig en veelzijdig. Wanneer scrapers je content opnieuw publiceren op hun domeinen, creëren ze dubbele content die zoekmachines verwart over welke versie het origineel is. Het algoritme van Google kan het moeilijk vinden om de gezaghebbende bron vast te stellen, waardoor zowel de originele als de gescrapete versie lager kunnen ranken in de zoekresultaten. Dit heeft direct invloed op het organische verkeer, omdat je zorgvuldig geoptimaliseerde content zichtbaarheid verliest aan scraper sites die niets aan het maken ervan hebben bijgedragen. Buiten zoekresultaten om vervuilen scrapers je website-analytics met nepverkeer van bots, waardoor het lastig wordt om echt gebruikersgedrag en betrokkenheid te meten. Je serverbronnen worden ook verspild aan scraper botverzoeken, wat de bandbreedtekosten verhoogt en je site mogelijk vertraagt voor legitieme bezoekers. De negatieve SEO-impact strekt zich uit tot je domeinautoriteit en backlinkprofiel, omdat scrapers mogelijk links van lage kwaliteit naar je site creëren of je content gebruiken in spamcontexten. Bovendien, als scrapers hoger scoren dan je originele content in zoekresultaten, mis je de kans om thought leadership en autoriteit in je branche op te bouwen, wat je merkreputatie en geloofwaardigheid schaadt.

Het identificeren van scraper sites vereist een combinatie van handmatige en geautomatiseerde aanpak. Google Alerts is een van de meest effectieve gratis tools, waarmee je je artikeltitels, unieke zinnen en merknaam kunt monitoren op ongeautoriseerde herpublicatie. Als Google Alerts je op een overeenkomst wijst, kun je onderzoeken of het om een legitieme bronvermelding of een scraper site gaat. Pingback-monitoring is vooral nuttig voor WordPress-sites, omdat pingbacks worden gegenereerd wanneer een andere site naar je content linkt. Als je pingbacks ontvangt van onbekende of verdachte domeinen, kunnen dit scraper sites zijn die je interne links hebben gekopieerd. SEO-tools zoals Ahrefs, SEM Rush en Grammarly bieden functies voor het detecteren van dubbele content die het web scannen op pagina’s die overeenkomen met jouw content. Deze tools kunnen zowel exacte duplicaten als geparafraseerde versies van je artikelen identificeren. Serverlog-analyse biedt technische inzichten in botverkeerpatronen en onthult verdachte IP-adressen, ongebruikelijke aanvraagfrequenties en bot user-agent strings. Reverse image search via Google Images of TinEye kan aangeven waar je afbeeldingen zonder toestemming zijn hergebruikt. Regelmatige controle van je Google Search Console kan indexeringsafwijkingen en duplicaatproblemen aan het licht brengen die op scrapingactiviteit kunnen wijzen.

Content scraping schendt meerdere lagen van juridische bescherming en is een van de meest vervolgbare vormen van online fraude. Auteursrecht beschermt automatisch alle originele content, zowel online als in druk, en geeft makers exclusieve rechten om hun werk te reproduceren, verspreiden en tonen. Scraping zonder toestemming is directe inbreuk op het auteursrecht, waardoor scrapers civielrechtelijk aansprakelijk zijn voor schadevergoedingen en gerechtelijke bevelen. De Digital Millennium Copyright Act (DMCA) biedt extra bescherming door het omzeilen van technische maatregelen die toegang tot auteursrechtelijk beschermd werk reguleren, te verbieden. Als je toegangscontroles of anti-scrapingmaatregelen implementeert, maakt de DMCA het illegaal om deze te omzeilen. De Computer Fraud and Abuse Act (CFAA) kan ook van toepassing zijn op scraping, vooral wanneer bots zonder toestemming systemen benaderen of toegestane toegang overschrijden. Website-gebruiksvoorwaarden verbieden scraping expliciet, en het schenden hiervan kan leiden tot juridische actie wegens contractbreuk. Veel contentmakers hebben met succes juridische procedures tegen scrapers gevoerd en via de rechter content laten verwijderen en scraping laten stoppen. Sommige rechtsgebieden erkennen scraping ook als een vorm van oneerlijke concurrentie, waardoor bedrijven schadevergoeding kunnen eisen op basis van gederfde inkomsten en marktschade.

De opkomst van AI-zoekmachines en large language models (LLM’s) heeft een nieuwe dimensie aan het scraper site-probleem toegevoegd. Wanneer AI-systemen zoals ChatGPT, Perplexity, Google AI Overviews en Claude het web crawlen voor trainingsdata of om antwoorden te genereren, kunnen ze scraper sites naast originele content tegenkomen. Als de scraper site vaker voorkomt of technisch betere SEO heeft, kan het AI-systeem de scraper citeren in plaats van de oorspronkelijke bron. Dit is vooral problematisch omdat AI-citaties zwaar wegen bij het bepalen van merkzichtbaarheid en autoriteit. Als een scraper site wordt geciteerd in een AI-antwoord in plaats van jouw originele content, mis je de kans om je merk als autoritatieve bron te positioneren in AI-gestuurde zoekresultaten. Daarnaast kunnen scrapers onnauwkeurigheden of verouderde informatie in AI-trainingsdata introduceren, waardoor AI-systemen mogelijk foutieve of misleidende antwoorden genereren. Het probleem wordt verergerd doordat veel AI-systemen geen transparante bronvermelding tonen, waardoor gebruikers niet kunnen nagaan of ze originele content of gescrapet materiaal lezen. Monitoringtools zoals AmICited helpen contentmakers te volgen waar hun merk en content verschijnen op AI-platforms en identificeren wanneer scrapers concurreren om zichtbaarheid in AI-antwoorden.

Het beschermen van je content tegen scraping vereist een gelaagde technische en operationele aanpak. Botdetectie- en blokkeringstools zoals ClickCease’s Bot Zapping kunnen kwaadaardige bots identificeren en blokkeren voordat ze je content bereiken, doorverwijzend naar foutpagina’s in plaats van je echte pagina’s. Robots.txt-configuratie stelt je in staat bottoegang tot specifieke mappen of pagina’s te beperken, al negeren hardnekkige scrapers deze richtlijnen soms. Noindex-tags kunnen worden toegepast op gevoelige pagina’s of automatisch gegenereerde content (zoals WordPress-tag- en categoriepagina’s) om te voorkomen dat ze worden geïndexeerd en gescrapet. Content gating vereist dat gebruikers formulieren invullen of inloggen om premium content te bekijken, waardoor het voor bots lastiger wordt om op grote schaal informatie te verzamelen. Rate limiting op je server beperkt het aantal verzoeken van één IP-adres binnen een bepaalde periode, waardoor scraper bots worden vertraagd en hun activiteiten minder efficiënt worden. CAPTCHA-uitdagingen kunnen controleren of verzoeken van mensen komen in plaats van bots, al kunnen geavanceerde bots deze soms omzeilen. Server-side monitoring van aanvraagpatronen helpt verdachte activiteit te identificeren, zodat je problematische IP-adressen proactief kunt blokkeren. Regelmatige back-ups van je content garanderen dat je bewijs hebt van de originele creatiedatum, wat waardevol is als je juridische stappen moet ondernemen tegen scrapers.

Het scraperslandschap blijft zich ontwikkelen naarmate de technologie voortschrijdt en nieuwe kansen ontstaan. AI-gedreven parafrasering wordt steeds geavanceerder, waardoor gescrapete content moeilijker als duplicaat te detecteren is met traditionele plagiaattools. Scrapers investeren in geavanceerdere proxyrotatie en browserautomatisering om botsystemen te ontwijken. De opkomst van AI-trainingsdata scraping vormt een nieuw front, waarbij scrapers zich specifiek richten op content voor gebruik in machine learning-modellen, vaak zonder enige vergoeding aan de originele makers. Sommige scrapers gebruiken inmiddels headless browsers en JavaScript-rendering om dynamische content te benaderen die traditionele scrapers niet konden bereiken. De integratie van scraping met affiliate marketingnetwerken en advertentiefraudeschema’s zorgt voor complexere en lastiger te detecteren scraper-operaties. Maar er zijn ook positieve ontwikkelingen: AI-detectiesystemen worden steeds beter in het herkennen van gescrapete content, en zoekmachines straffen scraper sites steeds zwaarder af in hun algoritmes. De Google core update van november 2024 was specifiek gericht op scraper sites, wat leidde tot fors verminderde zichtbaarheid voor veel scraper-domeinen. Contentmakers passen ook steeds vaker watermarkingtechnologieën en blockchain-gebaseerde verificatie toe om originele creatie en eigenaarschap te bewijzen. Naarmate AI-zoekmachines volwassen worden, implementeren ze betere bronvermelding en transparantie om ervoor te zorgen dat originele makers de juiste erkenning en zichtbaarheid krijgen.

Voor contentmakers en merkbeheerders reikt de uitdaging van scraper sites verder dan traditionele zoekmachines tot het opkomende landschap van AI-gedreven zoek- en antwoordsystemen. AmICited biedt gespecialiseerde monitoring waarmee je kunt volgen waar je merk, content en domein verschijnen op AI-platforms zoals Perplexity, ChatGPT, Google AI Overviews en Claude. Door je AI-zichtbaarheid te monitoren, kun je identificeren wanneer scraper sites concurreren om citaties in AI-antwoorden, wanneer jouw originele content correct wordt vermeld, en wanneer ongeautoriseerde kopieën aan terrein winnen. Deze inzichten stellen je in staat om proactief stappen te ondernemen ter bescherming van je intellectueel eigendom en het behoud van je merkautoriteit in AI-gestuurde zoekresultaten. Het begrijpen van het verschil tussen legitieme contentaggregatie en kwaadaardig scraping is cruciaal in het AI-tijdperk, aangezien de inzet voor merkzichtbaarheid en autoriteit nog nooit zo hoog is geweest.

Ja, content scraping is technisch gezien illegaal in de meeste rechtsgebieden. Het schendt auteursrechten die digitale content op dezelfde manier beschermen als fysieke publicaties. Daarnaast schendt scraping vaak de gebruiksvoorwaarden van websites en kan het leiden tot juridische stappen op grond van de Digital Millennium Copyright Act (DMCA) en de Computer Fraud and Abuse Act (CFAA). Website-eigenaren kunnen civiele en strafrechtelijke aansprakelijkheid eisen tegen scrapers.

Scraper sites hebben op meerdere manieren een negatieve impact op SEO. Wanneer dubbele content van scrapers hoger scoort dan het origineel, vermindert dit de zichtbaarheid en het organische verkeer van de originele site. Het algoritme van Google heeft moeite om te bepalen welke versie het origineel is, waardoor alle versies mogelijk lager scoren. Daarnaast verspillen scrapers het crawlbudget van je site en kunnen ze je analytics verstoren, waardoor het moeilijk is om echt gebruikersgedrag en prestatiecijfers te begrijpen.

Scraper sites dienen verschillende kwaadaardige doeleinden: het opzetten van nepwebwinkels om fraude te plegen, het hosten van nagemaakte websites die legitieme merken imiteren, het genereren van advertentie-inkomsten via frauduleus verkeer, het plagiaat plegen van content om pagina's zonder moeite te vullen, en het verzamelen van e-maillijsten en contactinformatie voor spamcampagnes. Sommige scrapers richten zich ook op prijsinformatie, productgegevens en socialmediacontent voor concurrentie-informatie of doorverkoop.

Je kunt gescrapete content detecteren met verschillende methodes: stel Google Alerts in voor je artikeltitels of unieke zinnen, zoek je contenttitels in Google om te zien of er duplicaten verschijnen, controleer op pingbacks bij interne links (vooral in WordPress), gebruik SEO-tools zoals Ahrefs of SEM Rush om dubbele content te vinden, en monitor de verkeerspatronen van je website op ongebruikelijke botactiviteit. Regelmatige monitoring helpt je snel scrapers te identificeren.

Web scraping is een bredere technische term voor het verzamelen van data van websites, wat legitiem kan zijn als dit met toestemming gebeurt voor onderzoek of data-analyse. Content scraping verwijst specifiek naar het ongeautoriseerd kopiëren van gepubliceerde content zoals artikelen, productbeschrijvingen en afbeeldingen voor herpublicatie. Waar web scraping legaal kan zijn, is content scraping per definitie kwaadaardig en illegaal omdat het auteursrecht en gebruiksvoorwaarden schendt.

Scraper bots gebruiken geautomatiseerde software om websites te crawlen, HTML-content te downloaden, tekst en afbeeldingen te extraheren en deze op te slaan in databases. Deze bots simuleren menselijk surfgedrag om basale detectiemethoden te omzeilen. Ze kunnen zowel publiek zichtbare content als soms verborgen databases benaderen als de beveiliging zwak is. De verzamelde data wordt vervolgens verwerkt, soms geparafraseerd met AI-tools, en opnieuw gepubliceerd op scraper sites met minimale aanpassingen om exacte duplicaatdetectie te voorkomen.

Effectieve preventiestrategieën zijn onder andere het implementeren van botdetectie- en blokkeringstools, het gebruik van robots.txt om bots de toegang te weigeren, het toevoegen van noindex-tags aan gevoelige pagina's, het afschermen van premium content achter inlogformulieren, het regelmatig monitoren van je site met Google Alerts en SEO-tools, het toepassen van CAPTCHA-uitdagingen, het instellen van rate limiting op je server en het monitoren van je serverlogs op verdachte IP-adressen en verkeerspatronen. Een gelaagde aanpak is het meest effectief.

Scraper sites vormen een aanzienlijke uitdaging voor AI-zoekmachines zoals ChatGPT, Perplexity en Google AI Overviews. Wanneer AI-systemen het web crawlen voor trainingsdata of om antwoorden te genereren, kunnen ze gescrapete content tegenkomen en scraper sites citeren in plaats van originele bronnen. Dit vermindert de zichtbaarheid van legitieme contentmakers in AI-antwoorden en kan ertoe leiden dat AI-systemen desinformatie verspreiden. Monitoringtools zoals AmICited helpen je te volgen waar je merk en content verschijnen op AI-platforms.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek de cruciale verschillen tussen AI-trainingscrawlers en zoekcrawlers. Leer hoe ze de zichtbaarheid van je content, optimalisatiestrategieën en AI-vermeldi...

Ontdek welke AI-crawlers je moet toestaan of blokkeren in je robots.txt. Uitgebreide gids over GPTBot, ClaudeBot, PerplexityBot en 25+ AI-crawlers met configura...

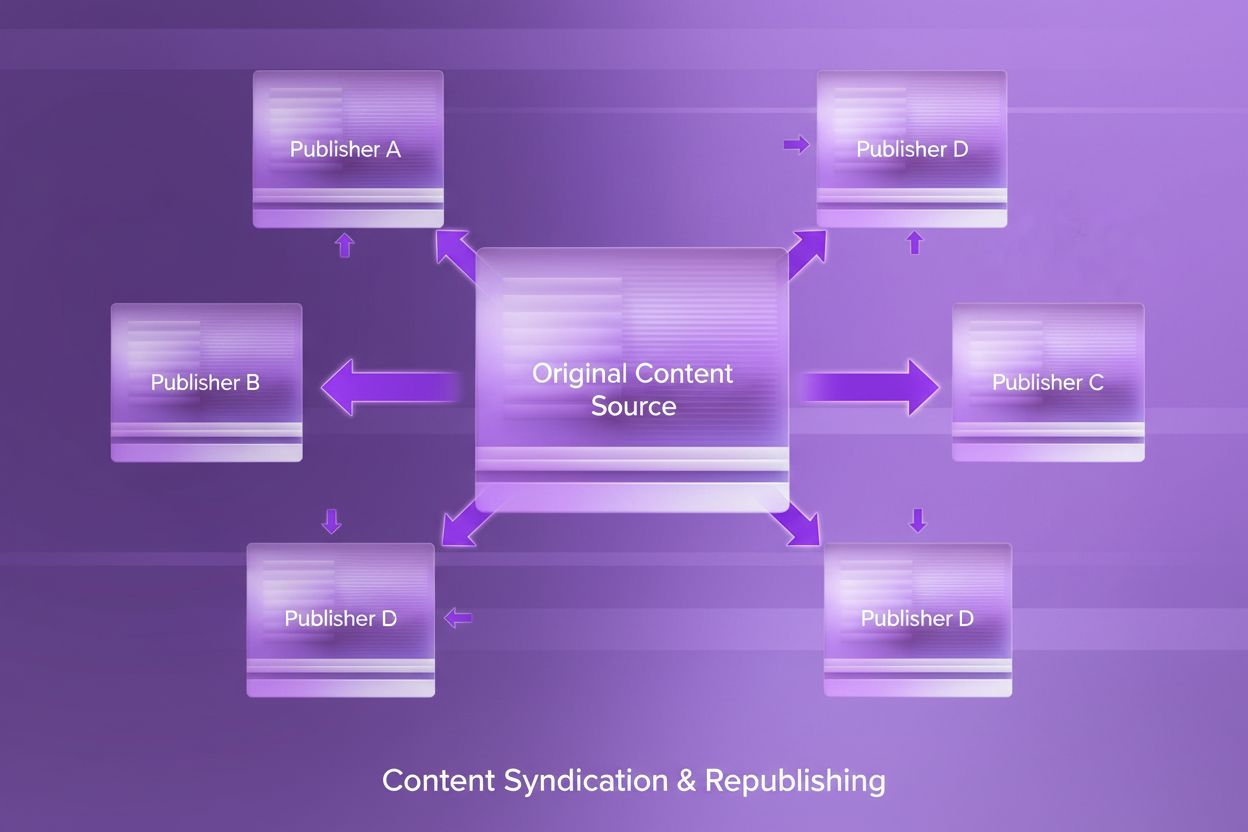

Ontdek wat content syndication is, hoe het werkt, de SEO-implicaties en best practices voor het herpubliceren van content op verschillende platforms om bereik t...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.