Spamdetectie

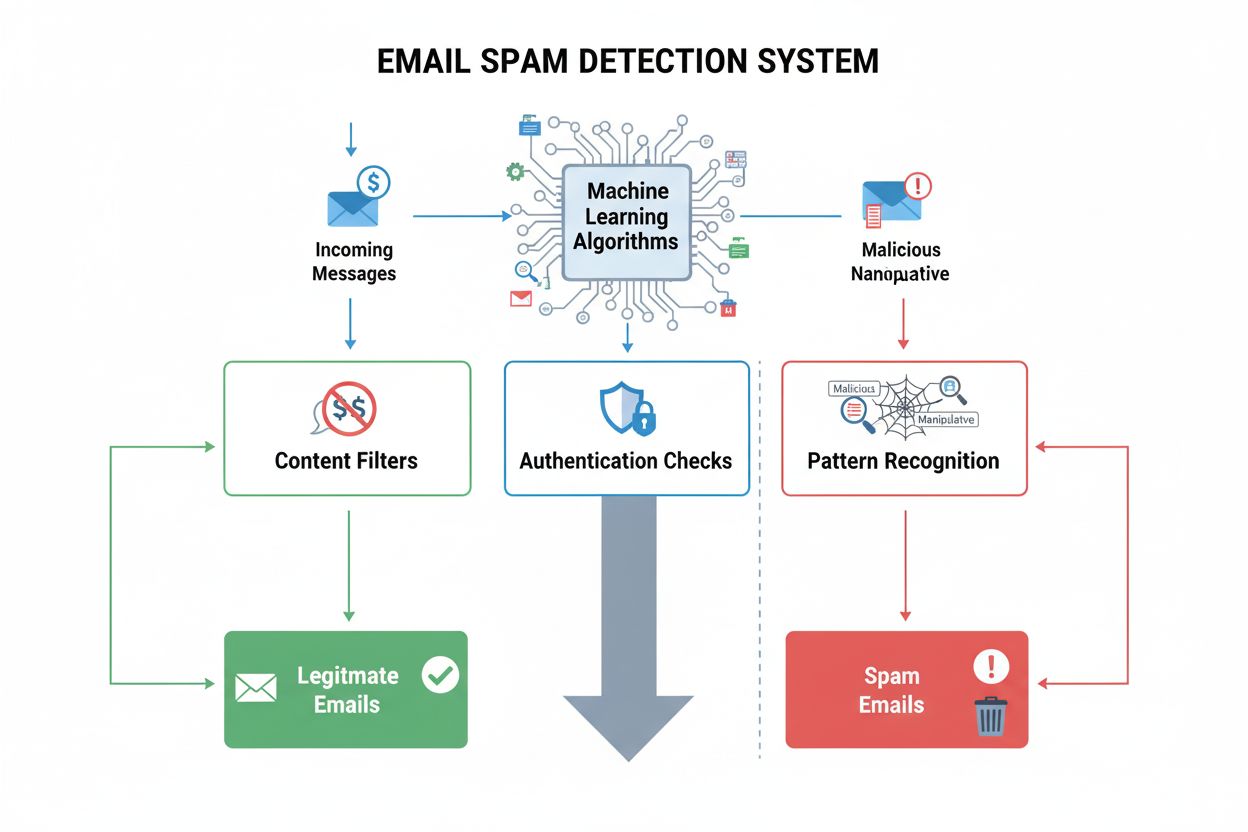

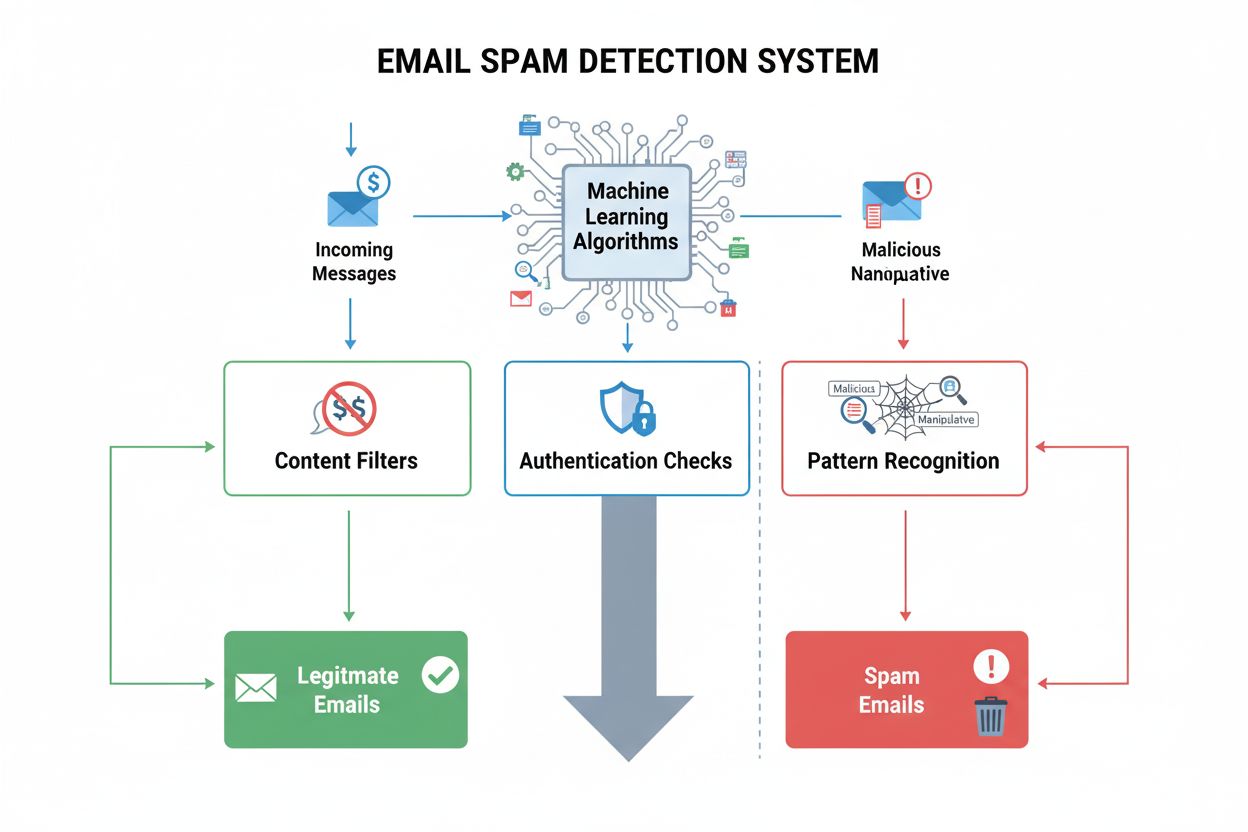

Spamdetectie identificeert ongewenste, manipulatieve inhoud met ML-algoritmen en gedragsanalyse. Ontdek hoe AI-systemen spam filteren in e-mail, sociale media, ...

Zoekmachine-spam verwijst naar opzettelijke manipulatie-tactieken die worden gebruikt om de zoekmachineresultaten kunstmatig te beïnvloeden via misleidende technieken die in strijd zijn met de richtlijnen van zoekmachines. Deze praktijken omvatten keyword stuffing, cloaking, linkfarms en verborgen tekst, en zijn ontworpen om algoritmes te misleiden in plaats van echte waarde aan gebruikers te bieden.

Zoekmachine-spam verwijst naar opzettelijke manipulatie-tactieken die worden gebruikt om de zoekmachineresultaten kunstmatig te beïnvloeden via misleidende technieken die in strijd zijn met de richtlijnen van zoekmachines. Deze praktijken omvatten keyword stuffing, cloaking, linkfarms en verborgen tekst, en zijn ontworpen om algoritmes te misleiden in plaats van echte waarde aan gebruikers te bieden.

Zoekmachine-spam, ook wel bekend als spamdexing, verwijst naar de opzettelijke manipulatie van zoekmachine-indexen via misleidende technieken die bedoeld zijn om de positie van een website kunstmatig te verhogen. De term omvat een breed scala aan onethische praktijken die in strijd zijn met de richtlijnen van zoekmachines, waaronder keyword stuffing, cloaking, linkfarms, verborgen tekst en sneaky redirects. Deze tactieken zijn gericht op het misleiden van zoekalgoritmes in plaats van het bieden van echte waarde aan gebruikers, wat de integriteit van zoekresultaten fundamenteel ondermijnt. Wanneer zoekmachines spam op een website detecteren, leggen ze doorgaans straffen op die variëren van lagere rankings tot volledige verwijdering uit de zoekindexen, waardoor de site onzichtbaar wordt voor potentiële bezoekers.

Zoekmachine-spam bestaat sinds de vroege dagen van het internet, toen zoekalgoritmes minder geavanceerd en gemakkelijker te manipuleren waren. In de jaren 90 en het begin van de jaren 2000 verspreidden spamdexing-technieken zich snel, omdat webmasters ontdekten dat ze de rankings kunstmatig konden verhogen via eenvoudige herhaling van zoekwoorden en linkmanipulatie. Naarmate zoekmachines evolueerden, vooral na de introductie van PageRank door Google en latere algoritme-updates zoals Panda (2011) en Penguin (2012), werd het opsporen en bestraffen van spam steeds geavanceerder. De opkomst van SpamBrain, het op AI gebaseerde spam-preventiesysteem van Google dat in 2022 werd geïntroduceerd, markeerde een belangrijke verschuiving naar machine learning-gestuurde spamdetectie. Tegenwoordig gebruiken zoekmachines geavanceerde algoritmes die honderden rankingfactoren analyseren, waardoor traditionele spamtactieken grotendeels ineffectief zijn geworden en er tegelijkertijd nieuwe kansen ontstaan voor geavanceerdere manipulatiepogingen.

Keyword stuffing blijft een van de meest herkenbare spamtactieken en houdt in dat doelzoekwoorden onnatuurlijk vaak worden herhaald in de pagina-inhoud, meta tags en verborgen elementen. Deze praktijk verhoogt kunstmatig de zoekwoorddichtheid zonder samenhangende of waardevolle informatie aan lezers te bieden. Cloaking is een meer misleidende aanpak waarbij er andere content aan zoekmachine-crawlers wordt getoond dan aan gebruikers, meestal via JavaScript of server-side technieken waarmee bots en menselijke bezoekers van elkaar worden onderscheiden. Linkfarms en Private Blog Networks (PBN’s) vormen een andere belangrijke categorie spam: netwerken van websites van lage kwaliteit die uitsluitend zijn gemaakt om kunstmatige backlinks naar doelwebsites te genereren. Deze netwerken maken misbruik van het feit dat zoekmachines backlinks historisch zwaar wogen als rankingfactor, hoewel moderne algoritmes steeds beter zijn geworden in het herkennen en waardeloos maken van dergelijke kunstmatige linkconstructies.

Sneaky redirects manipuleren gebruikersgedrag door bezoekers naar andere URL’s te sturen dan de zoekmachines crawlen, vaak door gebruikers na een klik vanuit zoekresultaten om te leiden naar irrelevante of kwaadaardige content. Verborgen tekst en links betekenen dat content in kleuren wordt geplaatst die overeenkomen met de achtergrond, extreem kleine lettertypes worden gebruikt, of tekst buiten het scherm wordt gepositioneerd—waardoor deze onzichtbaar is voor menselijke bezoekers maar zichtbaar blijft voor crawlers. Commentaarspam en forumspam maken misbruik van platforms met door gebruikers gegenereerde content door automatisch links en promotionele inhoud te plaatsen op blogs, fora en sociale mediaplatforms. Content scraping houdt in dat content zonder toestemming of aanpassing van andere websites wordt gekopieerd en opnieuw gepubliceerd om het aantal pagina’s kunstmatig te vergroten en zoekverkeer aan te trekken. Al deze tactieken zijn bedoeld om zoekalgoritmes te misleiden in plaats van op legitieme wijze rankings te verdienen.

| Aspect | Zoekmachine-spam (Black Hat) | Legitieme SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Primair doel | Manipuleren van algoritmes via misleiding | Waarde bieden aan gebruikers, rankings op natuurlijke wijze verdienen | Grijze gebieden in richtlijnen benutten |

| Contentkwaliteit | Lage kwaliteit, keyword stuffing of gescrapet | Hoge kwaliteit, origineel, gericht op gebruiker | Gemengde kwaliteit met twijfelachtige tactieken |

| Linkbuilding | Kunstmatige links van farms, PBN’s of gehackte sites | Natuurlijke links verdiend door kwaliteit | Gekochte links of wederkerige linkconstructies |

| Technische methoden | Cloaking, verborgen tekst, sneaky redirects | Schone HTML, juiste meta tags, gestructureerde data | JavaScript-redirects, doorway pages |

| Gebruikerservaring | Slecht; content gericht op algoritmes, niet op gebruikers | Uitstekend; content gericht op gebruikers | Matig; soms concessies aan gebruikservaring |

| Zoekmachine-straffen | Handmatige acties, de-indexering, rankingdalingen | Geen; doorlopende verbetering in rankings | Potentiële straffen bij ontdekking |

| Duurzaamheid | Onhoudbaar; straffen onvermijdelijk | Duurzaam; bouwt blijvende autoriteit op | Risicovol; afhankelijk van kans op ontdekking |

| Hersteltijd | Maanden tot jaren; sommige voordelen blijvend verloren | N.v.t.; geen straffen om van te herstellen | Weken tot maanden bij ontdekking |

SpamBrain betekent een fundamentele verandering in hoe zoekmachines spam bestrijden via kunstmatige intelligentie en machine learning. Google introduceerde SpamBrain in 2022; het systeem analyseert patronen op miljarden websites om spamkenmerken met ongekende nauwkeurigheid te herkennen. Het systeem werkt continu en onderzoekt zowel on-page factoren (contentkwaliteit, zoekwoordverdeling, structurele elementen) als off-page signalen (linkprofielen, domeingeschiedenis, gebruikersgedragspatronen). De machine learning-modellen van SpamBrain zijn getraind op grote datasets van bekende spam- en legitieme websites, waardoor het systeem nieuwe spamvariaties kan herkennen voordat deze wijdverspreid raken. Het AI-systeem kan geavanceerde spampogingen identificeren die regelgebaseerde detectiesystemen mogelijk ontwijken, zoals gecoördineerde linkconstructies, contentmanipulatie en misbruik van gehackte websites. Volgens Google heeft SpamBrain geleid tot ongeveer 45% minder content van lage kwaliteit en ongeoorloofde herkomst in de zoekresultaten sinds de invoering, waarmee de effectiviteit van AI-gestuurde spamdetectie wordt aangetoond.

De toename van zoekmachine-spam vermindert direct de kwaliteit en bruikbaarheid van zoekresultaten voor eindgebruikers. Wanneer spamcontent hoog scoort, komen gebruikers irrelevante, kwalitatief slechte of misleidende informatie tegen in plaats van gezaghebbende bronnen die hun vragen daadwerkelijk beantwoorden. Deze verslechtering van de zoekkwaliteit ondermijnt het vertrouwen van gebruikers in zoekmachines en dwingt platforms veel te investeren in spamdetectie en -verwijdering. De aanwezigheid van spam creëert ook een oneerlijk speelveld waarin legitieme bedrijven tijdelijk moeten concurreren met sites die onethische tactieken toepassen. Zoekmachines reageren op de verspreiding van spam met periodieke spamupdates—belangrijke verbeteringen aan hun spamdetectiesystemen die afzonderlijk van kernalgoritme-updates worden aangekondigd en gevolgd. De spamupdate van Google in december 2024 bijvoorbeeld werd wereldwijd in alle talen uitgerold en duurde tot een week voordat deze volledig was geïmplementeerd, wat de schaal en frequentie van spambestrijding laat zien. De voortdurende wapenwedloop tussen spammers en zoekmachines vergt aanzienlijke computerbronnen en technische inspanning die anders besteed zou kunnen worden aan het verbeteren van zoekkwaliteit.

Websites die zich schuldig maken aan zoekmachine-spam lopen uiteenlopende risico’s, van algoritmische straffen tot handmatige acties en volledige verwijdering uit de zoekresultaten. Handmatige acties zijn de meest directe reactie van Google op spam; menselijke beoordelaars identificeren overtredingen en leggen via Google Search Console specifieke straffen op. Deze acties informeren site-eigenaren over concrete overtredingen—zoals onnatuurlijke links, keyword stuffing of cloaking—en leiden meestal tot sterke dalingen in ranking of verwijdering uit de zoekresultaten. Algoritmische straffen treden op wanneer de automatische systemen van Google spam patronen detecteren en de zichtbaarheid van een site verminderen zonder menselijke tussenkomst. Deze straffen kunnen tijdelijk zijn (tot de spam is verwijderd en de site opnieuw is gecrawld) of permanent als de overtredingen ernstig of herhaald zijn. In extreme gevallen worden websites volledig gedeïndexeerd, waardoor ze helemaal niet meer in de zoekresultaten van Google verschijnen en hun organische zichtbaarheid wordt gewist. Herstel van handmatige acties vereist grondig herstel, uitgebreide documentatie van de wijzigingen en het indienen van een heroverwegingsverzoek via Google Search Console. Zelfs na succesvol herstel kunnen websites de rankingvoordelen die eerder door spamlinks zijn verkregen echter niet terugkrijgen—die voordelen zijn permanent verloren.

De opkomst van AI-gestuurde zoeksystemen zoals ChatGPT, Perplexity, Google AI Overviews en Claude brengt nieuwe dimensies in het probleem van zoekmachine-spam. Deze systemen zijn afhankelijk van webcontent om antwoorden te genereren, waardoor ze kwetsbaar zijn voor spam en content van lage kwaliteit die hun output kan beïnvloeden. In tegenstelling tot traditionele zoekmachines die gerangschikte lijsten tonen, synthetiseren AI-systemen informatie tot natuurlijke taalantwoorden, waardoor de impact van spam groter kan zijn als deze invloed heeft op de trainingsdata of op de retrieval-mechanismen. Organisaties zoals AmICited richten zich op deze uitdaging door AI-prompts monitoring te bieden, waarmee ze bijhouden waar merken en domeinen worden genoemd in AI-antwoorden. Deze monitoring is belangrijk omdat spamcontent in AI-antwoorden de reputatie en zichtbaarheid van een merk kan schaden op manieren die verschillen van traditionele zoekresultaten. Naarmate AI-systemen een grotere rol spelen in hoe mensen informatie vinden, wordt het belang van monitoring en het voorkomen van spam in deze nieuwe zoekparadigma’s exponentieel groter. De uitdaging voor AI-systemen is om onderscheid te maken tussen gezaghebbende bronnen en spamcontent bij het bepalen van welke informatie wordt opgenomen in gegenereerde antwoorden.

Organisaties die streven naar duurzame zichtbaarheid in zoekmachines moeten uitgebreide strategieën toepassen om spamtactieken te vermijden en te voldoen aan de richtlijnen van zoekmachines. Contentstrategie moet gericht zijn op het creëren van originele, kwalitatieve en op de gebruiker gerichte content die relevante zoekwoorden op een natuurlijke manier integreert, zonder kunstmatige herhaling of manipulatie. Linkbuilding moet zich richten op het verdienen van natuurlijke backlinks via contentkwaliteit, branchecontacten en legitieme outreach, niet op het kopen van links of deelnemen aan linkconstructies. Technische SEO moet de nadruk leggen op schone HTML, juiste meta tags, implementatie van gestructureerde data en transparante redirects die zoekmachines en gebruikers identiek behandelen. Regelmatige audits van websitecontent, links en technische elementen helpen potentiële spamproblemen vroegtijdig te identificeren voordat ze tot straffen leiden. Monitoringtools moeten rankings, backlinkprofielen en zoekzichtbaarheid volgen om ongebruikelijke veranderingen te signaleren die kunnen wijzen op spamproblemen of aanvallen van concurrenten. Optimalisatie van de gebruikerservaring zorgt ervoor dat content in de eerste plaats voor menselijke bezoekers wordt gemaakt, met zoekmachine-optimalisatie als secundaire overweging. Organisaties moeten ook duidelijke interne beleidsregels opstellen die spamtactieken verbieden en teamleden voorlichten over de risico’s en gevolgen van manipulatie.

De toekomst van zoekmachine-spamdetectie zal steeds meer vertrouwen op geavanceerde kunstmatige intelligentie en machine learning-systemen die geavanceerde manipulatiepogingen in realtime kunnen herkennen. SpamBrain en soortgelijke AI-systemen zullen zich blijven ontwikkelen om nieuwe spamvariaties sneller te detecteren dan menselijke spammers ze kunnen bedenken, waardoor een steeds snellere wapenwedloop ontstaat tussen detectie en ontwijking. De integratie van AI-gestuurde zoeksystemen in reguliere zoekervaringen vereist nieuwe spamdetectiemethoden die zijn afgestemd op hoe deze systemen informatie ophalen en synthetiseren. Zoekmachines zullen waarschijnlijk meer geavanceerde analyses van gebruikersgedrag inzetten om spam te herkennen op basis van hoe echte gebruikers met content omgaan, in plaats van uitsluitend op technische signalen te vertrouwen. Cross-platform monitoring wordt steeds belangrijker nu spamtactieken zich ontwikkelen om meerdere zoeksystemen tegelijk te targeten—traditionele zoekmachines, AI-chatbots en nieuwe zoekparadigma’s. De opkomst van generatieve AI-content brengt nieuwe spamuitdagingen met zich mee, aangezien geautomatiseerde systemen grootschalig plausibel ogende maar kwalitatief lage of misleidende content kunnen produceren. Organisaties zoals AmICited zullen een steeds belangrijkere rol spelen bij het helpen van merken om hun zichtbaarheid in diverse zoeksystemen te monitoren en spamdreigingen te detecteren voordat deze de zichtbaarheid beïnvloeden. Uiteindelijk zal de meest effectieve spampreventie een combinatie zijn van geavanceerde algoritmische detectie, menselijke expertise, gebruikersfeedback en samenwerking binnen de branche om zoekkwaliteit en gebruikersvertrouwen te waarborgen.

Zoekmachine-spam schendt de richtlijnen van zoekmachines en gebruikt misleidende tactieken om posities te manipuleren, terwijl legitieme SEO white-hat praktijken volgt die echte waarde aan gebruikers bieden. Legitieme SEO richt zich op het creëren van kwalitatieve content, het verdienen van natuurlijke backlinks en het verbeteren van de gebruikerservaring, terwijl spamtactieken zoals keyword stuffing en cloaking proberen algoritmes te misleiden. De richtlijnen van Google verbieden spamtactieken expliciet, en websites die deze gebruiken lopen het risico op handmatige straffen of volledige verwijdering uit de zoekresultaten.

Google gebruikt **SpamBrain**, een AI-gebaseerd spam-preventiesysteem dat websites continu monitort op overtredingen van spampolicy's. SpamBrain gebruikt machine learning-algoritmes om patronen te herkennen die geassocieerd zijn met spam, waaronder onnatuurlijke linkprofielen, keyword stuffing, cloaking en andere misleidende technieken. Het systeem analyseert zowel on-page als off-page factoren, signalen van gebruikersgedrag en contentkwaliteitsmetingen om onderscheid te maken tussen legitieme content en spam. Google voert ook handmatige beoordelingen uit en ontvangt gebruikersmeldingen via Search Console om spamwebsites te identificeren en te bestraffen.

De belangrijkste zoekmachine-spam tactieken zijn onder meer **keyword stuffing** (pagina's overladen met zoekwoorden), **cloaking** (verschillende content tonen aan zoekmachines en gebruikers), **sneaky redirects** (gebruikers omleiden naar andere pagina's dan de zoekmachine ziet), **linkfarms** (netwerken van lage kwaliteit sites die uitsluitend zijn gemaakt voor linkbuilding), **verborgen tekst en links** (content onzichtbaar voor gebruikers maar zichtbaar voor crawlers), en **commentaarspam** (geautomatiseerde spam in reacties en fora). Elke tactiek probeert zoekalgoritmes te manipuleren via misleiding in plaats van echte gebruikerswaarde te bieden.

Google legt verschillende straffen op voor zoekmachine-spam, variërend van dalingen in de ranking tot volledige verwijdering uit de index. Sites kunnen **handmatige acties** ontvangen via Google Search Console waarin specifieke overtredingen worden aangegeven, of ze kunnen getroffen worden door algoritmische spam-updates die automatisch de zichtbaarheid verminderen. In ernstige gevallen kunnen websites volledig uit de index van Google worden verwijderd, waardoor ze onzichtbaar worden in de zoekresultaten. Herstel vereist het identificeren en verwijderen van alle spamelementen, gevolgd door een heroverwegingsverzoek via Search Console. Het herstelproces kan maanden duren, en sommige rankingvoordelen die door spamlinks zijn verkregen, kunnen niet worden teruggewonnen.

Zoekmachine-spam vormt aanzienlijke uitdagingen voor AI-gestuurde zoeksystemen zoals **ChatGPT**, **Perplexity** en **Google AI Overviews**. Deze systemen zijn afhankelijk van webcontent om antwoorden te genereren en spam kan hun trainingsdata vervuilen of hun output beïnvloeden. Platforms zoals AmICited monitoren waar merken en domeinen verschijnen in AI-antwoorden, zodat organisaties kunnen bijhouden of spam of content van lage kwaliteit hun zichtbaarheid beïnvloedt. Naarmate AI-systemen belangrijker worden, wordt spamdetectie steeds crucialer om te waarborgen dat deze platforms nauwkeurige, betrouwbare informatie aan gebruikers bieden.

Ja, websites kunnen herstellen van spamstraffen, maar het proces vereist uitgebreide herstelmaatregelen. Website-eigenaren moeten alle spamelementen identificeren—including keyword stuffing, onnatuurlijke links, cloaking en verborgen content—en deze volledig verwijderen. Na opschoning dienen ze een heroverwegingsverzoek in via Google Search Console met gedetailleerde documentatie van de aangebrachte wijzigingen. Herstel duurt doorgaans enkele maanden omdat Google tijd nodig heeft om de site opnieuw te crawlen en te herbeoordelen. Rankingvoordelen die eerder door spamlinks zijn verkregen, kunnen echter niet worden herwonnen, en sites moeten zich richten op het opbouwen van legitieme autoriteit via kwalitatieve content en natuurlijke linkacquisitie.

Het monitoren van zoekmachine-spam is cruciaal omdat spamcontent de reputatie en zichtbaarheid van een merk op zoekplatforms kan schaden. Concurrenten kunnen spamtactieken gebruiken gericht op jouw merk, of je eigen website kan worden gecompromitteerd en gebruikt voor spam. Tools zoals **AmICited** helpen organisaties hun merkvermeldingen te volgen in AI-zoeksystemen en traditionele zoekmachines, zodat ze kunnen zien of spam of content van lage kwaliteit verschijnt in plaats van legitieme merkinformatie. Deze monitoring maakt proactieve opsporing van spamproblemen mogelijk en helpt de merkintegriteit te behouden in zoekresultaten en AI-gegenereerde antwoorden.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Spamdetectie identificeert ongewenste, manipulatieve inhoud met ML-algoritmen en gedragsanalyse. Ontdek hoe AI-systemen spam filteren in e-mail, sociale media, ...

Cloaking is een black-hat SEO-techniek waarbij andere content aan zoekmachines wordt getoond dan aan gebruikers. Ontdek hoe het werkt, de risico's, detectiemeth...

Leer wat keyword stuffing is, waarom het schadelijk is voor SEO, hoe Google het detecteert en best practices om deze black-hat tactiek te vermijden die de ranki...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.