Wat is vectorzoekopdracht en hoe werkt het?

Ontdek hoe vectorzoekopdracht machine learning-embeddings gebruikt om vergelijkbare items te vinden op basis van betekenis in plaats van exacte zoekwoorden. Beg...

Vector search is een methode om vergelijkbare items in een dataset te vinden door data te representeren als wiskundige vectoren en deze te vergelijken met behulp van afstandsmetingen zoals cosinusgelijkheid of Euclidische afstand. Deze benadering maakt semantisch begrip mogelijk, voorbij het zoeken op trefwoorden, waardoor systemen relaties en overeenkomsten op basis van betekenis kunnen ontdekken in plaats van exacte tekstovereenkomsten.

Vector search is een methode om vergelijkbare items in een dataset te vinden door data te representeren als wiskundige vectoren en deze te vergelijken met behulp van afstandsmetingen zoals cosinusgelijkheid of Euclidische afstand. Deze benadering maakt semantisch begrip mogelijk, voorbij het zoeken op trefwoorden, waardoor systemen relaties en overeenkomsten op basis van betekenis kunnen ontdekken in plaats van exacte tekstovereenkomsten.

Vector search is een methode om vergelijkbare items in een dataset te vinden door data te representeren als wiskundige vectoren en deze te vergelijken met afstandsmetingen om semantische gelijkenis te bepalen. In tegenstelling tot traditioneel zoeken op trefwoord, dat vertrouwt op exacte tekstovereenkomsten, begrijpt vector search de betekenis en context achter data door deze om te zetten in hoog-dimensionale numerieke representaties, genaamd vector embeddings. Deze aanpak maakt het mogelijk om relaties en overeenkomsten te ontdekken op basis van semantische inhoud in plaats van oppervlakkige kenmerken, waardoor het bijzonder krachtig is voor toepassingen die contextueel begrip vereisen. Vector search is fundamenteel geworden voor moderne AI-systemen en maakt semantisch zoeken, aanbevelingsengines, anomaliedetectie en retrieval-augmented generation (RAG) mogelijk op platforms zoals ChatGPT, Perplexity, Google AI Overviews en Claude.

In de kern transformeert vector search data in numerieke representaties waarbij nabijheid in de ruimte semantische gelijkenis aanduidt. Elk datapunt—of het nu tekst, beeld of audio is—wordt omgezet in een vector, wat in feite een array van getallen is die kenmerken of betekenis weergeven. Zo kan het woord “restaurant” worden weergegeven als [0.2, -0.5, 0.8, 0.1], waarbij elk getal verschillende aspecten van de semantische betekenis van het woord vastlegt. Het fundamentele principe is dat semantisch vergelijkbare items vectoren hebben die dicht bij elkaar liggen in deze hoog-dimensionale ruimte, terwijl niet-verwante items ver uit elkaar liggen. Deze wiskundige structuur stelt computers in staat concepten te vergelijken op basis van betekenis in plaats van exacte trefwoordovereenkomsten, waardoor een zoekopdracht naar “beste eetgelegenheden” ook resultaten oplevert voor “top-rated restaurants”, zelfs zonder exacte woordoverlap.

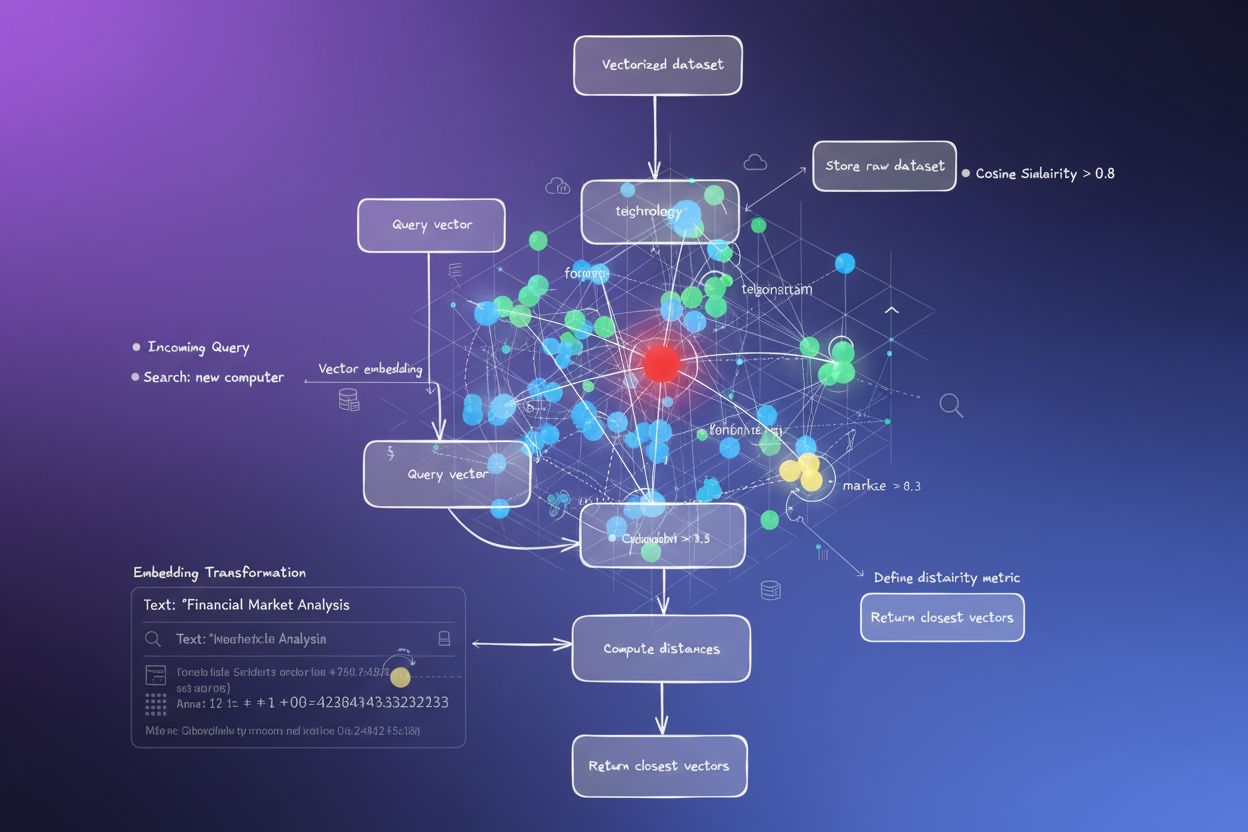

Het proces van het omzetten van data in vectoren heet embedding en wordt uitgevoerd door machine learning modellen die getraind zijn op grote datasets. Deze modellen leren vergelijkbare concepten naar nabijgelegen locaties in de vectorruimte te brengen door blootstelling aan miljarden voorbeelden. Veelgebruikte embeddingmodellen zijn Word2Vec, dat woordrelaties leert uit context; BERT (Bidirectional Encoder Representations from Transformers), dat contextuele betekenis vastlegt; en CLIP (Contrastive Language-Image Pre-training), dat multimodale data verwerkt. De resulterende embeddings zijn doorgaans 100 tot meer dan 1.000 dimensies, waardoor een rijke wiskundige representatie van semantische relaties ontstaat. Wanneer een gebruiker een zoekopdracht uitvoert, wordt diens zoekopdracht in een vector omgezet met hetzelfde embeddingmodel, waarna het systeem de afstanden tussen de queryvector en alle opgeslagen vectoren berekent om de meest vergelijkbare items te identificeren.

Vector search maakt gebruik van afstandmetingen om te kwantificeren hoe vergelijkbaar twee vectoren zijn. De drie belangrijkste metingen zijn cosinusgelijkheid, Euclidische afstand en dot-productgelijkheid, elk met hun eigen wiskundige eigenschappen en toepassingsgebieden. Cosinusgelijkheid meet de hoek tussen twee vectoren, variërend van -1 tot 1, waarbij 1 identieke richting betekent (maximale gelijkenis) en 0 orthogonale vectoren (geen relatie). Deze meting is bijzonder waardevol voor NLP-toepassingen omdat het focust op semantische richting ongeacht de grootte van de vector, wat ideaal is voor het vergelijken van documenten van verschillende lengtes. Euclidische afstand berekent de rechte afstand tussen vectoren in een multidimensionale ruimte en houdt zowel rekening met grootte als richting. Deze meting is gevoelig voor schaal en is nuttig wanneer de grootte van vectoren betekenisvol is, zoals bij aanbevelingssystemen waar aankoopfrequentie meespeelt.

Dot-productgelijkheid combineert aspecten van beide metingen, waarbij zowel grootte als richting wordt meegenomen en het computationeel efficiënt is. Veel grote taalmodellen gebruiken dot product voor training, waardoor het de juiste keuze is voor die toepassingen. De selectie van de juiste afstandsmeting is cruciaal—onderzoek toont aan dat het gebruik van dezelfde meting als waarmee je embeddingmodel is getraind, de beste resultaten oplevert. Zo is het all-MiniLM-L6-v2 model getraind met cosinusgelijkheid, dus het gebruik van cosinusgelijkheid in je index geeft de meest nauwkeurige resultaten. Organisaties die vector search implementeren, moeten zorgvuldig hun gekozen meting afstemmen op hun embeddingmodel en use case om zowel nauwkeurigheid als prestaties te waarborgen.

| Aspect | Vector Search | Keyword Search | Hybrid Search |

|---|---|---|---|

| Matching-methode | Semantische gelijkenis op basis van betekenis | Exacte woord- of zinsdeelovereenkomst | Combineert semantische en trefwoordmatching |

| Query-begrip | Begrijpt intentie en context | Vereist exacte trefwoorden | Benut beide benaderingen voor complete resultaten |

| Synoniemenbehandeling | Vindt automatisch synoniemen en gerelateerde termen | Mist synoniemen tenzij expliciet geïndexeerd | Vangt synoniemen via beide methodes |

| Prestaties bij vage queries | Uitstekend—begrijpt intentie | Slecht—vereist precieze trefwoorden | Zeer goed—dekt beide interpretaties |

| Computationele kosten | Hoger—vereist embedding en gelijkenisberekening | Lager—eenvoudige stringmatching | Gemiddeld—beide zoekopdrachten parallel |

| Schaalbaarheid | Vereist gespecialiseerde vectordatabases | Werkt met traditionele databases | Vereist hybride systemen |

| Toepassingen | Semantisch zoeken, aanbevelingen, RAG, anomaliedetectie | Exacte zinsdeelzoektocht, gestructureerde data | Enterprise search, AI-monitoring, merktracking |

| Voorbeeld | Zoeken op “gezonde diner ideeën” vindt “voedzame meal prep” | Vindt alleen resultaten met exact “gezond” en “diner” | Vindt zowel exacte matches als semantisch gerelateerde content |

Het implementeren van vector search omvat verschillende onderling verbonden stappen die ruwe data omzetten in doorzoekbare semantische representaties. De eerste stap is data-inname en preprocessing, waarbij ruwe documenten, afbeeldingen of andere data worden opgeschoond en genormaliseerd. Vervolgens vindt de vectortransformatie plaats, waarbij een embeddingmodel elk data-item omzet in een numerieke vector van doorgaans 100 tot meer dan 1.000 dimensies. Deze vectoren worden opgeslagen in een vectordatabase of indexstructuur die is geoptimaliseerd voor hoog-dimensionale data. Wanneer een zoekopdracht binnenkomt, wordt deze op dezelfde manier ge-embed tot een queryvector. Het systeem gebruikt vervolgens afstandmetingen om gelijkenisscores te berekenen tussen de queryvector en alle opgeslagen vectoren, waarbij resultaten worden gerangschikt op basis van nabijheid tot de query.

Om dit proces op schaal efficiënt te maken, gebruiken systemen Approximate Nearest Neighbor (ANN) algoritmen zoals HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index), of ScaNN (Scalable Nearest Neighbors). Deze algoritmen verruilen perfecte nauwkeurigheid voor snelheid, waardoor gezocht kan worden in miljoenen of miljarden vectoren in milliseconden in plaats van seconden. HNSW organiseert vectoren bijvoorbeeld in een meerlagige grafstructuur, waarbij hogere lagen langeafstandsverbindingen bevatten voor snelle traversals en lagere lagen korteafstandsverbindingen voor precisie. Deze hiërarchische aanpak reduceert de zoekcomplexiteit van lineair O(n) naar logaritmisch O(log n), waardoor grootschalige vector search praktisch wordt. De keuze van algoritme hangt af van factoren als datasetgrootte, queryvolume, latency-eisen en beschikbare rekenkracht.

Vector search is essentieel geworden voor AI-monitoringplatforms zoals AmICited, die merknamen volgen over AI-systemen heen. Traditionele monitoring op trefwoord zou geparafraseerde vermeldingen, contextuele verwijzingen en semantische variaties van merknamen of domein-URL’s missen. Vector search stelt deze platforms in staat te detecteren wanneer je merk wordt genoemd in AI-gegenereerde antwoorden, zelfs als de bewoording verschilt. Als je domein bijvoorbeeld “amicited.com” is, kan vector search vermeldingen als “AI prompt monitoring platform” of “merkzichtbaarheid in generatieve AI” identificeren als contextueel verwant aan je bedrijf, zelfs zonder expliciete URL-vermelding. Dit semantische begrip is cruciaal voor volledige AI-citatietracking over ChatGPT, Perplexity, Google AI Overviews en Claude heen.

De markt voor vector search-technologie groeit explosief, wat de erkenning van de waarde door het bedrijfsleven weerspiegelt. Volgens marktonderzoek werd de vectordatabasemarkt in 2024 gewaardeerd op $1,97 miljard en zal deze naar verwachting $10,60 miljard bereiken in 2032, met een samengesteld jaarlijks groeipercentage (CAGR) van 23,38%. Daarnaast rapporteerde Databricks een groei van 186% in adoptie van vectordatabases in slechts het eerste jaar na hun vector search-public preview in december 2023. Deze snelle adoptie toont aan dat bedrijven vector search steeds meer zien als kritische infrastructuur voor AI-toepassingen. Voor organisaties die hun aanwezigheid in AI-systemen monitoren, biedt vector search het semantische begrip dat nodig is om alle betekenisvolle vermeldingen te vangen, niet alleen exacte trefwoordmatches.

De prestaties van vector search op schaal hangen sterk af van geavanceerde indexeringstechnieken die snelheid, nauwkeurigheid en geheugengebruik in balans brengen. HNSW (Hierarchical Navigable Small World) is een van de populairste benaderingen en organiseert vectoren in een meerlagige graf waar elke laag steeds kortere verbindingen bevat. Het algoritme start zoekopdrachten op de bovenste laag met langeafstandsverbindingen voor snelle traversals en daalt dan af door lagen met steeds nauwkeurigere verbindingen. Uit onderzoek blijkt dat HNSW prestaties op state-of-the-art-niveau behaalt met recall-rates boven de 99%, terwijl de querylatentie onder de milliseconde blijft. HNSW vereist echter aanzienlijk geheugen—benchmarks tonen aan dat het indexeren van 1 miljoen vectoren met HNSW 0,5GB tot 5GB kan vereisen, afhankelijk van de parameters, waardoor geheugenefficiëntie belangrijk is voor grootschalige implementaties.

IVF (Inverted File Index) biedt een alternatief door vectoren te clusteren en te indexeren op clustercentra. Deze techniek verkleint de zoekruimte door alleen relevante clusters te doorzoeken in plaats van alle vectoren. ScaNN (Scalable Nearest Neighbors), ontwikkeld door Google Research, is specifiek geoptimaliseerd voor inner product search en levert uitstekende prestaties voor aanbevelingssystemen. Product Quantization (PQ) comprimeert vectoren door ze op te splitsen in subvectors en elk deel afzonderlijk te kwantiseren, waardoor het geheugenverbruik met een factor 10-100 wordt verminderd ten koste van enige nauwkeurigheid. Organisaties die vector search implementeren, moeten hun indexeringstechniek zorgvuldig selecteren op basis van hun specifieke eisen—of ze nu prioriteit geven aan recall-nauwkeurigheid, zoekingssnelheid, geheugenefficiëntie of een combinatie daarvan. Het vakgebied ontwikkelt zich snel, met regelmatig nieuwe algoritmen en optimalisatietechnieken die de computationele uitdagingen van hoog-dimensionale vectoroperaties aanpakken.

De definitie en toepassing van vector search blijven zich ontwikkelen naarmate AI-systemen geavanceerder worden en de adoptie in het bedrijfsleven versnelt. De toekomst wijst op hybride zoeksystemen die vector search combineren met traditioneel zoeken op trefwoord en geavanceerde filtermogelijkheden. Deze hybride benaderingen benutten het semantisch begrip van vector search, terwijl ze de precisie en vertrouwdheid van trefwoordmatching behouden, wat superieure resultaten oplevert voor complexe zoekopdrachten. Daarnaast wordt multimodale vector search steeds belangrijker, waarmee systemen gelijktijdig kunnen zoeken in tekst, afbeeldingen, audio en video via eenheidsembeddingsruimtes. Deze ontwikkelingen maken intuïtievere en completere zoekervaringen mogelijk over diverse datatypes heen.

Voor organisaties die hun aanwezigheid in AI-systemen monitoren, heeft de evolutie van vector search ingrijpende gevolgen. Naarmate AI-platforms zoals ChatGPT, Perplexity, Google AI Overviews en Claude steeds meer vertrouwen op vector search voor contentopslag en ranking, wordt begrijpen hoe je merk semantisch verschijnt net zo belangrijk als traditionele trefwoordzichtbaarheid. De verschuiving naar semantisch begrip betekent dat merktracking en AI-citatietracking zich moeten ontwikkelen voorbij eenvoudige trefwoordsdetectie, om contextuele vermeldingen en semantische relaties te kunnen vangen. Organisaties die investeren in kennis over vector search en de toepassingen ervan, zullen beter gepositioneerd zijn om hun zichtbaarheid in generatieve AI-systemen te optimaliseren. De convergentie van vector search-technologie met AI-monitoringplatforms markeert een fundamentele verschuiving in hoe merken hun aanwezigheid begrijpen en beheren in het AI-gedreven informatielandschap.

Traditioneel zoeken op trefwoord zoekt naar exacte woordovereenkomsten in documenten, terwijl vector search semantische betekenis en context begrijpt. Vector search zet tekst om in numerieke representaties, embeddings genoemd, waardoor het relevante resultaten kan vinden, zelfs als exacte trefwoorden niet overeenkomen. Bijvoorbeeld, zoeken naar 'draadloze koptelefoons' via vector search levert ook resultaten op voor 'Bluetooth-oordopjes', omdat ze een vergelijkbare semantische betekenis delen, terwijl zoeken op trefwoord deze verbinding zou missen.

Vector embeddings zijn numerieke representaties van data (tekst, beelden, audio) omgezet in arrays van getallen die semantische betekenis vatten. Ze worden gecreëerd met machine learning modellen zoals Word2Vec, BERT of transformer-gebaseerde modellen die leren om vergelijkbare concepten dicht bij elkaar te plaatsen in een hoog-dimensionale ruimte. Zo zouden de woorden 'koning' en 'koningin' embeddings hebben die dicht bij elkaar liggen vanwege hun semantische relatie, terwijl 'koning' en 'banaan' ver uit elkaar liggen.

De drie belangrijkste afstandsmetingen zijn cosinusgelijkheid (meet de hoek tussen vectoren), Euclidische afstand (meet de rechte afstand) en dot-productgelijkheid (houdt rekening met zowel grootte als richting). Cosinusgelijkheid is het meest gangbaar voor NLP-toepassingen omdat het zich richt op semantische richting, ongeacht de grootte van de vector. De keuze voor een meting moet overeenkomen met de meting die gebruikt is bij het trainen van je embeddingmodel voor optimale nauwkeurigheid.

Vector search stelt AI-monitoringplatforms zoals AmICited in staat merkvermeldingen te volgen over AI-systemen (ChatGPT, Perplexity, Google AI Overviews, Claude) door semantische context te begrijpen in plaats van exacte trefwoorden. Dit maakt het mogelijk om geparafraseerde vermeldingen, gerelateerde concepten en contextuele verwijzingen naar je merk te detecteren, wat een compleet overzicht biedt van hoe je domein verschijnt in AI-gegenereerde antwoorden op meerdere platforms.

ANN-algoritmen zoals HNSW (Hierarchical Navigable Small World) maken snelle gelijksheidszoekopdrachten mogelijk over miljoenen vectoren door benaderde in plaats van exacte dichtstbijzijnde buren te vinden. Deze algoritmen gebruiken hiërarchische grafstructuren om de zoekcomplexiteit van lineair naar logaritmisch te reduceren, waardoor vector search praktisch wordt voor grootschalige toepassingen. HNSW organiseert vectoren in meerlaagse grafen waarbij langere verbindingen op hogere lagen zorgen voor snellere doorzoeking.

Bedrijven genereren enorme hoeveelheden ongestructureerde data (e-mails, documenten, supporttickets) die moeilijk te organiseren zijn met traditioneel zoeken op trefwoord. Vector search maakt semantisch begrip mogelijk van deze data, wat toepassingen aandrijft zoals intelligente zoekopdrachten, aanbevelingssystemen, anomaliedetectie en retrieval-augmented generation (RAG). Volgens marktonderzoek groeit de vectordatabasemarkt van $2,65 miljard in 2025 naar $8,95 miljard in 2030, wat de adoptie in het bedrijfsleven weerspiegelt.

Vector databases zijn gespecialiseerde systemen die zijn geoptimaliseerd voor het opslaan, indexeren en opvragen van hoog-dimensionale vectorgegevens. Ze implementeren efficiënte indexeringstechnieken zoals HNSW, IVF (Inverted File Index) en ScaNN om snelle gelijksheidszoekopdrachten op schaal mogelijk te maken. Voorbeelden zijn Milvus, Pinecone, Weaviate en Zilliz Cloud. Deze databases verwerken de computationele complexiteit van vectoroperaties, zodat organisaties productieklare semantische zoek- en AI-toepassingen kunnen bouwen zonder infrastructurele complexiteit te hoeven beheren.

Begin met het volgen van hoe AI-chatbots uw merk vermelden op ChatGPT, Perplexity en andere platforms. Krijg bruikbare inzichten om uw AI-aanwezigheid te verbeteren.

Ontdek hoe vectorzoekopdracht machine learning-embeddings gebruikt om vergelijkbare items te vinden op basis van betekenis in plaats van exacte zoekwoorden. Beg...

Ontdek hoe vector-embeddings AI-systemen in staat stellen semantische betekenis te begrijpen en content te koppelen aan zoekopdrachten. Verken de technologie ac...

Semantisch zoeken interpreteert de betekenis en context van zoekopdrachten met behulp van NLP en machine learning. Leer hoe het verschilt van trefwoord zoeken, ...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.