Hvilke AI-crawlere bør jeg gi tilgang? Komplett guide for 2025

Lær hvilke AI-crawlere du bør tillate eller blokkere i robots.txt-filen din. Omfattende guide som dekker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med...

Lær hvordan du tar strategiske beslutninger om blokkering av AI-crawlere. Vurder innholdstype, trafikkilder, inntektsmodeller og konkurranseposisjon med vårt omfattende beslutningsrammeverk.

AI-crawlere har blitt en betydelig kraft i det digitale økosystemet og endrer fundamentalt hvordan innhold oppdages, indekseres og brukes på internett. Disse automatiserte systemene er laget for å systematisk bla gjennom nettsteder, hente ut data og mate dem inn i maskinlæringsmodeller som driver alt fra søkemotorer til generative AI-applikasjoner. Landskapet omfatter tre distinkte typer crawlere: datasamlere som henter ut spesifikk informasjon for kommersielle formål, søkemotor-crawlere som Googlebot som indekserer innhold for søkeresultater, og AI-assistent-crawlere som samler treningsdata for store språkmodeller. Eksempler inkluderer OpenAIs GPTBot, Anthropics Claude-Web og Googles AI Overviews-crawler, hver med ulike formål og påvirkningsprofiler. Ifølge nyere analyser har omtrent 21% av de 1 000 største nettstedene allerede implementert en form for blokkering av AI-crawlere, noe som indikerer økt bevissthet om behovet for å håndtere disse automatiserte besøkene. Å forstå hvilke crawlere som får tilgang til nettstedet ditt og hvorfor de gjør det, er det første kritiske steget for å ta en informert beslutning om du skal blokkere eller tillate dem. Innsatsen er høy fordi denne beslutningen direkte påvirker innholdets synlighet, trafikkmønstre og til slutt inntektsmodellen din.

I stedet for å ta en generell beslutning om å blokkere eller tillate alle AI-crawlere, innebærer en mer sofistikert tilnærming at du vurderer din spesifikke situasjon gjennom BEDC-rammeverket, som står for Forretningsmodell (Business Model), Eksponeringsrisiko (Exposure Risk), Avhengighet av organisk søk (Dependency on Organic Search) og Konkurranseposisjon (Competitive Position). Hver av disse fire faktorene tillegges ulik vekt, avhengig av nettstedets egenskaper, og sammen danner de en omfattende beslutningsmatrise som tar høyde for kompleksiteten i moderne digital publisering. Rammeverket anerkjenner at det ikke finnes ett svar som passer for alle—det som fungerer for en nyhetsorganisasjon kan være helt feil for et SaaS-selskap, og det som gagner et etablert merke kan skade en ny konkurrent. Ved å systematisk evaluere hver faktor kan du gå utover følelsesmessige reaksjoner på AI og i stedet ta datadrevne beslutninger som samsvarer med virksomhetens mål.

| Faktor | Anbefaling | Viktig hensyn |

|---|---|---|

| Forretningsmodell | Annonsestøttede nettsteder bør være mer forsiktige; abonnementsmodeller kan være mer åpne | Inntektsavhengighet av direkte brukerinvolvering vs. lisensiering |

| Eksponeringsrisiko | Original forskning og proprietært innhold bør blokkeres; generelt innhold kan være mer åpent | Konkurransefortrinn knyttet til unike innsikter eller data |

| Avhengighet av organisk søk | Høy avhengighet (>40% trafikk) tilsier å tillate Google-crawlere, men blokkere AI-assistenter | Balanse mellom søkesynlighet og beskyttelse mot AI-treningsdata |

| Konkurranseposisjon | Markedsledere kan tillate seg å blokkere; nye aktører kan dra nytte av AI-synlighet | Førstefordel i AI-partnerskap vs. innholdsbeskyttelse |

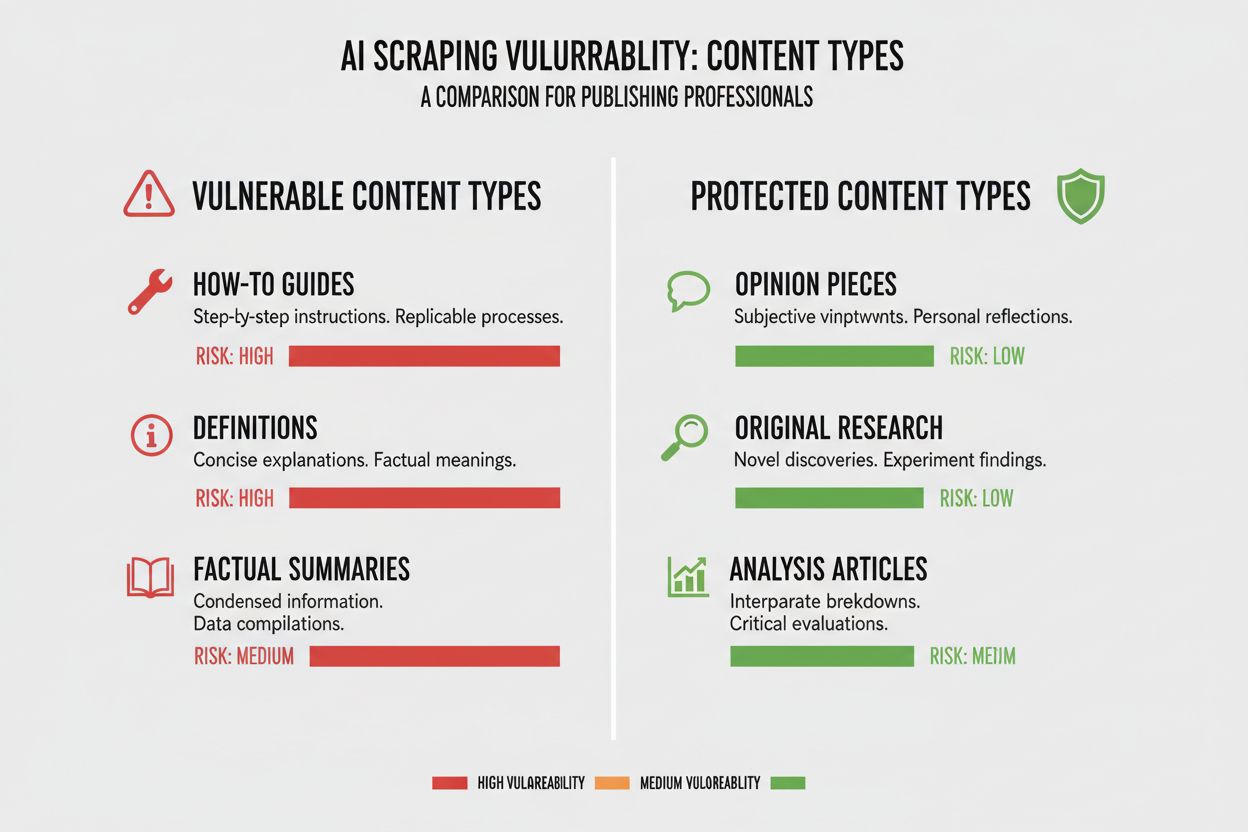

Ulike typer innhold har svært ulik sårbarhet for AI-crawling, og forståelsen av hvor innholdet ditt befinner seg på dette spekteret er avgjørende for å ta riktig beslutning. Original forskning og proprietære data utgjør dine mest verdifulle eiendeler og bør beskyttes sterkest, siden AI-modeller som trenes på dette innholdet kan konkurrere direkte med din inntektsstrategi. Nyheter og fersk informasjon havner i en mellomposisjon—selv om den tidskritiske verdien raskt avtar, er det fortsatt avgjørende for trafikken å bli indeksert av søkemotorer, noe som skaper en spenning mellom søkesynlighet og beskyttelse mot AI-treningsdata. Generelt innhold som guider, opplæringer og allmenn referanse er langt mindre sårbart fordi det er bredt tilgjengelig på internett og sjelden hovedkilden til inntekt. Tale- og multimedieinnhold har naturlig beskyttelse fordi dagens AI-crawlere sliter med å hente ut meningsfull verdi fra lyd og video, noe som gjør disse formatene iboende sikrere mot uttrekk av AI-treningsdata. Tidløst undervisningsinnhold og meningsartikler befinner seg et sted midt imellom; de er verdifulle for søketrafikk, men mindre direkte truet av AI-konkurranse. Hovedpoenget er at blokkering bør stå i forhold til konkurransefortrinnet innholdet ditt gir—beskytt det viktigste, og vær åpen for crawlere på innhold som drar nytte av bred distribusjon.

Avhengigheten din av organisk søketrafikk er kanskje den mest konkrete faktoren i beslutningen om AI-crawlere, fordi den direkte kvantifiserer avveiningen mellom søkesynlighet og innholdsbeskyttelse. Nettsteder som får mer enn 40% av trafikken fra organisk søk står overfor en kritisk begrensning: å blokkere AI-crawlere betyr ofte også å blokkere eller begrense Googles crawlere, noe som ville ødelegge synlighet og organisk trafikk. Skillet mellom Google-Extended (som crawler for AI-trening) og Googlebot (som crawler for søkeindeksering) er avgjørende her, da du teoretisk kan tillate én og blokkere den andre, selv om dette gir teknisk kompleksitet. En slående casestudie fra The New York Times illustrerer innsatsen: publikasjonen mottok omtrent 240 600 besøk fra AI-crawlere i en bestemt periode, noe som viser omfanget av AI-drevet trafikk for store utgivere. Likevel viser data fra Akamai at blokkering av crawlere gir 96% mindre henvisningstrafikk fra disse kildene, noe som tyder på at trafikkbidraget fra AI-crawlere er minimalt sammenlignet med tradisjonelt søk. Forholdet mellom crawling og reelle besøk for de fleste AI-crawlere er usedvanlig lavt—ofte gir mindre enn 0,15% av crawlet innhold faktiske retur-besøk—slik at blokkering av disse crawlerne har minimal innvirkning på reell brukertrafikk. For nettsteder med høy avhengighet av organisk søk, må beslutningen om å blokkere AI-crawlere veies opp mot risikoen for ved et uhell å blokkere søkemotorcrawlere, som ville være langt mer skadelig for virksomheten.

Inntektsmodellen din former grunnleggende hvordan du bør forholde deg til AI-crawlere, fordi ulike modeller gir ulike insentiver rundt innholdsdistribusjon og beskyttelse. Annonsestøttede nettsteder står overfor den største utfordringen med AI-crawlere, fordi inntektene deres er avhengig av at brukere besøker siden for å se annonser, og AI-modeller som oppsummerer innholdet reduserer incitamentet for brukere til å klikke seg inn. Abonnementsbaserte modeller kan være mer åpne for AI-crawlere, siden inntektene kommer fra direkte abonnementer heller enn annonsevisninger, og litt AI-synlighet kan til og med øke antallet abonnenter. Hybride modeller som kombinerer annonser, abonnement og affiliate-inntekter krever mer nyansert tenkning, da blokkering av crawlere kan beskytte annonseinntekter, men skade affiliate-muligheter eller abonnementvekst. En fremvoksende mulighet som fortjener oppmerksomhet er AI-henvisningsmodellen, der nettsteder potensielt kan tjene penger på å la AI-crawlere få tilgang til innhold mot attribusjon og trafikkhenvisninger—en modell som fortsatt er under utvikling, men som kan endre økonomien i innholdsdistribusjon. For utgivere som prøver å forstå den fulle effekten av AI-crawlere på virksomheten, gir verktøy som AmICited.com avgjørende overvåkningsmuligheter for å spore hvor innholdet ditt blir sitert og brukt av AI-systemer, slik at du får innsyn i den faktiske verdivekslingen som skjer med innholdet ditt. Det viktigste er å forstå inntektsmodellen godt nok til å forutse hvordan AI-crawlere vil påvirke hver inntektsstrøm, i stedet for å ta en generell beslutning basert på prinsipp.

Når du har bestemt deg for å blokkere visse AI-crawlere, krever den tekniske implementeringen forståelse av både muligheter og begrensninger i verktøyene du kan bruke. Den vanligste tilnærmingen er å bruke robots.txt, en enkel tekstfil plassert i nettstedets rotmappe som instruerer crawlere om hvilke deler av nettstedet de har og ikke har tilgang til. Men robots.txt har en vesentlig begrensning: det er en frivillig standard som er avhengig av at crawlere respekterer instruksjonene, og ondsinnede eller aggressive crawlere kan ignorere den fullstendig. Her er et eksempel på hvordan du blokkerer spesifikke AI-crawlere i robots.txt-filen din:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

I tillegg til robots.txt bør du vurdere å blokkere disse store AI-crawlerne:

For mer robust beskyttelse implementerer mange virksomheter blokkering på CDN-nivå via tjenester som Cloudflare, som kan blokkere trafikk i nettverkskanten før den når serverne, og gir bedre ytelse og sikkerhet. En tolags tilnærming som kombinerer robots.txt med CDN-blokkering gir sterkest beskyttelse, ettersom den fanger både crawlere som respekterer robots.txt og aggressive crawlere som ignorerer den. Det er viktig å merke seg at blokkering på CDN-nivå krever mer teknisk kompetanse og kan ha utilsiktede konsekvenser om det ikke konfigureres nøye, så denne tilnærmingen passer best for organisasjoner med dedikerte tekniske ressurser.

Den ubehagelige sannheten om å blokkere AI-crawlere er at den reelle effekten på trafikk ofte er langt mindre enn den følelsesmessige responsen på AI-skraping skulle tilsi, og dataene viser et mer nyansert bilde enn mange utgivere forventer. Ifølge nyere analyser står AI-crawlere vanligvis for kun 0,15% av total nettsteds-trafikk for de fleste utgivere, et overraskende lavt tall tatt i betraktning oppmerksomheten temaet får. Veksten i AI-crawlertrafikk har imidlertid vært dramatisk, og enkelte rapporter viser 7x vekst år-over-år i AI-crawlerforespørsler, noe som indikerer at selv om dagens effekt er liten, øker betydningen fort. ChatGPT står for omtrent 78% av all AI-crawlertrafikk, og gjør OpenAIs crawler til den dominerende aktøren, etterfulgt av små bidrag fra andre AI-selskaper. Data om forholdet mellom crawling og faktiske besøk er spesielt avslørende: selv om AI-crawlere kan be om millioner av sider, gir de faktiske retur-besøk i rater ofte under 0,15%, slik at blokkering har minimal innvirkning på reell brukertrafikk. Blokkering av AI-crawlere reduserer henvisningstrafikken med 96%, men fordi denne trafikken allerede var minimal (ofte under 0,15% av total trafikk), er nettoeffekten på virksomheten ofte ubetydelig. Dette skaper et paradoks: blokkering av AI-crawlere føles som et prinsippfast standpunkt mot innholdstyveri, men den reelle forretningseffekten er ofte så liten at den knapt vises i analysene dine. Det egentlige spørsmålet er ikke om blokkering av crawlere vil skade trafikken—det gjør det vanligvis ikke—men om det å tillate dem skaper strategiske muligheter eller risikoer som veier tyngre enn den minimale trafikkbidraget de gir.

Konkurranseposisjonen din i markedet former grunnleggende hvordan du bør forholde deg til AI-crawlere, fordi den optimale strategien for en markedsleder er dramatisk annerledes enn for en ny aktør. Dominerende aktører som The New York Times, Wall Street Journal og store nyhetsorganisasjoner kan tillate seg å blokkere AI-crawlere fordi deres merkevare og direkte publikumskontakt gjør at de ikke er avhengige av AI for trafikk. Nye og nisjeaktører har et annet regnestykke: å bli indeksert av AI-systemer og dukke opp i AI-genererte sammendrag kan være en av få måter å oppnå synlighet mot etablerte konkurrenter. Førstefordel i AI-partnerskap kan være betydelig—utgivere som forhandler gode vilkår med AI-selskaper tidlig kan sikre bedre attribusjon, trafikkhenvisninger eller lisensavtaler enn de som venter. Det finnes også en subsidieffekt: når dominerende utgivere blokkerer AI-crawlere, skaper det insentiv for AI-selskaper til å lene seg mer på innhold fra de som tillater crawling, og gir disse utgiverne uforholdsmessig stor synlighet i AI-systemer. Dette gir en konkurransedynamikk der blokkering faktisk kan skade posisjonen din hvis konkurrentene dine tillater crawlere og oppnår AI-synlighet som resultat. Å forstå hvor du står i konkurranselandskapet er avgjørende for å forutsi hvordan beslutningen om blokkering vil påvirke din markedsposisjon sammenlignet med konkurrentene.

Å ta beslutningen om å blokkere eller tillate AI-crawlere krever at du systematisk vurderer situasjonen din mot konkrete kriterier. Bruk denne sjekklisten for å veilede beslutningsprosessen:

Vurdering av innholdseksponering

Analyse av trafikk-sammensetning

Vurdering av markedsposisjon

Vurdering av inntektsrisiko

I tillegg til denne første vurderingen bør du gjennomføre kvartalsvise gjennomganger av AI-crawlerstrategien, ettersom landskapet endrer seg raskt og den optimale beslutningen i dag kan endre seg i løpet av måneder. Bruk verktøy som AmICited.com for å spore hvor innholdet ditt blir sitert og brukt av AI-systemer, slik at du får konkrete data om verdivekslingen som skjer med innholdet ditt. Hovedpoenget er at denne beslutningen ikke bør tas én gang og glemmes—den krever kontinuerlig vurdering og justering etter hvert som AI-landskapet og forretningsforholdene dine endrer seg.

En betydelig fremvoksende mulighet som kan endre hele AI-crawlerlandskapet er Cloudflares pay-per-crawl-funksjon, som introduserer en tillatelsesbasert internettmodell der nettstedseiere kan tjene penger på AI-crawler-tilgang i stedet for bare å blokkere eller tillate den. Denne tilnærmingen anerkjenner at AI-selskaper henter verdi fra å crawle innholdet ditt, og i stedet for å gå inn i en blokkeringskrig kan du forhandle kompensasjon for denne tilgangen. Modellen bygger på kryptografisk verifisering for å sikre at kun autoriserte crawlere får tilgang til innholdet ditt, og forhindrer uautorisert scraping samtidig som legitime AI-selskaper kan betale for tilgang. Dette gir granulær kontroll over hvilke crawlere som får tilgang til hvilket innhold, slik at du kan tjene penger på verdifullt innhold og samtidig være åpen mot søkemotorer og andre nyttige crawlere. Pay-per-crawl-modellen gir også AI-revisjonsmuligheter, slik at du kan se nøyaktig hvilket innhold som ble crawlet, når det ble gjort og av hvem, og gir en gjennomsiktighet som er umulig med tradisjonell blokkering. For utgivere som tar i bruk denne strategien, blir AmICited.com sine overvåkningsmuligheter enda mer verdifulle, da du kan spore ikke bare hvor innholdet ditt vises i AI-systemer, men også verifisere at du får riktig kompensasjon for denne bruken. Selv om modellen fortsatt er ny og utbredelsen begrenset, representerer den en potensielt langt mer sofistikert tilnærming enn det binære valget mellom blokkering og tillatelse—en tilnærming som anerkjenner den gjensidige verdien i forholdet mellom utgivere og AI-selskaper, samtidig som dine interesser beskyttes gjennom kontraktsmessige og tekniske mekanismer.

Blokkering av AI-crawlere hindrer dem i å få tilgang til innholdet ditt via robots.txt eller blokkering på CDN-nivå, og beskytter innholdet ditt mot å bli brukt i AI-trening. Hvis du tillater crawlere, kan innholdet ditt indekseres av AI-systemer, og potensielt dukke opp i AI-genererte sammendrag og svar. Valget avhenger av innholdstype, inntektsmodell og konkurranseposisjon.

Å blokkere AI-crawlere skader ikke SEO-en din direkte hvis du kun blokkerer AI-spesifikke crawlere som GPTBot, men tillater Googlebot. Dersom du ved en feil blokkerer Googlebot, vil søkerangeringen din bli betydelig dårligere. Nøkkelen er å bruke granulær kontroll for kun å blokkere AI-treningscrawlere, samtidig som du opprettholder tilgang for søkemotorer.

Ja, du kan bruke robots.txt til å blokkere bestemte crawlere basert på user-agent-strengen, samtidig som du tillater andre. For eksempel kan du blokkere GPTBot, men tillate Google-Extended, eller omvendt. Denne granulære tilnærmingen lar deg beskytte innholdet ditt mot enkelte AI-selskaper, samtidig som du forblir synlig for andre.

robots.txt er en frivillig standard som er avhengig av at crawlere respekterer instruksjonene dine—noen AI-selskaper ignorerer den. Blokkering på CDN-nivå (som Cloudflare) blokkerer trafikk i nettverkskanten før den når serverne dine, og gir sterkere håndheving. En tolags tilnærming som bruker begge metodene gir best beskyttelse.

Du kan sjekke serverloggene dine for user-agent-strenger fra kjente AI-crawlere som GPTBot, CCBot og Claude-Web. Verktøy som AmICited.com gir overvåkningsmuligheter for å spore hvor innholdet ditt dukker opp i AI-systemer, og hvor ofte det blir hentet av AI-crawlere.

Pay-per-crawl er en fremvoksende modell der AI-selskaper betaler for tilgang til innholdet ditt. Selv om den fortsatt er i beta og har begrenset utbredelse, representerer det en potensiell ny inntektsstrøm. Hvor levedyktig det er, avhenger av volumet av AI-crawlertrafikk og prisene AI-selskapene er villige til å betale.

Hvis en AI-crawler ignorerer robots.txt-direktivene dine, implementer blokkering på CDN-nivå via tjenester som Cloudflare. Du kan også konfigurere serveren din til å returnere 403-feil til kjente AI-crawler user-agenter. Ved vedvarende brudd, vurder juridiske tiltak eller ta direkte kontakt med AI-selskapet.

Gjennomgå AI-crawlerstrategien din hvert kvartal, da landskapet endrer seg raskt. Overvåk endringer i AI-crawlertrafikk, nye crawlere på markedet og endringer i konkurranseposisjonen din. Bruk verktøy som AmICited.com for å spore hvordan innholdet ditt brukes av AI-systemer og tilpass strategien din deretter.

Spor hvor innholdet ditt dukker opp i AI-genererte svar og forstå effekten AI-crawlere har på virksomheten din med AmICited.coms omfattende overvåkningsplattform.

Lær hvilke AI-crawlere du bør tillate eller blokkere i robots.txt-filen din. Omfattende guide som dekker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med...

Omfattende guide til AI-crawlere i 2025. Identifiser GPTBot, ClaudeBot, PerplexityBot og 20+ andre AI-boter. Lær hvordan du blokkerer, tillater eller overvåker ...

Fullstendig referanseguide for AI-crawlere og roboter. Identifiser GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brukeragenter, crawl-frekvens...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.