Slik legger du til statistikk for å forbedre AI-sitater – Komplett guide

Lær hvordan du bruker statistikk og datadrevne innsikter for å forbedre merkevarens synlighet i AI-søkemotorer som ChatGPT, Perplexity og Google Gemini. Oppdag ...

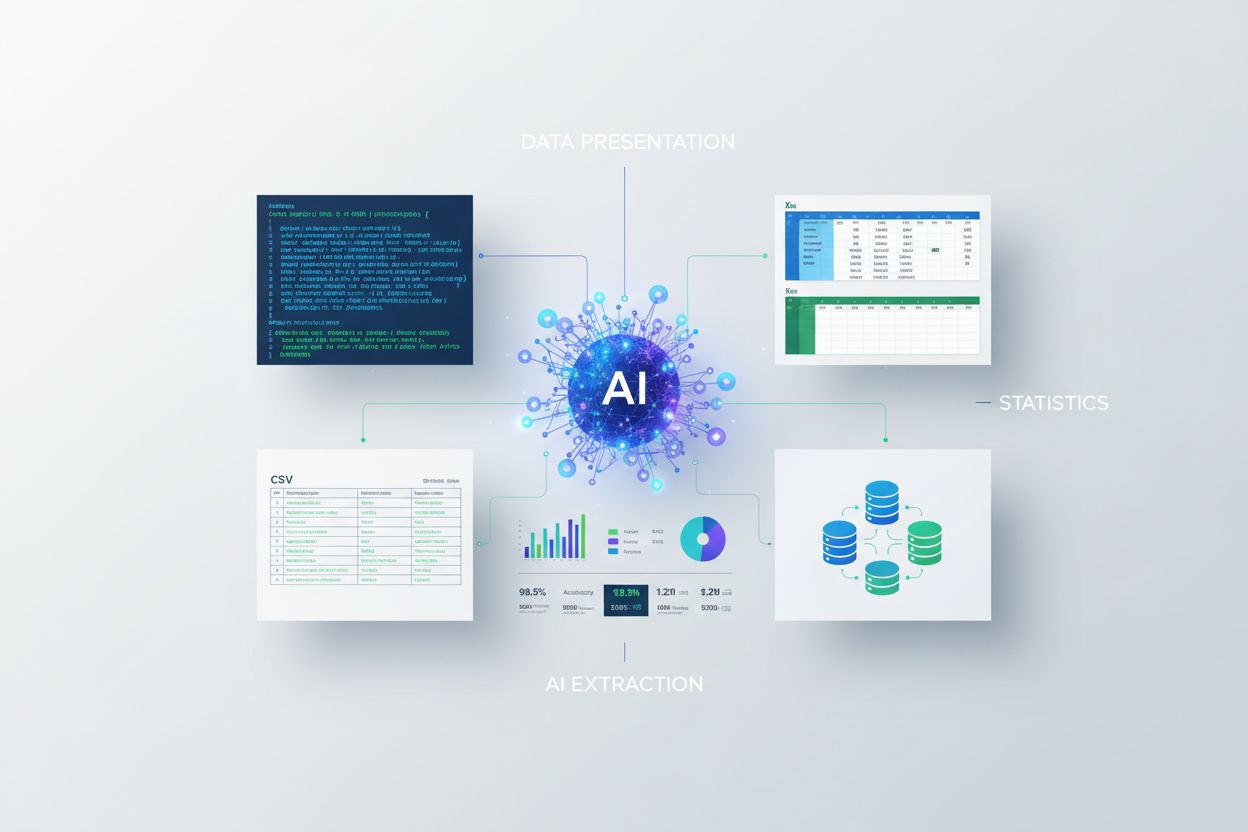

Lær hvordan du presenterer statistikk for AI-uttrekk. Oppdag beste praksis for dataformatering, JSON vs CSV, og hvordan du sikrer at dataene dine er AI-klare for LLM-er og AI-modeller.

Kunstig intelligens prosesserer informasjon fundamentalt annerledes enn mennesker, noe som gjør dataformat til en avgjørende faktor for vellykket uttrekk. Når statistikk presenteres i formater optimalisert for maskinlesing, kan AI-modeller analysere, forstå og trekke ut informasjon med betydelig høyere nøyaktighet og hastighet. Dårlig formaterte data tvinger AI-systemer til å bruke datakraft på tolkning og feilkorrigering, noe som fører til tregere behandling og mindre pålitelig uttrekk. Formatet du velger avgjør direkte om en AI-modell raskt kan identifisere relevante statistikker eller må kjempe med tvetydige presentasjoner. I virksomheter gir denne forskjellen målbar forretningsverdi—organisasjoner som bruker riktig formatert statistikk rapporterer 40-60 % raskere AI-behandling sammenlignet med de som baserer seg på ustrukturert presentasjon. Å forstå hvordan man presenterer statistikk for AI-uttrekk er ikke bare en teknisk vurdering, men et strategisk fortrinn som påvirker både operasjonell effektivitet og datanøyaktighet.

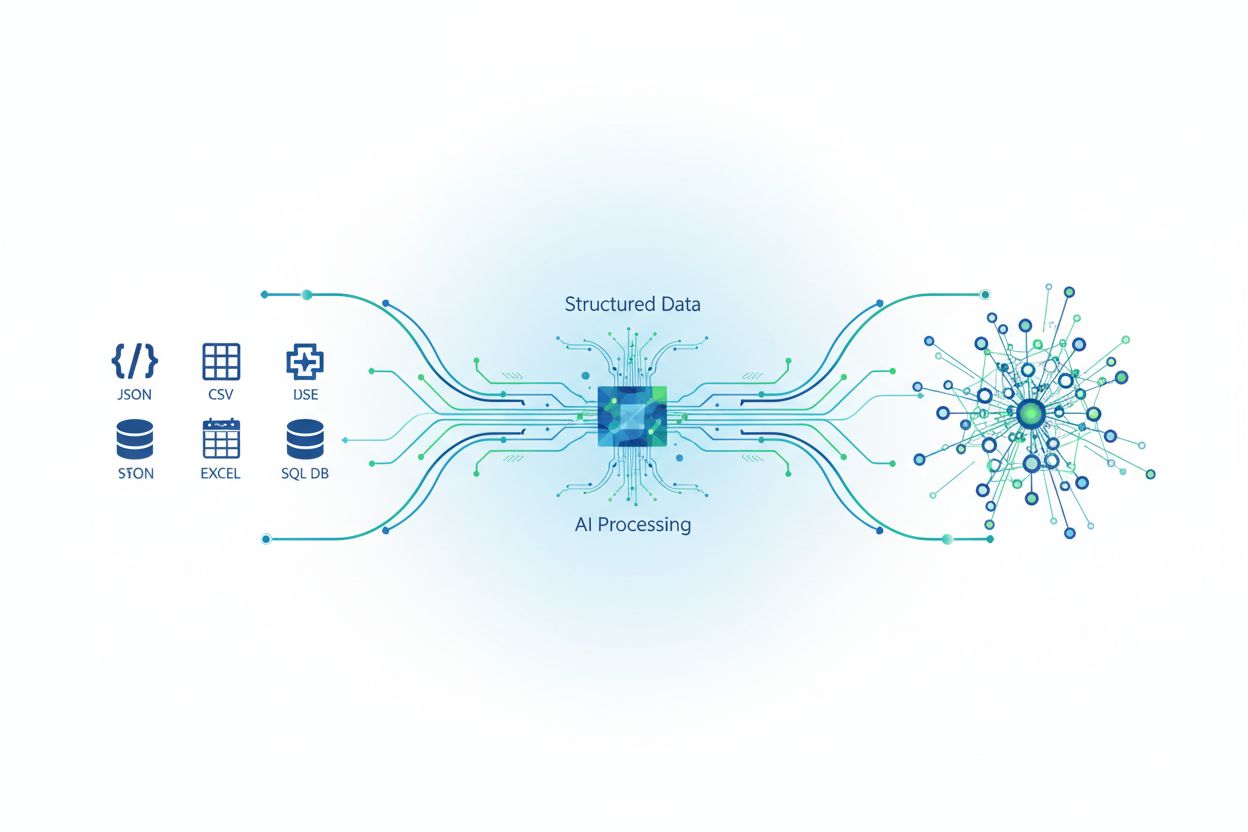

Skillet mellom strukturert og ustrukturert datapresentasjon former grunnleggende hvor effektivt AI-systemer kan trekke ut og behandle statistikk. Strukturerte data følger forhåndsdefinerte formater med tydelig organisering, mens ustrukturerte data eksisterer i fritekst, bilder eller blandede medier som krever omfattende tolkning. Til tross for fordelene med strukturerte data, er omtrent 90 % av bedriftsdata ustrukturerte, noe som skaper store utfordringer for organisasjoner som ønsker å bruke AI til statistikkuttrekk. Tabellen under viser hovedforskjellene mellom disse tilnærmingene:

| Format | AI-behandlingshastighet | Nøyaktighetsgrad | Lagringseffektivitet | Bruksområder |

|---|---|---|---|---|

| Strukturert (JSON/CSV) | 95-99 % raskere | 98-99 % | 60-70 % mer effektiv | Databaser, API-er, analyser |

| Ustrukturert (Tekst/PDF) | Grunnhastighet | 75-85 % | Standard lagring | Dokumenter, rapporter, nettinnhold |

| Semistrukturert (XML/HTML) | 80-90 % raskere | 90-95 % | 75-80 % effektiv | Nettsider, logger, blandede formater |

Organisasjoner som konverterer ustrukturert statistikk til strukturerte formater opplever dramatiske forbedringer i AI-uttrekk, med nøyaktighet som øker fra 75-85 % til 98-99 %. Valget mellom disse formatene bør avhenge av bruksområdet ditt, men strukturert presentasjon er fortsatt gullstandarden for AI-klare statistikker.

JSON og CSV er to av de mest brukte formatene for å presentere statistikk til AI-systemer, hver med sine fordeler avhengig av uttrekksbehov. JSON (JavaScript Object Notation) egner seg spesielt for hierarkiske og nestede datastrukturer, ideelt for komplekse statistiske relasjoner og datasett med mye metadata. CSV (Comma-Separated Values) byr på enkelhet og universell kompatibilitet, og fungerer svært godt for flat, tabulær statistikk som ikke krever nestede relasjoner. Når du presenterer statistikk for moderne LLM-er og AI-uttrekksverktøy, prosesserer JSON gjerne 30-40 % raskere takket være innebygd støtte for datatyper og strukturvalidering. Her er en praktisk sammenligning:

// JSON-format – best for kompleks statistikk

{

"quarterly_statistics": {

"q1_2024": {

"revenue": 2500000,

"growth_rate": 0.15,

"confidence_interval": 0.95

},

"q2_2024": {

"revenue": 2750000,

"growth_rate": 0.10,

"confidence_interval": 0.95

}

}

}

# CSV-format – best for enkel, flat statistikk

quarter,revenue,growth_rate,confidence_interval

Q1 2024,2500000,0.15,0.95

Q2 2024,2750000,0.10,0.95

Velg JSON når statistikken din inneholder nestede relasjoner, flere datatyper eller trenger bevaring av metadata; bruk CSV for rett-fram tabulær data der enkelhet og bred kompatibilitet er viktigst. Ytelsesforskjellen er betydelig—JSONs strukturerte validering reduserer uttrekksfeil med 15-25 % sammenlignet med CSV for komplekse datasett.

Å presentere statistikk til maskinlæringsmodeller krever nøye oppmerksomhet til hvordan numeriske data representeres, normaliseres og standardiseres—ofte ulikt formater for mennesker. Numeriske data må representeres med konsistent presisjon og datatyper—flyttall for kontinuerlige variabler, heltall for tellinger og kategoriske koder for klassifiseringer—for å unngå at AI-systemene feiltolker statistiske verdier. Normaliserings- og standardiseringsteknikker konverterer rå statistikk til intervaller som maskinlæring prosesserer best, som å skalere til 0-1 eller z-skårer med snitt 0 og standardavvik 1. Konsistens i datatyper over hele datasettet er avgjørende; blanding av tekststrenger og tallverdier gir tolkningsfeil som forplanter seg gjennom AI-pipelinen. Statistisk metadata—som måleenheter, innsamlingsdatoer, konfidensintervaller og kildeinformasjon—må inkluderes eksplisitt, siden AI-systemer ikke kan utlede kontekst slik mennesker gjør. Manglende verdier må håndteres eksplisitt gjennom dokumenterte strategier som gjennomsnittsutfylling, fremoverfylling eller nullmarkører, ikke ved å la hull stå åpne. Organisasjoner som følger disse formateringsstandardene rapporterer 35-45 % forbedring i modellnøyaktighet ved behandling av statistikk.

Å innføre beste praksis for statistisk presentasjon sikrer at AI-systemer pålitelig kan trekke ut, behandle og bruke dataene dine med minimalt behov for feilhåndtering eller omarbeiding. Her er essensielle tiltak:

Implementer streng datavalidering: Etabler valideringsregler før statistikken går inn i AI-pipelinen, og kontroller for datatyper, verdiområder og format. Dette hindrer dårlig data fra å ødelegge uttrekksresultater og reduserer nedstrøms feil med 50-70 %.

Definer tydelig skjema-dokumentasjon: Lag eksplisitte skjemaer som beskriver hvert felt, datatype, gyldige verdier og relasjoner. AI-systemer prosesserer skjema-dokumentert data 40 % raskere enn udokumenterte datasett fordi de umiddelbart forstår struktur og begrensninger.

Inkluder omfattende metadata: Legg ved metadata til alle datasett—innsamlingsmetodikk, tidsperiode, konfidensnivå, måleenheter og kildehenvisning. Denne konteksten hindrer feiltolkning og gir grunnlag for korrekt statistisk analyse.

Etabler feilhåndteringsprotokoller: Definer hvordan AI-systemet skal håndtere manglende verdier, avvik og inkonsistenser før de oppstår. Dokumentert feilhåndtering reduserer uttrekksfeil med 60 % og sikrer konsekvent oppførsel på tvers av flere AI-kjøringer.

Vedlikehold versjonskontroll: Spor endringer i formater, skjema og presentasjonsstandarder med versjonskontrollsystemer. Dette gjør at AI-systemer kan tolke historiske data riktig og gir mulighet til å ettergå endringer som påvirker uttrekksnøyaktighet.

Automatiser kvalitetskontroller: Innfør automatisert validering før AI-uttrekk, som sjekker datakompletthet, format og rimelighet. Automatisert QA fanger opp 85-90 % av presentasjonsfeil før de påvirker AI-behandlingen.

Standarder for statistisk presentasjon gir målbar forretningsverdi på tvers av bransjer hvor AI-uttrekk driver effektivitet og beslutninger. I bank og finans har institusjoner som presenterer kvartalsstatistikk i standardiserte JSON-formater med full metadata redusert lånebehandlingstiden med 35-40 % og økt godkjenningsnøyaktigheten fra 88 % til 96 %. Helsesektoren har ved bruk av strukturert statistikk på pasientutfall, kliniske studier og epidemiologiske tall, akselerert forskningsanalyse med 50 % og redusert tolkingsfeil med 45 %. E-handelsplattformer med riktig formatert lagerstatistikk, salgsdata og kundemålinger lar AI generere sanntidsanbefalinger og etterspørselsprognoser med 92-95 % nøyaktighet, mot 75-80 % fra ustrukturerte kilder. AmICiteds overvåkningsfunksjoner er spesielt verdifulle her, ved å spore hvordan AI-systemer som GPT-er og Perplexity trekker ut og siterer statistisk informasjon fra dine formaterte data, og sikrer nøyaktighet og korrekt attribusjon i AI-generert innhold. Konkurransefortrinnet er betydelig—organisasjoner som mestrer presentasjon for AI-uttrekk rapporterer 25-35 % raskere beslutningssykluser og 20-30 % forbedring i AI-drevne forretningsresultater.

Et omfattende økosystem av verktøy og teknologier gjør det mulig for organisasjoner å formatere, validere og presentere statistikk optimalt for AI-uttrekk og -behandling. Datauttrekksverktøy som Apache NiFi, Talend og Informatica tilbyr visuelle grensesnitt for å transformere ustrukturert statistikk til maskinlesbare formater, med bevaring av dataintegritet og revisjonshistorikk. API-rammeverk som FastAPI, Django REST Framework og Express.js muliggjør levering av riktig formatert statistikk til AI-systemer gjennom standardiserte endepunkt med skjema- og datavalidering. Databaser som PostgreSQL, MongoDB og spesialiserte datavarehus som Snowflake og BigQuery gir native støtte for strukturert statistisk lagring med innebygd validering, versjonering og ytelsesoptimalisering for AI-arbeidsmengder. Overvåkningsløsninger som AmICited sporer spesielt hvordan AI-modeller trekker ut og bruker statistiske data fra dine presentasjoner, og gir innsikt i uttrekksnøyaktighet, siteringsmønstre og mulige feiltolkninger i GPT-er, Perplexity og Google AI Overviews. Integrasjonsplattformer som Zapier, MuleSoft og egenutviklet mellomvare kobler statistiske datakilder til AI-pipelines mens de opprettholder format og kvalitet gjennom hele prosessen.

Selv velmenende organisasjoner gjør ofte presentasjonsfeil som svekker AI-uttrekkets ytelse og nøyaktighet. Inkonsistent formatering—som blanding av ulike datoformater, tallreprsentasjoner eller måleenheter i samme datasett—tvinger AI-systemer til å bruke ekstra ressurser på tolkning og skaper uklarhet som reduserer uttrekksnøyaktigheten med 15-25 %. Manglende eller ufullstendig metadata er en annen kritisk feil; statistikk uten kontekst som innsamlingsmetodikk, tidsperioder eller konfidensintervaller får AI til å gjøre gale antagelser og gi upålitelige uttrekk. Dårlig datakvalitet som utdatert informasjon, duplikater eller ikke-validerte tall undergraver hele uttrekksprosessen, fordi AI ikke kan skille pålitelige og upålitelige data uten eksplisitte kvalitetsindikatorer. Feil datatyper—som å lagre numerisk statistikk som tekst, datoer som ustrukturert tekst, eller blande kategoriske og kontinuerlige variabler—hindrer AI i å utføre matematiske operasjoner og analyser. Manglende dokumentasjon om presentasjonsstandarder, skjema og kvalitetsrutiner gir kunnskapshull som fører til inkonsekvent håndtering på tvers av AI-kjøringer og team. Organisasjoner som adresserer disse feilene systematisk rapporterer 40-60 % økning i uttrekksnøyaktighet og 30-50 % reduksjon i AI-prosesseringsfeil.

Landskapet for statistisk presentasjon til AI-uttrekk utvikler seg raskt, drevet av økende AI-kapasitet og nye bransjestandarder som endrer måten organisasjoner formaterer og leverer data på. Fremvoksende standarder som JSON Schema, YAML-spesifikasjoner og semantiske webteknologier (RDF, OWL) blir stadig viktigere for AI-systemer som trenger både datastruktur og semantisk betydning og relasjonsdefinisjoner. Arkitekturer for sanntids datastreaming med Apache Kafka, AWS Kinesis og lignende gjør det mulig for AI-systemer å behandle kontinuerlig oppdatert statistikk med minimal forsinkelse, og støtter behov for umiddelbar uttrekking og analyse av dynamiske data. Semantiske webteknologier får økt utbredelse fordi organisasjoner ser at AI har nytte av eksplisitte relasjonsdefinisjoner og ontologier som beskriver hvordan statistikk knyttes til forretningsbegreper og domeneinnsikt. Automatisert kvalitetssikring drevet av maskinlæring er på fremmarsj, der AI-systemer selv trenes til å oppdage presentasjonsavvik, validere statistisk rimelighet og flagge potensielle kvalitetsproblemer før mennesker eller downstream-AI møter dem. Kravene til store språkmodeller endres stadig, med nyere modeller som håndterer flere formater, samtidig som de stiller økende krav til struktur og metadata for presis sitering og attribusjon. Organisasjoner som forbereder seg på disse trendene ved å investere i fleksible, standardbaserte presentasjonsarkitekturer vil ha konkurransefortrinn etter hvert som AI-uttrekk modnes og bransjens forventninger til datakvalitet og transparens fortsetter å øke.

Det beste formatet avhenger av datakompleksiteten din. JSON er overlegent for hierarkiske og nestede statistikker med rik metadata, mens CSV fungerer best for enkel, flat tabulær data. JSON prosesserer vanligvis 30-40 % raskere for komplekse statistikker på grunn av innebygd støtte for datatyper, men CSV tilbyr større enkelhet og universell kompatibilitet. Velg JSON for moderne AI-systemer og API-er, CSV for enkle analyser og kompatibilitet med regneark.

Dataformatet påvirker uttrekkets nøyaktighet direkte gjennom konsistens, bevaring av metadata og validering av typer. Korrekt formaterte strukturerte data oppnår 98-99 % nøyaktighet sammenlignet med 75-85 % for ustrukturerte data. Formatkonsistens forhindrer tolkningsfeil, eksplisitt metadata forhindrer feiltolkninger, og riktige datatyper muliggjør matematiske operasjoner. Organisasjoner som innfører formatstandarder rapporterer 40-60 % forbedring i uttrekksnøyaktighet.

Ja, men med betydelige begrensninger. AI-modeller kan behandle ustrukturerte data ved hjelp av naturlig språkprosessering og maskinlæring, men nøyaktigheten synker til 75-85 % sammenlignet med 98-99 % for strukturerte data. Ustrukturerte data krever forhåndsbehandling, konvertering til strukturerte formater og ekstra datakraft. For optimal AI-uttrekksytelse anbefales det sterkt å konvertere ustrukturerte statistikker til strukturerte formater.

Viktig metadata inkluderer måleenheter, innsamlingsdatoer og tidsperioder, konfidensintervaller og signifikansnivåer, kildehenvisning, innsamlingsmetodikk og datakvalitetsindikatorer. Denne konteksten hindrer AI i å mistolke og muliggjør korrekt statistisk analyse. Eksplisitt metadata reduserer uttrekksfeil med 15-25 % og lar AI-systemer gi nøyaktige referanser og kontekst til uttrekket statistikk.

Implementer streng datavalidering, definer tydelig skjema-dokumentasjon, inkluder omfattende metadata, etabler feilhåndteringsprotokoller, vedlikehold versjonskontroll og automatiser kvalitetskontroller. Valider datatyper og verdier før AI-behandling, dokumenter hvert felt og relasjon, legg ved innsamlingsmetodikk og konfidensnivå, og kjør automatisert QA som fanger opp 85-90 % av presentasjonsfeil før AI-behandlingen starter.

AmICited sporer hvordan AI-systemer som GPT-er, Perplexity og Google AI Overviews trekker ut og siterer dine statistiske data. Plattformen overvåker uttrekksnøyaktighet, siteringsmønstre og potensielle feiltolkninger på tvers av AI-generert innhold. Denne innsikten sikrer at din statistikk får korrekt attribusjon og hjelper deg å identifisere når AI-systemer feiltolker dine data, slik at du kan forbedre presentasjonsformatene tilsvarende.

Dokumenter din strategi for manglende verdier eksplisitt før AI-behandling. Alternativer inkluderer gjennomsnittsutfylling for kontinuerlige variabler, fremoverfyllingsmetoder for tidsserier, eksplisitte nullmarkører eller ekskludering med dokumentasjon. Ikke la det være hull som forvirrer uttrekksalgoritmer. Dokumentert feilhåndtering reduserer uttrekksfeil med 60 % og sikrer konsistent oppførsel på tvers av flere AI-kjøringer.

JSON prosesserer 30-40 % raskere for komplekse statistikker takket være innebygd støtte for datatyper og strukturvalidering, og reduserer uttrekksfeil med 15-25 %. CSV gir raskere parsing for enkel, flat data og mindre filstørrelser (60-70 % mer effektivt), men mangler støtte for nestede strukturer og datavalidering. Velg JSON for komplekse, hierarkiske statistikker; CSV for enkel, tabulær data der hastighet og kompatibilitet prioriteres.

AmICited sporer hvordan AI-modeller og LLM-er siterer dine data og statistikker på tvers av GPT-er, Perplexity og Google AI Overviews. Sørg for at merkevaren din får korrekt attribuering.

Lær hvordan du bruker statistikk og datadrevne innsikter for å forbedre merkevarens synlighet i AI-søkemotorer som ChatGPT, Perplexity og Google Gemini. Oppdag ...

Lær hvordan du tester innholdsformater for AI-siteringer ved hjelp av A/B-testmetodikk. Finn ut hvilke formater som gir høyest AI-synlighet og siteringsrate på ...

Lær hvorfor tabeller er essensielle for AI-søkeoptimalisering. Oppdag hvordan strukturert data i tabeller forbedrer AI-forståelse, øker sjansen for sitater, og ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.