Hva Påvirker AI-indekseringshastighet? Viktige Faktorer for Raskere AI-oppdagelse

Oppdag de viktigste faktorene som påvirker AI-indekseringshastighet, inkludert nettstedets ytelse, gjennomsøkingsbudsjett, innholdsstruktur og teknisk optimalis...

Oppdag hvordan nettstedshastighet direkte påvirker AI-synlighet og siteringer i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders terskelen og optimaliseringsstrategier for AI-crawlere.

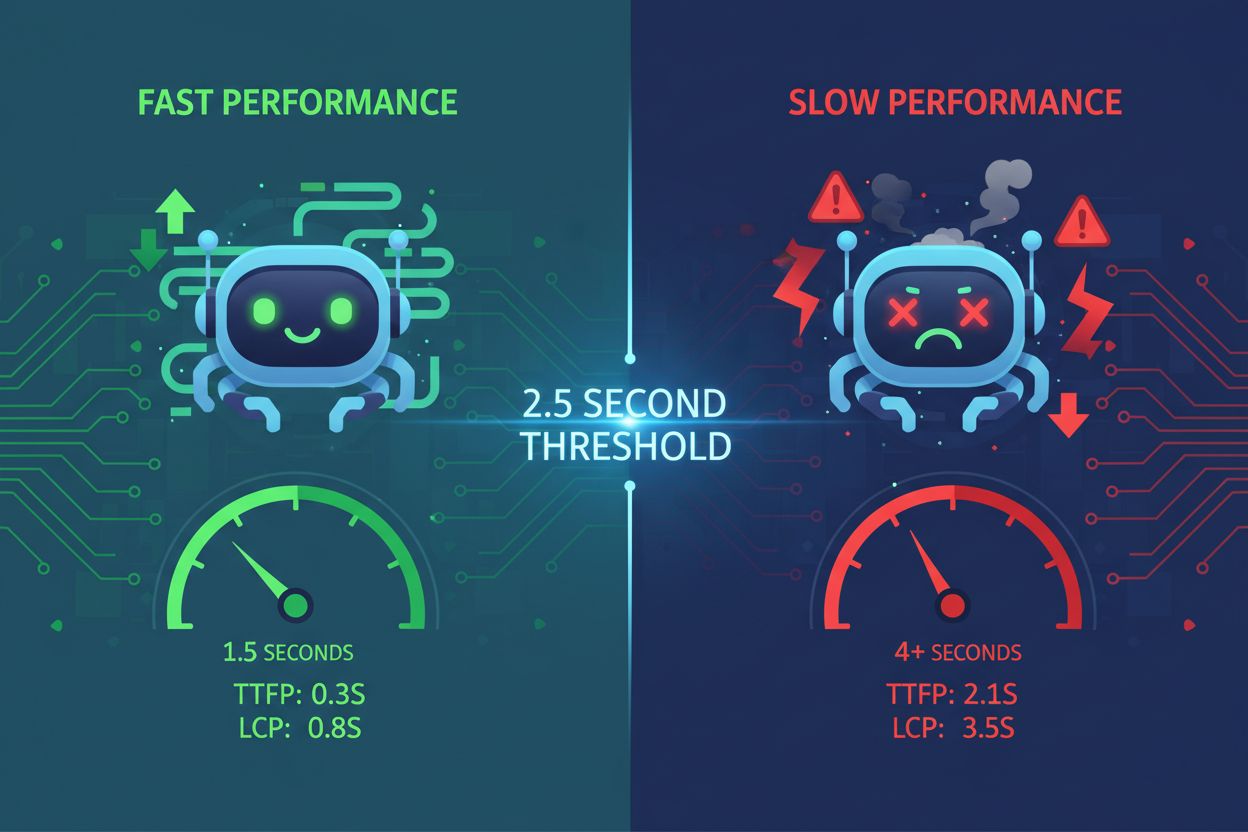

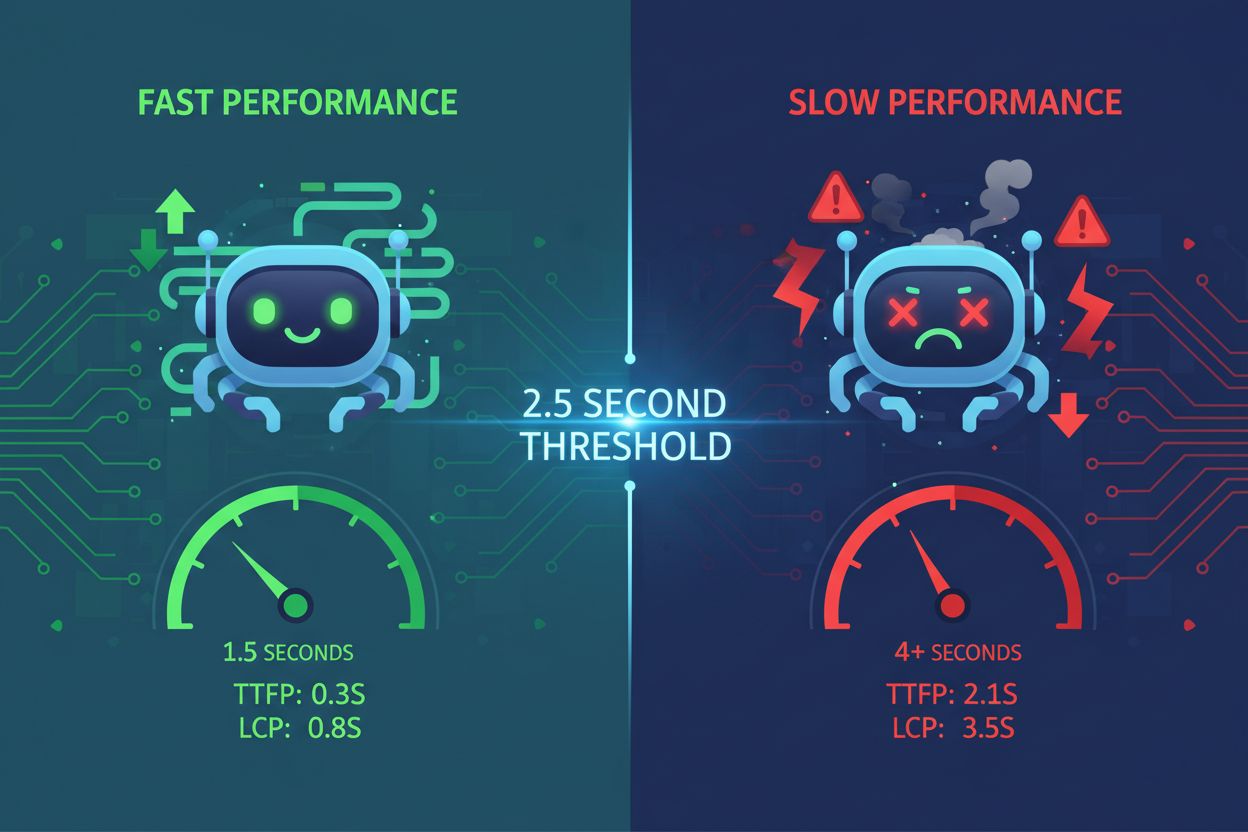

Nettstedshastighet har blitt en kritisk faktor for AI-synlighet og fundamentalt endret hvordan innhold blir oppdaget og sitert av store språkmodeller. AI-systemer som ChatGPT, Gemini og Perplexity opererer med strenge latenstidsbudsjetter – de har ikke råd til å vente på trege nettsteder når de henter informasjon til brukerforespørsler. Når en side bruker mer enn 2,5 sekunder på å laste, hopper ofte AI-crawlere over den helt og går videre til raskere alternativer som kan levere samme informasjon mer effektivt. Dette skaper en absolutt ytelsesgrense: nettsteder som ikke møter denne terskelen er i praksis usynlige for AI-systemer, uansett innholdskvalitet. Konsekvensene er store – dårlig nettstedshastighet gir direkte færre AI-siteringer og redusert synlighet i AI-drevne søkeresultater. Å forstå denne terskelen er første steg for å optimalisere for AI-synlighet.

AI-systemer bruker fire ulike innhentingsmoduser for å samle informasjon: pre-trening (historiske data tatt inn under modelltrening), sanntidslesing (live web-crawling under inferens), API-tilkoblinger (direkte integrasjoner med datakilder) og RAG (Retrieval-Augmented Generation-systemer som henter ferskt innhold). Hver modus har ulike ytelseskrav, men alle er følsomme for core web vitals og serverrespons. Når AI-crawlere vurderer en side, ser de på TTFB (Time to First Byte), LCP (Largest Contentful Paint), INP (Interaction to Next Paint) og CLS (Cumulative Layout Shift) – målinger som direkte påvirker om crawleren kan effektivt trekke ut og indeksere innholdet. Treg TTFB betyr at crawleren venter lenger før den mottar data; dårlig LCP betyr at viktig innhold vises sent; høy INP antyder mye JavaScript og treg parsing; mens CLS indikerer ustabile oppsett som gjør innholdsekstraksjon vanskelig.

| Måling | Hva den måler | Innvirkning på LLM-innhenting |

|---|---|---|

| TTFB | Tid til første byte ankommer fra server | Bestemmer oppstartshastighet; treg TTFB gir timeouts |

| LCP | Når største synlige innholdselement blir gjengitt | Forsinker tilgjengelighet for uttrekk og indeksering |

| INP | Respons på brukerinteraksjoner | Høy INP tyder på tung JavaScript som gjør parsing treg |

| CLS | Visuell stabilitet under lasting | Ustabile oppsett forvirrer innholdsekstraksjonsalgoritmer |

Forskning fra Cloudflare Radar viser et urovekkende misforhold: AI-boter crawler nettsteder langt oftere enn de faktisk gir trafikk eller siteringer. Dette crawl-to-referral-forholdet viser at ikke all crawl-aktivitet gir synlighet – noen AI-systemer indekserer rett og slett innhold uten å sitere det i svarene sine. Anthropics crawler har for eksempel et 70 900:1-forhold, noe som betyr at den crawler 70 900 sider for hver sitering den genererer. Dette tyder på at crawl-frekvens alene ikke er en pålitelig indikator for AI-synlighet; det som betyr noe er om crawleren effektivt kan prosessere innholdet ditt og avgjøre at det er verdt å sitere. Konklusjonen er tydelig: optimalisering for crawlbarhet er nødvendig, men ikke tilstrekkelig – du må også sikre at innholdet ditt er raskt nok til å bli behandlet og relevant nok til å bli valgt. Forståelsen av dette forholdet forklarer hvorfor noen høytrafikkerte nettsteder likevel sliter med AI-siteringer til tross for mye crawler-aktivitet.

AI-systemer vurderer i økende grad regional latenstid når de velger kilder til brukerforespørsler, spesielt for geografisk sensitive søk. Et nettsted som kun er hostet på én server i USA, kan laste raskt for amerikanske crawlere men sakte for crawlere i andre regioner, noe som påvirker global AI-synlighet. CDN-plassering og dataresidens blir kritiske faktorer – innhold levert fra geografisk distribuerte edge-lokasjoner lastes raskere for crawlere verden over og øker sannsynligheten for å bli valgt. For søk som inneholder “i nærheten” eller stedsmodifikatorer, prioriterer AI-systemer kilder med rask regional ytelse, så lokal optimalisering er essensielt for virksomheter som ønsker synlighet i bestemte geografier. Nettsteder som investerer i global CDN-infrastruktur får et konkurransefortrinn på AI-synlighet tvers av regioner. Ytelseskravet er globalt: 2,5 sekunders lastetid må være oppnåelig fra flere geografiske regioner, ikke bare fra hovedmarkedet ditt.

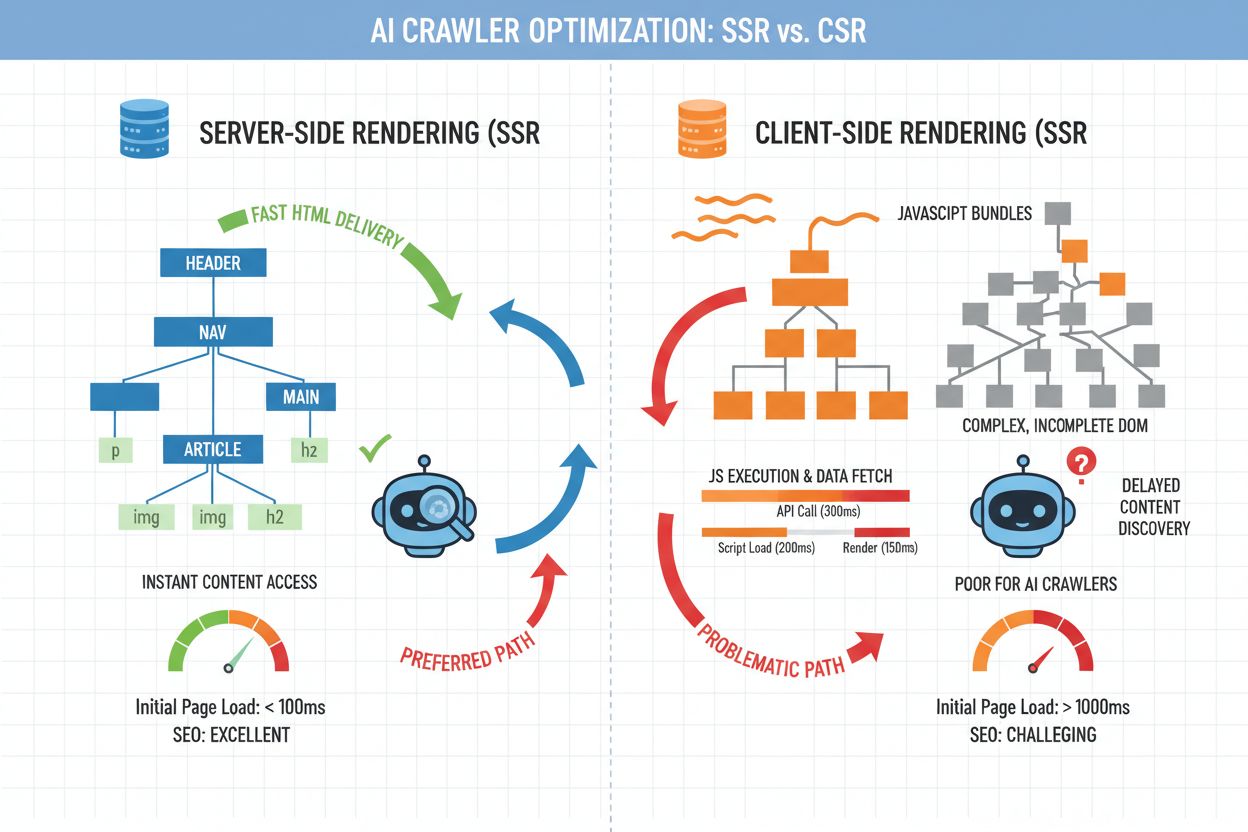

Valget mellom server-side rendering (SSR) og client-side rendering (CSR) har stor betydning for AI-synlighet. AI-crawlere foretrekker ren, semantisk HTML levert i første svar fremfor sider med mye JavaScript som krever client-side rendering for å vise innhold. Når en side er avhengig av client-side rendering, må crawleren kjøre JavaScript, vente på API-kall og gjengi DOM – en prosess som øker latenstid og kompleksitet. Minimalt med JavaScript, semantisk oppmerking og logiske overskriftsnivåer gjør innhold umiddelbart tilgjengelig for AI-systemer, reduserer behandlingstiden og gir bedre crawl-effektivitet. Server-side rendering sikrer at viktig innhold er til stede i den første HTML-responsen, slik at crawlere kan trekke ut informasjon uten å kjøre kode. Nettsteder som prioriterer rask, enkel HTML fremfor komplekse client-side-rammeverk får jevnt over bedre AI-synlighet. Arkitekturvalget handler ikke om å forlate moderne rammeverk – det handler om å sikre at kjerninnholdet ligger i første respons, med progressiv forbedring for brukerinteraksjon.

Optimalisering for AI-synlighet krever en systematisk tilnærming til ytelse. Følgende sjekkliste dekker de mest effektfulle optimaliseringene, alle med mål om å redusere latenstid og forbedre crawlbarhet:

Server kjerninnhold i initial HTML: Sørg for at hovedinnhold, overskrifter og nøkkelinformasjon er synlig i serverresponsen, ikke skjult bak JavaScript eller lazy-loading. AI-crawlere må kunne trekke ut det viktigste uten å kjøre kode.

Hold TTFB og HTML-størrelse nede: Optimaliser serverresponsen gjennom færre databasekall, caching og minimert HTML. En TTFB under 600 ms og initial HTML under 50 KB er realistiske mål for de fleste innholdssider.

Minimer blokkerende skript og CSS: Utsett ikke-kritisk JavaScript og ha kun viktig CSS inline. Blokkerende ressurser forsinker innhold og øker opplevd latenstid for crawlere.

Bruk semantisk HTML og logiske overskrifter: Strukturer innhold med riktig overskriftsnivå (H1, H2, H3), semantiske tagger (article, section, nav) og beskrivende alt-tekst. Dette hjelper AI-systemer å forstå innholdsstruktur og viktighet.

Begrens DOM-kompleksitet på viktige sider: Sider med tusenvis av DOM-noder tar lenger å tolke og gjengi. Forenkle oppsettet på hjørnesteinssider for å redusere behandlingsbelastningen.

Lag lette varianter av hjørnesteinsinnhold: Vurder å servere forenklede, tekstfokuserte versjoner av de viktigste sidene til AI-crawlere, samtidig som rike brukeropplevelser beholdes for mennesker. Dette kan gjøres med user-agent-deteksjon eller egne URL-er.

Å etablere et utgangspunkt er avgjørende før du optimaliserer for AI-synlighet. Bruk verktøy som Google PageSpeed Insights, WebPageTest og Lighthouse for å måle nåværende ytelse på sentrale målinger. Kjør kontrollerte eksperimenter ved å optimalisere bestemte sider og overvåke om AI-siteringene øker over tid – dette krever sporingsverktøy som korrelerer ytelsesendringer med synlighetsforbedringer. AmICited.com gir infrastrukturen til å overvåke AI-siteringer på tvers av flere LLM-plattformer, slik at du kan måle direkte effekten av ytelsesforbedringer. Sett opp varsler for ytelsesforringelser og ha månedlige gjennomganger av både hastighetsmålinger og AI-synlighet. Målet er å lage en tilbakemeldingssløyfe: mål utgangspunkt, gjennomfør optimaliseringer, følg med på siteringsøkning og iterer. Uten måling kan du ikke bevise sammenhengen mellom hastighet og AI-synlighet – og uten bevis er det vanskelig å forsvare videre investering i ytelsesoptimalisering.

AmICited.com har blitt det essensielle verktøyet for å spore AI-siteringer og overvåke synlighet i ChatGPT, Gemini, Perplexity og andre AI-systemer. Ved å integrere AmICited med ytelsesovervåkingen får du innsikt i hvordan hastighetsforbedringer henger sammen med økt sitering – en sammenheng som ellers er vanskelig å avdekke. Kompletterende verktøy som FlowHunt.io gir ytterligere innsikt i AI-crawler-adferd og innholdsindeksering. Konkurransefortrinnet ligger i å kombinere ytelsesoptimalisering med overvåking av AI-synlighet: du kan se hvilke tiltak som gir størst siteringsgevinst, og prioritere deretter. Nettsteder som systematisk sporer både ytelse og AI-siteringer kan ta datadrevne valg om hvor de skal investere utviklingsressurser. Denne integrerte tilnærmingen gjør nettstedshastighet til en målbar driver for AI-synlighet og organisk rekkevidde.

Mange nettsteder gjør kritiske feil når de optimaliserer for AI-synlighet. Overoptimalisering som fjerner innhold er en vanlig fallgruve – å kutte ut bilder, forklarende tekst eller gjemme innhold bak faner for å få bedre hastighetsmålinger slår ofte tilbake ved at innholdet blir mindre verdifullt for AI-systemer. Å kun fokusere på desktop-hastighet og ignorere mobil er en annen feil, siden AI-crawlere i økende grad etterligner mobile brukeragenter. Å stole på plattformstandarder uten testing er risikabelt; standardoppsett prioriterer ofte menneskelig brukeropplevelse foran AI-crawlbarhet. Å jage PageSpeed Insights-poeng i stedet for faktisk lastetid kan føre til feilprioriterte tiltak. Billig hosting for å spare serverkostnader gir ofte treg TTFB og dårlig ytelse under last – en falsk økonomi som koster mer i tapt AI-synlighet. Til slutt: å se på ytelsesoptimalisering som et engangsprosjekt i stedet for kontinuerlig vedlikehold fører til gradvis ytelsesforringelse etter hvert som innhold og kode vokser.

Nettstedshastighet vil fortsette å være viktig etter hvert som AI-søk utvikler seg og blir mer sofistikert. 2,5-sekunders terskelen kan bli strengere etter hvert som AI-systemene blir mer selektive, eller endres med nye innhentingsmetoder – men grunnprinsippet står fast: raske nettsteder er mer synlige for AI-systemer. Se på ytelsesoptimalisering som en løpende praksis, ikke et avsluttet prosjekt. Gjennomfør jevnlige revisjoner av hastighetsmålinger, følg AI-siteringstrender og juster teknisk arkitektur etter hvert som nye beste praksiser dukker opp. Nettstedene som vil dominere AI-drevne søkeresultater er de som samkjører optimaliseringsarbeidet for både menneskelig brukeropplevelse og AI-crawler-krav. Ved å holde fast på ytelsesgrunnprinsippene – rask TTFB, semantisk HTML, minimalt med JavaScript og ryddig arkitektur – sikrer du at innholdet ditt forblir synlig og siterbart uavhengig av hvordan AI-systemene utvikler seg. Fremtiden tilhører de som behandler hastighet som et strategisk fortrinn, ikke en ettertanke.

Tradisjonell SEO betrakter hastighet som én av mange rangeringsfaktorer, men AI-systemer har strenge latenstidsbudsjetter og hopper over trege nettsteder helt. Hvis siden din tar mer enn 2,5 sekunder å laste, gir AI-crawlere ofte opp før de trekker ut innholdet, noe som gjør hastighet til et absolutt krav for AI-synlighet – ikke bare en preferanse.

Den kritiske terskelen er 2,5 sekunder for full lasting av siden. Time to First Byte (TTFB) bør imidlertid være under 600 ms, og initial HTML bør laste innen 1–1,5 sekunder. Disse målingene sikrer at AI-crawlere effektivt kan få tilgang til og behandle innholdet ditt uten å time ut.

Test ytelsen månedlig med verktøy som Google PageSpeed Insights, WebPageTest og Lighthouse. Viktigere er det å korrelere disse målingene med AI-siteringssporing via verktøy som AmICited.com for å måle den faktiske effekten ytelsesendringer har på synligheten din.

Ja, i stadig større grad. AI-crawlere simulerer ofte mobile brukeragenter, og ytelsen på mobil er ofte dårligere enn på desktop. Sørg for at lastetiden på mobil samsvarer med desktop-ytelsen – dette er kritisk for global AI-synlighet på tvers av ulike regioner og nettforhold.

Du kan gjøre inkrementelle forbedringer gjennom caching, CDN-optimalisering og bildekomprimering. Men betydelige gevinster krever arkitekturelle endringer som server-side rendering, mindre JavaScript og forenklet DOM-struktur. De beste resultatene oppnås ved å forbedre både infrastruktur og kode.

Bruk AmICited.com for å spore AI-siteringer på tvers av plattformer og korreler siteringstrender med ytelsesdata fra Google PageSpeed Insights. Hvis siteringene faller etter en ytelsesforverring, eller øker etter optimalisering, har du klare bevis på sammenhengen.

Core Web Vitals (LCP, INP, CLS) påvirker direkte effektiviteten til AI-crawlere. Dårlig LCP forsinker tilgjengeligheten av innhold, høy INP antyder mye JavaScript, og CLS forvirrer innholdsekstraksjon. Selv om disse målingene er viktige for brukeropplevelsen, er de like kritiske for at AI-systemer effektivt skal kunne behandle og indeksere innholdet ditt.

Optimaliser for begge samtidig – de samme forbedringene som gjør nettstedet raskt for mennesker (ren kode, semantisk HTML, minimalt med JavaScript) gjør det også raskt for AI-crawlere. 2,5-sekunders terskelen gagner begge målgrupper, og det er ingen motsetning mellom brukeropplevelse og AI-synlighet.

Følg med på hvordan nettstedshastighet påvirker AI-synlighet i ChatGPT, Gemini og Perplexity. Få sanntidsinnsikt i dine AI-siteringer og optimaliser for maksimal synlighet.

Oppdag de viktigste faktorene som påvirker AI-indekseringshastighet, inkludert nettstedets ytelse, gjennomsøkingsbudsjett, innholdsstruktur og teknisk optimalis...

Lær hvordan sidehastighet påvirker synligheten din i AI-søkemotorer som ChatGPT, Perplexity og Gemini. Oppdag optimaliseringsstrategier og metrikker som er vikt...

Diskusjon i fellesskapet om hvorvidt sidehastighet påvirker AI-synlighet i søk. Faktiske data fra ytelsesingeniører og SEO-profesjonelle som analyserer sammenhe...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.