Nettstedshastighet og AI-synlighet: Påvirker ytelse siteringer?

Oppdag hvordan nettstedshastighet direkte påvirker AI-synlighet og siteringer i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders terskelen og optimaliserings...

Oppdag de viktigste faktorene som påvirker AI-indekseringshastighet, inkludert nettstedets ytelse, gjennomsøkingsbudsjett, innholdsstruktur og teknisk optimalisering. Lær hvordan du optimaliserer nettstedet ditt for raskere AI-søkemotorindeksering.

AI-indekseringshastighet påvirkes av flere faktorer, inkludert nettstedets ytelse og lastetider, tilgjengelig gjennomsøkingsbudsjett, innholdskvalitet og -struktur, teknisk SEO-konfigurasjon, effektivitet i databaseindeksering, implementering av schema markup, og kompleksiteten i nettstedets arkitektur. Optimalisering av disse elementene sikrer at AI-crawlere effektivt kan oppdage, behandle og indeksere innholdet ditt.

AI-indekseringshastighet avgjør hvor raskt innholdet ditt blir synlig i AI-drevne søkemotorer som ChatGPT, Perplexity og Googles AI Overviews. I motsetning til tradisjonelle søkemotorer som kun matcher nøkkelord til sider, må AI-systemer gjennomsøke, forstå og syntetisere innholdet ditt for å generere nøyaktige svar. Hvor raskt dette skjer avhenger av en rekke sammenkoblede faktorer som direkte påvirker synligheten din i AI-genererte svar og evnen til å fange trafikk fra AI-søkeplattformer.

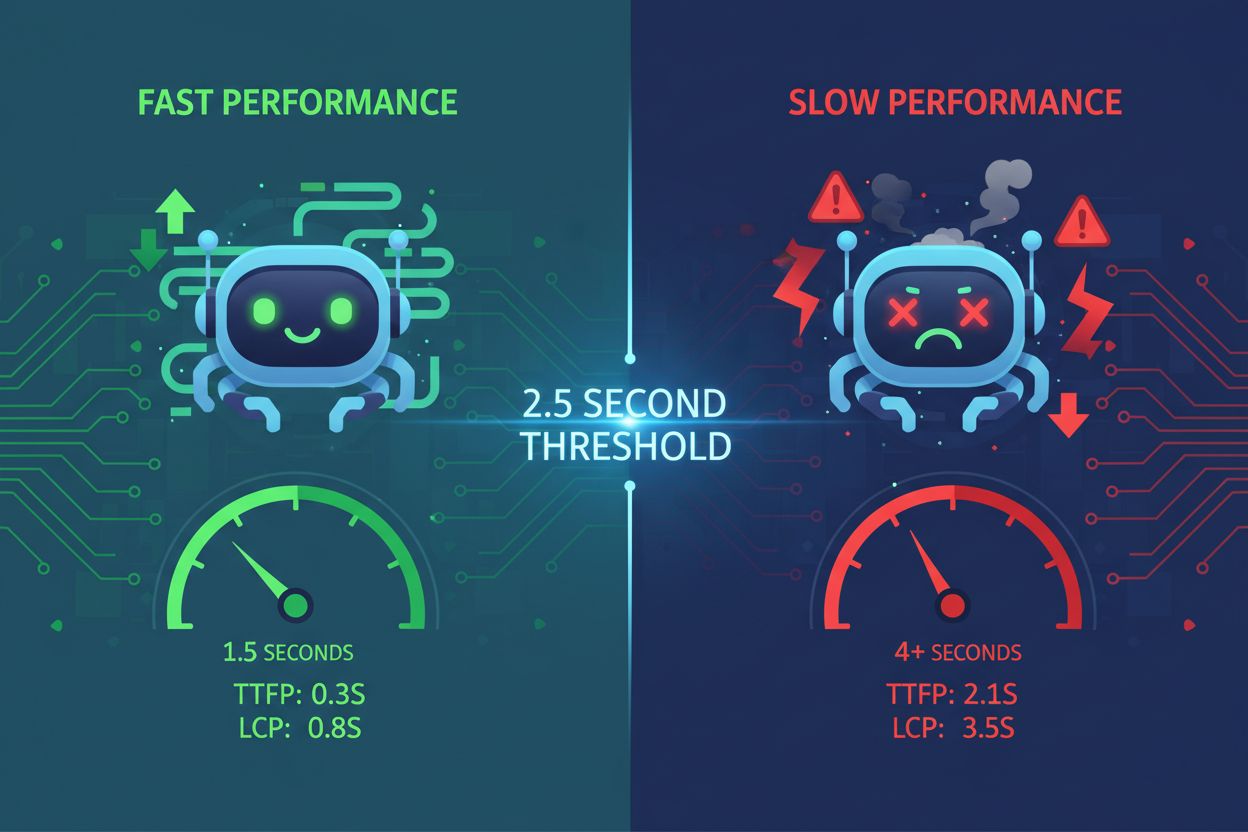

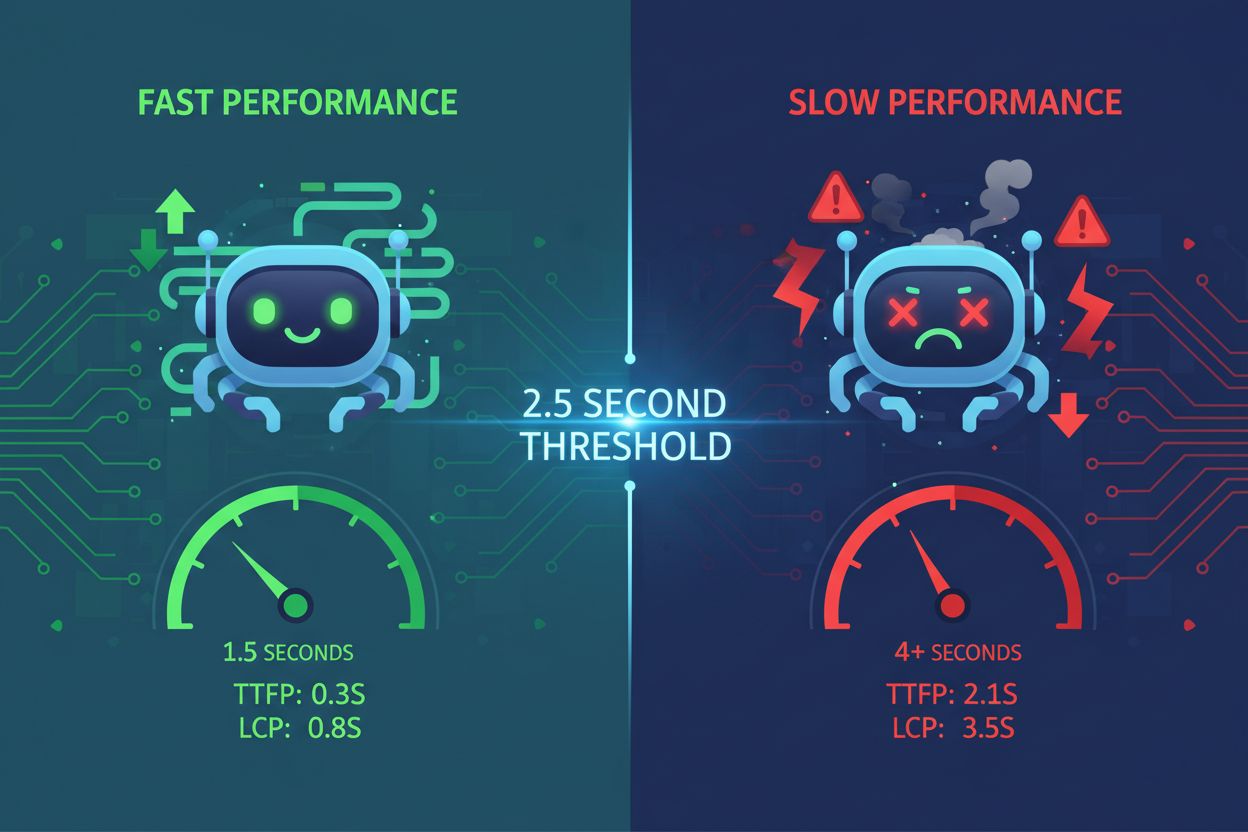

Sideinnlasting er en av de mest kritiske faktorene som påvirker AI-indekseringshastighet. AI-crawlere opererer innenfor strenge ressursbegrensninger og tidsrammer—typisk mellom 1–5 sekunder per sideforespørsel. Når nettstedet ditt laster sakte, bruker crawlere mer tid på å hente innhold, noe som betyr at færre sider blir indeksert innenfor deres tildelte gjennomsøkingsvindu. Dette gir en kjedereaksjon der svak ytelse direkte reduserer antallet sider AI-systemene kan behandle og indeksere.

Sakte nettsider signaliserer dårlig vedlikehold til AI-systemene. Når sider tar unødvendig lang tid å laste, kan AI-crawlere få tidsavbrudd før de får tilgang til det faktiske innholdet ditt, og bare HTML-skjelettet blir indeksert. Dette er spesielt problematisk for JavaScript-tunge nettsteder der innhold lastes dynamisk på klientsiden. Den to-trinns rendringsprosessen som kreves for JavaScript gir betydelig forsinkelse, noe som gjør det vanskeligere for AI-systemene å hente ut meningsfull informasjon. Komprimering av bilder, minifisering av kode, implementering av lat innlasting og bruk av Content Delivery Networks (CDN) kan dramatisk forbedre innlastingstiden og tillate AI-crawlere å behandle flere sider effektivt.

| Ytelsesmetrikker | Mål | Påvirkning på AI-indeksering |

|---|---|---|

| Sideinnlastingstid | Under 3 sekunder | Tillater flere sider å bli crawlet per økt |

| Largest Contentful Paint (LCP) | Under 2,5 sekunder | Sikrer at AI ser meningsfullt innhold raskt |

| First Input Delay (FID) | Under 100ms | Forbedrer crawler-responsivitet |

| Cumulative Layout Shift (CLS) | Nær null | Forhindrer feil ved innholdsekstraksjon |

Gjennomsøkingsbudsjett refererer til det begrensede antallet sider AI-systemer kan besøke innenfor en bestemt tidsramme. Hvert nettsted får en begrenset crawl-allokering fra AI-søkemotorer, på samme måte som Google tildeler gjennomsøkingsbudsjett. Når budsjettet er oppbrukt, slutter AI-systemene å indeksere nytt innhold, uavhengig av kvalitet. Dette blir spesielt utfordrende for store nettsteder med hundrevis eller tusenvis av sider som konkurrerer om begrensede indekseringsressurser.

Optimalisering av gjennomsøkingsbudsjettet er avgjørende for raskere AI-indeksering. Du bør prioritere sider med høy verdi—de som genererer inntekter, tiltrekker trafikk eller inneholder kritisk informasjon—over sider med lav verdi som dupliserte kategorifiltre eller overflødige tag-sider. Ved å bruke robots.txt strategisk kan du blokkere AI-crawlere fra å få tilgang til sider som ikke trenger indeksering, og spare budsjettet for viktig innhold. I tillegg bidrar en oppdatert XML-sitemap og god intern lenkestruktur til at AI-systemer raskere oppdager de viktigste sidene dine og får dem indeksert før budsjettet er brukt opp.

AI-systemer straffer sterkt duplisert og tynt innhold, noe som bremser indekseringen betydelig. Når AI-crawlere møter innhold uten originalitet eller substans, vil de nedprioritere å gjennomsøke lignende sider på nettstedet ditt. Dette fordi AI-systemer vurderer innholdskvalitet med E-E-A-T-signaler (Erfaring, Ekspertise, Autoritet og Troverdighet). Innhold som fremstår som lite gjennomarbeidet, AI-generert uten menneskelig gjennomgang, eller kopiert fra andre kilder, får lavere prioritet i indekseringskøen.

Høykvalitets, grundig innhold blir indeksert raskere av AI-systemer. Innhold på over 3 000 ord som grundig besvarer brukerens spørsmål fra flere vinkler får prioritert indeksering. AI-systemer foretrekker innhold som inkluderer støttende data, statistikk, eksempler fra virkeligheten og casestudier fordi dette viser ekspertise og troverdighet. Når du lager originalt, grundig innhold med reell verdi, vil AI-crawlere tildele mer ressurser til å indeksere sidene dine, noe som gir raskere oppdagelse og inkludering i AI-genererte svar.

Feil robots.txt-konfigurasjon kan ved et uhell blokkere AI-crawlere fra å indeksere innholdet ditt. Mange nettsteder hindrer uforvarende AI-søkeroboter fra å få tilgang til sidene sine ved feilkonfigurering av robots.txt-filer. Ulike AI-systemer bruker forskjellige crawler-identifikatorer—ChatGPT bruker OAI-SearchBot, Perplexity bruker PerplexityBot, og andre bruker AndiBot eller ExaBot. Hvis robots.txt-filen din ikke eksplisitt tillater disse crawlerne, kan de ikke indeksere innholdet ditt, uansett kvalitet eller relevans.

Ren HTML-struktur og semantisk markup akselererer AI-indeksering. AI-crawlere har utfordringer med JavaScript-tunge løsninger og komplekse, nestede strukturer. Bruk av semantiske HTML5-tagger (article, section, nav), riktige overskriftshierarkier (H1-H6), beskrivende lenketekst og alt-tekst for bilder gjør innholdet ditt umiddelbart tilgjengelig for AI-systemer. Server-side rendering (SSR)-rammeverk som Next.js eller Gatsby forbereder innhold på serveren, slik at AI-crawlere mottar fullverdige sider uten å måtte kjøre JavaScript, noe som betydelig øker indekseringshastigheten.

Overindeksering i databasen gir ventetid som bremser AI-indekseringshastigheten. Når databaser har for mange, overflødige eller overlappende indekser, må hver innsetting, oppdatering og sletting oppdatere flere indekser, noe som gir flaskehalser i skriveytelsen. Denne belastningen påvirker direkte hvor raskt publiseringssystemet ditt kan levere sider til AI-crawlere. Overflødige indekser bruker lagringsplass, gir forsinkelser og tvinger spørringsplanleggere til suboptimale beslutninger, noe som samlet reduserer innholdsleveransen til AI-systemene.

Optimalisering av databaseindekser forbedrer leveringshastigheten til AI-crawlere. Revider databasen jevnlig for å identifisere ubrukte eller overflødige indekser med verktøy som pg_stat_user_indexes (PostgreSQL) eller sys.schema_unused_indexes (MySQL). Fjern indekser som ikke har vært brukt på uker eller måneder, slå sammen overlappende indekser og sørg for at databaseskjemaet samsvarer med nåværende spørringsmønstre. En veloptimalisert database leverer innhold raskere til AI-crawlere, som gir raskere indeksering og inkludering i AI-genererte svar.

Manglende eller ufullstendig schema markup forsinker AI-forståelse og indeksering av innholdet ditt. Schema markup gir strukturert data som hjelper AI-systemer å raskt forstå kontekst, mening og relasjoner i innholdet ditt. Uten korrekt schema-implementering må AI-crawlere bruke ekstra prosesseringstid på å tolke innholdsstrukturen og hente ut nøkkelinformasjon. Denne ekstra tiden reduserer indekseringshastigheten fordi crawlere må bruke mer ressurser per side.

Omfattende schema markup akselererer AI-indeksering. FAQ-schema, How-To-schema, Article-schema og Product-schema gir AI-systemene forhåndsstrukturert informasjon som kan forstås og indekseres umiddelbart. Når du inkluderer forfatterinformasjon, publiseringsdatoer, vurderinger og annen strukturert data, kan AI-systemene raskt kategorisere og indeksere innholdet ditt uten ekstra prosessering. Forskning viser at 36,6 % av søkenøkkelord trigger utvalgte utdrag basert på schema markup, noe som viser hvordan strukturert data direkte påvirker AI-synlighet og indekseringshastighet.

Svak intern lenking hindrer AI-crawlere fra effektivt å oppdage innholdet ditt. Interne lenker fungerer som et veikart som guider AI-crawlere gjennom nettstedets arkitektur. Uten strategisk intern lenking kan AI-systemer slite med å oppdage viktige sider, spesielt nytt innhold som ligger dypt i strukturen. Denne oppdagelsesforsinkelsen gjør at indekseringen går tregere fordi crawlere må bruke mer tid på å finne sider som skal indekseres.

Strategisk intern lenking akselererer AI-oppdagelse og indeksering av innhold. Å lenke nytt innhold fra relevante eksisterende sider hjelper AI-crawlere å finne og indeksere det raskere. Bruk beskrivende ankertekst som tydelig indikerer hva den lenkede siden inneholder, slik at AI-systemene bedre forstår innholdsrelasjoner og kontekst. Riktig intern lenkestruktur sikrer at sider med høy verdi får mer crawl-oppmerksomhet, noe som gir raskere indeksering og høyere prioritet i AI-genererte svar.

Dårlig brukeropplevelse signaliserer for AI-systemer at innholdet ditt kanskje ikke er verdifullt. Høy fluktfrekvens, korte økter og lave engasjementstall indikerer for AI-crawlere at innholdet ikke møter brukernes behov. AI-systemer bruker i økende grad atferdssignaler for å vurdere innholdskvalitet, og sider med dårlig brukeropplevelse får lavere prioritet for indeksering. Når brukere raskt forlater sidene dine, tolker AI-systemene dette som et signal om at innholdet mangler verdi, og det tar lengre tid før det blir inkludert i AI-genererte svar.

Leservennlig innholdsstruktur forbedrer AI-indekseringshastigheten. Innhold formatert med korte avsnitt (2–3 setninger), beskrivende underoverskrifter, punktlister, nummererte lister og tabeller er lettere for både brukere og AI-systemer å behandle. Denne forbedrede lesbarheten gjør at AI-crawlere raskt kan hente ut nøkkelinformasjon og forstå innholdsstrukturen uten omfattende prosessering. Når innholdet ditt er godt organisert og tilgjengelig, kan AI-systemene indeksere det raskere og med høyere tillit til kvalitet og relevans.

Treg hosting-infrastruktur gir flaskehalser som forsinker AI-indeksering. Delt hosting har ofte begrensede ressurser og lavere responstid, noe som betyr at AI-crawlere må vente lengre for hver side. Denne ventetiden reduserer antallet sider som kan indekseres innenfor crawlerens tildelte tidsvindu. Serverens responstid påvirker direkte crawl-effektiviteten—hver millisekund med forsinkelse reduserer det totale antallet indekserte sider per økt.

Oppgradering til rask, skalerbar hosting akselererer AI-indeksering. Administrerte WordPress-hosting, VPS-løsninger og skyplattformer som Google Cloud eller AWS gir raskere serverresponstid og bedre ressursallokering. CDN-løsninger som Cloudflare cacher innhold globalt og leverer sider raskere til crawlere uansett geografisk beliggenhet. Når hosting-infrastrukturen leverer sider raskt, kan AI-crawlere behandle mer innhold per økt, noe som gir raskere total indeksering og bedre synlighet i AI-genererte svar.

Kontinuerlig overvåkning av AI-indekseringsytelsen muliggjør proaktiv optimalisering. Verktøy som Google Search Console, SE Rankings AI Results Tracker og Peec.ai hjelper deg å spore hvor raskt innholdet ditt vises i AI-søkeresultater og identifisere sider som ikke blir indeksert. Ved å overvåke disse målingene, kan du oppdage flaskehalser og implementere målrettede forbedringer som direkte påvirker indekseringshastigheten.

Regelmessige revisjoner og oppdateringer opprettholder optimal AI-indekseringshastighet. Gjennomfør periodiske ytelsesrevisjoner med verktøy som Google PageSpeed Insights, GTmetrix og WebPageTest for å identifisere hastighetsflaskehalser. Oppdater XML-sitemapen regelmessig, oppfrisk innhold for å opprettholde ferskhetssignaler, og optimaliser kontinuerlig database og infrastruktur. Konsistent optimalisering sikrer at AI-indekseringshastigheten din forblir konkurransedyktig og at innholdet ditt fortsetter å vises raskt i AI-genererte svar.

Følg med på hvor raskt innholdet ditt vises i AI-søkeresultater som ChatGPT, Perplexity og andre AI-svargeneratorer. Få sanntidsinnsikt i din AI-indekseringsytelse.

Oppdag hvordan nettstedshastighet direkte påvirker AI-synlighet og siteringer i ChatGPT, Gemini og Perplexity. Lær om 2,5-sekunders terskelen og optimaliserings...

Lær hvordan sidehastighet påvirker synligheten din i AI-søkemotorer som ChatGPT, Perplexity og Gemini. Oppdag optimaliseringsstrategier og metrikker som er vikt...

Diskusjon i fellesskapet om hvorvidt sidehastighet påvirker AI-synlighet i søk. Faktiske data fra ytelsesingeniører og SEO-profesjonelle som analyserer sammenhe...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.