Hvordan bestride og korrigere unøyaktig informasjon i AI-svar

Lær hvordan du bestrider unøyaktig AI-informasjon, rapporterer feil til ChatGPT og Perplexity, og implementerer strategier for å sikre at merkevaren din represe...

Prosesser for å bestride unøyaktig eller skadelig AI-generert merkevareinnhold. AI-innholdstvister viser til formelle utfordringer når kunstig intelligens genererer misvisende informasjon om merkevarer, produkter eller organisasjoner. Disse tvistene oppstår på grunn av AI-hallusinasjoner, feilaktige sitater og feiltolkninger som skader merkevarens omdømme på plattformer som ChatGPT, Perplexity og Google AI Overviews. Effektiv tvisteløsning krever overvåking, dokumentasjon, direkte kontakt med AI-selskaper, og strategisk innholdsproduksjon for å rette opp feilinformasjon.

Prosesser for å bestride unøyaktig eller skadelig AI-generert merkevareinnhold. AI-innholdstvister viser til formelle utfordringer når kunstig intelligens genererer misvisende informasjon om merkevarer, produkter eller organisasjoner. Disse tvistene oppstår på grunn av AI-hallusinasjoner, feilaktige sitater og feiltolkninger som skader merkevarens omdømme på plattformer som ChatGPT, Perplexity og Google AI Overviews. Effektiv tvisteløsning krever overvåking, dokumentasjon, direkte kontakt med AI-selskaper, og strategisk innholdsproduksjon for å rette opp feilinformasjon.

En AI-innholdstvist viser til en formell utfordring eller klageprosess når kunstig intelligens genererer, siterer eller presenterer unøyaktig, misvisende eller skadelig informasjon om en merkevare, et produkt eller en organisasjon. Disse tvistene oppstår når AI-drevne søkemotorer, chatboter og språkmodeller produserer innhold som feiltolker fakta, tilskriver feil informasjon eller skader merkevarens omdømme gjennom AI-hallusinasjoner—tilfeller der AI-systemer selvsikkert presenterer feilaktig informasjon som fakta. Etter hvert som AI-søk blir stadig mer sentralt for hvordan forbrukere oppdager og vurderer merkevarer, med plattformer som ChatGPT, Perplexity, Google AI Overviews og Gemini som påvirker kjøpsbeslutninger for millioner av brukere, har evnen til å utfordre og korrigere unøyaktig AI-generert innhold blitt kritisk for merkevarebeskyttelse og omdømmehåndtering.

Effekten av unøyaktig AI-generert innhold går langt utover tradisjonelle bekymringer innen merkevareovervåking. I motsetning til innlegg på sosiale medier som forsvinner fra strømmen i løpet av timer, kan AI-genererte merkevareomtaler vedvare på tvers av flere plattformer og påvirke forbrukeroppfatning i måneder eller år. Nesten 50 % av folk stoler på AI-anbefalinger, og med over 700 millioner ukentlige ChatGPT-brukere kan en enkelt unøyaktig uttalelse om din merkevare nå titalls millioner potensielle kunder. Når AI-systemer siterer feil prising, tilskriver produktegenskaper feil, eller anbefaler konkurrenter istedenfor din merkevare, påvirker konsekvensene direkte kundetilgang, konverteringsrater og markedsposisjonering.

| Aspekt | Tradisjonelle merkevaretvister | AI-innholdstvister |

|---|---|---|

| Levetid | Timer til dager (sosiale medier) | Måneder til år (vedvarende i AI-modeller) |

| Rekkevidde | Begrenset til plattformfølgere | Millioner av AI-brukere globalt |

| Korrigeringshastighet | Umiddelbart svar mulig | Krever innholdsstrategi og oppfølging |

| Verifisering | Menneskelig gjennomgang | AI-generert, vanskeligere å faktasjekke |

| Innvirkning på søk | Påvirker SEO-rangering | Påvirker AI Share of Voice og anbefalinger |

| Publikumstillit | Variabel per plattform | Høy (50 %+ stoler på AI) |

| Varighet | Kan slettes av opphavsperson | Innebygd i AI-treningsdata |

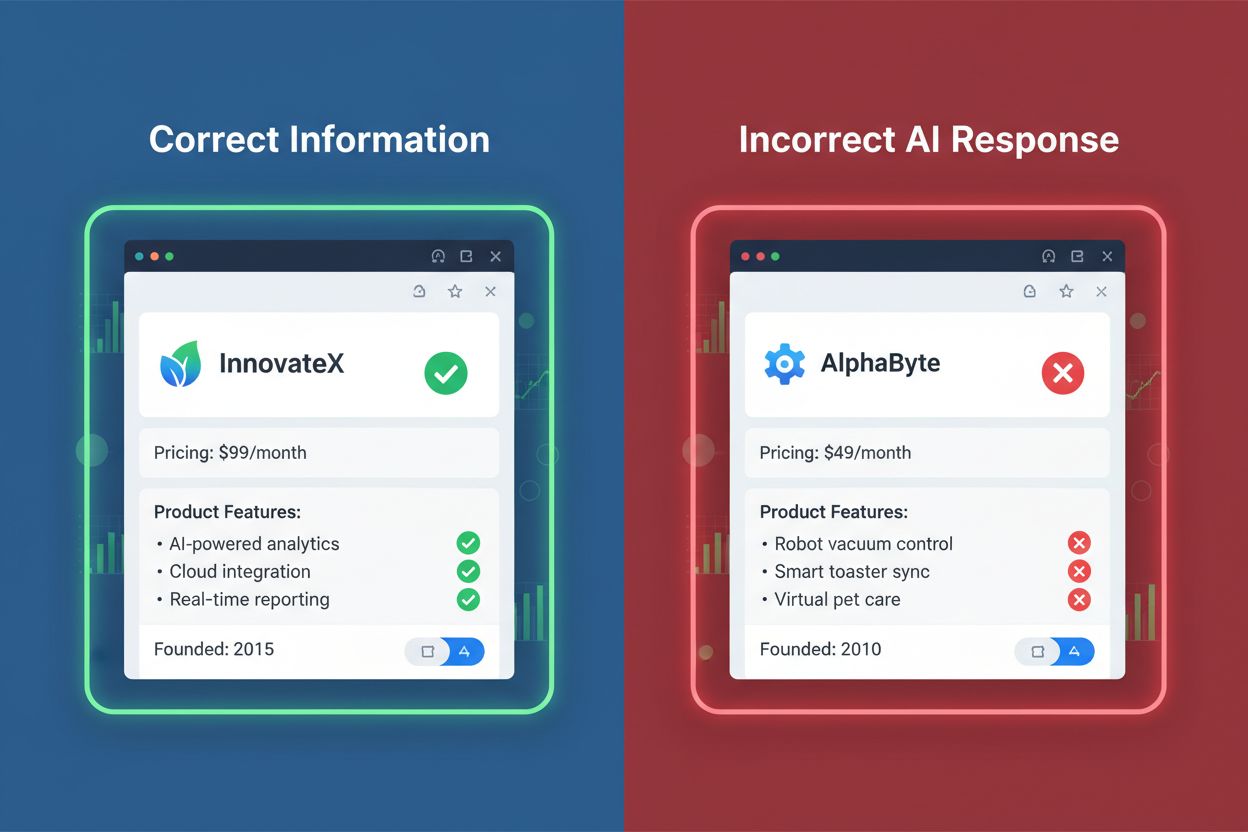

Virkelige eksempler viser alvoret: AI-systemer har sitert feil prising for abonnementstjenester, listet utgåtte produkter som aktive tilbud, og tilskrevet funksjoner til konkurrenter som egentlig tilhører den opprinnelige merkevaren. Disse feilene påvirker direkte kjøpsbeslutninger og kan føre til tapte inntekter, svekket kundeforhold og redusert konkurranseevne i AI-drevne søkeresultater.

AI-systemer genererer ulike kategorier av unøyaktig eller skadelig innhold om merkevarer. Å forstå disse typene hjelper organisasjoner å identifisere og prioritere tvisteløsning:

Å forstå hvorfor AI-systemer produserer unøyaktig merkevareinformasjon er avgjørende for å utvikle effektive strategier for tvisteløsning. AI-hallusinasjoner oppstår når språkmodeller genererer plausibel, men feil informasjon, som er et grunnleggende trekk ved hvordan disse systemene virker. I stedet for å hente fakta fra en database, forutser AI-modeller neste ord basert på statistiske mønstre i treningsdata, og produserer noen ganger selvsikre påstander om informasjon som ikke eksisterer eller er utdatert. Mange AI-systemer bruker Retrieval Augmented Generation (RAG), som supplerer treningsdata med sanntidssøk på nettet, men denne prosessen kan forsterke feil hvis kildene inneholder unøyaktigheter eller AI-en feiltolker konteksten. Begrensninger i treningsdata gjør at informasjon om nyere produkter, endringer i selskapet eller oppdatert prising ikke nødvendigvis gjenspeiles i AI-svar. I tillegg oppstår skjevhet i kildevalg når AI-systemer overvekter enkelte nettsteder—særlig domener med høy autoritet som Wikipedia, Reddit eller bransjeanmeldelser—som kan inneholde utdatert eller ufullstendig informasjon om din merkevare.

Effektiv tvisteløsning begynner med systematisk overvåking på tvers av flere AI-plattformer. Manuell overvåking innebærer periodisk å spørre AI-systemer om merkevarerelaterte spørsmål og gjennomgå svarene for nøyaktighet, men denne tilnærmingen er tidkrevende og fanger bare opp en brøkdel av mulige omtaler. Automatiserte AI-overvåkingsverktøy gir omfattende sporing på plattformer som ChatGPT, Perplexity, Google AI Overviews, Gemini, Claude og DeepSeek, og analyserer tusenvis av AI-genererte svar for å identifisere unøyaktigheter. Ledende plattformer som AmICited.com spesialiserer seg på å spore hvordan AI-systemer refererer til merkevarer og tilbyr sentimentanalyse for å identifisere negative fremstillinger og sitatsanalyse for å vise hvilke kilder AI-systemene benytter når de omtaler merkevaren. Konkurrerende løsninger som Authoritas tilbyr tilpassbar promptsporing med statistisk sikkerhet, Profound gir overvåking i stor skala med detaljert svaranalyse, og Ahrefs Brand Radar sporer AI-omtaler sammen med tradisjonell søkesynlighet. Verktøy som Otterly og Peec.ai tilbyr rimeligere inngangsnivåløsninger for mindre merkevarer som begynner å overvåke sin AI-tilstedeværelse. Effektiv overvåking bør ikke bare spore merkevareomtaler, men også AI Share of Voice—prosentandelen AI-anbefalinger din merkevare mottar sammenlignet med konkurrenter i relevante kategorier.

Når unøyaktig AI-innhold er identifisert, finnes det flere løsninger avhengig av alvorlighetsgraden og typen tvist. Direkte kontakt med AI-selskaper innebærer å kontakte plattformer som OpenAI, Anthropic, Google og Perplexity med dokumenterte eksempler på feil, og be om rettelser eller re-trening av modellene. Mange AI-selskaper har etablerte tilbakemeldingssystemer og tar hensyn til merkevareomdømme, spesielt når feil påvirker kundetillit eller gjelder faktiske feil. Innholdsproduksjon og optimalisering adresserer årsaken ved å sikre at nettsiden inneholder tydelig, nøyaktig og omfattende informasjon om merkevaren, produkter, prising og selskapsinformasjon—opplysninger som AI-systemene vil sitere i sine svar. Å lage egne sammenligningssider og FAQ-seksjoner som direkte adresserer vanlige spørsmål og konkurrent-sammenligninger øker sjansen for at AI-systemer siterer ditt autoritative innhold fremfor tredjepartskilder. PR og medieomtale kan forsterke korrigeringer gjennom bransjepublikasjoner og nyheter, og påvirke nettsider som AI-systemene henter informasjon fra. Influencer-partnerskap og tredjepartsanmeldelser på plattformer med høy autoritet som G2, Capterra eller bransjespesifikke anmeldelsessider gir alternative kilder for AI-systemene, og forbedrer merkevarens representasjon i AI-svar. Den mest effektive tilnærmingen kombinerer flere strategier: korrigere feil på nettsiden, skape autoritativt innhold AI-systemene vil sitere, og direkte engasjement med AI-selskaper når tvister gjelder faktiske feil som skader merkevarens omdømme.

Et voksende økosystem av spesialiserte verktøy hjelper merkevarer å overvåke, analysere og håndtere sin tilstedeværelse i AI-generert innhold. AmICited.com leder markedet for AI-merkevareovervåking, sporer omtaler på de største AI-plattformene med detaljert sentimentanalyse og sitatsporing for å identifisere hvilke kilder påvirker AI-svar om din merkevare. Authoritas kombinerer AI-søkeovervåking med tradisjonell SEO-sporing og tilbyr tilpasset promptgenerering og statistisk sikkerhet for analyser i stor skala. Profound gir daglig overvåking med omfattende svaranalyse og utforsking av samtaler for å forstå hvilke spørsmål som utløser merkevareomtale. Ahrefs Brand Radar integrerer AI-omtalesporing med synlighetsmåling i søk, og viser hvordan din merkevare fremstår på tvers av seks store AI-indekser sammen med tradisjonell søkeresultater. Otterly.ai tilbyr rimelig ukentlig overvåking med automatisk rapportering, ideelt for merkevarer som starter sin AI-synlighetsreise. Peec.ai gir mellomnivåløsninger med oversiktlige dashbord og konkurrentbenchmarking. Disse plattformene har felles funksjoner som omtalehyppighet, sentimentanalyse, konkurrent-sammenligning og identifisering av siterte kilder, men varierer i oppdateringshyppighet (sanntid til ukentlig), plattformdekning, tilpasningsmuligheter og pris. Valg av riktig verktøy avhenger av organisasjonens størrelse, budsjett og graden av analyse av AI-søk som kreves.

Etter hvert som AI-innholdstvister blir vanligere, utvikles juridiske og regulatoriske rammeverk for å ivareta merkevarebeskyttelse og innholdsnøyaktighet. Federal Trade Commission (FTC) har iverksatt tiltak mot selskaper som har gitt villedende opplysninger om AI-funksjonalitet, inkludert saker der AI-innholdsdeteksjonsverktøy ble markedsført med overdrevne nøyaktighetskrav. Opphavsretts- og varemerkebekymringer oppstår når AI-systemer feilkrediterer immaterielle rettigheter eller genererer innhold som krenker merkevarerettigheter. Nye reguleringer i EU, Storbritannia og foreslått amerikansk lovgivning krever i økende grad at AI-systemer oppgir treningsdatakilder og gir mekanismer for å rette feil informasjon. Ansvarsspørsmål er fortsatt uavklart: det må avgjøres om ansvaret for unøyaktig AI-innhold ligger hos AI-utviklere, selskapene som leverte treningsdata, eller merkevarene selv. Fremoverlente organisasjoner bør følge med på regulatoriske utviklinger og sørge for at prosesser for tvisteløsning samsvarer med nye juridiske krav til AI-gjennomsiktighet og nøyaktighet.

Proaktiv merkevarehåndtering i AI-tidsalderen krever en flerlags tilnærming som kombinerer forebygging, overvåking og rask respons. Vedlikehold nøyaktig informasjon på nettsiden på alle sider, og sørg for at prising, produktbeskrivelser, selskapsinformasjon og nøkkelfakta er oppdatert og tydelig presentert—dette blir den autoritative kilden AI-systemer siterer. Lag omfattende merkevare-dokumentasjon inkludert detaljerte FAQ-sider, sammenligningssider mot konkurrenter, og “om oss”-innhold som direkte besvarer spørsmål AI-systemer sannsynligvis får. Overvåk regelmessig ved å bruke spesialiserte AI-overvåkingsverktøy for å fange opp feil tidlig før de sprer seg til flere AI-plattformer. Reager raskt når tvister oppdages, med både direkte kontakt med AI-selskaper og innholdsproduksjon for å rette feilinformasjon. Bygg merkevareautoritet gjennom tredjepartsomtaler på nettsteder med høy autoritet, bransjeanmeldelser og medieomtale som AI-systemer vil prioritere som kilder. Optimaliser for AI-søk ved å lage innhold som besvarer spesifikke spørsmål brukere stiller AI-systemer, slik at din merkevare vises i relevante svar. Organisasjoner som kombinerer disse praksisene—nøyaktig informasjon, omfattende dokumentasjon, aktiv overvåking, rask respons og autoritetsbygging—reduserer risikoen og effekten av AI-innholdstvister betydelig, samtidig som de forbedrer synligheten i AI-drevne søkeresultater.

En AI-innholdstvist oppstår når kunstig intelligens genererer, siterer eller presenterer unøyaktig, misvisende eller skadelig informasjon om en merkevare, et produkt eller en organisasjon. Disse tvistene oppstår fra AI-hallusinasjoner—tilfeller der AI-systemer selvsikkert presenterer feilaktig informasjon som fakta—og kan i betydelig grad skade merkevarens omdømme på plattformer som ChatGPT, Perplexity og Google AI Overviews.

I motsetning til innlegg på sosiale medier som forsvinner i løpet av timer, vedvarer AI-genererte merkevareomtaler i måneder eller år og når millioner av brukere. Nesten 50 % stoler på AI-anbefalinger, og med over 700 millioner ukentlige ChatGPT-brukere kan en enkelt unøyaktig uttalelse påvirke titalls millioner potensielle kunder og direkte påvirke kjøpsbeslutninger.

Bruk spesialiserte AI-overvåkingsverktøy som AmICited.com, Authoritas eller Profound for å spore hvordan AI-systemer refererer til din merkevare på ChatGPT, Perplexity, Google AI Overviews og Gemini. Disse verktøyene tilbyr sentimentanalyse, sitatsporing og konkurrentbenchmarking for å identifisere unøyaktigheter, negative fremstillinger og manglende omtaler.

Vanlige tvister inkluderer faktiske feil (feil prising, stiftelsesdatoer, produktegenskaper), feilaktig tilskrevet informasjon, favorisering av konkurrenter i anbefalinger, forsterkning av negativt sentiment, manglende omtale av merkevaren i relevante kategorier, og skadelige assosiasjoner med uvedkommende eller kontroversielle temaer.

Effektiv løsning kombinerer flere strategier: direkte kontakt med AI-selskaper med dokumentert bevis, lage nøyaktig og omfattende innhold på nettsiden, utvikle sammenligningssider og FAQ-seksjoner, PR og medieomtale for å påvirke kildemateriale, og bygge merkevareautoritet gjennom tredjepartsanmeldelser og omtaler på plattformer med høy autoritet.

AI-systemer produserer unøyaktig innhold på grunn av hallusinasjoner (genererer plausibel, men feil informasjon), begrensninger i treningsdata (utdatert informasjon), feil i Retrieval Augmented Generation (feiltolking av nettsider), og skjevhet i kildevalg (overvekting av enkelte nettsteder og ignorering av andre).

Ledende plattformer inkluderer AmICited.com (spesialisert AI-merkevareovervåking), Authoritas (tilpassbar sporing av prompt med statistisk sikkerhet), Profound (overvåking i stor skala daglig), Ahrefs Brand Radar (AI-omtaler med synlighet i søk), Otterly (rimelig ukentlig overvåking) og Peec.ai (midt-nivåløsninger med konkurrentbenchmarking).

Tidslinjer for løsning varierer betydelig. Direkte korrigeringer på din nettside kan påvirke AI-responser i løpet av noen uker etter hvert som modellene oppdateres. Direkte kontakt med AI-selskaper kan ta 1–3 måneder. Å bygge autoritet gjennom tredjepartsinnhold og PR-arbeid krever vanligvis 2–6 måneder for å vise målbar effekt på AI-anbefalinger.

Oppdag hvordan AmICited hjelper merkevarer å spore og administrere sin tilstedeværelse på ChatGPT, Perplexity, Google AI Overviews og andre AI-plattformer. Få varsler i sanntid når AI-systemer feiltolker din merkevare og ta grep for å beskytte ditt omdømme.

Lær hvordan du bestrider unøyaktig AI-informasjon, rapporterer feil til ChatGPT og Perplexity, og implementerer strategier for å sikre at merkevaren din represe...

Lær effektive strategier for å identifisere, overvåke og rette opp unøyaktig informasjon om merkevaren din i AI-genererte svar fra ChatGPT, Perplexity og andre ...

Lær hva AI-innholdsattribusjon er, hvordan forskjellige plattformer siterer kilder, hvorfor det er viktig for merkevaresynlighet, og hvordan du kan optimalisere...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.