Finjustering

Definisjon av finjustering: tilpasse forhåndstrente AI-modeller for spesifikke oppgaver gjennom domenespesifikk trening. Lær hvordan finjustering forbedrer mode...

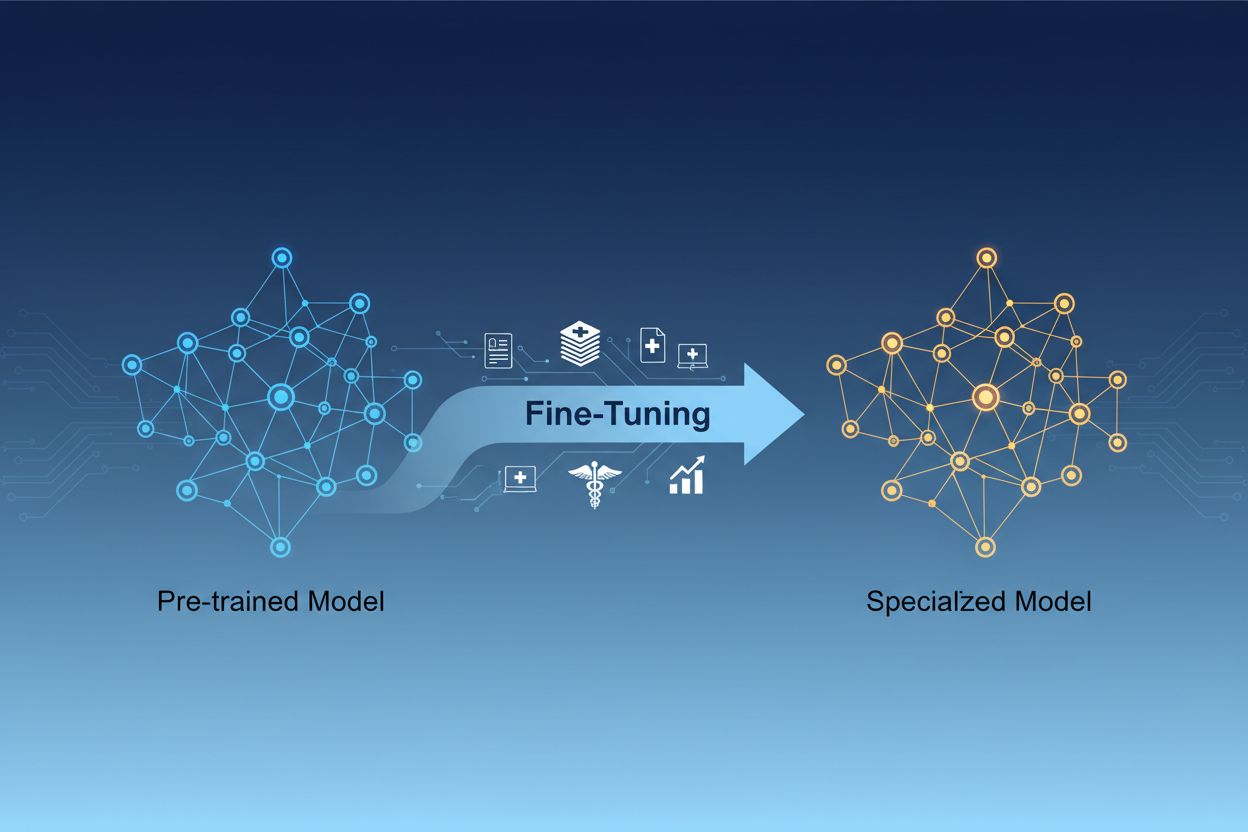

Finjustering av AI-modell er prosessen med å tilpasse forhåndstrente kunstig intelligens-modeller til å utføre spesifikke oppgaver eller arbeide med spesialiserte data ved å justere parameterne gjennom ytterligere trening på domene-spesifikke datasett. Denne tilnærmingen utnytter eksisterende grunnleggende kunnskap samtidig som modellene skreddersys for bestemte forretningsapplikasjoner, og muliggjør at organisasjoner kan lage høyt spesialiserte AI-systemer uten de store beregningskostnadene ved å trene fra bunnen av.

Finjustering av AI-modell er prosessen med å tilpasse forhåndstrente kunstig intelligens-modeller til å utføre spesifikke oppgaver eller arbeide med spesialiserte data ved å justere parameterne gjennom ytterligere trening på domene-spesifikke datasett. Denne tilnærmingen utnytter eksisterende grunnleggende kunnskap samtidig som modellene skreddersys for bestemte forretningsapplikasjoner, og muliggjør at organisasjoner kan lage høyt spesialiserte AI-systemer uten de store beregningskostnadene ved å trene fra bunnen av.

Finjustering av AI-modell er prosessen med å ta en forhåndstrent kunstig intelligens-modell og tilpasse den til å utføre spesifikke oppgaver eller arbeide med spesialiserte data. I stedet for å trene en modell fra bunnen av, utnytter finjustering den grunnleggende kunnskapen som allerede er innebygd i en forhåndstrent modell og justerer dens parametere gjennom ytterligere trening på domene- eller oppgavespesifikke datasett. Denne tilnærmingen kombinerer effektiviteten til transfer learning med den nødvendige tilpasningen for bestemte forretningsapplikasjoner. Finjustering gjør det mulig for organisasjoner å lage høyt spesialiserte AI-modeller uten de store beregningskostnadene og tidsbruken ved å trene fra grunnen av, og er derfor en essensiell teknikk i moderne maskinlæringsutvikling.

Forskjellen mellom finjustering og trening fra bunnen av representerer et av de viktigste valgene i maskinlæringsutvikling. Når du trener en modell fra bunnen av, starter du med tilfeldig initierte vekter og må lære modellen alt om språkstrukturer, visuelle egenskaper eller domene-spesifikk kunnskap ved hjelp av massive datasett og betydelige beregningsressurser. Denne tilnærmingen kan kreve uker eller måneder med treningstid og tilgang til spesialisert maskinvare som GPU-er eller TPU-er. Finjustering starter derimot med en modell som allerede forstår grunnleggende mønstre og konsepter, og krever bare en brøkdel av dataene og beregningskraften for å tilpasse den til dine spesifikke behov. Den forhåndstrente modellen har allerede lært generelle egenskaper under den innledende treningsfasen, så finjustering fokuserer på å justere disse til å matche din brukssituasjon. Denne effektivitetsgevinsten gjør finjustering til den foretrukne tilnærmingen for de fleste organisasjoner, siden det reduserer både tiden til markedet og infrastrukturkostnadene, samtidig som man ofte oppnår bedre ytelse enn å trene mindre modeller fra bunnen av.

| Aspekt | Finjustering | Trening fra bunnen av |

|---|---|---|

| Treningstid | Dager til uker | Uker til måneder |

| Datakrav | Tusenvis til millioner av eksempler | Millioner til milliarder av eksempler |

| Beregningkostnad | Moderat (ofte nok med én GPU) | Ekstremt høy (flere GPU-er/TPU-er nødvendig) |

| Startkunnskap | Utnytter forhåndstrente vekter | Starter med tilfeldig initiering |

| Ytelse | Ofte best med lite data | Bedre med enorme datasett |

| Krav til kompetanse | Middels | Avansert |

| Tilpasningsgrad | Høy for spesifikke oppgaver | Maksimal fleksibilitet |

| Infrastruktur | Standard skyressurser | Spesialiserte maskinvareklynger |

Finjustering har blitt en kritisk kapasitet for organisasjoner som ønsker å implementere AI-løsninger som gir konkurransefortrinn. Ved å tilpasse forhåndstrente modeller til din spesifikke forretningskontekst, kan du skape AI-systemer som forstår bransjeterminologi, kundepreferanser og operative krav med imponerende nøyaktighet. Denne skreddersømmen gjør det mulig å oppnå ytelsesnivåer som generiske standardmodeller rett og slett ikke kan matche, spesielt i spesialiserte domener som helse, juridiske tjenester eller teknisk support. Kostnadseffektiviteten i finjustering innebærer at selv mindre organisasjoner nå kan få tilgang til AI på bedriftsnivå uten enorme infrastrukturinvesteringer. I tillegg kan finjusterte modeller rulles ut raskere, slik at selskaper kan reagere hurtig på markedsmuligheter og konkurransepress. Evnen til å kontinuerlig forbedre modeller ved å finjustere dem med nye data, sikrer at AI-systemene dine forblir relevante og effektive etter hvert som forretningsforholdene endres.

Viktige forretningsfordeler med finjustering inkluderer:

Flere etablerte teknikker har utkrystallisert seg som beste praksis innen finjustering, hver med særegne fordeler avhengig av dine behov. Full finjustering innebærer å oppdatere alle parametere i den forhåndstrente modellen, noe som gir maksimal fleksibilitet og ofte best ytelse, men krever betydelige beregningsressurser og større datasett for å unngå overtilpasning. Parametereffektive finjusteringsteknikker som LoRA (Low-Rank Adaptation) og QLoRA har revolusjonert feltet ved å muliggjøre effektiv modelltilpasning ved å oppdatere kun en liten brøkdel av parameterne, noe som dramatisk reduserer minnekrav og treningstid. Disse teknikkene fungerer ved å legge til trenbare lav-rang matriser til modellens vektmatriser, og fange opp oppgavespesifikke tilpasninger uten å endre de opprinnelige forhåndstrente vektene. Adaptermoduler er en annen tilnærming, der små trenbare nettverk settes inn mellom lagene i den fryste forhåndstrente modellen, slik at man kan finjustere effektivt med minimale ekstra parametere. Prompt-basert finjustering fokuserer på å optimalisere innspillsbeskjeder fremfor modellvekter, nyttig for modeller der parameter-tilgang er begrenset. Instruksjonsfinjustering trener modeller til å følge bestemte instruksjoner og kommandoer, spesielt viktig for store språkmodeller som må svare hensiktsmessig på ulike brukerforespørsler. Valget mellom disse teknikkene avhenger av dine beregningsmessige begrensninger, datasettstørrelse, ytelseskrav og hvilke modellarkitekturer du arbeider med.

Finjustering av store språkmodeller (LLMs) gir unike muligheter og utfordringer sammenlignet med finjustering av mindre modeller eller andre typer nevrale nettverk. Moderne LLM-er som GPT-lignende modeller inneholder milliarder av parametere, noe som gjør full finjustering beregningsmessig uoverkommelig for de fleste organisasjoner. Dette har ført til utbredt bruk av parametereffektive teknikker som gjør det mulig å tilpasse LLM-er effektivt uten behov for infrastruktur på bedriftsnivå. Instruksjonsfinjustering har blitt særlig viktig for LLM-er, der modellene trenes på eksempler med instruksjoner og tilhørende høykvalitets svar, slik at de følger brukerens retningslinjer mer effektivt. Forsterkende læring fra menneskelig tilbakemelding (RLHF) er en avansert finjusteringsteknikk der modellene videreutvikles basert på menneskelige preferanser og evalueringer, noe som forbedrer samsvaret med menneskelige verdier og forventninger. Den relativt lille mengden oppgavespesifikke data som trengs for å finjustere LLM-er—ofte bare hundrevis eller tusenvis av eksempler—gjør dette tilgjengelig for organisasjoner uten enorme merkede datasett. Likevel krever finjustering av LLM-er nøye oppsett av hyperparametre, innstilling av læringsrate og forebygging av katastrofal glemsel, hvor modellen mister tidligere innlærte evner under tilpasningen til nye oppgaver.

Organisasjoner i ulike bransjer har funnet kraftfulle bruksområder for finjusterte AI-modeller som gir målbar forretningsverdi. Automatisering av kundeservice er et av de mest utbredte bruksområdene, der modeller finjusteres på bedriftsspesifikke supporthenvendelser, produktinformasjon og kommunikasjonsstiler for å lage chatboter som håndterer kundehenvendelser med domeneekspertise og merkevarekonsistens. Medisinsk og juridisk dokumentanalyse drar nytte av finjustering for å tilpasse generelle språkmodeller til å forstå spesialisert terminologi, regulatoriske krav og bransjespesifikke formater, noe som muliggjør nøyaktig informasjonsuttrekk og klassifisering. Sentimentanalyse og innholdsmoderering kan forbedres betydelig ved å finjustere modeller på eksempler fra din bransje eller ditt fellesskap, slik at de fanger opp nyanserte språk- og kontekstmønstre som generiske modeller overser. Kodegenerering og programvareutviklingsassistanse drar nytte av finjustering basert på organisasjonens egen kodebase, programmeringskonvensjoner og arkitektur, slik at AI-verktøy genererer kode i samsvar med deres standarder. Anbefalingssystemer finjusteres ofte på brukeradferdsdata og produktkataloger for å levere personlige forslag som øker engasjement og inntekter. Navngitt enhetsgjenkjenning og informasjonsuttrekk fra domene-spesifikke dokumenter—som finansrapporter, vitenskapelige artikler eller tekniske spesifikasjoner—kan forbedres dramatisk gjennom finjustering på relevante eksempler. Disse ulike bruksområdene viser at finjustering ikke er begrenset til én bransje eller ett formål, men er en grunnleggende kapasitet for å lage AI-systemer som gir konkurransefortrinn på tvers av nær sagt alle forretningsområder.

Finjusteringsprosessen følger en strukturert arbeidsflyt som begynner med nøye forberedelse og strekker seg til utrulling og overvåking. Datapreparering er det kritiske første trinnet, hvor du samler inn, vasker og formaterer ditt domene-spesifikke datasett slik at det matcher inn- og utdata-strukturen forventet av den forhåndstrente modellen. Dette datasettet bør være representativt for de oppgavene den finjusterte modellen skal utføre i produksjon, og kvalitet er viktigere enn kvantitet—et mindre datasett av høy kvalitet gir ofte bedre resultater enn et større datasett med inkonsekvente eller støyende etiketter. Trenings-, validerings- og testdeling sikrer at du kan evaluere modellens ytelse riktig, med typiske fordelinger på 70-80 % til trening, 10-15 % til validering og 10-15 % til testing. Valg av hyperparametre innebærer å velge læringsrater, batch-størrelser, antall treningsrunder og andre parametere som styrer finjusteringen; disse valgene har stor innvirkning på ytelse og treningseffektivitet. Modellinitiering bruker de forhåndstrente vektene som utgangspunkt, og bevarer grunnkunnskapen samtidig som parameterne tilpasses din oppgave. Treningsgjennomføring innebærer iterativ oppdatering av modellparametere på treningsdataene dine mens valideringsytelsen overvåkes for å oppdage overtilpasning. Evaluering og iterasjon bruker testsettet til å vurdere endelig ytelse og avgjøre om ytterligere finjustering, andre hyperparametre eller mer treningsdata vil forbedre resultatene. Forberedelse til utrulling inkluderer å optimalisere modellen for inferenshastighet og ressursbruk, for eksempel gjennom kvantisering eller destillasjon. Til slutt sørger overvåking og vedlikehold i produksjon for at modellen fortsetter å prestere godt etter hvert som datagrunnlaget endres, med periodisk nytrening på ferske data for å opprettholde nøyaktigheten.

Selv om finjustering er mer effektivt enn å trene fra bunnen av, byr det på egne utfordringer som utøvere må håndtere nøye. Overtilpasning oppstår når modeller memorerer treningsdata i stedet for å lære generaliserbare mønstre, noe som særlig er en risiko ved små datasett; dette kan motvirkes med teknikker som tidlig stopp, regularisering og dataforstørrelse. Katastrofal glemsel skjer når finjustering fører til at modellen mister tidligere tillærte evner, spesielt problematisk når man tilpasser generelle modeller til nisjeoppgaver; nøye valg av læringsrate og teknikker som kunnskapsdestillasjon bidrar til å bevare grunnkunnskapen. Datakvalitet og merking utgjør betydelige praktiske utfordringer, da finjustering krever høykvalitets merkede eksempler som nøyaktig representerer målområdet og brukstilfeller. Håndtering av beregningsressurser krever balansering av ytelsesforbedringer mot treningstid og infrastrukturkostnader, spesielt viktig ved store modeller. Hyperparametres følsomhet betyr at finjusteringsytelsen kan variere mye basert på læringsrate, batch-størrelse og andre innstillinger, og krever systematisk eksperimentering og validering.

Beste praksis for vellykket finjustering inkluderer:

Organisasjoner står ofte overfor et valg mellom tre komplementære tilnærminger for å tilpasse AI-modeller til spesifikke oppgaver: finjustering, Retrieval-Augmented Generation (RAG) og prompt engineering. Prompt engineering innebærer å utforme nøye formulerte instruksjoner og eksempler for å styre modellens atferd uten å endre selve modellen; dette er raskt og krever ingen trening, men har begrenset effekt for komplekse oppgaver og kan ikke lære modellene genuint ny informasjon. RAG supplerer modellens svar med relevante dokumenter eller data fra eksterne kilder før svargenerering, noe som gjør det mulig for modeller å få tilgang til oppdatert informasjon og domene-spesifikk kunnskap uten parameteroppdateringer; dette fungerer godt for kunnskapsintensive oppgaver, men øker latenstid og kompleksitet i bruk. Finjustering endrer modellparametrene for å innlemme oppgavespesifikk kunnskap og mønstre, og gir best ytelse for klart definerte oppgaver med tilstrekkelig treningsdata, men krever mer tid og beregningsressurser enn de andre tilnærmingene. Den optimale løsningen innebærer ofte å kombinere disse teknikkene: bruke prompt engineering for rask prototyping, RAG for kunnskapsintensive applikasjoner, og finjustering for ytelseskritiske systemer der investeringen i trening er berettiget. Finjustering utmerker seg når du trenger konsekvent og høy ytelse på spesifikke oppgaver, har tilstrekkelig treningsdata, og når ytelsesgevinsten rettferdiggjør utviklingsinnsatsen. RAG passer best til applikasjoner som krever tilgang til oppdatert eller proprietær informasjon som endres ofte. Prompt engineering er et utmerket utgangspunkt for utforskning og prototyping før man forplikter seg til mer ressurskrevende tilnærminger. Å forstå styrkene og begrensningene ved hver metode gjør det mulig for organisasjoner å ta informerte valg om hvilke teknikker de skal bruke for ulike deler av sine AI-systemer.

Transfer learning er det bredere konseptet med å utnytte kunnskap fra én oppgave for å forbedre ytelsen på en annen oppgave, mens finjustering er en spesifikk implementering av transfer learning. Finjustering tar en forhåndstrent modell og justerer dens parametere på nye data, mens transfer learning også kan inkludere feature extraction hvor du fryser de forhåndstrente vektene og kun trener nye lag. All finjustering innebærer transfer learning, men ikke all transfer learning krever finjustering.

Finjusteringstiden varierer betydelig basert på modellstørrelse, datasettstørrelse og tilgjengelig maskinvare. Ved bruk av parametereffektive teknikker som LoRA kan en modell med 13 milliarder parametere finjusteres på omtrent 5 timer på et enkelt A100 GPU. Mindre modeller eller parametereffektive metoder kan ta bare noen timer, mens full finjustering av større modeller kan ta dager eller uker. Hovedfordelen er at finjustering er dramatisk raskere enn å trene fra bunnen av, noe som kan ta måneder.

Ja, finjustering er spesielt utviklet for å fungere effektivt med begrensede data. Forhåndstrente modeller har allerede lært generelle mønstre, så du trenger vanligvis bare hundrevis til tusenvis av eksempler for effektiv finjustering, sammenlignet med millioner som kreves for trening fra bunnen av. Men datakvalitet er viktigere enn mengde—et mindre datasett med høy kvalitet og representative eksempler vil gi bedre resultater enn et større datasett med inkonsekvente eller støyende etiketter.

LoRA (Low-Rank Adaptation) er en parametereffektiv finjusteringsteknikk som legger til trenbare lav-rang matriser til en modells vektmatriser i stedet for å oppdatere alle parametere. Denne tilnærmingen reduserer antall trenbare parametere med tusenvis av ganger samtidig som den opprettholder sammenlignbar ytelse med full finjustering. LoRA er viktig fordi det gjør finjustering tilgjengelig på standard maskinvare, reduserer minnekrav dramatisk, og gjør det mulig for organisasjoner å finjustere store modeller uten kostbar infrastruktur.

Overtilpasning oppstår når trenings-tapet synker, men valideringstapet øker, noe som indikerer at modellen memorerer treningsdata i stedet for å lære generaliserbare mønstre. Overvåk begge metrikker under trening—hvis valideringsytelsen flater ut eller forverres mens treningsytelsen fortsetter å forbedres, overtilpasser sannsynligvis modellen. Implementer tidlig stopp for å avslutte treningen når valideringsytelsen slutter å forbedre seg, og bruk teknikker som regularisering og dataforstørrelse for å forhindre overtilpasning.

Kostnader ved finjustering inkluderer beregningsressurser (GPU/TPU-tid), datapreparering og merking, modell-lagring og distribusjonsinfrastruktur, samt kontinuerlig overvåking og vedlikehold. Likevel er disse kostnadene vanligvis 10-100 ganger lavere enn trening fra bunnen av. Ved bruk av parametereffektive teknikker som LoRA kan beregningskostnadene reduseres med 80-90% sammenlignet med full finjustering, noe som gjør finjustering til en økonomisk tilnærming for de fleste organisasjoner.

Ja, finjustering forbedrer vanligvis modellens nøyaktighet betydelig for spesifikke oppgaver. Ved å trene på domene-spesifikke data lærer modeller oppgaverelevante mønstre og terminologi som generiske modeller går glipp av. Studier viser at finjustering kan forbedre nøyaktigheten med 10-30% eller mer avhengig av oppgaven og datasettkvaliteten. Forbedringen er mest dramatisk når finjusteringsoppgaven skiller seg fra forhåndstreningsoppgaven, ettersom modellen tilpasser de lærte egenskapene til dine spesifikke krav.

Finjustering gjør det mulig for organisasjoner å beholde sensitive data på egen infrastruktur i stedet for å sende det til tredjeparts-API-er. Du kan finjustere modeller lokalt på proprietære eller regulerte data uten å eksponere dem for eksterne tjenester, og dermed sikre etterlevelse av datavernregler som GDPR, HIPAA eller bransjespesifikke krav. Denne tilnærmingen gir både sikkerhets- og etterlevelsesfordeler, samtidig som ytelsesfordelene ved å bruke forhåndstrente modeller opprettholdes.

Følg med på hvordan AI-systemer som GPT-er, Perplexity og Google AI Overviews siterer og refererer til merkevaren din med AmICiteds AI-overvåkningsplattform.

Definisjon av finjustering: tilpasse forhåndstrente AI-modeller for spesifikke oppgaver gjennom domenespesifikk trening. Lær hvordan finjustering forbedrer mode...

Modellparametere er lærbare variabler i AI-modeller som avgjør atferd. Forstå vekter, bias og hvordan parametere påvirker ytelse og trening av AI-modeller.

Oppdag sanntids AI-tilpasning – teknologien som gjør det mulig for AI-systemer å kontinuerlig lære av nåværende hendelser og data. Utforsk hvordan adaptiv AI fu...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.