Hvordan AI-søkemotorer fungerer: Arkitektur, gjenfinning og generering

Lær hvordan AI-søkemotorer som ChatGPT, Perplexity og Google AI Overviews fungerer. Oppdag LLM-er, RAG, semantisk søk og sanntids gjenfinningsmekanismer.

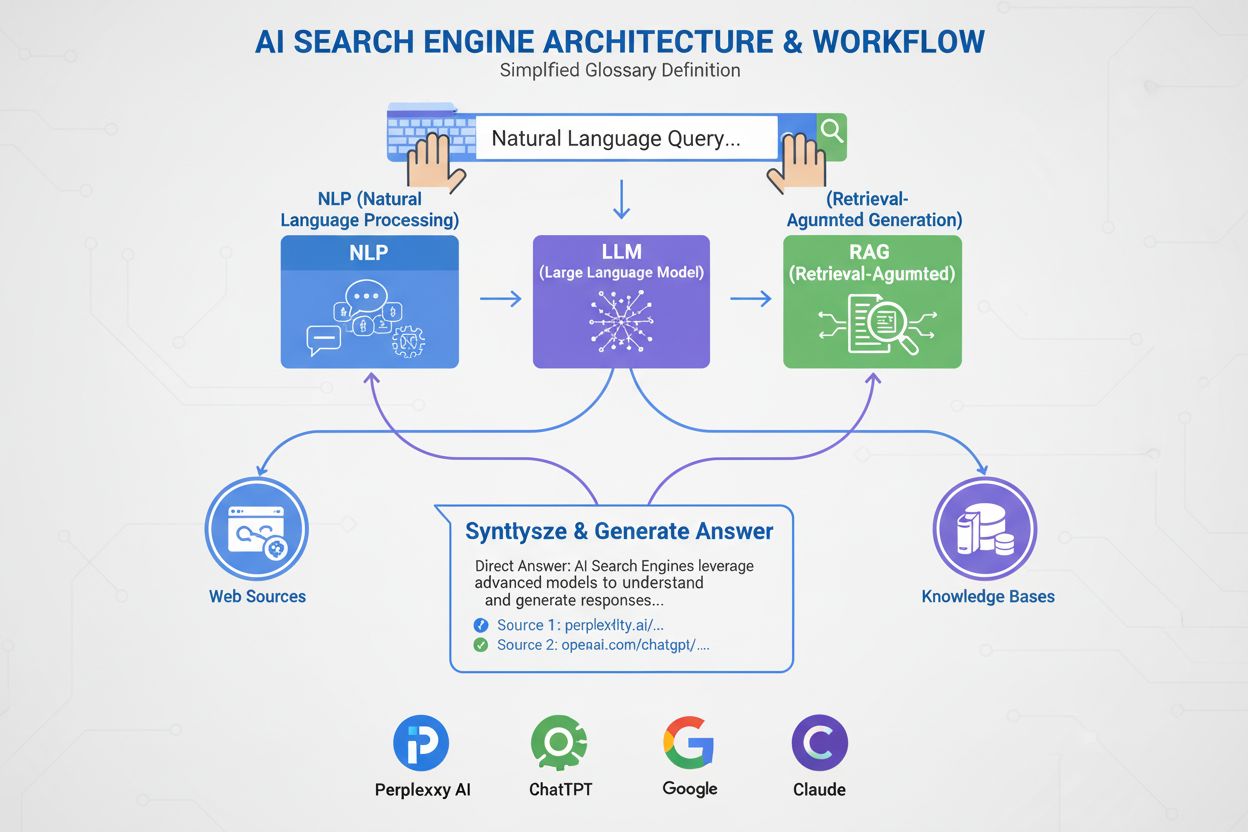

En AI-søkemotor er en plattform som bruker kunstig intelligens, naturlig språkprosessering og store språkmodeller for å tolke brukerforespørsler og generere direkte, samtalebaserte svar syntetisert fra nettbaserte kilder, i stedet for å vise tradisjonelle lister med lenker. Disse plattformene benytter retrieval-augmented generation (RAG) for å levere oppdatert, oppgitt informasjon med sanntidstilgang til nettet.

En AI-søkemotor er en plattform som bruker kunstig intelligens, naturlig språkprosessering og store språkmodeller for å tolke brukerforespørsler og generere direkte, samtalebaserte svar syntetisert fra nettbaserte kilder, i stedet for å vise tradisjonelle lister med lenker. Disse plattformene benytter retrieval-augmented generation (RAG) for å levere oppdatert, oppgitt informasjon med sanntidstilgang til nettet.

En AI-søkemotor er en plattform som bruker kunstig intelligens, naturlig språkprosessering (NLP) og store språkmodeller (LLM-er) for å tolke brukerforespørsler og generere direkte, samtalebaserte svar syntetisert fra nettbaserte kilder. I motsetning til tradisjonelle søkemotorer som viser lister med lenker, gir AI-søkemotorer konsise, lettfattelige sammendrag som direkte adresserer brukerintensjonen. Disse plattformene benytter retrieval-augmented generation (RAG) for å kombinere sanntidshenting fra nettet med generativ AI-syntese, noe som gjør dem i stand til å levere oppdatert, oppgitt informasjon. AI-søkemotorer representerer et grunnleggende skifte i hvordan folk oppdager informasjon på nettet, fra nøkkelordbaserte lenkelister til semantisk forståelse og direkte svar. Teknologien bak disse systemene integrerer flere AI-disipliner—inkludert semantisk søk, entitetsgjenkjenning og samtale-AI—for å skape en mer intuitiv og effektiv søkeopplevelse.

Fremveksten av AI-søkemotorer markerer en betydelig utvikling innen informasjonshenting. I flere tiår har søkemotorer operert etter et nøkkelordbasert paradigme, der relevans ble bestemt av tilstedeværelse og hyppighet av søketermer i indekserte dokumenter. Imidlertid har fremveksten av store språkmodeller og fremskritt innen naturlig språkforståelse fundamentalt endret mulighetene. Det globale markedet for AI-søkemotorer nådde 15,23 milliarder USD i 2024 og forventes å ha en årlig vekstrate (CAGR) på 16,8 % frem til 2032, ifølge markedsundersøkelser. Denne eksplosive veksten gjenspeiler både økt bruk i næringslivet og forbrukernes etterspørsel etter mer intelligente, samtalebaserte søk.

Generativ AI har endret måten folk oppdager informasjon på nettet, og flyttet søk bort fra den velkjente listen med blå lenker mot mer direkte, samtalebaserte svar. Bransjeledere som Google og Microsoft Bing har raskt integrert AI på tvers av sine plattformer for å holde tritt med nye aktører som Perplexity og You.com. Ifølge McKinsey har omtrent 50 % av Google-søk allerede AI-sammendrag, og dette tallet forventes å øke til mer enn 75 % innen 2028. Dette skiftet er mer enn bare en endring i brukergrensesnittet—det omdefinerer innholdsstrategi og søkemotoroptimalisering til en ny æra kalt “generative engine optimization” (GEO).

Overgangen gjenspeiler en bredere organisatorisk innføring av AI-teknologi. 78 % av organisasjoner rapporterte bruk av AI i 2024, opp fra 55 % året før, ifølge Stanford’s AI Index Report. For søke- og markedsføringsfolk betyr dette at synlighet nå avhenger av å forstå hvordan AI-systemer tolker, kondenserer og gjengir innhold til lettfattelige sammendrag. Utfordringen er at AI-genererte svar ofte leder trafikk bort fra de opprinnelige nettstedene, noe som gir både muligheter og utfordringer for innholdsprodusenter og merkevarer som ønsker synlighet i dette nye landskapet.

AI-søkemotorer opererer gjennom en sofistikert flertrinnspipeline som kombinerer henting, rangering og syntese. Prosessen starter med forespørselsforståelse, hvor systemet tolker brukerens input ved hjelp av naturlig språkprosessering for å trekke ut mening, intensjon og kontekst. I stedet for å behandle forespørselen som en enkel nøkkelordstreng, lager systemet flere representasjoner: en leksikalsk form for eksakt henting, en tett embedding for semantisk søk og en entitetsform for kunnskapsgrafmatching.

Når forespørselen er forstått, benytter de fleste AI-søkemotorer retrieval-augmented generation (RAG), et sentralt arkitekturmønster som adresserer de grunnleggende svakhetene ved store språkmodeller. RAG gjennomfører et direkte hentesteg, søker i nettindekser eller API-er for å trekke ut relevante dokumenter og avsnitt. Disse kandidatene blir deretter rangert på nytt med mer sofistikerte modeller som vurderer forespørsel og kandidat sammen for å produsere finjusterte relevanspoeng. De høyest rangerte resultatene mates inn i en stor språkmodell som kontekstramme, som så syntetiserer et samtalebasert svar og samtidig holder seg tro mot de hentede kildene.

Hybride hente-pipelines er standard på ledende plattformer. Disse kombinerer leksikalsk søk (nøkkelordbasert, med algoritmer som BM25) med semantisk søk (embedding-basert, med vektorsimilaritet). Leksikalsk søk er best på presisjon for eksakte treff, sjeldne termer og navn, mens semantisk søk er best på tilbakehenting for beslektet innhold. Ved å slå sammen begge tilnærminger og bruke cross-encoder-reranking, oppnår AI-søkemotorer høyere nøyaktighet enn noen metode alene. Den avsluttende syntesefasen bruker en stor språkmodell til å komponere et sammenhengende, menneskelignende svar som integrerer informasjon fra flere kilder, samtidig som det opprettholder nøyaktighet og gir henvisninger.

| Aspekt | Tradisjonelle søkemotorer | AI-søkemotorer |

|---|---|---|

| Resultatform | Lister med lenker og korte utdrag | Samtalebaserte sammendrag med direkte svar |

| Forespørselsprosessering | Nøkkelordmatching og rangering | Semantisk forståelse og intensjonsanalyse |

| Læringsmekanisme | Starter på nytt for hver forespørsel | Lærer kontinuerlig fra brukerinteraksjoner og tilbakemeldinger |

| Informasjonshenting | Leksikalsk/nøkkelordbasert matching | Hybrid (leksikalsk + semantisk + entitetsbasert) |

| Inputformater | Kun tekst | Tekst, bilder, tale og video (multimodal) |

| Sanntidsoppdateringer | Indeksbasert, periodisk crawling | Sanntidstilgang til nettet via RAG |

| Siteringsatferd | Ingen sitater; brukeren finner kilder selv | Integrerte henvisninger og kildeattribusjon |

| Brukerinteraksjon | Enkeltspørring, statiske resultater | Flertrinnssamtaler med oppfølgingsspørsmål |

| Bias-håndtering | Kuratorer organiserer informasjon | AI-syntese kan introdusere utviklerbias |

| Hallusinasjonsrisiko | Lav (lenker er faktiske) | Høyere (LLM-er kan generere feilinformasjon) |

Ulike AI-søkemotorer har distinkte arkitektoniske tilnærminger, hver med unike optimaliseringsimplikasjoner. Googles AI Overviews og AI Mode benytter en query fan-out-strategi, der én brukerforespørsel splittes i flere underforespørsler som retter seg mot ulike intensjonsdimensjoner. Disse underforespørslene kjøres parallelt mot ulike datakilder—nettindeks, Knowledge Graph, YouTube-transkripter, Google Shopping-feeder og spesialindekser. Resultatene aggregeres, dupliseres og rangeres før de syntetiseres til et sammendrag. For GEO-eksperter betyr dette at innholdet må dekke flere aspekter av en forespørsel på uttrekkbare måter for å slippe gjennom fan-out-prosessen.

Bing Copilot representerer en mer tradisjonell søkebasert tilnærming, der Microsofts modne Bing-rangeringsinfrastruktur brukes og GPT-klassifisert syntese legges på toppen. Plattformen bruker dobbeltløpet henting, som kombinerer BM25-leksikalsk søk med tett vektorbasert semantisk søk. Resultater passerer gjennom en kontekstuell cross-encoder-reranker som fokuserer på relevans på avsnittsnivå fremfor hele sider. Denne arkitekturen betyr at klassiske SEO-signaler—crawlingbarhet, kanoniske tagger, ren HTML, sidehastighet—fortsatt er svært viktige fordi de avgjør hvilke kandidater som når frem til grounding-settet. Bing Copilot legger også vekt på uttrekkbarhet: avsnitt med klar avgrensning, lister, tabeller og definisjonsbasert formulering blir oftere sitert.

Perplexity AI opererer med bevisst åpenhet, og viser kildene tydelig før det genererte svaret. Plattformen utfører sanntidssøk, ofte både i Google- og Bing-indekser, og vurderer deretter kandidater ut fra en blanding av leksikalsk og semantisk relevans, tematisk autoritet og svaruttrekkbarhet. Forskning på 59 ulike faktorer som påvirker Perplexitys rangeringsatferd viser at plattformen prioriterer direkte svarformatering—sider som eksplisitt gjentar forespørselen i en overskrift, etterfulgt av et kort, informasjonsrikt svar, er sterkt representert i siteringssettet. Entitetsfremtreden og lenking spiller også en stor rolle; Perplexity favoriserer avsnitt der nøkkelentiteter er tydelig navngitt og kontekstuelt koblet til relaterte konsepter.

ChatGPT Search tar en opportunistisk tilnærming, genererer søkespørsmål dynamisk og bruker Bings API for å hente spesifikke URL-er. I motsetning til plattformer med vedvarende indekser henter ChatGPT innhold i sanntid, noe som betyr at inkludering er avhengig av sanntids tilgjengelighet. Hvis et nettsted er blokkert av robots.txt, treigt å laste, skjult bak klientsiderendering eller semantisk uklart, vil det ikke bli brukt i syntesen. Denne arkitekturen prioriterer tilgjengelighet og klarhet: sider må være teknisk gjennomgangbare, lette og semantisk transparente slik at sanntidshenting gir ren, tolkbar tekst.

Naturlig språkprosessering (NLP) er den grunnleggende teknologien som gjør det mulig for AI-søkemotorer å gå utover nøkkelordmatching. NLP lar systemene tolke struktur, semantikk og intensjon bak søk, forstå kontekst og gjenkjenne synonymer og relaterte konsepter. Når en bruker spør “beste steder å spise i nærheten med uteservering”, forstår et NLP-drevet system at det søkes etter restauranter med uteplass, selv om de ordene ikke er brukt. Denne semantiske forståelsen gjør at AI-søkemotorer kan gi nyttige resultater selv når intensjonen er mindre åpenbar eller formulert samtalebasert.

Store språkmodeller (LLM-er) driver syntesefasen i AI-søkemotorer. Trenet på store mengder tekstdata forutsier LLM-er det mest logiske neste ordet basert på kontekst, noe som gjør dem i stand til å produsere sammenhengende, grammatisk korrekt tekst som ligner på menneskeskrevet innhold. LLM-er gir imidlertid også nye risikoer. De kan hallusinere—presentere feil som fakta—fordi de genererer tekst basert på sannsynlighetskunnskap og ikke alltid siterer sanntidskilder. Derfor er retrieval-augmented generation (RAG) kritisk: ved å forankre LLM-syntese i ferskt hentede, autoritative kilder, reduserer AI-søkemotorer hallusinasjonsrisikoen og forbedrer faktanøyaktigheten. Noen plattformer har innført linje-for-linje-artikkelhenvisninger for å motvirke hallusinasjon ytterligere, selv om de siterte artiklene ikke alltid er riktige og noen ganger ikke eksisterer.

AI-søkemotorer skiller seg fra tradisjonelle søkemotorer på flere grunnleggende måter. For det første gir de sammendrag i stedet for lenker. Vanlige søkemotorer viser resultater som lister med lenker og korte utdrag, mens AI-søkemotorer genererer korte sammendrag som svarer direkte på forespørsler, slik at brukerne slipper å bla og klikke seg gjennom flere nettsteder. For det andre lærer AI-søk over tid, mens tradisjonelt søk starter på nytt hver gang. AI-søkemotorer er laget for å lære kontinuerlig og tilpasse seg nye brukerinteraksjoner og data, og forbedrer ytelsen over tid. Tradisjonelle søkemotorer starter på nytt med hver nye forespørsel, uten å ta hensyn til tidligere søk eller brukerinteraksjoner.

For det tredje fokuserer AI-søk på semantikk, mens tradisjonelt søk fokuserer på nøkkelord. Vanlige søkemotorer er primært avhengige av nøkkelordmatching for å tolke forespørsler, mens AI-søkemotorer fokuserer på semantikk—den bredere meningen av ord i kontekst. Dette gjør at AI-søkemotorer bedre kan forstå brukerintensjon og levere resultater som i større grad samsvarer med det brukeren faktisk ønsker. For det fjerde aksepterer AI-søk flere inputformater, mens tradisjonelt søk kun aksepterer tekst. Noen AI-søkemotorer har multimodale funksjoner, noe som betyr at de kan behandle og forstå informasjon fra andre formater enn tekst, som bilder, video og lyd. Dette gir en mer intuitiv og fleksibel søkeopplevelse enn kun å skrive inn nøkkelord.

Fremveksten av AI-søkemotorer endrer hvordan merkevarer jobber med synlighet og innholdsstrategi. I stedet for å konkurrere kun om nøkkelordrangering, må utgivere og virksomheter nå ta høyde for hvordan AI-systemer tolker, kondenserer og gjengir innholdet deres til lettfattelige sammendrag. Dette skiftet har introdusert en ny æra med “generative engine optimization” (GEO), der målet ikke bare er å rangere, men å bli hentet, syntetisert og sitert av AI-systemer.

Forskning viser at selv GEO-ytelsen til bransjeledere kan ligge 20 til 50 prosent bak SEO, ifølge McKinsey-analyse. Dette gapet gjenspeiler den umodne tilstanden til GEO-strategier og kompleksiteten ved å optimalisere for flere AI-plattformer samtidig. For merkevarer er konsekvensene store: synlighet i AI-søk avhenger av at innholdet er søkbart (opptrer i søkeresultater), uttrekkbart (strukturert slik at AI-systemer lett kan tolke og sitere det) og tillitsvekkende (viser ekspertise, autoritet og troverdighet). Overvåkingsverktøy som AmICited sporer nå merkevaresynlighet på tvers av AI-plattformer—inkludert Perplexity, ChatGPT, Google AI Overviews og Claude—for å måle denne nye formen for synlighet og identifisere optimaliseringsmuligheter.

AI-søkelandskapet utvikler seg raskt, med betydelige konsekvenser for hvordan informasjon oppdages, distribueres og kommersialiseres. Det globale markedet for AI-søkemotorer forventes å vokse med 16,8 % CAGR frem til 2032, drevet av økt bruk i næringslivet og forbrukernes etterspørsel etter samtalebaserte, intelligente søkeopplevelser. Etter hvert som AI-søkemotorer modnes, forventes flere viktige trender å tre frem.

For det første vil konsolidering og spesialisering sannsynligvis akselerere. Selv om generelle plattformer som Google, Bing og Perplexity vil fortsette å dominere, vil spesialiserte AI-søkemotorer for bestemte vertikaler—jus, medisin, teknisk, e-handel—blomstre. Disse spesialiserte motorene vil tilby dypere domeneekspertise og mer presis syntese for nisjeforespørsler. For det andre vil siterings- og attribusjonsmekanismer bli mer sofistikerte og standardiserte. Etter hvert som regulatoriske krav øker og utgivere krever tydeligere attribusjon, vil AI-søkemotorer trolig innføre mer detaljerte siteringssystemer som gjør det enklere for brukere å spore påstander tilbake til kildene og for utgivere å måle synlighet.

For det tredje vil definisjonen og målingen av “synlighet” endres fundamentalt. I SEO-æraen betydde synlighet rangering og klikkrate. I GEO-æraen betyr synlighet å bli hentet, syntetisert og sitert—metrikker som krever nye målerammer og verktøy. AmICited og lignende plattformer leder an i dette måleområdet, ved å spore merkevaresynlighet på tvers av flere AI-plattformer og gi innsikt i hvor ofte og i hvilken kontekst merkevarer dukker opp i AI-genererte svar.

For det fjerde vil spenningen mellom AI-søk og tradisjonelt søk øke. Etter hvert som AI-søkemotorer kaprer mer brukeroppmerksomhet og trafikk, vil tradisjonelle søkemotorer føle presset for å utvikle seg eller risikere å bli irrelevante. Googles integrering av AI i sitt kjerneprodukt er et strategisk svar på denne trusselen, men den langsiktige vinneren er fortsatt usikker. Utgivere og merkevarer må optimalisere for både tradisjonelt og AI-søk samtidig, noe som gir en mer kompleks og ressurskrevende innholdsstrategi.

Til slutt vil tillit og nøyaktighet bli avgjørende. Når AI-søkemotorer blir primære informasjonskilder, øker kravene til nøyaktighet og bias-håndtering. Regulatoriske rammer rundt AI-gjennomsiktighet og ansvarlighet vil sannsynligvis dukke opp, som krever at AI-søkemotorer avslører treningsdata, rangeringsfaktorer og siteringsmetodikk. For merkevarer og utgivere betyr dette at E-E-A-T-signaler—ekspertise, erfaring, autoritet og troverdighet—blir enda viktigere for synlighet i både tradisjonelt og AI-basert søk.

+++ showCTA = true ctaHeading = “Overvåk merkevarens synlighet på tvers av AI-søkemotorer” ctaDescription = “Å forstå AI-søkemotorer er bare første steg. Spor hvor og hvordan merkevaren din vises i ChatGPT, Perplexity, Google AI Overviews og Claude med AmICiteds overvåkingsplattform for AI-søk. Mål GEO-ytelsen, identifiser siteringsmuligheter, og optimaliser innholdet ditt for neste generasjon søk.” ctaPrimaryText = “Kontakt oss” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Prøv nå” ctaSecondaryURL = “https://app.amicited.com ” +++

Tradisjonelle søkemotorer viser resultater som lister med lenker og utdrag, mens AI-søkemotorer genererer samtalebaserte sammendrag som gir direkte svar på forespørsler. AI-søkemotorer bruker naturlig språkprosessering og store språkmodeller for å forstå brukerintensjon semantisk, istedenfor å kun stole på nøkkelordmatching. De lærer kontinuerlig fra brukerinteraksjoner og kan behandle flere inputformater, inkludert tekst, bilder og tale. I tillegg gir AI-søkemotorer ofte sanntidstilgang til nettet gjennom retrieval-augmented generation (RAG), slik at de kan levere oppdatert informasjon med kildehenvisninger.

Retrieval-augmented generation (RAG) er en teknikk som gjør det mulig for store språkmodeller å hente og innlemme fersk informasjon fra eksterne kilder før de genererer svar. RAG adresserer de grunnleggende begrensningene til LLM-er—hallusinasjoner og kunnskapsavgrensninger—ved å forankre svarene i sanntidsdata. I AI-søkemotorer fungerer RAG ved først å gjennomføre et direkte søk eller hentesteg, hvor relevante dokumenter eller utdrag trekkes inn, før et svar syntetiseres basert på disse. Denne tilnærmingen sikrer at svarene både er oppdaterte og kan spores til spesifikke kilder, noe som gjør henvisninger mulig og forbedrer faktanøyaktigheten.

Ledende AI-søkemotorer inkluderer Perplexity (kjent for transparente kildehenvisninger), ChatGPT Search (drevet av GPT-4o med sanntidstilgang til nettet), Google Gemini og AI Overviews (integrert med Googles søkeinfrastruktur), Bing Copilot (bygget på Microsofts søkeindeks), og Claude (Anthropics modell med selektivt nettsøk). Perplexity prioriterer sanntidshenting og synlig kildeattribusjon, mens ChatGPT genererer søkespørsmål etter behov. Googles tilnærming bruker query fan-out for å dekke flere intensjonsdimensjoner, og Bing Copilot kombinerer tradisjonelle SEO-signaler med generativ syntese. Hver plattform har distinkte hentearkitekturer, siteringsatferd og optimaliseringskrav.

AI-søkemotorer følger en flertrinnsprosess: først tolker de brukerforespørselen ved hjelp av naturlig språkprosessering for å forstå intensjon; deretter henter de relevante dokumenter eller avsnitt fra nettindekser eller API-er ved hjelp av hybrid henting (kombinerer leksikalsk og semantisk søk); så rangeres kandidatene på nytt basert på relevans og hvor enkle de er å trekke ut; til slutt syntetiseres et samtalebasert svar med en stor språkmodell, der kildehenvisninger settes inn. Siteringsmekanismen varierer mellom plattformene—noen viser innebygde henvisninger, andre viser kildelister, og noen integrerer henvisninger i selve svaret. Kvaliteten og nøyaktigheten på henvisningene avhenger av hvor godt de hentede avsnittene stemmer overens med de syntetiserte påstandene.

Generative engine optimization (GEO) er praksisen med å optimalisere innhold og merkevaresynlighet spesifikt for AI-søkemotorer, i motsetning til tradisjonell SEO som fokuserer på nøkkelordrangering i lenkebaserte søkeresultater. GEO handler om å gjøre innhold søkbart, uttrekkbart og siterbart av AI-systemer. Viktige GEO-strategier inkluderer å strukturere innhold for tydelige og direkte svar, bruke naturlig språk som matcher brukerintensjon, implementere entitetsmerking og skjema, sikre raske innlastningstider og bygge tematisk autoritet. Som McKinsey viser, har omtrent 50 % av Google-søk allerede AI-sammendrag, og dette forventes å stige til over 75 % innen 2028, noe som gjør GEO stadig viktigere for merkevaresynlighet.

AI-søkemotorer kan både øke og redusere nettstedtrafikk, avhengig av hvordan innhold er optimalisert. Når innhold blir sitert i AI-genererte svar, får det synlighet og troverdighet, men brukere kan få svaret sitt direkte uten å klikke seg videre til kilden. Forskning viser at AI Overviews kan lede trafikk bort fra de opprinnelige nettstedene, selv om de også gir attribusjon og kildehenvisninger. For merkevarer betyr dette at synlighet nå avhenger av å bli hentet, syntetisert og sitert av AI-systemer—ikke bare rangert i tradisjonelle søkeresultater. Overvåkingsverktøy som AmICited sporer merkevernsomtaler på tvers av AI-plattformer (Perplexity, ChatGPT, Google AI Overviews, Claude) for å måle denne nye formen for synlighet og optimalisere deretter.

Naturlig språkprosessering (NLP) er grunnleggende for hvordan AI-søkemotorer forstår og behandler brukerforespørsler. NLP gjør det mulig for systemene å tolke struktur, semantikk og intensjon bak søk, i stedet for kun å matche nøkkelord. Det lar AI-søkemotorer forstå kontekst, avklare betydning og gjenkjenne synonymer og relaterte konsepter. NLP driver også syntesestadiet, der språkmodeller genererer grammatisk korrekte, sammenhengende svar som oppleves naturlige for brukeren. I tillegg hjelper NLP AI-søkemotorer med å trekke ut og strukturere informasjon fra nettsider, identifisere nøkkelentiteter, relasjoner og påstander som kan inkluderes i de genererte svarene.

AI-søkemotorer håndterer sanntidsinformasjon gjennom retrieval-augmented generation (RAG), som utfører direkte søk eller API-kall for å hente oppdatert data i øyeblikket, i stedet for bare å stole på treningsdata. Plattformene Perplexity og Googles AI Mode søker aktivt på nettet i sanntid for å sikre at svarene gjenspeiler den siste informasjonen. ChatGPT bruker Bings søke-API for å få tilgang til oppdatert nettinnhold når surfing er aktivert. Aktualitetssignaler inngår også i rangeringsalgoritmene—sider med nylige publiseringsdatoer og oppdatert innhold vektlegges mer for tidssensitive forespørsler. Noen AI-søkemotorer er imidlertid fortsatt delvis avhengige av treningsdata, som kan henge etter virkelige hendelser, og gjør sanntidshenting til en viktig differensiator mellom plattformene.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hvordan AI-søkemotorer som ChatGPT, Perplexity og Google AI Overviews fungerer. Oppdag LLM-er, RAG, semantisk søk og sanntids gjenfinningsmekanismer.

Lær hvordan du sender inn og optimaliserer innholdet ditt for AI-søkemotorer som ChatGPT, Perplexity og Gemini. Oppdag indekseringsstrategier, tekniske krav og ...

Lær hvordan AI-motorer som ChatGPT, Perplexity og Gemini indekserer og prosesserer nettinnhold ved hjelp av avanserte crawlere, NLP og maskinlæring for å trene ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.