Hvordan konfigurere robots.txt for AI-crawlere: Komplett guide

Lær hvordan du konfigurerer robots.txt for å kontrollere AI-crawlers tilgang, inkludert GPTBot, ClaudeBot og Perplexity. Administrer synligheten til merkevaren ...

Konfigurasjon av robots.txt med brukeragent-regler som spesifikt retter seg mot AI-crawlere. AI-spesifikk robots.txt gir nettstedseiere mulighet til å kontrollere hvordan kunstige intelligens-systemer, store språkmodeller og AI-treningsroboter får tilgang til og bruker innholdet deres. Den skiller mellom ulike typer AI-crawlere—treningscrawlere, søkecrawlere og brukerutløste crawlere—og muliggjør detaljert kontroll over innholdets synlighet for AI-systemer. Denne konfigurasjonen har blitt kritisk ettersom AI-crawlere nå står for omtrent 80 % av bot-trafikken til mange nettsteder.

Konfigurasjon av robots.txt med brukeragent-regler som spesifikt retter seg mot AI-crawlere. AI-spesifikk robots.txt gir nettstedseiere mulighet til å kontrollere hvordan kunstige intelligens-systemer, store språkmodeller og AI-treningsroboter får tilgang til og bruker innholdet deres. Den skiller mellom ulike typer AI-crawlere—treningscrawlere, søkecrawlere og brukerutløste crawlere—og muliggjør detaljert kontroll over innholdets synlighet for AI-systemer. Denne konfigurasjonen har blitt kritisk ettersom AI-crawlere nå står for omtrent 80 % av bot-trafikken til mange nettsteder.

AI-spesifikk robots.txt-konfigurasjon viser til praksisen med å lage målrettede regler i robots.txt-filen din som spesifikt adresserer kunstig intelligens-crawlere og treningsroboter, adskilt fra tradisjonelle søkemotorcrawlere som Googlebot. Mens vanlig robots.txt tradisjonelt har fokusert på å håndtere Googlebot, Bingbot og andre søkeindekserere, har fremveksten av store språkmodeller og AI-treningssystemer skapt en helt ny kategori av bot-trafikk som krever egne strategier. Ifølge ferske data fra november 2025 står AI-crawlere nå for omtrent 80 % av all bot-trafikk til mange utgiver-nettsteder, noe som fundamentalt endrer rollen til robots.txt fra et nyttig SEO-verktøy til et kritisk innholdsbeskyttelsesverktøy. Skillet er viktig fordi AI-treningscrawlere opererer etter andre forretningsmodeller enn søkemotorer—de samler data for å trene proprietære modeller, ikke for å drive trafikk—slik at det tradisjonelle byttet mellom crawler-tilgang og søkesynlighet ikke lenger gjelder. For utgivere betyr dette at robots.txt-beslutninger nå direkte påvirker innholdets synlighet for AI-systemer, potensiell uautorisert bruk av proprietært innhold i treningsdatasett, og de totale trafikktallene og inntektene fra AI-oppdagelse.

AI-crawlere faller inn i tre distinkte operasjonelle kategorier, hver med ulike kjennetegn, trafikkpåvirkning og strategiske hensyn for utgivere. Treningscrawlere er laget for å samle inn store mengder tekstdata til utvikling av maskinlæringsmodeller; de opererer ofte med høye båndbreddekrav, gir stor belastning på servere og gir ingen henvisningstrafikk tilbake—eksempler er OpenAI sin GPTBot og Anthropics ClaudeBot. Søke- og siteringscrawlere fungerer på samme måte som tradisjonelle søkemotorer ved å indeksere innhold for gjenfinning og å gi attribusjon; de genererer moderat trafikk og kan gi henvisningstrafikk gjennom sitater og lenker—denne kategorien inkluderer OpenAI sin OAI-SearchBot og Googles AI Overviews-crawler. Brukerutløste crawlere opererer på forespørsel når sluttbrukere eksplisitt ber om AI-analyse av en nettside, som ChatGPT sin webleserfunksjon eller Claudes dokumentanalyse; disse gir lavere trafikk, men representerer direkte brukerengasjement med innholdet ditt. Kategoriseringen har stor strategisk betydning fordi treningscrawlere gir størst risiko for innholdsbeskyttelse og minst forretningsmessig gevinst, søkecrawlere gir et kompromiss med noe henvisningspotensial, og brukerutløste crawlere samsvarer ofte med brukerintensjon og kan øke innholdets synlighet.

| Crawlerkategori | Formål | Trafikkvolum | Henvisningspotensial | Innholdsrisiko | Eksempler |

|---|---|---|---|---|---|

| Trening | Modellutvikling | Svært høy | Ingen | Svært høy | GPTBot, ClaudeBot |

| Søk/Sitering | Innholdsindeksering & attribusjon | Moderat | Moderat | Moderat | OAI-SearchBot, Google AI |

| Brukerutløst | Analyse ved behov | Lav | Lav | Lav | ChatGPT Weblesing, Claude |

De største AI-selskapene som driver crawlere er OpenAI, Anthropic, Google, Meta, Apple og Amazon, hver med sine egne brukeragent-strenger som gjør det mulig å identifisere dem i serverlogger og robots.txt. OpenAI har flere crawlere: GPTBot (brukeragent: GPTBot/1.0) for innsamling til trening, OAI-SearchBot (brukeragent: OAI-SearchBot/1.0) for søk og sitering, og ChatGPT-User (brukeragent: ChatGPT-User/1.0) for brukerutløst weblesing. Anthropics hovedcrawler er ClaudeBot (brukeragent: Claude-Web/1.0 eller anthropic-ai) brukt til trening og kunnskapsbase. Google bruker Google-Extended (brukeragent: Google-Extended/1.1) for Gemini og andre AI-produkter, Meta bruker facebookexternalhit for innholdsanalyse, Apple har AppleBot for Siri og søkefunksjoner, og Amazon bruker Amazonbot for Alexa og søk. For å identifisere disse crawlerne i serverloggene dine, se på User-Agent-headeren i HTTP-forespørslene—de fleste legitime AI-crawlere inkluderer firmanavn og versjon i dette feltet. For økt sikkerhet kan du verifisere crawlerens legitimitet ved å sjekke IP-adressen mot publiserte IP-områder fra hvert selskap; OpenAI, Google og flere andre publiserer slike IP-lister, slik at du kan skille legitime crawlere fra forfalskede brukeragenter.

Grunnleggende syntaks for AI-spesifikke robots.txt-regler følger standard robots.txt-format med brukeragent-matching og allow/disallow-direktiver rettet mot spesifikke crawlere. For å blokkere OpenAIs GPTBot fra å samle treningsdata, men tillate deres søkecrawler, kan robots.txt utformes slik:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

For mer detaljert kontroll kan du bruke stispecifikke regler som blokkerer visse deler men tillater andre—f.eks. blokkere AI-crawlere fra å få tilgang til betalingsinnhold eller brukerinnhold:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Du kan gruppere flere brukeragenter under ett regelsett for å bruke samme restriksjoner på flere crawlere og forenkle konfigurasjonen. Testing og validering av robots.txt er kritisk; verktøy som Google Search Console sin robots.txt-tester og tredjeparts validatorer kan sjekke at reglene er syntaktisk riktige og blir tolket riktig av crawlere. Husk at robots.txt er rådgivende og ikke håndhevbar—etterrettelige crawlere vil respektere reglene, men ondsinnede eller ikke-kompatible crawlere kan ignorere dem, så sensitive deler bør sikres med ytterligere tiltak på servernivå.

Beslutningen om å blokkere eller tillate AI-crawlere innebærer grunnleggende avveininger mellom innholdsbeskyttelse og synlighet, som varierer sterkt med forretningsmodell og innholdsstrategi. Blokkering av treningscrawlere som GPTBot eliminerer risikoen for at innholdet ditt brukes til å trene AI-modeller uten kompensasjon, men betyr også at innholdet ditt ikke vil vises i AI-genererte svar, noe som kan redusere oppdagelse og trafikk fra AI-systemer. Å tillate treningscrawlere øker sjansen for at innholdet ditt blir brukt i AI-trening, ofte uten attribusjon eller kompensasjon, men kan øke synligheten hvis AI-systemene siterer eller refererer til deg. Den strategiske avgjørelsen bør ta hensyn til innholdets konkurransefortrinn—proprietær forskning, original analyse og unike data bør beskyttes strengt, mens åpent lærestoff eller generisk informasjon kan ha nytte av bredere AI-synlighet. Ulike utgivertyper har ulikt regnestykke: nyhetsorganisasjoner kan tillate søkecrawlere for siteringstrafikk, men blokkere treningscrawlere, mens utdanningsutgivere kan åpne bredere, og SaaS-selskaper ofte blokkerer alt for å beskytte dokumentasjon. Overvåk virkningen av blokkeringen gjennom serverlogger og analyse for å sikre at konfigurasjonen gir ønsket forretningsresultat.

Selv om robots.txt gir en tydelig måte å kommunisere crawler-policy på, er den i bunn og grunn rådgivende og ikke juridisk håndhevbar—etterrettelige crawlere respekterer reglene, men andre ignorerer dem og krever flere tekniske tiltak. IP-verifisering og hvitlisting er den mest pålitelige metoden; ved å bruke lister over legitime IP-adresser publisert av OpenAI, Google, Anthropic og andre kan du sjekke at forespørsler faktisk kommer fra deres infrastruktur. Brannmurregler og blokkering på servernivå gir sterkest håndheving, slik at forespørsler fra bestemte brukeragenter eller IP-områder kan avvises allerede på nettverksnivå. For Apache-servere kan .htaccess-konfigurasjon håndheve crawler-restriksjoner:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta-tagger i HTML-head gir detaljert, sidevis kontroll over crawler-tilgang uten å endre robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Regelmessig sjekk av serverlogger for crawleraktivitet lar deg identifisere nye crawlere, verifisere at reglene følges, og oppdage forfalskede brukeragenter. Verktøy som Knowatoa og Merkle gir automatisk validering og overvåking av robots.txt-konfigurasjonen og crawleradferd, slik at du ser hvilke crawlere som får tilgang og om de respekterer reglene dine.

Løpende vedlikehold av AI-spesifikk robots.txt er kritisk fordi AI-crawlerlandskapet utvikler seg raskt, med nye crawlere og endrede brukeragent-strenger og adferdsmønstre. Overvåkingsstrategien bør inkludere:

Den raske utviklingen av AI-crawlerteknologi betyr at en robots.txt-konfigurasjon som var korrekt for seks måneder siden, kanskje ikke dekker dagens behov eller trusselbilde, så jevnlig gjennomgang og tilpasning er nødvendig for effektiv innholdsbeskyttelse.

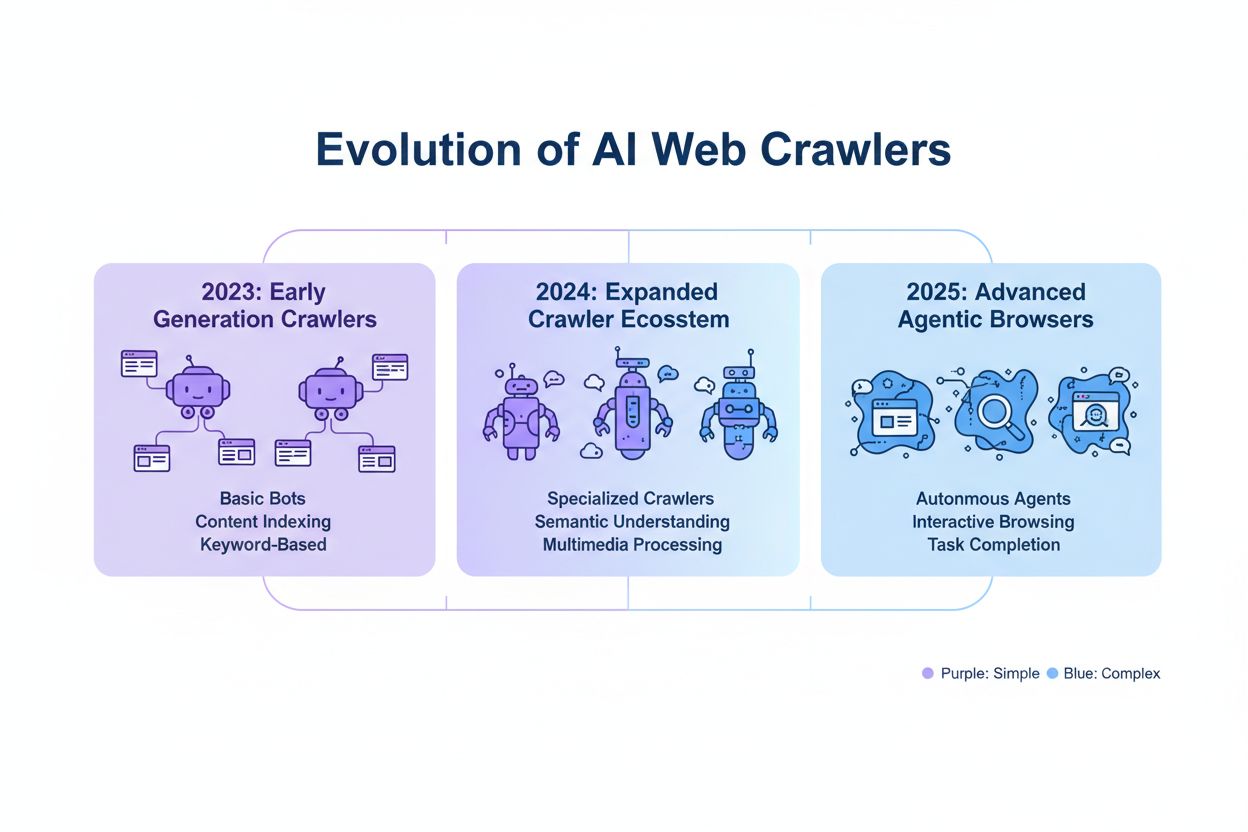

Neste generasjon AI-crawlere gir nye utfordringer som tradisjonell robots.txt kanskje ikke kan håndtere effektivt. Agentiske nettlesercrawlere som ChatGPT Atlas og Google Project Mariner fungerer som fullverdige nettlesere, kjører JavaScript, utfører brukerinteraksjoner og oppfører seg likt som ekte brukere—disse crawlerne kan unnlate å identifisere seg med egne brukeragent-strenger, slik at robots.txt-blokkering ikke virker. Mange nye crawlere tar i bruk vanlige Chrome-brukeragent-strenger for å unngå å bli detektert og blokkert, og skjuler dermed identiteten for å omgå robots.txt og andre kontroller. Dette fører til at IP-basert blokkering blir mer nødvendig, der utgivere må vedlikeholde hvitlister over legitime crawler-IP-adresser og blokkere all annen trafikk fra mistenkelige kilder—en overgang fra brukeragent-matching til nettverkskontroll. Forfalskede brukeragenter og omgåelsesteknikker blir mer vanlig, med aktører som utgir seg for å være legitime crawlere eller bruker generiske brukeragenter for å slippe gjennom. Fremtiden for AI-crawlerstyring vil antakelig kreve en flerlaget tilnærming med robots.txt, IP-verifisering, brannmurregler og kanskje atferdsanalyse for å skille legitime crawlere fra ondsinnede aktører. Det er viktig for utgivere å holde seg oppdatert om nye crawlerteknologier og delta i bransjediskusjoner om etikk og standarder for å opprettholde effektiv innholdsbeskyttelse.

Å implementere en effektiv AI-spesifikk robots.txt-konfigurasjon krever en helhetlig tilnærming som balanserer innholdsbeskyttelse med synlighetsmål. Start med en tydelig innholdsbeskyttelsespolicy som definerer hvilke innholdskategorier som skal blokkeres (proprietær forskning, premiuminnhold, brukergenerert innhold) versus hva som trygt kan eksponeres for AI-crawlere (offentlige artikler, utdanningsinnhold, generell informasjon). Bruk en lagdelt blokkeringsstrategi som skiller mellom treningscrawlere (som regel blokk), søkecrawlere (ofte tillat, med overvåking) og brukerutløste crawlere (vanligvis tillat), i stedet for en generell tillat/avvis-tilnærming mot alle AI-crawlere. Kombiner robots.txt med tiltak på servernivå som brannmurregler og IP-verifisering for det mest sensitive innholdet ditt, siden robots.txt alene ikke gir sterk nok beskyttelse. Integrer AI-crawlerstyring i din overordnede SEO- og innholdsstrategi og vurder hvordan blokkering påvirker synligheten i AI-genererte svar, sitater og AI-drevne søkefunksjoner—dette sikrer at robots.txt støtter dine forretningsmål. Etabler rutiner for overvåking og vedlikehold med ukentlige logg-gjennomganger, månedlig IP-verifisering og kvartalsvise revisjoner for å sikre at konfigurasjonen holder tritt med crawlerlandskapet. Bruk verktøy som AmICited.com for å overvåke innholdets synlighet i AI-systemer og forstå effekten av blokkeringene på AI-oppdagelse og sitering. For ulike utgivertyper: nyhetsmedier bør typisk tillate søkecrawlere og blokkere treningscrawlere for å maksimere siteringstrafikk; utdanningsutgivere kan vurdere bredere tilgang for økt rekkevidde; SaaS-selskaper bør ha streng blokkering av proprietær dokumentasjon. Når robots.txt-blokkering ikke strekker til grunnet forfalskede brukeragenter eller ikke-kompatible crawlere, bør du gå over til brannmurregler og IP-blokkering for å håndheve innholdsbeskyttelsen på nettverksnivå.

Treningscrawlere som GPTBot og ClaudeBot samler inn data til modellutvikling og gir ingen henvisningstrafikk, noe som gjør dem høyrisiko for innholdsbeskyttelse. Søkecrawlere som OAI-SearchBot og PerplexityBot indekserer innhold for AI-drevet søk og kan sende henvisningstrafikk gjennom sitater. De fleste utgivere blokkerer treningscrawlere, men tillater søkecrawlere for å balansere innholdsbeskyttelse og synlighet.

Google sier offisielt at blokkering av Google-Extended ikke påvirker søkerangeringer eller inkludering i AI Overviews. Noen nettredaktører har likevel meldt bekymringer, så overvåk søkeytelsen etter at du har implementert blokkering. AI Overviews i Google Søk følger vanlige Googlebot-regler, ikke Google-Extended.

Ja, robots.txt er rådgivende og ikke håndhevbar. Veloppdragne crawlere fra store selskaper respekterer vanligvis robots.txt-direktiver, men noen crawlere ignorerer dem. For sterkere beskyttelse, bruk blokkering på servernivå via .htaccess eller brannmurregler, og verifiser legitime crawlere med publiserte IP-adresseområder.

Gå gjennom og oppdater blokklisten din minst kvartalsvis. Nye AI-crawlere dukker opp jevnlig, så sjekk serverlogger månedlig for å identifisere nye crawlere som besøker nettstedet ditt. Følg med på fellesskapsressurser som ai.robots.txt GitHub-prosjektet for oppdateringer om nye crawlere og brukeragent-strenger.

Dette avhenger av dine forretningsprioriteringer. Blokkering av treningscrawlere beskytter innholdet ditt mot å bli brukt i AI-modeller uten kompensasjon. Blokkering av søkecrawlere kan redusere synligheten i AI-drevne oppdagelsesplattformer som ChatGPT-søk eller Perplexity. Mange utgivere velger selektiv blokkering rettet mot treningscrawlere, mens de tillater søke- og siteringscrawlere.

Sjekk serverloggene dine for crawler brukeragent-strenger, og verifiser at blokkerte crawlere ikke får tilgang til innholdssidene dine. Bruk analyseverktøy til å overvåke mønstre i bot-trafikk. Test konfigurasjonen din med Knowatoa AI Search Console eller Merkle robots.txt Tester for å validere at reglene fungerer som de skal.

Agentiske nettlesercrawlere som ChatGPT Atlas og Google Project Mariner fungerer som fullverdige nettlesere, ikke bare enkle HTTP-klienter. De bruker ofte standard Chrome brukeragent-strenger, noe som gjør dem vanskelige å skille fra vanlig nettlesertrafikk. IP-basert blokkering blir nødvendig for å kontrollere tilgangen til disse avanserte crawlerne.

AI-spesifikk robots.txt kontrollerer tilgangen til innholdet ditt, mens verktøy som AmICited overvåker hvordan AI-plattformer refererer og siterer innholdet ditt. Sammen gir de full oversikt og kontroll: robots.txt styrer crawler-tilgang, og overvåkingsverktøy følger opp innholdets påvirkning på tvers av AI-systemer.

AmICited sporer hvordan AI-systemer som ChatGPT, Claude, Perplexity og Google AI Overviews siterer og refererer til merkevaren din. Kombiner robots.txt-konfigurasjon med AI-synlighetsmonitorering for å forstå innholdets påvirkning på tvers av AI-plattformer.

Lær hvordan du konfigurerer robots.txt for å kontrollere AI-crawlers tilgang, inkludert GPTBot, ClaudeBot og Perplexity. Administrer synligheten til merkevaren ...

Lær hvordan Web Application Firewall gir avansert kontroll over AI-roboter utover robots.txt. Implementer WAF-regler for å beskytte innholdet ditt mot uautorise...

Lær hvilke AI-crawlere du bør tillate eller blokkere i robots.txt-filen din. Omfattende guide som dekker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.