Kontekstvindu

Kontekstvindu forklart: det maksimale antall tokens en LLM kan prosessere om gangen. Lær hvordan kontekstvinduer påvirker AI-nøyaktighet, hallusinasjoner og mer...

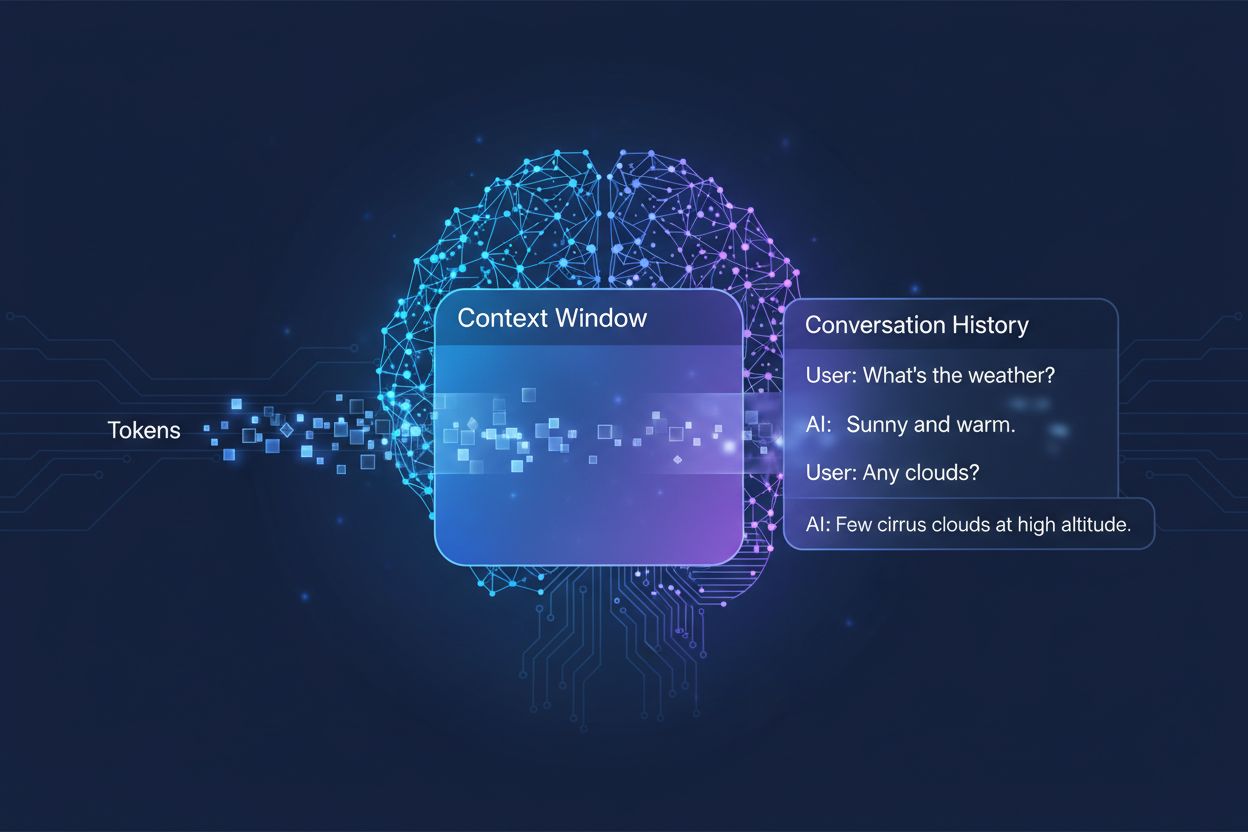

Mengden tidligere samtale et AI-system tar hensyn til når det genererer svar, målt i tokens. Det avgjør hvor mye tekst en AI kan behandle samtidig og påvirker direkte kvaliteten og sammenhengen i dens resultater i samtaler med flere utvekslinger.

Mengden tidligere samtale et AI-system tar hensyn til når det genererer svar, målt i tokens. Det avgjør hvor mye tekst en AI kan behandle samtidig og påvirker direkte kvaliteten og sammenhengen i dens resultater i samtaler med flere utvekslinger.

Et kontekstvindu er den maksimale mengden tekst en AI-språkmodell kan behandle og referere til om gangen under en samtale eller oppgave. Tenk på det som modellens arbeidsminne—akkurat som mennesker kun kan holde en begrenset mengde informasjon i umiddelbar bevissthet, kan AI-modeller bare “se” en viss mengde tekst før og etter sin nåværende posisjon. Denne kapasiteten måles i tokens, som er små tekstbiter som vanligvis representerer ord eller orddeler (i snitt tilsvarer ett engelsk ord omtrent 1,5 tokens). Å forstå modellens kontekstvindu er avgjørende fordi det direkte bestemmer hvor mye informasjon AI-en kan ta hensyn til når den genererer svar, og utgjør dermed en grunnleggende begrensning i hvor effektivt modellen kan håndtere komplekse samtaler med flere utvekslinger eller lange dokumenter.

Moderne språkmodeller, spesielt transformer-baserte arkitekturer, behandler tekst ved å konvertere den til tokens og analysere forholdet mellom alle tokens innenfor kontekstvinduet samtidig. Transformer-arkitekturen, introdusert i den banebrytende 2017-artikkelen “Attention is All You Need”, bruker en mekanisme kalt self-attention for å avgjøre hvilke deler av inputen som er mest relevante for hverandre. Denne oppmerksomhetsmekanismen lar modellen vekte viktigheten av ulike tokens opp mot hverandre, slik at den kan forstå kontekst og mening på tvers av hele vinduet. Denne prosessen blir imidlertid datakrevende når kontekstvinduet vokser, siden oppmerksomhetsmekanismen må beregne forholdet mellom hver token og alle andre tokens—et kvadratisk skaleringsproblem. Tabellen nedenfor viser hvordan ulike ledende AI-modeller sammenlignes når det gjelder kontekstvinduegenskaper:

| Modell | Kontekstvindu (tokens) | Lanseringsdato |

|---|---|---|

| GPT-4 | 128 000 | mars 2023 |

| Claude 3 Opus | 200 000 | mars 2024 |

| Gemini 1.5 Pro | 1 000 000 | mai 2024 |

| GPT-4 Turbo | 128 000 | november 2023 |

| Llama 2 | 4 096 | juli 2023 |

Disse ulike kapasitetene gjenspeiler forskjellige designvalg og datamessige avveininger gjort av hver organisasjon, der større vinduer muliggjør mer avanserte bruksområder, men krever mer prosessorkraft.

Utviklingen mot større kontekstvinduer er en av de viktigste fremskrittene innen AI de siste ti årene. Tidlige rekurrente nevrale nettverk (RNN) og long short-term memory (LSTM)-modeller slet med kontekst, fordi de behandlet tekst sekvensielt og hadde problemer med å huske informasjon fra fjerne deler av inputen. Gjennombruddet kom i 2017 med introduksjonen av Transformer-arkitekturen, som gjorde det mulig å behandle hele sekvenser parallelt og dramatisk forbedret modellens evne til å holde på kontekst over lengre tekster. Dette la grunnlaget for GPT-2 i 2019, som viste imponerende språkproduksjon med et kontekstvindu på 1 024 tokens, etterfulgt av GPT-3 i 2020 med 2 048 tokens, og til slutt GPT-4 i 2023 med 128 000 tokens. Hvert fremskritt var viktig fordi det utvidet mulighetene: større vinduer gjorde det mulig å håndtere lengre dokumenter, opprettholde sammenheng i samtaler med mange utvekslinger og forstå nyanserte relasjoner mellom fjerne konsepter i teksten. Den eksponentielle veksten i kontekstvindustørrelser skyldes både bedre arkitektoniske innovasjoner og økte datarressurser tilgjengelig for ledende AI-laboratorier.

Større kontekstvinduer utvider grunnleggende hva AI-modeller kan utrette, og muliggjør bruksområder som tidligere var umulige eller svært begrensede. Her er de viktigste fordelene:

Bedre samtalekontinuitet: Modeller kan opprettholde oversikt over hele samtalehistorikken, noe som reduserer behovet for å forklare konteksten på nytt og gir mer naturlige, sammenhengende samtaler som føles kontinuerlige i stedet for oppstykkede.

Dokumentbehandling i stor skala: Større vinduer gjør at AI kan analysere hele dokumenter, forskningsartikler eller kodebaser i ett gjennomløp, identifisere mønstre og relasjoner uten å miste informasjon fra tidligere seksjoner.

Forbedret resonnering og analyse: Med mer tilgjengelig kontekst kan modellene utføre mer avanserte resonnementer som krever forståelse av forhold mellom flere konsepter, noe som gjør dem mer effektive for forskning, analyse og komplekse problemløsninger.

Redusert kontekstbytte-overhead: Brukere slipper å oppsummere eller gjeninnføre informasjon gjentatte ganger; modellen kan referere til hele samtalehistorikken, noe som reduserer friksjon og øker effektiviteten i samarbeid.

Bedre håndtering av nyanserte oppgaver: Bruksområder som juridisk dokumentgjennomgang, medisinsk journalanalyse og kodegjennomgang drar stor nytte av muligheten til å ta hensyn til omfattende kontekst, noe som gir mer nøyaktige og grundige resultater.

Sømløse arbeidsflyter med flere dokumenter: Profesjonelle kan jobbe med flere relaterte dokumenter samtidig, slik at modellen kan kryssreferere informasjon og finne sammenhenger som ville vært umulig med mindre kontekstvindu.

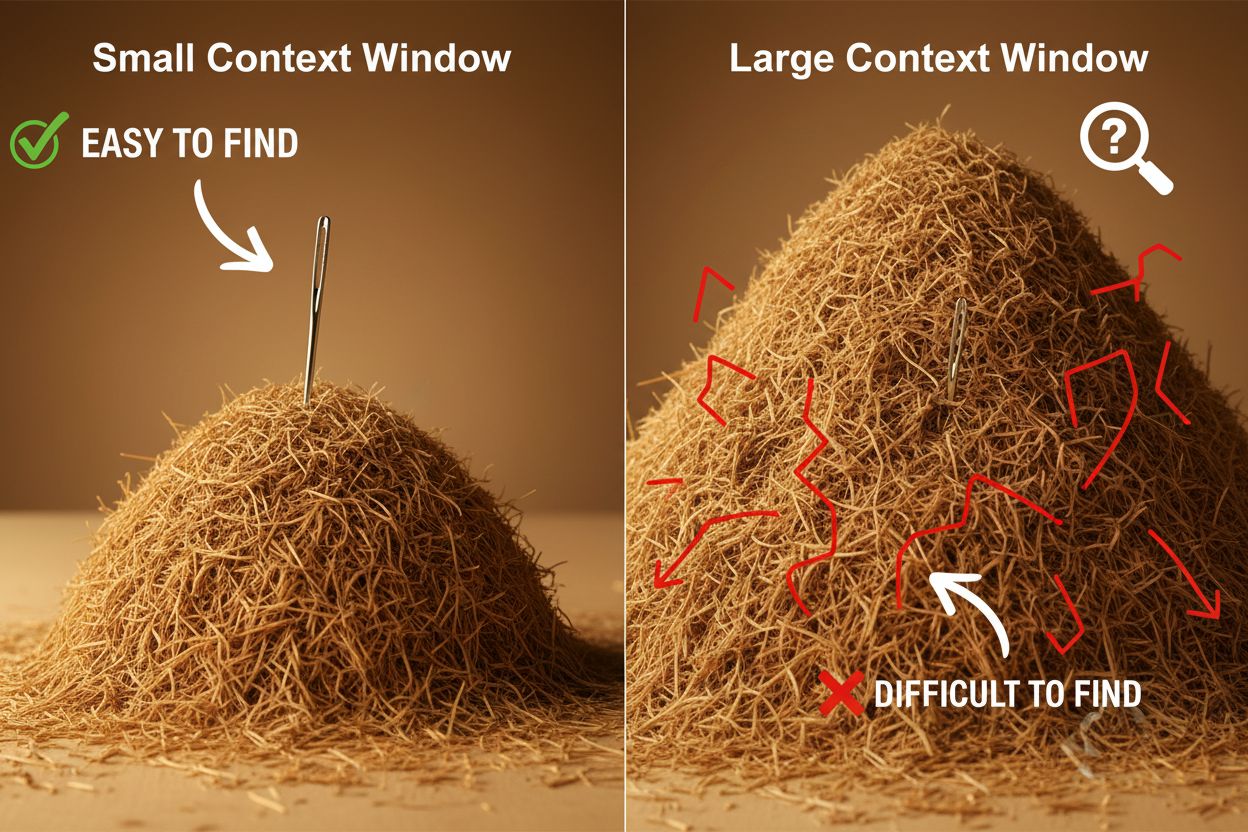

Til tross for fordelene gir store kontekstvinduer betydelige tekniske og praktiske utfordringer som utviklere og brukere må navigere nøye. Den mest åpenbare utfordringen er datakostnad: å behandle lengre sekvenser krever eksponentielt mer minne og prosessorkraft på grunn av den kvadratiske skaleringen til oppmerksomhetsmekanismen, noe som gjør store kontekstvinduer mye dyrere å kjøre. Dette økte datakravet gir også forsinkelsesproblemer, ettersom lengre kontekstvinduer betyr tregere svartider—en kritisk faktor for sanntidsapplikasjoner der brukere forventer raske svar. Et annet subtilt, men viktig problem er “nåla i høystakken”-fenomenet, der modeller sliter med å finne og bruke relevant informasjon når den er begravd i et svært stort kontekstvindu, og noen ganger presterer dårligere enn med mindre vinduer. I tillegg oppstår kontekstforvitring når informasjon fra begynnelsen av et langt kontekstvindu får mindre innflytelse på modellens utdata, fordi oppmerksomhetsmekanismen kan nedprioritere fjerne tokens til fordel for nyere. Disse utfordringene betyr at det ikke alltid er optimalt å maksimere størrelsen på kontekstvinduet for alle bruksområder.

Å forstå kontekstforvitring er avgjørende for å jobbe effektivt med store kontekstvinduer: når sekvensene blir lengre, får tokens i begynnelsen av konteksten gradvis mindre innflytelse på modellens utdata, slik at viktig informasjon i praksis kan “glemmes” selv om den teknisk sett er innenfor vinduet. Dette skjer fordi oppmerksomhetsbudsjettet—modellens evne til å gi meningsfull oppmerksomhet til alle tokens—blir strukket over et større tekstområde. Heldigvis har det dukket opp flere avanserte teknikker for å håndtere disse begrensningene. Retrieval-Augmented Generation (RAG) løser dette ved å lagre informasjon i eksterne databaser og hente kun de mest relevante delene ved behov, slik at modellen får en større effektiv kunnskapsbase uten å kreve et enormt kontekstvindu. Kontekstkomprimering-teknikker oppsummerer eller komprimerer mindre relevant informasjon, slik at de viktigste detaljene bevares og token-bruken reduseres. Strukturert notatteknikk oppmuntrer brukere til å organisere informasjon hierarkisk, slik at modellen lettere kan prioritere og finne nøkkelbegreper. Disse løsningene handler om å være strategisk med hvilken informasjon som legges i kontekstvinduet og hvordan den organiseres, i stedet for å prøve å få plass til alt i minnet samtidig.

De utvidede kontekstvinduene i moderne AI-modeller har åpnet for en rekke reelle bruksområder som tidligere var upraktiske eller umulige. Kundesystemer kan nå gjennomgå hele sakshistorikker og tilknyttet dokumentasjon i én forespørsel, noe som gir mer presise og kontekstuelt riktige svar uten at kundene må forklare situasjonen sin på nytt. Dokumentanalyse og forskning er blitt revolusjonert av modeller som kan ta inn hele forskningsartikler, juridiske kontrakter eller tekniske spesifikasjoner, identifisere nøkkelinformasjon og besvare detaljerte spørsmål om innholdet som ellers ville tatt mennesker timer å gjennomgå. Kodegjennomgang og programvareutvikling nyter godt av kontekstvinduer store nok til å romme hele filer eller flere relaterte filer, slik at AI kan forstå arkitektur og gi smartere forslag. Langforminnhold og iterativ skriving blir mer effektivt når modellen kan holde oversikt over hele dokumentets tone, stil og narrativ gjennom redigeringsprosessen. Møtereferatanalyse og forskningssammendrag utnytter store kontekstvinduer til å trekke innsikt fra timer med samtale eller dusinvis av kildedokumenter, og finne temaer og sammenhenger som ville vært vanskelig å identifisere manuelt. Disse bruksområdene viser at størrelsen på kontekstvinduet gir konkret verdi for fagfolk i ulike bransjer.

Utviklingen av kontekstvinduer tyder på at vi er på vei mot enda mer dramatiske utvidelser på kort sikt, med Gemini 1.5 Pro som allerede demonstrerer et kontekstvindu på 1 000 000 tokens og forskningsmiljøer som utforsker enda større kapasiteter. Utover ren størrelse vil fremtiden trolig innebære dynamiske kontekstvinduer som intelligent justerer størrelsen etter oppgaven, slik at de gir mer kapasitet ved behov og reduserer den for enklere spørsmål for å øke effektiviteten og redusere kostnadene. Forskere gjør også fremskritt på mer effektive oppmerksomhetsmekanismer som reduserer den datamessige straffen for større vinduer, og kan dermed bryte den kvadratiske skaleringsbarrieren som i dag begrenser kontekststørrelsen. Etter hvert som disse teknologiene modnes, vil kontekstvinduet sannsynligvis bli mindre av en begrensning og mer av et løst problem, slik at utviklere kan fokusere på andre aspekter ved AI-evne og pålitelighet. Samspillet mellom større vinduer, forbedret effektivitet og smartere kontekststyring vil trolig prege neste generasjon AI-applikasjoner og åpne for bruksområder vi ennå ikke har sett for oss.

Et kontekstvindu er den totale mengden tekst (målt i tokens) som en AI-modell kan behandle på én gang, mens en token-grense refererer til det maksimale antallet tokens modellen kan håndtere. Disse begrepene brukes ofte om hverandre, men kontekstvinduet refererer spesifikt til arbeidsminnet tilgjengelig under en enkelt inferens, mens token-grense også kan vise til utgangsbegrensninger eller API-bruksgrenser.

Større kontekstvinduer gir generelt bedre svar ved at modellen kan ta hensyn til mer relevant informasjon og opprettholde bedre kontinuitet i samtalen. Svært store vinduer kan imidlertid noen ganger svekke kvaliteten på grunn av kontekstforvitring, der modellen sliter med å prioritere viktig informasjon blant store mengder tekst. Den optimale størrelsen på kontekstvinduet avhenger av den spesifikke oppgaven og hvor godt informasjonen er organisert.

Større kontekstvinduer krever mer datakraft på grunn av den kvadratiske skaleringen til oppmerksomhetsmekanismen i transformermodeller. Oppmerksomhetsmekanismen må beregne forholdet mellom hver token og alle andre tokens, så en dobling av kontekstvinduet firedobler omtrent datakravene. Derfor er større kontekstvinduer dyrere å kjøre og gir tregere svartider.

'Nåla i høystakken'-problemet oppstår når en AI-modell sliter med å finne og bruke relevant informasjon ('nåla') når den er begravd i et svært stort kontekstvindu ('høystakken'). Modellene kan noen ganger prestere dårligere med svært store kontekstvinduer fordi oppmerksomhetsmekanismen blir utvannet over så mye informasjon, noe som gjør det vanskeligere å identifisere det som faktisk er viktig.

For å maksimere effekten av kontekstvinduet, organiser informasjon tydelig og hierarkisk, plasser den viktigste informasjonen tidlig eller sent i konteksten, bruk strukturerte formater som JSON eller markdown, og vurder å bruke Retrieval-Augmented Generation (RAG) for å laste inn kun den mest relevante informasjonen dynamisk. Unngå å overbelaste modellen med irrelevante detaljer som bruker tokens uten å tilføre verdi.

Kontekstvindu er modellens tekniske kapasitet til å behandle tekst på én gang, mens samtalehistorikk er den faktiske oversikten over tidligere meldinger i en samtale. Samtalehistorikken må få plass i kontekstvinduet, men kontekstvinduet inkluderer også plass til systemprompt, instruksjoner og annen metadata. En samtalehistorikk kan være lengre enn kontekstvinduet og krever da oppsummering eller avkorting.

Ingen AI-modeller har per i dag virkelig ubegrensede kontekstvinduer, siden alle modeller har arkitektoniske og datamessige begrensninger. Noen modeller, som Gemini 1.5 Pro, tilbyr imidlertid svært store vinduer (1 000 000 tokens), og teknikker som Retrieval-Augmented Generation (RAG) kan effektivt utvide modellens kunnskapsbase utover kontekstvinduet ved å hente inn informasjon dynamisk etter behov.

Størrelsen på kontekstvinduet påvirker direkte API-kostnadene fordi større vinduer krever mer datakraft å behandle. De fleste AI-API-leverandører tar betalt basert på token-bruk, så et større kontekstvindu betyr flere tokens behandlet og høyere kostnader. Noen leverandører tar også premium-priser for modeller med større kontekstvinduer, så det er viktig å velge riktig modellstørrelse for dine spesifikke behov.

AmICited sporer hvordan AI-systemer som ChatGPT, Perplexity og Google AI Overviews siterer og refererer til innholdet ditt. Forstå din AI-synlighet og overvåk omtale av merkevaren din på tvers av AI-plattformer.

Kontekstvindu forklart: det maksimale antall tokens en LLM kan prosessere om gangen. Lær hvordan kontekstvinduer påvirker AI-nøyaktighet, hallusinasjoner og mer...

Diskusjon i fellesskapet om AI-kontekstvinduer og deres betydning for innholdsmarkedsføring. Forstå hvordan kontekstgrenser påvirker hvordan AI behandler innhol...

Lær hva kontekstvinduer er i KI-språkmodeller, hvordan de fungerer, hvilken innvirkning de har på modellens ytelse og hvorfor de er viktige for KI-drevne applik...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.