Hvordan dynamisk rendering påvirker AI: Innvirkning på crawlbarhet og synlighet

Lær hvordan dynamisk rendering påvirker AI-crawlere, ChatGPT, Perplexity og Claude sin synlighet. Oppdag hvorfor AI-systemer ikke kan gjengi JavaScript og hvord...

Dynamisk gjengivelse er en server-side-teknikk som oppdager om en forespørsel kommer fra en bruker eller en søkemotorbot, og deretter leverer forskjellige versjoner av det samme innholdet deretter—klientside-gjengitt JavaScript for brukere og fullt server-side-gjengitt statisk HTML for roboter. Denne tilnærmingen optimaliserer gjennomsøking og indeksering samtidig som den opprettholder full brukeropplevelse.

Dynamisk gjengivelse er en server-side-teknikk som oppdager om en forespørsel kommer fra en bruker eller en søkemotorbot, og deretter leverer forskjellige versjoner av det samme innholdet deretter—klientside-gjengitt JavaScript for brukere og fullt server-side-gjengitt statisk HTML for roboter. Denne tilnærmingen optimaliserer gjennomsøking og indeksering samtidig som den opprettholder full brukeropplevelse.

Dynamisk gjengivelse er en server-side-teknikk for innholdslevering som oppdager hvilken type forespørsel som gjøres til et nettsted—om det er fra en menneskelig bruker eller en søkemotorbot—og leverer optimaliserte versjoner av innholdet deretter. Når en bruker besøker en side, får vedkommende den fullstendige klientside-gjengitte versjonen med alt JavaScript, interaktive elementer og dynamiske funksjoner intakt. Når derimot en søkemotorbot eller AI-robot ber om samme side, oppdager serveren dette via identifisering av user-agent og ruter forespørselen til en gjengivelsesmotor som konverterer det JavaScript-tunge innholdet til statisk, fullstendig gjengitt HTML. Denne statiske versjonen blir deretter levert til roboten, slik at roboten slipper å kjøre JavaScript-kode. Teknikken oppstod som en praktisk løsning på utfordringen søkemotorer møter når de skal prosessere JavaScript i stor skala, og har blitt stadig viktigere etter hvert som AI-drevne søkeplattformer som ChatGPT, Perplexity, Claude og Google AI Overviews har utvidet sine aktiviteter for gjennomsøking av nettet.

Dynamisk gjengivelse ble formelt introdusert for SEO-miljøet av Google under I/O-konferansen i 2018, da John Mueller presenterte det som en løsning på utfordringer med JavaScript-indeksering. På den tiden erkjente Google at selv om Googlebot teknisk sett kunne gjengi JavaScript, krevde dette betydelige datamessige ressurser i stor skala og førte til forsinkelser i innholdsoppdagelse og indeksering. Bing fulgte etter i juni 2018 og oppdaterte sine Webmaster Guidelines for å anbefale dynamisk gjengivelse spesielt for store nettsteder med begrensninger i JavaScript-behandling. Teknikken vant gehør blant bedriftsnettsteder og JavaScript-tunge applikasjoner som en pragmatisk mellomløsning mellom å bevare rike brukeropplevelser og sikre søkemotortilgjengelighet. Googles holdning utviklet seg imidlertid betydelig innen 2022, da selskapet oppdaterte sin offisielle dokumentasjon og eksplisitt uttalte at dynamisk gjengivelse er en midlertidig løsning og ikke en langsiktig strategi. Dette skiftet reflekterte Googles preferanse for mer bærekraftige gjengivelsesmetoder som server-side rendering (SSR), statisk gjengivelse og hydrering. Til tross for denne omklassifiseringen er dynamisk gjengivelse fortsatt mye brukt på nettet, spesielt blant store nettbutikker, single-page-applikasjoner og innholdstunge nettsteder som ikke umiddelbart kan migrere til alternative arkitekturer for gjengivelse.

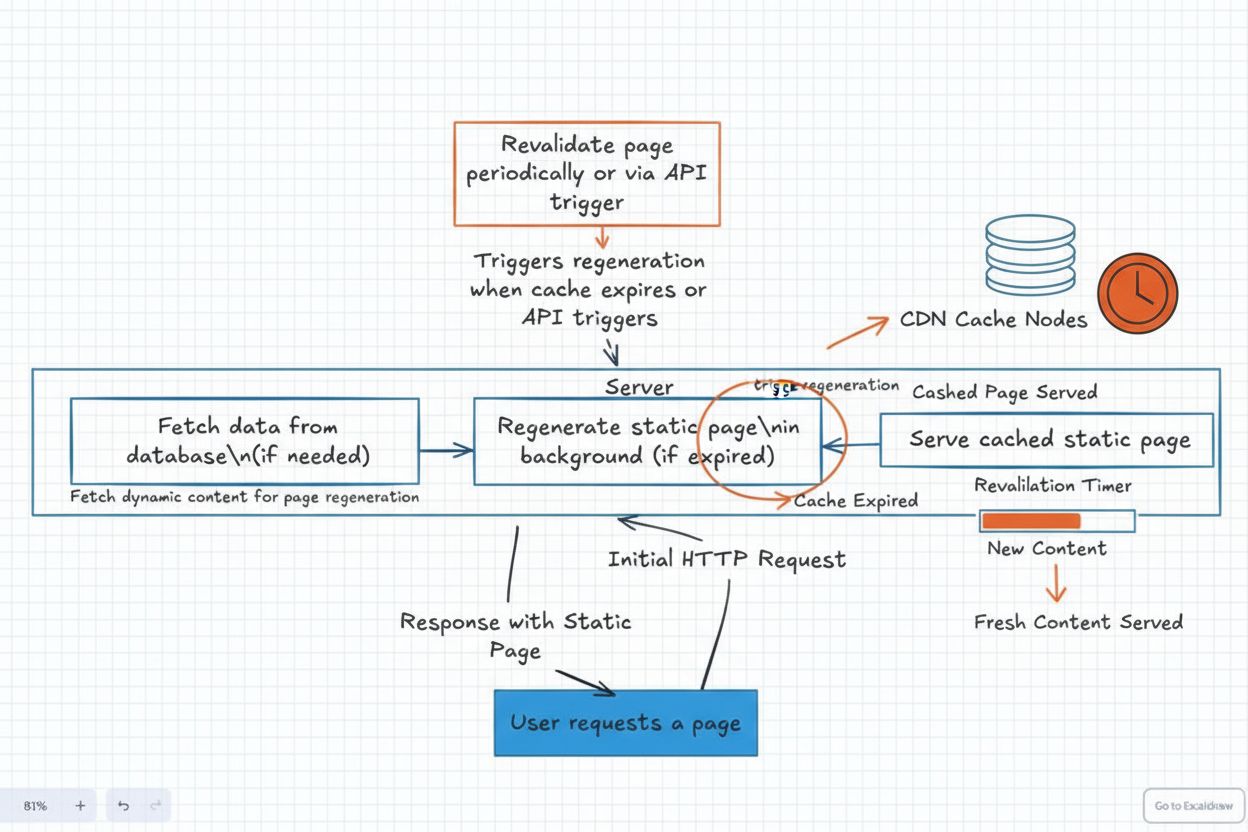

Mekanismene bak dynamisk gjengivelse involverer tre kjernekategorier som jobber sammen: user-agent-deteksjon, innholdsruting og gjengivelse og caching. Når en forespørsel kommer til en webserver, er første steg å identifisere om forespørselen kommer fra en menneskelig bruker eller en automatisk robot. Denne identifiseringen skjer ved å undersøke user-agent-strengen i HTTP-forespørselsheaderen, som inneholder informasjon om klienten som gjør forespørselen. Søkemotorroboter som Googlebot, Bingbot og AI-roboter fra plattformer som Perplexity og Claude identifiserer seg gjennom spesifikke user-agent-strenger. Når en bot er oppdaget, ruter serveren forespørselen til en dynamisk gjengivelsestjeneste eller mellomvare, som vanligvis benytter en headless-nettleser (som Chromium eller Puppeteer) for å gjengi sidens JavaScript og konvertere det til statisk HTML. Denne gjengivelsesprosessen kjører all JavaScript-kode, laster dynamisk innhold og genererer den endelige DOM-en (Document Object Model) som normalt ville blitt skapt i brukerens nettleser. Den resulterende statiske HTML-en caches deretter for å unngå gjentatt gjengivelsesbelastning og serveres direkte til roboten. For menneskelige brukere går forespørselen utenom denne gjengivelsesruten og får den opprinnelige klientside-gjengitte versjonen, slik at de får hele den interaktive opplevelsen med alle animasjoner, sanntidsoppdateringer og dynamiske funksjoner intakt.

| Aspekt | Dynamisk gjengivelse | Server-side rendering (SSR) | Statisk gjengivelse | Klientside-gjengivelse (CSR) |

|---|---|---|---|---|

| Innholdslevering til brukere | Klientside-gjengitt (JavaScript) | Server-side-gjengitt (HTML) | Forhåndsbygget statisk HTML | Klientside-gjengitt (JavaScript) |

| Innholdslevering til roboter | Server-side-gjengitt (HTML) | Server-side-gjengitt (HTML) | Forhåndsbygget statisk HTML | Klientside-gjengitt (JavaScript) |

| Implementeringskompleksitet | Moderat | Høy | Lav | Lav |

| Ressursbehov | Middels (gjengivelse kun for roboter) | Høy (gjengivelse for alle forespørsler) | Lav (ingen gjengivelse nødvendig) | Lav (kun klientside) |

| Ytelse for brukere | Avhenger av JavaScript | Utmerket | Utmerket | Variabel |

| Ytelse for roboter | Utmerket | Utmerket | Utmerket | Dårlig |

| Crawl budget-effekt | Positiv (raskere robotbehandling) | Positiv (raskere robotbehandling) | Positiv (raskest) | Negativ (treg gjengivelse) |

| SEO-anbefaling | Midlertidig løsning | Foretrukket på lang sikt | Foretrukket på lang sikt | Ikke anbefalt for SEO |

| Beste bruksområder | Store JS-tunge sider med budsjettbegrensninger | Moderne webapplikasjoner | Blogger, dokumentasjon, statisk innhold | Brukerfokuserte apper uten SEO-behov |

| Vedlikeholdsbyrde | Lav-moderat | Høy | Lav | Lav |

Hovedårsaken til at dynamisk gjengivelse finnes, kommer av en kritisk utfordring i moderne webutvikling: JavaScript-gjengivelse i stor skala. Selv om JavaScript muliggjør rike, interaktive brukeropplevelser med sanntidsoppdateringer, animasjoner og kompleks funksjonalitet, skaper det betydelige hindringer for søkemotorroboter. Når en søkemotorbot møter en side bygget med JavaScript-rammeverk som React, Vue eller Angular, må roboten kjøre JavaScript-koden for å se det endelige gjengitte innholdet. Denne prosessen er datakrevende og tidkrevende. Google har offentlig erkjent denne utfordringen gjennom uttalelser fra Martin Splitt, Google Search Advocate, som forklarte: “Selv om Googlebot kan kjøre JavaScript, vil vi ikke være avhengig av det.” Årsaken er at Google opererer med et begrenset crawl budget—en fastsatt mengde tid og datarressurser tildelt for å gjennomsøke hvert nettsted. Ifølge forskning fra Botify, som analyserte 6,2 milliarder Googlebot-forespørsler på 413 millioner nettsider, blir omtrent 51 % av sidene på store bedriftsnettsteder ikke gjennomsøkt på grunn av crawl budget-begrensninger. Når JavaScript gjør gjennomgangen tregere, blir færre sider oppdaget og indeksert. I tillegg eksisterer det et render budget som er adskilt fra crawl budget, så selv om en side blir gjennomsøkt, kan Google utsette å gjengi JavaScript til ressursene er tilgjengelige, noe som potensielt forsinker indekseringen med timer eller dager. Denne forsinkelsen er spesielt problematisk for nettbutikker med raskt skiftende varelager eller nyhetssider som publiserer hundrevis av artikler daglig, der tidsriktig indeksering har direkte innvirkning på synlighet og trafikk.

Crawl budget er et av de viktigste, men ofte misforståtte begrepene innen SEO. Google beregner crawl budget med formelen: Crawl budget = Crawl capacity + Crawl demand. Crawl capacity avhenger av sidens lastetid og serverfeil, mens crawl demand avhenger av sidens popularitet og oppdateringssignaler. Når et nettsted implementerer dynamisk gjengivelse, forbedrer det direkte crawl capacity ved å redusere tiden roboter bruker på å prosessere hver side. Forskning viser at sider med under 3 sekunders gjengivelsestid får omtrent 45 % hyppigere re-crawling sammenlignet med sider med 500-1000 ms lastetid, og omtrent 130 % mer crawling enn sider med over 1 000 ms. Ved å levere forhåndsgjengitt statisk HTML til roboter i stedet for JavaScript-tungt innhold, kan dynamisk gjengivelse drastisk redusere lastetiden for roboter, slik at de kan prosessere flere sider innenfor sitt tildelte budsjett. Denne effektiviseringen gir direkte forbedret indekseringsrate. For store nettsteder med tusenvis eller millioner av sider, kan dette utgjøre forskjellen mellom å få indeksert 50 % av sidene eller 80 % eller mer. I tillegg hjelper dynamisk gjengivelse med å sikre at JavaScript-lastet innhold umiddelbart er synlig for roboter i stedet for å bli utsatt til en sekundær gjengivelseskø. Dette er spesielt viktig for innhold som endres ofte, da det sikrer at roboter ser den nåværende versjonen og ikke en cachet eller utdatert gjengivelse.

Fremveksten av AI-drevne søkeplattformer som ChatGPT, Perplexity, Claude og Google AI Overviews har gitt en ny dimensjon til diskusjonen om dynamisk gjengivelse. Disse plattformene har egne roboter som prosesserer nettinnhold for å generere AI-drevne svar og oppsummeringer. I motsetning til tradisjonelle søkemotorer som primært indekserer sider for rangeringsformål, må AI-roboter få tilgang til og forstå innholdet grundig for å kunne generere presise, kontekstuelle svar. Dynamisk gjengivelse blir spesielt viktig i denne sammenhengen fordi den sikrer at AI-roboter får tilgang til innholdet ditt effektivt og fullstendig. Når AmICited overvåker merkevarens tilstedeværelse i AI-genererte svar på disse plattformene, er den avgjørende faktoren for om innholdet ditt blir sitert hvorvidt AI-roboten kunne få tilgang til og forstå innholdet på nettstedet ditt. Hvis nettstedet ditt er tungt avhengig av JavaScript og mangler dynamisk gjengivelse, kan AI-roboter slite med å få tilgang til innholdet, noe som reduserer sannsynligheten for at merkevaren din vises i AI-svar. På den annen side sikrer nettsteder med korrekt implementert dynamisk gjengivelse at AI-roboter får fullt gjengitt, tilgjengelig innhold, noe som øker sannsynligheten for sitering og synlighet. Dette gjør dynamisk gjengivelse til ikke bare en SEO-utfordring, men en kritisk komponent i en strategi for Generative Engine Optimization (GEO). Organisasjoner som bruker AmICited for å spore sin AI-synlighet bør vurdere dynamisk gjengivelse som en grunnleggende teknisk implementering for å maksimere tilstedeværelsen på alle AI-plattformer.

Implementering av dynamisk gjengivelse krever nøye planlegging og teknisk gjennomføring. Første steg er å identifisere hvilke sider som krever dynamisk gjengivelse—vanligvis prioriterte sider som forsider, produktsider og innhold som genererer mye trafikk eller endres hyppig. Ikke alle sider trenger nødvendigvis dynamisk gjengivelse; statiske sider med minimalt JavaScript kan ofte gjennomsøkes effektivt uten det. Neste steg er å velge en gjengivelsesløsning. Populære alternativer inkluderer Prerender.io (en betalt tjeneste som håndterer gjengivelse og caching), Rendertron (Googles open source-gjengivelsesløsning basert på headless Chromium), Puppeteer (et Node.js-bibliotek for å styre headless Chrome) og spesialiserte plattformer som Nostra AI’s Crawler Optimization. Hver løsning har ulike fordeler og ulemper når det gjelder kostnad, kompleksitet og vedlikehold. Etter å ha valgt et gjengivelsesverktøy må utviklere konfigurere user-agent-deteksjon mellomvare på serveren for å identifisere bot-forespørsler og rute dem korrekt. Dette innebærer vanligvis å sjekke user-agent-strengen mot en liste over kjente bot-identifikatorer og proxy-bot-forespørsler til gjengivelsestjenesten. Caching er kritisk—forhåndsgjengitt innhold bør caches aggressivt for å unngå å gjengi samme side gjentatte ganger, noe som ville ødelegge optimaliseringen. Til slutt bør implementeringen verifiseres med Google Search Consoles URL-inspeksjonsverktøy og Mobilvennlig test for å bekrefte at roboter mottar gjengitt innhold korrekt.

De viktigste fordelene med dynamisk gjengivelse er betydelige og godt dokumenterte. Forbedret crawlability er den mest umiddelbare fordelen—ved å fjerne JavaScript-behandlingsbelastningen kan roboter gjennomsøke flere sider raskere. Bedre indekseringsrate følger naturlig, ettersom flere sider blir oppdaget og indeksert innenfor crawl budget. Raskere robotbehandling reduserer serverbelastningen fra gjengivelsesforespørsler, da gjengivelsen skjer én gang og caches i stedet for å gjentas ved hvert bot-besøk. Bevart brukeropplevelse er en kritisk fordel som skiller dynamisk gjengivelse fra andre metoder—brukere får fortsatt den fulle, interaktive versjonen av nettstedet uten forringelse. Lavere implementeringskostnad sammenlignet med server-side rendering gjør det tilgjengelig for organisasjoner med begrensede utviklingsressurser. Men dynamisk gjengivelse har også sine begrensninger. Kompleksitet og vedlikeholdsbyrde kan være betydelig, spesielt for store nettsteder med tusenvis av sider eller komplekse innholdsstrukturer. Cache-utfordringer oppstår når innhold endres ofte—cachen må ugyldiggjøres og regenereres på riktig måte. Potensiale for inkonsistens mellom bruker- og robotversjonen kan oppstå hvis det ikke håndteres grundig, noe som kan gi indekseringsproblemer. Ressursbruk til gjengivelses- og cache-infrastruktur gir driftskostnader. Viktigst av alt er Googles offisielle standpunkt at dynamisk gjengivelse er en midlertidig løsning, ikke en varig strategi, og organisasjoner bør se det som en overgang mens de planlegger migrasjon til mer bærekraftige gjengivelsesmetoder.

Fremtiden for dynamisk gjengivelse er nært knyttet til bredere trender innen webutvikling og søkemotorutvikling. Etter hvert som JavaScript-rammeverk fortsetter å dominere moderne webutvikling, vil behovet for løsninger som bygger bro mellom rike brukeropplevelser og robottilgjengelighet forbli relevant. Industrien beveger seg imidlertid gradvis mot mer bærekraftige løsninger. Server-side rendering blir stadig mer praktisk ettersom rammeverk som Next.js, Nuxt og Remix gjør SSR-implementering mer tilgjengelig for utviklere. Statisk gjengivelse og inkrementell statisk regenerering gir utmerket ytelse for innhold som ikke endrer seg kontinuerlig. Hydrering—hvor en side først gjengis på serveren og deretter får interaktivitet på klientsiden—gir en mellomløsning som blir stadig mer utbredt. Googles oppdaterte retningslinjer anbefaler eksplisitt disse alternativene framfor dynamisk gjengivelse, noe som signaliserer at søkegiganten ser dynamisk gjengivelse som en overgangsløsning og ikke et permanent arkitekturmønster. Fremveksten av AI-drevne søkeplattformer gir en ny dimensjon til denne utviklingen. Etter hvert som disse plattformene blir mer sofistikerte i sin gjennomsøking og forståelse av innhold, øker viktigheten av tilgjengelig, godt strukturert innhold. Dynamisk gjengivelse vil sannsynligvis fortsatt være relevant for organisasjoner med eldre systemer eller spesielle begrensninger, men nye prosjekter bør prioritere mer bærekraftige gjengivelsesstrategier fra starten av. For organisasjoner som bruker AmICited for å overvåke AI-synlighet, er den strategiske implikasjonen klar: selv om dynamisk gjengivelse kan forbedre din umiddelbare synlighet i AI-svar, bør du planlegge migrasjon til mer bærekraftige gjengivelsesmetoder som en del av din langsiktige strategi for Generative Engine Optimization. Sammenkoblingen av tradisjonell SEO, teknisk ytelsesoptimalisering og AI-synlighet gjør at gjengivelsesstrategi ikke lenger er et rent teknisk anliggende, men en kjernebeslutning som påvirker synlighet på tvers av alle søkeplattformer.

Nei, Google sier eksplisitt at dynamisk gjengivelse ikke er cloaking så lenge innholdet som serveres til roboter og brukere er vesentlig likt. Cloaking innebærer å med vilje servere helt forskjellig innhold for å lure søkemotorer, mens dynamisk gjengivelse leverer det samme innholdet i ulike formater. Å servere helt forskjellige sider (som katter til brukere og hunder til roboter) vil derimot regnes som cloaking og bryter med Googles retningslinjer.

Dynamisk gjengivelse reduserer de datamessige ressursene som kreves for at søkemotorroboter skal behandle JavaScript, slik at de kan gjennomsøke flere sider innenfor sitt tildelte crawl budget. Ved å levere forhåndsgjengitt statisk HTML i stedet for tungt JavaScript-innhold, får roboter tilgang til og kan indeksere sider raskere. Forskning viser at sider med under 3 sekunders gjengivelsestid får omtrent 45 % hyppigere re-crawling sammenlignet med tregere sider, noe som direkte forbedrer indekseringsraten.

Server-side rendering (SSR) forhåndsgjengir innhold på serveren for både brukere og roboter, noe som forbedrer ytelsen for alle, men krever betydelige utviklingsressurser. Dynamisk gjengivelse forhåndsgjengir kun for roboter, mens brukere får den vanlige klientside-gjengitte versjonen, noe som gjør det mindre ressurskrevende å implementere. Google anbefaler imidlertid nå SSR, statisk gjengivelse eller hydrering som langsiktige løsninger fremfor dynamisk gjengivelse, som anses som en midlertidig løsning.

Dynamisk gjengivelse er ideelt for store, JavaScript-tunge nettsteder med hyppig oppdatert innhold, som nettbutikker med stadig skiftende vareutvalg, single-page-applikasjoner og nettsteder med komplekse interaktive funksjoner. Nettsteder som sliter med crawl budget—der Google ikke klarer å gjennomsøke betydelige deler av innholdet—er spesielt aktuelle. Ifølge forskning går Google glipp av omtrent 51 % av sidene på store bedriftsnettsteder på grunn av crawl budget-begrensninger.

AI-roboter brukt av plattformer som ChatGPT, Perplexity og Claude behandler nettinnhold på lignende måte som tradisjonelle søkemotorroboter, og krever fullt tilgjengelig HTML-innhold for optimal indeksering. Dynamisk gjengivelse hjelper disse AI-systemene med å få tilgang til og forstå JavaScript-generert innhold mer effektivt, noe som øker sannsynligheten for at nettstedet ditt vises i AI-genererte svar og oppsummeringer. Dette er spesielt viktig for AmICited-overvåkning, da korrekt gjengivelse sikrer at merkevaren din vises i AI-søkeresultater.

Populære løsninger for dynamisk gjengivelse omfatter Prerender.io (betalbar tjeneste), Rendertron (open source), Puppeteer og spesialiserte plattformer som Nostra AI's Crawler Optimization. Disse verktøyene oppdager bot user agents, genererer statiske HTML-versjoner av sider og cacher dem for raskere levering. Implementering innebærer vanligvis å installere en renderer på serveren, konfigurere middleware for user-agent-deteksjon og verifisere oppsettet gjennom Google Search Consoles URL-inspeksjonsverktøy.

Nei, dynamisk gjengivelse har ingen innvirkning på brukeropplevelsen fordi besøkende fortsatt får den fulle, klientside-gjengitte versjonen av nettstedet med alle interaktive elementer, animasjoner og dynamiske funksjoner intakt. Brukere ser aldri den statiske HTML-versjonen som serveres til roboter. Teknikken er spesifikt utviklet for å optimalisere roboters gjennomsøking uten å gå på kompromiss med den rike, interaktive opplevelsen som menneskelige besøkende forventer og setter pris på.

Google anbefalte dynamisk gjengivelse i 2018 som en praktisk løsning på begrensninger knyttet til JavaScript-gjengivelse i stor skala. Fra og med 2022 har Google imidlertid oppdatert sine retningslinjer for å presisere at dynamisk gjengivelse er en midlertidig løsning, ikke en varig strategi. Endringen reflekterer Googles preferanse for mer bærekraftige tilnærminger som server-side rendering, statisk gjengivelse eller hydrering. Dynamisk gjengivelse er fortsatt relevant for spesifikke bruksområder, men bør inngå som en del av en bredere ytelsesoptimaliseringsstrategi og ikke stå alene.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hvordan dynamisk rendering påvirker AI-crawlere, ChatGPT, Perplexity og Claude sin synlighet. Oppdag hvorfor AI-systemer ikke kan gjengi JavaScript og hvord...

Lær hva Incremental Static Regeneration (ISR) er, hvordan det fungerer, og hvorfor det er essensielt for moderne nettapplikasjoner. Oppdag ISR sin rolle i AI-ov...

Lær hvordan forhåndsgjengivelse hjelper nettstedet ditt å vises i AI-søkeresultater fra ChatGPT, Perplexity og Claude. Forstå den tekniske implementeringen og f...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.