Enterprise AI Visibility-løsninger: Velg den riktige plattformen

Komplett guide til enterprise AI-synlighetsløsninger. Sammenlign topp-plattformer som Conductor, Profound og Athena. Lær evalueringskriterier og utvelgelsesstra...

Enterprise AI-synlighetsstrategi refererer til den helhetlige tilnærmingen organisasjoner implementerer for å overvåke, spore og forstå alle kunstig intelligens-systemer, modeller og applikasjoner som opererer innenfor deres infrastruktur. Denne strategien omfatter evnen til å se hvilke AI-systemer som brukes, hvordan de presterer, hvem som bruker dem, og hvilke risikoer de innebærer på tvers av hele organisasjonen. For store virksomheter som håndterer hundrevis eller tusenvis av AI-implementeringer, blir synlighet kritisk viktig fordi skyggelagt AI—uautoriserte eller udokumenterte AI-verktøy—raskt kan spre seg uten riktig tilsyn. Uten omfattende synlighet kan ikke organisasjoner sikre etterlevelse, håndtere risiko, optimalisere ytelse eller hente ut maksimalt utbytte fra sine AI-investeringer.

Enterprise AI-synlighetsstrategi refererer til den helhetlige tilnærmingen organisasjoner implementerer for å overvåke, spore og forstå alle kunstig intelligens-systemer, modeller og applikasjoner som opererer innenfor deres infrastruktur. Denne strategien omfatter evnen til å se hvilke AI-systemer som brukes, hvordan de presterer, hvem som bruker dem, og hvilke risikoer de innebærer på tvers av hele organisasjonen. For store virksomheter som håndterer hundrevis eller tusenvis av AI-implementeringer, blir synlighet kritisk viktig fordi skyggelagt AI—uautoriserte eller udokumenterte AI-verktøy—raskt kan spre seg uten riktig tilsyn. Uten omfattende synlighet kan ikke organisasjoner sikre etterlevelse, håndtere risiko, optimalisere ytelse eller hente ut maksimalt utbytte fra sine AI-investeringer.

Enterprise AI-synlighetsstrategi refererer til den helhetlige tilnærmingen organisasjoner implementerer for å overvåke, spore og forstå alle kunstig intelligens-systemer, modeller og applikasjoner som opererer innenfor deres infrastruktur. Denne strategien omfatter evnen til å se hvilke AI-systemer som brukes, hvordan de presterer, hvem som bruker dem, og hvilke risikoer de innebærer på tvers av hele organisasjonen. For store virksomheter som håndterer hundrevis eller tusenvis av AI-implementeringer, blir synlighet kritisk viktig fordi skyggelagt AI—uautoriserte eller udokumenterte AI-verktøy—raskt kan spre seg uten riktig tilsyn. Utfordringen forsterkes i stor skala, der 85 % av virksomheter nå bruker AI i en eller annen form, men bare 11 % rapporterer tydelig forretningsverdi, noe som indikerer et betydelig gap mellom implementering og effektiv styring. Uten omfattende synlighet kan ikke organisasjoner sikre etterlevelse, håndtere risiko, optimalisere ytelse eller hente ut maksimalt utbytte fra sine AI-investeringer.

Enterprise AI-synlighet opererer på tvers av tre sammenkoblede dimensjoner som sammen gir full organisatorisk bevissthet om AI-systemer og deres påvirkning. Den første dimensjonen, bruksmonitorering, sporer hvilke AI-systemer som er distribuert, hvem som har tilgang, hvor ofte de brukes, og til hvilke forretningsformål. Den andre dimensjonen, kvalitetsovervåking, sikrer at AI-modeller presterer som forventet, opprettholder nøyaktighetskrav og ikke forringes over tid på grunn av datadrift eller modellforfall. Den tredje dimensjonen, sikkerhetsovervåking, beskytter mot uautorisert tilgang, databrudd, prompt injection-angrep, og sikrer samsvar med regulatoriske krav. Disse tre dimensjonene må fungere sammen, støttet av sentral logging, sanntidsdashbord og automatiserte varslingssystemer. Organisasjoner som implementerer omfattende synlighet på tvers av alle tre dimensjoner rapporterer betydelig bedre styringsresultater og raskere respons ved hendelser.

| Dimensjon | Formål | Nøkkelindikatorer |

|---|---|---|

| Bruksmonitorering | Spor distribusjon og bruksmønstre for AI-systemer | Aktive brukere, API-kall, modellversjoner, adopsjon per forretningsenhet |

| Kvalitetsovervåking | Sikre modellens ytelse og pålitelighet | Nøyaktighet, presisjon, recall, prediksjonsdrift, responstid |

| Sikkerhetsovervåking | Beskytte mot trusler og sikre samsvar | Tilgangslogger, avvik oppdaget, policybrudd, revisjonsspor |

Organisasjoner møter betydelige hindringer når de forsøker å implementere omfattende AI-synlighet i store, komplekse miljøer. Skyggelagt AI utgjør kanskje den største utfordringen—ansatte og avdelinger setter i gang AI-verktøy uten ITs viten eller godkjenning, og skaper blindsone som hindrer sentral overvåking og styring. Datasiloer fragmenterer informasjon på tvers av avdelinger, noe som gjør det umulig å korrelere AI-bruksmønstre eller identifisere dobbeltarbeid og sløsing med ressurser. Integrasjonskompleksitet oppstår når organisasjoner må koble synlighetsverktøy sammen med eldre systemer, skyplattformer og ulike AI-rammeverk som ikke var designet for overvåking. Regulatorisk fragmentering krever ulike synlighetsstandarder for ulike jurisdiksjoner, og skaper samsvarskompleksitet som krever fleksibel og tilpasningsdyktig overvåkingsinfrastruktur. I tillegg rapporterer 84 % av IT-ledere at de mangler en formell styringsprosess, og 72 % av organisasjoner rapporterer datakvalitetsproblemer som undergraver påliteligheten til synlighetsmålinger.

Viktige synlighetsutfordringer inkluderer:

Effektiv enterprise AI-synlighet krever tilpasning til etablerte styringsrammeverk og standarder som gir struktur og troverdighet til overvåkingen. NIST AI Risk Management Framework (RMF) tilbyr en helhetlig tilnærming for å identifisere, måle og håndtere AI-risiko, og gir grunnlag for synlighetskrav på tvers av hele organisasjonen. ISO/IEC 42001 etablerer internasjonale standarder for AI-ledelsessystemer, inkludert krav til overvåking, dokumentasjon og kontinuerlig forbedring i tråd med synlighetsmål. EUs AI-forordning pålegger strenge krav til transparens og dokumentasjon for høyrisiko AI-systemer, og krever detaljerte registre over AI-systemers atferd og beslutningsprosesser. Bransjespesifikke rammeverk legger til ekstra krav—finansielle virksomheter må etterleve bankregulatorers forventninger til AI-styring, helseorganisasjoner må oppfylle FDA-krav for kliniske AI-systemer, og offentlige etater må følge føderale AI-styringsdirektiver. Organisasjoner bør velge rammeverk som passer bransje, geografi og risikoprofil, og deretter bygge synlighetsinfrastruktur som dokumenterer samsvar med valgte standarder.

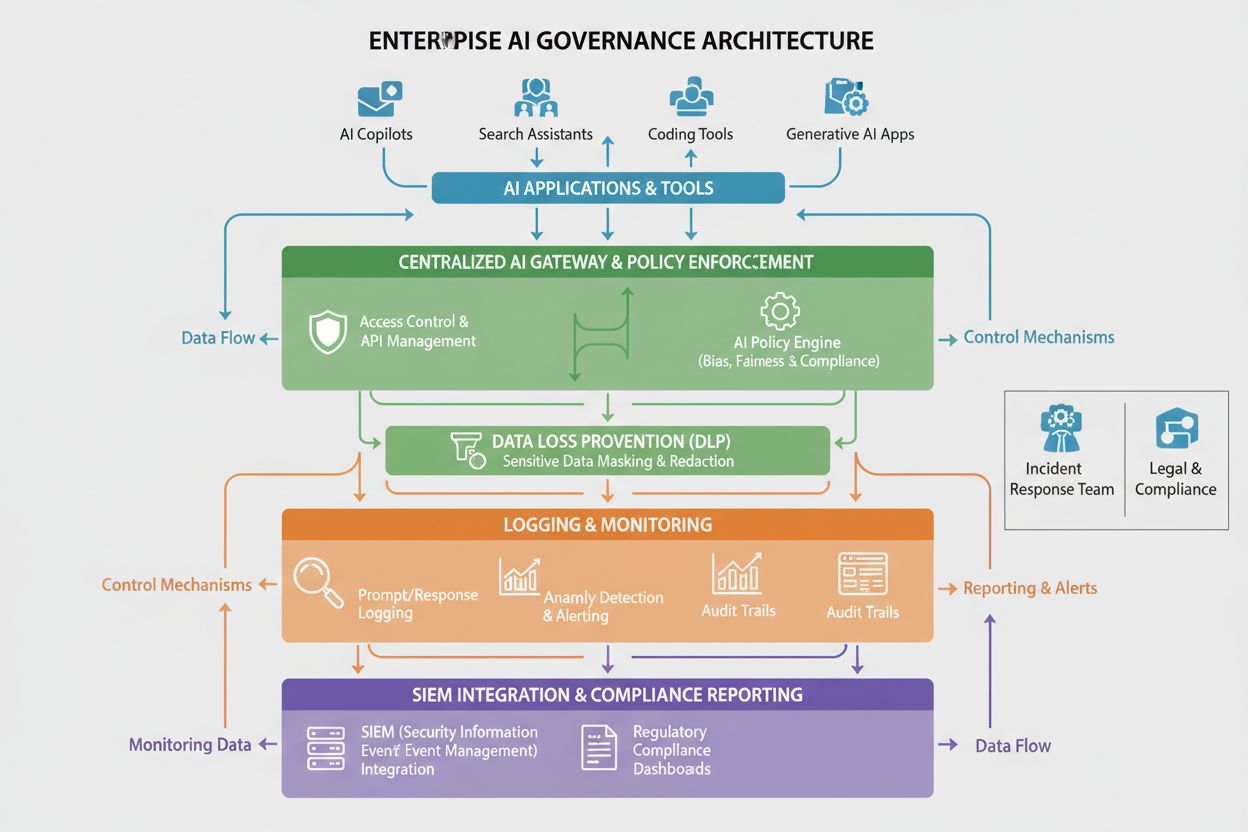

Implementering av enterprise AI-synlighet krever et robust teknisk fundament som fanger, prosesserer og presenterer data om AI-systemers atferd og ytelse. Sentraliserte AI-plattformer fungerer som ryggraden i synlighetsinfrastrukturen og gir ett samlet overblikk der organisasjoner kan overvåke alle AI-systemer uansett hvor de er distribuert. AI-gatewayer fungerer som mellomledd mellom applikasjoner og AI-tjenester, fanger metadata om hver forespørsel og respons, og muliggjør detaljert brukssporing og sikkerhetsovervåking. Omfattende loggesystemer registrerer alle AI-systemaktiviteter, modellprediksjoner, brukerinteraksjoner og systemytelsesdata i sentraliserte arkiv som støtter revisjonsspor og etterforskning. Data Loss Prevention (DLP)-verktøy overvåker AI-systemer for forsøk på å eksportere sensitiv data, og hindrer at modeller trenes på konfidensiell informasjon eller returnerer beskyttet data i svar. SIEM-integrasjon kobler AI-synlighetsdata til bredere sikkerhetsinformasjon og hendelseshåndtering, slik at AI-relaterte sikkerhetshendelser kan korreleres med andre trusler. Organisasjoner som implementerer disse tekniske komponentene rapporterer 30 % reduksjon i respons-tid ved hendelser relatert til AI-sikkerhet. Plattformene Liminal, Ardoq og Knostic leverer styringsfokuserte synlighetsløsninger, mens AmICited.com spesialiserer seg på å overvåke AI-svarskvalitet på tvers av GPT-er, Perplexity og Google AI Overviews.

Vellykket enterprise AI-synlighet krever tydelige organisatoriske strukturer og definerte roller som fordeler ansvar for overvåking og styring på tvers av organisasjonen. Et AI-styringsutvalg fungerer vanligvis som det utøvende organet som overvåker AI-synlighetsstrategien, setter retningslinjer og sikrer samsvar med forretningsmål og regulatoriske krav. Modelleiere har ansvar for spesifikke AI-systemer, og sikrer at disse er riktig dokumentert, overvåket og vedlikeholdt i henhold til organisasjonens standarder. AI-ambassadører i forretningsenheter fungerer som bindeledd mellom IT-styringsteam og sluttbrukere, fremmer synlighetspraksis og identifiserer skyggelagt AI før det blir uhåndterlig. Datastyrere forvalter kvalitet og tilgjengelighet av data brukt til å trene og overvåke AI-systemer, og sikrer at synlighetsmålinger er pålitelige og troverdige. Sikkerhets- og samsvarsteam etablerer overvåkingskrav, gjennomfører revisjoner og sikrer at synlighetsinfrastrukturen oppfyller regulatoriske forpliktelser. Klare ansvarsstrukturer sikrer at synlighet ikke behandles som et IT-ansvar alene, men som et felles organisatorisk ansvar som krever deltakelse fra forretning, teknikk og styring.

Organisasjoner må etablere tydelige nøkkelindikatorer (KPI-er) og målerammer for å vurdere om AI-synlighetsstrategien gir verdi og støtter organisasjonens mål. Synlighetsdekning måler prosentandelen AI-systemer som er dokumentert og overvåket, der modne organisasjoner sikter mot 95 % eller høyere dekning av alle AI-distribusjoner. Styringsmodenhet følger fremdriften gjennom definerte stadier—fra ad hoc-overvåking til standardiserte prosesser til optimalisert, automatisert styring—ved å bruke rammeverk som CMMI-modellen tilpasset AI-styring. Hendelsesdeteksjon og respons måler hvor raskt organisasjonen identifiserer og reagerer på AI-relaterte hendelser, der forbedret deteksjonshastighet og responstid indikerer mer effektiv synlighet. Etterlevelse følger prosentandelen AI-systemer som oppfyller regulatoriske krav og interne standarder, med revisjonsfunn og utbedringsfrister som nøkkelindikatorer. Forretningsverdi måler om synlighetsinvesteringer gir konkrete fordeler som redusert risiko, forbedret modellprestasjon, raskere lansering av AI-initiativer eller bedre ressursallokering. Organisasjoner bør implementere sanntidsdashbord som viser disse målingene til interessenter, slik at kontinuerlig overvåking og rask korrigering muliggjøres når synlighetshull oppstår.

Ulike bransjer står overfor unike krav til AI-synlighet, drevet av regulatoriske rammer, risikoprofiler og forretningsmodeller som krever tilpasset overvåking. Finansielle tjenester må etterleve bankregulatorers krav til AI-styring, inkludert detaljert overvåking av AI-systemer brukt i utlånsbeslutninger, svindeldeteksjon og handelsalgoritmer, med spesielt fokus på bias-deteksjon og rettferdighetsmålinger. Helsevesenet må oppfylle FDA-krav for kliniske AI-systemer, inkludert validering av modellprestasjon, overvåking av sikkerhetsutfordringer og dokumentasjon av hvordan AI-systemer påvirker kliniske beslutninger. Juridiske virksomheter som bruker AI til kontraktanalyse, juridisk forskning og due diligence må sikre synlighet i treningsdata for å forhindre brudd på konfidensialitet og opprettholde advokat-klientprivilegiet. Offentlige etater må følge føderale AI-styringsdirektiver, inkludert krav til transparens, bias-revisjon og dokumentasjon av AI-systemers beslutningsprosesser for offentlig ansvarlighet. Detaljhandel og netthandel må overvåke AI-systemer brukt i anbefalingsmotorer og personalisering for samsvar med forbrukerbeskyttelseslover og konkurranseregler. Industri og produksjon må følge AI-systemer brukt til kvalitetskontroll og prediktivt vedlikehold for å sikre sikkerhet og pålitelighet. Bransjespesifikke synlighetskrav bør innarbeides i styringsrammeverk fremfor å behandles som separate samsvarsøvelser.

Organisasjoner som implementerer enterprise AI-synlighet bør ta en trinnvis tilnærming som gir raske gevinster samtidig som man bygger mot en omfattende, moden styringsevne. Start med inventar og dokumentasjon—gjennomfør en revisjon for å identifisere alle AI-systemer i bruk, inkludert skyggelagt AI, og opprett et sentralt register som dokumenterer systemets formål, eier, datakilder og forretningskritikalitet. Identifiser raske gevinster ved å fokusere de første overvåkingsinnsatsene på høy-risiko systemer som kundevendt AI, systemer som behandler sensitiv data eller modeller som tar viktige beslutninger om enkeltpersoner. Implementer sentral logging som en grunnleggende evne som fanger metadata om alle AI-systemaktiviteter, og muliggjør både sanntidsovervåking og historisk analyse. Etabler styringspolicyer som definerer standarder for dokumentasjon, overvåking og samsvar for AI-systemer, og kommuniser disse tydelig til alle interessenter. Bygg tverrfaglige team med representanter fra IT, sikkerhet, forretning og samsvar, slik at synlighetsinitiativene ivaretar behov fra hele organisasjonen. Mål og kommuniser fremdrift ved å følge synlighetsmålinger og dele resultatene med ledelsen, for å synliggjøre verdien av styringsinvesteringer og bygge støtte for videre satsing på AI-synlighetsinfrastruktur.

AI-synlighet er evnen til å se og overvåke hva AI-systemene gjør, mens AI-styring er det bredere rammeverket av retningslinjer, prosesser og kontroller som styrer hvordan AI-systemer utvikles, distribueres og brukes. Synlighet er en grunnleggende komponent i styring—du kan ikke styre det du ikke kan se. Effektiv AI-styring krever omfattende synlighet på tvers av alle tre dimensjoner: bruk, kvalitet og sikkerhetsovervåking.

Store organisasjoner står overfor unike utfordringer med å håndtere hundrevis eller tusenvis av AI-implementeringer på tvers av flere avdelinger, skytjenester og forretningsenheter. Uten omfattende synlighet øker skyggelagt AI, samsvarsrisikoen øker, og organisasjoner klarer ikke å optimalisere AI-investeringene eller sikre ansvarlig AI-bruk. Synlighet gjør det mulig for organisasjoner å identifisere risiko, håndheve retningslinjer og hente ut maksimalt utbytte fra AI-initiativer.

Dårlig AI-synlighet skaper flere risikoer: skyggelagt AI-systemer opererer uten tilsyn, sensitiv data kan bli eksponert gjennom uovervåkede AI-systemer, brudd på etterlevelse forblir uoppdaget, modellens ytelsesforringelse blir ikke identifisert, sikkerhetstrusler blir ikke oppdaget, og organisasjoner kan ikke demonstrere styring overfor tilsynsmyndigheter. Disse risikoene kan føre til databrudd, regulatoriske bøter, omdømmeskade og tapt kundetillit.

Skyggelagt AI—uautoriserte AI-verktøy som distribueres uten ITs kunnskap—skaper blindsone som hindrer sentral overvåking og styring. Ansatte kan bruke offentlige AI-tjenester som ChatGPT uten organisasjonens tilsyn, noe som potensielt kan eksponere sensitiv data eller bryte med samsvarskrav. Skyggelagt AI fører også til dobbeltarbeid, sløsing med ressurser og manglende evne til å håndheve organisasjonens AI-policyer og standarder.

Spesialbygde AI-styringsplattformer som Liminal, Ardoq og Knostic tilbyr sentral overvåking, policyhåndheving og samsvarsrapporter. Disse plattformene integreres med AI-tjenester, fanger opp detaljerte logger, oppdager avvik og gir dashbord for styringsteam. I tillegg spesialiserer AmICited seg på å overvåke hvordan AI-systemer refererer til merkevaren din på tvers av GPT-er, Perplexity og Google AI Overviews, og gir innsikt i kvaliteten på AI-svar.

Regulatoriske rammeverk som EUs AI-forordning, GDPR, CCPA og bransjespesifikke reguleringer (OCC for bank, FDA for helsevesen) krever spesifikke synlighets- og dokumentasjonskrav. Organisasjoner må implementere overvåking som demonstrerer etterlevelse av disse reguleringene, inkludert revisjonsspor, bias-testing, ytelsesovervåking og dokumentasjon av AI-systemets beslutningsprosesser. Synlighetsinfrastrukturen må utformes for å møte disse regulatoriske forpliktelsene.

Viktige måleparametre inkluderer: synlighetsdekning (prosentandel av AI-systemer dokumentert og overvåket), styringsmodenhet (fremdrift gjennom definerte styringsstadier), hendelsesdeteksjon og responstid, etterlevelse (prosentandel av systemer som oppfyller regulatoriske krav), og forretningsverdi (konkrete fordeler fra synlighetsinvesteringer). Organisasjoner bør også følge bruksdata (aktive brukere, API-kall), kvalitetsmålinger (nøyaktighet, drift) og sikkerhetsmålinger (avvik oppdaget, policybrudd).

Tidslinjer for implementering varierer basert på organisasjonens størrelse og kompleksitet. Grunnleggende synlighetsinfrastruktur (inventar, enkel logging, dashbord) kan etableres på 3–6 måneder. Å oppnå fullstendig synlighet på tvers av alle AI-systemer krever typisk 6–12 måneder. Moden, optimalisert styringsevne oppnås vanligvis i løpet av 12–24 måneder. Organisasjoner bør ta en trinnvis tilnærming, med fokus på høy-risiko systemer og raske gevinster først, og deretter utvide til full dekning.

AmICited sporer hvordan AI-systemer som GPT-er, Perplexity og Google AI Overviews refererer til merkevaren og innholdet ditt. Få innsikt i kvaliteten på AI-svar og merkevareomtale på tvers av alle større AI-plattformer.

Komplett guide til enterprise AI-synlighetsløsninger. Sammenlign topp-plattformer som Conductor, Profound og Athena. Lær evalueringskriterier og utvelgelsesstra...

Lær hvordan du lager et AI-synlighets veikart med kvartalsvise mål og GEO-milepæler. Få en mal, beste praksis og verktøy for å overvåke merkevaren din på tvers ...

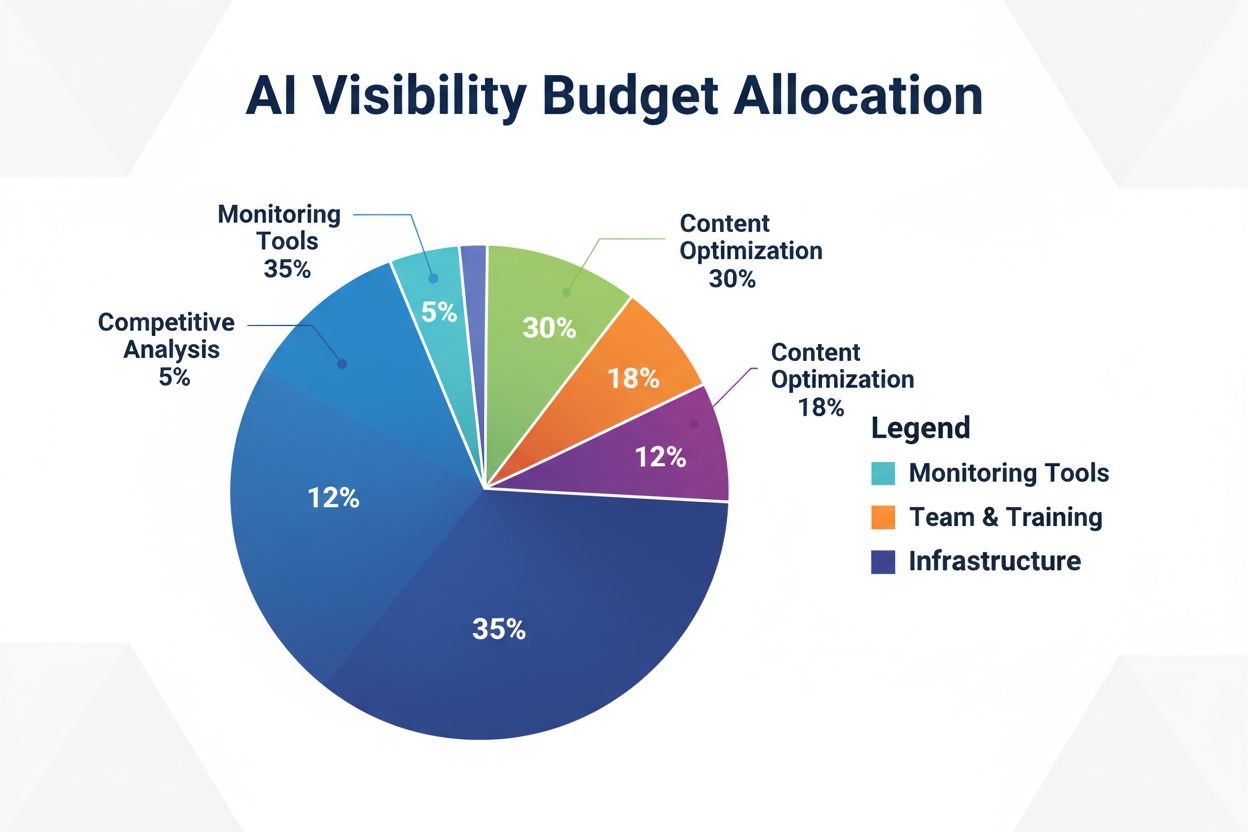

Lær hvordan du strategisk kan allokere AI-synlighetsbudsjettet ditt på overvåkingsverktøy, innholdsoptimalisering, teamressurser og konkurranseanalyse for å mak...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.