AI-synlighet i finansielle tjenester: Etterlevelse og optimalisering

Overvåk hvordan din finansielle merkevare fremstår i AI-genererte svar. Lær krav til etterlevelse, synlighetsstrategier og optimaliseringsteknikker for regulert...

Regulatoriske krav til finansinstitusjoner om å åpent redegjøre for sin bruk av kunstig intelligens i beslutningstaking, risikostyring og kundeorienterte applikasjoner. Omfatter forventninger fra SEC, CFPB, FINRA og andre myndigheter om dokumentasjon av AI-styring, modellprestasjon og konsekvenser for forbrukere og markeder.

Regulatoriske krav til finansinstitusjoner om å åpent redegjøre for sin bruk av kunstig intelligens i beslutningstaking, risikostyring og kundeorienterte applikasjoner. Omfatter forventninger fra SEC, CFPB, FINRA og andre myndigheter om dokumentasjon av AI-styring, modellprestasjon og konsekvenser for forbrukere og markeder.

Finansiell AI-åpenhet viser til regulatoriske krav og beste praksis for at finansinstitusjoner åpent skal redegjøre for sin bruk av kunstig intelligens i beslutningsprosesser, risikostyring og kundeorienterte applikasjoner. Dette omfatter forventninger fra SEC, CFPB, FINRA og andre myndigheter om dokumentasjon av AI-styring, modellprestasjon og mulige konsekvenser for forbrukere og markeder. I desember 2024 la SECs Investor Advisory Committee (IAC) frem en formell anbefaling om at etaten bør utstede retningslinjer som krever at utstedere opplyser om hvordan kunstig intelligens påvirker deres virksomheter. IAC påpekte en “mangel på konsistens” i dagens AI-opplysninger, noe som “kan være problematisk for investorer som søker tydelig og sammenlignbar informasjon.” Kun 40 % av S&P 500-selskapene gir AI-relaterte opplysninger, og bare 15 % opplyser om styrets tilsyn med AI, til tross for at 60 % av S&P 500-selskapene anser AI som en vesentlig risiko.

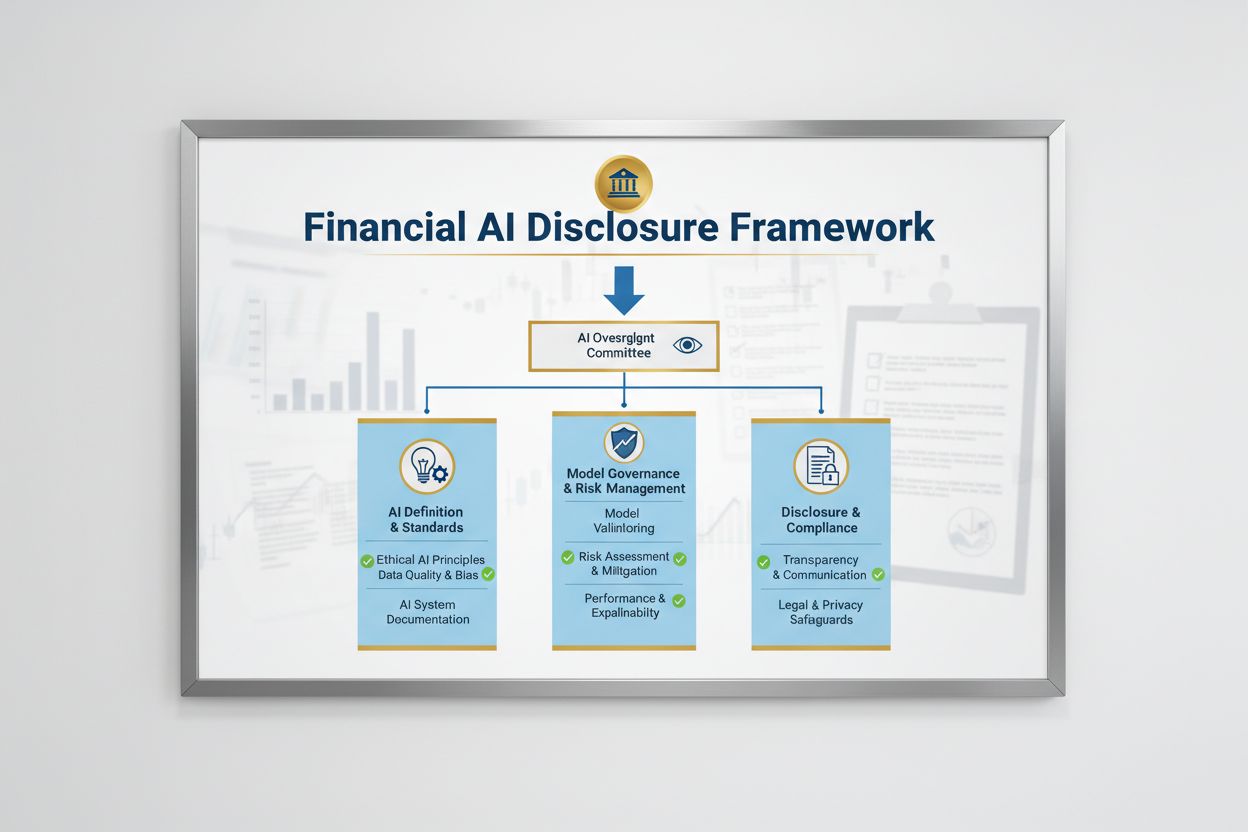

Det regulatoriske landskapet for Finansiell AI-åpenhet formes av flere føderale etater som anvender eksisterende teknologinøytrale lover på AI-systemer. SECs Investor Advisory Committee foreslo et rammeverk med tre hovedpilarer: (1) krav om at utstedere definerer hva de mener med “kunstig intelligens”, (2) å redegjøre for styrets tilsynsmekanismer for AI-implementering, og (3) å rapportere om vesentlige AI-implementeringer og deres effekt på interne operasjoner og kundeorienterte produkter. I tillegg har CFPB, FINRA, OCC og Federal Reserve gitt veiledning som understreker at eksisterende forbrukerbeskyttelseslover – inkludert regler om rettferdig utlån, datavern og anti-svindel – gjelder for AI-systemer uavhengig av teknologi. Disse etatene har en teknologinøytral tilnærming, noe som betyr at etterlevelseskravene under Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) og Unfair or Deceptive Acts or Practices (UDAAP) forblir uendret også når AI er involvert.

| Tilsynsmyndighet | Fokusområde | Nøkkelkrav |

|---|---|---|

| SEC | Investeroropplysninger, interessekonflikter | Definere AI, redegjøre for styrets tilsyn, rapportere vesentlige implementeringer |

| CFPB | Rettferdig utlån, forbrukerbeskyttelse | Sikre at AI-modeller etterlever ECOA, gi begrunnelser ved negative avgjørelser |

| FINRA | Meglervirksomhet, kundekommunikasjon | Etablere AI-styringspraksis, overvåke AI-bruk på alle områder |

| OCC/Federal Reserve/FDIC | Bankmodellstyring, operasjonell risiko | Validere AI-modeller, dokumentere kontroller, vurdere pålitelighet |

| FTC | Villedende praksis, datahåndtering | Overvåke AI-relaterte påstander, forhindre urettferdig bruk av data |

Effektiv Finansiell AI-åpenhet krever tydelig styretilsyn med implementering av kunstig intelligens og risikostyring. SECs IAC-anbefaling understreker at investorer har en legitim interesse av å vite om det finnes klare ansvarsforhold for implementering av AI-teknologi i interne forretningsprosesser og produktlinjer. Finansinstitusjoner må etablere styringsstrukturer som gir styret eller en dedikert styrekomité ansvar for AI-tilsyn, slik at AI-relaterte risikoer håndteres på høyeste nivå i organisasjonen. Dette styringsrammeverket bør inkludere dokumenterte retningslinjer og prosedyrer for AI-utvikling, testing, validering og implementering, med regelmessig rapportering til styret om modellprestasjon, identifiserte risikoer og utbedringstiltak. Uten tydelig styreansvar risikerer finansinstitusjoner regulatorisk oppmerksomhet og mulige sanksjoner for utilstrekkelig tilsyn med vesentlige AI-systemer.

Finansinstitusjoner må separat opplyse om vesentlige effekter av AI-implementering på interne forretningsprosesser og kundeorienterte produkter. For interne operasjoner bør opplysningene dekke påvirkning av AI på humankapital (som nedbemanning eller behov for oppkvalifisering), nøyaktighet i finansiell rapportering, styringsprosesser og cybersikkerhetsrisiko. For kundeorienterte forhold bør institusjonene opplyse om investeringer i AI-drevne plattformer, integrering av AI i produkter og tjenester, regulatoriske konsekvenser av AI-bruk, og hvordan AI påvirker prissettingsstrategier eller forretningsmål. SEC anbefaler å integrere disse opplysningene i eksisterende Regulation S-K opplysningspunkter (som punktene 101, 103, 106 og 303) basert på vesentlighet, i stedet for å opprette helt nye kategorier. Denne tilnærmingen lar finansinstitusjoner benytte eksisterende rammeverk og samtidig gi investorer tydelig, sammenlignbar informasjon om AIs rolle i virksomhetens drift og strategi.

Høykvalitetsdata er avgjørende for ansvarlig AI-implementering i finanssektoren, men mange institusjoner sliter med å etablere datastyringsrammer som møter regulatoriske forventninger. Finansinstitusjoner må sikre at data brukt til å trene, teste og validere AI-modeller er rene, komplette, standardiserte og omfattende, med tydelig dokumentasjon av datakilder, opprinnelse og eventuelle kjente begrensninger. Datasikkerhetstiltak må forhindre “datagift” – manipulering av treningsdata for å svekke modellens integritet – og beskytte mot uautorisert tilgang eller utlevering av sensitiv informasjon. Gramm-Leach-Bliley Act (GLBA) gir grunnleggende beskyttelse av forbrukeres finansielle data, men mange myndigheter og forbrukerforkjempere mener at disse beskyttelsene er utilstrekkelige i AI-sammenheng, særlig med utvidet datainnsamling til modelltrening. Finansinstitusjoner må også ivareta immaterielle rettigheter, sikre at de har gyldig tillatelse til å bruke data til AI-utvikling, og respektere tredjepartsrettigheter. Å implementere solide datastyringsrammer, inkludert prinsipper for dataminimering, tilgangskontroller og regelmessige revisjoner, er avgjørende for å vise etterlevelse av regulatoriske krav.

Regulatoriske myndigheter har gjort det klart at AI-modeller brukt i finansielle beslutninger må testes for skjevhet og mulige diskriminerende utfall, uansett modellens nøyaktighet eller prestasjon. “Black box”-problemet – der komplekse AI-systemer gir resultater som er vanskelige eller umulige å forklare – innebærer betydelig etterlevelsesrisiko, særlig i kundeorienterte applikasjoner som kredittvurdering, prising og svindeldeteksjon. Finansinstitusjoner må implementere prosesser for å avdekke og redusere skjevhet gjennom hele modellens livssyklus, inkludert testing under utvikling, validering og løpende overvåking. Etterlevelse av rettferdig utlån krever at institusjoner kan forklare de konkrete årsakene til negative avgjørelser (som kredittavslag) og vise at AI-modellene ikke har negativ forskjellsbehandling av beskyttede grupper. Testing av “mindre diskriminerende alternativer” – metoder som når forretningsmålene med mindre skjevhet – forventes i økende grad av myndighetene. Mange institusjoner tar i bruk forklarbare AI-teknikker (xAI), som feature importance-analyser og beslutningstrær, for å bedre åpenhet og ansvarlighet i AI-baserte avgjørelser.

Finansinstitusjoner som bruker AI i kundeorienterte applikasjoner må følge gjeldende forbrukerbeskyttelseslover, inkludert krav til begrunnelse ved negative avgjørelser, informasjon om datavern og rettferdig behandling. Når et AI-system brukes til å ta eller vesentlig påvirke beslutninger om kreditt, forsikring eller andre finansielle produkter, har forbrukeren rett til å forstå hvorfor de ble avslått eller fikk dårligere betingelser. CFPB har understreket at kredittgivere under Equal Credit Opportunity Act (ECOA) ikke har lov til å bruke “black box”-modeller dersom de ikke kan gi spesifikke og nøyaktige begrunnelser for negative avgjørelser. I tillegg gjelder UDAAP-standarden for AI-drevne systemer som kan skade forbrukere gjennom uoversiktlig datainnsamling, brudd på personvern eller ved å styre mot uegnede produkter. Finansinstitusjoner må sikre at AI-systemer brukt i kundeservice, produktanbefalinger og kontooppfølging er åpne om bruken av AI og gir tydelig informasjon om hvordan forbrukerdata samles inn, brukes og beskyttes.

De fleste finansinstitusjoner er avhengige av tredjepartsleverandører for å utvikle, implementere eller drifte AI-systemer, noe som gir betydelige forpliktelser innen tredjepartsrisikostyring (TPRM). De føderale bankmyndighetenes Interagency Guidance on Third-Party Relationships understreker at finansinstitusjoner er ansvarlige for ytelsen og etterlevelsen til tredjeparts AI-systemer, selv om institusjonen ikke har utviklet modellen selv. Effektiv TPRM for AI krever grundig forhåndsvurdering før man inngår avtale med en leverandør, inkludert vurdering av leverandørens datastyringspraksis, modellvalideringsprosesser og evne til å gi innsyn i modelloperasjoner. Finansinstitusjoner må også overvåke konsentrasjonsrisiko – potensielt systemisk påvirkning hvis et fåtall AI-leverandører får problemer eller svikter. Risiko i forsyningskjeden, inkludert pålitelighet av datakilder og stabilitet i tredjeparts infrastruktur, må vurderes og dokumenteres. Kontrakter med AI-leverandører bør inkludere tydelige krav til datasikkerhet, overvåking av modellprestasjon, hendelsesrapportering og mulighet for revisjon eller testing av AI-systemet. Særlig mindre finansinstitusjoner kan ha utfordringer med teknisk kompetanse til å evaluere komplekse AI-systemer, noe som skaper behov for bransjestandarder eller sertifiseringsordninger for å forenkle leverandørvurdering.

Finansinstitusjoner som opererer på tvers av landegrenser står overfor et stadig mer komplekst lapptrekteppe av AI-reguleringer, der EUs AI-forordning er det mest omfattende rammeverket så langt. EUs AI-forordning klassifiserer AI-systemer brukt til kredittvurdering, svindelforebygging og anti-hvitvasking som “høyrisiko”, og krever omfattende dokumentasjon, testing for skjevhet, menneskelig tilsyn og samsvarsvurderinger. OECD og G7 har også gitt prinsipper og anbefalinger for ansvarlig AI-styring i finanssektoren, med vekt på åpenhet, rettferdighet, ansvarlighet og menneskelig tilsyn. Mange av disse internasjonale standardene har ekstraterritoriell rekkevidde, noe som betyr at finansinstitusjoner med kunder i EU, Storbritannia eller andre regulerte jurisdiksjoner kan måtte etterleve disse standardene selv om de har hovedkontor andre steder. Arbeidet med regulatorisk harmonisering pågår, men det er fortsatt betydelige forskjeller mellom jurisdiksjoner, noe som gir etterlevelsesutfordringer for globale finansinstitusjoner. Proaktiv tilpasning til de strengeste internasjonale standardene – som EUs AI-forordning og OECD-prinsippene – kan hjelpe institusjoner å forberede seg på fremtidige regulatoriske endringer og redusere risikoen for sanksjoner på tvers av flere jurisdiksjoner.

Finansinstitusjoner bør etablere omfattende dokumentasjons- og styringsrutiner for å vise etterlevelse av kravene til Finansiell AI-åpenhet. Viktige anbefalinger inkluderer:

Ved å ta i bruk disse praksisene kan finansinstitusjoner redusere regulatorisk risiko, bygge tillit hos interessenter og posisjonere seg som ledende innen ansvarlig AI-implementering i finanssektoren.

Finansiell AI-åpenhet viser til regulatoriske krav for at finansinstitusjoner åpent redegjør for sin bruk av kunstig intelligens i beslutningstaking, risikostyring og kundeorienterte applikasjoner. Det omfatter forventninger fra SEC, CFPB, FINRA og andre reguleringsorganer om dokumentasjon av AI-styring, modellprestasjon og konsekvenser for forbrukere og markeder. SECs Investor Advisory Committee anbefalte i desember 2024 at finansinstitusjoner definerer sin bruk av AI, redegjør for styrets tilsynsmekanismer og rapporterer om vesentlig AI-implementering.

Finansinstitusjoner må opplyse om AI-bruk for å beskytte investorer, forbrukere og markedsintegriteten. Tilsynsmyndigheter har funnet at kun 40 % av S&P 500-selskapene gir AI-relaterte opplysninger, noe som skaper inkonsistens og informasjonsmangler for investorer. Opplysningskravene sikrer at interessenter forstår hvordan AI påvirker finansielle beslutninger, risikostyring og forbrukerutfall. I tillegg gjelder eksisterende forbrukerbeskyttelseslover – inkludert regler for rettferdig utlån og datavern – for AI-systemer, noe som gjør åpenhet avgjørende for regulatorisk etterlevelse.

SECs Investor Advisory Committee anbefalte tre hovedpilarer for AI-åpenhet: (1) at utstedere må definere hva de mener med 'kunstig intelligens', (2) redegjøre for styrets tilsynsmekanismer for AI-implementering, og (3) rapportere om vesentlig AI-implementering og dens effekt på interne operasjoner og kundeorienterte produkter. Disse anbefalingene skal gi investorer tydelig, sammenlignbar informasjon om hvordan AI påvirker finansinstitusjoners drift og strategi.

Finansiell AI-åpenhet fokuserer spesifikt på regulatoriske krav til åpen kommunikasjon om AI-bruk overfor eksterne interessenter (investorer, myndigheter, forbrukere), mens generell AI-styring viser til interne prosesser og kontroller for å håndtere AI-systemer. Åpenhet er den utadrettede komponenten av AI-styring, som sikrer at interessenter har tilgang til vesentlig informasjon om AI-implementering, risiko og konsekvenser. Begge deler er essensielle for ansvarlig AI-bruk i finanssektoren.

Opplysninger om AI-implementering bør omfatte både interne prosesser og konsekvenser for kunder. For interne operasjoner bør institusjoner redegjøre for påvirkningen på humankapital, finansiell rapportering, styring og cybersikkerhetsrisiko. For kundeorienterte produkter bør opplysningene dekke investeringer i AI-plattformer, integrering av AI i produkter, regulatoriske konsekvenser og hvordan AI påvirker prissetting eller forretningsstrategier. Opplysningene bør integreres i eksisterende regulatoriske opplysningskrav (som SEC Regulation S-K) basert på vesentlighet.

Lover om rettferdig utlån, inkludert Equal Credit Opportunity Act (ECOA) og Fair Credit Reporting Act (FCRA), gjelder for AI-systemer brukt i kredittvurdering uavhengig av teknologi. Finansinstitusjoner må kunne forklare de konkrete årsakene til negative beslutninger (som kredittavslag) og vise at deres AI-modeller ikke har en negativ forskjellsbehandling av beskyttede grupper. Tilsynsmyndigheter forventer at institusjoner tester AI-modeller for skjevhet, implementerer 'mindre diskriminerende alternativer' der det er mulig, og dokumenterer tester og validering for rettferdighet.

De fleste finansinstitusjoner er avhengige av tredjepartsleverandører for AI-systemer, noe som skaper betydelige forpliktelser innen tredjepartsrisikostyring (TPRM). Finansinstitusjoner er ansvarlige for ytelsen og etterlevelsen til tredjeparts AI-systemer, selv om de ikke har utviklet modellen selv. Effektiv TPRM for AI krever grundig forhåndsvurdering, løpende overvåkning, vurdering av leverandørens datastyringspraksis og dokumentasjon av modellprestasjon. Institusjonene må også overvåke konsentrasjonsrisiko – potensialet for systemiske konsekvenser dersom et fåtall AI-leverandører får problemer.

EUs AI-forordning representerer det mest omfattende regulatoriske rammeverket for AI, der finansielle AI-systemer klassifiseres som 'høyrisiko' og krever omfattende dokumentasjon, testing for skjevhet og menneskelig tilsyn. OECD og G7 har også gitt prinsipper for ansvarlig AI-styring. Mange av disse internasjonale standardene har ekstraterritoriell rekkevidde, noe som betyr at finansinstitusjoner med kunder i regulerte jurisdiksjoner kan måtte etterleve disse standardene. Proaktiv tilpasning til internasjonale standarder kan hjelpe institusjoner å forberede seg på fremtidige regulatoriske endringer og redusere risikoen for sanksjoner.

Følg med på hvordan din finansinstitusjon nevnes i AI-responser på tvers av GPT-er, Perplexity og Google AI Overviews. Sørg for at merkevaren din opprettholder synlighet og nøyaktighet i AI-generert finansinnhold.

Overvåk hvordan din finansielle merkevare fremstår i AI-genererte svar. Lær krav til etterlevelse, synlighetsstrategier og optimaliseringsteknikker for regulert...

Lær essensiell AI-åpenhet og beste praksis for merking. Oppdag atferdsmessige, verbale og tekniske merkingsmetoder for å bygge tillit og sikre samsvar med stadi...

Lær hvordan AI-plattformer som ChatGPT, Perplexity og Google AI Overviews evaluerer finansielt innhold. Forstå YMYL-kravene, E-E-A-T-standardene og rammeverk fo...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.