Hva er GPTBot og Bør Du Tillate Det? Komplett Guide for Nettstedeiere

Lær hva GPTBot er, hvordan det fungerer, og om du bør tillate eller blokkere OpenAIs nettrobot. Forstå innvirkningen på merkevarens synlighet i AI-søkemotorer o...

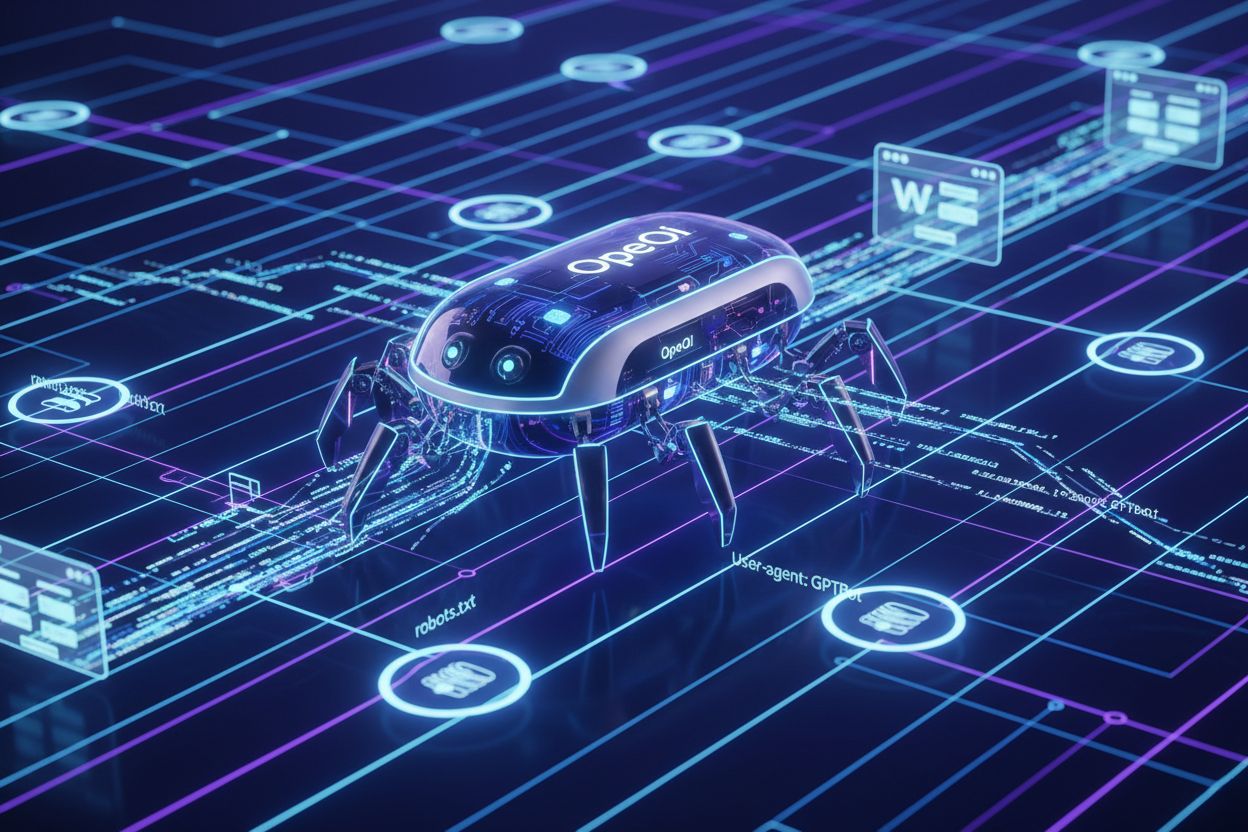

OpenAIs offisielle nett-crawler som samler inn treningsdata for AI-modeller som ChatGPT og GPT-4. Nettstedseiere kan styre tilgangen via robots.txt ved å bruke ‘User-agent: GPTBot’-direktiver. Crawleren følger standard webprotokoller og indekserer kun offentlig tilgjengelig innhold.

OpenAIs offisielle nett-crawler som samler inn treningsdata for AI-modeller som ChatGPT og GPT-4. Nettstedseiere kan styre tilgangen via robots.txt ved å bruke 'User-agent: GPTBot'-direktiver. Crawleren følger standard webprotokoller og indekserer kun offentlig tilgjengelig innhold.

GPTBot er OpenAIs offisielle nett-crawler, utviklet for å indeksere offentlig tilgjengelig innhold fra hele internett for å trene og forbedre AI-modeller som ChatGPT og GPT-4. I motsetning til generelle søkemotorcrawlere som Googlebot, opererer GPTBot med et spesifikt oppdrag: å samle inn data som hjelper OpenAI å forbedre sine språkmodeller og gi bedre AI-drevne svar til brukere. Nettstedseiere kan identifisere GPTBot gjennom dens karakteristiske user agent string (“GPTBot/1.0”), som vises i serverlogger og analyseplattformer hver gang crawleren besøker sidene deres. GPTBot respekterer robots.txt-filen, noe som betyr at nettstedseiere kan kontrollere om crawleren får tilgang til innholdet ved å legge til spesifikke direktiver i denne filen. Crawleren indekserer kun offentlig tilgjengelig innhold og forsøker ikke å omgå autentisering eller få tilgang til begrensede områder av nettsteder. Å forstå GPTBots formål og oppførsel er avgjørende for nettstedseiere som vil ta informerte valg om hvorvidt de vil tillate eller blokkere denne crawleren fra sine digitale eiendommer.

GPTBot opererer ved systematisk å krype gjennom nettsider, analysere innholdet og sende data tilbake til OpenAIs servere for prosessering og modelltrening. Crawleren sjekker først nettstedets robots.txt-fil for å avgjøre hvilke sider den får tilgang til, og følger direktivene spesifisert av nettstedseierne før den starter indeksering. Når GPTBot har identifisert seg gjennom sin user agent string, laster den ned og prosesserer sideinnhold, og trekker ut tekst, metadata og strukturell informasjon som bidrar til treningsdatasett. Crawleren kan generere betydelig båndbreddeforbruk, og noen nettsteder rapporterer om 30TB eller mer i månedlig crawler-trafikk på tvers av alle roboter samlet, selv om GPTBots individuelle påvirkning varierer avhengig av nettstedets størrelse og innholdets relevans.

| Crawler-navn | Formål | Respekterer robots.txt | Påvirkning på SEO | Dataforbruk |

|---|---|---|---|---|

| GPTBot | AI-modelltrening | Ja | Indirekte (AI-synlighet) | Treningsdatasett |

| Googlebot | Søkeindeksering | Ja | Direkte (rangeringer) | Søkeresultater |

| Bingbot | Søkeindeksering | Ja | Direkte (rangeringer) | Søkeresultater |

| ClaudeBot | AI-modelltrening | Ja | Indirekte (AI-synlighet) | Treningsdatasett |

Nettstedseiere kan overvåke GPTBot-aktivitet gjennom serverlogger ved å søke etter den spesifikke user agent-strengen, noe som gjør det mulig å spore crawl-frekvens og identifisere potensielle ytelsespåvirkninger. Crawlerens oppførsel er utformet for å være skånsom mot serverressurser, men nettsteder med mye trafikk kan likevel oppleve merkbart båndbreddeforbruk når flere AI-crawlere opererer samtidig.

Mange nettstedseiere velger å blokkere GPTBot på grunn av bekymringer rundt innholdsbruk uten kompensasjon, siden OpenAI bruker crawlet innhold til å trene kommersielle AI-modeller uten å gi noen direkte fordel eller betaling til innholdsskaperne. Serverbelastning er også en betydelig bekymring, spesielt for mindre nettsteder eller de med begrenset båndbredde, ettersom AI-crawlere kan bruke betydelige ressurser—noen nettsteder rapporterer over 30TB månedlig crawler-trafikk på tvers av alle roboter, der GPTBot bidrar betydelig til dette. Dataeksponering og sikkerhetsrisiko bekymrer innholdsskapere som frykter at deres proprietære informasjon, forretningshemmeligheter eller sensitiv data kan bli indeksert og brukt i AI-trening, noe som potensielt kan undergrave konkurransefortrinn eller bryte konfidensialitetsavtaler. Det juridiske landskapet rundt AI-treningsdata er fortsatt uklart, med uløste spørsmål rundt GDPR-overholdelse, CCPA-forpliktelser og brudd på opphavsrett, som skaper ansvarsbekymringer både for OpenAI og nettsteder som tillater ubegrenset crawling. Statistikk viser at omtrent 3,5 % av nettsteder aktivt blokkerer GPTBot, mens mer enn 30 store publikasjoner blant de 100 største nettstedene blokkerer crawleren, inkludert The New York Times, CNN, Associated Press og Reuters—noe som indikerer at innholdsleverandører med høy autoritet ser betydelige risikoer. Kombinasjonen av disse faktorene har gjort GPTBot-blokkering til en stadig vanligere praksis blant utgivere, medieselskaper og innholdsrike nettsteder som ønsker å beskytte sin immaterielle eiendom og opprettholde kontroll over hvordan innholdet deres brukes.

Nettstedseiere som gir GPTBot tilgang ser den strategiske verdien av ChatGPT-synlighet, gitt at plattformen har omtrent 800 millioner ukentlige brukere som regelmessig interagerer med AI-genererte svar som kan referere til eller oppsummere indeksert innhold. Når GPTBot crawler et nettsted, øker det sannsynligheten for at nettstedets innhold blir sitert, oppsummert eller referert til i ChatGPT-svar, noe som gir merkevarerepresentasjon i AI-grensesnitt og når brukere som i økende grad benytter AI-verktøy fremfor tradisjonelle søkemotorer. Forskning viser at AI-søketrafikk konverterer 23x bedre enn tradisjonell organisk søketrafikk, noe som betyr at brukere som finner innhold via AI-oppsummeringer og -anbefalinger viser vesentlig høyere engasjement og konverteringsrate sammenlignet med vanlige søkemotorbesøkende. Å tillate tilgang for GPTBot representerer en form for fremtidssikring, ettersom AI-drevet søk og innholdsoppdagelse blir stadig mer dominerende i måten brukere finner informasjon på nettet, og tidlig satsing på AI-synlighetsstrategier gir et konkurransefortrinn. Nettstedseiere som omfavner GPTBot-posisjonering drar også nytte av Generative Engine Optimization (GEO), en fremvoksende disiplin som fokuserer på å optimalisere innhold for AI-systemer i stedet for tradisjonelle søkealgoritmer, noe som kan gi betydelig trafikkvekst på sikt. Ved å tillate GPTBot-tilgang posisjonerer fremtidsrettede utgivere og virksomheter seg for å fange trafikk fra det raskt voksende segmentet av brukere som stoler på AI-verktøy for informasjonsinnhenting og beslutningstaking.

Å blokkere GPTBot er enkelt og krever kun endringer i nettstedets robots.txt-fil, som ligger i rotkatalogen og styrer crawler-tilgang på tvers av hele domenet. Den enkleste tilnærmingen er å legge til en total blokkering for alle OpenAI-crawlere:

User-agent: GPTBot

Disallow: /

Hvis du vil blokkere GPTBot fra spesifikke kataloger, men tillate tilgang til andre, bruk målrettede direktiver:

User-agent: GPTBot

Disallow: /private/

Disallow: /admin/

Disallow: /api/

For å blokkere alle OpenAI-relaterte crawlere, inkludert GPTBot, ChatGPT-User og ChatGPT-Plugins:

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ChatGPT-Plugins

Disallow: /

I tillegg til robots.txt-endringer kan nettstedseiere bruke alternative blokkeringsmetoder som IP-basert blokkering via brannmur, Web Application Firewall (WAF) som filtrerer forespørsler på user agent, og ratebegrensning som begrenser crawlerens båndbreddeforbruk. For maksimal kontroll kombinerer noen nettsteder flere tilnærminger—ved å bruke robots.txt som primærmekanisme og IP-blokkering som sekundær sikring mot crawlere som ignorerer robots.txt-direktiver. Etter at en blokkeringsstrategi er implementert, bør du verifisere effekten ved å sjekke serverloggene for GPTBot user agent-strenger og bekrefte at crawleren ikke lenger får tilgang til innholdet.

Visse bransjer har spesielle risikoer ved ubegrenset AI-crawler-tilgang og bør nøye vurdere om blokkering av GPTBot samsvarer med deres forretningsinteresser og innholdsbeskyttelsesstrategier:

Disse bransjene bør implementere blokkeringsstrategier for å opprettholde konkurransefortrinn, beskytte proprietær informasjon og sikre samsvar med databeskyttelsesregler.

Nettstedseiere bør regelmessig overvåke serverlogger for å identifisere GPTBot-aktivitet og spore crawl-mønstre, noe som gir innsikt i hvordan AI-systemer får tilgang til og potensielt bruker innholdet. GPTBot-identifisering er enkel—crawleren identifiserer seg med user agent-strengen “GPTBot/1.0” i HTTP-forespørselshoder, noe som gjør den lett å skille fra andre crawlere i serverlogger og analyseverktøy. De fleste moderne analyseverktøy og SEO-overvåkningsprogrammer (inkludert Google Analytics, Semrush, Ahrefs og spesialiserte bot-overvåkingsplattformer) kategoriserer og rapporterer automatisk GPTBot-aktivitet, slik at nettstedseiere kan følge med på crawl-frekvens, båndbreddeforbruk og besøkte sider uten manuell logganalyse. Gjennomgang av serverlogger gir detaljert informasjon om GPTBot-forespørsler, inkludert tidspunkter, besøkte URL-er, responskoder og båndbreddeforbruk, som gir nøyaktig innsikt i crawlerens oppførsel. Regelmessig overvåking er avgjørende fordi crawler-oppførsel kan endre seg over tid, nye AI-crawlere kan dukke opp, og blokkerings-effektiviteten krever periodisk verifisering for å sikre at direktivene fungerer som de skal. Nettstedseiere bør etablere grunnlagsmålinger for normal crawler-trafikk og undersøke betydelige avvik som kan tyde på økt AI-crawler-aktivitet eller potensielle sikkerhetsproblemer.

OpenAI har gitt offentlige forpliktelser til ansvarlig AI-utvikling og datahåndtering, inkludert eksplisitte uttalelser om at GPTBot respekterer nettstedseieres preferanser som uttrykt gjennom robots.txt-filer og andre tekniske direktiver. Selskapet legger vekt på datapersonvern og ansvarlig AI-praksis, og anerkjenner at innholdsskapere har legitime interesser i å kontrollere hvordan arbeidet deres brukes og kompenseres, selv om OpenAIs nåværende tilnærming ikke gir direkte kompensasjon til de som får innholdet sitt crawlet. OpenAIs dokumenterte policy bekrefter at GPTBot respekterer robots.txt-direktiver, noe som betyr at selskapet har bygget inn samsvarsmekanismer i sin crawler-infrastruktur og forventer at nettstedseiere bruker standard tekniske verktøy for å styre tilgangen. Selskapet har også uttrykt vilje til å samarbeide med utgivere og innholdsskapere om bekymringer rundt databruk, selv om formelle lisensavtaler og kompensasjonsordninger fortsatt er begrenset. OpenAIs retningslinjer fortsetter å utvikle seg som respons på juridiske utfordringer, regulatorisk press og tilbakemeldinger fra bransjen, noe som antyder at fremtidige versjoner av GPTBot kan inkludere flere sikkerhetstiltak, åpenhet eller kompensasjonsmekanismer. Nettstedseiere bør følge med på OpenAIs offisielle kommunikasjon og policyoppdateringer for å forstå hvordan selskapets tilnærming til innholdscrawling og datahåndtering kan endre seg over tid.

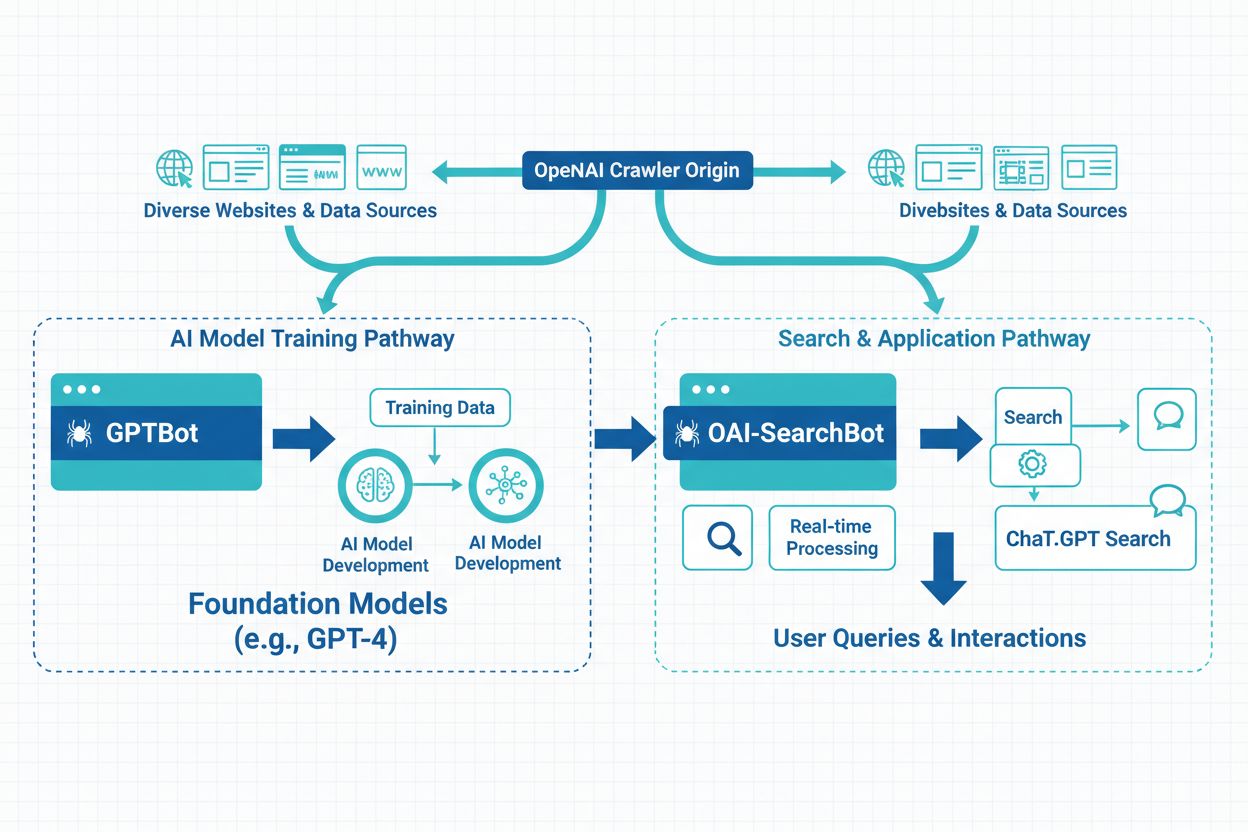

OpenAI opererer tre distinkte crawler-typer for ulike formål: GPTBot (generell webcrawling for modelltrening), ChatGPT-User (crawler lenker delt av ChatGPT-brukere), og ChatGPT-Plugins (tilgang til innhold via plugin-integrasjoner)—alle med forskjellige user agent-strenger og tilgangsmønstre. Utover OpenAIs crawlere finnes det en rekke andre crawlere fra konkurrerende selskaper: Google-Extended (Googles AI-treningscrawler), CCBot (Commoncrawl), Perplexity (AI-søkemotor), Claude (Anthropics AI-modell), og nye crawlere fra andre AI-selskaper, hver med ulike formål og dataforbruk. Nettstedseiere står overfor et strategisk valg mellom selektiv blokkering (rettet mot spesifikke crawlere som GPTBot, mens andre tillates) og omfattende blokkering (blokkering av alle AI-crawlere for full kontroll over innholdsbruk). Utbredelsen av AI-crawlere gjør at blokkering av kun GPTBot kanskje ikke beskytter innholdet fullt ut mot AI-trening, siden andre crawlere fortsatt kan få tilgang til og indeksere samme materiale gjennom alternative mekanismer. Noen nettstedseiere implementerer trinnvise strategier, hvor de blokkerer de mest aggressive eller kommersielt betydningsfulle crawlerne, samtidig som de tillater mindre eller forskningsrettede crawlere. Å forstå forskjellene mellom disse crawlerne hjelper nettstedseiere å ta informerte valg om hvilke crawlere de skal blokkere, basert på spesifikke bekymringer rundt databruk, konkurransepåvirkning og forretningsmål.

ChatGPTs innflytelse på søkeatferd endrer hvordan brukere finner informasjon, med 800 millioner ukentlige brukere som i økende grad vender seg til AI-verktøy istedenfor tradisjonelle søkemotorer, og endrer det konkurransemessige landskapet for innholdssynlighet. AI-genererte oppsummeringer og utvalgte utdrag i ChatGPT-svar fungerer nå som alternative oppdagelsesmekanismer, noe som betyr at innhold som rangerer godt i tradisjonelle søkeresultater kan bli oversett hvis det ikke blir valgt for inkludering i AI-genererte svar. Generative Engine Optimization (GEO) har blitt en avgjørende disiplin for fremoverlente innholdsskapere, med fokus på å optimalisere innholdsstruktur, klarhet og autoritet for å øke sannsynligheten for å bli inkludert i AI-genererte svar og oppsummeringer. De langsiktige synlighetskonsekvensene er betydelige: nettsteder som blokkerer GPTBot kan miste muligheten til å vises i ChatGPT-svar, noe som potensielt reduserer trafikken fra det raskest voksende segmentet av AI-drevne søkebrukere, mens de som tillater tilgang posisjonerer seg for AI-basert oppdagelse. Forskning viser at 86,5 % av innholdet i Googles topp 20 søkeresultater inneholder delvis AI-genererte elementer, noe som viser at AI-integrasjon blir standard i søkelandskapet, ikke bare et nisjefenomen. Konkurranseposisjonering avhenger i økende grad av synlighet både i tradisjonelle søkemotorer og AI-systemer, noe som gjør strategiske valg rundt GPTBot-tilgang avgjørende for langsiktig SEO-suksess og organisk trafikkvekst. Nettstedseiere må balansere hensynet til innholdsbeskyttelse mot risikoen for å miste synlighet i AI-systemer som blir primære oppdagelsesmekanismer for millioner av brukere verden over.

GPTBot er OpenAIs offisielle nett-crawler laget for å samle inn treningsdata til AI-modeller som ChatGPT og GPT-4. I motsetning til Googlebot, som indekserer innhold for søkeresultater, samler GPTBot data spesifikt for å forbedre språkmodeller. Begge crawlerne respekterer robots.txt-direktiver og har kun tilgang til offentlig tilgjengelig innhold, men de har grunnleggende ulike formål i det digitale økosystemet.

Avgjørelsen avhenger av forretningsmålene dine og innholdsstrategien. Blokker GPTBot hvis du har proprietært innhold, opererer i regulerte bransjer, eller har bekymringer rundt immaterielle rettigheter. Tillat GPTBot hvis du ønsker synlighet i ChatGPT (800M ukentlige brukere), dra nytte av AI-søketrafikk (som konverterer 23x bedre enn organisk), eller vil fremtidssikre din digitale tilstedeværelse for AI-drevet søk.

Legg til disse linjene i robots.txt-filen din for å blokkere GPTBot fra hele nettstedet: User-agent: GPTBot / Disallow: /. For å blokkere spesifikke kataloger, erstatt skråstreken med katalogbanen. For å blokkere alle OpenAI-crawlere, legg til separate User-agent-oppføringer for GPTBot, ChatGPT-User og ChatGPT-Plugins. Endringer trer i kraft umiddelbart og er enkle å reversere.

Virkningen av GPTBot varierer basert på nettstedets størrelse og innholdets relevans. Selv om påvirkningen fra én crawler vanligvis er håndterbar, kan flere AI-crawlere som opererer samtidig bruke betydelig båndbredde—noen nettsteder rapporterer om 30TB+ månedlig crawler-trafikk på tvers av alle roboter. Overvåk serverlogger for å spore GPTBot-aktivitet og innfør ratebegrensning eller IP-blokkering hvis båndbreddeforbruket blir problematisk.

Ja, du kan bruke målrettede robots.txt-direktiver for å blokkere GPTBot fra bestemte kataloger eller sider, samtidig som du gir tilgang til resten. For eksempel kan du blokkere /private/ og /admin/-kataloger, men tillate resten av nettstedet. Denne selektive tilnærmingen lar deg beskytte sensitivt innhold og samtidig opprettholde synlighet på AI-systemer for offentlige sider.

Sjekk serverloggene dine for brukeragent-strengen 'GPTBot/1.0' i HTTP-forespørselshoder. De fleste analyseplattformer (Google Analytics, Semrush, Ahrefs) kategoriserer og rapporterer automatisk GPTBot-aktivitet. Du kan også bruke SEO-overvåkingsverktøy som sporer AI-crawler-aktivitet. Regelmessig overvåking hjelper deg å forstå crawl-frekvens og avdekke eventuelle ytelsespåvirkninger.

Det juridiske landskapet er fortsatt i utvikling. Å tillate GPTBot reiser spørsmål om GDPR-overholdelse, CCPA-forpliktelser og brudd på opphavsrett, selv om OpenAI hevder å respektere robots.txt-direktiver. Å blokkere GPTBot er juridisk ukomplisert, men kan begrense synligheten din i AI-systemer. Rådfør deg med juridisk ekspertise hvis du opererer i regulerte bransjer eller håndterer sensitiv data for å finne den beste tilnærmingen for din situasjon.

Å tillate GPTBot påvirker ikke direkte tradisjonelle Google-rangeringer, men øker synligheten din i ChatGPT-svar og andre AI-drevne søkeresultater. Med 800M ChatGPT-brukere og AI-søketrafikk som konverterer 23x bedre enn organisk, posisjonerer du deg for langsiktig synlighet i AI-systemer ved å tillate GPTBot. Å blokkere GPTBot kan redusere muligheten for å vises i AI-genererte svar, og dermed potensielt begrense trafikken fra det raskest voksende søkesegmentet.

Følg med på hvordan merkevaren din vises i ChatGPT, Perplexity, Google AI og andre AI-plattformer. Få sanntidsinnsikt i AI-sitater og synlighet med AmICited.

Lær hva GPTBot er, hvordan det fungerer, og om du bør tillate eller blokkere OpenAIs nettrobot. Forstå innvirkningen på merkevarens synlighet i AI-søkemotorer o...

Lær hovedforskjellene mellom GPTBot og OAI-SearchBot crawlere. Forstå deres formål, crawl-atferd og hvordan du kan håndtere dem for optimal synlighet i AI-søker...

Diskusjon i fellesskapet om konfigurering av robots.txt for AI-crawlere som GPTBot, ClaudeBot og PerplexityBot. Virkelige erfaringer fra webansvarlige og SEO-sp...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.