Slik lager du LLM meta-svar: Selvstendige innsikter AI kan sitere

Lær hvordan du lager LLM meta-svar som AI-systemer siterer. Oppdag strukturelle teknikker, strategier for svartetthet og siteringsklare innholdsformater som øke...

Innhold som direkte adresserer hvordan språkmodeller kan tolke og svare på relaterte spørsmål, utformet for å øke synlighet i AI-genererte svar på plattformer som ChatGPT, Google AI Overviews og Perplexity. LLM Meta Answers representerer syntetiserte svar som kombinerer informasjon fra flere kilder til sammenhengende, samtalebaserte svar som møter brukerens hensikt.

Innhold som direkte adresserer hvordan språkmodeller kan tolke og svare på relaterte spørsmål, utformet for å øke synlighet i AI-genererte svar på plattformer som ChatGPT, Google AI Overviews og Perplexity. LLM Meta Answers representerer syntetiserte svar som kombinerer informasjon fra flere kilder til sammenhengende, samtalebaserte svar som møter brukerens hensikt.

LLM Meta Answers representerer de syntetiserte, AI-genererte svarene som store språkmodeller produserer når brukere stiller dem spørsmål via plattformer som ChatGPT, Claude eller Googles AI Overviews. Disse svarene er grunnleggende forskjellige fra tradisjonelle søkeresultater fordi de kombinerer informasjon fra flere kilder til et sammenhengende, samtalebasert svar som direkte adresserer brukerens hensikt. I stedet for å presentere en liste med lenker, analyserer LLM-er innhentet innhold og genererer original tekst som inkorporerer fakta, perspektiver og innsikt fra deres treningsdata og retrieval-augmented generation (RAG)-systemer. Å forstå hvordan LLM-er konstruerer disse meta-svarene er essensielt for innholdsskapere som ønsker at arbeidet deres skal bli sitert og referert i AI-genererte svar. Synligheten til innholdet ditt i slike AI-svar har blitt like viktig som rangering i tradisjonelle søkeresultater, noe som gjør LLM-optimalisering (LLMO) til en kritisk del av moderne innholdsstrategi.

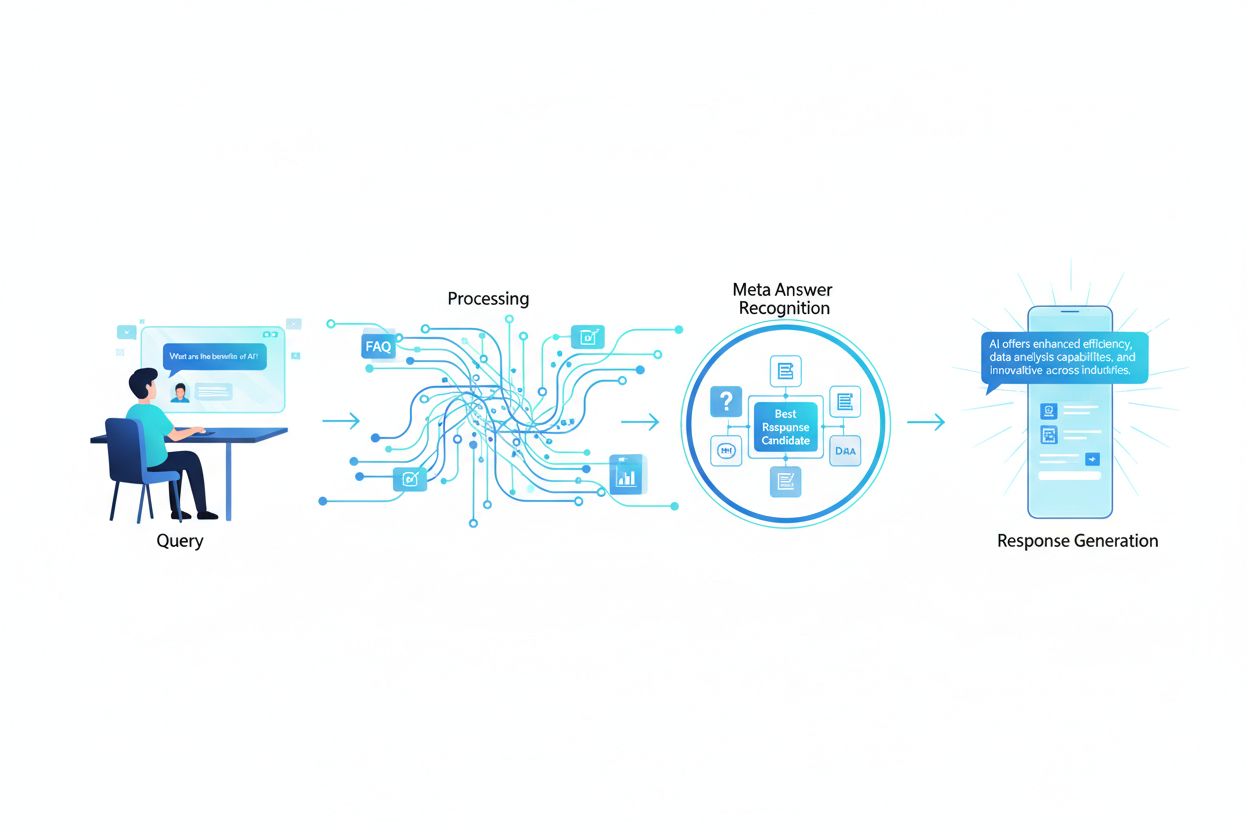

Når en bruker sender inn et spørsmål til en LLM, nøyer ikke systemet seg med å matche søkeord slik tradisjonelle søkemotorer gjør. I stedet utfører LLM-er semantisk analyse for å forstå den underliggende hensikten, konteksten og nyansene i spørsmålet. Modellen bryter ned spørsmålet i konseptuelle komponenter, identifiserer relaterte temaer og entiteter, og avgjør hva slags svar som vil være mest nyttig—om det er en definisjon, sammenligning, steg-for-steg-guide eller et analytisk perspektiv. LLM-er henter deretter relevant innhold fra kunnskapsbasen sin ved hjelp av RAG-systemer som prioriterer kilder basert på relevans, autoritet og grundighet. Henteprosessen tar hensyn til ikke bare nøyaktige søkeordtreff, men også semantisk likhet, tematiske relasjoner og hvor godt innholdet dekker spesifikke aspekter av spørsmålet. Dette betyr at innholdet ditt må være oppdagbart ikke bare for nøyaktige søkeord, men for de semantiske konseptene og relaterte temaene brukerne faktisk spør om.

| Tolkningsfaktor | Tradisjonelt søk | LLM Meta Answers |

|---|---|---|

| Matchingsmetode | Søkeordmatching | Semantisk forståelse |

| Resultatformat | Liste med lenker | Syntetisert fortelling |

| Kildevalg | Relevansrangering | Relevans + grundighet + autoritet |

| Kontekstvurdering | Begrenset | Omfattende semantisk kontekst |

| Svarsyntese | Brukeren må lese flere kilder | AI kombinerer flere kilder |

| Siteringskrav | Valgfritt | Ofte inkludert |

For at innholdet ditt skal bli valgt og sitert i LLM meta-svar, må det ha flere kritiske egenskaper som stemmer overens med hvordan disse systemene evaluerer og syntetiserer informasjon. Først må innholdet ditt vise tydelig ekspertise og autoritet på temaet, med sterke E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness) som hjelper LLM-er å identifisere pålitelige kilder. For det andre bør innholdet gi reell informasjonsverdi—unike innsikter, data eller perspektiver som tilfører merverdi utover det som vanligvis er tilgjengelig. For det tredje må innholdet være strukturert slik at LLM-er lett kan tolke og hente ut relevant informasjon, ved å bruke tydelige hierarkier og logisk organisering. For det fjerde er semantisk rikdom avgjørende; innholdet ditt bør grundig utforske relaterte konsepter, bruke variert terminologi og bygge omfattende tematisk autoritet i stedet for å fokusere snevert på enkeltsøkeord. For det femte er ferskhet viktig for aktuelle temaer, da LLM-er prioriterer nylig, oppdatert informasjon når de lager svar. Til slutt bør innholdet inkludere støttende bevis i form av sitater, data og eksterne referanser som bygger tillit hos LLM-systemene.

Viktige egenskaper som øker LLM-sitering:

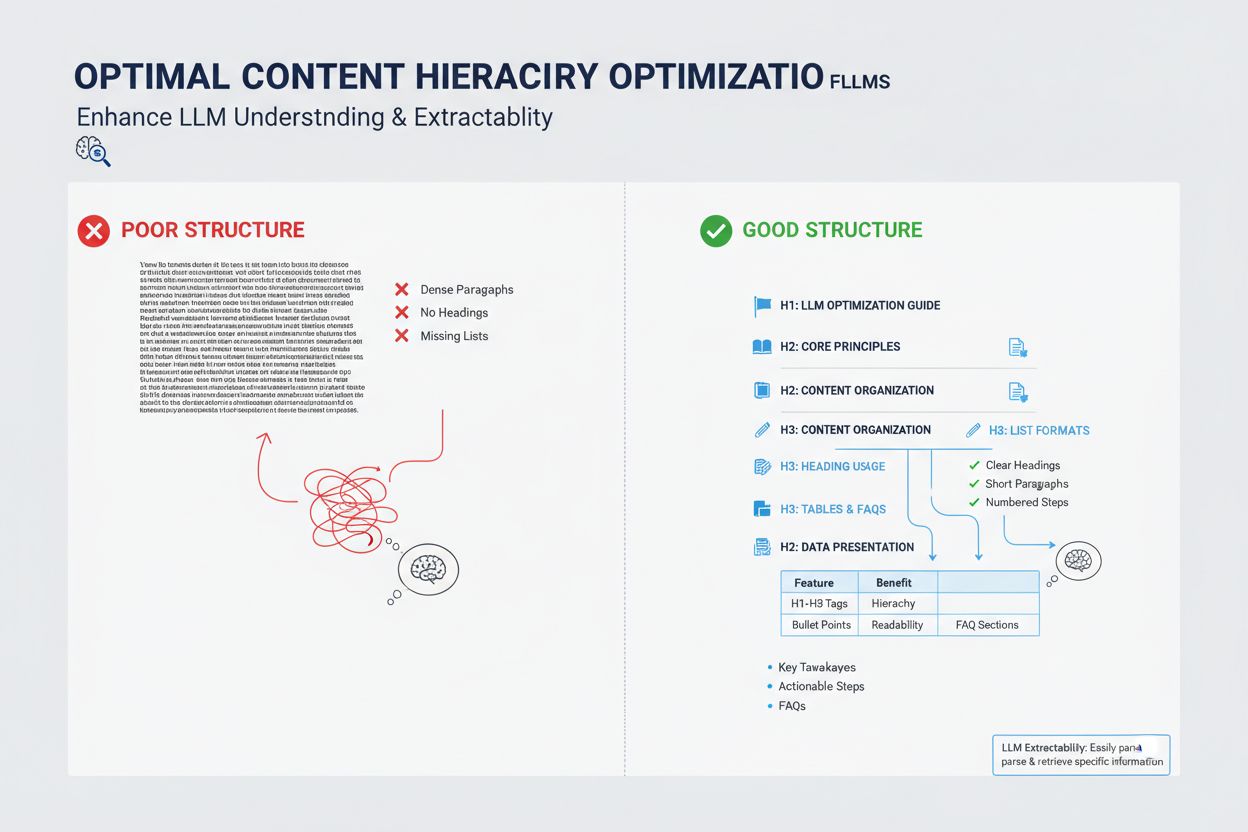

Måten du strukturerer innholdet ditt på har stor betydning for om LLM-er vil velge det til meta-svar, ettersom disse systemene er optimalisert for å hente og syntetisere godt organisert informasjon. LLM-er favoriserer sterkt innhold med tydelige overskriftshierarkier (H1, H2, H3) som skaper logisk informasjonsarkitektur, slik at modellen kan forstå sammenhengen mellom konsepter og effektivt hente relevante seksjoner. Punktlister og nummererte lister er spesielt verdifulle fordi de presenterer informasjon i oversiktlige, diskrete enheter som LLM-er lett kan innlemme i sine syntetiserte svar. Tabeller er spesielt kraftige for LLM-synlighet fordi de presenterer strukturert data i et format som er lett for AI-systemer å tolke og referere til. Korte avsnitt (3–5 setninger) fungerer bedre enn tette tekstblokker, ettersom de gjør det mulig for LLM-er å identifisere og trekke ut spesifikk informasjon uten å måtte navigere gjennom irrelevant innhold. I tillegg gir bruk av schema markup (FAQ, Article, HowTo) eksplisitte signaler til LLM-er om innholdets struktur og hensikt, noe som betydelig øker sannsynligheten for sitering.

Selv om LLM meta answers og featured snippets kan virke like ved første øyekast, representerer de grunnleggende forskjellige mekanismer for innholdssynlighet og krever ulike optimaliseringsstrategier. Featured snippets velges av tradisjonelle søkealgoritmer fra eksisterende nettinnhold og vises på en spesifikk plassering på søkeresultatsiden, vanligvis med 40–60 ord av utdratt tekst. LLM meta answers, derimot, er AI-genererte svar som syntetiserer informasjon fra flere kilder til en ny, original fortelling som kan være lengre og mer omfattende enn noen enkeltkilde. Featured snippets belønner innhold som direkte svarer på et spesifikt spørsmål i et konsist format, mens LLM meta answers belønner omfattende, autoritativt innhold som gir dyp tematisk dekning. Siteringsmekanismene er vesentlig ulike: featured snippets viser en kilde-lenke, men innholdet trekkes ut ordrett, mens LLM meta answers kan parafrasere eller syntetisere innholdet ditt og vanligvis inkluderer attribusjon. I tillegg er featured snippets primært optimalisert for tradisjonelt søk, mens LLM meta answers er optimalisert for AI-plattformer og kanskje ikke vises i søkeresultater i det hele tatt.

| Aspekt | Featured Snippets | LLM Meta Answers |

|---|---|---|

| Genereringsmetode | Algoritme trekker ut eksisterende tekst | AI syntetiserer fra flere kilder |

| Visningsformat | Posisjon i søkeresultatside | AI-plattform svar |

| Innholdslengde | Vanligvis 40–60 ord | 200–500+ ord |

| Siteringsstil | Kildelenke med utdratt tekst | Attribusjon med parafrasert innhold |

| Optimaliseringsfokus | Konsise direkte svar | Omfattende autoritet |

| Plattform | Google Search | ChatGPT, Claude, Google AI Overviews |

| Synlighetsmåling | Søkevisninger | AI-svar siteringer |

Semantisk rikdom—dybden og bredden i konseptuell dekning i innholdet ditt—er en av de viktigste, men ofte oversette faktorene i LLM-optimalisering. LLM-er ser ikke bare etter ditt målsøkeord; de analyserer de semantiske relasjonene mellom konsepter, kontekstuell informasjon rundt hovedtemaet ditt, og hvor grundig du utforsker relaterte ideer. Innhold med høy semantisk rikdom bruker variert terminologi, utforsker flere vinkler av et tema og bygger koblinger mellom beslektede konsepter, noe som hjelper LLM-er å forstå at innholdet ditt er genuint autoritativt fremfor overfladisk søkeordoptimalisert. Når du skriver om et tema, inkluder relaterte begreper, synonymer og konseptuelt nærliggende ideer som hjelper LLM-er å plassere innholdet ditt i en bredere kunnskapsgraf. For eksempel bør en artikkel om “innholdsmarkedsføring” naturlig inkludere diskusjoner om målgruppe-segmentering, kjøperpersonas, innholdsdistribusjon, analyse og ROI—ikke fordi du skal stappe inn søkeord, men fordi disse konseptene er semantisk relaterte og nødvendige for å forstå temaet grundig. Denne semantiske dybden signaliserer til LLM-er at du har reell ekspertise og kan gi de nyanserte, mangesidige svarene brukerne søker.

LLM-er vurderer autoritet annerledes enn tradisjonelle søkemotorer, med større vekt på signaler som indikerer reell ekspertise og troverdighet fremfor bare lenkepopularitet. Forfatterkreditering og dokumentert erfaring er spesielt viktig; LLM-er favoriserer innhold fra anerkjente eksperter, praktikere eller organisasjoner med etablert autoritet på sitt felt. Eksterne sitater og referanser til andre autoritative kilder bygger troverdighet hos LLM-systemene, da det viser at innholdet ditt er forankret i bredere kunnskap og bekreftet av andre eksperter. Konsistens på tvers av flere innholdsstykker om et tema hjelper til å etablere tematisk autoritet; LLM-er gjenkjenner når en forfatter eller organisasjon har publisert flere omfattende artikler om relaterte emner. Tredjepartsvalidering gjennom omtaler, sitater eller referanser fra andre autoritative kilder øker synligheten din i LLM meta-svar betydelig. Original forskning, egen data eller unike metoder gir sterke autoritetssignaler fordi de representerer informasjon som ikke finnes andre steder. I tillegg signaliserer en oppdatert publiseringshistorikk og jevnlig oppfriskning av innhold at du er aktivt engasjert i temaet og holder deg oppdatert på utviklingen.

Autoritetssignaler som påvirker LLM-utvalg:

Innholdets ferskhet har blitt stadig viktigere for LLM-synlighet, spesielt for temaer der informasjon endres ofte eller der nylige utviklinger har stor betydning for svaret. LLM-er er trent på data med kunnskapsavgrensning, men de benytter i økende grad RAG-systemer som henter oppdatert informasjon fra nettet, noe som betyr at publiseringsdato og oppdateringsfrekvens på innholdet direkte påvirker om det blir valgt til meta-svar. For tidløse temaer signaliserer regelmessige oppdateringer—selv små som oppdaterer publiseringsdato—til LLM-er at innholdet ditt vedlikeholdes aktivt og er pålitelig. For tidskritiske temaer som bransjetrender, teknologinyheter eller aktuelle hendelser, blir utdatert innhold aktivt nedprioritert av LLM-systemer til fordel for nyere kilder. Beste praksis er å etablere en vedlikeholdsplan der du gjennomgår og oppdaterer nøkkelinnhold kvartalsvis eller halvårlig, oppdaterer statistikk, legger til nye eksempler og inkorporerer siste utvikling. Dette vedlikeholdet forbedrer ikke bare LLM-synlighet, men viser både AI-systemer og lesere at du er en aktuell, pålitelig kilde til informasjon.

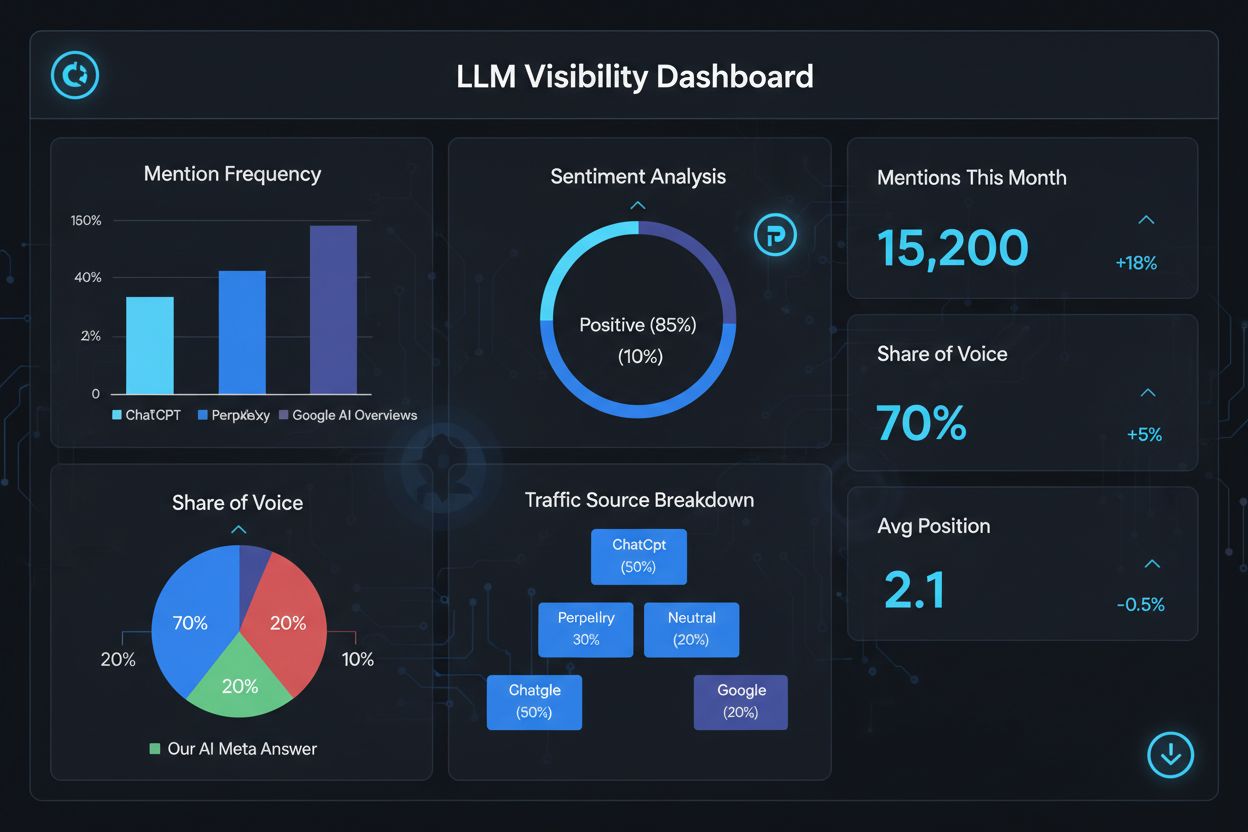

Å måle suksess for LLM meta answers krever andre måleparametere og verktøy enn tradisjonell SEO, siden disse svarene eksisterer utenfor det tradisjonelle søkeresultatsystemet. Verktøy som AmICited.com gir spesialisert overvåking som sporer når og hvor innholdet ditt vises i AI-genererte svar, slik at du får innsikt i hvilke artikler som blir sitert og hvor ofte. Du bør følge med på flere nøkkelparametere: siteringsfrekvens (hvor ofte innholdet ditt vises i LLM-svar), siteringskontekst (hvilke temaer utløser at innholdet ditt blir inkludert), kildemangfold (om du blir sitert på ulike LLM-plattformer), og svarposisjonering (om innholdet ditt blir fremhevet i det syntetiserte svaret). Følg med på hvilke spesifikke sider eller seksjoner som oftest blir sitert, da dette avslører hvilken type informasjon LLM-er anser som mest verdifull og troverdig. Overvåk endringer i siteringsmønster over tid for å identifisere hvilke optimaliseringstiltak som virker og hvilke temaer som trenger videreutvikling. I tillegg bør du analysere hvilke spørsmål som utløser siteringene dine for å forstå hvordan LLM-er tolker brukerhensikt og hvilke semantiske varianter som er mest effektive.

Nøkkelparametere for LLM meta answer-resultater:

Optimalisering for LLM meta answers krever en strategisk tilnærming som kombinerer teknisk implementering, innholdskvalitet og kontinuerlig måling. Start med grundig tematisk research for å identifisere hull der din ekspertise kan gi unik verdi som LLM-er vil prioritere fremfor generiske kilder. Strukturer innholdet ditt med tydelige hierarkier, bruk H2- og H3-overskrifter for å skape logisk informasjonsarkitektur som LLM-er lett kan tolke og hente ut fra. Implementer schema markup (FAQ, Article, HowTo) for å eksplisitt signalisere innholdets struktur og hensikt til LLM-systemene, noe som betydelig forbedrer oppdagbarheten. Utvikle omfattende, autoritativt innhold som grundig utforsker temaet fra flere vinkler, innlemmer relaterte konsepter og bygger semantisk rikdom som viser genuin ekspertise. Inkluder original forskning, data eller innsikt som gir informasjonsverdi og skiller innholdet ditt fra konkurrentene. Oppretthold en regelmessig oppdateringsplan, og frisk opp nøkkelinnhold kvartalsvis for å sikre ferskhet og signalisere kontinuerlig autoritet. Bygg tematisk autoritet ved å lage flere relaterte artikler som samlet etablerer din ekspertise innen et fagområde. Bruk tydelig, direkte språk som svarer på spesifikke spørsmål brukerne stiller, slik at det blir lett for LLM-er å hente ut og syntetisere innholdet ditt. Til slutt, overvåk LLM-siteringsresultatene dine med spesialiserte verktøy for å identifisere hva som fungerer og kontinuerlig forbedre strategien basert på datadrevne innsikter.

LLM Meta Answers fokuserer på hvordan språkmodeller tolker og siterer innhold, mens tradisjonell SEO fokuserer på rangering i søkeresultater. LLM-er prioriterer relevans og klarhet fremfor domeneautoritet, noe som gjør godt strukturert, svar-først-innhold viktigere enn lenker. Innholdet ditt kan bli sitert i LLM-svar selv om det ikke rangerer i Googles toppresultater.

Strukturer innhold med tydelige overskrifter, gi direkte svar først, bruk schema markup (FAQ, Article), inkluder sitater og statistikk, oppretthold tematisk autoritet, og sørg for at siden din kan gjennomsøkes av AI-boter. Fokuser på semantisk rikdom, informasjonsverdi og omfattende tematisk dekning fremfor snever søkeordmålretting.

LLM-er henter utdrag fra godt organisert innhold lettere. Tydelige overskrifter, lister, tabeller og korte avsnitt hjelper modellene med å identifisere og sitere relevant informasjon. Studier viser at LLM-siterte sider har betydelig flere strukturelementer enn gjennomsnittlige nettsider, noe som gjør struktur til en kritisk rangeringsfaktor.

Ja. I motsetning til tradisjonell SEO prioriterer LLM-er spørringsrelevans og innholdskvalitet over domeneautoritet. En velstrukturert, svært relevant nisjeside kan bli sitert av LLM-er selv om den ikke rangerer i Googles toppresultater, noe som gjør ekspertise og klarhet viktigere enn nettstedets autoritet.

Oppdater innhold regelmessig, spesielt for tidskritiske temaer. Legg til tidsstempler som viser når innholdet sist ble oppdatert. For tidløse temaer anbefales kvartalsvise gjennomganger. Friskt innhold signaliserer nøyaktighet til LLM-er, øker sannsynligheten for sitering og viser kontinuerlig autoritet.

AmICited.com er spesialister på overvåking av AI-omtaler på ChatGPT, Perplexity og Google AI Overviews. Andre verktøy inkluderer Semrush's AI SEO Toolkit, Ahrefs Brand Radar og Peec AI. Disse verktøyene sporer omtalehyppighet, synlighetsandel, sentiment og hjelper deg å måle optimaliserings-suksess.

Schema markup (FAQ, Article, HowTo) gir maskinlesbar struktur som hjelper LLM-er å forstå og hente ut innhold mer nøyaktig. Det signaliserer innholdstype og hensikt, noe som gjør siden din mer sannsynlig å bli valgt til relevante spørsmål og forbedrer oppdagbarheten.

Eksterne omtaler på høyt ansette nettsteder (nyheter, Wikipedia, bransjepublikasjoner) bygger troverdighet og øker sjansen for at LLM-er siterer innholdet ditt. Flere uavhengige kilder som nevner merkevaren eller dataene dine, skaper et autoritetsmønster LLM-er gjenkjenner og belønner med hyppigere sitering.

Følg med på hvordan merkevaren din vises i AI-genererte svar på ChatGPT, Perplexity og Google AI Overviews med AmICiteds spesialiserte overvåkningsplattform.

Lær hvordan du lager LLM meta-svar som AI-systemer siterer. Oppdag strukturelle teknikker, strategier for svartetthet og siteringsklare innholdsformater som øke...

Lær hva LLMO er, hvordan det fungerer, og hvorfor det er viktig for AI-synlighet. Oppdag optimaliseringsteknikker for å få merkevaren din nevnt i ChatGPT, Perpl...

Lær hva LLM Seeding er og hvordan du strategisk plasserer innhold på plattformer med høy autoritet for å påvirke AI-trening og bli sitert av ChatGPT, Claude og ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.