Hva er vektorsøk og hvordan fungerer det?

Lær hvordan vektorsøk bruker maskinlæringsinnbygginger for å finne lignende elementer basert på mening i stedet for eksakte nøkkelord. Forstå vektordatabaser, A...

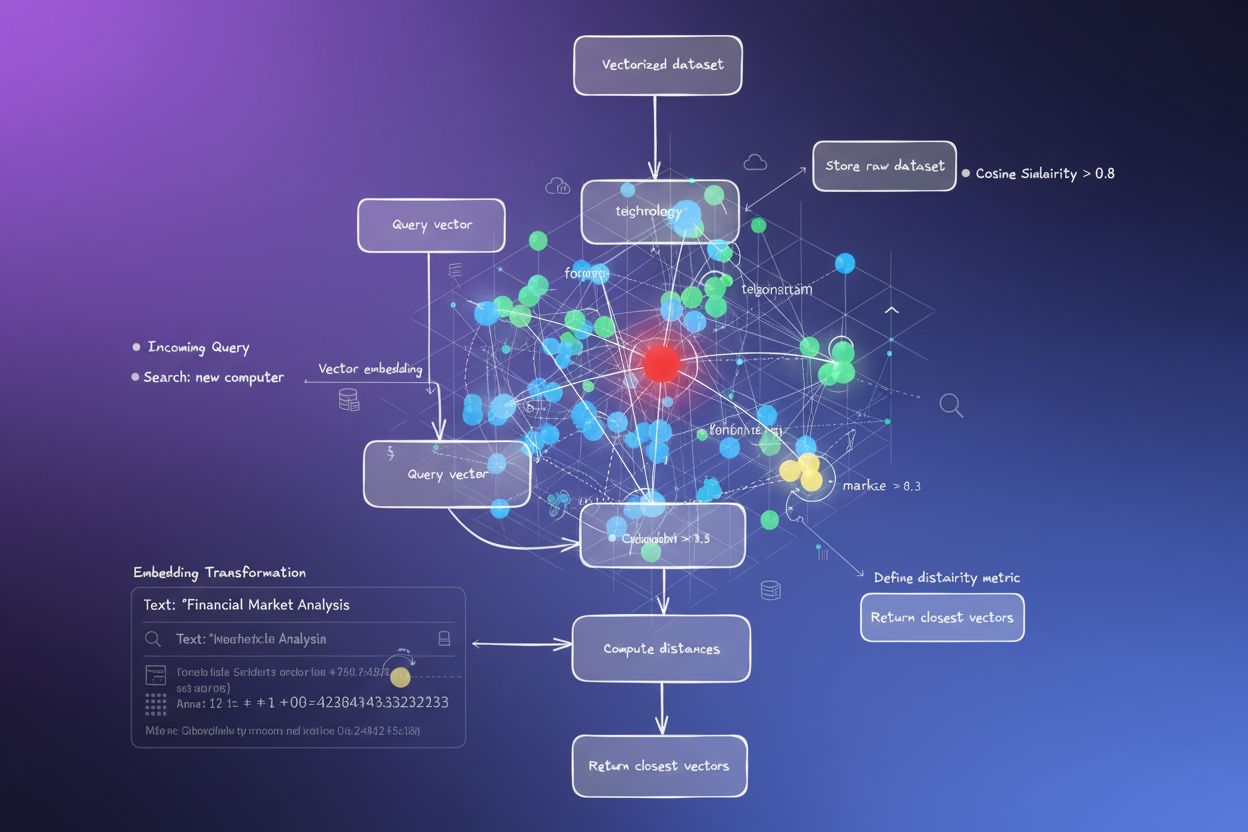

Vektorsøk er en metode for å finne lignende elementer i et datasett ved å representere data som matematiske vektorer og sammenligne dem ved hjelp av avstandsmål som cosinuslikhet eller euklidisk avstand. Denne tilnærmingen muliggjør semantisk forståelse utover nøkkelordmatcher, slik at systemer kan oppdage relasjoner og likheter basert på mening i stedet for nøyaktige teksttreff.

Vektorsøk er en metode for å finne lignende elementer i et datasett ved å representere data som matematiske vektorer og sammenligne dem ved hjelp av avstandsmål som cosinuslikhet eller euklidisk avstand. Denne tilnærmingen muliggjør semantisk forståelse utover nøkkelordmatcher, slik at systemer kan oppdage relasjoner og likheter basert på mening i stedet for nøyaktige teksttreff.

Vektorsøk er en metode for å finne lignende elementer i et datasett ved å representere data som matematiske vektorer og sammenligne dem ved hjelp av avstandsmål for å måle semantisk likhet. I motsetning til tradisjonelle nøkkelordbaserte søk som er avhengige av nøyaktige teksttreff, forstår vektorsøk meningen og konteksten bak data ved å konvertere dem til høy-dimensjonale numeriske representasjoner kalt vektorembeddings. Denne tilnærmingen gjør det mulig for systemer å oppdage relasjoner og likheter basert på semantisk innhold i stedet for overfladiske trekk, og er spesielt effektiv for applikasjoner som krever kontekstuelt skjønn. Vektorsøk har blitt grunnlaget for moderne AI-systemer, og muliggjør semantisk søk, anbefalingsmotorer, avvikdeteksjon og retrieval-augmented generation (RAG) på tvers av plattformer som ChatGPT, Perplexity, Google AI Overviews og Claude.

I kjernen forvandler vektorsøk data til numeriske representasjoner der nærhet i rommet indikerer semantisk likhet. Hvert datapunkt—enten det er tekst, bilde eller lyd—konverteres til en vektor, som i praksis er en tallrekke som representerer egenskaper eller mening. For eksempel kan ordet “restaurant” representeres som [0.2, -0.5, 0.8, 0.1], der hvert tall fanger ulike aspekter ved ordets semantiske betydning. Det grunnleggende prinsippet er at semantisk like elementer vil ha vektorer plassert nær hverandre i dette høy-dimensjonale rommet, mens ulike elementer vil være langt fra hverandre. Denne matematiske strukturen lar datamaskiner sammenligne konsepter basert på betydning i stedet for eksakte nøkkelordmatcher, slik at et søk etter “beste spisesteder” også kan gi resultater på “topprangerte restauranter” selv uten identisk ordbruk.

Prosessen med å konvertere data til vektorer kalles embedding, som utføres av maskinlæringsmodeller trent på store datasett. Disse modellene lærer å plassere lignende konsepter nær hverandre i vektorrommet gjennom eksponering for milliarder av eksempler. Vanlige embedding-modeller inkluderer Word2Vec, som lærer ordrelasjoner fra kontekst; BERT (Bidirectional Encoder Representations from Transformers), som fanger opp kontekstuell mening; og CLIP (Contrastive Language-Image Pre-training), som håndterer multimodale data. De resulterende embeddingene har vanligvis mellom 100 og 1 000+ dimensjoner, og skaper en rik matematisk representasjon av semantiske relasjoner. Når en bruker utfører et søk, konverteres spørringen til en vektor med samme embedding-modell, og systemet beregner deretter avstanden mellom spørringsvektoren og alle lagrede vektorer for å finne de mest lignende elementene.

Vektorsøk er avhengig av avstandsmål for å kvantifisere hvor like to vektorer er. De tre viktigste målene er cosinuslikhet, euklidisk avstand og prikkproduktlikhet, alle med ulike matematiske egenskaper og bruksområder. Cosinuslikhet måler vinkelen mellom to vektorer, fra -1 til 1, der 1 indikerer identisk retning (maksimal likhet) og 0 indikerer ortogonale vektorer (ingen relasjon). Dette målet er spesielt nyttig for NLP-applikasjoner fordi det fokuserer på semantisk retning uavhengig av vektormagnituden, og er derfor ideelt for å sammenligne dokumenter av ulik lengde. Euklidisk avstand beregner den rette linjen mellom vektorer i flerdimensjonalt rom, og tar hensyn til både størrelse og retning. Dette målet er følsomt for skala, og er nyttig når størrelsen på vektorene har meningsfull informasjon, for eksempel i anbefalingssystemer der kjøpsfrekvens betyr noe.

Prikkproduktlikhet kombinerer aspekter fra begge målene, og tar hensyn til både størrelse og retning samtidig som det gir beregningsmessig effektivitet. Mange store språkmodeller bruker prikkprodukt for trening, noe som gjør det til riktig valg for disse applikasjonene. Valg av riktig avstandsmål er kritisk—forskning viser at bruk av det samme målet som ble brukt til å trene embedding-modellen gir optimale resultater. For eksempel ble all-MiniLM-L6-v2-modellen trent med cosinuslikhet, så bruk av cosinuslikhet i indeksen vil gi de mest nøyaktige resultatene. Organisasjoner som implementerer vektorsøk må nøye matche valgt mål til embedding-modell og bruksområde for å sikre både nøyaktighet og ytelse.

| Aspekt | Vektorsøk | Nøkkelordsøk | Hybridsøk |

|---|---|---|---|

| Matchingsmetode | Semantisk likhet basert på betydning | Nøyaktig ord- eller frasematching | Kombinerer både semantisk og nøkkelordmatching |

| Spørringsforståelse | Forstår hensikt og kontekst | Krever at eksakte nøkkelord er til stede | Utnytter begge tilnærminger for helhetlige resultater |

| Håndtering av synonymer | Finner automatisk synonymer og relaterte begreper | Går glipp av synonymer med mindre de er eksplisitt indeksert | Fanger synonymer gjennom begge metoder |

| Ytelse på vage spørringer | Utmerket—forstår hensikt | Dårlig—krever presise nøkkelord | Veldig god—dekker begge tolkninger |

| Beregningkostnad | Høyere—krever embedding og likhetsberegning | Lavere—enkel tekstmatching | Moderat—kjører begge søk samtidig |

| Skalerbarhet | Krever spesialiserte vektordatabaser | Fungerer med tradisjonelle databaser | Krever systemer som støtter hybridsøk |

| Bruksområder | Semantisk søk, anbefalinger, RAG, avviksdeteksjon | Nøyaktig frasesøk, strukturerte data | Bedriftssøk, AI-overvåkning, merkevaresporing |

| Eksempel | Søk etter “sunn middagstips” finner “næringsrik matlaging” | Finner kun resultater med eksakt “sunn” og “middag” | Finner både eksakte og semantisk relaterte resultater |

Å implementere vektorsøk innebærer flere sammenhengende trinn som forvandler rådata til søkbare semantiske representasjoner. Første trinn er datainntak og forbehandling, der rådokumenter, bilder eller andre data renses og normaliseres. Deretter kommer vektortransformasjon, der en embedding-modell konverterer hvert element til en numerisk vektor, vanligvis mellom 100 og 1 000+ dimensjoner. Disse vektorene lagres så i en vektordatabase eller indeksstruktur optimalisert for høy-dimensjonale data. Når en søkespørring mottas, gjennomgår den samme embedding-prosess for å lage en spørringsvektor. Systemet bruker deretter avstandsmål for å beregne likhetspoeng mellom spørringsvektoren og alle lagrede vektorer, og rangerer resultater etter nærhet til spørringen.

For å gjøre denne prosessen effektiv i stor skala, benytter systemene Approximate Nearest Neighbor (ANN)-algoritmer som HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) eller ScaNN (Scalable Nearest Neighbors). Disse algoritmene ofrer perfekt nøyaktighet for hastighet, slik at søk blant millioner eller milliarder av vektorer kan gjøres på millisekunder i stedet for sekunder. HNSW organiserer for eksempel vektorer i en flerlags grafstruktur der høyere lag gir langdistanseforbindelser for rask traversering, mens lavere lag gir kortdistanseforbindelser for presisjon. Denne hierarkiske tilnærmingen reduserer søkekompleksiteten fra lineær O(n) til logaritmisk O(log n), og gjør storskala vektorsøk praktisk. Valg av algoritme avhenger av faktorer som datasettstørrelse, søkevolum, latenskrav og tilgjengelige ressurser.

Vektorsøk har blitt essensielt for AI-overvåkningsplattformer som AmICited som sporer merkevareomtaler på tvers av AI-systemer. Tradisjonell nøkkelordbasert overvåkning ville gått glipp av omskrevne omtaler, kontekstuelle referanser og semantiske variasjoner av merkenavn eller domenenavn. Vektorsøk gjør det mulig for slike plattformer å oppdage når merkevaren din nevnes i AI-genererte svar selv om den eksakte ordlyden er annerledes. Hvis ditt domene for eksempel er “amicited.com”, kan vektorsøk identifisere omtaler som “AI prompt-overvåkningsplattform” eller “merkevaresynlighet i generativ AI” som kontekstuelt relatert til virksomheten din, selv uten eksplisitte URL-omtaler. Denne semantiske forståelsen er avgjørende for fullstendig AI-sitasjonssporing på tvers av ChatGPT, Perplexity, Google AI Overviews og Claude.

Markedet for vektorsøkteknologi opplever eksplosiv vekst, noe som reflekterer at virksomheter ser verdien. Ifølge markedsundersøkelser ble markedet for vektordatabaser verdsatt til 1,97 milliarder dollar i 2024 og forventes å nå 10,60 milliarder dollar innen 2032, med en årlig vekstrate (CAGR) på 23,38 %. I tillegg rapporterte Databricks 186 % vekst i adopsjon av vektordatabaser allerede det første året etter deres vektorsøk-lansering i desember 2023. Denne raske adopsjonen viser at virksomheter i økende grad anser vektorsøk som kritisk infrastruktur for AI-applikasjoner. For organisasjoner som overvåker sin tilstedeværelse i AI-systemer gir vektorsøk den semantiske forståelsen som trengs for å fange opp alle meningsfulle omtaler, ikke bare eksakte nøkkelordtreff.

Vektorsøk-ytelse i stor skala avhenger kritisk av sofistikerte indekseringsteknikker som balanserer hastighet, nøyaktighet og minnebruk. HNSW (Hierarchical Navigable Small World) har blitt en av de mest populære tilnærmingene, og organiserer vektorer i en flerlags graf der hvert lag gir stadig kortere forbindelser. Algoritmen starter søkene på øverste lag med langdistanseforbindelser for rask traversering, og går deretter ned gjennom lagene for økt presisjon. Forskning viser at HNSW gir topp ytelse med recall på over 99 % og spørringslatens på under millisekundet. HNSW krever imidlertid betydelig minne—tester viser at indeksering av 1 million vektorer med HNSW kan kreve 0,5GB til 5GB avhengig av parametere, noe som gjør minneoptimalisering viktig for storskala bruk.

IVF (Inverted File Index) tilbyr en alternativ tilnærming ved å klynge vektorer og indeksere dem etter klynge-sentroidene. Denne teknikken reduserer søkeområdet ved å fokusere på relevante klynger i stedet for å søke i alle vektorer. ScaNN (Scalable Nearest Neighbors), utviklet av Google Research, optimaliserer spesielt for indreprodukt-søk og gir utmerket ytelse for anbefalingssystemer. Product Quantization (PQ) komprimerer vektorer ved å dele dem opp i undervektorer og kvantisere hver for seg, og reduserer minnebehovet med 10-100 ganger på bekostning av noe nøyaktighet. Organisasjoner som implementerer vektorsøk må nøye velge indekseringsteknikker basert på egne krav—om de prioriterer recall, søkehastighet, minneeffektivitet eller en kombinasjon. Feltet utvikler seg raskt, med stadig nye algoritmer og optimaliseringsteknikker som adresserer de beregningsmessige utfordringene ved høy-dimensjonale vektoroperasjoner.

Definisjonen og bruken av vektorsøk utvikles stadig etter hvert som AI-systemer blir mer avanserte og bedriftsadopsjonen øker. Fremtiden peker mot hybridsøk-systemer som kombinerer vektorsøk med tradisjonelt nøkkelordsøk og avanserte filtre. Disse hybride tilnærmingene utnytter den semantiske forståelsen fra vektorsøk samtidig som de ivaretar presisjonen og kjennskapen fra nøkkelordmatching, og gir overlegne resultater på komplekse spørringer. I tillegg vokser multimodalt vektorsøk frem som en kritisk egenskap, der systemer kan søke på tvers av tekst, bilder, lyd og video samtidig i et samlet embedding-rom. Denne utviklingen vil gjøre søkeopplevelsen mer intuitiv og omfattende på tvers av ulike datatyper.

For organisasjoner som overvåker sin tilstedeværelse i AI-systemer får utviklingen av vektorsøk store konsekvenser. Etter hvert som AI-plattformer som ChatGPT, Perplexity, Google AI Overviews og Claude i økende grad bruker vektorsøk for innhenting og rangering av innhold, blir det like viktig å forstå hvordan merkevaren din fremkommer semantisk som tradisjonelt nøkkelordsynlighet. Overgangen til semantisk forståelse betyr at merkevareovervåkning og AI-sitasjonssporing må utvikles utover enkel nøkkelorddeteksjon for å fange opp kontekstuelle omtaler og semantiske relasjoner. Organisasjoner som investerer i forståelse og bruk av vektorsøk vil stå bedre rustet til å optimalisere synligheten i generative AI-systemer. Sammenkoblingen av vektorsøkteknologi og AI-overvåkningsplattformer markerer et grunnleggende skifte i hvordan merkevarer forstår og håndterer sin tilstedeværelse i det AI-drevne informasjonssamfunnet.

Tradisjonelt nøkkelordsøk ser etter nøyaktige ordtreff i dokumenter, mens vektorsøk forstår semantisk mening og kontekst. Vektorsøk konverterer tekst til numeriske representasjoner kalt embeddings, slik at det kan finne relevante resultater selv når nøyaktige nøkkelord ikke samsvarer. For eksempel vil et søk etter 'trådløse hodetelefoner' med vektorsøk også gi resultater for 'Bluetooth ørepropper' fordi de deler lignende semantisk mening, mens nøkkelordsøk ville gått glipp av denne forbindelsen.

Vektorembeddings er numeriske representasjoner av data (tekst, bilder, lyd) konvertert til tallrekkefølger som fanger semantisk mening. De lages med maskinlæringsmodeller som Word2Vec, BERT eller transformerbaserte modeller som lærer å plassere lignende konsepter nær hverandre i et høy-dimensjonalt rom. For eksempel vil ordene 'konge' og 'dronning' ha embeddings plassert nær hverandre fordi de deler semantiske relasjoner, mens 'konge' og 'banan' vil være langt fra hverandre.

De tre primære avstandsmålene er cosinuslikhet (måler vinkel mellom vektorer), euklidisk avstand (måler rettlinjet avstand) og prikkproduktlikhet (tar hensyn til både størrelse og retning). Cosinuslikhet er vanligst for NLP-applikasjoner fordi den fokuserer på semantisk retning uavhengig av vektormagnituden. Valg av avstandsmål bør samsvare med det som ble brukt til å trene embedding-modellen for optimal nøyaktighet.

Vektorsøk gjør det mulig for AI-overvåkningsplattformer som AmICited å spore merkevareomtaler på tvers av AI-systemer (ChatGPT, Perplexity, Google AI Overviews, Claude) ved å forstå semantisk kontekst i stedet for nøyaktige nøkkelordmatcher. Dette muliggjør deteksjon av omskrevne omtaler, relaterte konsepter og kontekstuelle referanser til merkevaren, og gir full oversikt over hvordan domenet ditt omtales i AI-genererte svar på flere plattformer.

ANN-algoritmer som HNSW (Hierarchical Navigable Small World) muliggjør raske likhetssøk blant millioner av vektorer ved å finne omtrentlige i stedet for nøyaktige nærmeste naboer. Disse algoritmene bruker hierarkiske grafstrukturer for å redusere søkekompleksiteten fra lineær til logaritmisk, noe som gjør vektorsøk praktisk for storskala applikasjoner. HNSW organiserer vektorer i flerlags grafer der langdistanseforbindelser finnes på høyere lag for rask traversering.

Bedrifter genererer enorme mengder ustrukturert data (e-post, dokumenter, supportsaker) som tradisjonelt nøkkelordsøk har problemer med å organisere effektivt. Vektorsøk muliggjør semantisk forståelse av disse dataene, og driver applikasjoner som intelligent søk, anbefalingssystemer, avvikdeteksjon og retrieval-augmented generation (RAG). Ifølge markedsundersøkelser forventes markedet for vektordatabaser å vokse fra 2,65 milliarder dollar i 2025 til 8,95 milliarder dollar innen 2030, noe som gjenspeiler bedriftsadopsjon.

Vektordatabaser er spesialiserte systemer optimalisert for lagring, indeksering og spørring av høy-dimensjonale vektordata. De implementerer effektive indekseringsteknikker som HNSW, IVF (Inverted File Index) og ScaNN for å muliggjøre raske likhetssøk i stor skala. Eksempler inkluderer Milvus, Pinecone, Weaviate og Zilliz Cloud. Disse databasene håndterer den beregningsmessige kompleksiteten ved vektoroperasjoner, slik at organisasjoner kan bygge produksjonsklare semantiske søk og AI-applikasjoner uten å måtte håndtere infrastrukturkompleksitet.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hvordan vektorsøk bruker maskinlæringsinnbygginger for å finne lignende elementer basert på mening i stedet for eksakte nøkkelord. Forstå vektordatabaser, A...

Lær hvordan vektorembeddinger gjør det mulig for AI-systemer å forstå semantisk mening og matche innhold til forespørsler. Utforsk teknologien bak semantisk søk...

Semantisk søk tolker mening og kontekst i forespørsler ved hjelp av NLP og maskinlæring. Lær hvordan det skiller seg fra nøkkelordsøk, driver AI-systemer, og fo...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.