Analiza treści AI konkurencji: czego się nauczyć i zastosować

Dowiedz się, jak analizować treści generowane przez AI u konkurencji, wyciągać praktyczne wnioski i wykorzystywać wywiad konkurencyjny do budowy skutecznej stra...

Procedury kwestionowania nieprawdziwych lub szkodliwych treści generowanych przez AI na temat marki. Spory dotyczące treści AI odnoszą się do formalnych zgłoszeń, gdy systemy sztucznej inteligencji generują mylące informacje o markach, produktach lub organizacjach. Spory te wynikają z halucynacji AI, błędnych cytowań i przeinaczeń, które szkodzą reputacji marki na platformach takich jak ChatGPT, Perplexity czy Google AI Overviews. Skuteczne rozstrzyganie sporów wymaga monitorowania, dokumentowania, bezpośredniego kontaktu z firmami AI oraz strategicznego tworzenia treści korygujących dezinformację.

Procedury kwestionowania nieprawdziwych lub szkodliwych treści generowanych przez AI na temat marki. Spory dotyczące treści AI odnoszą się do formalnych zgłoszeń, gdy systemy sztucznej inteligencji generują mylące informacje o markach, produktach lub organizacjach. Spory te wynikają z halucynacji AI, błędnych cytowań i przeinaczeń, które szkodzą reputacji marki na platformach takich jak ChatGPT, Perplexity czy Google AI Overviews. Skuteczne rozstrzyganie sporów wymaga monitorowania, dokumentowania, bezpośredniego kontaktu z firmami AI oraz strategicznego tworzenia treści korygujących dezinformację.

Spór dotyczący treści AI to formalny proces zgłaszania lub kwestionowania, gdy systemy sztucznej inteligencji generują, cytują lub prezentują nieprawidłowe, mylące lub szkodliwe informacje na temat marki, produktu lub organizacji. Spory te pojawiają się, gdy wyszukiwarki AI, chatboty i modele językowe tworzą treści zniekształcające fakty, przypisujące błędne informacje lub szkodzące reputacji marki poprzez halucynacje AI — sytuacje, w których system AI z przekonaniem prezentuje fałszywe informacje jako fakty. Wraz z rosnącym znaczeniem wyszukiwania AI w procesie odkrywania i oceny marek przez konsumentów, a platformy takie jak ChatGPT, Perplexity, Google AI Overviews i Gemini wpływają na decyzje zakupowe milionów użytkowników, możliwość kwestionowania i korygowania nieprawidłowych treści generowanych przez AI staje się kluczowa dla ochrony marki i zarządzania reputacją.

Wpływ nieprawidłowych treści generowanych przez AI wykracza daleko poza tradycyjne obawy związane z monitoringiem marki. W przeciwieństwie do postów w mediach społecznościowych, które znikają z feedu w ciągu kilku godzin, wzmianki o marce generowane przez AI mogą utrzymywać się na wielu platformach i wpływać na postrzeganie konsumentów przez miesiące lub lata. Prawie 50% ludzi ufa rekomendacjom AI, a przy ponad 700 milionach cotygodniowych użytkowników ChatGPT, jedno nieprawidłowe stwierdzenie na temat Twojej marki może dotrzeć do dziesiątek milionów potencjalnych klientów. Gdy systemy AI cytują nieprawidłowe ceny, błędnie przypisują cechy produktu lub polecają konkurencję zamiast Twojej marki, konsekwencje mają bezpośredni wpływ na pozyskiwanie klientów, współczynnik konwersji i pozycjonowanie rynkowe.

| Aspekt | Tradycyjne spory o markę | Spory dotyczące treści AI |

|---|---|---|

| Czas trwania | Od kilku godzin do dni (media społecznościowe) | Od miesięcy do lat (utrwalone w modelach AI) |

| Zasięg | Ograniczony do obserwatorów platformy | Miliony użytkowników AI na całym świecie |

| Szybkość korekty | Możliwa natychmiastowa odpowiedź | Wymaga strategii treści i kontaktu |

| Weryfikacja | Przegląd ludzki | Generowane przez AI, trudniejsze do sprawdzenia |

| Wpływ na wyszukiwanie | Wpływa na pozycje SEO | Wpływa na AI Share of Voice i rekomendacje |

| Zaufanie odbiorców | Zmienna w zależności od platformy | Wysokie (50%+ ufa AI) |

| Trwałość | Poster może usunąć treść | Utrwalone w danych treningowych AI |

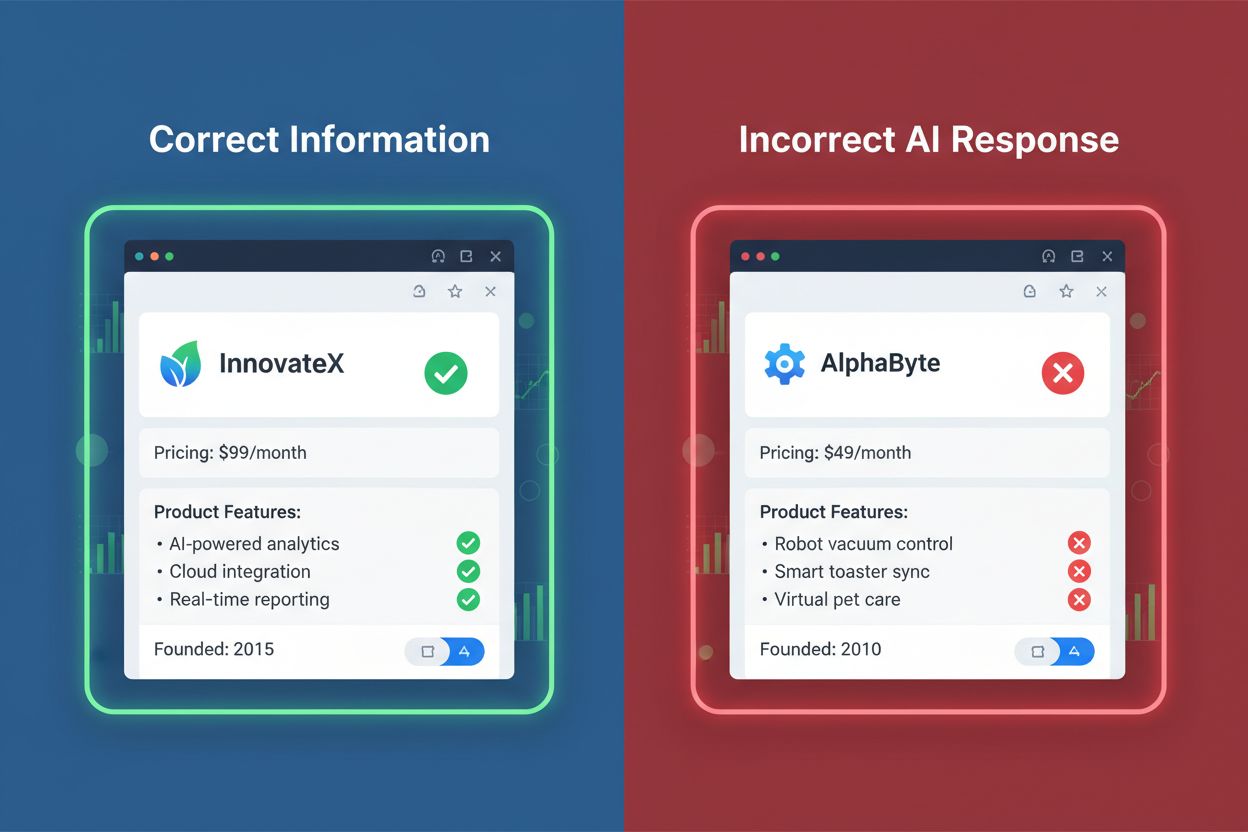

Przykłady z życia wzięte pokazują skalę problemu: systemy AI cytowały nieprawidłowe ceny subskrypcji, prezentowały wycofane produkty jako aktualne oraz przypisywały cechy konkurentom, które faktycznie należą do oryginalnej marki. Takie błędy bezpośrednio wpływają na decyzje zakupowe i mogą prowadzić do utraty przychodów, pogorszenia relacji z klientami oraz osłabienia pozycji konkurencyjnej w wynikach wyszukiwania napędzanych przez AI.

Systemy AI generują różne kategorie nieprawidłowych lub szkodliwych treści o markach. Zrozumienie tych typów pomaga organizacjom identyfikować i priorytetyzować działania naprawcze:

Zrozumienie, dlaczego systemy AI generują nieprawidłowe informacje o marce, jest kluczowe dla skutecznej strategii rozwiązywania sporów. Halucynacje AI pojawiają się, gdy modele językowe tworzą wiarygodnie brzmiące, lecz fałszywe informacje — jest to fundamentalna cecha ich działania. Zamiast pobierać fakty z bazy danych, modele AI przewidują kolejne słowo na podstawie statystycznych wzorców z danych treningowych, czasami tworząc przekonujące twierdzenia o informacjach, które nie istnieją lub są nieaktualne. Wiele systemów AI stosuje Retrieval Augmented Generation (RAG), która uzupełnia dane treningowe o wyniki wyszukiwań w czasie rzeczywistym, ale proces ten może potęgować błędy, jeśli źródłowe strony zawierają nieprawidłowe informacje lub AI błędnie interpretuje kontekst. Ograniczenia danych treningowych powodują, że informacje o nowych produktach, ostatnich zmianach w firmie czy aktualnych cenach mogą nie być odzwierciedlone w odpowiedziach AI. Dodatkowo, stronniczość w wyborze źródeł występuje, gdy systemy AI nadmiernie opierają się na określonych stronach — szczególnie domenach o wysokim autorytecie, takich jak Wikipedia, Reddit czy branżowe portale recenzenckie — które mogą zawierać nieaktualne lub niepełne informacje o Twojej marce.

Efektywne zarządzanie sporami zaczyna się od systematycznego monitoringu wielu platform AI. Ręczne monitorowanie polega na okresowym zadawaniu pytań systemom AI o markę i sprawdzaniu odpowiedzi pod kątem poprawności, ale ta metoda jest czasochłonna i obejmuje tylko niewielką część potencjalnych wzmianek. Zautomatyzowane narzędzia do monitorowania AI umożliwiają kompleksowe śledzenie na platformach takich jak ChatGPT, Perplexity, Google AI Overviews, Gemini, Claude i DeepSeek, analizując tysiące odpowiedzi generowanych przez AI w celu identyfikacji nieprawidłowości. Wiodące platformy, takie jak AmICited.com, specjalizują się w śledzeniu, jak systemy AI odnoszą się do marek, oferując analizę sentymentu w celu wykrycia negatywnego przedstawiania oraz analizę cytowań pokazującą, na jakich źródłach opierają się systemy AI, mówiąc o Twojej marce. Konkurencyjne rozwiązania, takie jak Authoritas, oferują dostosowywanie promptów z pomiarem pewności statystycznej, Profound zapewnia monitoring na poziomie enterprise z analizą każdej odpowiedzi, a Ahrefs Brand Radar śledzi wzmianki AI równolegle z widocznością w tradycyjnych wyszukiwarkach. Narzędzia takie jak Otterly i Peec.ai oferują tańsze opcje dla mniejszych marek rozpoczynających monitoring swojej obecności w AI. Skuteczny monitoring powinien obejmować nie tylko wzmianki o marce, ale także AI Share of Voice — procent rekomendacji AI, które otrzymuje Twoja marka w porównaniu z konkurencją w odpowiednich kategoriach.

Po zidentyfikowaniu nieprawidłowych treści AI dostępnych jest kilka ścieżek rozwiązania, w zależności od wagi i charakteru sporu. Bezpośredni kontakt z firmami AI polega na zgłoszeniu platformom takim jak OpenAI, Anthropic, Google czy Perplexity udokumentowanych dowodów nieprawidłowości, z prośbą o korektę lub przeuczenie modeli. Wiele firm AI wdrożyło mechanizmy zgłaszania i traktuje poważnie kwestie reputacji marek, zwłaszcza gdy błędy podważają zaufanie klientów lub dotyczą faktów. Tworzenie i optymalizacja treści rozwiązuje problem u źródła, zapewniając, że na Twojej stronie znajdują się jasne, poprawne i wyczerpujące informacje o marce, produktach, cenach oraz historii firmy — na których systemy AI będą się opierać, generując odpowiedzi. Tworzenie dedykowanych stron porównawczych i sekcji FAQ, które bezpośrednio odpowiadają na najczęstsze pytania i porównania z konkurencją, zwiększa szansę, że systemy AI zacytują Twoje autorytatywne treści zamiast źródeł zewnętrznych. Działania PR i media relations mogą nagłośnić korekty poprzez publikacje branżowe i wiadomości, wpływając na źródła, z których korzystają systemy AI. Współpraca z influencerami i recenzje zewnętrzne na platformach takich jak G2, Capterra czy branżowe portale recenzenckie dostarczają alternatywnych źródeł cytowań, poprawiając reprezentację marki w odpowiedziach AI. Najskuteczniejsze podejście łączy kilka strategii: poprawę nieprawidłowości na własnej stronie, tworzenie autorytatywnych treści, które systemy AI będą cytować, oraz bezpośredni kontakt z firmami AI w przypadku błędów faktograficznych szkodzących reputacji marki.

Rozwija się ekosystem specjalistycznych narzędzi wspierających marki w monitorowaniu, analizowaniu i zarządzaniu obecnością w treściach generowanych przez AI. AmICited.com jest liderem monitoringu marki w AI, śledząc wzmianki na głównych platformach AI z zaawansowaną analizą sentymentu i cytowań, by wykrywać, które źródła wpływają na odpowiedzi AI dotyczące Twojej marki. Authoritas łączy monitoring wyszukiwań AI z klasycznym SEO, oferując dostosowywanie promptów i analizę statystyczną na poziomie enterprise. Profound zapewnia codzienny monitoring z analizą odpowiedzi i eksploracją konwersacji, by zrozumieć, jakie pytania wywołują wzmianki o marce. Ahrefs Brand Radar integruje śledzenie wzmianek AI z metrykami widoczności w wyszukiwarkach, pokazując obecność marki w sześciu głównych indeksach AI oraz w tradycyjnym SEO. Otterly.ai oferuje niedrogi monitoring tygodniowy i automatyczne raporty, idealne dla marek rozpoczynających budowanie widoczności w AI. Peec.ai zapewnia rozwiązania średniego szczebla z przejrzystymi dashboardami i porównaniem z konkurencją. Wszystkie te platformy łączą takie funkcje jak: liczenie częstości wzmianek, analiza sentymentu, porównania z konkurencją i identyfikacja źródeł cytowań, różniąc się jednak częstotliwością aktualizacji (od czasu rzeczywistego po tygodniowe), zakresem platform, możliwościami personalizacji i modelem cenowym. Wybór odpowiedniego narzędzia zależy od wielkości organizacji, budżetu oraz głębokości analizy wyszukiwań AI.

Wraz ze wzrostem liczby sporów dotyczących treści AI rozwijają się przepisy prawne dotyczące ochrony marki i poprawności treści. Federalna Komisja Handlu (FTC) podjęła działania wobec firm reklamujących narzędzia wykrywania treści AI z zawyżonymi deklaracjami skuteczności. Problemy z prawami autorskimi i znakami towarowymi pojawiają się, gdy systemy AI błędnie przypisują własność intelektualną lub generują treści naruszające prawa marki. Nowo powstające regulacje w UE, Wielkiej Brytanii oraz planowane w USA coraz częściej wymagają od systemów AI ujawniania źródeł danych treningowych i wprowadzenia mechanizmów korekty nieprawidłowych informacji. Pytania o odpowiedzialność pozostają otwarte: nie jest jasne, czy za nieprawidłowe treści odpowiadają twórcy AI, firmy udostępniające dane treningowe czy same marki. Nowoczesne organizacje powinny śledzić zmiany regulacyjne i upewniać się, że procesy rozwiązywania sporów są zgodne z nowymi standardami prawnymi dotyczącymi transparentności i poprawności AI.

Proaktywne zarządzanie marką w dobie AI wymaga wielowarstwowego podejścia łączącego prewencję, monitoring i szybką reakcję. Utrzymuj aktualne informacje na stronie internetowej na wszystkich podstronach — ceny, opisy produktów, historię firmy i kluczowe fakty — by stały się one autorytatywnym źródłem dla systemów AI. Twórz wyczerpującą dokumentację marki, w tym rozbudowane FAQ, strony porównawcze z konkurencją oraz sekcje „o nas” odpowiadające na pytania, z jakimi mogą zetknąć się systemy AI. Monitoruj regularnie za pomocą specjalistycznych narzędzi, by szybko wychwycić nieprawidłowości, zanim rozprzestrzenią się na wielu platformach AI. Reaguj szybko po wykryciu sporu, łącząc bezpośredni kontakt z firmami AI oraz działania contentowe by skorygować dezinformację. Buduj autorytet marki poprzez wzmianki na stronach o wysokim autorytecie, branżowe recenzje i publikacje medialne, które systemy AI będą traktować jako źródła. Optymalizuj treści pod wyszukiwanie AI, tworząc materiały odpowiadające na konkretne pytania użytkowników, tak by marka pojawiała się w adekwatnych odpowiedziach AI. Organizacje, które łączą te praktyki — aktualne informacje, pełną dokumentację, aktywny monitoring, szybką reakcję i budowę autorytetu — znacząco zmniejszają ryzyko i skutki sporów dotyczących treści AI, jednocześnie poprawiając widoczność w wynikach wyszukiwania napędzanych przez AI.

Spór dotyczący treści AI pojawia się, gdy systemy sztucznej inteligencji generują, cytują lub przedstawiają nieprawidłowe, mylące lub szkodliwe informacje na temat marki, produktu lub organizacji. Spory te wynikają z halucynacji AI — przypadków, gdy systemy AI z przekonaniem prezentują fałszywe informacje jako fakty — i mogą poważnie zaszkodzić reputacji marki na platformach takich jak ChatGPT, Perplexity i Google AI Overviews.

W przeciwieństwie do postów w mediach społecznościowych, które znikają w ciągu kilku godzin, wzmianki o marce generowane przez AI mogą utrzymywać się przez miesiące lub lata i docierają do milionów użytkowników. Prawie 50% ludzi ufa rekomendacjom AI, a przy ponad 700 milionach cotygodniowych użytkowników ChatGPT, jedno nieprawidłowe stwierdzenie może wpłynąć na dziesiątki milionów potencjalnych klientów i bezpośrednio zmienić ich decyzje zakupowe.

Skorzystaj ze specjalistycznych narzędzi do monitorowania AI, takich jak AmICited.com, Authoritas czy Profound, aby śledzić, jak systemy AI odnoszą się do Twojej marki w ChatGPT, Perplexity, Google AI Overviews i Gemini. Narzędzia te oferują analizę sentymentu, śledzenie cytowań i porównanie z konkurencją, by wykrywać nieprawidłowości, negatywne przedstawienia oraz brakujące wzmianki.

Do typowych sporów należą błędy faktyczne (nieprawidłowe ceny, daty założenia, cechy produktu), błędnie przypisane informacje, faworyzowanie konkurencji w rekomendacjach, wzmacnianie negatywnego sentymentu, brak wzmianki o marce w odpowiednich kategoriach oraz szkodliwe powiązania z niezwiązanymi lub kontrowersyjnymi tematami.

Skuteczne rozwiązanie łączy wiele strategii: bezpośredni kontakt z firmami AI z udokumentowanymi dowodami, tworzenie precyzyjnych i wyczerpujących treści na własnej stronie, przygotowanie stron porównawczych i sekcji FAQ, działania PR i media relations w celu wpływania na źródła, a także budowanie autorytetu marki przez recenzje i wzmianki na platformach o wysokim autorytecie.

Systemy AI tworzą nieprawidłowe treści z powodu halucynacji (generowanie prawdopodobnie brzmiących, ale fałszywych informacji), ograniczeń danych treningowych (nieaktualne informacje), błędów w Retrieval Augmented Generation (błędna interpretacja źródeł z sieci) oraz stronniczości w wyborze źródeł (faworyzowanie niektórych stron kosztem innych).

Wiodące platformy to AmICited.com (specjalistyczny monitoring marki w AI), Authoritas (monitorowanie promptów z pewnością statystyczną), Profound (monitoring na poziomie enterprise), Ahrefs Brand Radar (wzmianki AI z widocznością w wyszukiwarce), Otterly (niedrogi monitoring tygodniowy) oraz Peec.ai (rozwiązania średniego szczebla z porównaniem do konkurencji).

Czas rozstrzygania jest bardzo zróżnicowany. Bezpośrednie poprawki na stronie mogą wpłynąć na odpowiedzi AI w ciągu kilku tygodni, gdy modele zostaną zaktualizowane. Bezpośredni kontakt z firmami AI może potrwać 1–3 miesiące. Budowanie autorytetu przez treści zewnętrzne i działania PR zazwyczaj wymaga 2–6 miesięcy, by przynieść mierzalny efekt w rekomendacjach AI.

Dowiedz się, jak AmICited pomaga markom śledzić i zarządzać swoją obecnością w ChatGPT, Perplexity, Google AI Overviews i innych platformach AI. Otrzymuj powiadomienia w czasie rzeczywistym, gdy systemy AI zniekształcają informacje o Twojej marce i podejmuj działania chroniące reputację.

Dowiedz się, jak analizować treści generowane przez AI u konkurencji, wyciągać praktyczne wnioski i wykorzystywać wywiad konkurencyjny do budowy skutecznej stra...

Dowiedz się, czym jest audyt treści AI, czym różni się od tradycyjnych audytów treści oraz dlaczego monitorowanie obecności Twojej marki w wyszukiwarkach AI, ta...

Dowiedz się, czym jest wykrywanie treści AI, jak działają narzędzia oparte na uczeniu maszynowym i NLP oraz dlaczego są ważne dla monitorowania marki, edukacji ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.